Wie verwende ich Caching in Go?

Caching ist eine in der Informatik häufig verwendete Technologie, die die Systemleistung und Reaktionsgeschwindigkeit effektiv verbessern kann. In der Go-Sprache gibt es viele verschiedene Cache-Implementierungen, wie z. B. sync.Map, Map, LRU Cache, Redis usw. Für unterschiedliche Nutzungsszenarien und Anforderungen müssen wir unterschiedliche Caching-Lösungen auswählen. In diesem Artikel besprechen wir die relevanten Kenntnisse und Techniken zur Verwendung von Caching in Go.

Cache-Implementierung in der Go-Sprache

In Go können wir Map verwenden, um einen grundlegenden Cache zu implementieren. Beispielsweise können wir eine Zuordnung definieren, um eine URL einem Byte-Array ihres Antwortinhalts zuzuordnen, und dann bei der Verarbeitung einer HTTP-Anfrage prüfen, ob die der URL entsprechende Antwort im Cache vorhanden ist. Wenn sie vorhanden ist, wird die Antwort direkt zurückgegeben Inhalt im Cache, andernfalls von Rufen Sie die Antwortdaten von der ursprünglichen Datenquelle ab und fügen Sie sie dem Cache hinzu. Das Folgende ist ein Implementierungsbeispiel:

package main

import (

"fmt"

"sync"

)

var cache = struct {

sync.RWMutex

data map[string][]byte

}{data: make(map[string][]byte)}

func main() {

url := "https://www.example.com"

if res, ok := get(url); ok {

fmt.Println("cache hit")

fmt.Println(string(res))

} else {

fmt.Println("cache miss")

// fetch response from url

res := fetchContent(url)

set(url, res)

fmt.Println(string(res))

}

}

func get(key string) ([]byte, bool) {

cache.RLock()

defer cache.RUnlock()

if res, ok := cache.data[key]; ok {

return res, true

}

return nil, false

}

func set(key string, value []byte) {

cache.Lock()

defer cache.Unlock()

cache.data[key] = value

}

func fetchContent(url string) []byte {

// fetch content from url

// ...

}Im obigen Codebeispiel definieren wir zunächst eine globale Variable namens Cache, die über eine Lese-/Schreibsperre und eine Karte zum Speichern der Zuordnungsbeziehung zwischen der URL und ihrem Antwortinhalt verfügt. Als nächstes verwenden wir bei der Verarbeitung der HTTP-Anfrage die Get-Funktion, um die Antwort aus dem Cache abzurufen, und geben sie direkt zurück, falls vorhanden. Andernfalls verwenden wir die Funktion fetchContent, um die Antwortdaten aus der ursprünglichen Datenquelle abzurufen und hinzuzufügen der Cache.

Zusätzlich zur Verwendung von Map bietet die Go-Sprache auch einige andere Cache-Implementierungen, wie z. B. sync.Map und LRU Cache.

sync.Map ist eine threadsichere Map, die gleichzeitige Lese- und Schreibvorgänge zwischen mehreren Goroutinen ohne Sperren ausführen kann. Durch die Verwendung von sync.Map zum Implementieren von Caching kann die Parallelitätsleistung des Systems verbessert werden. Das Folgende ist ein Implementierungsbeispiel:

package main

import (

"fmt"

"sync"

)

func main() {

m := sync.Map{}

m.Store("key1", "value1")

m.Store("key2", "value2")

if res, ok := m.Load("key1"); ok {

fmt.Println(res)

}

m.Range(func(k, v interface{}) bool {

fmt.Printf("%v : %v

", k, v)

return true

})

}Im obigen Codebeispiel speichern wir Daten in der Karte, indem wir die Store-Methode von sync.Map aufrufen und die Daten mithilfe der Load-Methode aus der Karte abrufen. Darüber hinaus können wir auch die Range-Methode verwenden, um die Funktion zum Durchqueren der Karte zu implementieren.

LRU-Cache ist eine gängige Caching-Strategie, die den zuletzt verwendeten Algorithmus (Least Latest Used) verwendet, um die am längsten verwendeten Daten aus dem Cache zu ersetzen, wenn der Cache-Speicherplatz voll ist. In der Go-Sprache können Sie das Paket golang-lru verwenden, um den LRU-Cache zu implementieren. Das Folgende ist ein Implementierungsbeispiel:

package main

import (

"fmt"

"github.com/hashicorp/golang-lru"

)

func main() {

cache, _ := lru.New(128)

cache.Add("key1", "value1")

cache.Add("key2", "value2")

if res, ok := cache.Get("key1"); ok {

fmt.Println(res)

}

cache.Remove("key2")

fmt.Println(cache.Len())

}Im obigen Codebeispiel erstellen wir zunächst einen LRU-Cache, fügen Daten zum Cache hinzu, indem wir die Add-Methode aufrufen, rufen die Daten mit der Get-Methode aus dem Cache ab und entfernen die Daten aus den LRU-Cache mit der Remove-Methode Daten löschen.

So entwerfen Sie ein effizientes Caching-System

Für unterschiedliche Szenarien und Anforderungen müssen wir häufig unterschiedliche Caching-Strategien wählen. Unabhängig davon, welche Caching-Strategie wir anwenden, müssen wir uns jedoch überlegen, wie wir ein effizientes Caching-System entwerfen können.

Hier einige Tipps zum Entwerfen eines effizienten Caching-Systems:

- Stellen Sie die richtige Cache-Größe ein.

Die Cache-Größe sollte entsprechend den Speicher- und Datenzugriffsmustern des Systems eingestellt werden. Wenn der Cache zu groß ist, wird der Systemspeicher knapp und die Systemleistung nimmt ab. Wenn der Cache zu klein ist, können die Systemressourcen nicht vollständig genutzt werden und es kann nicht genügend Cache bereitgestellt werden.

- Legen Sie eine geeignete Cache-Ablaufzeit fest.

Durch das Festlegen einer geeigneten Cache-Ablaufzeit können Sie verhindern, dass die zwischengespeicherten Daten zu alt werden, und die Echtzeitnatur der Daten sicherstellen. Die Cache-Ablaufzeit sollte basierend auf den Eigenschaften der Daten und Zugriffsmuster festgelegt werden.

- Mehrstufigen Cache verwenden

Für Daten, auf die nicht häufig zugegriffen wird, können Sie einen größeren Festplatten- oder Netzwerkspeicher-Cache verwenden, und für Daten, auf die häufiger zugegriffen wird, können Sie einen kleineren Speichercache verwenden. Durch mehrstufiges Caching können die Leistung und Skalierbarkeit des Systems verbessert werden.

- Cache-Penetration

Cache-Penetration bedeutet, dass die angeforderten Daten nicht im Cache vorhanden sind und die angeforderten Daten nicht in der Datenquelle vorhanden sind. Um eine Cache-Penetration zu vermeiden, können Sie ein boolesches Flag hinzufügen, um anzugeben, ob die Daten vorhanden sind, wenn der Cache abläuft. Wenn die abgefragten Daten nicht vorhanden sind, werden leere Daten zurückgegeben und das Flag-Bit der Daten wird auf „false“ gesetzt. Die nächste Abfrage basiert auf dem Flag-Bit, um wiederholte Abfragen zu vermeiden.

- Cache-Lawine

Cache-Lawine bedeutet, dass eine große Menge zwischengespeicherter Daten gleichzeitig ausfällt, was dazu führt, dass eine große Anzahl von Anforderungen auf dem Back-End-System gedrückt wird, was zum Absturz des Systems führt. Um das Problem der Cache-Lawine zu vermeiden, können Sie die Zufälligkeit der Cache-Ablaufzeit zur Verteilung verwenden oder die Cache-Ablaufzeit in mehrere Zeiträume aufteilen und die Ablaufzeit in verschiedenen Zeiträumen zufällig festlegen, um eine große Anzahl von Caches zu vermeiden Gleichzeitig kommt es zu Ausfällen, die zu einer übermäßigen Systemlast führen.

Zusammenfassung

In der Go-Sprache kann die Verwendung des Caches die Systemleistung und Reaktionsgeschwindigkeit effektiv verbessern. Wir können verschiedene Cache-Implementierungslösungen auswählen, z. B. Map, sync.Map, LRU Cache, Redis usw. Gleichzeitig ist es beim Entwurf eines effizienten Cache-Systems erforderlich, eine geeignete Cache-Strategie basierend auf spezifischen Anforderungen und Szenarien auszuwählen und Aspekte wie Cache-Größe, Cache-Ablaufzeit, mehrstufiger Cache, Cache-Penetration und Cache-Lawine zu berücksichtigen , usw.

Das obige ist der detaillierte Inhalt vonWie verwende ich Caching in Go?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

So verwenden Sie Reflection, um auf private Felder und Methoden in Golang zuzugreifen

May 03, 2024 pm 12:15 PM

So verwenden Sie Reflection, um auf private Felder und Methoden in Golang zuzugreifen

May 03, 2024 pm 12:15 PM

Sie können Reflektion verwenden, um auf private Felder und Methoden in der Go-Sprache zuzugreifen: So greifen Sie auf private Felder zu: Rufen Sie den Reflektionswert des Werts über „reflect.ValueOf()“ ab, verwenden Sie dann „FieldByName()“, um den Reflektionswert des Felds abzurufen, und rufen Sie auf String()-Methode zum Drucken des Feldwerts. Rufen Sie eine private Methode auf: Rufen Sie auch den Reflexionswert des Werts über Reflect.ValueOf () ab, verwenden Sie dann MethodByName (), um den Reflexionswert der Methode abzurufen, und rufen Sie schließlich die Methode Call () auf, um die Methode auszuführen. Praktischer Fall: Ändern Sie private Feldwerte und rufen Sie private Methoden durch Reflexion auf, um Objektkontrolle und Komponententestabdeckung zu erreichen.

Der Unterschied zwischen Leistungstests und Unit-Tests in der Go-Sprache

May 08, 2024 pm 03:09 PM

Der Unterschied zwischen Leistungstests und Unit-Tests in der Go-Sprache

May 08, 2024 pm 03:09 PM

Leistungstests bewerten die Leistung einer Anwendung unter verschiedenen Lasten, während Komponententests die Korrektheit einer einzelnen Codeeinheit überprüfen. Leistungstests konzentrieren sich auf die Messung von Antwortzeit und Durchsatz, während Unit-Tests sich auf Funktionsausgabe und Codeabdeckung konzentrieren. Leistungstests simulieren reale Umgebungen mit hoher Last und Parallelität, während Unit-Tests unter niedrigen Last- und seriellen Bedingungen ausgeführt werden. Das Ziel von Leistungstests besteht darin, Leistungsengpässe zu identifizieren und die Anwendung zu optimieren, während das Ziel von Unit-Tests darin besteht, die Korrektheit und Robustheit des Codes sicherzustellen.

Caching-Mechanismus und Anwendungspraxis in der PHP-Entwicklung

May 09, 2024 pm 01:30 PM

Caching-Mechanismus und Anwendungspraxis in der PHP-Entwicklung

May 09, 2024 pm 01:30 PM

In der PHP-Entwicklung verbessert der Caching-Mechanismus die Leistung, indem er häufig aufgerufene Daten vorübergehend im Speicher oder auf der Festplatte speichert und so die Anzahl der Datenbankzugriffe reduziert. Zu den Cache-Typen gehören hauptsächlich Speicher-, Datei- und Datenbank-Cache. In PHP können Sie integrierte Funktionen oder Bibliotheken von Drittanbietern verwenden, um Caching zu implementieren, wie zum Beispiel Cache_get() und Memcache. Zu den gängigen praktischen Anwendungen gehören das Zwischenspeichern von Datenbankabfrageergebnissen zur Optimierung der Abfrageleistung und das Zwischenspeichern von Seitenausgaben zur Beschleunigung des Renderings. Der Caching-Mechanismus verbessert effektiv die Reaktionsgeschwindigkeit der Website, verbessert das Benutzererlebnis und reduziert die Serverlast.

Auf welche Fallstricke sollten wir beim Entwurf verteilter Systeme mit Golang-Technologie achten?

May 07, 2024 pm 12:39 PM

Auf welche Fallstricke sollten wir beim Entwurf verteilter Systeme mit Golang-Technologie achten?

May 07, 2024 pm 12:39 PM

Fallstricke in der Go-Sprache beim Entwurf verteilter Systeme Go ist eine beliebte Sprache für die Entwicklung verteilter Systeme. Allerdings gibt es bei der Verwendung von Go einige Fallstricke zu beachten, die die Robustheit, Leistung und Korrektheit Ihres Systems beeinträchtigen können. In diesem Artikel werden einige häufige Fallstricke untersucht und praktische Beispiele für deren Vermeidung gegeben. 1. Übermäßiger Gebrauch von Parallelität Go ist eine Parallelitätssprache, die Entwickler dazu ermutigt, Goroutinen zu verwenden, um die Parallelität zu erhöhen. Eine übermäßige Nutzung von Parallelität kann jedoch zu Systeminstabilität führen, da zu viele Goroutinen um Ressourcen konkurrieren und einen Mehraufwand beim Kontextwechsel verursachen. Praktischer Fall: Übermäßiger Einsatz von Parallelität führt zu Verzögerungen bei der Dienstantwort und Ressourcenkonkurrenz, was sich in einer hohen CPU-Auslastung und einem hohen Aufwand für die Speicherbereinigung äußert.

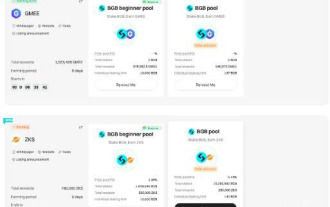

Was ist Bitget Launchpool? Wie verwende ich Bitget Launchpool?

Jun 07, 2024 pm 12:06 PM

Was ist Bitget Launchpool? Wie verwende ich Bitget Launchpool?

Jun 07, 2024 pm 12:06 PM

BitgetLaunchpool ist eine dynamische Plattform, die für alle Kryptowährungsbegeisterten entwickelt wurde. BitgetLaunchpool zeichnet sich durch sein einzigartiges Angebot aus. Hier können Sie Ihre Token einsetzen, um weitere Belohnungen freizuschalten, darunter Airdrops, hohe Renditen und einen großzügigen Preispool, der nur frühen Teilnehmern vorbehalten ist. Was ist BitgetLaunchpool? BitgetLaunchpool ist eine Kryptowährungsplattform, auf der Token zu benutzerfreundlichen Bedingungen eingesetzt und verdient werden können. Durch die Investition von BGB oder anderen Token in Launchpool haben Benutzer die Möglichkeit, kostenlose Airdrops und Einnahmen zu erhalten und an großzügigen Bonuspools teilzunehmen. Die Einnahmen aus verpfändeten Vermögenswerten werden innerhalb von T+1 Stunden berechnet und die Belohnungen basieren darauf

Golang-Technologiebibliotheken und Tools für maschinelles Lernen

May 08, 2024 pm 09:42 PM

Golang-Technologiebibliotheken und Tools für maschinelles Lernen

May 08, 2024 pm 09:42 PM

Zu den Bibliotheken und Tools für maschinelles Lernen in der Go-Sprache gehören: TensorFlow: eine beliebte Bibliothek für maschinelles Lernen, die Tools zum Erstellen, Trainieren und Bereitstellen von Modellen bereitstellt. GoLearn: Eine Reihe von Klassifizierungs-, Regressions- und Clustering-Algorithmen. Gonum: Eine wissenschaftliche Computerbibliothek, die Matrixoperationen und lineare Algebrafunktionen bereitstellt.

Wie verwende ich Caching im verteilten Golang-System?

Jun 01, 2024 pm 09:27 PM

Wie verwende ich Caching im verteilten Golang-System?

Jun 01, 2024 pm 09:27 PM

Im verteilten Go-System kann Caching mithilfe des Groupcache-Pakets implementiert werden. Dieses Paket bietet eine allgemeine Caching-Schnittstelle und unterstützt mehrere Caching-Strategien wie LRU, LFU, ARC und FIFO. Durch die Nutzung von Groupcache kann die Anwendungsleistung deutlich verbessert, die Backend-Last reduziert und die Systemzuverlässigkeit erhöht werden. Die spezifische Implementierungsmethode lautet wie folgt: Importieren Sie die erforderlichen Pakete, legen Sie die Cache-Pool-Größe fest, definieren Sie den Cache-Pool, legen Sie die Cache-Ablaufzeit fest, legen Sie die Anzahl gleichzeitiger Wertanforderungen fest und verarbeiten Sie die Ergebnisse der Wertanforderungen.

Die Rolle der Golang-Technologie in der mobilen IoT-Entwicklung

May 09, 2024 pm 03:51 PM

Die Rolle der Golang-Technologie in der mobilen IoT-Entwicklung

May 09, 2024 pm 03:51 PM

Aufgrund ihrer hohen Parallelität, Effizienz und plattformübergreifenden Natur ist die Go-Sprache eine ideale Wahl für die Entwicklung mobiler Internet-of-Things-Anwendungen (IoT). Das Parallelitätsmodell von Go erreicht durch Goroutinen (Lightweight Coroutines) einen hohen Grad an Parallelität, der für die Handhabung einer großen Anzahl gleichzeitig verbundener IoT-Geräte geeignet ist. Der geringe Ressourcenverbrauch von Go trägt dazu bei, Anwendungen auf mobilen Geräten mit begrenzter Rechenleistung und Speicherkapazität effizient auszuführen. Darüber hinaus ermöglicht die plattformübergreifende Unterstützung von Go die einfache Bereitstellung von IoT-Anwendungen auf einer Vielzahl mobiler Geräte. Der praktische Fall demonstriert die Verwendung von Go zum Erstellen einer BLE-Temperatursensoranwendung, die Kommunikation mit dem Sensor über BLE und die Verarbeitung eingehender Daten zum Lesen und Anzeigen von Temperaturmesswerten.