Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

NVIDIA veröffentlicht eine dedizierte ChatGPT-GPU, die die Inferenzgeschwindigkeit um das Zehnfache erhöht

NVIDIA veröffentlicht eine dedizierte ChatGPT-GPU, die die Inferenzgeschwindigkeit um das Zehnfache erhöht

NVIDIA veröffentlicht eine dedizierte ChatGPT-GPU, die die Inferenzgeschwindigkeit um das Zehnfache erhöht

Es war einmal, als die künstliche Intelligenz aufgrund unzureichender Rechenleistung in einen jahrzehntelangen Engpass geriet und die GPU Deep Learning in Gang setzte. Im Zeitalter von ChatGPT steht die KI erneut vor dem Problem unzureichender Rechenleistung aufgrund großer Modelle. Hat NVIDIA dieses Mal eine Lösung?

Am 22. März fand die GTC-Konferenz offiziell statt. Bei der gerade abgehaltenen Keynote holte NVIDIA-CEO Jensen Huang die für ChatGPT vorbereiteten Chips heraus.

„Computing zu beschleunigen ist nicht einfach. Im Jahr 2012 nutzte das Computer-Vision-Modell AlexNet die GeForce GTX 580 und konnte 262 PetaFLOPS pro Sekunde verarbeiten. Dieses Modell löste eine Explosion der KI-Technologie aus“, sagte Huang. „Zehn Jahre später erschien Transformer. GPT-3 nutzte 323 ZettaFLOPS Rechenleistung, 1 Million Mal so viel wie AlexNet, um ChatGPT zu erstellen, eine KI, die die Welt schockierte. Eine neue Computerplattform erschien und die iPhone-Ära der KI ist angebrochen . „

Der Boom in der KI hat den Aktienkurs von Nvidia in diesem Jahr um 77 % steigen lassen. Derzeit beträgt der Marktwert von Nvidia 640 Milliarden US-Dollar, was fast dem Fünffachen von Intel entspricht. Die heutige Veröffentlichung zeigt uns jedoch, dass Nvidia noch nicht damit aufgehört hat.

Entwerfen dedizierter Rechenleistung für AIGC

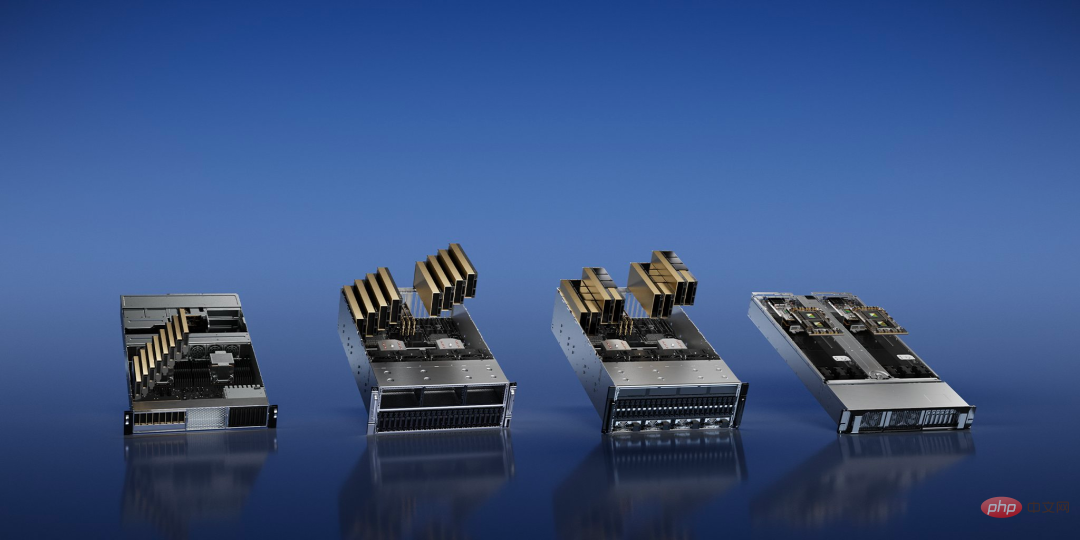

Die Entwicklung generativer KI (AIGC) verändert die Anforderungen von Technologieunternehmen an Rechenleistung. NVIDIA hat vier Inferenzplattformen für KI-Aufgaben gleichzeitig vorgestellt, die alle eine einheitliche Architektur verwenden.

Unter anderem bietet NVIDIA L4 „120-mal höhere KI-gesteuerte Videoleistung als CPU und 99 % Energieeffizienz“, die für Video-Streaming, Kodierung und Dekodierung sowie die Generierung von KI-Videos verwendet werden kann Leistung: Der leistungsstärkere NVIDIA L40 wird speziell für die 2D/3D-Bilderzeugung verwendet.

Als Reaktion auf ChatGPT, das enorme Rechenleistung erfordert, hat NVIDIA NVIDIA H100 NVL herausgebracht, eine dedizierte LLM-Lösung (Large Language Model) mit 94 GB Speicher und beschleunigter Transformer Engine, ausgestattet mit einer PCIE H100-GPU mit Dual-GPU-NVLINK .

„Derzeit ist die einzige GPU, die ChatGPT tatsächlich verarbeiten kann, die NVIDIA HGX A100. Im Vergleich zur ersteren ist ein Standardserver, der mit vier H100-Paaren und Dual-NVLINK ausgestattet ist, jetzt zehnmal schneller und kann große Mengen konvertieren Sprachmodelle Die Verarbeitungskosten werden um eine Größenordnung reduziert“, sagte Huang.

Schließlich gibt es NVIDIA Grace Hopper für Empfehlungsmodelle, das nicht nur für Empfehlungsaufgaben optimiert ist, sondern auch grafische neuronale Netze und Vektordatenbanken betreiben kann.

Lassen Sie Chips physikalische Grenzen durchbrechen

Derzeit stößt der Produktionsprozess von Halbleitern an die Grenzen, die die Physik erreichen kann. Was ist nach dem 2-nm-Prozess der Durchbruch? NVIDIA hat beschlossen, mit der primitivsten Phase der Chipherstellung zu beginnen – der Fotolithographie.

Grundsätzlich handelt es sich hierbei um ein Abbildungsproblem an den Grenzen der Physik. Bei fortschrittlichen Herstellungsprozessen sind viele Merkmale auf dem Chip kleiner als die Wellenlänge des im Druckprozess verwendeten Lichts, und das Design der Maske muss ständig geändert werden, ein Schritt, der als optische Proximity-Korrektur bezeichnet wird. Die Computerlithographie simuliert das Verhalten von Licht, wenn es mit dem Fotolack durch das Original interagiert. Dieses Verhalten wird anhand der Maxwell-Gleichungen beschrieben. Dies ist die rechenintensivste Aufgabe im Bereich Chip-Design und -Herstellung.

Jensen Huang kündigte auf der GTC eine neue Technologie namens CuLitho an, um das Design und die Herstellung von Halbleitern zu beschleunigen. Die Software nutzt Nvidia-Chips, um die Schritte zwischen dem softwarebasierten Chipdesign und der physischen Herstellung der Fotolithographiemasken zu beschleunigen, die zum Drucken des Designs auf den Chip verwendet werden.

CuLitho läuft auf GPUs und bietet 40-fache Leistungssteigerungen gegenüber aktuellen Lithografietechnologien, wodurch umfangreiche Rechenaufgaben beschleunigt werden, die derzeit Dutzende Milliarden CPU-Stunden pro Jahr verbrauchen. „Der Aufbau von H100 erfordert 89 Masken. Bei der Ausführung auf der CPU dauert eine Maske zwei Wochen, wenn H100 jedoch zur Ausführung auf CuLitho verwendet wird, dauert es nur 8 Stunden“, sagte Huang.

Das bedeutet, dass 500 NVIDIA DGX H100-Systeme die Arbeit von 40.000 CPU-Systemen ersetzen und alle Teile des rechnerischen Lithografieprozesses ausführen können, was dazu beiträgt, den Strombedarf und mögliche Auswirkungen auf die Umwelt zu reduzieren.

Dieser Fortschritt wird es ermöglichen, dass die Transistoren und Schaltkreise der Chips kleiner als heute sind, während gleichzeitig die Markteinführungszeit des Chips verkürzt und die Energieeffizienz in den riesigen Rechenzentren verbessert wird, die rund um die Uhr in Betrieb sind, um den Herstellungsprozess voranzutreiben.

Nvidia sagte, dass es mit ASML, Synopsys und TSMC zusammenarbeitet, um die Technologie auf den Markt zu bringen. Berichten zufolge wird TSMC im Juni mit den Vorbereitungen für die Testproduktion dieser Technologie beginnen.

„Die Chipindustrie ist die Grundlage für fast jede andere Industrie auf der Welt“, sagte Huang. „Mit Lithographietechnologie an den Grenzen der Physik können Fabs durch CuLitho und die Zusammenarbeit mit unseren Partnern TSMC, ASML und Synopsys die Produktion steigern, ihren CO2-Fußabdruck reduzieren und den Grundstein für 2 nm und mehr legen.“ Beschleunigtes Quantencomputersystem

Bei der heutigen Veranstaltung kündigte NVIDIA außerdem ein neues System an, das auf Quantenmaschinen basiert und Forschern, die an klassischem Quantencomputing mit hoher Leistung und geringer Latenz arbeiten, eine revolutionäre neue Architektur bietet.

Das Herzstück von DGX Quantum ist ein NVIDIA Grace Hopper-System, das über PCIe mit Quantum Machines OPX+ verbunden ist und eine Latenzzeit von weniger als einer Mikrosekunde zwischen der GPU und der Quantum Processing Unit (QPU) ermöglicht.

Tim Costa, Direktor für HPC und Quanten bei NVIDIA, sagte: „Quantenbeschleunigtes Supercomputing hat das Potenzial, Wissenschaft und Industrie neu zu gestalten, und NVIDIA DGX Quantum wird es Forschern ermöglichen, die Grenzen des klassischen Quantencomputings zu verschieben.“

Ja, deshalb hat NVIDIA die leistungsstarke Hopper-Architektur-GPU mit der neuen Grace-CPU des Unternehmens in „Grace Hopper“ integriert, um Superleistung für riesige KI- und HPC-Anwendungen bereitzustellen. Es bietet eine bis zu 10-fache Leistung für Anwendungen, die Terabytes an Daten verarbeiten, und gibt Forschern der Quantenklassik mehr Möglichkeiten, die komplexesten Probleme der Welt zu lösen.

DGX Quantum stattet Entwickler außerdem mit NVIDIA CUDA Quantum aus, einem leistungsstarken einheitlichen Software-Stack, der jetzt Open Source ist. CUDA Quantum ist eine hybride quantenklassische Computerplattform, die QPUs, GPUs und CPUs in einem System integriert und programmiert.

37.000 US-Dollar pro Monat, um Ihr eigenes ChatGPT auf der Webseite zu trainieren

Microsoft hat Hunderte Millionen Dollar ausgegeben, um Zehntausende A100 zu kaufen, um einen GPT-Supercomputer zu bauen. Vielleicht möchten Sie jetzt OpenAI und Microsoft mieten, um ChatGPT zu trainieren und müssen Sie sollten nach derselben GPU suchen, um Ihr eigenes großes Modell zu trainieren.Die von NVIDIA vorgeschlagene DGX Cloud bietet einen dedizierten NVIDIA DGX AI-Supercomputing-Cluster, gepaart mit NVIDIA AI-Software. Dieser Service ermöglicht jedem Unternehmen den Zugriff auf AI-Supercomputing über einen einfachen Webbrowser, wodurch die Notwendigkeit der Anschaffung, Bereitstellung und Verwaltung entfällt Komplexität der lokalen Infrastruktur.

Berichten zufolge verfügt jede DGX Cloud-Instanz über acht H100- oder A100-80-GB-Tensor-Core-GPUs mit insgesamt 640 GB GPU-Speicher pro Knoten. Eine leistungsstarke Fabric mit geringer Latenz, die mit NVIDIA Networking aufgebaut ist, stellt sicher, dass Arbeitslasten über Cluster miteinander verbundener Systeme skaliert werden können, sodass mehrere Instanzen als eine riesige GPU fungieren können, um die Leistungsanforderungen eines fortgeschrittenen KI-Trainings zu erfüllen.

Jetzt können Unternehmen einen DGX Cloud-Cluster auf monatlicher Basis mieten, um die Entwicklung großer Trainings-Workloads mit mehreren Knoten schnell und einfach zu skalieren, ohne auf beschleunigte Rechenressourcen warten zu müssen, die oft stark nachgefragt werden.

Der monatliche Mietpreis beginnt laut Huang Renxun bei 36.999 US-Dollar pro Instanz und Monat.

„Wir befinden uns im iPhone-Moment der künstlichen Intelligenz“, sagte Huang. „Startups versuchen, bahnbrechende Produkte und Geschäftsmodelle zu entwickeln, und etablierte Unternehmen wollen darauf reagieren. DGX Cloud bietet Kunden sofortigen Zugriff auf NVIDIA-KI-Supercomputing auf globaler Ebene.“ in der Cloud.“

Jetzt können Benutzer NVIDIA NeMo-Sprachdienste und NVIDIA Picasso-Bild-, Video- und 3D-Dienste nutzen, um proprietäre, domänenspezifische generative KI-Anwendungen für intelligente Konversation und Kundensupport, professionelle Inhaltserstellung, digitale Simulation usw. zu erstellen. Unabhängig davon kündigte NVIDIA neue Modelle des Biologie-Cloud-Dienstes NVIDIA BioNeMo an.

„Generative KI ist ein neuer Computertyp, der in natürlicher menschlicher Sprache programmiert werden kann. Diese Fähigkeit ist weitreichend – jeder kann Computer befehlen, Probleme zu lösen, was vor nicht allzu langer Zeit die Domäne von Programmierern war. Patent“, sagte Huang.

Der heutigen Veröffentlichung zufolge verbessert NVIDIA nicht nur kontinuierlich das Hardwaredesign für die KI-Workloads von Technologieunternehmen, sondern schlägt auch neue Geschäftsmodelle vor. In den Augen einiger möchte NVIDIA „TSMC im Bereich KI“ sein: fortschrittliche produktive Gießereidienstleistungen wie eine Waferfabrik bereitstellen und darüber hinaus anderen Unternehmen dabei helfen, KI-Algorithmen für ihre spezifischen Szenarien zu trainieren.

Wird dies die zukünftige Richtung der KI-Entwicklung sein, indem wir das Supercomputer-Training von NVIDIA nutzen, um die Notwendigkeit von Zwischenhändlern, die den Preisunterschied verdienen, direkt zu eliminieren?

Das obige ist der detaillierte Inhalt vonNVIDIA veröffentlicht eine dedizierte ChatGPT-GPU, die die Inferenzgeschwindigkeit um das Zehnfache erhöht. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

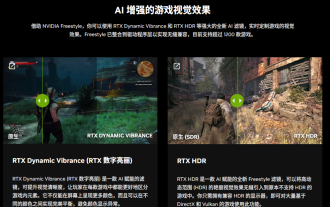

NVIDIA führt RTX HDR-Funktion ein: Nicht unterstützte Spiele nutzen KI-Filter, um wunderschöne visuelle HDR-Effekte zu erzielen

Feb 24, 2024 pm 06:37 PM

NVIDIA führt RTX HDR-Funktion ein: Nicht unterstützte Spiele nutzen KI-Filter, um wunderschöne visuelle HDR-Effekte zu erzielen

Feb 24, 2024 pm 06:37 PM

Laut Nachrichten dieser Website vom 23. Februar hat NVIDIA gestern Abend die NVIDIA-Anwendung aktualisiert und gestartet und bietet Spielern ein neues einheitliches GPU-Kontrollzentrum, das es Spielern ermöglicht, wunderbare Momente durch das leistungsstarke Aufzeichnungstool des In-Game-Floating festzuhalten Fenster. In diesem Update hat NVIDIA auch die RTXHDR-Funktion eingeführt. Die offizielle Einführung ist wie folgt beigefügt: RTXHDR ist ein neuer KI-gestützter Freestyle-Filter, der die großartigen visuellen Effekte von High Dynamic Range (HDR) nahtlos in Spiele einführen kann, die dies ursprünglich nicht tun unterstützt HDR. Sie benötigen lediglich einen HDR-kompatiblen Monitor, um diese Funktion mit einer Vielzahl von DirectX- und Vulkan-basierten Spielen nutzen zu können. Nachdem der Player die RTXHDR-Funktion aktiviert hat, läuft das Spiel auch dann, wenn es HD nicht unterstützt

Es wird berichtet, dass Grafikkarten der NVIDIA RTX 50-Serie nativ mit einer 16-Pin-PCIe-Gen-6-Stromversorgungsschnittstelle ausgestattet sind

Feb 20, 2024 pm 12:00 PM

Es wird berichtet, dass Grafikkarten der NVIDIA RTX 50-Serie nativ mit einer 16-Pin-PCIe-Gen-6-Stromversorgungsschnittstelle ausgestattet sind

Feb 20, 2024 pm 12:00 PM

Laut Nachrichten dieser Website vom 19. Februar enthüllte Moderator Tom im neuesten Video von Moores LawisDead-Kanal, dass Grafikkarten der Nvidia GeForce RTX50-Serie nativ mit einer PCIeGen6 16-Pin-Stromversorgungsschnittstelle ausgestattet sein werden. Tom sagte, dass neben den High-End-Serien GeForceRTX5080 und GeForceRTX5090 auch die Mittelklasse-GeForceRTX5060 neue Stromversorgungsschnittstellen ermöglichen wird. Berichten zufolge hat Nvidia klare Vorgaben gemacht, dass künftig jede GeForce RTX50-Serie mit einer PCIeGen6 16-Pin-Stromversorgungsschnittstelle ausgestattet sein soll, um die Lieferkette zu vereinfachen. Die dieser Seite beigefügten Screenshots lauten wie folgt: Tom sagte auch, dass GeForceRTX5090

Die Grafikkarten NVIDIA RTX 4070 und 4060 Ti FE sind unter den empfohlenen Verkaufspreis von 4599 bzw. 2999 Yuan gefallen

Feb 22, 2024 pm 09:43 PM

Die Grafikkarten NVIDIA RTX 4070 und 4060 Ti FE sind unter den empfohlenen Verkaufspreis von 4599 bzw. 2999 Yuan gefallen

Feb 22, 2024 pm 09:43 PM

Laut den Nachrichten dieser Website vom 22. Februar haben NVIDIA und AMD im Allgemeinen Beschränkungen bei der Kanalpreisgestaltung, und einige Händler, die privat die Preise erheblich senken, werden ebenfalls bestraft. Beispielsweise hat AMD kürzlich Händler bestraft, die 6750GRE-Grafikkarten zu niedrigeren Preisen verkauft haben Der Mindestpreis wurde bestraft. Diese Seite hat festgestellt, dass die NVIDIA GeForce RTX 4070 und 4060 Ti auf Rekordtiefs gefallen sind. Die Version ihres Gründers, also die öffentliche Version der Grafikkarte, kann derzeit im selbst betriebenen Store von JD.com mit einem Gutschein im Wert von 200 Yuan erhalten werden Preise von 4.599 Yuan und 2.999 Yuan. Wenn Sie Drittanbieter-Shops in Betracht ziehen, fallen natürlich niedrigere Preise an. In Bezug auf die Parameter verfügt die RTX4070-Grafikkarte über einen 5888CUDA-Kern, verwendet 12 GBGDDR6X-Speicher und eine Bitbreite von 192 Bi

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Das NVIDIA-Dialogmodell ChatQA wurde auf Version 2.0 weiterentwickelt, wobei die angegebene Kontextlänge 128 KB beträgt

Jul 26, 2024 am 08:40 AM

Die offene LLM-Community ist eine Ära, in der hundert Blumen blühen und konkurrieren. Sie können Llama-3-70B-Instruct, QWen2-72B-Instruct, Nemotron-4-340B-Instruct, Mixtral-8x22BInstruct-v0.1 und viele andere sehen hervorragende Darsteller. Allerdings weisen offene Modelle im Vergleich zu den proprietären Großmodellen GPT-4-Turbo in vielen Bereichen noch erhebliche Lücken auf. Zusätzlich zu allgemeinen Modellen wurden einige offene Modelle entwickelt, die sich auf Schlüsselbereiche spezialisieren, wie etwa DeepSeek-Coder-V2 für Programmierung und Mathematik und InternVL für visuelle Sprachaufgaben.

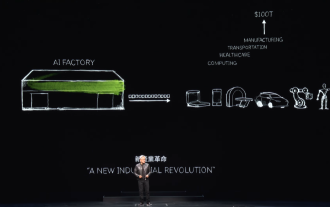

„AI Factory' wird die Neugestaltung des gesamten Software-Stacks vorantreiben, und NVIDIA stellt Llama3-NIM-Container für die Bereitstellung durch Benutzer bereit

Jun 08, 2024 pm 07:25 PM

„AI Factory' wird die Neugestaltung des gesamten Software-Stacks vorantreiben, und NVIDIA stellt Llama3-NIM-Container für die Bereitstellung durch Benutzer bereit

Jun 08, 2024 pm 07:25 PM

Laut Nachrichten dieser Website vom 2. Juni stellte Huang Renxun bei der laufenden Keynote-Rede von Huang Renxun 2024 Taipei Computex vor, dass generative künstliche Intelligenz die Neugestaltung des gesamten Software-Stacks fördern wird, und demonstrierte seine cloudnativen Mikrodienste NIM (Nvidia Inference Microservices). . Nvidia glaubt, dass die „KI-Fabrik“ eine neue industrielle Revolution auslösen wird: Am Beispiel der von Microsoft vorangetriebenen Softwareindustrie glaubt Huang Renxun, dass generative künstliche Intelligenz deren Umgestaltung im gesamten Stack vorantreiben wird. Um die Bereitstellung von KI-Diensten durch Unternehmen jeder Größe zu erleichtern, hat NVIDIA im März dieses Jahres die cloudnativen Mikrodienste NIM (Nvidia Inference Microservices) eingeführt. NIM+ ist eine Suite cloudnativer Mikroservices, die darauf optimiert sind, die Markteinführungszeit zu verkürzen

Warum ist Vanar Chain nach mehreren Transformationen und der Zusammenarbeit mit dem KI-Riesen Nvidia innerhalb von 30 Tagen um das 4,6-fache gestiegen?

Mar 14, 2024 pm 05:31 PM

Warum ist Vanar Chain nach mehreren Transformationen und der Zusammenarbeit mit dem KI-Riesen Nvidia innerhalb von 30 Tagen um das 4,6-fache gestiegen?

Mar 14, 2024 pm 05:31 PM

In letzter Zeit hat die Layer-1-Blockchain VanarChain aufgrund ihrer hohen Wachstumsrate und der Zusammenarbeit mit dem KI-Riesen NVIDIA die Aufmerksamkeit des Marktes auf sich gezogen. Hinter der Popularität von VanarChain stehen nicht nur zahlreiche Markentransformationen, sondern auch beliebte Konzepte wie Hauptspiele, Metaverse und KI, die dem Projekt viel Popularität und Themen eingebracht haben. Vor seiner Umwandlung wurde Vanar, ehemals TerraVirtua, im Jahr 2018 als Plattform gegründet, die kostenpflichtige Abonnements unterstützte, Inhalte für Virtual Reality (VR) und Augmented Reality (AR) bereitstellte und Zahlungen in Kryptowährung akzeptierte. Die Plattform wurde von den Mitbegründern Gary Bracey und Jawad Ashraf erstellt, wobei Gary Bracey über umfangreiche Erfahrung in der Produktion und Entwicklung von Videospielen verfügt.

RTX 4080 ist 15 % schneller als RTX 4070 Ti Super und die Nicht-Super-Version ist 8 % langsamer.

Jan 24, 2024 pm 01:27 PM

RTX 4080 ist 15 % schneller als RTX 4070 Ti Super und die Nicht-Super-Version ist 8 % langsamer.

Jan 24, 2024 pm 01:27 PM

Laut den Nachrichten dieser Website vom 23. Januar ist die Nvidia GeForce RTX4070TiSuper-Grafikkarte nach Angaben des ausländischen Technologiemediums Videocardz basierend auf den 3DMark-Testergebnissen 15 % langsamer als die RTX4080 und 8 % schneller als die RTX4070Ti-Grafikkarte. Dem Medienbericht zufolge testen mehrere Tester die Grafikkarte GeForce RTX4070TiSuper und werden in den nächsten Tagen detaillierte Testergebnisse bekannt geben. Einer der Rezensenten teilte die Nachricht anonym dem VideoCardz-Portal mit und teilte die Leistungsinformationen der Grafikkarte im synthetischen 3DMark-Test mit. Auf dieser Website wurde die Meinung der Medien zitiert, dass die folgenden Laufergebnisse die Leistung der RTX4070TiSuper nicht vollständig widerspiegeln können. R

TrendForce: Nvidias Blackwell-Plattformprodukte sorgen dafür, dass die CoWoS-Produktionskapazität von TSMC in diesem Jahr um 150 % steigt

Apr 17, 2024 pm 08:00 PM

TrendForce: Nvidias Blackwell-Plattformprodukte sorgen dafür, dass die CoWoS-Produktionskapazität von TSMC in diesem Jahr um 150 % steigt

Apr 17, 2024 pm 08:00 PM

Laut Nachrichten dieser Website vom 17. April hat TrendForce kürzlich einen Bericht veröffentlicht, in dem es davon ausgeht, dass die Nachfrage nach den neuen Blackwell-Plattformprodukten von Nvidia optimistisch ist und die gesamte CoWoS-Verpackungsproduktionskapazität von TSMC im Jahr 2024 voraussichtlich um mehr als 150 % steigen wird. Zu den neuen Blackwell-Plattformprodukten von NVIDIA gehören GPUs der B-Serie und GB200-Beschleunigerkarten, die NVIDIAs eigene GraceArm-CPU integrieren. TrendForce bestätigt, dass die Lieferkette derzeit sehr optimistisch in Bezug auf GB200 ist. Es wird geschätzt, dass die Auslieferungen im Jahr 2025 eine Million Einheiten überschreiten werden, was 40-50 % der High-End-GPUs von Nvidia ausmacht. Nvidia plant, in der zweiten Jahreshälfte Produkte wie GB200 und B100 auszuliefern, aber vorgelagerte Waferverpackungen müssen noch komplexere Produkte einführen.