Betrieb und Instandhaltung

Betrieb und Instandhaltung

Nginx

Nginx

So konfigurieren Sie den Lastausgleich für TCP im Nginx-Server

So konfigurieren Sie den Lastausgleich für TCP im Nginx-Server

So konfigurieren Sie den Lastausgleich für TCP im Nginx-Server

1. Installieren Sie nginx

1. Laden Sie nginx

# wget http://nginx.org/download/nginx-1.2.4.tar.gz

2 herunter #

# wget https://github.com/yaoweibin/nginx_tcp_proxy_module/tarball/master

Quellcode-Homepage: https://github.com/yaoweibin/nginx_tcp_proxy_module

3. Installieren Sie nginx

# tar xvf nginx-1.2.4.tar.gz # tar xvf yaoweibin-nginx_tcp_proxy_module-v0.4-45-ga40c99a.tar.gz # cd nginx-1.2.4 # patch -p1 < ../yaoweibin-nginx_tcp_proxy_module-a40c99a/tcp.patch #./configure --prefix=/usr/local/nginx --with-pcre=../pcre-8.30 --add-module=../yaoweibin-nginx_tcp_proxy_module-ae321fd/ # make # make install

II, Ändern Sie die Konfigurationsdatei

Ändern Sie die Konfigurationsdatei nginx.conf

# cd /usr/local/nginx/conf # vim nginx.conf

worker_processes 1;

events {

worker_connections 1024;

}

tcp {

upstream mssql {

server 10.0.1.201:1433;

server 10.0.1.202:1433;

check interval=3000 rise=2 fall=5 timeout=1000;

}

server {

listen 1433;

server_name 10.0.1.212;

proxy_pass mssql;

}

}3. Starten Sie nginx

#🎜🎜 ## cd /usr/local/nginx/sbin/

# ./nginx

Port 1433 anzeigen:

#lsof :1433

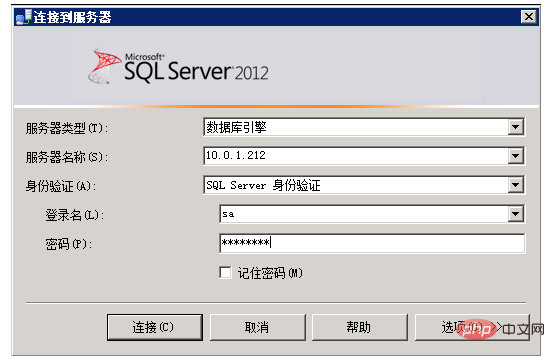

4. Test

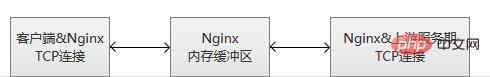

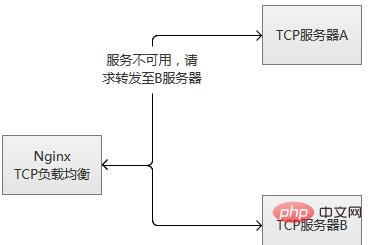

nginx überwacht die Client-Verbindung und die Upstream-Verbindung. Sobald die Daten empfangen werden, liest Nginx sie sofort und überträgt sie an die Upstream-Verbindung, ohne eine Datenerkennung innerhalb der TCP-Verbindung durchzuführen. Nginx unterhält einen Speicherpuffer für das Schreiben von Client- und Upstream-Daten. Wenn der Client oder Server eine große Datenmenge überträgt, erhöht der Puffer die Speichergröße entsprechend. Wenn ein Server wiederholt ausfällt (die durch max_fails oder fail_timeout konfigurierten Parameter überschreiten), wird Nginx den Server ebenfalls kicken. 60 Sekunden nach dem Start des Servers versucht Nginx gelegentlich, die Verbindung wiederherzustellen, um zu überprüfen, ob der Normalzustand wieder hergestellt ist. Wenn der Server wieder normal ist, fügt Nginx ihn wieder der Upstream-Gruppe hinzu und erhöht langsam den Anteil der Verbindungsanfragen. Der Grund für „langsam ansteigend“ liegt darin, dass ein Dienst normalerweise über „heiße Daten“ verfügt, d. h. mehr als 80 % oder mehr der Anfragen werden tatsächlich im „Hot Data Cache“ blockiert „Davon wird nur ein kleiner Teil der Anfragen tatsächlich bearbeitet. Wenn die Maschine gerade gestartet wird, ist der „Hot-Data-Cache“ noch nicht eingerichtet. Zu diesem Zeitpunkt wird eine große Anzahl von Anfragen explosionsartig weitergeleitet, was wahrscheinlich dazu führt, dass die Maschine nicht mehr „aushalten“ kann und wieder auflegt . Am Beispiel von MySQL fallen normalerweise mehr als 95 % unserer MySQL-Abfragen in den Speichercache und nicht viele Abfragen werden tatsächlich ausgeführt. Tatsächlich besteht dieses Risiko, unabhängig davon, ob es sich um eine einzelne Maschine oder einen Cluster handelt, beim Neustart oder beim Wechsel in einem Szenario mit hoher gleichzeitiger Anforderung. Es gibt zwei Möglichkeiten, es zu lösen: Das TCP-Lastausgleichsmodul unterstützt die integrierte Robustheitserkennung. Wenn ein Upstream-Server eine TCP-Verbindung länger als die konfigurierte Zeit für „proxy_connect_timeout“ verweigert, wird davon ausgegangen, dass sie fehlgeschlagen ist. In diesem Fall versucht Nginx sofort, eine Verbindung zu einem anderen normalen Server in der Upstream-Gruppe herzustellen. Informationen zu Verbindungsfehlern werden im Nginx-Fehlerprotokoll aufgezeichnet. Wenn ein Server wiederholt ausfällt (die durch max_fails oder fail_timeout konfigurierten Parameter überschreiten), wird Nginx den Server ebenfalls kicken. 60 Sekunden nach dem Hochfahren des Servers versucht Nginx gelegentlich, die Verbindung wiederherzustellen, um zu überprüfen, ob der Normalzustand wieder hergestellt ist. Wenn der Server wieder normal ist, fügt Nginx ihn wieder der Upstream-Gruppe hinzu und erhöht langsam den Anteil der Verbindungsanfragen. Der Grund für „langsam ansteigend“ liegt darin, dass ein Dienst normalerweise über „Hot Data“ verfügt, d. h. mehr als 80 % oder sogar mehr Anfragen werden tatsächlich im „Hot Data Cache“ blockiert. “, wird nur ein kleiner Teil der Anfragen tatsächlich bearbeitet. Wenn die Maschine gerade gestartet wird, ist der „Hot-Data-Cache“ noch nicht eingerichtet. Zu diesem Zeitpunkt wird eine große Anzahl von Anfragen explosionsartig weitergeleitet, was wahrscheinlich dazu führt, dass die Maschine nicht mehr „aushalten“ kann und wieder auflegt . Am Beispiel von MySQL fallen normalerweise mehr als 95 % unserer MySQL-Abfragen in den Speichercache und nicht viele Abfragen werden tatsächlich ausgeführt. Tatsächlich besteht dieses Risiko, unabhängig davon, ob es sich um eine einzelne Maschine oder einen Cluster handelt, beim Neustart oder beim Wechsel in einem Szenario mit hoher gleichzeitiger Anforderung. Es gibt zwei Möglichkeiten, es zu lösen: (2) Bereiten Sie „häufig verwendete“ Daten im Voraus vor, „heizen“ Sie den Dienst proaktiv vor und öffnen Sie dann den Zugriff auf den Server, nachdem das Vorheizen abgeschlossen ist. Das obige ist der detaillierte Inhalt vonSo konfigurieren Sie den Lastausgleich für TCP im Nginx-Server. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!# telnet 10.0.1.201 1433

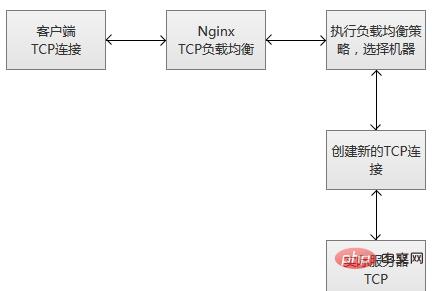

6. Ausführungsprinzip von TCP Lastausgleich# 🎜🎜#

TCP-Lastausgleich unterstützt den ursprünglichen Planungsalgorithmus von Nginx, einschließlich Round Robin (Standard, Abfrageplanung), Hash (konsistent auswählen) usw. Gleichzeitig arbeiten die Planungsinformationsdaten auch mit dem Robustheitserkennungsmodul zusammen, um für jede Verbindung den geeigneten Ziel-Upstream-Server auszuwählen. Wenn Sie die Planungsmethode für den Hash-Lastausgleich verwenden, können Sie $remote_addr (Client-IP) verwenden, um eine einfache dauerhafte Sitzung zu erreichen (Verbindungen mit derselben Client-IP erfolgen immer auf demselben Dienstserver).

Wie andere Upstream-Module unterstützt das TCP-Stream-Modul auch die benutzerdefinierte Weiterleitungsgewichtung für den Lastausgleich (Konfiguration „weight=2“) sowie Backup- und Down-Parameter zum Beheben von Ausfällen des Upstream-Servers. Der Parameter max_conns kann die Anzahl der TCP-Verbindungen eines Servers begrenzen und den entsprechenden Konfigurationswert entsprechend der Kapazität des Servers festlegen. Insbesondere in Szenarien mit hoher Parallelität kann er den Zweck des Überlastungsschutzes erreichen.

# 🎜🎜 #(1) Die Anfragen nehmen allmählich zu, von weniger zu mehr, es sammeln sich nach und nach Hotspot-Daten an und erreichen schließlich den normalen Servicestatus.

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

So konfigurieren Sie den Namen des Cloud -Server -Domänennamens in Nginx

Apr 14, 2025 pm 12:18 PM

So konfigurieren Sie den Namen des Cloud -Server -Domänennamens in Nginx

Apr 14, 2025 pm 12:18 PM

So konfigurieren Sie einen Nginx -Domänennamen auf einem Cloud -Server: Erstellen Sie einen Datensatz, der auf die öffentliche IP -Adresse des Cloud -Servers zeigt. Fügen Sie virtuelle Hostblöcke in die NGINX -Konfigurationsdatei hinzu, wobei der Hörport, Domänenname und das Root -Verzeichnis der Website angegeben werden. Starten Sie Nginx neu, um die Änderungen anzuwenden. Greifen Sie auf die Konfiguration des Domänennamens zu. Weitere Hinweise: Installieren Sie das SSL -Zertifikat, um HTTPS zu aktivieren, sicherzustellen, dass die Firewall den Verkehr von Port 80 ermöglicht, und warten Sie, bis die DNS -Auflösung wirksam wird.

So überprüfen Sie den Namen des Docker -Containers

Apr 15, 2025 pm 12:21 PM

So überprüfen Sie den Namen des Docker -Containers

Apr 15, 2025 pm 12:21 PM

Sie können den Namen des Docker -Containers abfragen, indem Sie den Schritten folgen: Alle Container auflisten (Docker PS). Filtern Sie die Containerliste (unter Verwendung des GREP -Befehls). Ruft den Containernamen ab (befindet sich in der Spalte "Namen").

So überprüfen Sie, ob Nginx gestartet wird

Apr 14, 2025 pm 01:03 PM

So überprüfen Sie, ob Nginx gestartet wird

Apr 14, 2025 pm 01:03 PM

So bestätigen Sie, ob Nginx gestartet wird: 1. Verwenden Sie die Befehlszeile: SystemCTL Status Nginx (Linux/Unix), Netstat -ano | FindStr 80 (Windows); 2. Überprüfen Sie, ob Port 80 geöffnet ist; 3. Überprüfen Sie die Nginx -Startmeldung im Systemprotokoll. 4. Verwenden Sie Tools von Drittanbietern wie Nagios, Zabbix und Icinga.

So konfigurieren Sie Nginx in Windows

Apr 14, 2025 pm 12:57 PM

So konfigurieren Sie Nginx in Windows

Apr 14, 2025 pm 12:57 PM

Wie konfiguriere ich Nginx in Windows? Installieren Sie NGINX und erstellen Sie eine virtuelle Hostkonfiguration. Ändern Sie die Hauptkonfigurationsdatei und geben Sie die Konfiguration der virtuellen Host ein. Starten oder laden Nginx neu. Testen Sie die Konfiguration und sehen Sie sich die Website an. Aktivieren Sie selektiv SSL und konfigurieren Sie SSL -Zertifikate. Stellen Sie die Firewall selektiv fest, damit Port 80 und 443 Verkehr.

So überprüfen Sie die Nginx -Version

Apr 14, 2025 am 11:57 AM

So überprüfen Sie die Nginx -Version

Apr 14, 2025 am 11:57 AM

Die Methoden, die die Nginx -Version abfragen können, sind: Verwenden Sie den Befehl nginx -v; Zeigen Sie die Versionsrichtlinie in der Datei nginx.conf an. Öffnen Sie die Nginx -Fehlerseite und sehen Sie sich den Seitentitel an.

So starten Sie einen Container von Docker

Apr 15, 2025 pm 12:27 PM

So starten Sie einen Container von Docker

Apr 15, 2025 pm 12:27 PM

Startschritte des Docker -Containers: Ziehen Sie das Containerbild: Führen Sie "Docker Pull [Mirror Name]" aus. Erstellen eines Containers: Verwenden Sie "Docker erstellen [Optionen] [Spiegelname] [Befehle und Parameter]". Starten Sie den Container: Führen Sie "Docker Start [Container Name oder ID]" aus. Containerstatus überprüfen: Stellen Sie sicher, dass der Container mit "Docker PS" ausgeführt wird.

So starten Sie den Nginx -Server

Apr 14, 2025 pm 12:27 PM

So starten Sie den Nginx -Server

Apr 14, 2025 pm 12:27 PM

Das Starten eines Nginx-Servers erfordert unterschiedliche Schritte gemäß verschiedenen Betriebssystemen: Linux/UNIX-System: Installieren Sie das NGINX-Paket (z. B. mit APT-Get oder Yum). Verwenden Sie SystemCTL, um einen Nginx -Dienst zu starten (z. B. sudo systemctl start nginx). Windows -System: Laden Sie Windows -Binärdateien herunter und installieren Sie sie. Starten Sie Nginx mit der ausführbaren Datei nginx.exe (z. B. nginx.exe -c conf \ nginx.conf). Unabhängig davon, welches Betriebssystem Sie verwenden, können Sie auf die Server -IP zugreifen

So erstellen Sie Container für Docker

Apr 15, 2025 pm 12:18 PM

So erstellen Sie Container für Docker

Apr 15, 2025 pm 12:18 PM

Erstellen Sie einen Container in Docker: 1. Ziehen Sie das Bild: Docker Pull [Spiegelname] 2. Erstellen Sie einen Container: Docker Ausführen [Optionen] [Spiegelname] [Befehl] 3. Starten Sie den Container: Docker Start [Containername]