Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Chinesisches Team unterwandert Lebenslauf! SEEM teilt alle Explosionen perfekt und teilt das „augenblickliche Universum' mit einem Klick auf

Chinesisches Team unterwandert Lebenslauf! SEEM teilt alle Explosionen perfekt und teilt das „augenblickliche Universum' mit einem Klick auf

Chinesisches Team unterwandert Lebenslauf! SEEM teilt alle Explosionen perfekt und teilt das „augenblickliche Universum' mit einem Klick auf

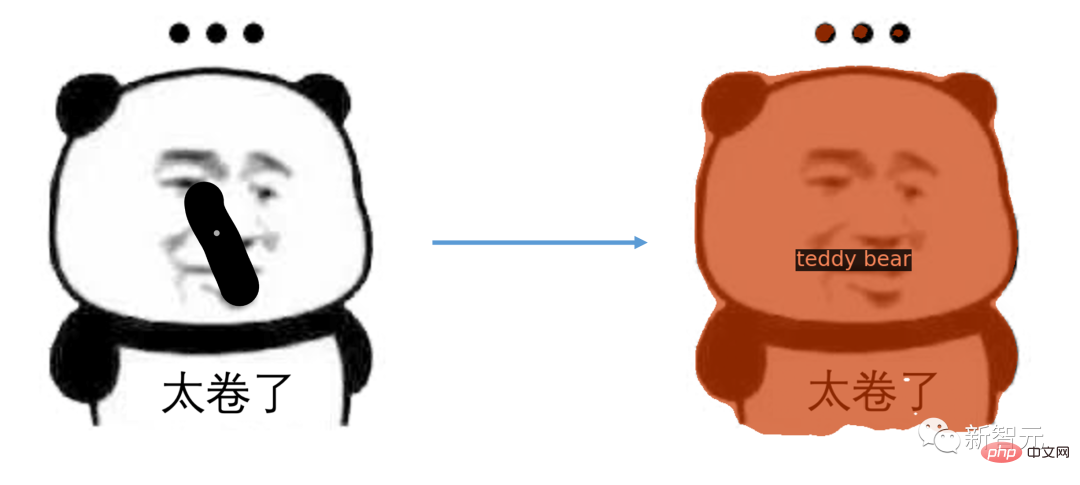

Das Aufkommen von Metas „Divide Everything“ ließ viele Menschen ausrufen, dass CV nicht mehr existiert.

Basierend auf diesem Modell haben viele Internetnutzer weitere Arbeiten durchgeführt, beispielsweise Grounded SAM.

Durch die gemeinsame Verwendung von Stable Diffusion, Whisper und ChatGPT können Sie einen Hund durch Stimme in einen Affen verwandeln.

Und jetzt können Sie durch multimodale Eingabeaufforderungen nicht nur per Spracheingabe alles überall gleichzeitig segmentieren.

Wie geht das konkret?

Klicken Sie mit der Maus, um den geteilten Inhalt direkt auszuwählen.

Öffne deinen Mund.

Wischen Sie einfach darüber und schon ist das komplette Emoticon-Paket da.

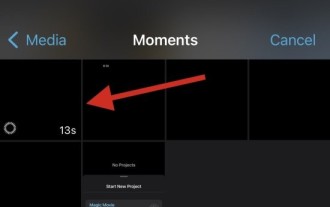

Sie können das Video sogar teilen.

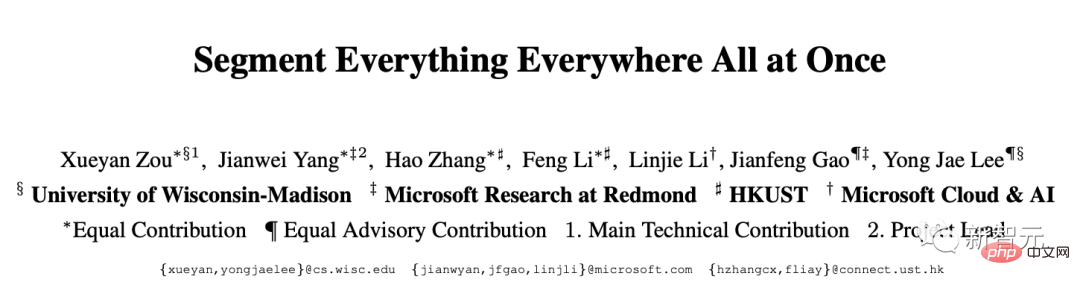

Die neueste Forschung zu SEEM wurde gemeinsam von Wissenschaftlern der University of Wisconsin-Madison, Microsoft Research und anderen Institutionen durchgeführt.

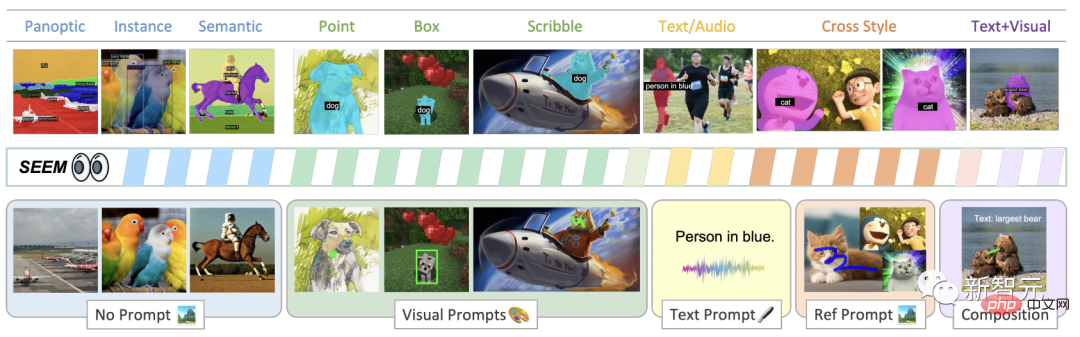

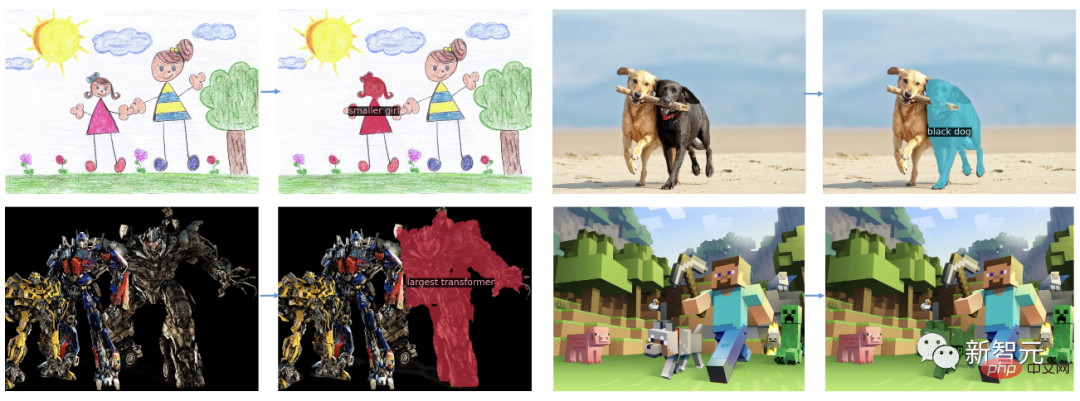

Segmentieren Sie Bilder ganz einfach mithilfe verschiedener Arten von Hinweisen, visuellen Hinweisen (Punkte, Markierungen, Kästchen, Kritzeleien und Bildfragmente) und verbalen Hinweisen (Text und Audio) mit SEEM.

Adresse des Artikels: https://arxiv.org/pdf/2304.06718.pdf

Das Interessante am Titel dieses Artikels ist, dass er sich auf eine amerikanische Science-Fiction bezieht Der 2022 erschienene Film „Everything Everywhere All at Once“ hat einen sehr ähnlichen Namen.

NVIDIA-Wissenschaftler Jim Fan sagte, dass der Oscar für die beste Arbeit an „Segment Everything Everywhere All at Once“ geht.

Eine einheitliche, multifunktionale Schnittstelle zur Aufgabenspezifikation ist die Grundlage für die Erweiterung Die Größe des großformatigen Modells ist der Schlüssel. Multimodale Eingabeaufforderungen sind der Weg der Zukunft.

Nachdem sie die Zeitung gelesen hatten, sagten Internetnutzer, dass der Lebenslauf jetzt beginnt, große Modelle zu akzeptieren. Wo ist die Zukunft für Doktoranden?

Oscar Best Titled Paper

Inspiriert durch die Entwicklung prompt-basierter universeller Schnittstellen für LLMs schlugen Forscher SEEM vor.

Wie in der Abbildung gezeigt, kann das SEEM-Modell jede Segmentierungsaufgabe im offenen Satz ohne Hinweise ausführen, z. B. semantische Segmentierung, Instanzsegmentierung und Panoramasegmentierung.

Darüber hinaus unterstützt es jede Kombination von visuellen, Text- und Zitatbereichshinweisen , was eine vielseitige und interaktive Referenzaufteilung ermöglicht.

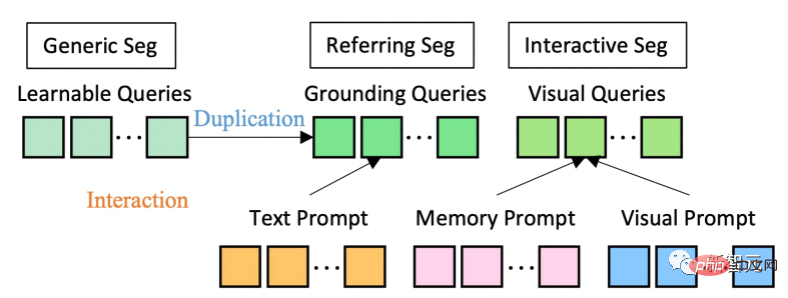

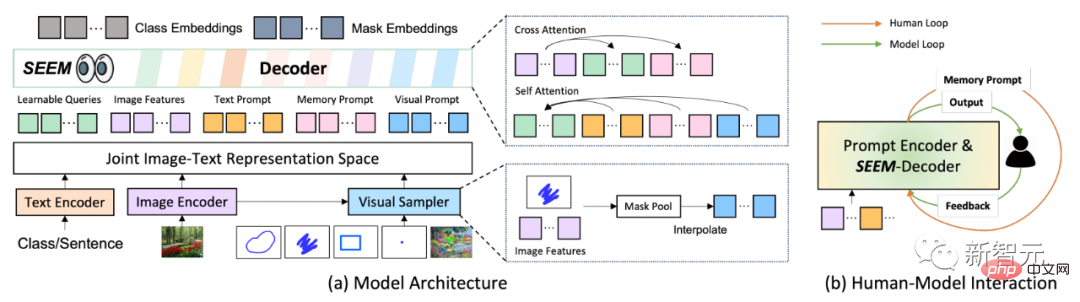

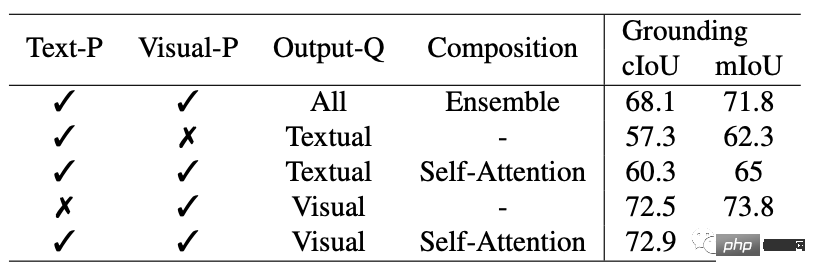

In Bezug auf die Modellarchitektur verwendet SEEM eine gemeinsame Encoder-Decoder-Architektur. Das Besondere daran ist die komplexe Interaktion zwischen Abfragen und Eingabeaufforderungen.

Funktionen und Hinweise werden vom entsprechenden Encoder oder Sampler-A-Gelenk codiert visueller semantischer Raum.

Lernbare Abfragen werden zufällig initialisiert, und der SEEM-Decoder akzeptiert lernbare Abfragen, Bildfunktionen und Textaufforderungen als Ein- und Ausgabe, einschließlich Klassen- und Maskeneinbettungen, für Maskierung und semantische Vorhersage.

Es ist erwähnenswert, dass das SEEM-Modell mehrere Interaktionsrunden aufweist. Jede Runde besteht aus einem manuellen Zyklus und einem Modellzyklus.

In der manuellen Schleife wird die Maskenausgabe der vorherigen Iteration manuell empfangen und durch visuelle Hinweise wird positives Feedback für die nächste Decodierungsrunde gegeben. In der Modellschleife empfängt und aktualisiert das Modell Speicherhinweise für zukünftige Vorhersagen.

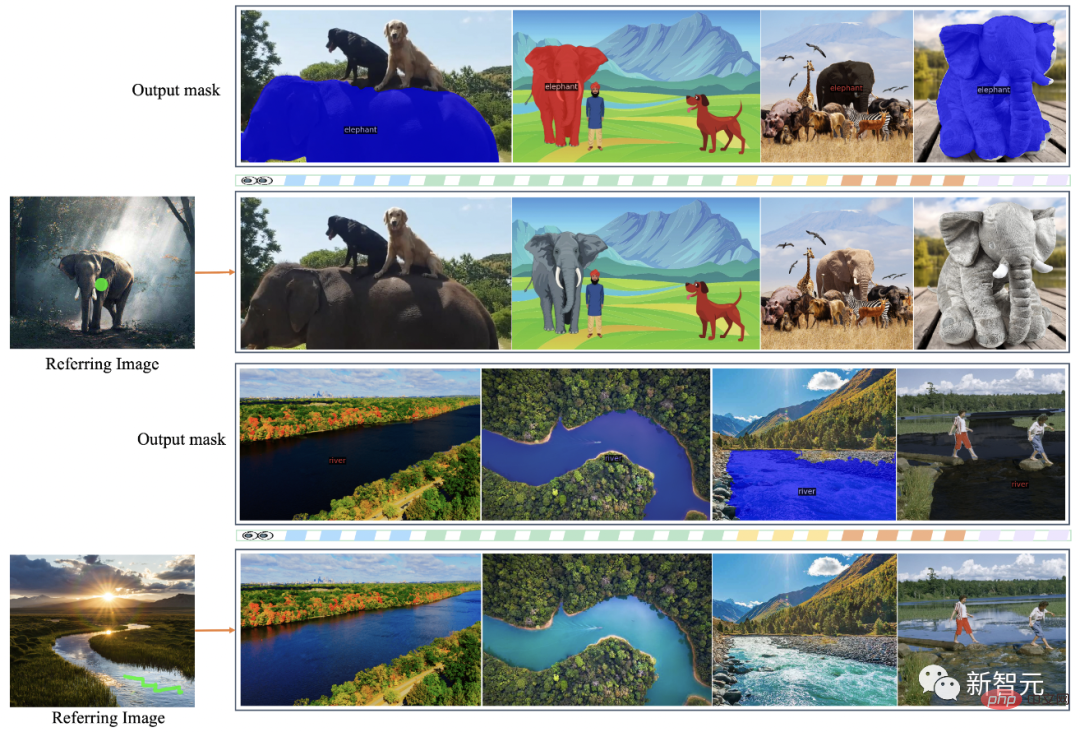

Über SEEM können Sie ein Bild des Optimus Prime-Trucks bereitstellen. Segmentieren Sie Optimus Prime auf einem beliebigen Zielbild.

Generieren Sie Masken aus vom Benutzer eingegebenem Text für die Segmentierung mit einem Klick.

Darüber hinaus können Sie mit SEEM Objekte mit ähnlicher Semantik segmentieren das Zielbild.

Darüber hinaus versteht SEEM räumliche Zusammenhänge sehr gut. Nachdem die Zebras in der oberen linken Reihe mit Graffiti versehen wurden, wird auch das Zebra ganz links segmentiert.

SEEM kann Bilder auch auf Videomasken verweisen, es ist kein Video erforderlich Datentraining kann Videos perfekt segmentieren.

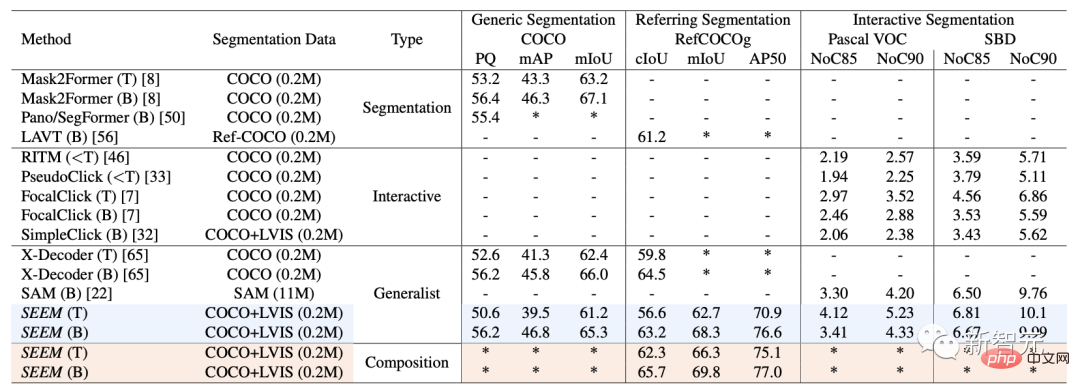

In Bezug auf Datensätze und Einstellungen wurde SEEM anhand von drei Datensätzen trainiert: Panoramasegmentierung, Referenzsegmentierung und interaktive Segmentierung.

Interaktive Segmentierung

Bei der interaktiven Segmentierung verglichen die Forscher SEEM mit modernsten interaktiven Segmentierungsmodellen.

Als allgemeines Modell hat SEEM eine vergleichbare Leistung wie RITM, SimpleClick usw. erreicht. Und es erreicht eine sehr ähnliche Leistung wie SAM und verwendet außerdem 50 weitere segmentierte Daten für das Training.

Bemerkenswerterweise unterstützt SEEM im Gegensatz zu bestehenden interaktiven Modellen nicht nur klassische Segmentierungsaufgaben, sondern auch eine breite Palette multimodaler Eingaben, darunter Text, Punkte, Kritzeleien, Begrenzungsrahmen und Bilder, die leistungsstarke Kombinationsmöglichkeiten bieten.

Universelle Segmentierung

Mit einem Satz von Parametern, die für alle Segmentierungsaufgaben vorab trainiert wurden, können Forscher die Leistung anhand universeller Segmentierungsdatensätze direkt bewerten.

SEEM erzielt eine bessere Leistung bei Panoramaansicht, Instanz und semantischer Segmentierung.

Forscher haben vier erwartete Ziele für SEEM:

1. Vielseitigkeit: Durch die Einführung einer multifunktionalen Eingabeaufforderungs-Engine zur Verarbeitung verschiedener Arten von Eingabeaufforderungen, einschließlich Punkten, Kästchen, Graffiti, Masken und Text und ein Referenzbereich eines anderen Bildes;

2. Durch das Erlernen eines gemeinsamen visuell-semantischen Raums, um sofortige Abfragen für visuelle und textuelle Hinweise zu kombinieren;

3 Konversationsverlaufsinformationen durch maskengesteuerte Kreuzaufmerksamkeit bewahren;

4. Semantisches Bewusstsein: Ermöglichen Sie die Segmentierung des offenen Vokabulars, indem Sie Textabfragen und Maskierungstags verwenden. Der Unterschied zwischen

und SAM

Das von Meta vorgeschlagene SAM-Modell kann einen Punkt, einen Begrenzungsrahmen und einen Satz in einem einheitlichen Framework angeben, das den Encoder dazu auffordert, Objekte mit einem Klick zu segmentieren.

SAM verfügt über eine breite Vielseitigkeit, das heißt, es verfügt über die Fähigkeit zur Übertragung ohne Proben, was ausreicht, um verschiedene Anwendungsfälle abzudecken. Es erfordert keine zusätzliche Schulung und kann sofort verwendet werden in neuen Bildfeldern, unabhängig davon, ob es sich um ein Unterwasserfoto oder ein Zellmikroskop handelt.

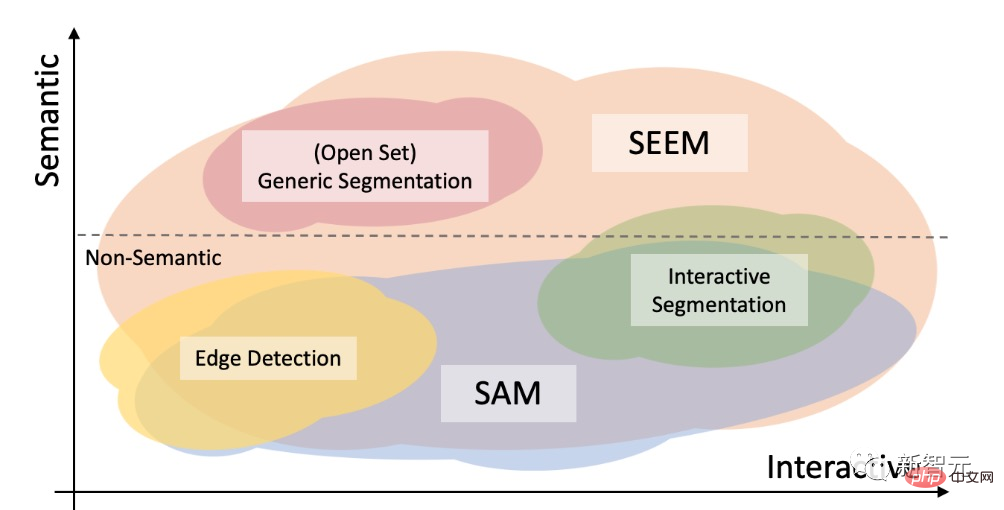

Die Forscher verglichen SEEM und SAM hinsichtlich ihrer interaktiven und semantischen Fähigkeiten für drei Segmentierungsaufgaben (Kantenerkennung, offene Menge und interaktive Segmentierung).

Die Segmentierung offener Mengen erfordert auch eine Semantik auf hoher Ebene und erfordert keine Interaktion.

Im Vergleich zu SAM deckt SEEM ein breiteres Spektrum an Interaktionen und semantischen Ebenen ab.

SAM unterstützt nur begrenzte Interaktionstypen wie Punkte und Begrenzungsrahmen und ignoriert Aufgaben mit hoher Semantik, da es selbst keine semantischen Beschriftungen ausgibt.

Für SEEM haben Forscher zwei Highlights hervorgehoben:

Erstens verfügt SEEM über einen einheitlichen Cue-Encoder, der alle visuellen und sprachlichen Hinweise in einem gemeinsamen Darstellungsraum kodiert. Daher kann SEEM eine allgemeinere Verwendung unterstützen und möglicherweise auf benutzerdefinierte Eingabeaufforderungen erweitert werden.

Zweitens leistet SEEM hervorragende Arbeit bei der Textmaskierung und der Ausgabe semantikbewusster Vorhersagen.

Vorstellung des Autors

Die Erstautorin des Artikels Xueyan Zou

Sie ist derzeit Doktorandin am Fachbereich Informatik der University of Wisconsin-Madison und ihre Betreuerin ist Professor Yong Jae Lee.

Zuvor verbrachte Zou drei Jahre an der University of California, Davis, unter der Leitung desselben Mentors und arbeitete eng mit Dr. Fanyi Xiao zusammen.

Sie erhielt ihren Bachelor-Abschluss von der Hong Kong Baptist University unter der Betreuung von Professor PC Yuen und Professor Chu Xiaowen.

Jianwei Yang

Yang ist leitender Forscher in der Deep-Learning-Gruppe von Microsoft Research in Redmond unter der Leitung von Dr. Jianfeng Gao.

Yangs Forschung konzentriert sich hauptsächlich auf Computer Vision, Vision und Sprache sowie maschinelles Lernen. Er konzentriert sich auf verschiedene Ebenen des strukturierten visuellen Verständnisses und darauf, wie diese für die intelligente Interaktion mit Menschen durch Sprache und Umweltverkörperung weiter genutzt werden können.

Bevor er im März 2020 zu Microsoft kam, promovierte Yang in Informatik an der School of Interactive Computing der Georgia Tech, wo sein Berater Professor Devi Parikh war, und er arbeitete auch eng mit Professor Dhruv Batra zusammen.

Gao Jianfeng

Gao Jianfeng ist ein angesehener Wissenschaftler und Vizepräsident von Microsoft Research, ein Mitglied von IEEE und ein angesehenes Mitglied von ACM.

Derzeit leitet Gao Jianfeng die Deep-Learning-Gruppe. Die Mission der Gruppe besteht darin, den Stand der Technik des Deep Learning und seiner Anwendungen im natürlichen Sprach- und Bildverständnis voranzutreiben und Fortschritte bei Konversationsmodellen und -methoden zu erzielen.

Die Forschung umfasst hauptsächlich neuronale Sprachmodelle für das Verständnis und die Erzeugung natürlicher Sprache, neuronales symbolisches Computing, Grundlagen und Verständnis visueller Sprache, künstliche Konversationsintelligenz usw.

Von 2014 bis 2018 war Gao Jianfeng als Partnerforschungsmanager für kommerzielle künstliche Intelligenz in der Abteilung für künstliche Intelligenz und Forschung von Microsoft und im Deep Learning Technology Center (DLTC) von Redmond Microsoft Research tätig.

Von 2006 bis 2014 war Gao Jianfeng leitender Forscher in der Gruppe zur Verarbeitung natürlicher Sprache.

Yong Jae Lee

Lee ist außerordentlicher Professor am Fachbereich Informatik der University of Washington, Madison.

Er verbrachte ein Jahr als Gastdozent für künstliche Intelligenz bei Cruise, bevor er im Herbst 2021 an die UW-Madison kam, und davor war er 6 Jahre lang als Assistenz- und außerordentlicher Professor an der University of California, Davis tätig.

Er verbrachte außerdem ein Jahr als Postdoktorand am Robotics Institute der Carnegie Mellon University.

Er erhielt seinen Doktortitel im Mai 2012 von der University of Texas in Austin bei Kristen Grauman und seinen BA von der University of Illinois in Urbana-Champaign im Mai 2006.

Außerdem arbeitete er als Sommerpraktikant bei Microsoft Research bei Larry Zitnick und Michael Cohen.

Derzeit konzentriert sich Lees Forschung auf Computer Vision und maschinelles Lernen. Lee ist besonders daran interessiert, leistungsstarke visuelle Erkennungssysteme zu entwickeln, die visuelle Daten mit minimaler menschlicher Aufsicht verstehen können.

Derzeit hat SEEM eine Demo geöffnet:

https://huggingface.co/spaces/xdecoder/SEEM

Beeilen Sie sich und probieren Sie es aus.

Das obige ist der detaillierte Inhalt vonChinesisches Team unterwandert Lebenslauf! SEEM teilt alle Explosionen perfekt und teilt das „augenblickliche Universum' mit einem Klick auf. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Wo werden Videodateien im Browser-Cache gespeichert?

Feb 19, 2024 pm 05:09 PM

Wo werden Videodateien im Browser-Cache gespeichert?

Feb 19, 2024 pm 05:09 PM

In welchem Ordner speichert der Browser das Video? Wenn wir den Internetbrowser täglich nutzen, schauen wir uns häufig verschiedene Online-Videos an, z. B. Musikvideos auf YouTube oder Filme auf Netflix. Diese Videos werden während des Ladevorgangs vom Browser zwischengespeichert, sodass sie bei späterer erneuter Wiedergabe schnell geladen werden können. Die Frage ist also: In welchem Ordner werden diese zwischengespeicherten Videos tatsächlich gespeichert? Verschiedene Browser speichern zwischengespeicherte Videoordner an unterschiedlichen Orten. Im Folgenden stellen wir einige gängige Browser und deren Funktionen vor

Ist es ein Verstoß, die Videos anderer Leute auf Douyin zu posten? Wie werden Videos ohne Rechtsverletzung bearbeitet?

Mar 21, 2024 pm 05:57 PM

Ist es ein Verstoß, die Videos anderer Leute auf Douyin zu posten? Wie werden Videos ohne Rechtsverletzung bearbeitet?

Mar 21, 2024 pm 05:57 PM

Mit dem Aufkommen von Kurzvideoplattformen ist Douyin zu einem unverzichtbaren Bestandteil des täglichen Lebens eines jeden geworden. Auf TikTok können wir interessante Videos aus aller Welt sehen. Manche Leute posten gerne die Videos anderer Leute, was die Frage aufwirft: Verstößt Douyin gegen das Posten der Videos anderer Leute? In diesem Artikel wird dieses Problem erörtert und Ihnen erklärt, wie Sie Videos ohne Rechtsverletzung bearbeiten und Probleme mit Rechtsverletzungen vermeiden können. 1. Verstößt es gegen Douyins Veröffentlichung von Videos anderer Personen? Gemäß den Bestimmungen des Urheberrechtsgesetzes meines Landes stellt die unbefugte Nutzung der Werke des Urheberrechtsinhabers ohne die Erlaubnis des Urheberrechtsinhabers einen Verstoß dar. Daher stellt das Posten von Videos anderer Personen auf Douyin ohne die Erlaubnis des ursprünglichen Autors oder Urheberrechtsinhabers einen Verstoß dar. 2. Wie bearbeite ich ein Video ohne Urheberrechtsverletzung? 1. Verwendung von gemeinfreien oder lizenzierten Inhalten: Öffentlich

So entfernen Sie Video-Wasserzeichen in Wink

Feb 23, 2024 pm 07:22 PM

So entfernen Sie Video-Wasserzeichen in Wink

Feb 23, 2024 pm 07:22 PM

Wie entferne ich Wasserzeichen aus Videos in Wink? Es gibt ein Tool zum Entfernen von Wasserzeichen aus Videos in Wink, aber die meisten Freunde wissen nicht, wie man Wasserzeichen aus Videos in Wink entfernt Vom Herausgeber bereitgestelltes Text-Tutorial, interessierte Benutzer kommen vorbei und schauen es sich an! So entfernen Sie das Video-Wasserzeichen in Wink: 1. Öffnen Sie zunächst die Wink-App und wählen Sie im Startseitenbereich die Funktion [Wasserzeichen entfernen] aus. 2. Wählen Sie dann das Video aus, bei dem Sie das Wasserzeichen entfernen möchten in der oberen rechten Ecke nach der Bearbeitung des Videos [√] 4. Klicken Sie abschließend auf [Ein-Klick-Drucken] und dann auf [Verarbeiten].

Wie kann man mit dem Posten von Videos auf Douyin Geld verdienen? Wie kann ein Neuling mit Douyin Geld verdienen?

Mar 21, 2024 pm 08:17 PM

Wie kann man mit dem Posten von Videos auf Douyin Geld verdienen? Wie kann ein Neuling mit Douyin Geld verdienen?

Mar 21, 2024 pm 08:17 PM

Douyin, die nationale Kurzvideoplattform, ermöglicht uns nicht nur, in unserer Freizeit eine Vielzahl interessanter und neuartiger Kurzvideos zu genießen, sondern gibt uns auch eine Bühne, um uns zu zeigen und unsere Werte zu verwirklichen. Wie kann man also Geld verdienen, indem man Videos auf Douyin veröffentlicht? Dieser Artikel wird diese Frage ausführlich beantworten und Ihnen dabei helfen, mit TikTok mehr Geld zu verdienen. 1. Wie kann man mit dem Posten von Videos auf Douyin Geld verdienen? Nachdem Sie ein Video gepostet und eine bestimmte Anzahl an Aufrufen auf Douyin erreicht haben, haben Sie die Möglichkeit, am Werbe-Sharing-Plan teilzunehmen. Diese Einkommensmethode ist eine der bekanntesten unter Douyin-Benutzern und stellt auch für viele YouTuber die Haupteinnahmequelle dar. Douyin entscheidet anhand verschiedener Faktoren wie Kontogewicht, Videoinhalt und Publikumsfeedback, ob Möglichkeiten zum Teilen von Werbung bereitgestellt werden sollen. Die TikTok-Plattform ermöglicht es Zuschauern, ihre Lieblingsschöpfer durch das Versenden von Geschenken zu unterstützen.

2 Möglichkeiten, Zeitlupe aus Videos auf dem iPhone zu entfernen

Mar 04, 2024 am 10:46 AM

2 Möglichkeiten, Zeitlupe aus Videos auf dem iPhone zu entfernen

Mar 04, 2024 am 10:46 AM

Auf iOS-Geräten können Sie mit der Kamera-App Zeitlupenvideos aufnehmen, oder sogar 240 Bilder pro Sekunde, wenn Sie das neueste iPhone besitzen. Mit dieser Funktion können Sie High-Speed-Aktionen detailreich erfassen. Aber manchmal möchten Sie vielleicht Zeitlupenvideos mit normaler Geschwindigkeit abspielen, damit Sie die Details und das Geschehen im Video besser wahrnehmen können. In diesem Artikel erklären wir alle Methoden zum Entfernen von Zeitlupe aus vorhandenen Videos auf dem iPhone. So entfernen Sie Zeitlupe aus Videos auf dem iPhone [2 Methoden] Sie können die Fotos-App oder die iMovie-App verwenden, um Zeitlupe aus Videos auf Ihrem Gerät zu entfernen. Methode 1: Mit der Fotos-App auf dem iPhone öffnen

Wie veröffentliche ich Xiaohongshu-Videowerke? Worauf sollte ich beim Posten von Videos achten?

Mar 23, 2024 pm 08:50 PM

Wie veröffentliche ich Xiaohongshu-Videowerke? Worauf sollte ich beim Posten von Videos achten?

Mar 23, 2024 pm 08:50 PM

Mit dem Aufkommen von Kurzvideoplattformen ist Xiaohongshu für viele Menschen zu einer Plattform geworden, auf der sie ihr Leben teilen, sich ausdrücken und Traffic gewinnen können. Auf dieser Plattform ist die Veröffentlichung von Videoarbeiten eine sehr beliebte Art der Interaktion. Wie veröffentlicht man also Xiaohongshu-Videoarbeiten? 1. Wie veröffentliche ich Xiaohongshu-Videowerke? Stellen Sie zunächst sicher, dass Sie einen Videoinhalt zum Teilen bereit haben. Sie können zum Fotografieren Ihr Mobiltelefon oder eine andere Kameraausrüstung verwenden, Sie müssen jedoch auf die Bildqualität und die Klarheit des Tons achten. 2. Bearbeiten Sie das Video: Um die Arbeit attraktiver zu gestalten, können Sie das Video bearbeiten. Sie können professionelle Videobearbeitungssoftware wie Douyin, Kuaishou usw. verwenden, um Filter, Musik, Untertitel und andere Elemente hinzuzufügen. 3. Wählen Sie ein Cover: Das Cover ist der Schlüssel, um Benutzer zum Klicken zu bewegen. Wählen Sie ein klares und interessantes Bild als Cover, um Benutzer zum Klicken zu bewegen.

So konvertieren Sie vom UC-Browser heruntergeladene Videos in lokale Videos

Feb 29, 2024 pm 10:19 PM

So konvertieren Sie vom UC-Browser heruntergeladene Videos in lokale Videos

Feb 29, 2024 pm 10:19 PM

Wie wandele ich vom UC-Browser heruntergeladene Videos in lokale Videos um? Viele Mobiltelefonbenutzer verwenden gerne den UC-Browser. Sie können nicht nur im Internet surfen, sondern auch verschiedene Videos und Fernsehprogramme online ansehen und ihre Lieblingsvideos auf ihr Mobiltelefon herunterladen. Eigentlich können wir heruntergeladene Videos in lokale Videos konvertieren, aber viele Leute wissen nicht, wie das geht. Daher stellt Ihnen der Editor speziell eine Methode zur Verfügung, mit der Sie die vom UC-Browser zwischengespeicherten Videos in lokale Videos konvertieren können. Methode zum Konvertieren von im UC-Browser zwischengespeicherten Videos in lokale Videos 1. Öffnen Sie den UC-Browser und klicken Sie auf die Option „Menü“. 2. Klicken Sie auf „Download/Video“. 3. Klicken Sie auf „Video zwischengespeichert“. 4. Drücken Sie lange auf ein beliebiges Video. Wenn die Optionen angezeigt werden, klicken Sie auf „Verzeichnis öffnen“. 5. Markieren Sie diejenigen, die Sie herunterladen möchten

So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren_So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren

Mar 30, 2024 pm 12:26 PM

So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren_So posten Sie Videos auf Weibo, ohne die Bildqualität zu komprimieren

Mar 30, 2024 pm 12:26 PM

1. Öffnen Sie zunächst Weibo auf Ihrem Mobiltelefon und klicken Sie unten rechts auf [Ich] (wie im Bild gezeigt). 2. Klicken Sie dann oben rechts auf [Zahnrad], um die Einstellungen zu öffnen (wie im Bild gezeigt). 3. Suchen und öffnen Sie dann [Allgemeine Einstellungen] (wie im Bild gezeigt). 4. Geben Sie dann die Option [Video Follow] ein (wie im Bild gezeigt). 5. Öffnen Sie dann die Einstellung [Video-Upload-Auflösung] (wie im Bild gezeigt). 6. Wählen Sie abschließend [Originalbildqualität] aus, um eine Komprimierung zu vermeiden (wie im Bild gezeigt).