Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ein Artikel, der die wichtigsten technischen Schwierigkeiten des autonomen Fahrens erläutert

Ein Artikel, der die wichtigsten technischen Schwierigkeiten des autonomen Fahrens erläutert

Ein Artikel, der die wichtigsten technischen Schwierigkeiten des autonomen Fahrens erläutert

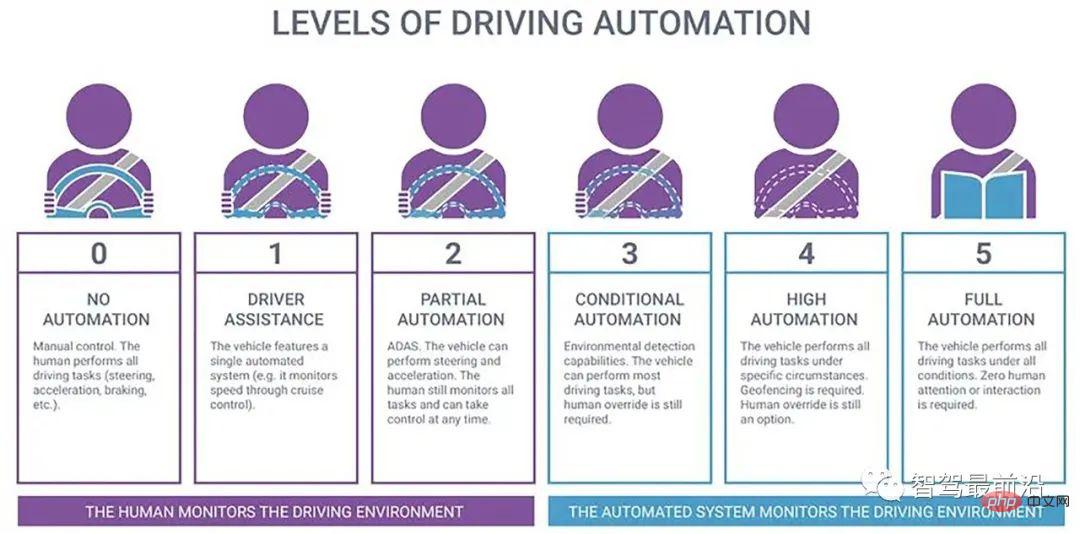

Die American Society of Automotive Engineers unterteilt autonomes Fahren in sechs Stufen, L0-L5, basierend auf dem Grad der Fahrzeugintelligenz:

- # 🎜🎜# L0 ist No Automation (NA), ein traditionelles Auto, bei dem der Fahrer alle Bedienaufgaben wie Lenken, Bremsen, Beschleunigen, Abbremsen oder Parken ausführt; 🎜#L1 ist ein Fahrassistent (DA), der dem Fahrer Fahrwarnungen oder -unterstützung bereitstellen kann, z. B. die Unterstützung einer Lenkradbetätigung oder der Beschleunigung und Verzögerung. Der Rest wird vom Fahrer bereitgestellt Bedienung;

-

L2 ist Teilautomatisierung (PA), das Fahrzeug führt mehrere Operationen am Lenkrad aus und sorgt für Beschleunigung und Verzögerung beim Fahren, und der Fahrer ist für andere Fahrvorgänge verantwortlich; Um die meisten Fahrvorgänge durchzuführen, muss sich der Fahrer auf die Vorbereitung auf Notfälle konzentrieren. Alle Fahrvorgänge werden vom Fahrzeug durchgeführt. Der Fahrer muss sich nicht konzentrieren, aber die Straßen- und Umgebungsbedingungen sind begrenzt.

- L5 Bei der Vollautomatisierung (FA) führt das autonome Fahrsystem alle Fahrvorgänge unter allen Straßen- und Umgebungsbedingungen aus, ohne dass der Fahrer dies tun muss konzentrieren.

-

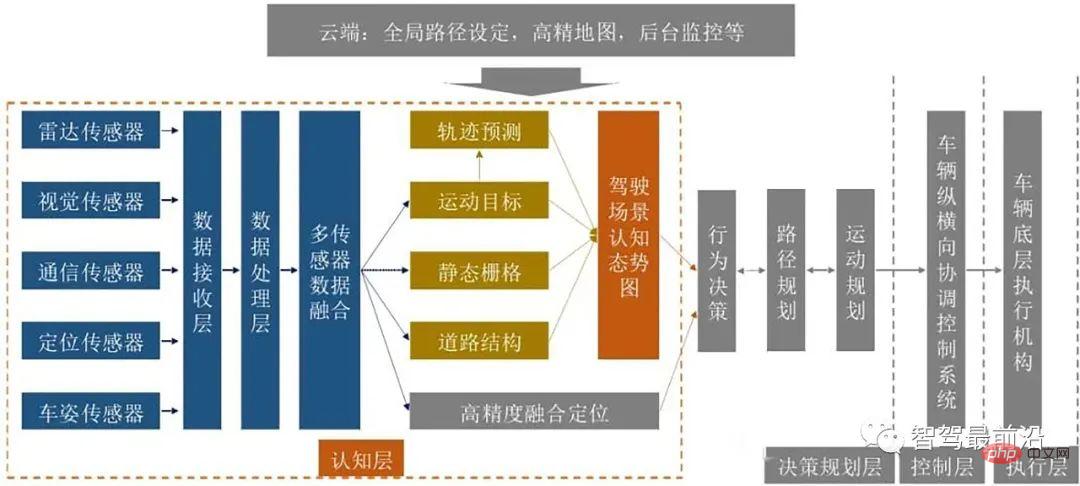

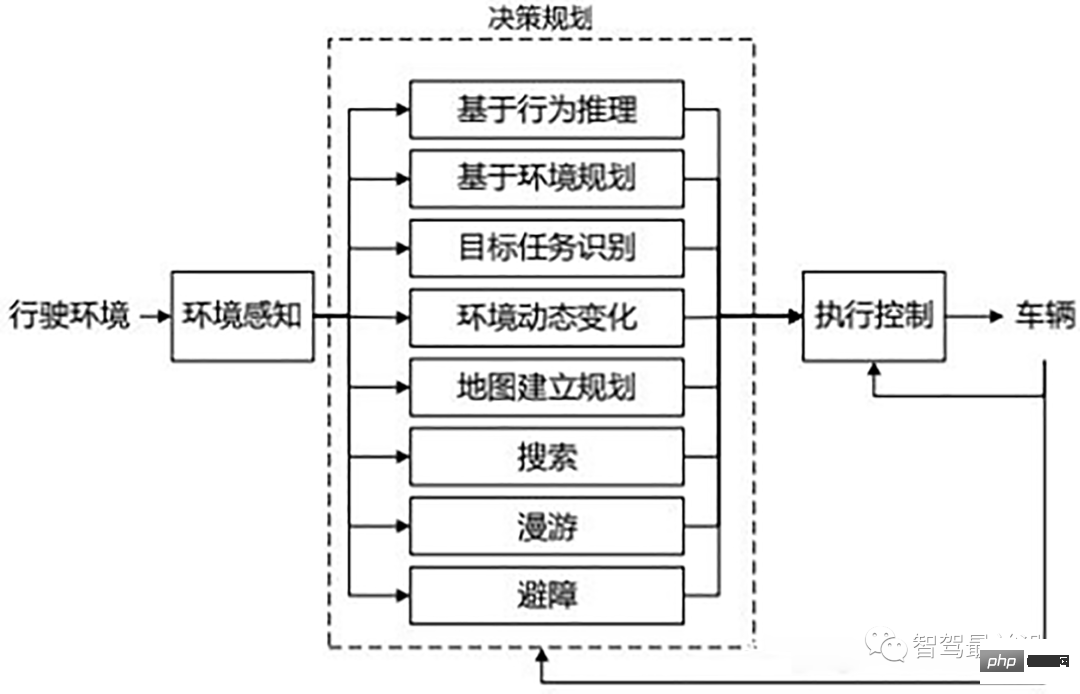

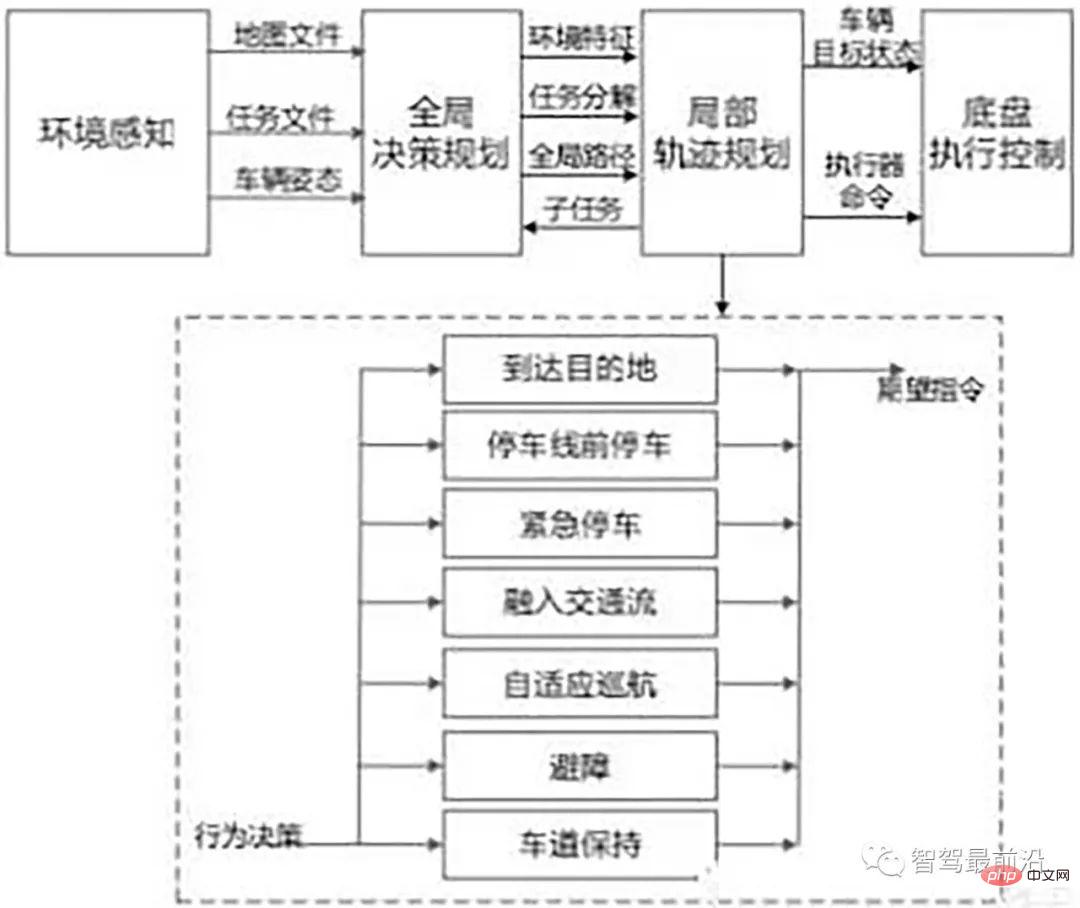

Die Software- und Hardwarearchitektur des Selbstfahrenden Das Auto ist in Abbildung 2 dargestellt. Wie gezeigt, ist es hauptsächlich in eine Schicht zur Umwelterkennung, eine Entscheidungs- und Planungsschicht, eine Kontrollschicht und eine Ausführungsschicht unterteilt. Die Umgebungserkennungsschicht (Wahrnehmungsschicht) erhält hauptsächlich Umgebungsinformationen und Fahrzeugstatusinformationen des Fahrzeugs über Sensoren wie Lidar, Millimeterwellenradar, Ultraschallradar, Fahrzeugkameras, Nachtsichtsysteme, GPS und Gyroskope, insbesondere einschließlich: Spurlinienerkennung, Verkehr Lichterkennung, Verkehrszeichenerkennung, Fußgängererkennung, Fahrzeugerkennung, Hinderniserkennung und Fahrzeugpositionierung usw.; die Entscheidungs- und Planungsebene ist in Aufgabenplanung, Verhaltensplanung und Flugbahnplanung unterteilt, basierend auf der festgelegten Routenplanung und der Umgebung . und den eigenen Status des Fahrzeugs, um die nächsten spezifischen Fahraufgaben (Spurhaltung, Spurwechsel, Verfolgung, Überholen, Kollisionsvermeidung usw.), Verhaltensweisen (Beschleunigung, Verzögerung, Abbiegen, Bremsen usw.) und Pfade (Fahrtrajektorien) zu planen. ; Kontrollschicht und Ausführung Die Schicht steuert das Fahren, Bremsen, Lenken usw. des Fahrzeugs basierend auf dem Fahrzeugdynamiksystemmodell, sodass das Fahrzeug der vorgeschriebenen Fahrbahn folgt. -

- Autonome Fahrtechnologie umfasst viele Schlüsseltechnologien. In diesem Artikel wird hauptsächlich die Umwelt vorgestellt . Wahrnehmungstechnik, hochpräzise Positionierungstechnik, Entscheidungs- und Planungstechnik sowie Steuerungs- und Ausführungstechnik.

01 Umgebungswahrnehmungstechnologie

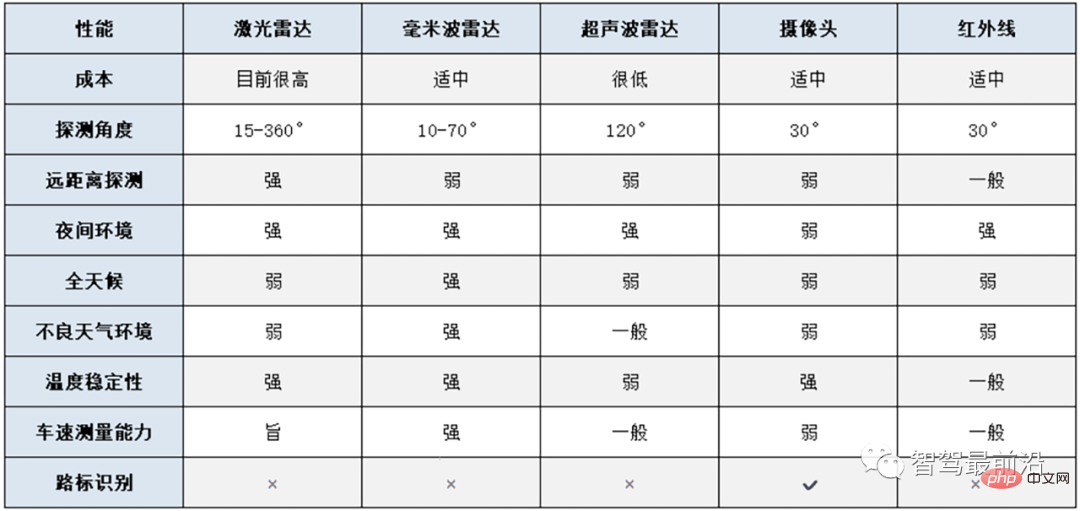

Zu den häufig verwendeten Umgebungswahrnehmungssensoren für autonome Fahrzeuge gehören: Kameras, Lidar, Millimeterwellenradar, Infrarot- und Ultraschallradar usw. Kameras sind das am häufigsten verwendete, einfachste und dem Abbildungsprinzip des menschlichen Auges am nächsten kommende Prinzip von Umgebungswahrnehmungssensoren für autonome Fahrzeuge. Durch die Erfassung der Umgebung des Fahrzeugs in Echtzeit wird die CV-Technologie zur Analyse der aufgenommenen Bilder eingesetzt, um Funktionen wie die Erkennung von Fahrzeugen und Fußgängern sowie die Erkennung von Verkehrszeichen rund um das Fahrzeug zu erreichen.

Millimeterwellenradar ist auch ein häufig verwendeter Sensor für autonome Fahrzeuge. Millimeterwellenradar bezieht sich auf Radar, das im Millimeterwellenband (Wellenlänge 1–10 mm, Frequenzbereich 30–300 GHz) arbeitet Basierend auf der ToF-Technologie (Time of Flight) erkennt es Zielobjekte. Das Millimeterwellenradar sendet kontinuierlich Millimeterwellensignale an die Außenwelt und empfängt das vom Ziel zurückgegebene Signal. Es bestimmt die Entfernung zwischen dem Ziel und dem Fahrzeug anhand der Zeitdifferenz zwischen dem Senden und Empfangen des Signals. Daher wird Millimeterwellenradar hauptsächlich zur Vermeidung von Kollisionen zwischen Autos und umgebenden Objekten verwendet, z. B. zur Erkennung des toten Winkels, zur Unterstützung bei der Vermeidung von Hindernissen, zur Einparkhilfe, zur adaptiven Geschwindigkeitsregelung usw. Millimeterwellenradar verfügt über eine starke Entstörungsfähigkeit, und seine Fähigkeit, Regen, Sand, Staub, Rauch und Plasma zu durchdringen, ist viel stärker als Laser und Infrarot und kann bei jedem Wetter eingesetzt werden. Es weist jedoch auch Nachteile auf, wie z. B. große Signaldämpfung, leichte Blockierung durch Gebäude, menschliche Körper usw., kurze Übertragungsentfernung, geringe Auflösung und Schwierigkeiten bei der Bildgebung.

Lidar nutzt auch die ToF-Technologie, um den Zielort und die Entfernung zu bestimmen. LiDAR erkennt Ziele durch das Aussenden von Laserstrahlen und seine Erkennungsreichweite ist größer. Allerdings ist LiDAR anfälliger für Störungen durch Regen, Schnee, Dunst usw. in der Luft und seine hohen Kosten schränken es ebenfalls ein seine Anwendung. Fahrzeugmontierte Lidar-Geräte können entsprechend der Anzahl der emittierten Laserstrahlen in einzeilige, 4-zeilige, 8-zeilige, 16-zeilige und 64-zeilige Lidar-Geräte unterteilt werden. Anhand der folgenden Tabelle (Tabelle 1) können Sie die Vor- und Nachteile gängiger Sensoren vergleichen.

Die Wahrnehmung der autonomen Fahrumgebung übernimmt normalerweise „schwache Wahrnehmung + Superintelligenz“ und die beiden großen technischen Wege „starke Wahrnehmung + starke Intelligenz“. Die Technologie „schwache Wahrnehmung + Superintelligenz“ basiert hauptsächlich auf Kameras und Deep-Learning-Technologie, um die Umgebungswahrnehmung zu erreichen, und nicht auf Lidar. Bei dieser Technologie wird davon ausgegangen, dass Menschen mit zwei Augen fahren können und dass sich das Auto auch auf Kameras verlassen kann, um die Umgebung klar zu sehen. Wenn es vorübergehend schwierig ist, Superintelligenz zu erreichen, ist es für das Erreichen des fahrerlosen Fahrens notwendig, die Wahrnehmungsfähigkeiten zu verbessern. Dies ist der sogenannte technische Weg „starke Wahrnehmung + starke Intelligenz“.

Verglichen mit der technischen Route „schwache Wahrnehmung + Superintelligenz“ ist das größte Merkmal der technischen Route „starke Wahrnehmung + starke Intelligenz“ die Hinzufügung eines Lidar-Sensors. Dadurch wird die Wahrnehmung deutlich verbessert. Tesla wählt den technischen Weg „schwache Intelligenz + Superintelligenz“, während Google Waymo, Baidu Apollo, Uber, Ford Motor und andere Unternehmen für künstliche Intelligenz, Reiseunternehmen und traditionelle Automobilhersteller alle den technischen Weg „starke Wahrnehmung + starke Intelligenz“ wählen.

02 Hochpräzise Positionierungstechnologie

Der Zweck der Positionierung besteht darin, die Positionierung des Autonomen zu erhalten Fahrzeug relativ zur äußeren Umgebung Die genaue Ortung ist eine wesentliche Grundlage für autonome Fahrzeuge. Beim Fahren auf komplexen Stadtstraßen erfordert die Positionierungsgenauigkeit einen Fehler von nicht mehr als 10 cm. Zum Beispiel: Nur wenn wir den Abstand zwischen dem Fahrzeug und der Kreuzung genau kennen, können wir genauere Vorhersagen und Vorbereitungen treffen. Nur durch die genaue Positionierung des Fahrzeugs können wir die Fahrspur bestimmen, auf der sich das Fahrzeug befindet. Wenn der Positionierungsfehler hoch ist, kann es zu einem vollständigen Verkehrsunfall kommen.

GPS ist derzeit die am weitesten verbreitete Ortungsmethode. Je höher die GPS-Genauigkeit, desto teurer ist der GPS-Sensor. Allerdings ist die aktuelle Positionierungsgenauigkeit der kommerziellen GPS-Technologie bei weitem nicht ausreichend. Ihre Genauigkeit liegt nur im Meterbereich und kann leicht durch Faktoren wie Tunnelbehinderung und Signalverzögerung beeinträchtigt werden. Um dieses Problem zu lösen, hat Qualcomm eine Vision-Enhanced-High-Precision-Positioning-Technologie (VEPP) entwickelt, die Informationen aus mehreren Automobilkomponenten wie der globalen GNSS-Navigation, Kameras, IMU-Trägheitsnavigation und gegenseitigen Radgeschwindigkeitssensoren integriert Fusion, um eine globale, fahrspurgenaue Echtzeitpositionierung zu erreichen.

03 Entscheidungs- und Planungstechnologie

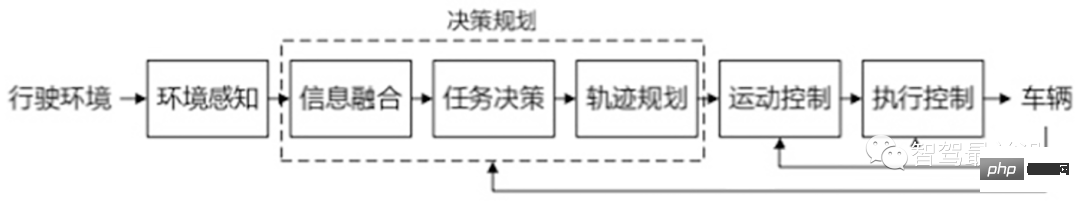

Entscheidungsplanung ist einer der Schlüsselbestandteile des autonomen Fahrens Es führt zunächst Multisensorinformationen zusammen und trifft dann Aufgabenentscheidungen basierend auf den Fahranforderungen. Anschließend kann es mehrere sichere Wege zwischen zwei Punkten planen und dabei bestehende Hindernisse vermeiden und einen optimalen Weg unter diesen Wegen auswählen Die Fahrbahn des Fahrzeugs wird geplant. Je nach Unterteilungsebene kann es in zwei Arten unterteilt werden: Globale Planung und lokale Planung. Bei der globalen Planung geht es darum, auf der Grundlage der erhaltenen Karteninformationen einen kollisionsfreien optimalen Weg unter bestimmten Bedingungen zu planen. Beispielsweise gibt es viele Straßen von Shanghai nach Peking. Die Planung einer davon als Fahrroute ist die Gesamtplanung.

Statische Pfadplanungsalgorithmen wie Gittermethode, visuelle Diagrammmethode, Topologiemethode, Freiraummethode, neuronale Netzwerkmethode usw. Lokale Planung basiert auf globaler Planung und auf der Grundlage einiger lokaler Umweltinformationen ist es ein Prozess, der Kollisionen mit einigen unbekannten Hindernissen vermeiden und schließlich den Zielpunkt erreichen kann. Beispielsweise wird es auf der global geplanten Route von Shanghai nach Peking andere Fahrzeuge oder Hindernisse geben. Wenn Sie diesen Hindernissen oder Fahrzeugen ausweichen möchten, müssen Sie abbiegen und die Fahrspur anpassen. Zu den lokalen Pfadplanungsmethoden gehören: Methode des künstlichen Potenzialfelds, Methode des Vektordomänen-Histogramms, Methode des virtuellen Kraftfelds, genetischer Algorithmus und andere dynamische Pfadplanungsalgorithmen.

Die Entscheidungs- und Planungsebene ist das autonome Fahrsystem. Sie ist ein direktes Spiegelbild der Intelligenz und spielt eine entscheidende Rolle für die Fahrsicherheit des Fahrzeugs und des gesamten Fahrzeugs und reaktiv und eine Mischung aus beidem.

Die hierarchische progressive Architektur ist die Struktur eines Seriensystems. In diesem System ist die Ausgabe des vorherigen Moduls die Eingabe des nächsten Moduls wird als Wahrnehmungsplanungs-Aktionsstruktur bezeichnet. Allerdings ist die Zuverlässigkeit dieser Struktur nicht hoch. Sobald in einem bestimmten Modul ein Software- oder Hardwarefehler auftritt, wird der gesamte Informationsfluss beeinträchtigt und das gesamte System wird wahrscheinlich zusammenbrechen oder sogar lahmgelegt.

Die reaktive Architektur nimmt eine parallele Struktur an. Die Kontrollschicht kann Entscheidungen direkt auf der Grundlage der Eingaben des Sensors treffen. die die wahrgenommenen Aktionen hervorheben können, geeignet für völlig unbekannte Umgebungen. Bei vielen Verhaltensweisen in der reaktiven Architektur handelt es sich hauptsächlich um einfache Spezialaufgaben, sodass Planung und Steuerung eng integriert werden können und der belegte Speicherplatz nicht groß ist, sodass schnelle Reaktionen und eine starke Echtzeitleistung erzielt werden können Gleichzeitig muss jede Schicht nur für ein bestimmtes Verhalten des Systems verantwortlich sein. Das gesamte System kann den Übergang von der niedrigen zur hohen Ebene bequem und flexibel realisieren. Darüber hinaus kann das verbleibende Modul einen unerwarteten Fehler aufweisen Ebenen können immer noch sinnvolle Ergebnisse liefern, die Robustheit des Systems wurde jedoch erheblich verbessert. Die Schwierigkeit besteht darin, dass aufgrund der Flexibilität der Aktionsausführung ein spezifischer Koordinationsmechanismus erforderlich ist, um die Konflikte zwischen den verschiedenen Regelkreisen zu lösen und sich darauf zu einigen die Behauptung des Aktors, um ein aussagekräftiges Ergebnis zu erhalten.

Die Struktur des hierarchischen Systems und die Struktur des reaktiven Systems haben beide ihre eigenen Vor- und Nachteile, und es ist für sie schwierig, die komplexen und sich ändernden Anforderungen der Fahrumgebung allein zu erfüllen Immer mehr Branchenexperten haben damit begonnen, hybride Architekturen zu untersuchen und die Vorteile beider effektiv zu kombinieren, um hierarchische hierarchische Verhaltensweisen zu erzeugen, die durch Ziele auf der globalen Planungsebene und eine zielorientierte Suche auf der lokalen Planungsebene definiert werden .

04 Steuerungs- und Ausführungstechnologie

Die Kernsteuerungstechnologie des autonomen Fahrens ist die Längssteuerung, Quersteuerung, Längssteuerung sowie Fahr- und Bremssteuerung des Fahrzeugs, und die Quersteuerung ist die Lenkung Rad Die Einstellung des Winkels und die Steuerung der Reifenkraft ermöglichen eine automatische Längs- und Quersteuerung, und der Fahrzeugbetrieb kann entsprechend vorgegebenen Zielen und Einschränkungen automatisch gesteuert werden.

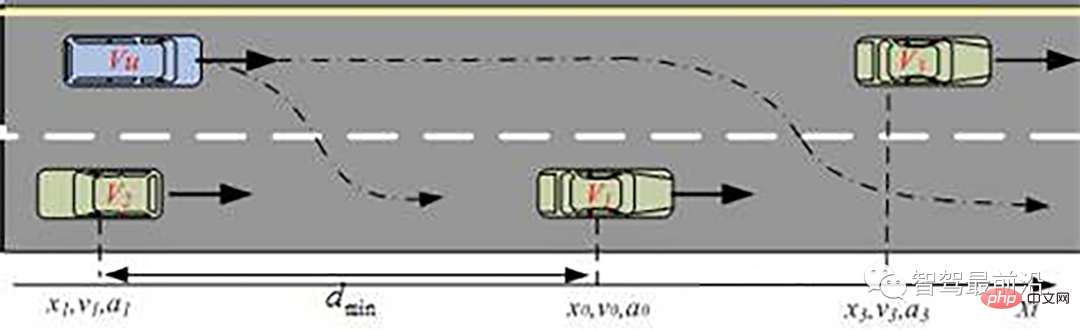

Die Längsregelung des Fahrzeugs ist die Regelung in Richtung der Fahrgeschwindigkeit, also die automatische Regelung der Fahrzeuggeschwindigkeit und des Abstands zwischen dem Fahrzeug und den vorausfahrenden oder dahinter liegenden Fahrzeugen bzw. Fahrzeugen Hindernisse. Tempomat und Notbremsassistent sind typische Beispiele für die Längsregelung beim autonomen Fahren. Bei dieser Art von Steuerungsproblem geht es um die Steuerung von Motorantrieben, Motoren, Getrieben und Bremssystemen. Verschiedene Motor-Motor-Getriebe-Modelle, Fahrzeugbetriebsmodelle und Bremsprozessmodelle werden mit unterschiedlichen Regleralgorithmen zu verschiedenen Längsregelungsmodi kombiniert.

Die seitliche Kontrolle des Fahrzeugs bezieht sich auf die Kontrolle senkrecht zur Bewegungsrichtung. Ziel ist es, das Auto so zu steuern, dass es automatisch die gewünschte Fahrroute beibehält und bei unterschiedlichen Fahrzeuggeschwindigkeiten, Lasten, Windwiderständen und Straßenbedingungen einen guten Fahrkomfort und eine gute Stabilität erreicht. Es gibt zwei grundlegende Entwurfsmethoden für die Fahrzeugquersteuerung. Eine basiert auf der Fahrersimulation (eine besteht darin, ein einfacheres Dynamikmodell und Fahrermanipulationsregeln zum Entwerfen des Controllers zu verwenden; die andere besteht darin, den Manipulationsprozess des Fahrers zu verwenden. Der Datentrainingscontroller erhält die Der andere ist eine Steuermethode, die das Modell der Querbewegungsmechanik des Fahrzeugs liefert (es muss ein genaues Modell der Querbewegung des Fahrzeugs erstellt werden. Ein typisches Modell ist beispielsweise ein Einspurmodell, das die Eigenschaften der linken und rechten Seite berücksichtigt

05 Zusammenfassung

Neben der oben vorgestellten Umgebungswahrnehmung, präzisen Positionierung, Entscheidungsplanung und Steuerungsausführung beinhalten autonome Fahrzeuge auch Schlüsseltechnologien wie hochpräzise Karten , V2X und autonome Fahrzeugtests. Autonome Fahrtechnologie ist eine Kombination aus künstlicher Intelligenz, Hochleistungschips, Kommunikationstechnologie, Sensortechnologie, Fahrzeugsteuerungstechnologie, Big-Data-Technologie und anderen Mehrfeldtechnologien. Die Technologie ist schwierig zu implementieren. Darüber hinaus ist es für die Umsetzung autonomer Fahrtechnologie erforderlich, grundlegende Transporteinrichtungen einzurichten, die den Anforderungen des autonomen Fahrens gerecht werden, und Gesetze und Vorschriften zum autonomen Fahren zu berücksichtigen.

Das obige ist der detaillierte Inhalt vonEin Artikel, der die wichtigsten technischen Schwierigkeiten des autonomen Fahrens erläutert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1677

1677

14

14

1431

1431

52

52

1334

1334

25

25

1280

1280

29

29

1257

1257

24

24

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Sprechen wir über End-to-End- und autonome Fahrsysteme der nächsten Generation sowie über einige Missverständnisse über End-to-End-Autonomes Fahren?

Apr 15, 2024 pm 04:13 PM

Im vergangenen Monat hatte ich aus bekannten Gründen einen sehr intensiven Austausch mit verschiedenen Lehrern und Mitschülern der Branche. Ein unvermeidliches Thema im Austausch ist natürlich End-to-End und der beliebte Tesla FSDV12. Ich möchte diese Gelegenheit nutzen, einige meiner aktuellen Gedanken und Meinungen als Referenz und Diskussion darzulegen. Wie definiert man ein durchgängiges autonomes Fahrsystem und welche Probleme sollten voraussichtlich durchgängig gelöst werden? Gemäß der traditionellsten Definition bezieht sich ein End-to-End-System auf ein System, das Rohinformationen von Sensoren eingibt und für die Aufgabe relevante Variablen direkt ausgibt. Bei der Bilderkennung kann CNN beispielsweise als End-to-End bezeichnet werden, verglichen mit der herkömmlichen Methode zum Extrahieren von Merkmalen + Klassifizieren. Bei autonomen Fahraufgaben werden Eingabedaten verschiedener Sensoren (Kamera/LiDAR) benötigt