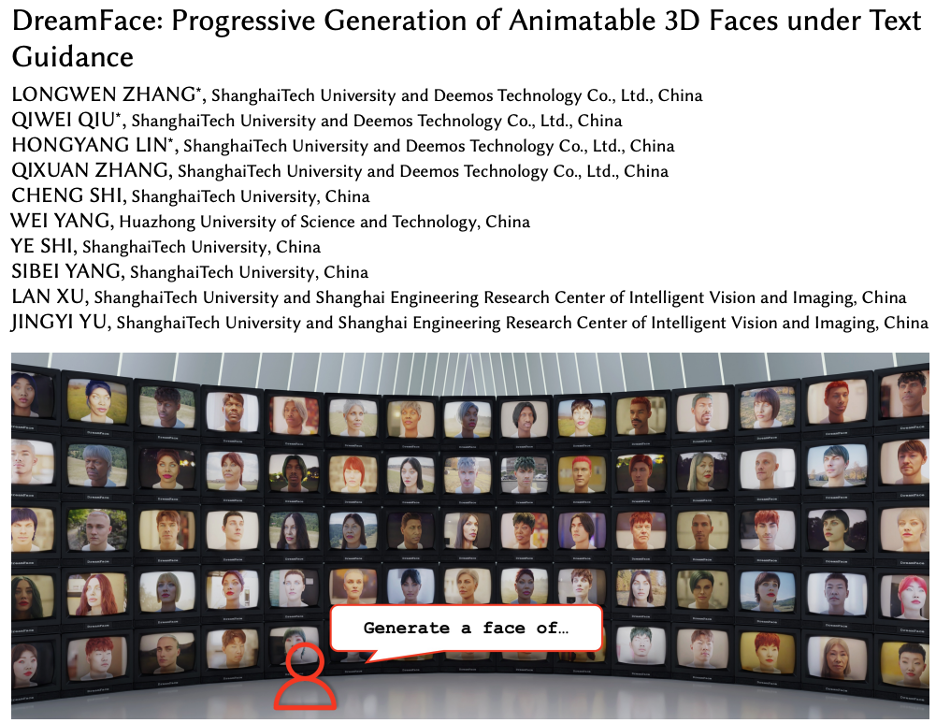

Mit der rasanten Entwicklung von Wissenschaft und Technologie rückt die Forschung in den Bereichen generative künstliche Intelligenz und Computergrafik zunehmend in den Fokus. Branchen wie die Film- und Fernsehproduktion sowie die Spieleentwicklung stehen vor großen Herausforderungen und Chancen. Dieser Artikel stellt Ihnen eine Forschung auf dem Gebiet der 3D-Generierung vor – DreamFace, das erste textgesteuerte progressive 3D-Generierungs-Framework, das die produktionsbereite 3D-Asset-Generierung unterstützt und textgenerierte hyperrealistische digitale 3D-Menschen ermöglicht.

Diese Arbeit wurde von Transactions on Graphics, der führenden internationalen Fachzeitschrift im Bereich Computergrafik, angenommen und wird auf der SIGGRAPH 2023, der führenden internationalen Computergrafikkonferenz, präsentiert.

Projektwebsite: https://sites.google.com/view/dreamface

Vordruckpapier: https://arxiv.org/abs/2304.03117

Web-Demo: https://hyperhuman.top

HuggingFace Space: https://huggingface.co/spaces/DEEMOSTECH/ChatAvatar

Selbsttext- und Bildgenerierungstechnologie Seitdem Nach ihrem großen Durchbruch ist die 3D-Generierungstechnologie nach und nach in den Mittelpunkt der wissenschaftlichen Forschung und Industrie gerückt. Allerdings stehen die derzeit auf dem Markt befindlichen 3D-Generierungstechnologien noch vor vielen Herausforderungen, darunter Kompatibilitätsprobleme mit der CG-Pipeline, Genauigkeitsprobleme und Probleme mit der Laufgeschwindigkeit.

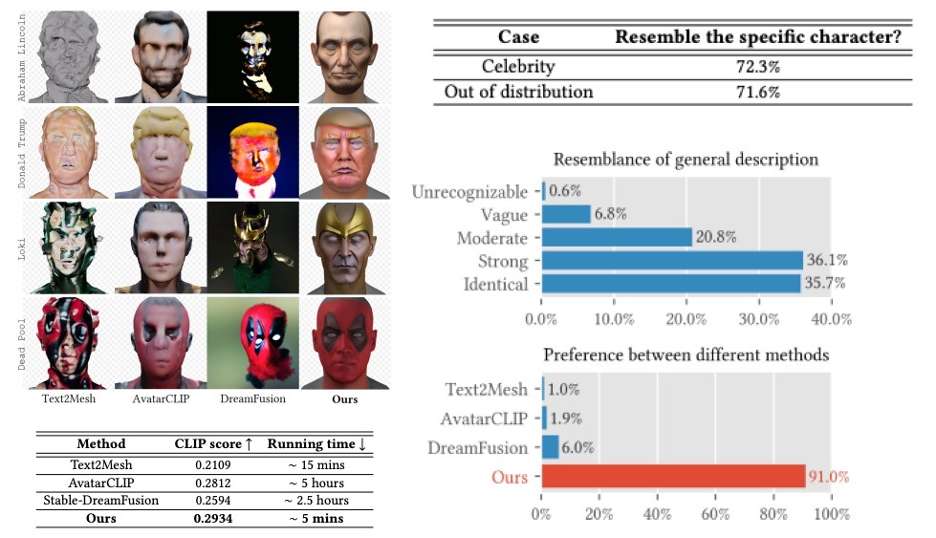

Um diese Probleme zu lösen, schlug das Forschungs- und Entwicklungsteam von Yingmo Technology und der ShanghaiTech University ein textgesteuertes progressives 3D-Generierungsframework vor – DreamFace. Das Framework kann direkt 3D-Assets generieren, die den CG-Produktionsstandards entsprechen, mit höherer Genauigkeit, schnellerer Laufgeschwindigkeit und besserer CG-Pipeline-Kompatibilität. In diesem Artikel werden die Hauptfunktionen von DreamFace im Detail vorgestellt und seine Anwendungsperspektiven in der Film- und Fernsehproduktion, der Spieleentwicklung und anderen Branchen untersucht.

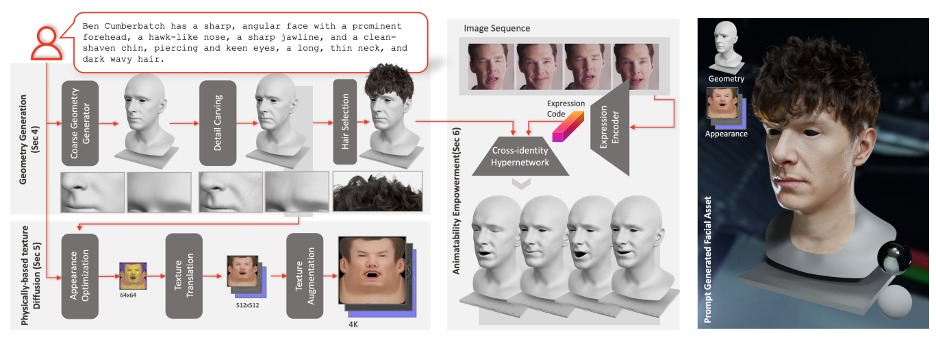

Das DreamFace-Framework umfasst hauptsächlich drei Module: Geometriegenerierung, physikbasierte Materialdiffusionsgenerierung und Animationsfähigkeitsgenerierung. Diese drei Module ergänzen sich zu einer effizienten und zuverlässigen 3D-Generierungstechnologie.

Geometriegenerierung

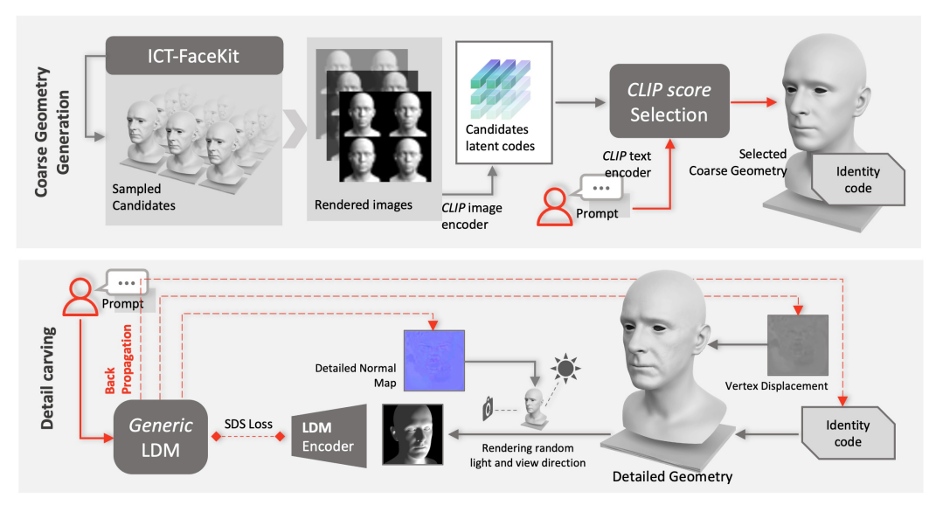

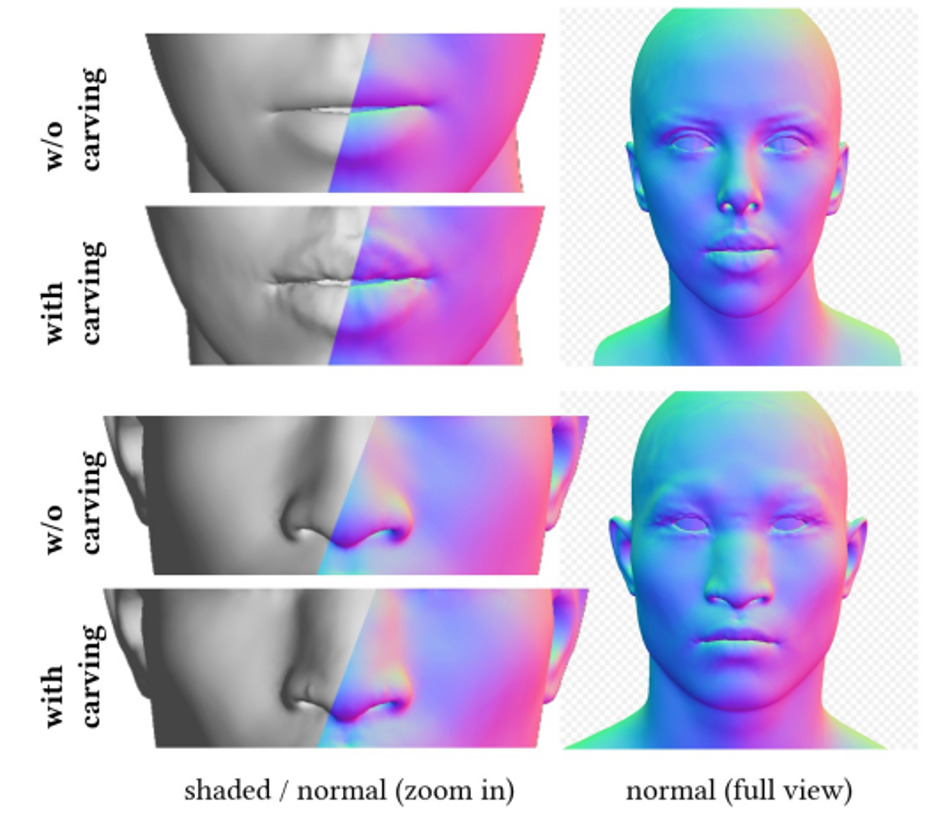

Die Kernaufgabe des Geometriegenerierungsmoduls besteht darin, ein konsistentes geometrisches Modell basierend auf Texteingaben zu generieren. DreamFace verwendet ein auf CLIP (Contrastive Language-Image Pre-Training) basierendes Auswahl-Framework, das zunächst das beste grobe geometrische Modell aus zufällig ausgewählten Kandidaten innerhalb des geometrischen Parameterraums des Gesichts auswählt und es dann mithilfe des Implicit Diffusion Model (LDM) Geometrisch modelliert Details, um das Kopfmodell besser mit Texthinweisen in Einklang zu bringen. Darüber hinaus unterstützt das Framework auch die Generierung von Frisuren und Farben basierend auf Texteingaben.

Physikalisch basierte Materialdiffusionsgenerierung

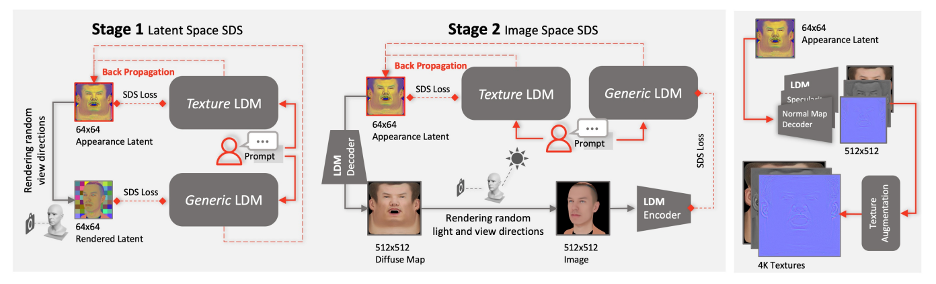

Das physikalisch basierte Materialdiffusionsgenerierungsmodul ist darauf ausgelegt, Gesichtstexturen im Einklang mit vorhergesagten Geometrie- und Texthinweisen vorherzusagen. DreamFace optimierte zunächst das vorab trainierte LDM anhand des groß angelegten UV-Materialdatensatzes, um zwei LDM-Diffusionsmodelle zu erhalten. Anschließend wird ein gemeinsames Trainingsschema verwendet, um zwei Diffusionsprozesse zu koordinieren, einen zum direkten Entrauschen von UV-Texturkarten und den anderen für überwachte gerenderte Bilder.

Um sicherzustellen, dass die erstellten Texturkarten keine unerwünschten Merkmale oder Beleuchtungssituationen enthalten und gleichzeitig die Vielfalt gewahrt bleibt, wurde eine Hinweis-Lernstrategie entwickelt. Das Team verwendet zwei Methoden, um hochwertige diffuse Reflexionskarten zu erstellen: (1) Prompt Tuning. Im Gegensatz zu handgefertigten domänenspezifischen Texthinweisen kombiniert DreamFace die beiden domänenspezifischen kontinuierlichen Texthinweise Cd und Cu mit entsprechenden Texthinweisen, die während des U-Net-Denoiser-Trainings optimiert werden, um Instabilität und zeitaufwändiges manuelles Schreiben von Eingabeaufforderungen zu vermeiden. (2) Maskierung von Nicht-Gesichtsbereichen. Der LDM-Rauschunterdrückungsprozess wird zusätzlich durch Nicht-Gesichtsbereichsmasken eingeschränkt, um sicherzustellen, dass die resultierende diffuse Karte keine unerwünschten Elemente enthält.

Generieren Sie abschließend physikalisch basierte 4K-Texturen über das Super-Resolution-Modul für hochwertiges Rendering.

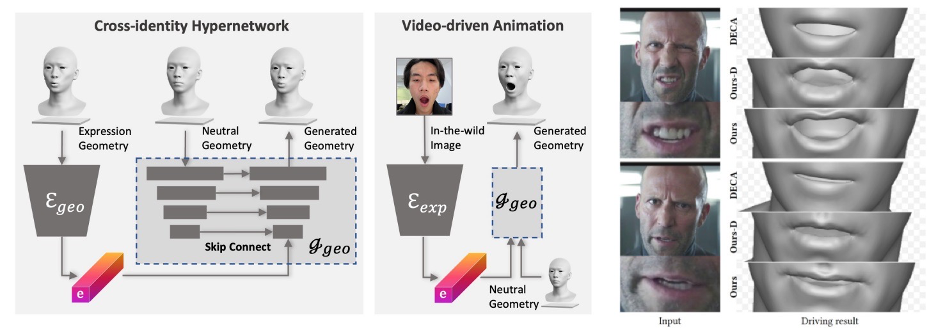

Animationsfähigkeit. Generation

Das von DreamFace generierte Modell verfügt über Animationsfunktionen. Durch die Vorhersage einzigartiger Verformungen und die Animation des generierten neutralen Modells können Sie personalisierte Animationen erstellen. Der neuronale Gesichtsanimationsansatz von DreamFace liefert feinere Ausdrucksdetails und ermöglicht fein erfasste Leistungen im Vergleich zu Ansätzen, die generische BlendShapes zur Ausdruckssteuerung verwenden.

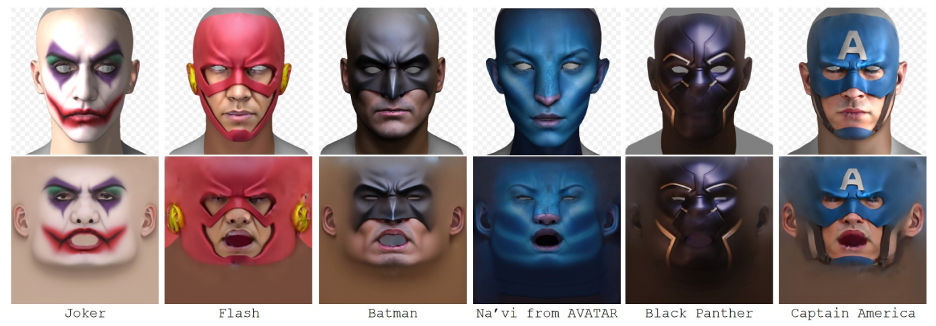

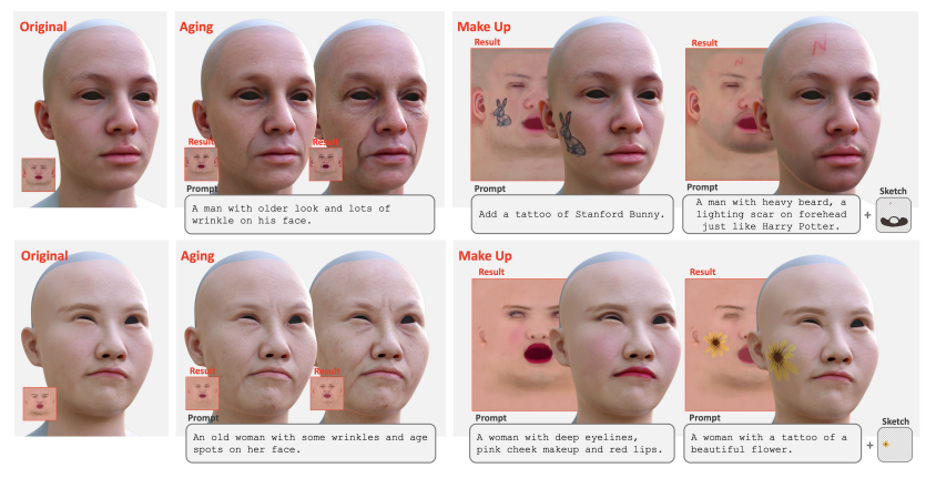

Das DreamFace-Framework hat hervorragende Ergebnisse bei der Generierung von Prominenten und Charakteren basierend auf Beschreibungen erzielt. Darüber hinaus wird die Texturbearbeitung mithilfe von Hinweisen und Skizzen für globale Bearbeitungseffekte wie Alterung und Make-up unterstützt. Durch die weitere Kombination von Masken oder Skizzen können verschiedene Effekte wie Tätowierungen, Bärte und Muttermale erzeugt werden.

Das progressive Generierungsframework von DreamFace bietet eine effektive Lösung für die Lösung komplexer 3D-Generierungsaufgaben und dürfte weitere ähnliche Forschungs- und Technologieentwicklungen fördern. Darüber hinaus werden die physikalisch basierte Materialdiffusionsgenerierung und die Generierung von Animationsfähigkeiten die Anwendung der 3D-Generierungstechnologie in der Film- und Fernsehproduktion, der Spieleentwicklung und anderen verwandten Branchen fördern. Lassen Sie uns abwarten, wie sich ihre Entwicklung und Anwendung in Zukunft entwickelt.

Das obige ist der detaillierte Inhalt vonDreamFace: Einen digitalen 3D-Menschen in einem Satz generieren?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Antiviren Software

Antiviren Software

CSS-Hintergrundcode-Sammlung

CSS-Hintergrundcode-Sammlung

Empfohlene Lernreihenfolge für C++ und Python

Empfohlene Lernreihenfolge für C++ und Python

Welche Tools zur statischen Codeprüfung gibt es?

Welche Tools zur statischen Codeprüfung gibt es?

Einführung in alle Verwendungsmöglichkeiten von Python

Einführung in alle Verwendungsmöglichkeiten von Python

vps

vps

Notepad ist das Beste

Notepad ist das Beste

Die Druckerinstallation ist fehlgeschlagen

Die Druckerinstallation ist fehlgeschlagen

Vollständige Sammlung von HTML-Tags

Vollständige Sammlung von HTML-Tags