Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

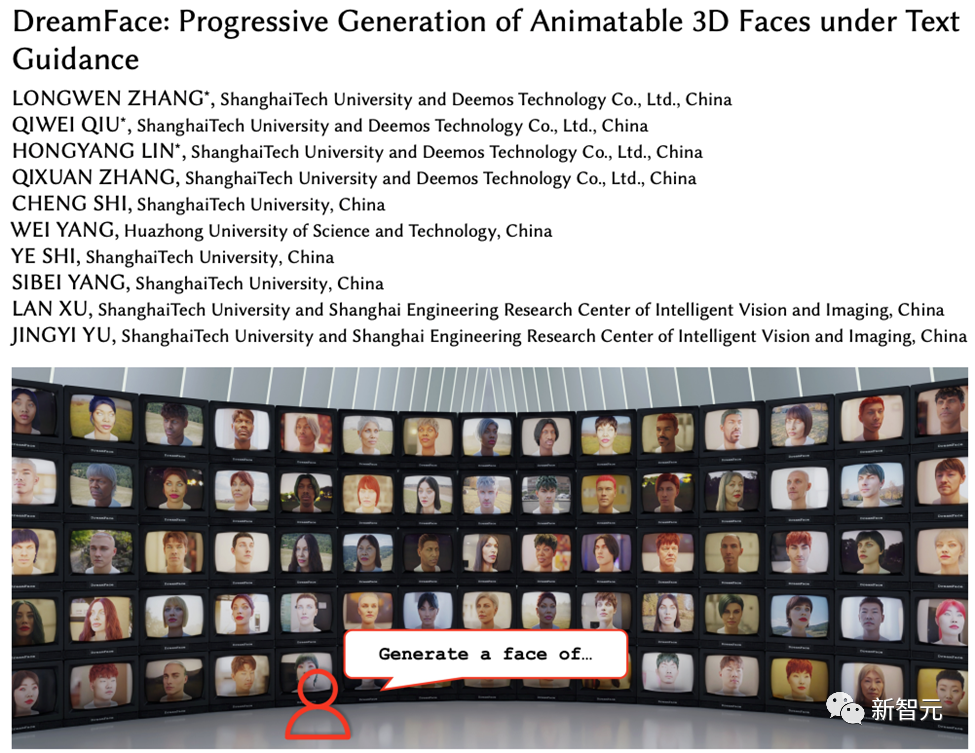

Die Shanghai University of Science and Technology und andere haben DreamFace veröffentlicht: Nur Text kann einen „hyperrealistischen 3D-Digitalmenschen' erzeugen.

Die Shanghai University of Science and Technology und andere haben DreamFace veröffentlicht: Nur Text kann einen „hyperrealistischen 3D-Digitalmenschen' erzeugen.

Die Shanghai University of Science and Technology und andere haben DreamFace veröffentlicht: Nur Text kann einen „hyperrealistischen 3D-Digitalmenschen' erzeugen.

Mit der Entwicklung von Large Language Model (LLM), Diffusion (Diffusion) und anderen Technologien hat die Geburt von Produkten wie ChatGPT und Midjourney eine neue Welle der KI-Begeisterung ausgelöst, und auch die generative KI hat begonnen erregte auch viel Aufmerksamkeit.

Im Gegensatz zu Text und Bildern befindet sich die 3D-Generierung noch im Stadium der technologischen Erforschung.

Ende 2022 starteten Google, NVIDIA und Microsoft nacheinander ihre eigene 3D-Generierungsarbeit, die meisten davon basierten jedoch implizit auf dem Advanced Neural Radiation Field (NeRF). Ausdruck und Die Rendering-Pipelines industrieller 3D-Software wie Unity, Unreal Engine und Maya sind nicht kompatibel.

Selbst wenn es mit herkömmlichen Lösungen in durch Mesh ausgedrückte geometrische und Farbkarten umgewandelt wird, führt dies zu unzureichender Genauigkeit und verringerter visueller Qualität und kann nicht direkt auf Film angewendet werden und Fernsehproduktion und Spieleproduktion.

Projektwebsite: https://sites.google .com/view/dreamface

Papieradresse: https://arxiv.org/abs/2304.03117#🎜 🎜#

Web-Demo: https://hyperhuman.top

#🎜 🎜#HuggingFace Space: https://huggingface.co/spaces/DEEMOSTECH/ChatAvatar

Um diese Probleme zu lösen, haben Shadow Eye Technology und Shanghai Technology Das Forschungs- und Entwicklungsteam der Universität schlägt ein textgesteuertes, progressives 3D-Generierungsframework vor.Dieses Framework führt externe Datensätze (einschließlich Geometrie und PBR-Materialien) ein, die den CG-Produktionsstandards entsprechen, und kann basierend auf Text direkt 3D-Assets generieren, die diesem Standard entsprechen Es ist das erste A-Framework, das die Generierung produktionsbereiter 3D-Assets unterstützt.

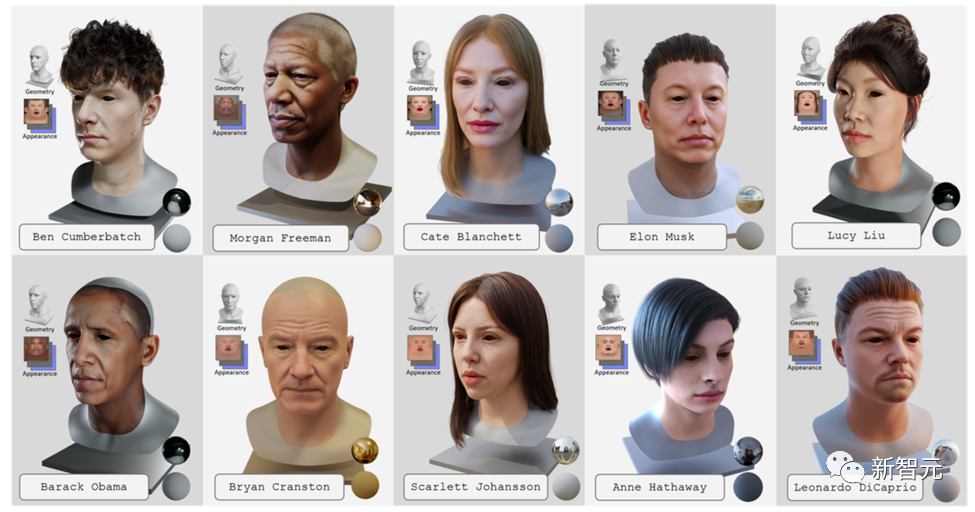

Um textgenerierte hyperrealistische digitale 3D-Menschen zu erreichen, kombinierte das Team dieses Framework mit einem digitalen 3D-Menschendatensatz in Produktionsqualität. Diese Arbeit wurde von Transactions on Graphics, der führenden internationalen Fachzeitschrift im Bereich Computergrafik, angenommen und wird auf der SIGGRAPH 2023, der führenden internationalen Computergrafikkonferenz, vorgestellt.

DreamFace umfasst hauptsächlich drei Module: Geometriegenerierung, physikbasierte Materialdiffusion und Animationsfähigkeitsgenerierung.

Im Vergleich zu früheren Arbeiten zur 3D-Generierung umfassen die Hauptbeiträge dieser Arbeit:

#🎜 🎜 #·

schlägt DreamFace vor, eine neuartige Generierungslösung, die aktuelle visuelle Sprachmodelle mit animierbaren und physisch materialisierbaren Gesichtselementen kombiniert und dabei progressives Lernen nutzt, um Geometrie, Aussehen und Animationsfunktionen zu trennen.

·führt ein zweikanaliges Erscheinungsbildgenerierungsdesign ein, das ein neuartiges Materialdiffusionsmodell mit einem vorab trainierten Modell kombiniert, während zwei- Die Bühnenoptimierung wird im Latentraum und im Bildraum durchgeführt.

·Gesichtsassets mit BlendShapes oder generierten personalisierten BlendShapes werden animiert und demonstrieren die Kompetenz von DreamFace in der Anwendung natürlicher Charakterdesigns. Geometriegenerierung

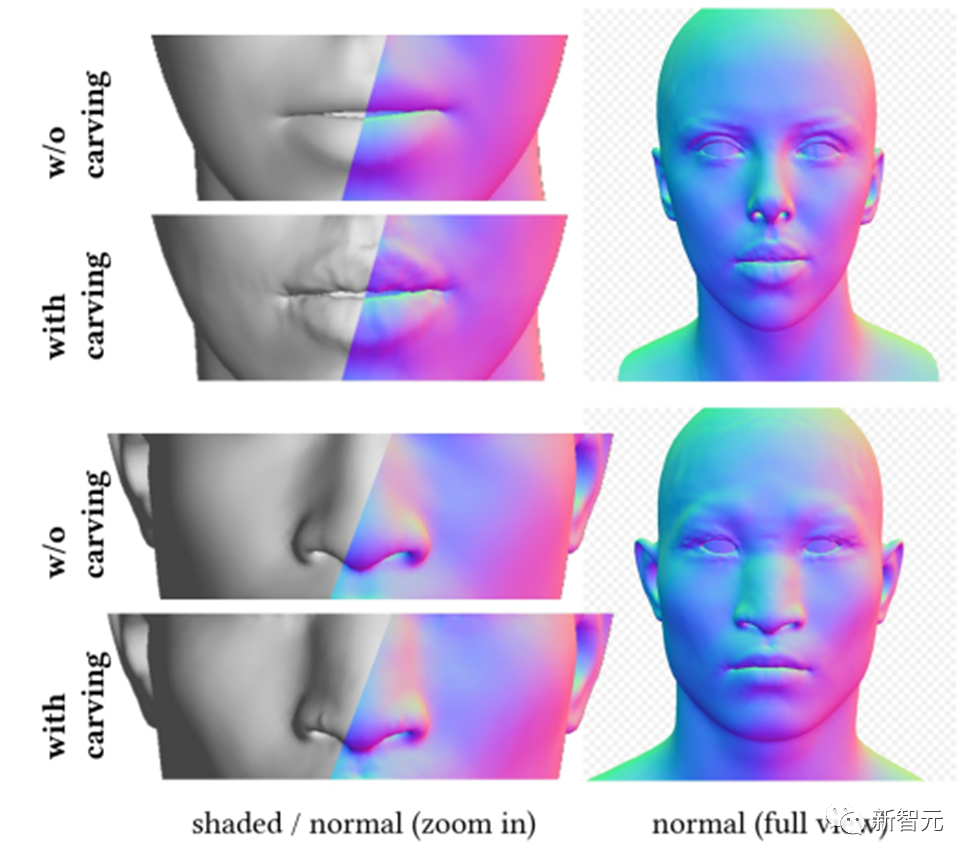

Das Geometriegenerierungsmodul kann ein konsistentes geometrisches Modell basierend auf Textaufforderungen generieren. Wenn es jedoch um die Gesichtergenerierung geht, kann es schwierig sein, diese zu überwachen und zu konvergieren.

Daher schlägt DreamFace ein auf CLIP (Contrastive Language-Image Pre-Training) basierendes Auswahlframework vor, bei dem zunächst zufällig Kandidaten aus dem geometrischen Parameterraum des Gesichts ausgewählt werden, um die besten auszuwählen Wählen Sie aus den Optionen ein grobes Geometriemodell aus und formen Sie dann die geometrischen Details, um das Kopfmodell besser mit der Textaufforderung in Einklang zu bringen.

Dadurch kann DreamFace durch Scheitelpunktverschiebung und detaillierte Normalkarten Gesichtsdetails zu groben Geometriemodellen hinzufügen, was zu einer hochdetaillierten Geometrie führt.

Ähnlich wie beim Kopfmodell trifft auch DreamFace auf diesem Rahmen basierende Frisuren- und Farbauswahlen.

Physikalisch basierte Materialdiffusionsgenerierung

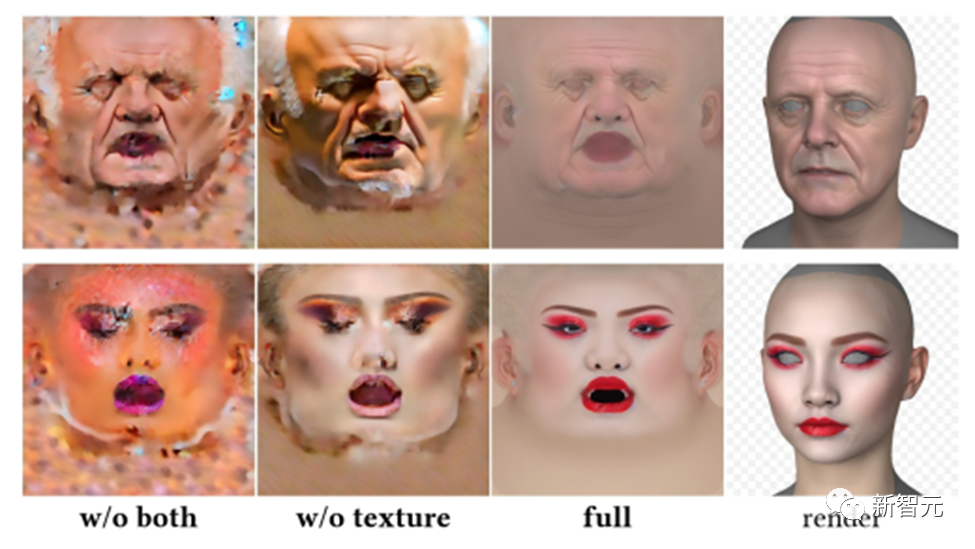

Das physikalisch basierte Materialdiffusionsmodul ist darauf ausgelegt, Gesichtstexturen vorherzusagen, die mit vorhergesagten Geometrie- und Texthinweisen übereinstimmen.

Zuerst hat DreamFace das vorab trainierte LDM anhand des groß angelegten UV-Materialdatensatzes verfeinert, um zwei LDM-Diffusionsmodelle zu erhalten.

DreamFace verwendet ein gemeinsames Trainingsschema, das zwei Diffusionsprozesse koordiniert, einen zum direkten Entrauschen von UV-Texturkarten und einen zur Überwachung des gerenderten Bildes, um sicherzustellen, dass die Gesichts-UV-Karte und das gerenderte Bild die richtige Formation haben von stimmt mit der Textaufforderung überein.

Um die Generierungszeit zu verkürzen, verwendet DreamFace eine Phase der potenziellen Diffusion grober Texturen, um a priori Potenzial für die Generierung detaillierter Texturen bereitzustellen.

Um sicherzustellen, dass die erstellten Texturkarten keine unerwünschten Merkmale oder Beleuchtungssituationen enthalten und dennoch die Vielfalt gewahrt bleibt, wurde eine Hinweis-Lernstrategie entwickelt.

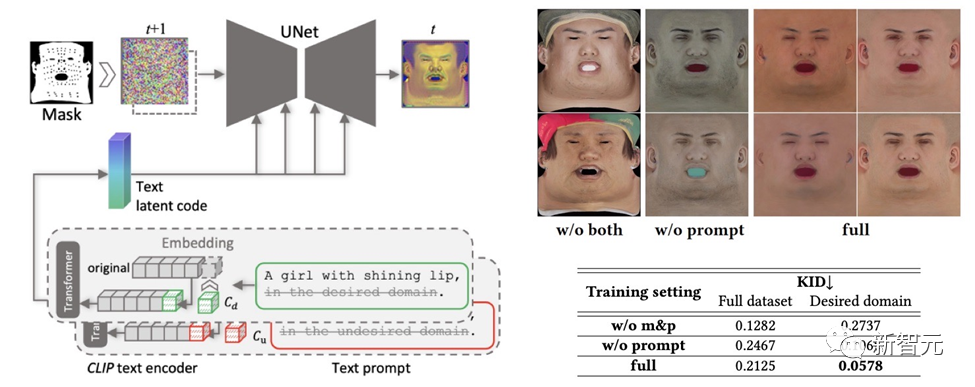

Das Team verwendet zwei Methoden, um hochwertige diffuse Karten zu generieren:

(1) Prompt Tuning. Im Gegensatz zu handgefertigten domänenspezifischen Texthinweisen kombiniert DreamFace die beiden domänenspezifischen kontinuierlichen Texthinweise Cd und Cu mit entsprechenden Texthinweisen, die während des U-Net-Denoiser-Trainings optimiert werden, um Instabilität und zeitaufwändiges manuelles Schreiben von Eingabeaufforderungen zu vermeiden.

(2) Maskierung von Nicht-Gesichtsbereichen. Der LDM-Rauschunterdrückungsprozess wird zusätzlich durch Nicht-Gesichtsbereichsmasken eingeschränkt, um sicherzustellen, dass die resultierende diffuse Karte keine unerwünschten Elemente enthält.

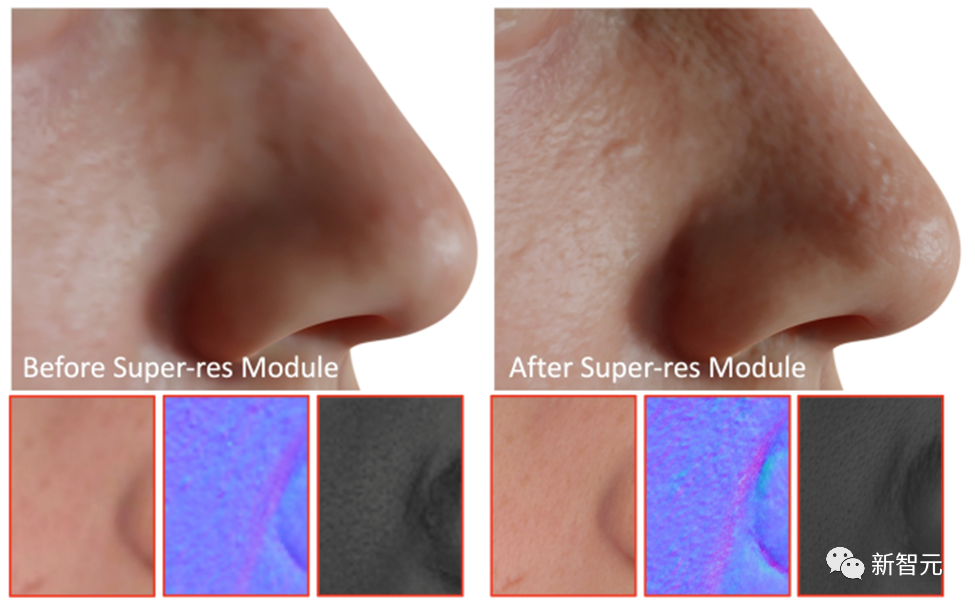

Als letzten Schritt wendet DreamFace das Super-Resolution-Modul an, um physikalisch basierte 4K-Texturen für ein hochwertiges Rendering zu generieren.

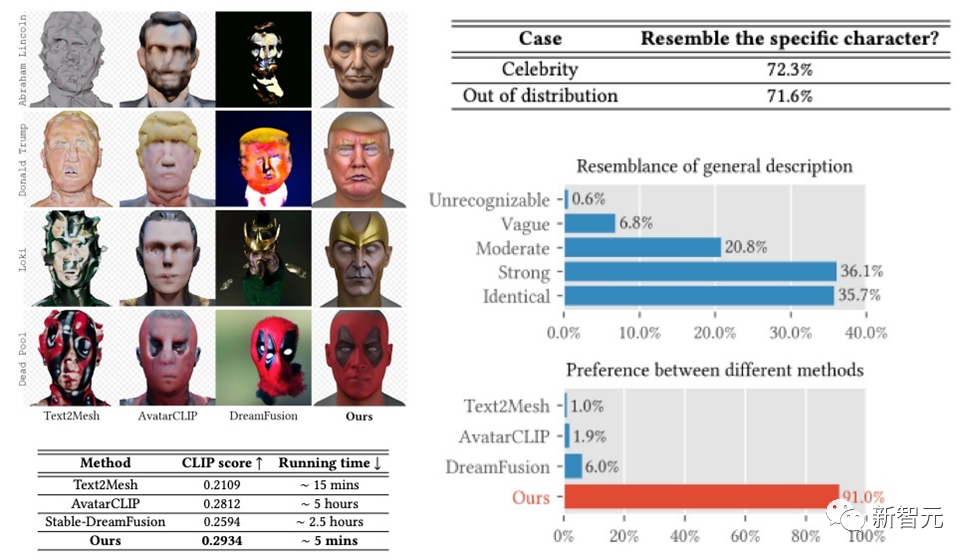

Das DreamFace-Framework hat sehr gute Ergebnisse bei der Generierung von Prominenten und Charakteren auf der Grundlage von Beschreibungen erzielt und Ergebnisse erzielt, die frühere Arbeiten bei Benutzerstudien weit übertreffen. Im Vergleich zu früheren Arbeiten weist es auch offensichtliche Vorteile bei der Laufzeit auf.

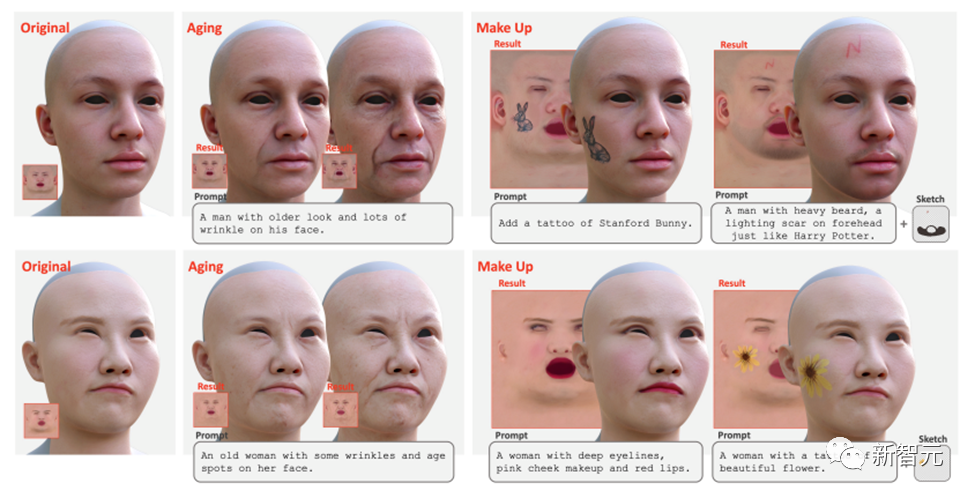

Darüber hinaus unterstützt DreamFace auch die Texturbearbeitung mithilfe von Tipps und Skizzen. Globale Bearbeitungseffekte wie Alterung und Make-up können durch die direkte Verwendung fein abgestimmter Textur-LDMs und Cues erzielt werden. Durch die weitere Kombination von Masken oder Skizzen können verschiedene Effekte wie Tätowierungen, Bärte und Muttermale erzeugt werden.

Animationsfunktionsgenerierung

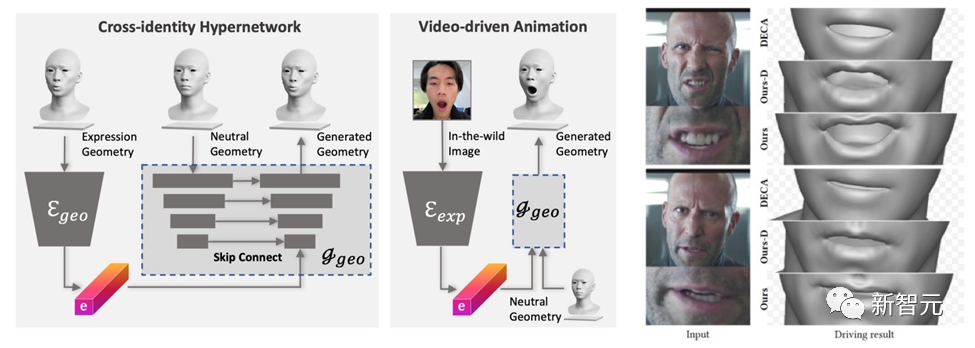

Das von DreamFace generierte Modell verfügt über Animationsfunktionen. Im Gegensatz zu BlendShapes-basierten Methoden erzeugt die neuronale Gesichtsanimationsmethode von DreamFace personalisierte Animationen, indem sie einzigartige Verformungen vorhersagt, um das resultierende neutrale Modell zu animieren.

Zuerst wird ein Geometriegenerator trainiert, um den latenten Raum von Ausdrücken zu lernen, wobei der Decoder erweitert wird, um auf neutrale Geometrien konditioniert zu werden. Anschließend wird der Ausdrucksencoder weiter trainiert, um Ausdrucksmerkmale aus RGB-Bildern zu extrahieren. Daher ist DreamFace in der Lage, mithilfe monokularer RGB-Bilder personalisierte Animationen zu generieren, die auf neutralen geometrischen Formen basieren.

Im Vergleich zu DECA, das generische BlendShapes zur Ausdruckssteuerung verwendet, bietet das Framework von DreamFace feine Ausdrucksdetails und ist in der Lage, Darbietungen mit feinen Details zu erfassen.

Fazit

In diesem Artikel wird DreamFace vorgestellt, ein textgesteuertes progressives 3D-Generierungsframework, das die neuesten visuellen Sprachmodelle, implizite Diffusionsmodelle und physikalisch basierte Materialdiffusionstechnologie kombiniert.

Zu den wichtigsten Innovationen von DreamFace gehören die Geometriegenerierung, die physikalisch basierte Materialdiffusionsgenerierung und die Generierung von Animationsmöglichkeiten. Im Vergleich zu herkömmlichen 3D-Generierungsmethoden bietet DreamFace eine höhere Genauigkeit, eine schnellere Laufgeschwindigkeit und eine bessere CG-Pipeline-Kompatibilität.

Das progressive Generierungsframework von DreamFace bietet eine effektive Lösung für die Lösung komplexer 3D-Generierungsaufgaben und dürfte weitere ähnliche Forschungs- und Technologieentwicklungen fördern.

Darüber hinaus wird die physikalisch basierte Materialdiffusionsgenerierung und die Generierung von Animationsfähigkeiten die Anwendung der 3D-Generierungstechnologie in der Film- und Fernsehproduktion, der Spieleentwicklung und anderen verwandten Branchen fördern.

Das obige ist der detaillierte Inhalt vonDie Shanghai University of Science and Technology und andere haben DreamFace veröffentlicht: Nur Text kann einen „hyperrealistischen 3D-Digitalmenschen' erzeugen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Die Shanghai University of Science and Technology und andere haben DreamFace veröffentlicht: Nur Text kann einen „hyperrealistischen 3D-Digitalmenschen' erzeugen.

May 17, 2023 am 08:02 AM

Die Shanghai University of Science and Technology und andere haben DreamFace veröffentlicht: Nur Text kann einen „hyperrealistischen 3D-Digitalmenschen' erzeugen.

May 17, 2023 am 08:02 AM

Mit der Entwicklung von Large Language Model (LLM), Diffusion (Diffusion) und anderen Technologien hat die Geburt von Produkten wie ChatGPT und Midjourney eine neue Welle der KI-Begeisterung ausgelöst, und auch generative KI ist zu einem Thema großer Besorgnis geworden. Im Gegensatz zu Text und Bildern befindet sich die 3D-Generierung noch im Stadium der technologischen Erforschung. Ende 2022 haben Google, NVIDIA und Microsoft nacheinander ihre eigene 3D-Generierungsarbeit gestartet, die meisten davon basieren jedoch auf der impliziten Expression des Advanced Neural Radiation Field (NeRF) und sind nicht mit den Rendering-Pipelines industrieller 3D-Software wie Unity kompatibel , UnrealEngine und Maya. Selbst wenn es mit herkömmlichen Lösungen in eine durch Mesh ausgedrückte geometrische und farbliche Karte umgewandelt wird, führt dies zu einem Mangel an Genauigkeit.

Große Modelle sind bei digitalen Menschen beliebt: Ein Satz kann in 5 Minuten angepasst werden, und Sie können ihn beim Tanzen, Hosten und Ausliefern von Waren halten

May 08, 2024 pm 08:10 PM

Große Modelle sind bei digitalen Menschen beliebt: Ein Satz kann in 5 Minuten angepasst werden, und Sie können ihn beim Tanzen, Hosten und Ausliefern von Waren halten

May 08, 2024 pm 08:10 PM

In nur 5 Minuten können Sie einen digitalen 3D-Menschen erstellen, der direkt mit der Arbeit beginnen kann. Dies ist der jüngste Schock, den große Modelle im Bereich der digitalen Menschen ausgelöst haben. Genau so beschreibt ein Satz die Anforderung: Die generierten digitalen Menschen können direkt den Live-Übertragungsraum betreten und als Moderatoren dienen. Es ist kein Problem, bei einem Girlgroup-Tanz mitzutanzen. Sagen Sie während des gesamten Produktionsprozesses einfach, was Ihnen in den Sinn kommt. Das große Modell kann die Anforderungen automatisch zerlegen, und Sie können sofort Entwürfe erstellen und Ideen ändern. △Mit der 2-fachen Geschwindigkeit müssen Sie sich keine Sorgen mehr machen, dass die Ideen des Chefs/der Gruppe A zu neuartig sind. Diese digitale Humantechnologie von Vincent stammt aus der neuesten Version der Baidu Intelligent Cloud. Es ist an der Zeit, es zu sagen oder nicht, aber es ist an der Zeit, die Hürde für digitale Menschen zu senken, es auf einen Schlag zu nutzen. Nachdem wir von einem solchen Artefakt gehört haben, haben wir uns wie gewohnt sofort die Qualifikation für interne Tests gesichert. Werfen wir einen Blick auf weitere Details ~ In 5 Minuten in einem Satz wird der 3D-Digitalmann direkt im Einsatz sein.

Verdammt, ich bin von digitalen Kollegen umgeben! Die digitalen Mitarbeiter von Xiaobing AI werden erneut aufgerüstet, mit Anpassung ohne Muster und sofortiger Beschäftigung

Jul 19, 2024 pm 05:52 PM

Verdammt, ich bin von digitalen Kollegen umgeben! Die digitalen Mitarbeiter von Xiaobing AI werden erneut aufgerüstet, mit Anpassung ohne Muster und sofortiger Beschäftigung

Jul 19, 2024 pm 05:52 PM

„Hallo, ich bin gerade unserem Unternehmen beigetreten. Wenn ich Fragen zum Geschäft habe, geben Sie mir bitte Ihren Rat!“ Was, diese Kollegen sind alles „digitale Menschen“, die von großen Vorbildern angetrieben werden? Es dauert nur 30 Sekunden Bild, 10 Sekunden Ton und 10 Minuten, um schnell einen „digitalen Kollegen“ anzupassen, der sich nicht von einer echten Person unterscheidet. Es kann in Echtzeit direkt mit Ihnen interagieren und verfügt über eine hochwertige Audio- und Videoübertragung mit geringer Latenz auf der Ebene des Kommunikationsbetreibers. So: So: Dies ist die neueste von Xiaoice eingeführte „Zero-Shot Xiaoice Neural Rendering, Zero-XNR“-Technologie, die auf einer großen Modellbasis von über 100 Milliarden neuer Technologien basiert

Digitale Menschen zünden die Hauptfackel der Asienspiele, und dieser ICCV-Artikel enthüllt Ants generative KI-Schwarztechnologie

Sep 29, 2023 pm 11:57 PM

Digitale Menschen zünden die Hauptfackel der Asienspiele, und dieser ICCV-Artikel enthüllt Ants generative KI-Schwarztechnologie

Sep 29, 2023 pm 11:57 PM

Öffnen Sie einen digitalen Menschen und er wird voller generativer KI sein. Am Abend des 23. September, bei der Eröffnungszeremonie der Asienspiele in Hangzhou, zeigte das Anzünden der Hauptfackel die „kleinen Flammen“ von Hunderten Millionen digitalen Fackelträgern, die sich online am Qiantang-Fluss versammelten und das Bild eines digitalen Menschen formten . Dann gingen der digitale menschliche Fackelträger und der sechste Fackelträger vor Ort gemeinsam zur Fackelbühne und zündeten gemeinsam die Hauptfackel an. Als Kernidee der Eröffnungsfeier wurde das digital-real-vernetzte Fackelbeleuchtungsformat zu einem heißen Suchthema , das Interesse der Menschen wecken. Umgeschriebener Inhalt: Als Kernidee der Eröffnungszeremonie hat die Fackelbeleuchtungsmethode des Digital Reality Internet hitzige Diskussionen ausgelöst und die Aufmerksamkeit der Menschen auf sich gezogen. Hunderte Millionen Menschen haben daran teilgenommen große Anzahl fortschrittlicher und komplexer Technologien. Eine der wichtigsten Fragen ist das Wie

Yang Dong, technischer Plattformdirektor von Unity Greater China: Beginn der digitalen menschlichen Reise im Metaversum

Apr 08, 2023 pm 06:11 PM

Yang Dong, technischer Plattformdirektor von Unity Greater China: Beginn der digitalen menschlichen Reise im Metaversum

Apr 08, 2023 pm 06:11 PM

Als Eckpfeiler beim Aufbau von Metaverse-Inhalten sind digitale Menschen die frühesten ausgereiften Szenarien für die Metaverse-Unterteilung, die implementiert und nachhaltig weiterentwickelt werden können. Derzeit wurden kommerzielle Anwendungen wie virtuelle Idole, E-Commerce-Bereitstellung, TV-Hosting und virtuelle Anker erkannt die Öffentlichkeit. In der Welt des Metaversums sind nichts Geringeres als digitale Menschen einer der wichtigsten Inhalte, denn digitale Menschen sind nicht nur die „Inkarnationen“ realer Menschen im Metaversum, sie sind auch eines der wichtigsten Vehikel für uns Führen Sie verschiedene Interaktionen im Metaversum durch. Es ist bekannt, dass das Erstellen und Rendern realistischer digitaler menschlicher Charaktere eines der schwierigsten Probleme in der Computergrafik ist. Kürzlich gab der technische Direktor der Unity Greater China Platform, Yang Dong, auf der von 51CTO veranstalteten MetaCon Metaverse Technology Conference „Game and AI Interaction“ eine Reihe von Demo-Demonstrationen

Was ist ein digitaler Mensch und was bringt die Zukunft?

Oct 16, 2023 pm 02:25 PM

Was ist ein digitaler Mensch und was bringt die Zukunft?

Oct 16, 2023 pm 02:25 PM

In der heutigen technologisch fortgeschrittenen Welt sind lebensechte digitale Menschen zu einem aufstrebenden Bereich geworden, der viel Aufmerksamkeit erregt. Als digitales virtuelles Bild, das dem menschlichen Bild nahe kommt, das auf der Grundlage von Computergrafik-Technologie (CG) und künstlicher Intelligenz erstellt wurde, können digitale Menschen den Menschen bequemere, effizientere und personalisiertere Dienste bieten. Gleichzeitig kann das Aufkommen digitaler Menschen auch die Entwicklung der virtuellen Wirtschaft fördern und mehr Möglichkeiten für die Innovation digitaler Inhalte und den digitalen Konsum bieten. Laut einem Bericht der International Data Corporation (IDC) wird der weltweite Markt für virtuelle digitale Menschen im Jahr 2025 voraussichtlich 27 Milliarden US-Dollar erreichen, mit einer durchschnittlichen jährlichen Wachstumsrate von 22,5 %. Es zeigt sich, dass digitale Menschen sehr breite Anwendungsaussichten und Marktpotenziale haben. Was ist ein digitaler Mensch? Digitale Menschen haben Glück

DreamFace: Einen digitalen 3D-Menschen in einem Satz generieren?

May 16, 2023 pm 09:46 PM

DreamFace: Einen digitalen 3D-Menschen in einem Satz generieren?

May 16, 2023 pm 09:46 PM

Heutzutage, mit der rasanten Entwicklung von Wissenschaft und Technologie, rückt die Forschung in den Bereichen generative künstliche Intelligenz und Computergrafik zunehmend in den Fokus. Branchen wie die Film- und Fernsehproduktion sowie die Spieleentwicklung stehen vor großen Herausforderungen und Chancen. Dieser Artikel stellt Ihnen eine Forschung auf dem Gebiet der 3D-Generierung vor – DreamFace, das erste textgesteuerte progressive 3D-Generierungs-Framework, das die Generierung von produktionsbereiten 3D-Assets unterstützt und textgenerierte hyperrealistische digitale 3D-Menschen realisieren kann. Diese Arbeit wurde von Transactionson Graphics, der führenden internationalen Fachzeitschrift im Bereich Computergrafik, angenommen und wird auf der führenden internationalen Computergrafikkonferenz SIGGRAPH2023 vorgestellt. Projektwebsite: https://sites.

KI und digitaler Mensch realisieren neue Interaktion China Telecom bringt KI in das intelligente Leben

May 27, 2023 pm 12:34 PM

KI und digitaler Mensch realisieren neue Interaktion China Telecom bringt KI in das intelligente Leben

May 27, 2023 pm 12:34 PM

(Fotoquelle: Photo Network) (Reporter Chen Jinfeng) Vor kurzem begann das Shanghai Information Consumption Festival 2023, und „digitale Menschen“ sind zu den unvermeidlichen Protagonisten geworden. Brancheninsider glauben, dass der Einsatz von KI-Technologie die Entwicklung hochwertiger Inhalte beschleunigen wird und virtuelle digitale Menschen zu einem neuen Verkehrszugang werden könnten. KI-Digitalmenschen halten Einzug in den Alltag Mit der Entwicklung von künstlicher Intelligenz, virtueller Realität und anderen Technologien halten virtuelle Digitalmenschen Einzug in den Alltag der Menschen und spielen in vielen Bereichen eine einzigartige Rolle. Die virtuelle Schönheitsexpertin Liu Yexi erhielt innerhalb von drei Tagen nach ihrem Douyin-Debüt über Nacht das beste virtuelle Idol in China. Beim Silvesterkonzert von Jiangsu Satellite TV kehrte die ehemalige Sängerin Teresa Teng mit Sängerin Zhou auf die Bühne zurück Shen auf derselben Bühne, die die Jugenderinnerungen mehrerer Generationen miteinander verwob; mehr als 20 digitale Menschen traten bei den Olympischen Winterspielen auf derselben Bühne auf und fungierten als Protagonisten der Gebärdensprache