Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Google gerät in Panik! Wenn Sie einen Artikel veröffentlichen möchten, müssen Sie eine Genehmigung einholen und der Produktentwicklung Vorrang einräumen: Ist ChatGPT ein Abgesang auf dem Gebiet der künstlichen Intelligenz?

Google gerät in Panik! Wenn Sie einen Artikel veröffentlichen möchten, müssen Sie eine Genehmigung einholen und der Produktentwicklung Vorrang einräumen: Ist ChatGPT ein Abgesang auf dem Gebiet der künstlichen Intelligenz?

Google gerät in Panik! Wenn Sie einen Artikel veröffentlichen möchten, müssen Sie eine Genehmigung einholen und der Produktentwicklung Vorrang einräumen: Ist ChatGPT ein Abgesang auf dem Gebiet der künstlichen Intelligenz?

Die rasante Entwicklung der KI in den letzten zehn Jahren hat von der Zusammenarbeit von Universitäten, Unternehmen und einzelnen Entwicklern profitiert und den Bereich der künstlichen Intelligenz voller Open-Source-Code, Daten und Tutorials gemacht # 🎜🎜#.

Google war auch führend in der KI-Branche und hat Artikel zu den Themen natürliche Sprachverarbeitung, Computer Vision, Reinforcement Learning und anderen Bereichen veröffentlicht und dazu beigetragen zur Industrie. Viele Grundmodelle und Architekturen wie Transformer, Bert, PaLM, etc. .

Aber OpenAI hat mit Transformer nicht nur ChatGPT entwickelt, sondern auch auf die Vorteile von Startups gesetzt, wie z als # 🎜🎜#Weniger von Gesetz und öffentlicher Meinung betroffen, Trainingsdaten, Modellgröße, Architektur und andere Informationen müssen nicht offengelegt werden Sie haben viele Mitarbeiter von großen Unternehmen wie Google abgeworben und Google verlor an Boden.

Angesichts von OpenAI, das keine Ethik hat, kann Google nur passiv geschlagen werden.Nach Angaben anonymer Quellen sagte

Google AI-Chef Jeff Dean im Februar dieses Jahres in einer Besprechung:# 🎜🎜 #Google würde seine eigenen KI-Entdeckungen ausnutzen und Papiere erst weitergeben, nachdem die Laborarbeit in Produkte umgewandelt worden sei

# 🎜🎜 #Google wird seine eigenen Errungenschaften im Bereich der künstlichen Intelligenz nutzen und Papiere erst dann weitergeben, wenn die Laborergebnisse in Produkte umgesetzt wurden.

Google, das sich in einen „Verteidigungsstaat“ verwandelt hat, hofft möglicherweise, alle ähnlichen KI-Unternehmen loszuwerden und sein Kerngeschäft im Bereich Suche und seinen Aktienkurs besser zu schützen.

Aber wenn der KI der Open-Source-Geist dieser großen Unternehmen fehlt und sie zum Monopol wird, wird es dann noch zu den bisherigen Entwicklungswundern im Bereich der künstlichen Intelligenz kommen?

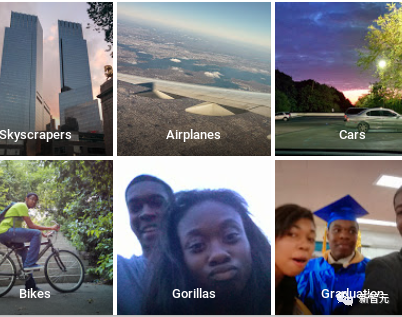

Google wurde gestohlen, nur weil es „zu verantwortungsvoll“ war

Für ein Unternehmen mit Milliarden von Nutzern wie Google sind sogar Experimente im kleinen Maßstab möglich kann auch Millionen von Menschen betreffen und von der öffentlichen Meinung abgelehnt werden. Aus diesem Grund zögert Google, Chatbots einzuführen und sich an die Maxime einer „verantwortungsvollen KI“ zu halten.Im Jahr 2015 führte Google Fotos eine Bildklassifizierungsfunktion ein und klassifizierte einen schwarzen Mann fälschlicherweise als Gorillas (Gorilla). Google geriet sofort in eine PR-Krise und entschuldigte sich schnell und korrigierte das Problem.

Die Korrekturmaßnahme von Google besteht darin, das Gorillas-Tag und sogar Kategorien direkt zu löschen wie Pudel, Schimpanse und Affe wurden gelöscht.

Die Korrekturmaßnahme von Google besteht darin, das Gorillas-Tag und sogar Kategorien direkt zu löschen wie Pudel, Schimpanse und Affe wurden gelöscht.

Das Ergebnis ist, dass der Bildklassifikator schwarze Menschen nicht mehr als Orang-Utans identifizieren kann, aber er kann keine echten Orang-Utans mehr identifizieren.

Obwohl Google seit vielen Jahren viel Geld in die Entwicklung künstlicher Intelligenztechnologie investiert, kann Google dies aufgrund der Black-Box-Unerklärlichkeit neuronaler Netze nicht vollständig garantieren Die Kontrollierbarkeit erfordert längere Sicherheitstests und der First-Mover-Vorteil geht verloren.

Im April dieses Jahres machte Google-Chef Sundar Pichai während der Sendung „60 Minutes“ noch deutlich, dass die Menschen vorsichtig sein müssen, was künstliche Intelligenz angeht großer Schaden für die Gesellschaft, wie zum Beispiel das Fälschen von Bildern und Videos.

Wenn Google sich dafür entscheidet, „weniger verantwortungsvoll“ zu sein, wird es unweigerlich die Aufmerksamkeit von mehr Regulierungsbehörden, Forschern für künstliche Intelligenz und Wirtschaftsführern auf sich ziehen.

Aber DeepMind-Mitbegründer Mustafa Suleyman sagte, dass das nicht daran liegt, dass sie zu vorsichtig sind, sondern nur daran, dass sie nicht bereit sind, bestehende Einnahmequellen und Geschäftsmodelle zu stören beginnen zu erwachen, wenn es eine echte äußere Bedrohung gibt.

Und diese Bedrohung ist bereits gekommen.

Für Google läuft die Zeit davon

Seit 2010 hat Google damit begonnen, Startups für künstliche Intelligenz zu erwerben und verwandte Technologien zu integrieren. Integrieren Sie diese schrittweise in Ihr Unternehmen eigene Produkte.Im Jahr 2013 lud Google den Deep-Learning-Pionier und Turing-Award-Gewinner Hinton ein (er war gerade gegangen); ein Jahr später übernahm Google das Startup-Unternehmen auch für die USA 625 Millionen US-Dollar. DeepMind

Kurz nach seiner Ernennung zum CEO von Google kündigte Pichai sogar an, dass Google „AI first“ als grundlegende Strategie zur Integration künstlicher Intelligenz in verwenden werde alle seine Produkte.

Jahrelange harte Arbeit hat auch dem Google-Forschungsteam für künstliche Intelligenz viele Durchbrüche ermöglicht, aber gleichzeitig haben auch einige kleinere Startups einige Erfolge auf dem Gebiet der künstlichen Intelligenz erzielt.

OpenAI wurde ursprünglich gegründet, um das Monopol großer Technologieunternehmen auf die Übernahme von Unternehmen im Bereich der künstlichen Intelligenz auszugleichen. Aufgrund der Vorteile kleiner Unternehmen unterliegt es weniger Kontrolle und Aufsicht und ist eher bereit, schnell zu handeln Bereitstellung von Modellen der künstlichen Intelligenz in den Händen normaler Benutzer.

Das Wettrüsten mit künstlicher Intelligenz verschärft sich also ohne Aufsicht. Angesichts der Konkurrenz kann die „Verantwortung“ großer Unternehmen allmählich nachlassen.

Google-Führungskräfte müssen auch die Perspektiven allgemeiner Konzepte der künstlichen Intelligenz wie „Künstliche Intelligenz-Technologie-Matching“ und „Übermenschliche Intelligenz“ auswählen, die von DeepMind unterstützt werden.

Am 21. April dieses Jahres kündigte Pichai die Fusion von Google Brain, das ursprünglich von Jeff Dean betrieben wurde, und dem zuvor übernommenen DeepMind an und beauftragte den Mitbegründer und CEO von DeepMind, Demis Hassabis, damit, die Entwicklung von Google zu beschleunigen Bereich der künstlichen Intelligenz.

Hassabis glaubt, dass das Niveau der künstlichen Intelligenz innerhalb weniger Jahre näher am Niveau der menschlichen Intelligenz liegen könnte, als die meisten Experten vorhersagen.

Google ist in die „Kriegsbereitschaft“ eingetreten

Laut Interviews ausländischer Medien mit 11 aktuellen und ehemaligen Google-Mitarbeitern hat Google in den letzten Monaten eine umfassende Reform seines Geschäfts mit künstlicher Intelligenz durchgeführt, mit dem Hauptziel: Schnelle Einführung von Produkten Senken Sie die Hürden für die Einführung experimenteller KI-Tools für kleine Benutzergruppen und entwickeln Sie neue Bewertungsmetriken und Prioritäten in Bereichen wie Fairness.

Bruder Pichai betonte, dass Googles Versuch, Forschung und Entwicklung zu beschleunigen, keine Abstriche bedeutet.

Wir richten eine neue Abteilung ein, die darauf abzielt, leistungsfähigere, sicherere und verantwortungsvollere Systeme aufzubauen, um die verantwortungsvolle Entwicklung der allgemeinen künstlichen Intelligenz sicherzustellen.

Der frühere Google Brain-Forscher für künstliche Intelligenz, Brian Kihoon Lee, wurde im Januar dieses Jahres in einer Welle von Massenentlassungen entlassen. Er beschrieb den Übergang als Googles Übergang von „Friedenszeiten“ zu „Kriegszeiten“, sobald der Wettbewerb hart wird. In einer Kriegssituation sind auch Marktanteilsgewinne der Wettbewerber von entscheidender Bedeutung.

Google-Sprecher Brian Gabriel sagte: Im Jahr 2018 hat Google eine interne Managementstruktur und einen umfassenden Überprüfungsprozess etabliert und bisher Hunderte von Bewertungen in verschiedenen Produktbereichen durchgeführt. Google wird diesen Prozess weiterhin auf alle KI-basierten Technologien anwenden und sicherstellen, dass die verantwortungsvolle Entwicklung der KI für das Unternehmen weiterhin oberste Priorität hat.

Allerdings haben die sich ändernden Standards zur Bestimmung, wann Produkte der künstlichen Intelligenz marktreif sind, auch bei den Mitarbeitern für Unbehagen gesorgt. Nachdem Google beispielsweise beschlossen hatte, Bard freizugeben, senkte es die Testergebnisstandards für experimentelle Produkte der künstlichen Intelligenz, was zu Unruhe führte interne Spannungen.

Anfang 2023 kündigte Google etwa 20 Richtlinien an, die von zwei Teams für künstliche Intelligenz (Responsible Innovation und Responsible AI) um Bard festgelegt wurden. Die Mitarbeiter waren im Allgemeinen der Ansicht, dass diese Vorschriften recht klar und vollständig seien.

Einige Mitarbeiter glauben, dass diese Standards eher eine Leistung für die Außenwelt sind. Es ist besser, öffentliche Trainingsdaten oder Open-Source-Modelle bereitzustellen, damit Benutzer ein klareres Verständnis der Fähigkeiten der Modelle haben.

Die Veröffentlichung von Papieren erfordert eine Genehmigung

Die Entscheidung von Google, Forschung und Entwicklung zu beschleunigen, ist ein gemischter Segen für die Mitarbeiter.

Die gute Nachricht ist, dass Mitarbeiter in nicht-wissenschaftlichen Forschungspositionen grundsätzlich optimistisch sind und glauben, dass diese Entscheidung Google dabei helfen kann, wieder die Oberhand zu gewinnen.

Aber für Forscher kann die Notwendigkeit, vor der Veröffentlichung relevanter Forschungsergebnisse im Bereich der künstlichen Intelligenz zusätzliche Genehmigungen einzuholen, dazu führen, dass Forscher neue Möglichkeiten im sich schnell entwickelnden Bereich der generativen künstlichen Intelligenz verpassen.

Es gibt auch Bedenken, dass Google kontroverse Papiere stillschweigend unterdrücken könnte, wie beispielsweise eine Studie aus dem Jahr 2020 über die Gefahren großer Sprachmodelle, die vom Ethical AI-Team von Google geleitet und von Timnit Gebru und Margaret Mitchell gemeinsam verfasst wurde.

Viele Spitzenforscher im Bereich der künstlichen Intelligenz wurden im vergangenen Jahr von Start-ups abgeworben, was teilweise auf Googles Nachlässigkeit und übermäßige Prüfung der Ergebnisse wissenschaftlicher Forscher zurückzuführen ist.

Um eine Arbeit zu genehmigen, kann es strenge Wiederholungen durch erfahrene Forscher erfordern, sagt ein ehemaliger Google-Forscher. Google hat viele Forscher engagiert, damit sie sich weiterhin an breiteren Forschungsthemen in diesem Bereich beteiligen können, und Veröffentlichungsbeschränkungen könnten dazu führen, dass eine andere Gruppe von Forschern das Unternehmen verlässt.

Sollte die KI-Forschung und -Entwicklung verlangsamt werden?

Während Google seine Entwicklung beschleunigt, gibt es auch einige Stimmen, die nicht so harmonisch klingen. Sie fordern große Hersteller künstlicher Intelligenz auf, die Entwicklungsgeschwindigkeit zu verlangsamen, und glauben, dass die Entwicklungsgeschwindigkeit Diese Technologie hat die Erwartungen des Erfinders übertroffen.

Geoffrey Hinton, ein Pionier im Bereich Deep Learning, verließ Google aus Angst vor der potenziellen Gefahr superintelligenter KI, die der menschlichen Kontrolle entkommen könnte.

Verbraucher beginnen allmählich, die Risiken und Grenzen großer Sprachmodelle zu verstehen, wie etwa die Tendenz künstlicher Intelligenz, Fakten zu erfinden usw., aber es gibt keine kleinen Drucken Sie den Haftungsausschluss auf ChatGPT. Erläutern Sie die Einschränkungen.

Nachgelagerte Anwendungen, die auf ChatGPT basieren, haben weitere Probleme aufgedeckt. Beispielsweise führte Professor Percy Liang von der Stanford University einmal eine Studie durch, und die von New Bing bereitgestellten Zitate betrugen nur etwa 70 % ist richtig.

Am 4. Mai lud das Weiße Haus die CEOs von Google, OpenAI und Microsoft zu einem Treffen ein, um öffentliche Bedenken hinsichtlich der KI-Technologie und der Regulierung von KI zu diskutieren.

US-Präsident Biden machte im Einladungsschreiben deutlich, dass KI-Unternehmen die Sicherheit ihrer Produkte gewährleisten müssen, bevor sie der Öffentlichkeit zugänglich gemacht werden können.

Das obige ist der detaillierte Inhalt vonGoogle gerät in Panik! Wenn Sie einen Artikel veröffentlichen möchten, müssen Sie eine Genehmigung einholen und der Produktentwicklung Vorrang einräumen: Ist ChatGPT ein Abgesang auf dem Gebiet der künstlichen Intelligenz?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Laravels Geospatial: Optimierung interaktiver Karten und großen Datenmengen

Apr 08, 2025 pm 12:24 PM

Verarbeiten Sie 7 Millionen Aufzeichnungen effizient und erstellen Sie interaktive Karten mit Geospatial -Technologie. In diesem Artikel wird untersucht, wie über 7 Millionen Datensätze mithilfe von Laravel und MySQL effizient verarbeitet und in interaktive Kartenvisualisierungen umgewandelt werden können. Erstes Herausforderungsprojektanforderungen: Mit 7 Millionen Datensätzen in der MySQL -Datenbank wertvolle Erkenntnisse extrahieren. Viele Menschen erwägen zunächst Programmiersprachen, aber ignorieren die Datenbank selbst: Kann sie den Anforderungen erfüllen? Ist Datenmigration oder strukturelle Anpassung erforderlich? Kann MySQL einer so großen Datenbelastung standhalten? Voranalyse: Schlüsselfilter und Eigenschaften müssen identifiziert werden. Nach der Analyse wurde festgestellt, dass nur wenige Attribute mit der Lösung zusammenhängen. Wir haben die Machbarkeit des Filters überprüft und einige Einschränkungen festgelegt, um die Suche zu optimieren. Kartensuche basierend auf der Stadt

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Wie man MySQL löst, kann nicht gestartet werden

Apr 08, 2025 pm 02:21 PM

Es gibt viele Gründe, warum MySQL Startup fehlschlägt und durch Überprüfung des Fehlerprotokolls diagnostiziert werden kann. Zu den allgemeinen Ursachen gehören Portkonflikte (prüfen Portbelegung und Änderung der Konfiguration), Berechtigungsprobleme (Überprüfen Sie den Dienst Ausführen von Benutzerberechtigungen), Konfigurationsdateifehler (Überprüfung der Parametereinstellungen), Datenverzeichniskorruption (Wiederherstellung von Daten oder Wiederaufbautabellenraum), InnoDB-Tabellenraumprobleme (prüfen IBDATA1-Dateien), Plug-in-Ladeversagen (Überprüfen Sie Fehlerprotokolle). Wenn Sie Probleme lösen, sollten Sie sie anhand des Fehlerprotokolls analysieren, die Hauptursache des Problems finden und die Gewohnheit entwickeln, Daten regelmäßig zu unterstützen, um Probleme zu verhindern und zu lösen.

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

So verwenden Sie MySQL nach der Installation

Apr 08, 2025 am 11:48 AM

Der Artikel führt den Betrieb der MySQL -Datenbank vor. Zunächst müssen Sie einen MySQL -Client wie MySQLworkBench oder Befehlszeilen -Client installieren. 1. Verwenden Sie den Befehl mySQL-uroot-P, um eine Verbindung zum Server herzustellen und sich mit dem Stammkonto-Passwort anzumelden. 2. Verwenden Sie die Erstellung von Createdatabase, um eine Datenbank zu erstellen, und verwenden Sie eine Datenbank aus. 3.. Verwenden Sie CreateTable, um eine Tabelle zu erstellen, Felder und Datentypen zu definieren. 4. Verwenden Sie InsertInto, um Daten einzulegen, Daten abzufragen, Daten nach Aktualisierung zu aktualisieren und Daten nach Löschen zu löschen. Nur indem Sie diese Schritte beherrschen, lernen, mit gemeinsamen Problemen umzugehen und die Datenbankleistung zu optimieren, können Sie MySQL effizient verwenden.

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Verstehen von Säureeigenschaften: Die Säulen einer zuverlässigen Datenbank

Apr 08, 2025 pm 06:33 PM

Detaillierte Erläuterung von Datenbanksäureattributen Säureattribute sind eine Reihe von Regeln, um die Zuverlässigkeit und Konsistenz von Datenbanktransaktionen sicherzustellen. Sie definieren, wie Datenbanksysteme Transaktionen umgehen, und sorgen dafür, dass die Datenintegrität und -genauigkeit auch im Falle von Systemabstürzen, Leistungsunterbrechungen oder mehreren Benutzern gleichzeitiger Zugriff. Säureattributübersicht Atomizität: Eine Transaktion wird als unteilbare Einheit angesehen. Jeder Teil schlägt fehl, die gesamte Transaktion wird zurückgerollt und die Datenbank behält keine Änderungen bei. Wenn beispielsweise eine Banküberweisung von einem Konto abgezogen wird, jedoch nicht auf ein anderes erhöht wird, wird der gesamte Betrieb widerrufen. begintransaktion; updateAccountsSetBalance = Balance-100WH

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

MySQL kann nach dem Herunterladen nicht installiert werden

Apr 08, 2025 am 11:24 AM

Die Hauptgründe für den Fehler bei MySQL -Installationsfehlern sind: 1. Erlaubnisprobleme, Sie müssen als Administrator ausgeführt oder den Sudo -Befehl verwenden. 2. Die Abhängigkeiten fehlen, und Sie müssen relevante Entwicklungspakete installieren. 3. Portkonflikte müssen Sie das Programm schließen, das Port 3306 einnimmt, oder die Konfigurationsdatei ändern. 4. Das Installationspaket ist beschädigt. Sie müssen die Integrität herunterladen und überprüfen. 5. Die Umgebungsvariable ist falsch konfiguriert und die Umgebungsvariablen müssen korrekt entsprechend dem Betriebssystem konfiguriert werden. Lösen Sie diese Probleme und überprüfen Sie jeden Schritt sorgfältig, um MySQL erfolgreich zu installieren.

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineers (Plattformen) benötigen Kreise

Apr 08, 2025 pm 12:27 PM

Remote Senior Backend Engineer Job Vacant Company: Circle Standort: Remote-Büro-Jobtyp: Vollzeitgehalt: 130.000 bis 140.000 US-Dollar Stellenbeschreibung Nehmen Sie an der Forschung und Entwicklung von Mobilfunkanwendungen und öffentlichen API-bezogenen Funktionen, die den gesamten Lebenszyklus der Softwareentwicklung abdecken. Die Hauptaufgaben erledigen die Entwicklungsarbeit unabhängig von RubyonRails und arbeiten mit dem Front-End-Team von React/Redux/Relay zusammen. Erstellen Sie die Kernfunktionalität und -verbesserungen für Webanwendungen und arbeiten Sie eng mit Designer und Führung während des gesamten funktionalen Designprozesses zusammen. Fördern Sie positive Entwicklungsprozesse und priorisieren Sie die Iterationsgeschwindigkeit. Erfordert mehr als 6 Jahre komplexes Backend für Webanwendungen

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

Kann MySQL JSON zurückgeben?

Apr 08, 2025 pm 03:09 PM

MySQL kann JSON -Daten zurückgeben. Die JSON_EXTRACT -Funktion extrahiert Feldwerte. Über komplexe Abfragen sollten Sie die Where -Klausel verwenden, um JSON -Daten zu filtern, aber auf die Leistungsauswirkungen achten. Die Unterstützung von MySQL für JSON nimmt ständig zu, und es wird empfohlen, auf die neuesten Versionen und Funktionen zu achten.

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laravel eloquent orm bei bangla partieller Modellsuche)

Apr 08, 2025 pm 02:06 PM

Laraveleloquent-Modellab Abruf: Das Erhalten von Datenbankdaten Eloquentorm bietet eine prägnante und leicht verständliche Möglichkeit, die Datenbank zu bedienen. In diesem Artikel werden verschiedene eloquente Modellsuchtechniken im Detail eingeführt, um Daten aus der Datenbank effizient zu erhalten. 1. Holen Sie sich alle Aufzeichnungen. Verwenden Sie die Methode All (), um alle Datensätze in der Datenbanktabelle zu erhalten: UseApp \ Models \ post; $ posts = post :: all (); Dies wird eine Sammlung zurückgeben. Sie können mit der Foreach-Schleife oder anderen Sammelmethoden auf Daten zugreifen: foreach ($ postas $ post) {echo $ post->