So implementieren Sie die Nginx-Strombegrenzung

So funktioniert die Nginx-Strombegrenzung

Die Nginx-Strombegrenzung verwendet den Leaky-Bucket-Algorithmus, der in der Kommunikation und in paketvermittelten Computern weit verbreitet ist Netzwerke zur Bewältigung von Notfällen, wenn die Bandbreite begrenzt ist. Das Prinzip ist einem Eimer sehr ähnlich, bei dem Wasser von oben eindringt und von unten ausläuft; wenn die Wasserzuflussrate größer ist als die Wasseraustrittsrate, läuft der Eimer über.

Im Anforderungsverarbeitungsprozess stellt das Wasser die Anforderung des Clients dar, und der Bucket stellt eine Warteschlange dar, in der die Anforderung darauf wartet, gemäß dem First-In-First-Out-Prinzip (FIFO) verarbeitet zu werden ) Algorithmus. Ein Leck bedeutet, dass eine Anfrage den Puffer verlässt und vom Server verarbeitet wird. Ein Überlauf bedeutet, dass eine Anfrage verworfen und nie bedient wird.

1. Zugriffshäufigkeit begrenzen (normaler Datenverkehr)

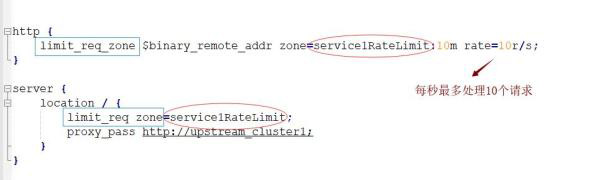

In Nginx verwenden wir ngx_http_limit_req_module Modul zur Begrenzung der Zugriffshäufigkeit von Anfragen, implementiert auf Basis des Leaky-Bucket-Algorithmus-Prinzips. Als nächstes verwenden wir die Nginx-Anweisungen limit_req_zone und limit_req, um die Anforderungsverarbeitungsrate einer einzelnen IP zu begrenzen.

Syntax: limit_req_zone key zone rate

Taste: Definieren Sie das aktuelle Begrenzungsobjekt, binär_remote_addr Es handelt sich um einen Schlüssel, der die aktuelle Begrenzung basierend auf remote_addr (Client-IP) darstellt. Der Zweck von binär_ besteht darin, die Speichernutzung zu komprimieren.

zone: Definieren Sie einen gemeinsamen Speicherbereich zum Speichern von Zugriffsinformationen: 10m stellt einen Speicherbereich mit einer Größe von 10m und dem Namen myratelimit dar. Alle 1 m können die Zugangsinformationen von 16.000 IP-Adressen speichern, sodass 10 m die Zugangsinformationen von 160.000 IP-Adressen speichern können.

Der Parameter „Rate“ wird verwendet, um die maximale Zugriffsrate festzulegen. „Rate=10r/s“ bedeutet, dass nicht mehr als 10 Anfragen pro Sekunde verarbeitet werden. . Nginx verfolgt Anforderungsinformationen tatsächlich mit einer Granularität von Millisekunden, daher ist 10r/s tatsächlich die Grenze: Alle 100 Millisekunden wird eine Anforderung verarbeitet. Dies bedeutet, dass die Bearbeitung der Anfrage verweigert wird, wenn innerhalb der nächsten 100 Millisekunden nach der Verarbeitung der letzten Anfrage eine weitere Anfrage eintrifft.

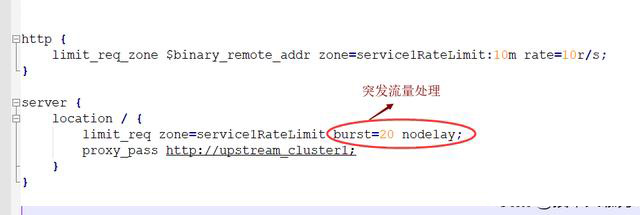

2. Begrenzen Sie die Zugriffshäufigkeit (Burst-Verkehr)

Gemäß der obigen Konfiguration, wenn der Verkehr plötzlich ansteigt Wenn es groß ist, werden übermäßige Anfragen abgelehnt und Burst-Verkehr kann nicht verarbeitet werden. Wie sollen wir also mit Burst-Verkehr umgehen? Nginx stellt den Burst-Parameter bereit, um das Problem des Burst-Verkehrs zu lösen, und wird in Verbindung mit dem Nodelay-Parameter verwendet. Burst wird als Burst, Burst übersetzt und gibt die Anzahl der zusätzlichen Anforderungen an, die nach Überschreiten der eingestellten Verarbeitungsrate verarbeitet werden können.

burst=20 nodelay bedeutet, dass diese 20 Anfragen sofort und ohne Verzögerung bearbeitet werden, was einer Sonderbearbeitung entspricht Fälle. Selbst wenn diese 20 Burst-Anfragen sofort verarbeitet werden, werden nachfolgende Anfragen nicht sofort verarbeitet. Burst = 20 entspricht der Belegung von 20 Lücken in der Cache-Warteschlange. Selbst wenn die Anforderung verarbeitet wird, können diese 20 Positionen nur alle 100 ms freigegeben werden. Dadurch wird der Effekt einer stabilen Geschwindigkeit erreicht, aber auch plötzlicher Verkehr kann normal verarbeitet werden.

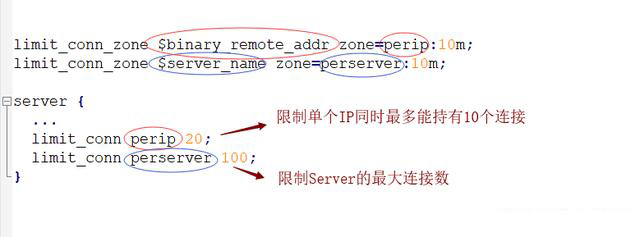

3. Begrenzen Sie die Anzahl gleichzeitiger Verbindungen

Das ngx_http_limit_conn_module-Modul bietet die Funktion, die Anzahl der Ressourcenverbindungen mithilfe von limit_conn_zone und limit_conn zu begrenzen zwei Nur ein Befehl reicht aus.

limit_conn perip 20: Der entsprechende Schlüssel ist $binary_remote_addr, was bedeutet, dass eine einzelne IP auf das gleichzeitige Halten von bis zu 20 Verbindungen beschränkt werden kann . limit_conn perserver 100: Der entsprechende Schlüssel ist $server_name, der die Gesamtzahl gleichzeitiger Verbindungen angibt, die der virtuelle Host (Server) gleichzeitig verarbeiten kann. Beachten Sie, dass diese Verbindung erst gezählt wird, nachdem der Anforderungsheader vom Backend-Server verarbeitet wurde.

Das obige ist der detaillierte Inhalt vonSo implementieren Sie die Nginx-Strombegrenzung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

So starten Sie Nginx unter Linux

Apr 14, 2025 pm 12:51 PM

So starten Sie Nginx unter Linux

Apr 14, 2025 pm 12:51 PM

Schritte zum Starten von Nginx unter Linux: Überprüfen Sie, ob Nginx installiert ist. Verwenden Sie SystemCTL Start Nginx, um den Nginx -Dienst zu starten. Verwenden Sie SystemCTL aktivieren NGINX, um das automatische Start von NGINX beim Systemstart zu aktivieren. Verwenden Sie den SystemCTL -Status NGINX, um zu überprüfen, ob das Startup erfolgreich ist. Besuchen Sie http: // localhost in einem Webbrowser, um die Standard -Begrüßungsseite anzuzeigen.

So überprüfen Sie, ob Nginx gestartet wird

Apr 14, 2025 pm 01:03 PM

So überprüfen Sie, ob Nginx gestartet wird

Apr 14, 2025 pm 01:03 PM

So bestätigen Sie, ob Nginx gestartet wird: 1. Verwenden Sie die Befehlszeile: SystemCTL Status Nginx (Linux/Unix), Netstat -ano | FindStr 80 (Windows); 2. Überprüfen Sie, ob Port 80 geöffnet ist; 3. Überprüfen Sie die Nginx -Startmeldung im Systemprotokoll. 4. Verwenden Sie Tools von Drittanbietern wie Nagios, Zabbix und Icinga.

So starten Sie den Nginx -Server

Apr 14, 2025 pm 12:27 PM

So starten Sie den Nginx -Server

Apr 14, 2025 pm 12:27 PM

Das Starten eines Nginx-Servers erfordert unterschiedliche Schritte gemäß verschiedenen Betriebssystemen: Linux/UNIX-System: Installieren Sie das NGINX-Paket (z. B. mit APT-Get oder Yum). Verwenden Sie SystemCTL, um einen Nginx -Dienst zu starten (z. B. sudo systemctl start nginx). Windows -System: Laden Sie Windows -Binärdateien herunter und installieren Sie sie. Starten Sie Nginx mit der ausführbaren Datei nginx.exe (z. B. nginx.exe -c conf \ nginx.conf). Unabhängig davon, welches Betriebssystem Sie verwenden, können Sie auf die Server -IP zugreifen

So lösen Sie Nginx403 -Fehler

Apr 14, 2025 pm 12:54 PM

So lösen Sie Nginx403 -Fehler

Apr 14, 2025 pm 12:54 PM

Der Server verfügt nicht über die Berechtigung, auf die angeforderte Ressource zuzugreifen, was zu einem NGINX 403 -Fehler führt. Zu den Lösungen gehören: Überprüfung der Dateiberechtigungen. Überprüfen Sie die Konfiguration .htaccess. Überprüfen Sie die Nginx -Konfiguration. Konfigurieren Sie Selinux -Berechtigungen. Überprüfen Sie die Firewall -Regeln. Fehlerbehebung bei anderen Ursachen wie Browserproblemen, Serverausfällen oder anderen möglichen Fehlern.

So konfigurieren Sie Nginx in Windows

Apr 14, 2025 pm 12:57 PM

So konfigurieren Sie Nginx in Windows

Apr 14, 2025 pm 12:57 PM

Wie konfiguriere ich Nginx in Windows? Installieren Sie NGINX und erstellen Sie eine virtuelle Hostkonfiguration. Ändern Sie die Hauptkonfigurationsdatei und geben Sie die Konfiguration der virtuellen Host ein. Starten oder laden Nginx neu. Testen Sie die Konfiguration und sehen Sie sich die Website an. Aktivieren Sie selektiv SSL und konfigurieren Sie SSL -Zertifikate. Stellen Sie die Firewall selektiv fest, damit Port 80 und 443 Verkehr.

So lösen Sie Nginx403

Apr 14, 2025 am 10:33 AM

So lösen Sie Nginx403

Apr 14, 2025 am 10:33 AM

Wie fixiere ich Nginx 403 Verbotener Fehler? Überprüfen Sie die Datei- oder Verzeichnisberechtigungen; 2.Htaccess -Datei prüfen; 3. Überprüfen Sie die Konfigurationsdatei der Nginx; 4. Starten Sie Nginx neu. Weitere mögliche Ursachen sind Firewall -Regeln, Selinux -Einstellungen oder Anwendungsprobleme.

So lösen Sie Nginx304 Fehler

Apr 14, 2025 pm 12:45 PM

So lösen Sie Nginx304 Fehler

Apr 14, 2025 pm 12:45 PM

Antwort auf die Frage: 304 Nicht geänderter Fehler gibt an, dass der Browser die neueste Ressourcenversion der Client -Anfrage zwischengespeichert hat. Lösung: 1. Löschen Sie den Browser -Cache; 2. Deaktivieren Sie den Browser -Cache; 3. Konfigurieren Sie Nginx, um den Client -Cache zu ermöglichen. 4. Überprüfen Sie die Dateiberechtigungen; 5. Datei Hash prüfen; 6. Deaktivieren Sie CDN oder Reverse Proxy -Cache; 7. Starten Sie Nginx neu.

Wie kann ich überprüfen, ob Nginx begonnen wird?

Apr 14, 2025 pm 12:48 PM

Wie kann ich überprüfen, ob Nginx begonnen wird?

Apr 14, 2025 pm 12:48 PM

Verwenden Sie unter Linux den folgenden Befehl, um zu überprüfen, ob Nginx gestartet wird: SystemCTL -Status Nginx Richter basierend auf der Befehlsausgabe: Wenn "aktiv: aktiv (lief) angezeigt wird, wird Nginx gestartet. Wenn "Active: Inactive (Dead)" angezeigt wird, wird Nginx gestoppt.