Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die Destillation kann auch Schritt für Schritt erfolgen: Durch die neue Methode können kleine Modelle mit großen Modellen verglichen werden, die 2000-mal größer sind

Die Destillation kann auch Schritt für Schritt erfolgen: Durch die neue Methode können kleine Modelle mit großen Modellen verglichen werden, die 2000-mal größer sind

Die Destillation kann auch Schritt für Schritt erfolgen: Durch die neue Methode können kleine Modelle mit großen Modellen verglichen werden, die 2000-mal größer sind

Obwohl große Sprachmodelle aufgrund ihres großen Umfangs über erstaunliche Fähigkeiten verfügen, sind die für ihre Bereitstellung erforderlichen Kosten oft enorm. Die University of Washington hat zusammen mit dem Google Cloud Computing Artificial Intelligence Research Institute und Google Research dieses Problem weiter gelöst und das Distilling Step-by-Step-Paradigma vorgeschlagen, um das Modelltraining zu unterstützen. Im Vergleich zu LLM ist diese Methode effektiver beim Training kleiner Modelle und deren Anwendung auf bestimmte Aufgaben und erfordert weniger Trainingsdaten als herkömmliche Feinabstimmung und Destillation. Bei einer Benchmark-Aufgabe übertraf das Modell 770M T5 das Modell 540B PaLM. Beeindruckend ist, dass ihr Modell nur 80 % der verfügbaren Daten nutzte.

Während große Sprachmodelle (LLMs) beeindruckende Lernfähigkeiten mit wenigen Schüssen gezeigt haben, ist es schwierig, solche groß angelegten Modelle in realen Anwendungen einzusetzen. Eine dedizierte Infrastruktur für ein LLM mit einer Parameterskala von 175 Milliarden erfordert mindestens 350 GB GPU-Speicher. Darüber hinaus besteht das moderne LLM heute aus mehr als 500 Milliarden Parametern, was bedeutet, dass es mehr Speicher und Rechenressourcen benötigt. Solche Rechenanforderungen sind für die meisten Hersteller unerreichbar, ganz zu schweigen von Anwendungen, die eine geringe Latenz erfordern.

Um dieses Problem großer Modelle zu lösen, verwenden Entwickler häufig stattdessen kleinere spezifische Modelle. Diese kleineren Modelle werden mithilfe gängiger Paradigmen trainiert – Feinabstimmung oder Destillation. Durch die Feinabstimmung wird ein kleines vorab trainiertes Modell mithilfe nachgeschalteter, von Menschen kommentierter Daten aktualisiert. Die Destillation trainiert ein ebenso kleineres Modell unter Verwendung der vom größeren LLM erzeugten Etiketten. Leider sind diese Paradigmen bei gleichzeitiger Reduzierung der Modellgröße mit Kosten verbunden: Um eine mit LLM vergleichbare Leistung zu erzielen, sind für die Feinabstimmung teure menschliche Markierungen erforderlich, während für die Destillation große Mengen unbeschrifteter Daten erforderlich sind, die schwer zu erhalten sind.

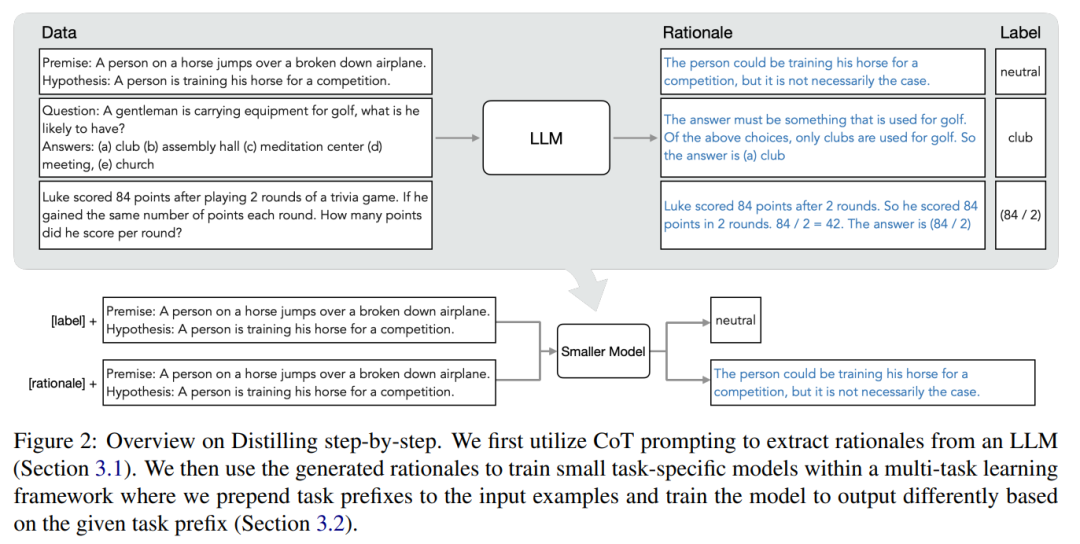

In einem Artikel mit dem Titel „Distilling Step-by-Step! Outperforming Larger Language Models with Less Training Data and Smaller Model Sizes“ stellten Forscher der University of Washington und Google einen neuen einfachen Mechanismus vor – Schritt-für-Schritt-Destillieren, Wird verwendet, um kleinere Modelle mit weniger Trainingsdaten zu trainieren. Dieser Mechanismus reduziert die Menge an Trainingsdaten, die zur Feinabstimmung und Destillation des LLM erforderlich sind, was zu einer kleineren Modellgröße führt. Der Kern dieses Mechanismus besteht darin, die Perspektive zu ändern und LLM als etwas zu betrachten, das kann als Argument dienen und nicht als Quelle lauter Etiketten dienen. LLM kann Begründungen in natürlicher Sprache generieren, die zur Erklärung und Unterstützung der vom Modell vorhergesagten Bezeichnungen verwendet werden können. Auf die Frage „Ein Herr trägt Golfausrüstung, was könnte er haben? (a) Schläger, (b) Auditorium, (c) Meditationszentrum, (d) Konferenz, (e) Kirche“ kann LLM antworten: „(a ) Club“ durch Gedankenketten-Argumentation (CoT) und rationalisieren Sie diese Bezeichnung, indem Sie erklären, dass „die Antwort etwas sein muss, das zum Golfspielen verwendet wird.“ Von den oben genannten Optionen werden nur Schläger zum Golfen verwendet. Wir verwenden diese Begründungen als zusätzliche, umfassendere Informationen, um kleinere Modelle in einer Trainingsumgebung mit mehreren Aufgaben zu trainieren und Etikettenvorhersagen und Begründungsvorhersagen durchzuführen.

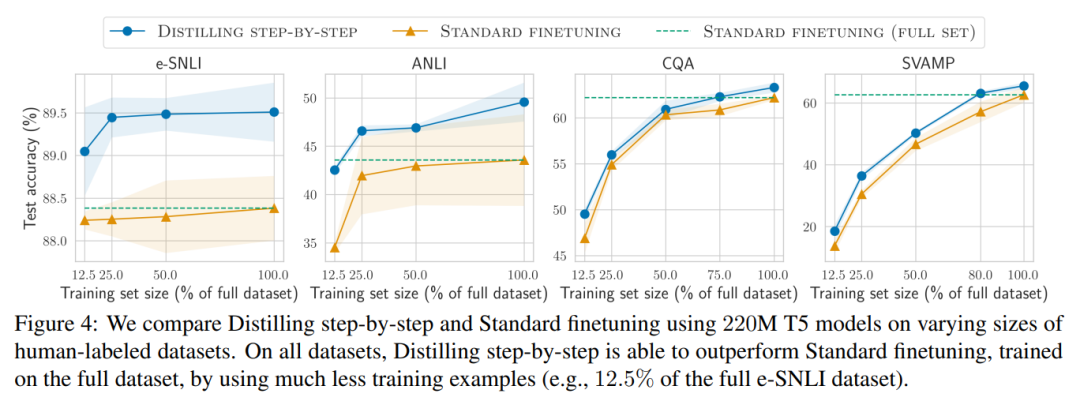

Wie in Abbildung 1 dargestellt, können durch schrittweise Destillation kleine Modelle für bestimmte Aufgaben erlernt werden, und die Anzahl der Parameter dieser Modelle beträgt weniger als 1/500 von LLM. Bei der schrittweisen Destillation werden außerdem weitaus weniger Trainingsbeispiele verwendet als bei der herkömmlichen Feinabstimmung oder Destillation.

Die experimentellen Ergebnisse zeigen, dass es unter den 4 NLP-Benchmarks drei vielversprechende experimentelle Schlussfolgerungen gibt.

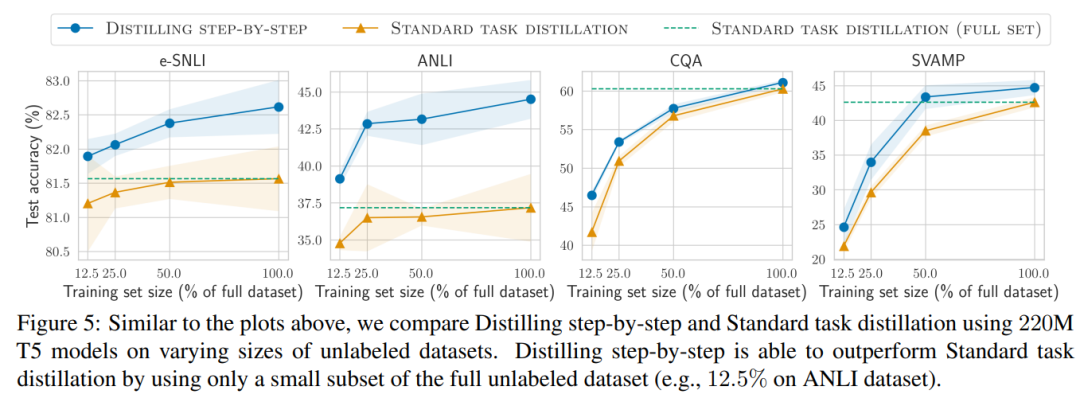

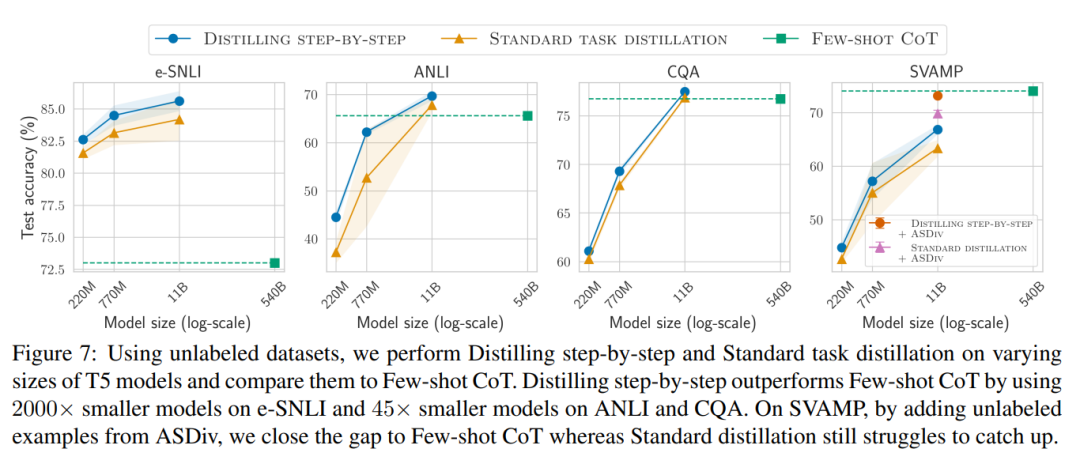

Wenn nur unbeschriftete Daten vorliegen, ist die Leistung des kleinen Modells immer noch so gut wie die von LLM – mit nur einem 11B übertrifft das T5-Modell die Leistung des 540B PaLM. Die Studie zeigt außerdem, dass eine schrittweise Destillation die zusätzlichen unbeschrifteten Daten effektiver nutzen kann, wenn ein kleineres Modell eine schlechtere Leistung als LLM erbringt, um es kleineren Modellen zu ermöglichen, die Leistung von LLM zu erreichen . Die Forscher schlugen ein neues Paradigma der schrittweisen Destillation vor, das die Argumentationsfähigkeit von LLM nutzt, um seine Vorhersagen anhand hoher Datenmengen vorherzusagen effiziente Möglichkeit, kleinere Modelle zu trainieren. Der Gesamtrahmen ist in Abbildung 2 dargestellt. Dieses Paradigma besteht aus zwei einfachen Schritten: Zunächst wird bei einem gegebenen LLM und einem unbeschrifteten Datensatz der LLM aufgefordert, ein Ausgabeetikett und einen Grund zu generieren, um zu beweisen, dass das Etikett wahr ist. Die Begründung wird in natürlicher Sprache erläutert und unterstützt die vom Modell vorhergesagte Bezeichnung (siehe Abbildung 2). Rechtfertigung ist eine aufkommende Verhaltenseigenschaft aktueller selbstüberwachter LLMs. Verwenden Sie dann zusätzlich zu den Aufgabenbezeichnungen diese Gründe, um kleinere nachgelagerte Modelle zu trainieren. Um es ganz klar auszudrücken: Gründe können umfassendere und detailliertere Informationen liefern, um zu erklären, warum eine Eingabe einer bestimmten Ausgabebezeichnung zugeordnet wird. Die Forscher überprüften im Experiment die Wirksamkeit der schrittweisen Destillation. Erstens trägt die schrittweise Destillation im Vergleich zu Standardmethoden zur Feinabstimmung und Aufgabendestillation dazu bei, eine bessere Leistung mit einer viel geringeren Anzahl von Trainingsbeispielen zu erzielen, wodurch die Dateneffizienz beim Lernen kleiner aufgabenspezifischer Modelle erheblich verbessert wird.

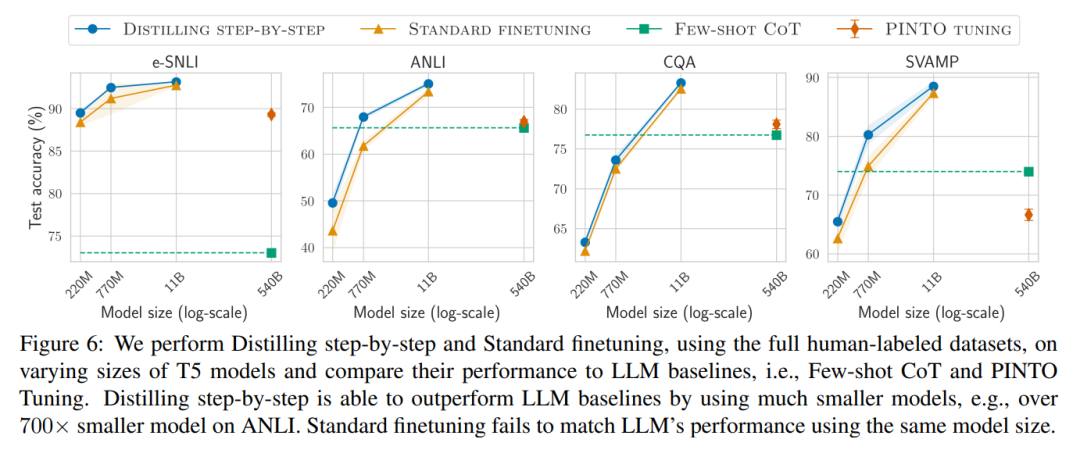

# 🎜 🎜# Zweitens zeigen Untersuchungen, dass die Methode der schrittweisen Destillation die Leistung von LLM bei einer kleineren Modellgröße übertrifft und die Bereitstellungskosten im Vergleich zu LLM erheblich senkt.

Schrittweise Destillation

# 🎜 🎜#

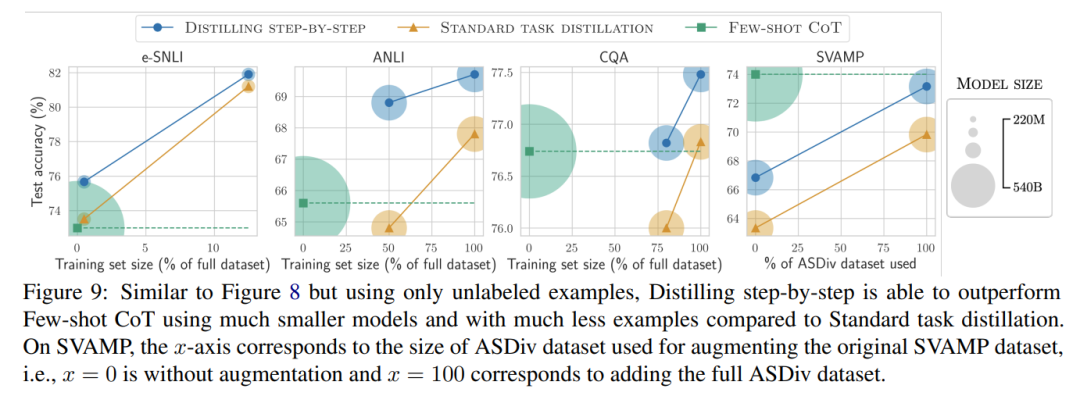

Abschließend untersuchten die Forscher die Mindestressourcen, die die schrittweise Destillationsmethode im Hinblick auf eine über LLM hinausgehende Leistung erfordert, einschließlich der Anzahl der Trainingsbeispiele und Modellgröße. Sie zeigen, dass der schrittweise Destillationsansatz sowohl die Dateneffizienz als auch die Bereitstellungseffizienz verbessert, indem weniger Daten und kleinere Modelle verwendet werden.

Das obige ist der detaillierte Inhalt vonDie Destillation kann auch Schritt für Schritt erfolgen: Durch die neue Methode können kleine Modelle mit großen Modellen verglichen werden, die 2000-mal größer sind. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Stehen Sie vor einer Verzögerung oder einer langsamen mobilen Datenverbindung auf dem iPhone? Normalerweise hängt die Stärke des Mobilfunk-Internets auf Ihrem Telefon von mehreren Faktoren ab, wie z. B. der Region, dem Mobilfunknetztyp, dem Roaming-Typ usw. Es gibt einige Dinge, die Sie tun können, um eine schnellere und zuverlässigere Mobilfunk-Internetverbindung zu erhalten. Fix 1 – Neustart des iPhone erzwingen Manchmal werden durch einen erzwungenen Neustart Ihres Geräts viele Dinge zurückgesetzt, einschließlich der Mobilfunkverbindung. Schritt 1 – Drücken Sie einfach einmal die Lauter-Taste und lassen Sie sie los. Drücken Sie anschließend die Leiser-Taste und lassen Sie sie wieder los. Schritt 2 – Der nächste Teil des Prozesses besteht darin, die Taste auf der rechten Seite gedrückt zu halten. Lassen Sie das iPhone den Neustart abschließen. Aktivieren Sie Mobilfunkdaten und überprüfen Sie die Netzwerkgeschwindigkeit. Überprüfen Sie es erneut. Fix 2 – Datenmodus ändern 5G bietet zwar bessere Netzwerkgeschwindigkeiten, funktioniert jedoch besser, wenn das Signal schwächer ist

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,