Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Lassen Sie uns aus technischer Sicht darüber sprechen, warum es schwierig ist, binokulare autonome Fahrsysteme populär zu machen.

Lassen Sie uns aus technischer Sicht darüber sprechen, warum es schwierig ist, binokulare autonome Fahrsysteme populär zu machen.

Lassen Sie uns aus technischer Sicht darüber sprechen, warum es schwierig ist, binokulare autonome Fahrsysteme populär zu machen.

Monokulares Sehen ist die magische Waffe von Mobileye (ME). Tatsächlich dachte man damals auch an binokulares Sehen, entschied sich aber schließlich dafür, aufzugeben.

Worauf basieren monokulare Entfernungsmessung und 3D-Schätzung? Es ist die Bounding Box (BB), die das Ziel erkennt. Wenn das Hindernis nicht erkannt werden kann, kann das System seine Entfernung und 3D-Lage/Ausrichtung nicht schätzen. Ohne tiefes Lernen schätzt ME die Entfernung hauptsächlich basierend auf dem BB, der durch die Kamerakalibrierung erhaltenen Haltung und Höhe und der Annahme, dass die Straßenoberfläche gerade ist.

Mit Deep Learning kann das NN-Modell auf der Grundlage der 3D-Grundwahrheit trainiert werden, um 3D-Größen- und Lageschätzungen zu erhalten. Die Entfernung wird auf der Grundlage des Parallellinienprinzips (Einzelansichtsmesstechnik) ermittelt. Die von Baidu Apollo vor kurzem angekündigte monokulare L3-Lösung erklärt es klarer. Das Referenzpapier lautet „3D Bounding Box Estimation by Deep Learning and Geometry“. Natürlich kann das Fernglas Parallaxe und Tiefe berechnen, auch wenn dies nicht der Fall ist Erkannte Hindernisse (der Detektor ist aufgrund der zusätzlichen Tiefeninformationen besser als ein Monokular) lösen ebenfalls einen Alarm aus. Das Problem besteht darin, dass es für ein binokulares Sichtsystem nicht so einfach ist, die Disparität abzuschätzen. Ein typisches Problem beim Computersehen ist, dass eine breite Basislinie zu genauen Entfernungsmessungsergebnissen für entfernte Ziele führt, während eine kurze Basislinie zu guten Entfernungsmessungsergebnissen führt In der Nähe von Zielen gibt es hier einen Kompromiss.

Das aktuelle ADAS-Binokularsichtsystem auf dem Markt ist Subaru EyeSight, und seine Leistung soll in Ordnung sein.

Der von Baidu eingeführte Shuttlebus Apollo L4 wird in einer Massenproduktion von 100 Einheiten hergestellt und ist mit einem Fernglassystem ausgestattet. Das EU-Projekt zum autonomen Parken V-Charge nutzt ebenfalls ein vorwärtsgerichtetes binokulares Sichtsystem, ebenso wie das autonome Fahrforschungs- und -entwicklungssystem Berta Benz, das in das Radarsystem integriert ist. Darunter ist der binokulare Matching-Hinderniserkennungsalgorithmus Stixel sehr bekannt. Tier-1-Unternehmen wie Bosch und Conti haben in der Vergangenheit ebenfalls binokulare Sehlösungen entwickelt, diese hatten jedoch keine Auswirkungen auf den Markt und wurden Berichten zufolge eingestellt.

Apropos Schwierigkeiten des Fernglassystems: Neben der Stereoanpassung gibt es auch die Kalibrierung. Das kalibrierte System wird „driften“, daher ist eine Online-Kalibrierung ein Muss. Das Gleiche gilt für Monokulare, da sich Reifenverformungen und Stöße der Fahrzeugkarosserie auf die Änderungen der externen Parameter der Kamera auswirken und einige Parameter wie Nick- und Gierwinkel online kalibriert und korrigiert werden müssen.

Die binokulare Online-Kalibrierung ist komplizierter, da die binokulare Anpassung so weit wie möglich auf die 1-D-Suche vereinfacht wird, sodass die optischen Achsen der beiden Linsen durch Stereogleichrichtung parallel und senkrecht zur Grundlinie sein müssen. Daher werden Händler im Vergleich zum erzielten Gewinn aufgeben, wenn dies aufgrund der erhöhten Komplexität und Kosten nicht rentabel ist.

Das binokulare Sehen wurde kürzlich erneut erwähnt, weil das Silicon-Valley-Chipunternehmen Ambarella 2014 das Vis Lab der Universität Parma in Italien erwarb und nach der CES im vergangenen Jahr binokulare ADAS und autonome Fahrchips entwickelte. Enterprise und Tier-1. Darüber hinaus forscht Ambarella derzeit weiter, um die Leistung des Systems zu verbessern.

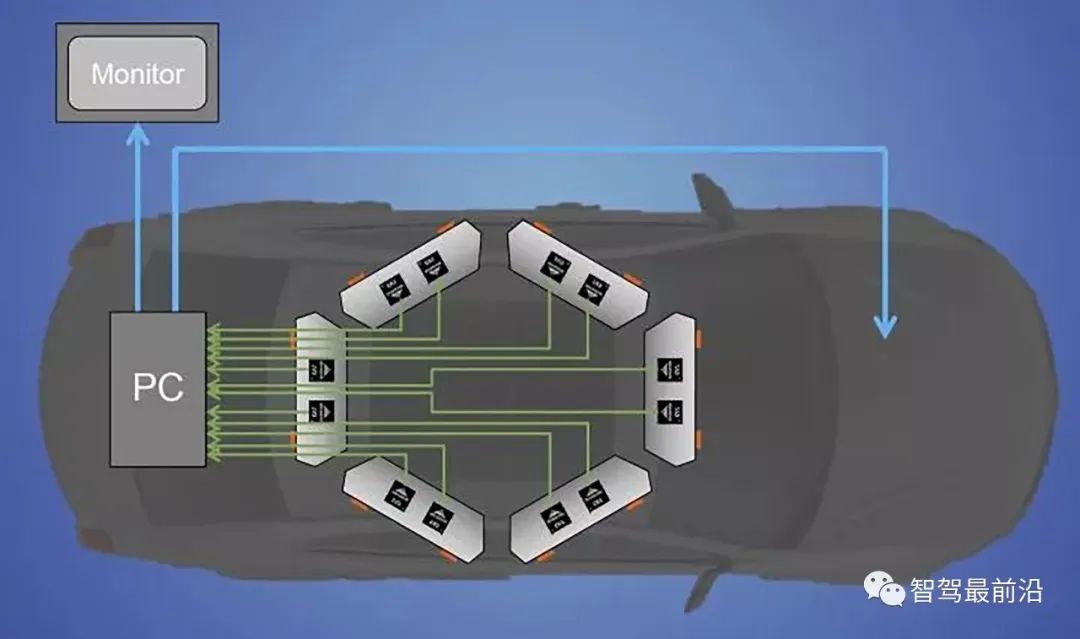

Das Bild unten ist ein schematisches Diagramm von sechs Paaren von Stereosichtsystemen, die auf dem Dach des Autos installiert sind. Ihre Basislinienbreiten können unterschiedlich sein, und die effektiven Erkennungsabstände sind entsprechend unterschiedlich. Der Autor fuhr einmal mit seinem selbstfahrenden Auto und konnte 200 Meter in die Ferne und 20 bis 30 Meter in die Ferne sehen. Es kann tatsächlich jederzeit eine Online-Kalibrierung durchführen und einige binokulare Sehparameter anpassen.

01 Stereo-Matching

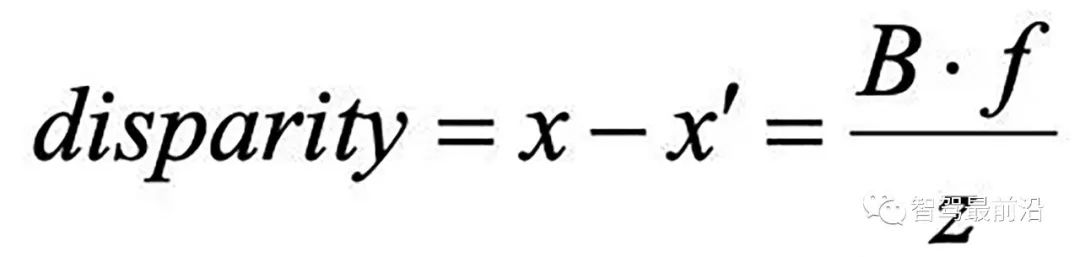

Lassen Sie uns zunächst über Stereo-Matching sprechen, also über die Disparitäts-/Tiefenschätzung. Nehmen Sie, wie in der Abbildung gezeigt, an, dass die Brennweite der linken und rechten Kamera f ist, die Breite der Basislinie (die Linie, die die beiden optischen Zentren verbindet) B ist und die Tiefe des 3D-Punkts

ist

Die sichtbare Parallaxe kann den Tiefenwert umgekehrt berechnen. Am schwierigsten ist es jedoch, festzustellen, ob die von der linken und rechten Linse gesehenen Bilder dasselbe Ziel darstellen, d. h. das Übereinstimmungsproblem.

Die sichtbare Parallaxe kann den Tiefenwert umgekehrt berechnen. Am schwierigsten ist es jedoch, festzustellen, ob die von der linken und rechten Linse gesehenen Bilder dasselbe Ziel darstellen, d. h. das Übereinstimmungsproblem.

Es gibt zwei Matching-Methoden, die globale Methode und die lokale Methode. Es gibt vier Schritte beim binokularen Matching:

- Kostenaggregation;

- Parallaxenberechnung/-optimierung;

- Disparitätskorrektur (Verfeinerung).

- Die bekannteste lokale Methode ist SGM (Semi-Global Matching). Die von vielen Produkten verwendeten Methoden basieren auf dieser Verbesserung, und viele Vision-Chips verwenden diesen Algorithmus.

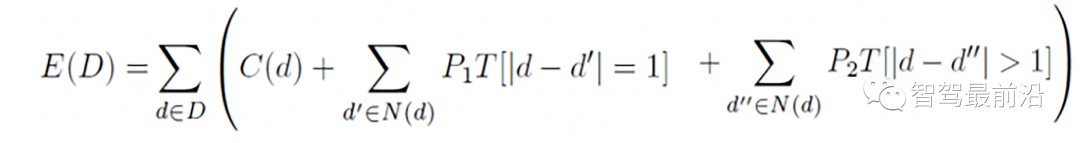

SGM dient dazu, eine globale Optimierung in eine Kombination mehrerer lokaler Optimierungsprobleme zu approximieren. Die folgende Formel ist die Optimierungszielfunktion des 2D-Matchings, die als Summe mehrerer 1D-Optimierungspfade implementiert wird

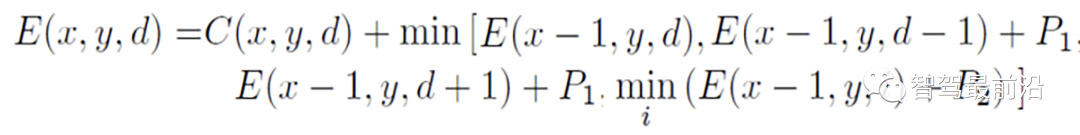

Das Bild unten zeigt die Pfadoptimierungsfunktion entlang der horizontalen Richtung.

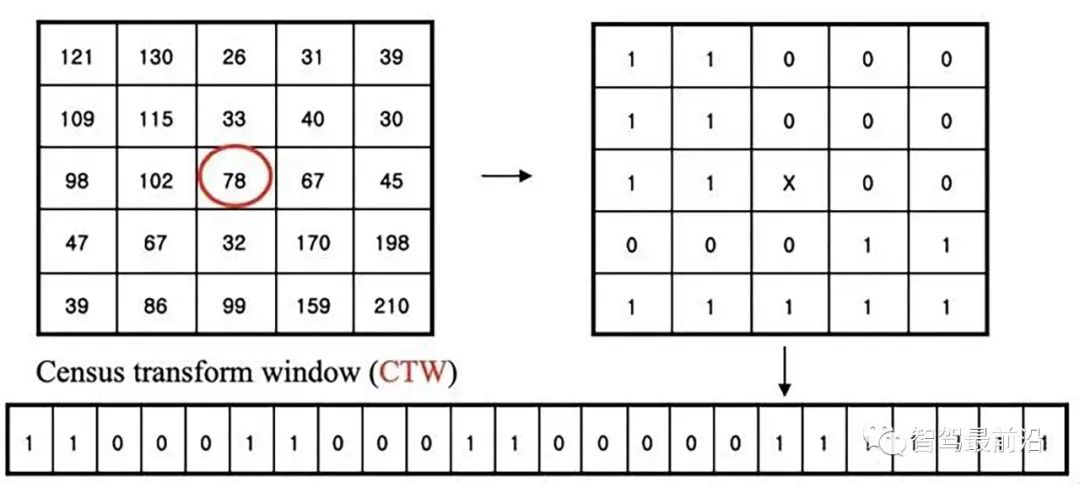

Census Transform wandelt 8/24-Bit-Pixel in eine Binärsequenz um. Eine weitere binäre Funktion heißt LBP (Local Binary Pattern). ähnlich. Der Stereo-Matching-Algorithmus basiert auf dieser Transformation und wandelt das Matching in eine Minimierungssuche der Hamming-Distanz um. Intels RealSense erwarb ein 1994 auf Basis dieser Technologie gegründetes Binokular-Vision-Startup-Unternehmen, erwarb außerdem mehrere andere kleine Unternehmen und fusionierte sie, um diese Technologie zu schaffen.

Die folgende Abbildung ist ein schematisches Diagramm der CS-Transformation:

PatchMatch ist ein Algorithmus, der den Bildvorlagenabgleich beschleunigt und bei der Berechnung des optischen Flusses und der Disparitätsschätzung verwendet wird. Microsoft Research hat zuvor ein Projekt durchgeführt, das auf der 3D-Rekonstruktion einer monokularen Mobiltelefonkamera basiert und das zuvor erfolgreiche KinectFusion basierend auf dem RGB-D-Algorithmus nachahmt, mit einem ähnlichen Namen wie MonoFusion, bei dem die Tiefenkartenschätzung eine modifizierte PatchMatch-Methode verwendet .

Die Grundidee besteht darin, die Disparitäts- und Ebenenparameter zufällig zu initialisieren und dann die Schätzung durch Informationsweitergabe zwischen benachbarten Pixeln zu aktualisieren. Der PM-Algorithmus ist in fünf Schritte unterteilt:

1) Räumliche Ausbreitung: Jedes Pixel überprüft die Disparitäts- und Ebenenparameter der linken und oberen Nachbarn und ersetzt die aktuelle Schätzung, wenn die Anpassungskosten kleiner werden

2) Ansichtsausbreitung: Transformieren Sie Pixel aus anderen Ansichten, überprüfen Sie die Schätzung des entsprechenden Bildes und ersetzen Sie es, wenn es kleiner wird

- 3) Zeitliche Ausbreitung: Berücksichtigen Sie die Schätzung des entsprechenden Pixels im vorherigen und nächsten Frame;

- 4) Flugzeugverfeinerung: Generieren Sie nach dem Zufallsprinzip Stichproben und aktualisieren Sie sie bei Bedarf, um die Matching-Kosten zu reduzieren.

- 5) Nachbearbeitung: Links-Rechts-Konsistenz und gewichteter Medianfilter zur Entfernung von Ausreißern.

- Das folgende Bild ist ein schematisches Diagramm von PM:

- 02 Online-Kalibrierung

Lassen Sie uns über die Online-Kalibrierung sprechen.

Dies ist eine Kalibrierungsmethode, die Straßenmarkierungen (Zebrastreifen) verwendet: Das parallele Linienmuster des Zebrastreifens ist bekannt, der Zebrastreifen wird erkannt und die Eckpunkte werden extrahiert, und die Parameter für die Homographietransformation (Homographie) werden ermittelt Passend zum Zebrastreifenmuster und der Straßenoberfläche werden die Kalibrierungsparameter berechnet.

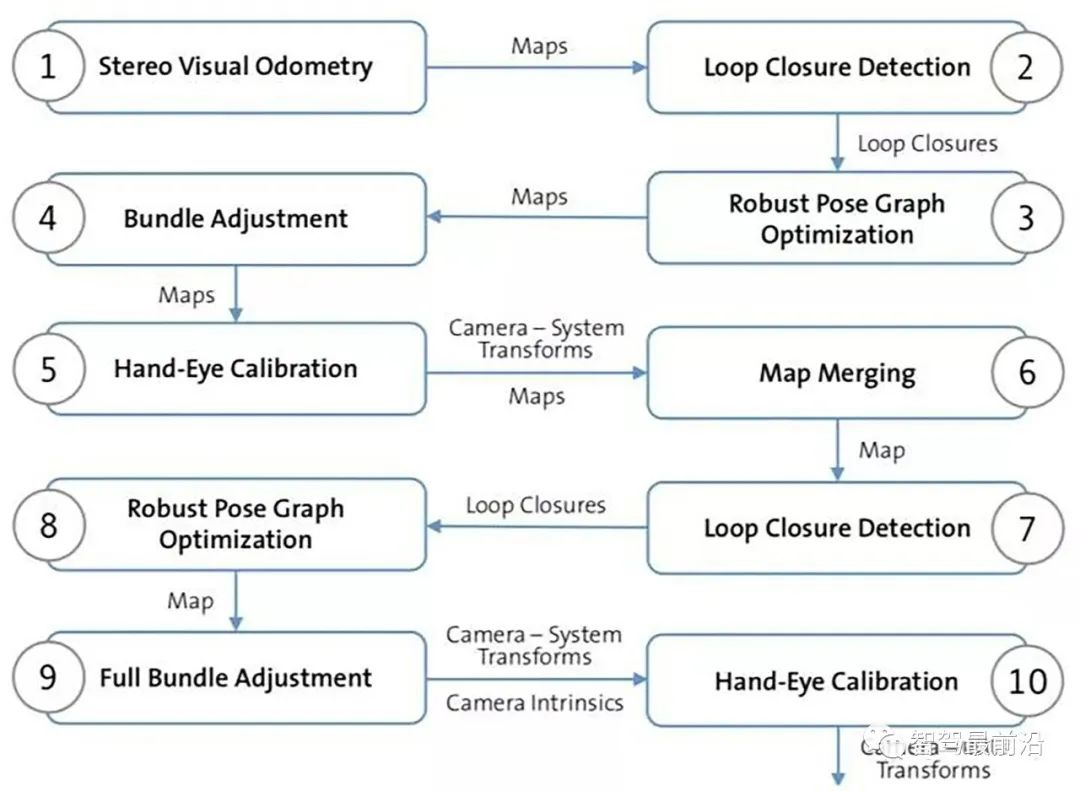

Die andere Methode basiert auf VO und SLAM, was komplizierter ist, aber gleichzeitig eine kartenbasierte Positionierung durchführen kann. Die Verwendung von SLAM für die Online-Kalibrierung ist für Hochfrequenzoperationen nicht geeignet. Die folgende Abbildung zeigt das Flussdiagramm des Algorithmus: Schritte 1 bis 4: Erhalten der globalen kontinuierlichen Karte durch Stereovision SLAM. Schritt 5 gibt die anfängliche Schätzung der binokularen Kamera an Transformation, Schritt 6: Fassen Sie die Karten aller Stereokameras in einer Karte zusammen; ermitteln Sie die Posen zwischen mehreren Kameras in den Schritten 7–8.

Ähnlich wie bei der monokularen Methode kann die Online-Kalibrierung unter der Annahme, dass die Fahrspurlinien parallel sind und die Straße flach ist, schnell abgeschlossen werden Fluchtpunkttheorie: Gehen Sie von einem flachen Straßenmodell, klaren Längslinien der Fahrspur und keinen anderen Objekten mit parallelen Kanten aus; die Fahrgeschwindigkeit muss niedrig sein und die Fahrspurlinien müssen kontinuierlich sein Der Höhen-/Schrägwinkel der linken Kamera relativ zur Straßenoberfläche (Gier-/Rollwinkel) ist relativ klein. Auf diese Weise kann der Driftbetrag der binokularen externen Parameter durch Vergleich mit dem initialisierten Fluchtpunkt (bezogen auf) berechnet werden Offline-Kalibrierung) (Abbildung 5-269). Der Algorithmus dient dazu, den Höhen-/Neigungswinkel der Kamera vom Fluchtpunkt aus zu schätzen.

03 Typisches binokulares autonomes Fahrsystem

#🎜 🎜# Hier sind einige typische binokulare autonome Fahrsysteme.

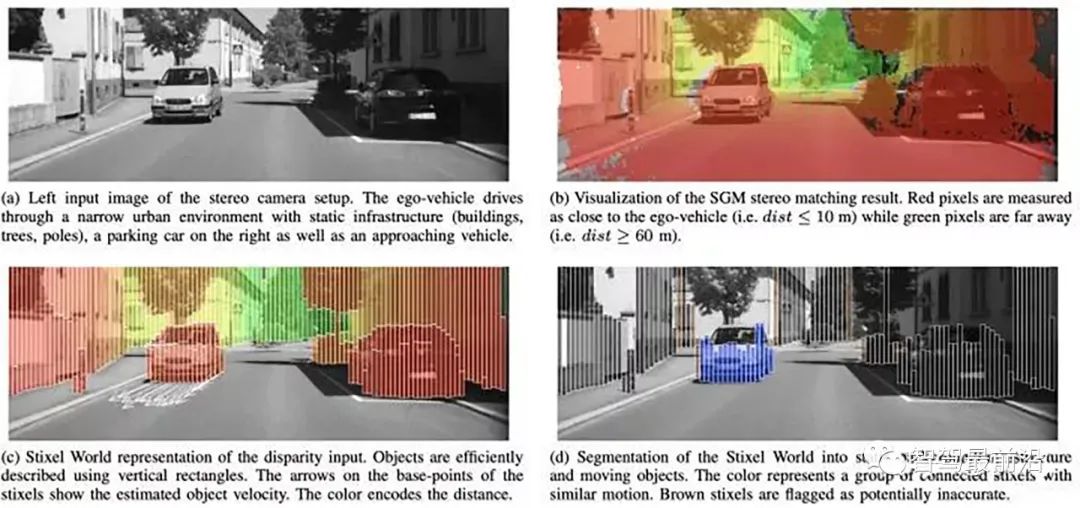

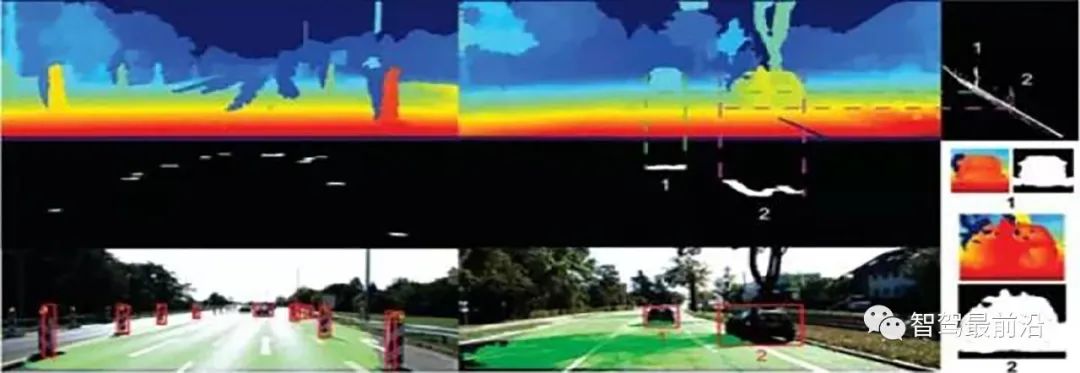

Der von Berta Benz übernommene Hinderniserkennungsalgorithmus Stixel basiert auf folgenden Annahmen: Die Ziele in der Szene werden als Säulen beschrieben, der Schwerpunkt des Ziels ist auf dem Boden stehend und jedes Ziel Der obere Teil ist tiefer als der untere Teil. Die folgende Abbildung (a–d) stellt vor, wie SGM-Disparitätsergebnisse Stixel-Segmentierungsergebnisse generieren: Stixels Schematische Darstellung: (a) Berechnung des freien Fahrraums basierend auf dynamischer Programmierung (b) Attributwerte in der Höhensegmentierung (c) Kostenbild (Graustufenwerte umgekehrt) (d) Höhensegmentierung.

Dies ist das Blockdiagramm und die neuen Ergebnisse von Stixel, nachdem sie Deep Learning für die Parallaxenfusion hinzugefügt haben:

#🎜 🎜#

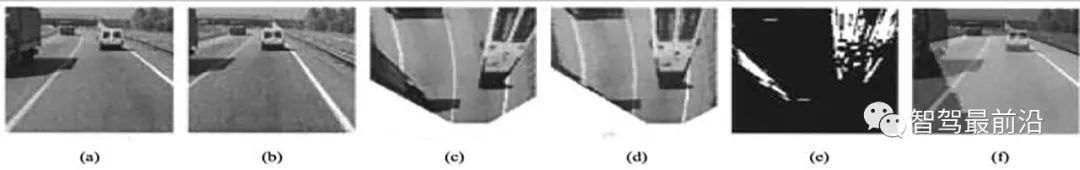

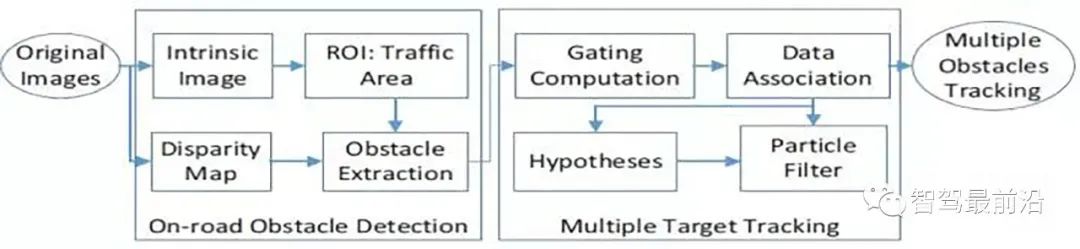

Einführung eines frühen binokularen Hindernisalgorithmus von VisLab, des Generic Obstacle and Lane Detection System (GOLD). Basierend auf IPM (Inverse Perspective Mapping) werden Fahrspurlinien erkannt und Hindernisse auf der Straße basierend auf der Differenz zwischen den linken und rechten Bildern berechnet:(a) Links (b) Rechts (c) Neu zugeordnet nach links. (d) Neu zugeordneter Unterschied zwischen neu zugeordneten Ansichten (f) Der von beiden Kameras sichtbare Straßenbereich (b) Neu zugeordnet . (e) Binarisiert. 🎜🎜#Dies sind VisLab-Fahrzeuge, die am autonomen Fahrwettbewerb VIAC (VisLab Intercontinental Autonomous Challenge) teilnehmen und neben binokularen Kameras auch über Lidar als Hilfsmittel zur Straßenklassifizierung verfügen.

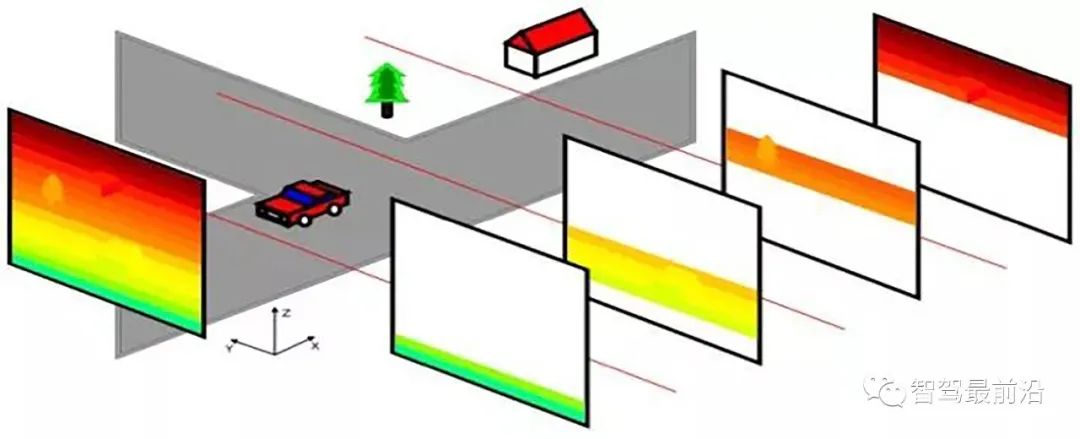

Dies ist das Flussdiagramm zur binokularen Hinderniserkennung: Die Disparitätsschätzung nutzt den SGM-Algorithmus und den SAD-basierten Korrelationsalgorithmus.

Zwei DSI-Raumfilter (Disparity Space Image) werden in der Nachbearbeitung hinzugefügt, siehe Abbildung 5-274 Die eine ist die Glättungsverarbeitung und die andere die Bewegungstrajektorienverarbeitung basierend auf der Trägheitsnavigation (IMU).

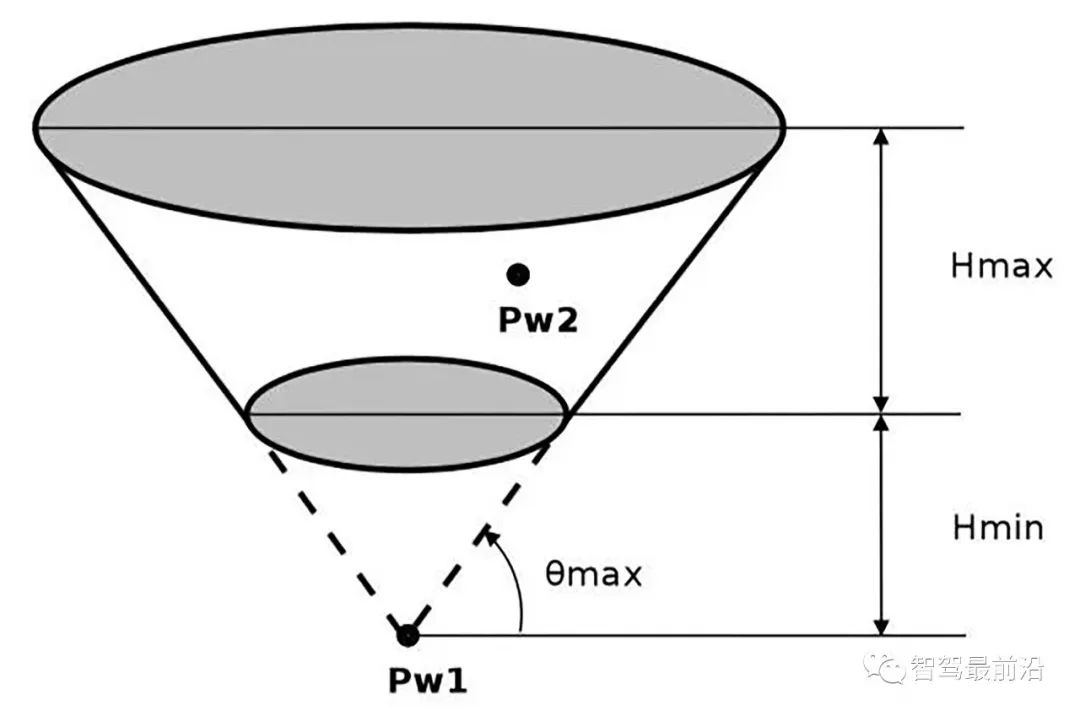

Der Hinderniserkennungsalgorithmus verwendet die JPL-Methode und gruppiert Hindernisse basierend auf den räumlichen Anordnungsmerkmalen und den physikalischen Eigenschaften des Fahrzeugs. Zu den physikalischen Eigenschaften gehören die maximale Höhe (Fahrzeug), die minimale Höhe (Hindernis) und die maximal befahrbare Reichweite der Straße. Diese Einschränkungen definieren einen Raumkegelstumpf (Kegelstumpf), wie in der Abbildung dargestellt, und dann im Clustering-Prozess. alles fällt. Punkte innerhalb des Kegelstumpfes werden als Hindernisse bezeichnet.

Um den Disparitätsschätzungsalgorithmus zu beschleunigen, wird die Methode zur Division von DSI übernommen:

Eine weitere klassische Methode besteht darin, die Straßenparallaxe basierend auf der Straßengleichung zu erhalten (Stereovision). , und berechnen Sie die Straßenoberfläche basierend auf diesen Hindernissen:

04 Zusammenfassung

Im Allgemeinen basiert die Methode der binokularen Erkennung von Hindernissen im Wesentlichen auf Disparitätskarten, und es gibt viele Methoden, die darauf basieren auf der Straßenoberflächesparallaxe. Vielleicht werden mit der rasanten Entwicklung des Deep Learning und der Verbesserung der Computerplattformen auch binokulare autonome Fahrsysteme populär.

Das obige ist der detaillierte Inhalt vonLassen Sie uns aus technischer Sicht darüber sprechen, warum es schwierig ist, binokulare autonome Fahrsysteme populär zu machen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

CUDAs universelle Matrixmultiplikation: vom Einstieg bis zur Kompetenz!

Mar 25, 2024 pm 12:30 PM

Die allgemeine Matrixmultiplikation (GEMM) ist ein wesentlicher Bestandteil vieler Anwendungen und Algorithmen und außerdem einer der wichtigen Indikatoren zur Bewertung der Leistung der Computerhardware. Eingehende Forschung und Optimierung der Implementierung von GEMM können uns helfen, Hochleistungsrechnen und die Beziehung zwischen Software- und Hardwaresystemen besser zu verstehen. In der Informatik kann eine effektive Optimierung von GEMM die Rechengeschwindigkeit erhöhen und Ressourcen einsparen, was für die Verbesserung der Gesamtleistung eines Computersystems von entscheidender Bedeutung ist. Ein tiefgreifendes Verständnis des Funktionsprinzips und der Optimierungsmethode von GEMM wird uns helfen, das Potenzial moderner Computerhardware besser zu nutzen und effizientere Lösungen für verschiedene komplexe Computeraufgaben bereitzustellen. Durch Optimierung der Leistung von GEMM

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Das intelligente Fahrsystem Qiankun ADS3.0 von Huawei wird im August auf den Markt kommen und erstmals auf dem Xiangjie S9 eingeführt

Jul 30, 2024 pm 02:17 PM

Am 29. Juli nahm Yu Chengdong, Huawei-Geschäftsführer, Vorsitzender von Terminal BG und Vorsitzender von Smart Car Solutions BU, an der Übergabezeremonie des 400.000sten Neuwagens von AITO Wenjie teil, hielt eine Rede und kündigte an, dass die Modelle der Wenjie-Serie dies tun werden Dieses Jahr auf den Markt kommen Im August wurde die Huawei Qiankun ADS 3.0-Version auf den Markt gebracht und es ist geplant, die Upgrades sukzessive von August bis September voranzutreiben. Das Xiangjie S9, das am 6. August auf den Markt kommt, wird erstmals mit dem intelligenten Fahrsystem ADS3.0 von Huawei ausgestattet sein. Mit Hilfe von Lidar wird Huawei Qiankun ADS3.0 seine intelligenten Fahrfähigkeiten erheblich verbessern, über integrierte End-to-End-Funktionen verfügen und eine neue End-to-End-Architektur von GOD (allgemeine Hinderniserkennung)/PDP (prädiktiv) einführen Entscheidungsfindung und Kontrolle), Bereitstellung der NCA-Funktion für intelligentes Fahren von Parkplatz zu Parkplatz und Aktualisierung von CAS3.0

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Jenseits von ORB-SLAM3! SL-SLAM: Szenen mit wenig Licht, starkem Jitter und schwacher Textur werden verarbeitet

May 30, 2024 am 09:35 AM

Heute diskutieren wir darüber, wie Deep-Learning-Technologie die Leistung von visionbasiertem SLAM (Simultaneous Localization and Mapping) in komplexen Umgebungen verbessern kann. Durch die Kombination von Methoden zur Tiefenmerkmalsextraktion und Tiefenanpassung stellen wir hier ein vielseitiges hybrides visuelles SLAM-System vor, das die Anpassung in anspruchsvollen Szenarien wie schlechten Lichtverhältnissen, dynamischer Beleuchtung, schwach strukturierten Bereichen und starkem Jitter verbessern soll. Unser System unterstützt mehrere Modi, einschließlich erweiterter Monokular-, Stereo-, Monokular-Trägheits- und Stereo-Trägheitskonfigurationen. Darüber hinaus wird analysiert, wie visuelles SLAM mit Deep-Learning-Methoden kombiniert werden kann, um andere Forschungen zu inspirieren. Durch umfangreiche Experimente mit öffentlichen Datensätzen und selbst abgetasteten Daten demonstrieren wir die Überlegenheit von SL-SLAM in Bezug auf Positionierungsgenauigkeit und Tracking-Robustheit.

Welche Version des Apple 16-Systems ist die beste?

Mar 08, 2024 pm 05:16 PM

Welche Version des Apple 16-Systems ist die beste?

Mar 08, 2024 pm 05:16 PM

Die beste Version des Apple 16-Systems ist iOS16.1.4. Die beste Version des iOS16-Systems kann von Person zu Person unterschiedlich sein. Die Ergänzungen und Verbesserungen im täglichen Nutzungserlebnis wurden auch von vielen Benutzern gelobt. Welche Version des Apple 16-Systems ist die beste? Antwort: iOS16.1.4 Die beste Version des iOS 16-Systems kann von Person zu Person unterschiedlich sein. Öffentlichen Informationen zufolge gilt iOS16, das 2022 auf den Markt kam, als eine sehr stabile und leistungsstarke Version, und die Benutzer sind mit dem Gesamterlebnis recht zufrieden. Darüber hinaus wurden die neuen Funktionen und Verbesserungen des täglichen Nutzungserlebnisses in iOS16 von vielen Benutzern gut angenommen. Insbesondere in Bezug auf die aktualisierte Akkulaufzeit, Signalleistung und Heizungssteuerung war das Feedback der Benutzer relativ positiv. Betrachtet man jedoch das iPhone14

Immer neu! Upgrade der Huawei Mate60-Serie auf HarmonyOS 4.2: KI-Cloud-Erweiterung, Xiaoyi-Dialekt ist so einfach zu bedienen

Jun 02, 2024 pm 02:58 PM

Immer neu! Upgrade der Huawei Mate60-Serie auf HarmonyOS 4.2: KI-Cloud-Erweiterung, Xiaoyi-Dialekt ist so einfach zu bedienen

Jun 02, 2024 pm 02:58 PM

Am 11. April kündigte Huawei erstmals offiziell den 100-Maschinen-Upgradeplan für HarmonyOS 4.2 an. Dieses Mal werden mehr als 180 Geräte an dem Upgrade teilnehmen, darunter Mobiltelefone, Tablets, Uhren, Kopfhörer, Smart-Screens und andere Geräte. Im vergangenen Monat haben mit dem stetigen Fortschritt des HarmonyOS4.2-Upgradeplans für 100 Maschinen auch viele beliebte Modelle, darunter Huawei Pocket2, Huawei MateX5-Serie, Nova12-Serie, Huawei Pura-Serie usw., mit der Aktualisierung und Anpassung begonnen, was bedeutet, dass dass es mehr Benutzer von Huawei-Modellen geben wird, die das gemeinsame und oft neue Erlebnis von HarmonyOS genießen können. Den Rückmeldungen der Benutzer zufolge hat sich das Erlebnis der Modelle der Huawei Mate60-Serie nach dem Upgrade von HarmonyOS4.2 in allen Aspekten verbessert. Vor allem Huawei M

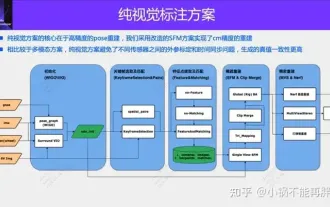

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

Die erste rein visuelle statische Rekonstruktion des autonomen Fahrens

Jun 02, 2024 pm 03:24 PM

Eine rein visuelle Annotationslösung nutzt hauptsächlich die visuelle Darstellung sowie einige Daten von GPS, IMU und Radgeschwindigkeitssensoren für die dynamische Annotation. Für Massenproduktionsszenarien muss es sich natürlich nicht nur um visuelle Aspekte handeln. Einige in Massenproduktion hergestellte Fahrzeuge verfügen über Sensoren wie Festkörperradar (AT128). Wenn wir aus Sicht der Massenproduktion einen geschlossenen Datenkreislauf erstellen und alle diese Sensoren verwenden, können wir das Problem der Kennzeichnung dynamischer Objekte effektiv lösen. Aber in unserem Plan gibt es kein Festkörperradar. Aus diesem Grund stellen wir diese gängigste Etikettierungslösung für die Massenproduktion vor. Der Kern einer rein visuellen Annotationslösung liegt in der hochpräzisen Posenrekonstruktion. Wir verwenden das Posenrekonstruktionsschema von Structure from Motion (SFM), um die Genauigkeit der Rekonstruktion sicherzustellen. Aber pass

Welche Computer-Betriebssysteme gibt es?

Jan 12, 2024 pm 03:12 PM

Welche Computer-Betriebssysteme gibt es?

Jan 12, 2024 pm 03:12 PM

Ein Computerbetriebssystem ist ein System zur Verwaltung von Computerhardware und -software. Es ist auch ein Betriebssystemprogramm, das auf allen Softwaresystemen basiert. Welche Computersysteme gibt es also? Im Folgenden erklärt Ihnen der Herausgeber, was Computer-Betriebssysteme sind. Das sogenannte Betriebssystem dient der Verwaltung von Computerhardware und Softwareprogrammen. Sämtliche Software wird auf Basis von Betriebssystemprogrammen entwickelt. Tatsächlich gibt es viele Arten von Betriebssystemen, darunter solche für den industriellen Einsatz, den kommerziellen Einsatz und den persönlichen Gebrauch, die ein breites Anwendungsspektrum abdecken. Im Folgenden erklärt Ihnen der Herausgeber, was Computer-Betriebssysteme sind. Welche Computer-Betriebssysteme sind Windows-Systeme? Das Windows-System ist ein Betriebssystem, das von der Microsoft Corporation in den Vereinigten Staaten entwickelt wurde. als die meisten

Ausführliche Erklärung zum Ändern des Systemdatums in der Oracle-Datenbank

Mar 09, 2024 am 10:21 AM

Ausführliche Erklärung zum Ändern des Systemdatums in der Oracle-Datenbank

Mar 09, 2024 am 10:21 AM

Ausführliche Erläuterung der Methode zum Ändern des Systemdatums in der Oracle-Datenbank. In der Oracle-Datenbank umfasst die Methode zum Ändern des Systemdatums hauptsächlich das Ändern des Parameters NLS_DATE_FORMAT und die Verwendung der Funktion SYSDATE. In diesem Artikel werden diese beiden Methoden und ihre spezifischen Codebeispiele ausführlich vorgestellt, um den Lesern zu helfen, den Vorgang zum Ändern des Systemdatums in der Oracle-Datenbank besser zu verstehen und zu beherrschen. 1. Ändern Sie die NLS_DATE_FORMAT-Parametermethode. NLS_DATE_FORMAT sind Oracle-Daten