So verwenden Sie Nginx-Keepalive

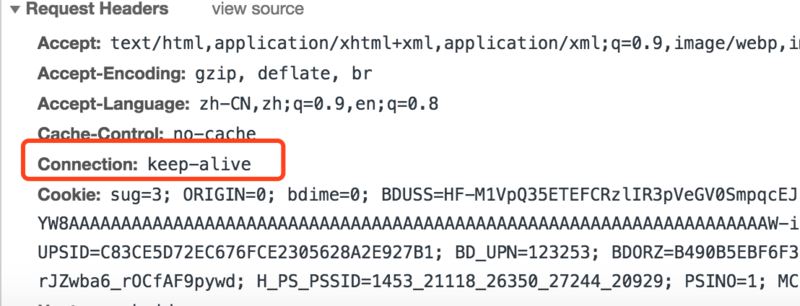

Standardmäßig aktiviert der Anforderungsheader des http1.1-Protokolls standardmäßig Keepalive, wie in der Abbildung gezeigt:

Was ist also Keepalive? Was ist die Funktion?

Keepalive ist ein Mechanismus in TCP, der tote Verbindungen erkennen kann. Seine Funktion besteht darin, zu verhindern, dass lange Socket-Verbindungen getrennt werden. Es ist eine Funktion der TCP-Schicht und gehört nicht zur Anwendungsschicht.

Wie hält die TCP-Schicht eine lange Verbindung aufrecht?

Sehen wir uns zunächst die Verwendung von Keepalive an: Es gibt drei Parameter, die für die Anwendungsschicht geöffnet sind Die Standardkonfiguration wird überschrieben und manuell festgelegt.

Für eine bestehende TCP-Verbindung. Wenn innerhalb der keepalive_time keine Datenpaketübertragung zwischen den beiden Parteien erfolgt, sendet das Ende, das die Keepalive-Funktion aktiviert, ein Keepalive-Daten-Heartbeat-Paket. Wenn keine Antwort empfangen wird, wird das Datenpaket alle keepalive_intvl-Zeiten und keepalive_probes-Zeiten erneut gesendet . Erfolgt keine Antwort, wird ein erstes Paket gesendet, um die Verbindung zu schließen. Wenn eine Antwort eingeht, wird der Timer gelöscht.Erfassen Sie das Paket, um den Inhalt des TCP-Heartbeat-Pakets zu überprüfen.

Analysieren Sie weiterhin den Inhalt des von Keepalive gesendeten und beantworteten Heartbeat-Pakets basierend auf der Paketerfassung:

Der Quellcode des TCP-Headers Die Struktur lautet:sk->keepalive_probes:探测次数,重试次数 sk->keepalive_time 探测的心跳间隔,tcp链接在多少秒之后没有数据报文传输启动探测报文 sk->keepalive_intvl 探测间隔,未收到回复时,重试的时间间隔

Sehen Sie sich den Inhalt des gesendeten Heartbeat-Pakets an:

Sehen Sie sich den Inhalt des gesendeten Heartbeat-Pakets an: [***@*** ~]$ cat /proc/sys/net/ipv4/tcp_keepalive_time 7200 [***@*** ~]$ cat /proc/sys/net/ipv4/tcp_keepalive_intvl 75 [***@*** ~]$ cat /proc/sys/net/ipv4/tcp_keepalive_probes 9

Sehen Sie sich weiterhin den Inhalt des Antwort-Heartbeat-Pakets an:

int keepalive = 1; // 开启keepalive属性 int keepidle = 60; // 如该连接在60秒内没有任何数据往来,则进行探测 int keepinterval = 5; // 探测时发包的时间间隔为5 秒 int keepcount = 3; // 探测尝试的次数。如果第1次探测包就收到响应了,则后2次的不再发。并且清零该计数 setsockopt(rs, sol_socket, so_keepalive, (void *)&keepalive , sizeof(keepalive )); setsockopt(rs, sol_tcp, tcp_keepidle, (void*)&keepidle , sizeof(keepidle )); setsockopt(rs, sol_tcp, tcp_keepintvl, (void *)&keepinterval , sizeof(keepinterval )); setsockopt(rs, sol_tcp, tcp_keepcnt, (void *)&keepcount , sizeof(keepcount ));

Wie aus dem Obigen ersichtlich ist, verwaltet das Heartbeat-Paket von TCP ein Eine lange Verbindung besteht darin, dass der Browser zuerst ein Bestätigungspaket an den Server sendet und der Server dann mit einem Bestätigungspaket antwortet.

Wie wird Nginx mit der Keepalive-Anfrage umgehen, wenn die Optionsdaten verfügbar sind?typedef struct _tcp_header

{

short m_ssourport; // 源端口号16bit

short m_sdestport; // 目的端口号16bit

unsigned int m_uisequnum; // req字段 序列号32bit

unsigned int m_uiacknowledgenum; //ack字段 确认号32bit

short m_sheaderlenandflag; // 前4位:tcp头长度;中6位:保留;后6位:标志位

short m_swindowsize; //win字段 窗口大小16bit

short m_schecksum; // 检验和16bit

short m_surgentpointer; // 紧急数据偏移量16bit

}__attribute__((packed))tcp_header, *ptcp_header;Nachdem Nginx Keepalive über Setsockopt(ls[i].fd, sol_socket, so_keepalive,(const void *) &value, sizeof(int)) aktiviert hat, wird immer eine lange Verbindung mit dem Client aufrechterhalten, was zu einem Problem führt sehr ernstes Problem Das Problem besteht darin, dass die Anzahl der Verbindungen, die jeder Worker aufrechterhalten kann, begrenzt ist (ep = epoll_create(cycle->connection_n / 2);cycle->connection_n / 2 ist die Obergrenze von fd, die epoll verwalten kann) . Auf diese Weise sind die Daten schnell erschöpft. Wie soll Nginx damit umgehen?

Um diese Antwort zu finden, schauen wir uns die beiden Konfigurationsparameter von Nginx über Keeoalive an 75s); Wenn Sie den Wert auf 0 setzen, wird die Keep-Alive-Client-Verbindung deaktiviert. Zweiter Parameter: Legen Sie optional einen Wert „keep-alive: timeout=time“ im Header-Feld der Antwort fest legen Sie es fest;

Hinweis: keepalive_timeout Standard 75s

keepalive_requests

keepalive_requests-Direktive wird verwendet, um die maximale Anzahl von Anfragen festzulegen, die auf einer Keep-Alive-Verbindung bedient werden können. Wenn die maximale Anzahl von Anfragen erreicht ist, wird die Verbindung geschlossen . Ein Wert von 0 deaktiviert auch die Keep-Alive-Client-Verbindung. Der Standardwert ist 100.

Die Antwort liegt auf der Hand. Verwenden Sie keepalive_timeout keepalive_requests, um lange Verbindungen zu verwalten. Wenn eine TCP-Verbindung den keepalive_timeout überschreitet, wird sie durch Timer geschlossen Wenn die Anzahl der Verbindungen „keepalive_requests“ überschreitet, wird sie ebenfalls geschlossen. Diese beiden Mechanismen werden verwendet, um sicherzustellen, dass die Anzahl der Verbindungen jedes Workers die Anzahl nicht überschreitet, die epoll verwalten kann.Das obige ist der detaillierte Inhalt vonSo verwenden Sie Nginx-Keepalive. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

So erlauben Sie den externen Netzwerkzugriff auf den Tomcat-Server

Apr 21, 2024 am 07:22 AM

So erlauben Sie den externen Netzwerkzugriff auf den Tomcat-Server

Apr 21, 2024 am 07:22 AM

Um dem Tomcat-Server den Zugriff auf das externe Netzwerk zu ermöglichen, müssen Sie Folgendes tun: Ändern Sie die Tomcat-Konfigurationsdatei, um externe Verbindungen zuzulassen. Fügen Sie eine Firewallregel hinzu, um den Zugriff auf den Tomcat-Server-Port zu ermöglichen. Erstellen Sie einen DNS-Eintrag, der den Domänennamen auf die öffentliche IP des Tomcat-Servers verweist. Optional: Verwenden Sie einen Reverse-Proxy, um Sicherheit und Leistung zu verbessern. Optional: Richten Sie HTTPS für mehr Sicherheit ein.

So führen Sie thinkphp aus

Apr 09, 2024 pm 05:39 PM

So führen Sie thinkphp aus

Apr 09, 2024 pm 05:39 PM

Schritte zum lokalen Ausführen von ThinkPHP Framework: Laden Sie ThinkPHP Framework herunter und entpacken Sie es in ein lokales Verzeichnis. Erstellen Sie einen virtuellen Host (optional), der auf das ThinkPHP-Stammverzeichnis verweist. Konfigurieren Sie Datenbankverbindungsparameter. Starten Sie den Webserver. Initialisieren Sie die ThinkPHP-Anwendung. Greifen Sie auf die URL der ThinkPHP-Anwendung zu und führen Sie sie aus.

Willkommen bei Nginx! Wie kann ich es lösen?

Apr 17, 2024 am 05:12 AM

Willkommen bei Nginx! Wie kann ich es lösen?

Apr 17, 2024 am 05:12 AM

Um den Fehler „Willkommen bei Nginx!“ zu beheben, müssen Sie die Konfiguration des virtuellen Hosts überprüfen, den virtuellen Host aktivieren, Nginx neu laden. Wenn die Konfigurationsdatei des virtuellen Hosts nicht gefunden werden kann, erstellen Sie eine Standardseite und laden Sie Nginx neu. Anschließend wird die Fehlermeldung angezeigt verschwindet und die Website wird normal angezeigt.

So kommunizieren Sie zwischen Docker-Containern

Apr 07, 2024 pm 06:24 PM

So kommunizieren Sie zwischen Docker-Containern

Apr 07, 2024 pm 06:24 PM

In der Docker-Umgebung gibt es fünf Methoden für die Containerkommunikation: freigegebenes Netzwerk, Docker Compose, Netzwerk-Proxy, freigegebenes Volume und Nachrichtenwarteschlange. Wählen Sie abhängig von Ihren Isolations- und Sicherheitsanforderungen die am besten geeignete Kommunikationsmethode, z. B. die Nutzung von Docker Compose zur Vereinfachung von Verbindungen oder die Verwendung eines Netzwerk-Proxys zur Erhöhung der Isolation.

So generieren Sie eine URL aus einer HTML-Datei

Apr 21, 2024 pm 12:57 PM

So generieren Sie eine URL aus einer HTML-Datei

Apr 21, 2024 pm 12:57 PM

Für die Konvertierung einer HTML-Datei in eine URL ist ein Webserver erforderlich. Dazu sind die folgenden Schritte erforderlich: Besorgen Sie sich einen Webserver. Richten Sie einen Webserver ein. Laden Sie eine HTML-Datei hoch. Erstellen Sie einen Domainnamen. Leiten Sie die Anfrage weiter.

So stellen Sie das NodeJS-Projekt auf dem Server bereit

Apr 21, 2024 am 04:40 AM

So stellen Sie das NodeJS-Projekt auf dem Server bereit

Apr 21, 2024 am 04:40 AM

Serverbereitstellungsschritte für ein Node.js-Projekt: Bereiten Sie die Bereitstellungsumgebung vor: Erhalten Sie Serverzugriff, installieren Sie Node.js, richten Sie ein Git-Repository ein. Erstellen Sie die Anwendung: Verwenden Sie npm run build, um bereitstellbaren Code und Abhängigkeiten zu generieren. Code auf den Server hochladen: über Git oder File Transfer Protocol. Abhängigkeiten installieren: Stellen Sie eine SSH-Verbindung zum Server her und installieren Sie Anwendungsabhängigkeiten mit npm install. Starten Sie die Anwendung: Verwenden Sie einen Befehl wie node index.js, um die Anwendung zu starten, oder verwenden Sie einen Prozessmanager wie pm2. Konfigurieren Sie einen Reverse-Proxy (optional): Verwenden Sie einen Reverse-Proxy wie Nginx oder Apache, um den Datenverkehr an Ihre Anwendung weiterzuleiten

Was sind die häufigsten Anweisungen in einer Docker-Datei?

Apr 07, 2024 pm 07:21 PM

Was sind die häufigsten Anweisungen in einer Docker-Datei?

Apr 07, 2024 pm 07:21 PM

Die am häufigsten verwendeten Anweisungen in Dockerfile sind: FROM: Neues Image erstellen oder neues Image ableiten RUN: Befehle ausführen (Software installieren, System konfigurieren) COPY: Lokale Dateien in das Image kopieren ADD: Ähnlich wie COPY kann es automatisch dekomprimiert werden tar-Archive oder URL-Dateien abrufen CMD: Geben Sie den Befehl an, wenn der Container gestartet wird. EXPOSE: Deklarieren Sie den Container-Überwachungsport (aber nicht öffentlich). ENV: Legen Sie die Umgebungsvariable fest. VOLUME: Mounten Sie das Hostverzeichnis oder das anonyme Volume. WORKDIR: Legen Sie das Arbeitsverzeichnis im fest Container ENTRYPOINT: Geben Sie an, was beim Start des Containers ausgeführt werden soll. Ausführbare Datei (ähnlich wie CMD, kann aber nicht überschrieben werden)

Kann von außen auf Nodejs zugegriffen werden?

Apr 21, 2024 am 04:43 AM

Kann von außen auf Nodejs zugegriffen werden?

Apr 21, 2024 am 04:43 AM

Ja, auf Node.js kann von außen zugegriffen werden. Sie können die folgenden Methoden verwenden: Verwenden Sie Cloud Functions, um die Funktion bereitzustellen und öffentlich zugänglich zu machen. Verwenden Sie das Express-Framework, um Routen zu erstellen und Endpunkte zu definieren. Verwenden Sie Nginx, um Proxy-Anfragen an Node.js-Anwendungen umzukehren. Verwenden Sie Docker-Container, um Node.js-Anwendungen auszuführen und sie über Port-Mapping verfügbar zu machen.