Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die ChatGPT-Anwendung boomt. Wo findet man eine sichere große Datenbank?

Die ChatGPT-Anwendung boomt. Wo findet man eine sichere große Datenbank?

Die ChatGPT-Anwendung boomt. Wo findet man eine sichere große Datenbank?

Es besteht kein Zweifel daran, dass AIGC einen tiefgreifenden Wandel in der menschlichen Gesellschaft mit sich bringt.

Aber abgesehen von seinem schillernden und wunderschönen Aussehen kann der Laufkern nicht von der Unterstützung massiver Daten getrennt werden.

Das „Eindringen“ von ChatGPT hat in allen Lebensbereichen Besorgnis über Inhaltsplagiate hervorgerufen und das Bewusstsein für die Sicherheit von Netzwerkdaten geschärft.

Obwohl die KI-Technologie neutral ist, ist sie kein Grund, sich Verantwortungen und Verpflichtungen zu entziehen.

Kürzlich warnte der britische Geheimdienst, das British Government Communications Headquarters (GCHQ), dass ChatGPT und andere Chatbots mit künstlicher Intelligenz eine neue Sicherheitsbedrohung darstellen werden.

Obwohl es das Konzept von ChatGPT noch nicht lange gibt, sind die Bedrohungen der Netzwerksicherheit und Datensicherheit in den Fokus der Branche gerückt.

Sind solche Sorgen für ChatGPT, das sich noch in einem frühen Entwicklungsstadium befindet, unbegründet?

Sicherheitsbedrohungen können auftreten

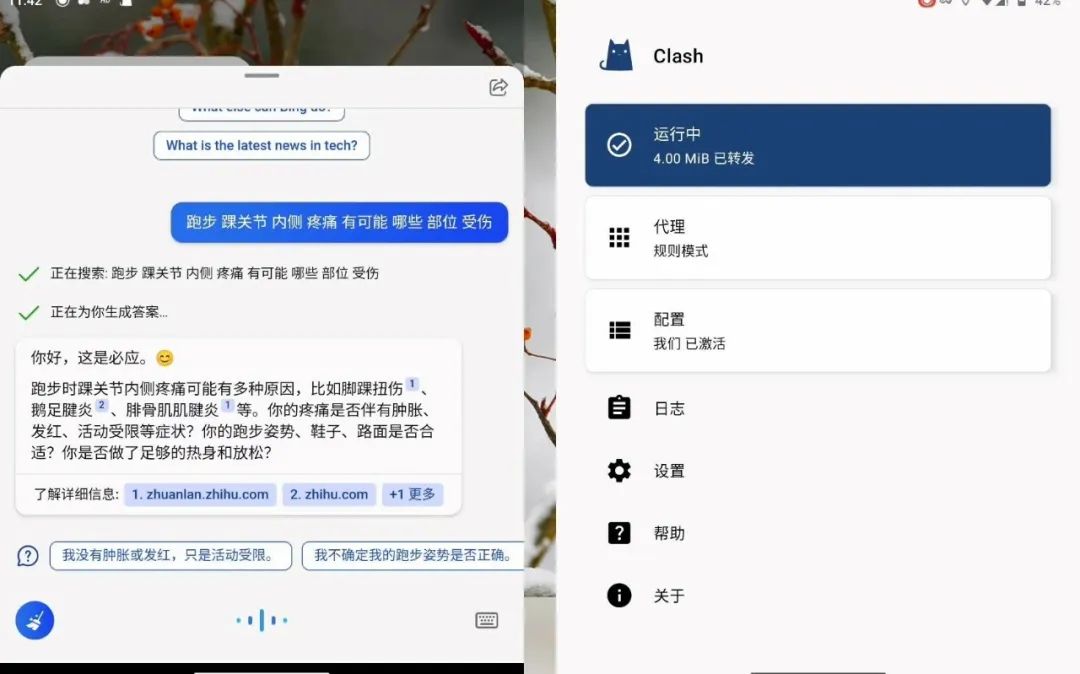

Ende letzten Jahres startete das Startup OpenAI ChatGPT. Danach startete sein Investor Microsoft ChatGPT In diesem Jahr wurde der Chat-Roboter „Bing Chat“ mithilfe der Technologie entwickelt.

Da diese Art von Software menschenähnliche Gespräche ermöglichen kann, ist dieser Dienst auf der ganzen Welt beliebt geworden.

Die Cybersicherheitsabteilung von GCHQ stellte fest, dass Unternehmen, die KI-Chatbots anbieten, den Abfrageinhalt sehen können Vom Benutzer eingegebene Daten, im Fall von ChatGPT, kann der Entwickler OpenAI dies sehen.

ChatGPT wird anhand einer großen Anzahl von Textkorpora trainiert und seine Deep-Learning-Fähigkeiten hängen stark von den dahinter stehenden Daten ab.

Aufgrund der Besorgnis über Informationslecks haben viele Unternehmen und Institutionen „ChatGPT-Verbote“ erlassen. Die Anwaltskanzlei Mishcon de Reya der City of London hat ihren Anwälten die Eingabe von Kundendaten in ChatGPT verboten, weil sie befürchtet, dass rechtlich geschützte Informationen gefährdet sein könnten.

Das internationale Beratungsunternehmen Accenture hat seine 700.000 Mitarbeiter auf der ganzen Welt aus ähnlichen Gründen davor gewarnt, ChatGPT zu verwenden, da es befürchtet, dass vertrauliche Kundendaten in die falschen Hände geraten könnten .

Die japanische SoftBank Group, die Muttergesellschaft des britischen Computerchip-Unternehmens Arm, warnte ihre Mitarbeiter außerdem davor, personenbezogene Daten oder vertrauliche Daten von Firmenmitarbeitern in Chatbots mit künstlicher Intelligenz einzugeben.

Im Februar dieses Jahres schränkte JPMorgan Chase als erste Wall Street-Investmentbank die Nutzung von ChatGPT am Arbeitsplatz ein.

Citigroup und Goldman Sachs folgten diesem Beispiel, wobei erstere ihren Mitarbeitern den unternehmensweiten Zugriff auf ChatGPT verbot und letztere ihre Mitarbeiter daran hinderten, das Produkt auf dem Börsenparkett zu nutzen.

Um zu verhindern, dass Mitarbeiter bei der Nutzung von ChatGPT Geheimnisse preisgeben, haben Amazon und Microsoft ihnen zuvor verboten, vertrauliche Daten mit ihnen zu teilen, da diese Informationen als solche verwendet werden könnten Trainingsdaten für weitere Iterationen.

Tatsächlich stecken hinter diesen Chatbots mit künstlicher Intelligenz große Sprachmodelle (LLM), und der Abfrageinhalt des Benutzers wird gespeichert und zu einem späteren Zeitpunkt aktualisiert . Bei Verwendung zur Entwicklung von LLM-Diensten oder -Modellen.

Das bedeutet, dass der LLM-Anbieter verwandte Abfragen lesen und diese möglicherweise auf irgendeine Weise in zukünftige Releases integrieren kann.

Obwohl LLM-Betreiber Maßnahmen zum Schutz der Daten ergreifen sollten, kann die Möglichkeit eines unbefugten Zugriffs nicht vollständig ausgeschlossen werden. Daher müssen Unternehmen sicherstellen, dass sie über strenge Richtlinien verfügen und technische Unterstützung zur Überwachung der Verwendung von LLM bereitstellen, um das Risiko einer Datenoffenlegung zu minimieren.

Obwohl ChatGPT selbst nicht in der Lage ist, die Netzwerk- und Datensicherheit direkt anzugreifen, kann es aufgrund seiner Fähigkeit, natürliche Sprache zu generieren und zu verstehen, zum Fälschen falscher Informationen, zum Angriff auf Social Engineering usw. verwendet werden.

Darüber hinaus können Angreifer auch natürliche Sprache verwenden, um ChatGPT entsprechende Angriffscodes, Malware-Codes, Spam-E-Mails usw. generieren zu lassen.

Daher kann KI denjenigen, die nicht in der Lage sind, Angriffe zu starten, ermöglichen, Angriffe auf KI-Basis zu generieren, und die Erfolgsquote von Angriffen erheblich steigern.

Mit der Unterstützung von Automatisierung, KI, „Attack as a Service“ und anderen Technologien und Modellen verzeichnen Netzwerksicherheitsangriffe einen rasanten Trend.

Bevor ChatGPT populär wurde, gab es viele Cyberangriffe durch Hacker, die KI-Technologie nutzten.

Tatsächlich ist es nicht ungewöhnlich, dass künstliche Intelligenz von Benutzern so eingestellt wird, dass sie „vom Rhythmus abweicht“. Als er vor sechs Jahren online ging, verhielt sich Tay höflich, aber innerhalb 24 Stunden lang wurde er von skrupellosen Nutzern „böse gemacht“, indem er unhöfliche und schmutzige Worte machte und sogar Rassismus, Pornografie und Nazis ins Spiel brachte. Seine Worte waren voller Diskriminierung, Hass und Vorurteile, also musste er offline genommen und beendet werden sein kurzes Leben.

Andererseits besteht das Risiko, dass Benutzer bei der Verwendung von KI-Tools wie ChatGPT versehentlich private Daten in das Cloud-Modell eingeben oder an andere weitergegeben werden der Antwort, was zu Datenschutzverletzungen und Compliance-Risiken führt.

KI-Anwendungen müssen ein sicheres Fundament legen

Als großes Sprachmodell besteht die Kernlogik von ChatGPT tatsächlich in der Sammlung, Verarbeitung, Verarbeitung und Ausgabe von Rechenergebnissen großer Datenmengen.

Generell können diese Links in dreierlei Hinsicht mit Risiken verbunden sein: technische Elemente, Organisationsmanagement und digitale Inhalte.

Obwohl ChatGPT erklärt hat, dass es sich bei der Speicherung der für das Training und die Ausführung von Modellen erforderlichen Daten strikt an Datenschutz- und Sicherheitsrichtlinien halten wird, kann es in Zukunft zu Netzwerkangriffen und Daten-Crawling kommen, und es bestehen weiterhin Datensicherheitsrisiken, die nicht ignoriert werden können .

Insbesondere wenn es um die Erfassung, Verarbeitung und kombinierte Nutzung nationaler Kerndaten, wichtiger lokaler und branchenspezifischer Daten sowie personenbezogener Daten geht, ist ein ausgewogenes Verhältnis zwischen Datenschutz und Flow-Sharing erforderlich.

Zusätzlich zu den versteckten Gefahren von Daten- und Datenschutzlecks birgt die KI-Technologie auch Probleme wie Datenverzerrung, falsche Informationen und Schwierigkeiten bei der Interpretation von Modellen, die zu Missverständnissen und Misstrauen führen können.

Der Trend ist angekommen und die AIGC-Welle kommt. Vor dem Hintergrund einer vielversprechenden Zukunft ist es entscheidend, voranzukommen und eine Datenschutzmauer zu errichten.

Insbesondere wenn sich die KI-Technologie allmählich verbessert, kann sie zu einem leistungsstarken Werkzeug zur Produktivitätssteigerung werden, kann aber auch leicht zu einem Werkzeug für Straftaten werden.

Überwachungsdaten des QiAnXin Threat Intelligence Center zeigen, dass von Januar bis Oktober 2022 mehr als 95 Milliarden chinesische institutionelle Daten illegal im Ausland gehandelt wurden, davon mehr als 57 Milliarden persönliche Informationen.

Daher ist die Gewährleistung der Sicherheit der Datenspeicherung, -berechnung und -zirkulation eine Voraussetzung für die Entwicklung der digitalen Wirtschaft.

Als Ganzes betrachtet sollten Spitzendesign und industrielle Entwicklung Hand in Hand gehen. Auf der Grundlage des Cybersicherheitsgesetzes sollte das Risiko- und Verantwortungsanalysesystem verfeinert und ein Mechanismus zur Sicherheitsverantwortung eingerichtet werden.

Gleichzeitig können Regulierungsbehörden regelmäßige Inspektionen durchführen und Unternehmen im Sicherheitsbereich zusammenarbeiten, um ein prozessübergreifendes Datensicherheitssystem aufzubauen.

Im Hinblick auf die Themen Datenkonformität und Datensicherheit, insbesondere nach der Einführung des „Datenschutzgesetzes“, gewinnt der Datenschutz immer mehr an Bedeutung.

Wenn Datensicherheit und Compliance beim Einsatz von KI-Technologie nicht gewährleistet werden können, können große Risiken für das Unternehmen entstehen.

Besonders kleine und mittelständische Unternehmen verfügen über mangelndes Wissen zum Thema Datenschutz und Sicherheit und wissen nicht, wie sie Daten vor Sicherheitsbedrohungen schützen können.

Datensicherheits-Compliance ist keine Angelegenheit einer bestimmten Abteilung, sondern die wichtigste Angelegenheit für das gesamte Unternehmen.

Unternehmen sollten ihre Mitarbeiter schulen, um ihnen bewusst zu machen, dass jeder, der Daten nutzt, zum Schutz der Daten verpflichtet ist, einschließlich IT-Personal, KI-Abteilungen, Dateningenieure, Entwickler, Personen, die Berichte verwenden usw. Menschen und Technologie müssen miteinander kombiniert werden .

Wie können Regulierungsbehörden und relevante Unternehmen angesichts der oben genannten potenziellen Risiken den Datenschutz im AIGC-Bereich auf institutioneller und technischer Ebene stärken?

Im Vergleich zu regulatorischen Maßnahmen wie der direkten Beschränkung der Nutzung von Benutzerterminals wird es effektiver sein, von Forschungs- und Entwicklungsunternehmen für KI-Technologie eindeutig zu verlangen, dass sie wissenschaftliche und technologische ethische Grundsätze befolgen, da diese Unternehmen den Umfang der Benutzer einschränken können ' Verwendung auf technischer Ebene.

Auf institutioneller Ebene ist es notwendig, ein Datenklassifizierungs- und hierarchisches Schutzsystem einzurichten und zu verbessern, das auf den Merkmalen und Funktionen der Daten basiert, die für die zugrunde liegende Technologie von AIGC erforderlich sind.

Zum Beispiel können die Daten im Trainingsdatensatz nach Datensubjekt, Datenverarbeitungsebene, Datenrechtsattributen usw. klassifiziert und verwaltet werden, und die Daten können basierend auf dem Wert der Daten klassifiziert und verwaltet werden Sobald die Daten manipuliert, vernichtet usw. werden, wird die Gefährdungsstufe der betroffenen Person abgestuft.

Auf der Grundlage der Datenklassifizierung und -klassifizierung werden Datenschutzstandards und Freigabemechanismen festgelegt, die dem Datentyp und der Sicherheitsstufe entsprechen.

Wir konzentrieren uns auf Unternehmen und müssen die Anwendung der „Private Computing“-Technologie im AIGC-Bereich beschleunigen.

Diese Art von Technologie ermöglicht es mehreren Dateneigentümern, Daten zu teilen, zu interagieren, zu berechnen und zu modellieren, indem sie SDKs teilen oder SDK-Berechtigungen öffnen, ohne die Daten selbst preiszugeben, und stellt gleichzeitig sicher, dass AIGC dies tun kann. Während die Dienste normal bereitgestellt werden, stellen Sie sicher, dass die Daten nicht offengelegt werden an andere Teilnehmer weitergegeben.

Darüber hinaus rückt die Bedeutung eines prozessübergreifenden Compliance-Managements immer stärker in den Vordergrund.

Unternehmen sollten zunächst darauf achten, ob die von ihnen verwendeten Datenressourcen den gesetzlichen und behördlichen Anforderungen entsprechen. Zweitens sollten sie sicherstellen, dass auch der gesamte Prozess des Algorithmus- und Modellbetriebs konform ist die ethischen Erwartungen der Öffentlichkeit weitestgehend widerspiegeln.

Gleichzeitig sollten Unternehmen interne Managementstandards formulieren und entsprechende Überwachungsabteilungen einrichten, um Daten in allen Aspekten von Anwendungsszenarien der KI-Technologie zu überwachen und sicherzustellen, dass Datenquellen legal sind, die Verarbeitung legal ist und die Ausgabe legal ist um die eigene Compliance sicherzustellen.

Der Schlüssel zur KI-Anwendung liegt in der Abwägung zwischen Bereitstellungsmethode und Kosten. Es muss jedoch beachtet werden, dass Sicherheitseinhaltung und Datenschutz „größere Risiken“ für Unternehmen bergen können, wenn sie nicht gut umgesetzt werden.

KI ist ein zweischneidiges Schwert. Wenn sie richtig eingesetzt wird, wird sie das Unternehmen leistungsfähiger machen; wenn sie nicht richtig eingesetzt wird, verursacht sie größere Verluste für das Unternehmen, indem sie Sicherheit, Datenschutz und Compliance vernachlässigt.

Bevor KI angewendet werden kann, ist es daher notwendig, eine stabilere „Datenbasis“ aufzubauen. Wie das Sprichwort sagt, kann nur ein stetiger Fortschritt zu einer langfristigen Entwicklung führen.

Das obige ist der detaillierte Inhalt vonDie ChatGPT-Anwendung boomt. Wo findet man eine sichere große Datenbank?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Bytedance Cutting führt SVIP-Supermitgliedschaft ein: 499 Yuan für ein fortlaufendes Jahresabonnement, das eine Vielzahl von KI-Funktionen bietet

Jun 28, 2024 am 03:51 AM

Diese Seite berichtete am 27. Juni, dass Jianying eine von FaceMeng Technology, einer Tochtergesellschaft von ByteDance, entwickelte Videobearbeitungssoftware ist, die auf der Douyin-Plattform basiert und grundsätzlich kurze Videoinhalte für Benutzer der Plattform produziert Windows, MacOS und andere Betriebssysteme. Jianying kündigte offiziell die Aktualisierung seines Mitgliedschaftssystems an und führte ein neues SVIP ein, das eine Vielzahl von KI-Schwarztechnologien umfasst, wie z. B. intelligente Übersetzung, intelligente Hervorhebung, intelligente Verpackung, digitale menschliche Synthese usw. Preislich beträgt die monatliche Gebühr für das Clipping von SVIP 79 Yuan, die Jahresgebühr 599 Yuan (Hinweis auf dieser Website: entspricht 49,9 Yuan pro Monat), das fortlaufende Monatsabonnement beträgt 59 Yuan pro Monat und das fortlaufende Jahresabonnement beträgt 499 Yuan pro Jahr (entspricht 41,6 Yuan pro Monat). Darüber hinaus erklärte der Cut-Beamte auch, dass diejenigen, die den ursprünglichen VIP abonniert haben, das Benutzererlebnis verbessern sollen

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Kann LLM durch Feinabstimmung wirklich neue Dinge lernen: Die Einführung neuen Wissens kann dazu führen, dass das Modell mehr Halluzinationen hervorruft

Jun 11, 2024 pm 03:57 PM

Large Language Models (LLMs) werden auf riesigen Textdatenbanken trainiert und erwerben dort große Mengen an realem Wissen. Dieses Wissen wird in ihre Parameter eingebettet und kann dann bei Bedarf genutzt werden. Das Wissen über diese Modelle wird am Ende der Ausbildung „verdinglicht“. Am Ende des Vortrainings hört das Modell tatsächlich auf zu lernen. Richten Sie das Modell aus oder verfeinern Sie es, um zu erfahren, wie Sie dieses Wissen nutzen und natürlicher auf Benutzerfragen reagieren können. Aber manchmal reicht Modellwissen nicht aus, und obwohl das Modell über RAG auf externe Inhalte zugreifen kann, wird es als vorteilhaft angesehen, das Modell durch Feinabstimmung an neue Domänen anzupassen. Diese Feinabstimmung erfolgt mithilfe von Eingaben menschlicher Annotatoren oder anderer LLM-Kreationen, wobei das Modell auf zusätzliches Wissen aus der realen Welt trifft und dieses integriert

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Um ein neues wissenschaftliches und komplexes Frage-Antwort-Benchmark- und Bewertungssystem für große Modelle bereitzustellen, haben UNSW, Argonne, die University of Chicago und andere Institutionen gemeinsam das SciQAG-Framework eingeführt

Jul 25, 2024 am 06:42 AM

Herausgeber | Der Frage-Antwort-Datensatz (QA) von ScienceAI spielt eine entscheidende Rolle bei der Förderung der Forschung zur Verarbeitung natürlicher Sprache (NLP). Hochwertige QS-Datensätze können nicht nur zur Feinabstimmung von Modellen verwendet werden, sondern auch effektiv die Fähigkeiten großer Sprachmodelle (LLMs) bewerten, insbesondere die Fähigkeit, wissenschaftliche Erkenntnisse zu verstehen und zu begründen. Obwohl es derzeit viele wissenschaftliche QS-Datensätze aus den Bereichen Medizin, Chemie, Biologie und anderen Bereichen gibt, weisen diese Datensätze immer noch einige Mängel auf. Erstens ist das Datenformular relativ einfach, die meisten davon sind Multiple-Choice-Fragen. Sie sind leicht auszuwerten, schränken jedoch den Antwortauswahlbereich des Modells ein und können die Fähigkeit des Modells zur Beantwortung wissenschaftlicher Fragen nicht vollständig testen. Im Gegensatz dazu offene Fragen und Antworten

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

SOTA Performance, eine multimodale KI-Methode zur Vorhersage der Protein-Ligand-Affinität in Xiamen, kombiniert erstmals molekulare Oberflächeninformationen

Jul 17, 2024 pm 06:37 PM

Herausgeber |. KX Im Bereich der Arzneimittelforschung und -entwicklung ist die genaue und effektive Vorhersage der Bindungsaffinität von Proteinen und Liganden für das Arzneimittelscreening und die Arzneimitteloptimierung von entscheidender Bedeutung. Aktuelle Studien berücksichtigen jedoch nicht die wichtige Rolle molekularer Oberflächeninformationen bei Protein-Ligand-Wechselwirkungen. Auf dieser Grundlage schlugen Forscher der Universität Xiamen ein neuartiges Framework zur multimodalen Merkmalsextraktion (MFE) vor, das erstmals Informationen über Proteinoberfläche, 3D-Struktur und -Sequenz kombiniert und einen Kreuzaufmerksamkeitsmechanismus verwendet, um verschiedene Modalitäten zu vergleichen Ausrichtung. Experimentelle Ergebnisse zeigen, dass diese Methode bei der Vorhersage von Protein-Ligand-Bindungsaffinitäten Spitzenleistungen erbringt. Darüber hinaus belegen Ablationsstudien die Wirksamkeit und Notwendigkeit der Proteinoberflächeninformation und der multimodalen Merkmalsausrichtung innerhalb dieses Rahmens. Verwandte Forschungen beginnen mit „S

ChatGPT ist jetzt mit der Veröffentlichung einer speziellen App für macOS verfügbar

Jun 27, 2024 am 10:05 AM

ChatGPT ist jetzt mit der Veröffentlichung einer speziellen App für macOS verfügbar

Jun 27, 2024 am 10:05 AM

Die ChatGPT-Mac-Anwendung von Open AI ist jetzt für alle verfügbar, während sie in den letzten Monaten nur denjenigen mit einem ChatGPT Plus-Abonnement vorbehalten war. Die App lässt sich wie jede andere native Mac-App installieren, sofern Sie über ein aktuelles Apple S verfügen

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

GlobalFoundries erschließt Märkte wie KI und erwirbt die Galliumnitrid-Technologie von Tagore Technology und zugehörige Teams

Jul 15, 2024 pm 12:21 PM

Laut Nachrichten dieser Website vom 5. Juli veröffentlichte GlobalFoundries am 1. Juli dieses Jahres eine Pressemitteilung, in der die Übernahme der Power-Galliumnitrid (GaN)-Technologie und des Portfolios an geistigem Eigentum von Tagore Technology angekündigt wurde, in der Hoffnung, seinen Marktanteil in den Bereichen Automobile und Internet auszubauen Anwendungsbereiche für Rechenzentren mit künstlicher Intelligenz, um höhere Effizienz und bessere Leistung zu erforschen. Da sich Technologien wie generative künstliche Intelligenz (GenerativeAI) in der digitalen Welt weiterentwickeln, ist Galliumnitrid (GaN) zu einer Schlüssellösung für nachhaltiges und effizientes Energiemanagement, insbesondere in Rechenzentren, geworden. Auf dieser Website wurde die offizielle Ankündigung zitiert, dass sich das Ingenieurteam von Tagore Technology im Rahmen dieser Übernahme mit GF zusammenschließen wird, um die Galliumnitrid-Technologie weiterzuentwickeln. G

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

SK Hynix wird am 6. August neue KI-bezogene Produkte vorstellen: 12-Layer-HBM3E, 321-High-NAND usw.

Aug 01, 2024 pm 09:40 PM

Laut Nachrichten dieser Website vom 1. August hat SK Hynix heute (1. August) einen Blogbeitrag veröffentlicht, in dem es ankündigt, dass es am Global Semiconductor Memory Summit FMS2024 teilnehmen wird, der vom 6. bis 8. August in Santa Clara, Kalifornien, USA, stattfindet viele neue Technologien Generation Produkt. Einführung des Future Memory and Storage Summit (FutureMemoryandStorage), früher Flash Memory Summit (FlashMemorySummit), hauptsächlich für NAND-Anbieter, im Zusammenhang mit der zunehmenden Aufmerksamkeit für die Technologie der künstlichen Intelligenz wurde dieses Jahr in Future Memory and Storage Summit (FutureMemoryandStorage) umbenannt Laden Sie DRAM- und Speicheranbieter und viele weitere Akteure ein. Neues Produkt SK Hynix wurde letztes Jahr auf den Markt gebracht