Was ist Textklassifizierung?

Übersetzer |. Li Rui

Rezensent |.

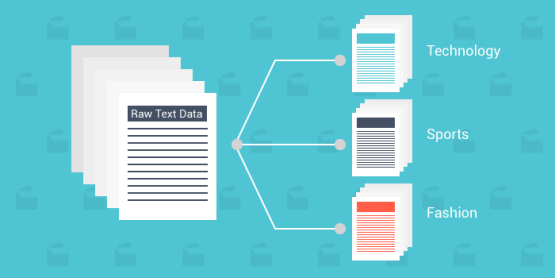

Textklassifizierung ist der Prozess der Klassifizierung von Text in eine oder mehrere verschiedene Kategorien, um ihn nach beliebigen Parametern zu organisieren, zu strukturieren und zu filtern. Beispielsweise wird die Textklassifizierung in juristischen Dokumenten, medizinischen Studien und Dokumenten oder einfach in Produktrezensionen verwendet. Daten sind wichtiger denn je; viele Unternehmen geben riesige Summen aus, um möglichst viele Erkenntnisse zu gewinnen.

Da Text-/Dokumentdaten immer umfangreicher werden als andere Datentypen, ist der Einsatz neuer Methoden unerlässlich. Da Daten von Natur aus unstrukturiert und äußerst umfangreich sind, kann eine leicht verständliche Organisation, um ihnen einen Sinn zu geben, ihren Wert erheblich steigern. Nutzen Sie Textklassifizierung und maschinelles Lernen, um relevante Texte schneller und kostengünstiger automatisch zu erstellen. Im Folgenden werden die Textklassifizierung, ihre Funktionsweise und einige der bekanntesten Algorithmen definiert und Datensätze bereitgestellt, die für den Beginn Ihrer Textklassifizierungsreise nützlich sein können. Warum maschinelles Lernen zur Textklassifizierung nutzen?Skalierung: Manuelle Dateneingabe, -analyse und -organisation sind mühsam und langsam. Maschinelles Lernen ermöglicht eine automatisierte Analyse unabhängig von der Größe des Datensatzes.

- Konsistenz: Menschliches Versagen entsteht aufgrund der Ermüdung des Personals und der Unempfindlichkeit gegenüber dem Material im Datensatz. Maschinelles Lernen verbessert die Skalierbarkeit und erhöht die Genauigkeit aufgrund der unvoreingenommenen und konsistenten Natur des Algorithmus erheblich.

- Geschwindigkeit: Manchmal müssen Sie möglicherweise schnell auf Daten zugreifen und diese organisieren. Algorithmen für maschinelles Lernen können Daten analysieren und Informationen auf leicht verständliche Weise bereitstellen.

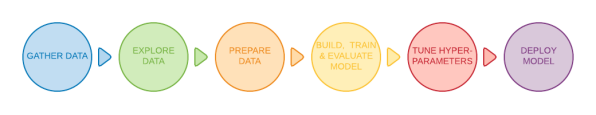

- 6 Allgemeine Schritte

Einige grundlegende Methoden können verschiedene Textdokumente bis zu einem gewissen Grad klassifizieren, aber die gebräuchlichste Methode verwendet maschinelles Lernen. Textklassifizierungsmodelle durchlaufen sechs grundlegende Schritte, bevor sie eingesetzt werden können.

Tag-Wort: Smarter

- Tag-Unterwort: Smart-er

- Tag-Zeichen: S-m-a-r-t-e-r

- Warum ist die Tokenisierung wichtig? Denn Textklassifizierungsmodelle können Daten nur auf tokenbasierter Ebene verarbeiten und keine vollständigen Sätze verstehen und verarbeiten. Das Modell erfordert eine weitere Verarbeitung des gegebenen Rohdatensatzes, um die gegebenen Daten leicht verarbeiten zu können. Entfernen Sie unnötige Funktionen, filtern Sie Null- und Unendlichwerte heraus und vieles mehr. Durch die Neuorganisation des gesamten Datensatzes können Verzerrungen während der Trainingsphase vermieden werden.

- Word2Vec: Dies ist eine von Google entwickelte unbeaufsichtigte Methode zur Worteinbettung. Es nutzt neuronale Netze, um aus großen Textdatensätzen zu lernen. Wie der Name schon sagt, wandelt die Word2Vec-Methode jedes Wort in einen bestimmten Vektor um.

- GloVe: Auch als globaler Vektor bekannt, handelt es sich um ein unbeaufsichtigtes maschinelles Lernmodell, das zum Erhalten von Vektordarstellungen von Wörtern verwendet wird. Ähnlich wie die Word2Vec-Methode ordnet der GloVe-Algorithmus Wörter einem sinnvollen Raum zu, wobei der Abstand zwischen Wörtern mit der semantischen Ähnlichkeit zusammenhängt.

- TF-IDF: TF-IDF ist die Abkürzung für Term Frequency-Inverse Text Frequency, einem Worteinbettungsalgorithmus, der zur Bewertung der Bedeutung von Wörtern in einem bestimmten Dokument verwendet wird. TF-IDF weist jedem Wort eine bestimmte Bewertung zu, um seine Bedeutung in einer Reihe von Dokumenten darzustellen.

Textklassifizierungsalgorithmen

Im Folgenden sind drei der bekanntesten und effektivsten Textklassifizierungsalgorithmen aufgeführt. Es ist wichtig zu bedenken, dass in jede Methode weitere definierte Algorithmen eingebettet sind.

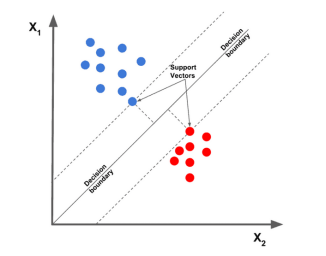

1. Linear Support Vector Machine

Der lineare Support Vector Machine-Algorithmus gilt derzeit als einer der besten Textklassifizierungsalgorithmen. Er zeichnet einen bestimmten Datenpunkt basierend auf einem bestimmten Merkmal und zeichnet dann eine am besten geeignete Linie. Teilen und klassifizieren Sie Daten in verschiedene Kategorien.

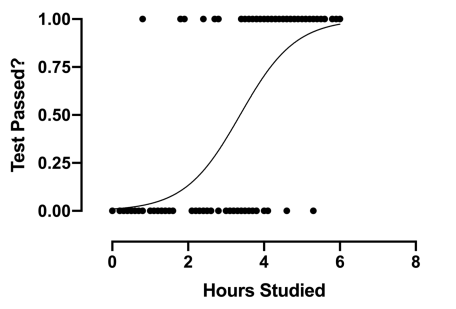

2. Logistische Regression

Logistische Regression ist eine Unterkategorie der Regression, die sich hauptsächlich auf Klassifizierungsprobleme konzentriert. Es nutzt Entscheidungsgrenzen, Regression und Distanz, um Datensätze auszuwerten und zu klassifizieren.

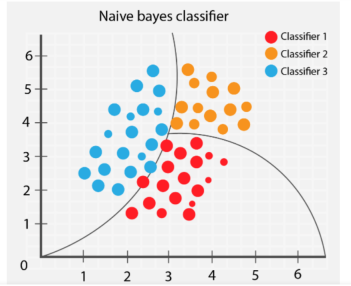

3. Naive Bayes

Der Naive Bayes-Algorithmus klassifiziert verschiedene Objekte basierend auf den von den Objekten bereitgestellten Merkmalen. Anschließend werden Gruppengrenzen gezogen, um diese Gruppenklassifizierungen zur weiteren Auflösung und Klassifizierung abzuleiten.

Welche Probleme sollten beim Einrichten der Textklassifizierung vermieden werden?

1. Überfüllte Trainingsdaten

Das Füttern des Algorithmus mit Daten geringer Qualität führt zu schlechten Zukunftsvorhersagen. Ein häufiges Problem für Praktiker des maschinellen Lernens besteht darin, dass Trainingsmodelle mit zu vielen Datensätzen gefüttert werden und unnötige Funktionen enthalten. Eine übermäßige Verwendung irrelevanter Daten führt zu einer Verschlechterung der Modellleistung. Und wenn es um die Auswahl und Organisation von Datensätzen geht, ist weniger mehr.

Ein falsches Verhältnis von Trainings- zu Testdaten kann die Leistung des Modells stark beeinträchtigen und das Mischen und Filtern von Daten beeinträchtigen. Genaue Datenpunkte werden nicht durch andere unerwünschte Faktoren beeinträchtigt und das trainierte Modell arbeitet effizienter.

Wählen Sie beim Training eines Modells einen Datensatz aus, der die Anforderungen des Modells erfüllt, filtern Sie unnötige Werte, mischen Sie den Datensatz und testen Sie die Genauigkeit des endgültigen Modells. Einfachere Algorithmen erfordern weniger Rechenzeit und Ressourcen, und die besten Modelle sind die einfachsten, die komplexe Probleme lösen können.

2. Überanpassung und Unteranpassung

Wenn das Training seinen Höhepunkt erreicht, nimmt die Genauigkeit des Modells mit fortschreitendem Training allmählich ab. Dies wird als Überanpassung bezeichnet. Da das Training zu lange dauert, beginnt das Modell, unerwartete Muster zu lernen. Seien Sie vorsichtig, wenn Sie eine hohe Genauigkeit des Trainingssatzes erreichen, da das Hauptziel darin besteht, ein Modell zu entwickeln, dessen Genauigkeit auf dem Testsatz basiert (Daten, die das Modell zuvor noch nicht gesehen hat).

Andererseits bedeutet Underfitting, dass das trainierte Modell noch Raum für Verbesserungen hat und sein maximales Potenzial noch nicht erreicht hat. Schlecht trainierte Modelle sind auf die Länge des Trainings oder eine übermäßige Regulierung des Datensatzes zurückzuführen. Dies verdeutlicht, was es bedeutet, über prägnante und präzise Daten zu verfügen.

Beim Training Ihres Modells ist es entscheidend, den Sweet Spot zu finden. Die Aufteilung des Datensatzes im Verhältnis 80/20 ist ein guter Anfang, aber die Anpassung der Parameter kann für ein bestimmtes Modell erforderlich sein, um eine optimale Leistung zu erzielen.

3. Falsches Textformat

Obwohl in diesem Artikel nicht ausführlich erwähnt, führt die Verwendung des richtigen Textformats bei Textklassifizierungsproblemen zu besseren Ergebnissen. Einige Methoden zur Darstellung von Textdaten umfassen GloVe, Word2Vec und Einbettungsmodelle.

Die Verwendung des richtigen Textformats verbessert die Art und Weise, wie das Modell den Datensatz liest und interpretiert, was ihm wiederum hilft, Muster zu verstehen.

Textklassifizierungs-App

- Spam filtern: E-Mails können durch die Suche nach bestimmten Schlüsselwörtern als nützlich oder Spam klassifiziert werden.

- Textklassifizierung: Mithilfe der Textklassifizierung kann die Anwendung verschiedene Elemente (Artikel und Bücher usw.) in verschiedene Kategorien einteilen, indem sie zugehörigen Text (z. B. Elementnamen und Beschreibungen usw.) klassifiziert. Die Verwendung dieser Techniken verbessert das Erlebnis, da sie den Benutzern die Navigation innerhalb der Datenbank erleichtert.

- Hassrede identifizieren: Einige Social-Media-Unternehmen nutzen die Textklassifizierung, um anstößige Kommentare oder Beiträge zu erkennen und zu sperren.

- Marketing und Werbung: Unternehmen können spezifische Änderungen vornehmen, um ihre Kunden zufriedenzustellen, indem sie verstehen, wie Benutzer auf bestimmte Produkte reagieren. Es kann auch bestimmte Produkte basierend auf Benutzerbewertungen ähnlicher Produkte empfehlen. Textklassifizierungsalgorithmen können in Verbindung mit Empfehlungssystemen verwendet werden, einem weiteren Deep-Learning-Algorithmus, der von vielen Online-Websites zur Gewinnung von Folgegeschäften verwendet wird.

Beliebte Textklassifizierungsdatensätze

Mit einer großen Anzahl beschrifteter und gebrauchsfertiger Datensätze können Sie jederzeit nach dem perfekten Datensatz suchen, der Ihren Modellanforderungen entspricht.

Während Sie möglicherweise Schwierigkeiten bei der Entscheidung haben, welchen Sie verwenden möchten, werden im Folgenden einige der bekanntesten Datensätze empfohlen, die der Öffentlichkeit zur Verfügung stehen.

- IMDB-Datensatz

- Amazon-Bewertungsdatensatz

- Yelp-Bewertungsdatensatz

- SMS-Spam-Sammlung

- Opin-Rank-Bewertungsdatensatz

- Twitter-Sentiment-Datensatz für US-Fluggesellschaften

- Hassreden und beleidigende Sprache-Datensatz

- Clickbait-Daten set

Kaggle usw. Die Website enthält verschiedene Datensätze zu allen Themen. Sie können zum Üben versuchen, das Modell mit mehreren der oben genannten Datensätze auszuführen.

Textklassifizierung beim maschinellen Lernen

Da maschinelles Lernen im letzten Jahrzehnt große Fortschritte gemacht hat, versuchen Unternehmen auf jede erdenkliche Weise, maschinelles Lernen zur Automatisierung von Prozessen zu nutzen. Rezensionen, Beiträge, Artikel, Zeitschriften und Dokumente sind im Text von unschätzbarem Wert. Und durch den Einsatz von Textklassifizierung auf vielfältige Weise zur Extraktion von Benutzereinblicken und -mustern können Unternehmen datengestützte Entscheidungen schneller als je zuvor treffen und wertvolle Informationen abrufen.

Originaltitel:Was ist Textklassifizierung?, Autor: Kevin Vu

Das obige ist der detaillierte Inhalt vonWas ist Textklassifizierung?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In diesem Artikel erfahren Sie mehr über SHAP: Modellerklärung für maschinelles Lernen

Jun 01, 2024 am 10:58 AM

In den Bereichen maschinelles Lernen und Datenwissenschaft stand die Interpretierbarkeit von Modellen schon immer im Fokus von Forschern und Praktikern. Mit der weit verbreiteten Anwendung komplexer Modelle wie Deep Learning und Ensemble-Methoden ist das Verständnis des Entscheidungsprozesses des Modells besonders wichtig geworden. Explainable AI|XAI trägt dazu bei, Vertrauen in maschinelle Lernmodelle aufzubauen, indem es die Transparenz des Modells erhöht. Eine Verbesserung der Modelltransparenz kann durch Methoden wie den weit verbreiteten Einsatz mehrerer komplexer Modelle sowie der Entscheidungsprozesse zur Erläuterung der Modelle erreicht werden. Zu diesen Methoden gehören die Analyse der Merkmalsbedeutung, die Schätzung des Modellvorhersageintervalls, lokale Interpretierbarkeitsalgorithmen usw. Die Merkmalswichtigkeitsanalyse kann den Entscheidungsprozess des Modells erklären, indem sie den Grad des Einflusses des Modells auf die Eingabemerkmale bewertet. Schätzung des Modellvorhersageintervalls

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Implementierung von Algorithmen für maschinelles Lernen in C++: Häufige Herausforderungen und Lösungen

Jun 03, 2024 pm 01:25 PM

Zu den häufigsten Herausforderungen, mit denen Algorithmen für maschinelles Lernen in C++ konfrontiert sind, gehören Speicherverwaltung, Multithreading, Leistungsoptimierung und Wartbarkeit. Zu den Lösungen gehören die Verwendung intelligenter Zeiger, moderner Threading-Bibliotheken, SIMD-Anweisungen und Bibliotheken von Drittanbietern sowie die Einhaltung von Codierungsstilrichtlinien und die Verwendung von Automatisierungstools. Praktische Fälle zeigen, wie man die Eigen-Bibliothek nutzt, um lineare Regressionsalgorithmen zu implementieren, den Speicher effektiv zu verwalten und leistungsstarke Matrixoperationen zu nutzen.

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Erklärbare KI: Erklären komplexer KI/ML-Modelle

Jun 03, 2024 pm 10:08 PM

Übersetzer |. Rezensiert von Li Rui |. Chonglou Modelle für künstliche Intelligenz (KI) und maschinelles Lernen (ML) werden heutzutage immer komplexer, und die von diesen Modellen erzeugten Ergebnisse sind eine Blackbox, die den Stakeholdern nicht erklärt werden kann. Explainable AI (XAI) zielt darauf ab, dieses Problem zu lösen, indem es Stakeholdern ermöglicht, die Funktionsweise dieser Modelle zu verstehen, sicherzustellen, dass sie verstehen, wie diese Modelle tatsächlich Entscheidungen treffen, und Transparenz in KI-Systemen, Vertrauen und Verantwortlichkeit zur Lösung dieses Problems gewährleistet. In diesem Artikel werden verschiedene Techniken der erklärbaren künstlichen Intelligenz (XAI) untersucht, um ihre zugrunde liegenden Prinzipien zu veranschaulichen. Mehrere Gründe, warum erklärbare KI von entscheidender Bedeutung ist. Vertrauen und Transparenz: Damit KI-Systeme allgemein akzeptiert und vertrauenswürdig sind, müssen Benutzer verstehen, wie Entscheidungen getroffen werden

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

Verbesserter Erkennungsalgorithmus: zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern

Jun 06, 2024 pm 12:33 PM

01Ausblicksübersicht Derzeit ist es schwierig, ein angemessenes Gleichgewicht zwischen Detektionseffizienz und Detektionsergebnissen zu erreichen. Wir haben einen verbesserten YOLOv5-Algorithmus zur Zielerkennung in hochauflösenden optischen Fernerkundungsbildern entwickelt, der mehrschichtige Merkmalspyramiden, Multierkennungskopfstrategien und hybride Aufmerksamkeitsmodule verwendet, um die Wirkung des Zielerkennungsnetzwerks in optischen Fernerkundungsbildern zu verbessern. Laut SIMD-Datensatz ist der mAP des neuen Algorithmus 2,2 % besser als YOLOv5 und 8,48 % besser als YOLOX, wodurch ein besseres Gleichgewicht zwischen Erkennungsergebnissen und Geschwindigkeit erreicht wird. 02 Hintergrund und Motivation Mit der rasanten Entwicklung der Fernerkundungstechnologie wurden hochauflösende optische Fernerkundungsbilder verwendet, um viele Objekte auf der Erdoberfläche zu beschreiben, darunter Flugzeuge, Autos, Gebäude usw. Objekterkennung bei der Interpretation von Fernerkundungsbildern

Ist Flash Attention stabil? Meta und Harvard stellten fest, dass die Gewichtsabweichungen ihrer Modelle um Größenordnungen schwankten

May 30, 2024 pm 01:24 PM

Ist Flash Attention stabil? Meta und Harvard stellten fest, dass die Gewichtsabweichungen ihrer Modelle um Größenordnungen schwankten

May 30, 2024 pm 01:24 PM

MetaFAIR hat sich mit Harvard zusammengetan, um einen neuen Forschungsrahmen zur Optimierung der Datenverzerrung bereitzustellen, die bei der Durchführung groß angelegten maschinellen Lernens entsteht. Es ist bekannt, dass das Training großer Sprachmodelle oft Monate dauert und Hunderte oder sogar Tausende von GPUs verwendet. Am Beispiel des Modells LLaMA270B erfordert das Training insgesamt 1.720.320 GPU-Stunden. Das Training großer Modelle stellt aufgrund des Umfangs und der Komplexität dieser Arbeitsbelastungen einzigartige systemische Herausforderungen dar. In letzter Zeit haben viele Institutionen über Instabilität im Trainingsprozess beim Training generativer SOTA-KI-Modelle berichtet. Diese treten normalerweise in Form von Verlustspitzen auf. Beim PaLM-Modell von Google kam es beispielsweise während des Trainingsprozesses zu Instabilitäten. Numerische Voreingenommenheit ist die Hauptursache für diese Trainingsungenauigkeit.

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Fünf Schulen des maschinellen Lernens, die Sie nicht kennen

Jun 05, 2024 pm 08:51 PM

Maschinelles Lernen ist ein wichtiger Zweig der künstlichen Intelligenz, der Computern die Möglichkeit gibt, aus Daten zu lernen und ihre Fähigkeiten zu verbessern, ohne explizit programmiert zu werden. Maschinelles Lernen hat ein breites Anwendungsspektrum in verschiedenen Bereichen, von der Bilderkennung und der Verarbeitung natürlicher Sprache bis hin zu Empfehlungssystemen und Betrugserkennung, und es verändert unsere Lebensweise. Im Bereich des maschinellen Lernens gibt es viele verschiedene Methoden und Theorien, von denen die fünf einflussreichsten Methoden als „Fünf Schulen des maschinellen Lernens“ bezeichnet werden. Die fünf Hauptschulen sind die symbolische Schule, die konnektionistische Schule, die evolutionäre Schule, die Bayes'sche Schule und die Analogieschule. 1. Der Symbolismus, auch Symbolismus genannt, betont die Verwendung von Symbolen zum logischen Denken und zum Ausdruck von Wissen. Diese Denkrichtung glaubt, dass Lernen ein Prozess der umgekehrten Schlussfolgerung durch das Vorhandene ist

Maschinelles Lernen in C++: Ein Leitfaden zur Implementierung gängiger Algorithmen für maschinelles Lernen in C++

Jun 03, 2024 pm 07:33 PM

Maschinelles Lernen in C++: Ein Leitfaden zur Implementierung gängiger Algorithmen für maschinelles Lernen in C++

Jun 03, 2024 pm 07:33 PM

In C++ umfasst die Implementierung von Algorithmen für maschinelles Lernen: Lineare Regression: Wird zur Vorhersage kontinuierlicher Variablen verwendet. Zu den Schritten gehören das Laden von Daten, das Berechnen von Gewichtungen und Verzerrungen, das Aktualisieren von Parametern und die Vorhersage. Logistische Regression: Wird zur Vorhersage diskreter Variablen verwendet. Der Prozess ähnelt der linearen Regression, verwendet jedoch die Sigmoidfunktion zur Vorhersage. Support Vector Machine: Ein leistungsstarker Klassifizierungs- und Regressionsalgorithmus, der die Berechnung von Support-Vektoren und die Vorhersage von Beschriftungen umfasst.

Ausblick auf zukünftige Trends der Golang-Technologie im maschinellen Lernen

May 08, 2024 am 10:15 AM

Ausblick auf zukünftige Trends der Golang-Technologie im maschinellen Lernen

May 08, 2024 am 10:15 AM

Das Anwendungspotenzial der Go-Sprache im Bereich des maschinellen Lernens ist enorm. Ihre Vorteile sind: Parallelität: Sie unterstützt die parallele Programmierung und eignet sich für rechenintensive Operationen bei maschinellen Lernaufgaben. Effizienz: Der Garbage Collector und die Sprachfunktionen sorgen dafür, dass der Code auch bei der Verarbeitung großer Datenmengen effizient ist. Benutzerfreundlichkeit: Die Syntax ist prägnant und erleichtert das Erlernen und Schreiben von Anwendungen für maschinelles Lernen.