Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ausführliche Interpretation der Sensorkalibrierungstechnologie für intelligente Autos

Ausführliche Interpretation der Sensorkalibrierungstechnologie für intelligente Autos

Ausführliche Interpretation der Sensorkalibrierungstechnologie für intelligente Autos

Die Kalibrierung von Sensoren ist ein notwendiges Bindeglied im Wahrnehmungssystem des autonomen Fahrens und ein notwendiger Schritt und eine Voraussetzung für die anschließende Sensorfusion. Ihr Zweck besteht darin, zwei oder mehr Sensoren in ein einheitliches räumlich-zeitliches Koordinatensystem umzuwandeln, damit die Sensorfusion sinnvoll ist . Wahrnehmung ist eine entscheidende Voraussetzung für die Entscheidungsfindung. Jeder Sensor muss nach der Herstellung und Installation durch Experimente kalibriert werden, um sicherzustellen, dass der Sensor den Designspezifikationen entspricht und die Genauigkeit der Messwerte gewährleistet ist.

Nachdem der Sensor im autonomen Fahrzeug installiert wurde, muss er gleichzeitig kalibriert werden. Während des Fahrvorgangs des Fahrzeugs weicht die Sensorposition aufgrund von Vibrationen und anderen Gründen von der ursprünglichen Position ab. Daher ist es notwendig, ihn in bestimmten Abständen zu kalibrieren, um den Sensor zu kalibrieren. Selbstfahrende Autos arbeiten gleichzeitig mit mehreren Arten von Sensoren zur Umweltwahrnehmung und Selbstwahrnehmung. Die Robustheit und Genauigkeit von Sensoren sind im Wahrnehmungsprozess selbstfahrender Autos besonders wichtig.

01 Kamerakalibrierung

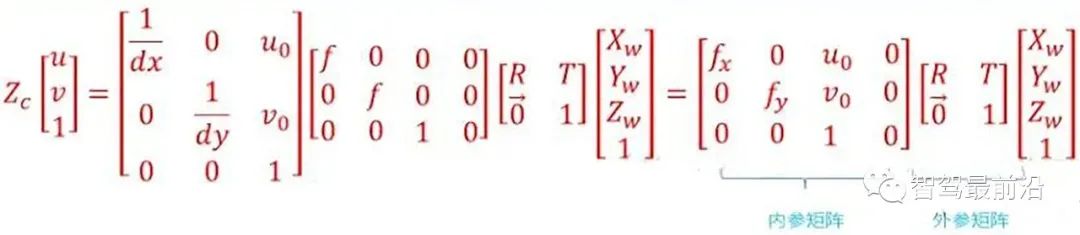

Die fahrzeugmontierte Kamera wird in einem bestimmten Winkel und in einer bestimmten Position am Fahrzeug installiert, um die von der fahrzeugmontierten Kamera erfassten Umgebungsdaten mit den realen Objekten im fahrenden Fahrzeug abzugleichen Umgebung, dh um die von der am Fahrzeug montierten Kamera generierten Daten zu finden. Die Konvertierungsbeziehung zwischen den Punktkoordinaten im Bildpixelkoordinatensystem und den Punktkoordinaten im Kameraumgebungskoordinatensystem erfordert eine Kamerakalibrierung. 1. Kamerainterne Parameterkalibrierung , wir können Finden Sie die Konvertierungsbeziehung zwischen dem Umgebungskoordinatensystem und dem Bildpixelkoordinatensystem, dh dem Punkt P von

in der realen Welt. Seine Koordinaten im Umgebungskoordinatensystem sind ( Die Konvertierungsbeziehung zwischen Bildpixelkoordinatensystemen

zur internen Parametermatrix, ihren vier Konstanten fx, fy, Uo, Vo. Er bezieht sich auf technische Designindikatoren wie Brennweite, Hauptpunkt und Sensor der Kamera und hat nichts mit externen Faktoren (wie Umgebung, Kameraposition) zu tun. Daher wird er als interner Parameter der Kamera bezeichnet Kamera. Die interne Referenz wird festgelegt, wenn die Kamera das Werk verlässt. Aufgrund des Herstellungsprozesses und anderer Probleme weisen jedoch selbst auf derselben Produktionslinie hergestellte Kameras leicht unterschiedliche interne Parameter auf. Daher ist es häufig erforderlich, die internen Parameter der Kamera durch Experimente zu bestimmen. Die Kalibrierung einer monokularen Kamera bezieht sich normalerweise auf die experimentelle Bestimmung der internen Parameter der Kamera.

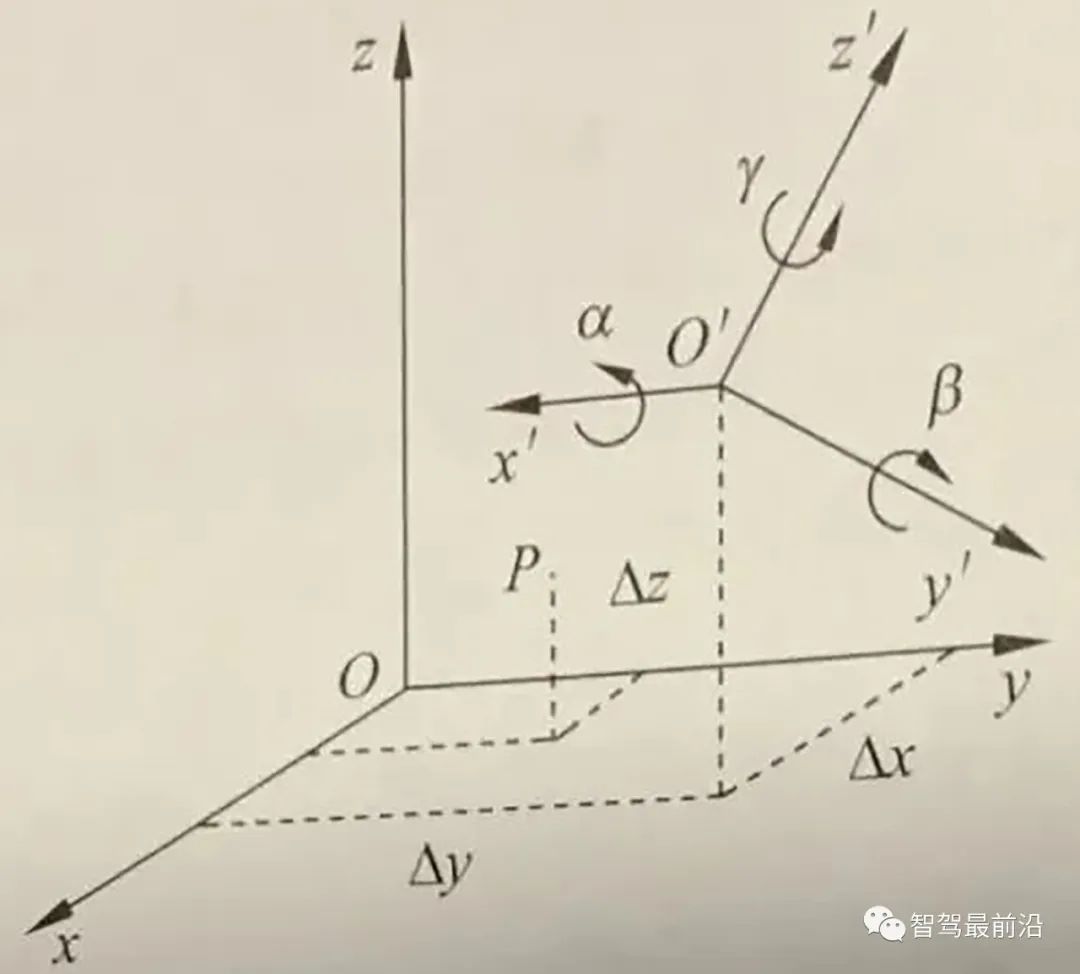

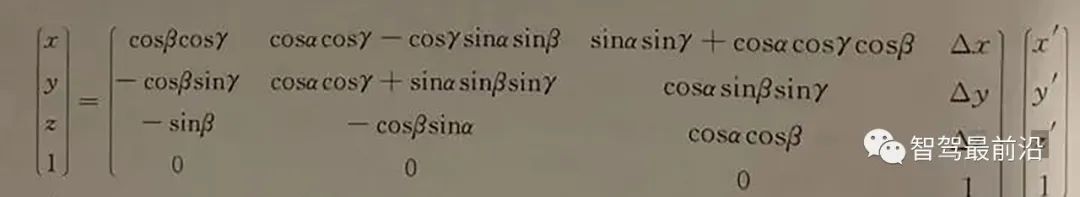

Die externe Parametermatrix umfasst die Rotationsmatrix und die Translationsmatrix. Die Rotationsmatrix und die Translationsmatrix beschreiben gemeinsam, wie der Punkt vom Weltkoordinatensystem in das Kamerakoordinatensystem umgewandelt wird. In der Computer Vision wird der Prozess der Bestimmung der externen Parametermatrix üblicherweise als visuelle Lokalisierung bezeichnet. Nachdem die Bordkamera in ein selbstfahrendes Auto eingebaut wurde, muss die Kameraposition im Fahrzeugkoordinatensystem kalibriert werden. Darüber hinaus ändert sich die Position der Bordkamera aufgrund der Stöße und Vibrationen des Autos im Laufe der Zeit langsam, sodass selbstfahrende Autos die Kameraposition regelmäßig neu kalibrieren müssen, ein Vorgang, der als Kalibrierung bezeichnet wird.

1.2 Kameraverzerrungskorrektur

Beim tatsächlichen Gebrauch kann die Kamera die perspektivische Projektion nicht ganz genau gemäß dem idealen Lochkameramodell durchführen. Normalerweise kommt es zu einer Linsenverzerrung, d. h. der Objektpunkt wird im Bild abgebildet Tatsächliche Kamera Zwischen dem in der Ebene erzeugten Bild und der idealen Abbildung besteht ein gewisser optischer Verzerrungsfehler, und der Verzerrungsfehler besteht hauptsächlich aus radialen Verzerrungsfehlern und tangentialen Verzerrungsfehlern.

Beim tatsächlichen Gebrauch kann die Kamera die perspektivische Projektion nicht ganz genau gemäß dem idealen Lochkameramodell durchführen. Normalerweise kommt es zu einer Linsenverzerrung, d. h. der Objektpunkt wird im Bild abgebildet Tatsächliche Kamera Zwischen dem in der Ebene erzeugten Bild und der idealen Abbildung besteht ein gewisser optischer Verzerrungsfehler, und der Verzerrungsfehler besteht hauptsächlich aus radialen Verzerrungsfehlern und tangentialen Verzerrungsfehlern.

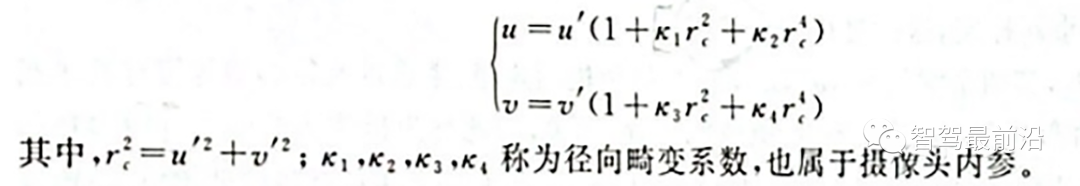

Radiale Verzerrung: Aufgrund der Eigenschaften des Objektivs neigt das Licht dazu, sich am Rand des Kameraobjektivs in kleinem oder großem Maße zu krümmen, was als radiale Verzerrung bezeichnet wird. Diese Art der Verzerrung ist bei gewöhnlichen billigen Objektiven deutlicher zu erkennen. Die radiale Verzerrung umfasst hauptsächlich Tonnenverzerrung und Kissenverzerrung. Bei der tonnenförmigen Verzerrung handelt es sich um eine tonnenförmige Erweiterung des Abbildungsbildes, die durch die Struktur des Linsenobjekts und der Linsengruppe im Objektiv verursacht wird. Tonnenverzerrungen sind normalerweise leichter zu erkennen, wenn ein Weitwinkelobjektiv oder das Weitwinkelende eines Zoomobjektivs verwendet wird. Unter Kissenverzerrung versteht man das Phänomen, dass das Bild durch das Objektiv zur Mitte hin „schrumpft“. Bei Verwendung des Telebereichs eines Zoomobjektivs ist die Wahrscheinlichkeit größer, dass Menschen eine kissenförmige Verzerrung bemerken. Beim Computersehen hat die radiale Verzerrung einen sehr wichtigen Einfluss auf die Szenenrekonstruktion. Die Wahrnehmung der Umgebung durch das autonome Fahrsystem erfordert eine hochpräzise Rekonstruktion der Umgebung durch die Kamera. Wenn die Verzerrung nicht korrigiert wird, können keine genauen Umgebungsinformationen erhalten werden. Beispielsweise können Ziele in der Umgebung in jedem Bereich des Bildes erscheinen. Wenn die Verzerrung nicht korrigiert wird, sind die durch die Bildverarbeitungstechnologie ermittelte Zielposition und -größe häufig ungenau, was sich direkt auf die Fahrsicherheit autonomer Fahrzeuge auswirkt. Darüber hinaus sind selbstfahrende Autos mit mehreren Kameras an verschiedenen Standorten ausgestattet. Wenn die radiale Verzerrung während des Bildzusammenfügungsprozesses nicht berücksichtigt wird, wird der Unschärfeeffekt der zusammengefügten Bilder durch die Nichtübereinstimmung entsprechender Merkmale verursacht. Bei allgemeinen Kameras wird die radiale Verzerrung des Bildes häufig als Polynommodell niedriger Ordnung beschrieben. Angenommen, (u, v) ist die Koordinate des korrigierten Punkts, (u', u') ist die Koordinate des unkorrigierten Punkts, dann kann die Transformation zwischen den beiden durch die folgende Formel bestimmt werden:

Radiales Polynommodell niedriger Ordnung

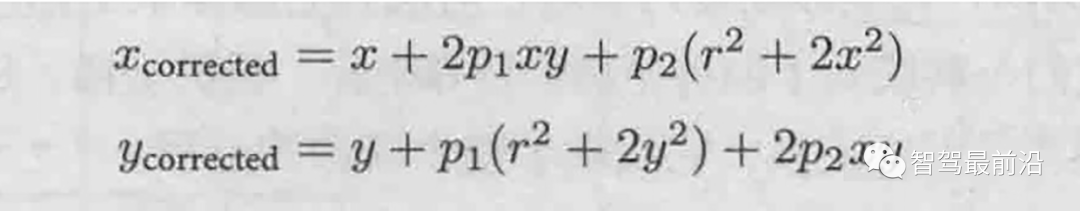

Andererseits können für die Tangentialverzerrung zwei weitere Parameter p1, p2 zur Korrektur verwendet werden:

Tangentialverzerrung Low- Ordnungspolynommodell

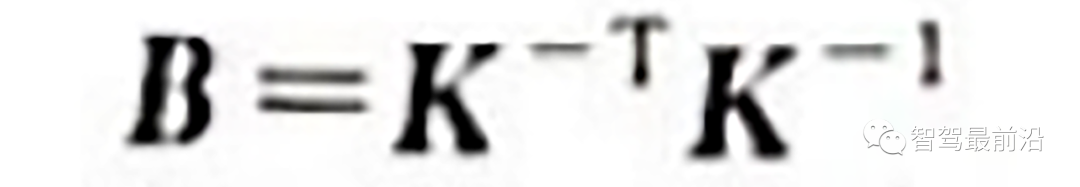

1.3 Kamerainterne Parameterkalibrierungsmethode

In dieser Phase wird die Kalibrierung der Verzerrungsparameter im Allgemeinen gleichzeitig mit den anderen internen Parametern durchgeführt. Die derzeit am weitesten verbreitete Methode ist die von Zhang Zhengyou im Jahr 2000 vorgeschlagene Zhang Zhengyou-Kalibrierungsmethode. Die Kalibrierungsmethode von Zhang Zhengyou findet die internen Eckpunkte des Schachbrett-Kalibrierungsbretts in jedem Bild, indem es das Schachbrett-Kalibrierungsbrett an verschiedenen Positionen fotografiert, und legt durch die Korrespondenz zwischen den internen Eckpunkten Einschränkungen für die Matrix fest, wodurch die internen Parameter wiederhergestellt werden Matrix K.  2. Kalibrierung externer Parameter zwischen Kameras

2. Kalibrierung externer Parameter zwischen Kameras

Um den blinden Wahrnehmungsbereich zu minimieren, wird häufig ein Multikameramodus verwendet. Die Bestimmung der relativen Positionsbeziehung zwischen mehreren Kameras wird als externe Parameterkalibrierung der Kamera bezeichnet.

Aus einer anderen Perspektive kann die externe Parameterkalibrierung der Kamera auch als „Posenschätzungsproblem“ bezeichnet werden. Die relative Pose [R|t] zwischen den beiden Kameras hat 6 Freiheitsgrade (räumliche Position und Rotationsbeziehung), solange die beiden Kameras gleichzeitig 3 Punkte im Raum erfassen relative Haltung wiederhergestellt werden. Das Problem der Wiederherstellung der relativen Haltung zwischen Kameras aus drei Paaren entsprechender Punkte wird als „Perspektive-3-Punkte-Problem, P3P“ bezeichnet. In der Realität werden häufig mehr als 3 Punkte verwendet, um die relative Haltung wiederherzustellen und die Robustheit zu verbessern, und das P3P-Problem wird als PnP-Problem verallgemeinert.

Zunächst verwendeten die Forscher die direkte lineare Transformation (DLT), um das PnP-Problem zu lösen. Um die Genauigkeit zu verbessern, schlugen die Forscher später den Reprojektionsfehler der robusten Linearisierung vor und begannen, die alternative Methode zur Lösung des PnP zu verwenden Problem und schlug daher die berühmte Bündelanpassungsmethode (Bundle Adjustment, BA) zur Einstellungsschätzung vor.

02 Lidar-Kalibrierung

Lidar ist einer der Hauptsensoren der autonomen Fahrplattform und spielt eine wichtige Rolle bei der Wahrnehmung und Positionierung. Wie Kameras muss auch Lidar seine internen und externen Parameter vor der Verwendung kalibrieren. Die interne Parameterkalibrierung bezieht sich auf die Konvertierungsbeziehung zwischen dem internen Koordinatensystem des Lasersenders und dem eigenen Koordinatensystem des Radars. Sie wurde vor Verlassen des Werks kalibriert und kann direkt verwendet werden. Was das autonome Fahrsystem durchführen muss, ist eine externe Parameterkalibrierung, also die Beziehung zwischen dem eigenen Koordinatensystem des Lidar und dem Koordinatensystem der Fahrzeugkarosserie.

Der Lidar und die Fahrzeugkarosserie sind starr miteinander verbunden und die relative Lage und Verschiebung zwischen beiden ist festgelegt. Um die relative Koordinatenbeziehung zwischen Lidars sowie zwischen Lidars und Fahrzeugen herzustellen, ist es notwendig, die Lidar-Installation zu kalibrieren und die Lidar-Daten vom Lidar-Koordinatensystem in das Fahrzeugkarosserie-Koordinatensystem umzuwandeln.

Fahrzeugkoordinatensystem und Lidar-Koordinatensystem

Die realen Koordinaten desselben Punktes in zwei Koordinatensystemen, also desselben Punktes, werden durch Experimente ermittelt Eine Reihe von Gleichungen kann diese 16 unbekannten Parameter berechnen. Darüber hinaus ist es in autonomen Fahrzeugen normalerweise erforderlich, das Laserradar und das Koordinatensystem der Trägheitsnavigationseinheit (IMU) zu kalibrieren, um die Beziehung zwischen dem Laserradar und dem Koordinatensystem der Fahrzeugkarosserie herzustellen.

1. Kalibrierung zwischen Lidar und Lidar

Bei autonomen Fahrzeugen gibt es manchmal mehrere Lidars, und die von jedem Lidar erfasste äußere Umgebung muss genau auf das Koordinatensystem der Fahrzeugkarosserie abgebildet werden. Wenn daher mehrere Lidars vorhanden sind, müssen die relativen Positionen der mehreren Lidars kalibriert und kalibriert werden.

Es gibt viele Ideen für die Kalibrierung externer Parameter zwischen Lidars. Die am häufigsten verwendete Idee besteht darin, die Koordinatentransformationsbeziehung zwischen Lidars indirekt über die Koordinatentransformationsbeziehung zwischen verschiedenen Lidars und der Karosserie abzuleiten.

2. Kalibrierung von Lidar und Kamera

Bei einem autonomen Fahrzeug sind das Lidar und das fahrerlose Auto fest verbunden, und die relative Lage und Verschiebung zwischen den beiden ist festgelegt Punkte haben eindeutige Positionskoordinaten, die ihnen im Umgebungskoordinatensystem entsprechen. Ebenso verfügt die Kamera über eindeutige Positionskoordinaten im Umgebungskoordinatensystem, sodass zwischen dem Lidar und der Kamera eine feste Koordinatentransformation stattfindet. Die gemeinsame Kalibrierung von Lidar und Kameras besteht darin, die Vereinheitlichung mehrerer Sensorkoordinaten wie einzeilige Lidar-Koordinaten, Kamerakoordinaten und Bildpixelkoordinaten durch Extrahieren der entsprechenden Merkmalspunkte des Kalibrierungsobjekts auf dem einzeiligen Lidar und dem Bild abzuschließen. und realisieren Sie die räumliche Kalibrierung von Lidar und Kamera.

Nach Abschluss der Kalibrierung der externen Kameraparameter und der externen Parameterkalibrierung des Lidar kann die Beziehung zwischen beiden tatsächlich vollständig bestimmt werden. Der Lidar-Scanpunkt kann auf das Bildpixelkoordinatensystem projiziert werden.

Ähnlich wie die interne Parameterkalibrierungsmethode der Kamera kann die Kalibrierungsmethode der Kalibrierplatte auch für die externe Parameterkalibrierung von Lidar und Kamera verwendet werden.

Das obige ist der detaillierte Inhalt vonAusführliche Interpretation der Sensorkalibrierungstechnologie für intelligente Autos. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Warum ist Gaussian Splatting beim autonomen Fahren so beliebt, dass NeRF allmählich aufgegeben wird?

Jan 17, 2024 pm 02:57 PM

Oben geschrieben und persönliches Verständnis des Autors. Dreidimensionales Gaussplatting (3DGS) ist eine transformative Technologie, die in den letzten Jahren in den Bereichen explizite Strahlungsfelder und Computergrafik entstanden ist. Diese innovative Methode zeichnet sich durch die Verwendung von Millionen von 3D-Gaußkurven aus, was sich stark von der Neural Radiation Field (NeRF)-Methode unterscheidet, die hauptsächlich ein implizites koordinatenbasiertes Modell verwendet, um räumliche Koordinaten auf Pixelwerte abzubilden. Mit seiner expliziten Szenendarstellung und differenzierbaren Rendering-Algorithmen garantiert 3DGS nicht nur Echtzeit-Rendering-Fähigkeiten, sondern führt auch ein beispielloses Maß an Kontrolle und Szenenbearbeitung ein. Dies positioniert 3DGS als potenziellen Game-Changer für die 3D-Rekonstruktion und -Darstellung der nächsten Generation. Zu diesem Zweck geben wir erstmals einen systematischen Überblick über die neuesten Entwicklungen und Anliegen im Bereich 3DGS.

Wow cool! Samsung Galaxy Ring-Erlebnis: 2999 Yuan echter Smart Ring

Jul 19, 2024 pm 02:31 PM

Wow cool! Samsung Galaxy Ring-Erlebnis: 2999 Yuan echter Smart Ring

Jul 19, 2024 pm 02:31 PM

Samsung hat am 17. Juli offiziell die nationale Version des Samsung Galaxy Ring zum Preis von 2.999 Yuan veröffentlicht. Das echte Telefon des Galaxy Ring ist wirklich die 2024-Version von „WowAwesome, das ist mein exklusiver Moment“. Es ist das elektronische Produkt, das uns in den letzten Jahren das frischeste Gefühl gibt (obwohl es wie eine Flagge klingt). (Im Bild sind die Ringe links und rechts Galaxy Ring ↑) Samsung Galaxy Ring-Spezifikationen (Daten von der offiziellen Website der Bank of China): ZephyrRTOS-System, 8 MB wasserdicht + IP68; Batteriekapazität 18 mAh mAh (verschiedene Größen

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Wie lässt sich das Long-Tail-Problem in autonomen Fahrszenarien lösen?

Jun 02, 2024 pm 02:44 PM

Gestern wurde ich während des Interviews gefragt, ob ich irgendwelche Long-Tail-Fragen gestellt hätte, also dachte ich, ich würde eine kurze Zusammenfassung geben. Das Long-Tail-Problem des autonomen Fahrens bezieht sich auf Randfälle bei autonomen Fahrzeugen, also mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. Das wahrgenommene Long-Tail-Problem ist einer der Hauptgründe, die derzeit den betrieblichen Designbereich intelligenter autonomer Einzelfahrzeugfahrzeuge einschränken. Die zugrunde liegende Architektur und die meisten technischen Probleme des autonomen Fahrens wurden gelöst, und die verbleibenden 5 % der Long-Tail-Probleme wurden nach und nach zum Schlüssel zur Einschränkung der Entwicklung des autonomen Fahrens. Zu diesen Problemen gehören eine Vielzahl fragmentierter Szenarien, Extremsituationen und unvorhersehbares menschliches Verhalten. Der „Long Tail“ von Randszenarien beim autonomen Fahren bezieht sich auf Randfälle in autonomen Fahrzeugen (AVs). Randfälle sind mögliche Szenarien mit geringer Eintrittswahrscheinlichkeit. diese seltenen Ereignisse

Upgrade auf Vollbild! Das iPhone SE4 ist auf September vorgerückt

Jul 24, 2024 pm 12:56 PM

Upgrade auf Vollbild! Das iPhone SE4 ist auf September vorgerückt

Jul 24, 2024 pm 12:56 PM

Kürzlich wurden auf Weibo neue Neuigkeiten zum iPhone SE4 enthüllt. Es heißt, dass der Backcover-Prozess des iPhone SE4 genau derselbe ist wie der der iPhone 16-Standardversion. Mit anderen Worten, das iPhone SE4 wird eine Glasrückwand verwenden gerader Bildschirm und gerades Kantendesign. Es wird berichtet, dass das iPhone SE4 vor September dieses Jahres auf den Markt kommen wird, was bedeutet, dass es wahrscheinlich gleichzeitig mit dem iPhone 16 vorgestellt wird. 1. Den belichteten Renderings zufolge ähnelt das Frontdesign des iPhone SE4 dem des iPhone 13, mit einer Frontkamera und einem FaceID-Sensor auf dem Notch-Bildschirm. Die Rückseite weist ein ähnliches Layout wie das iPhoneXr auf, verfügt jedoch nur über eine Kamera und kein umfassendes Kameramodul.

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

Kamera oder Lidar wählen? Eine aktuelle Übersicht über die Erzielung einer robusten 3D-Objekterkennung

Jan 26, 2024 am 11:18 AM

0. Vorab geschrieben&& Persönliches Verständnis, dass autonome Fahrsysteme auf fortschrittlichen Wahrnehmungs-, Entscheidungs- und Steuerungstechnologien beruhen, indem sie verschiedene Sensoren (wie Kameras, Lidar, Radar usw.) verwenden, um die Umgebung wahrzunehmen, und Algorithmen und Modelle verwenden für Echtzeitanalysen und Entscheidungsfindung. Dies ermöglicht es Fahrzeugen, Verkehrszeichen zu erkennen, andere Fahrzeuge zu erkennen und zu verfolgen, das Verhalten von Fußgängern vorherzusagen usw. und sich so sicher an komplexe Verkehrsumgebungen anzupassen. Diese Technologie erregt derzeit große Aufmerksamkeit und gilt als wichtiger Entwicklungsbereich für die Zukunft des Transportwesens . eins. Aber was autonomes Fahren schwierig macht, ist herauszufinden, wie man dem Auto klarmachen kann, was um es herum passiert. Dies erfordert, dass der dreidimensionale Objekterkennungsalgorithmus im autonomen Fahrsystem Objekte in der Umgebung, einschließlich ihrer Standorte, genau wahrnehmen und beschreiben kann.

Wie groß ist der 1-Zoll-Sensor eines Mobiltelefons? Er ist tatsächlich größer als der 1-Zoll-Sensor einer Kamera

May 08, 2024 pm 06:40 PM

Wie groß ist der 1-Zoll-Sensor eines Mobiltelefons? Er ist tatsächlich größer als der 1-Zoll-Sensor einer Kamera

May 08, 2024 pm 06:40 PM

Im gestrigen Artikel wurde die „Sensorgröße“ nicht erwähnt. Ich hatte nicht erwartet, dass es so viele Missverständnisse geben würde ... Wie viel ist 1 Zoll? Aufgrund einiger historischer Probleme* beträgt „1 Zoll“ in der Diagonalenlänge des Sensors nicht 25,4 mm, unabhängig davon, ob es sich um eine Kamera oder ein Mobiltelefon handelt. *Bei Vakuumröhren gibt es hier keine Ausdehnung. Es ist ein bisschen so, als ob der Hintern eines Pferdes über die Breite einer Eisenbahnschiene entscheidet. Um Missverständnisse zu vermeiden, lautet die strengere Schreibweise „Typ 1.0“ oder „Typ 1.0“. Wenn die Sensorgröße außerdem kleiner als 1/2 Typ ist, ist Typ 1 = 18 mm, und wenn die Sensorgröße größer oder gleich 1/2 Typ ist, ist Typ 1 =

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

SIMPL: Ein einfacher und effizienter Multi-Agent-Benchmark zur Bewegungsvorhersage für autonomes Fahren

Feb 20, 2024 am 11:48 AM

Originaltitel: SIMPL: ASimpleandEfficientMulti-agentMotionPredictionBaselineforAutonomousDriving Paper-Link: https://arxiv.org/pdf/2402.02519.pdf Code-Link: https://github.com/HKUST-Aerial-Robotics/SIMPL Autor: Hong Kong University of Science und Technologie DJI-Papieridee: Dieses Papier schlägt eine einfache und effiziente Bewegungsvorhersagebasislinie (SIMPL) für autonome Fahrzeuge vor. Im Vergleich zum herkömmlichen Agent-Cent