Dieses Videosegmentierungsmodell der Southern University of Science and Technology kann alles im Video verfolgen.

Es kann nicht nur „ansehen“, sondern auch „schneiden“. Es ist auch einfach, einzelne Personen aus dem Video zu entfernen.

Zur Bedienung genügen ein paar Mausklicks.

Der Spezialeffektkünstler schien einen Retter gefunden zu haben, nachdem er die Nachrichten gesehen hatte, und sagte unverblümt, dass dieses Produkt die Spielregeln in der CGI-Branche ändern werde.

Dieses Modell heißt TAM (Track Anything Model). Ähnelt es dem Namen von Metas Bildsegmentierungsmodell SAM?

Tatsächlich erweitert TAM SAM auf den Videobereich und beleuchtet den Fähigkeitsbaum der Dynamischen Objektverfolgung.

Das Videosegmentierungsmodell ist eigentlich keine neue Technologie, aber das traditionelle Segmentierungsmodell erleichtert die menschliche Arbeit nicht.

Die von diesen Modellen verwendeten Trainingsdaten erfordern alle manuelle Anmerkungen und müssen vor der Verwendung sogar mit den Maskenparametern bestimmter Objekte initialisiert werden.

Das Aufkommen von SAM bietet eine Voraussetzung für die Lösung dieses Problems – zumindest müssen die Initialisierungsdaten nicht mehr manuell beschafft werden.

Natürlich verwendet TAM SAM nicht Frame für Frame und überlagert es dann. Die entsprechende räumlich-zeitliche Beziehung muss ebenfalls konstruiert werden.

Das Team integrierte SAM mit einem Speichermodul namens XMem.

Sie müssen SAM nur verwenden, um Anfangsparameter im ersten Frame zu generieren, und XMem kann den nachfolgenden Tracking-Prozess steuern.

Es kann viele Verfolgungsziele geben, wie zum Beispiel die Szene am Qingming-Fluss unten:

Auch wenn sich die Szene ändert, hat dies keinen Einfluss auf die Leistung von TAM:

Wir haben es erlebt und festgestellt, dass TAM Interactive übernimmt Benutzeroberfläche, sehr einfach und benutzerfreundlich.

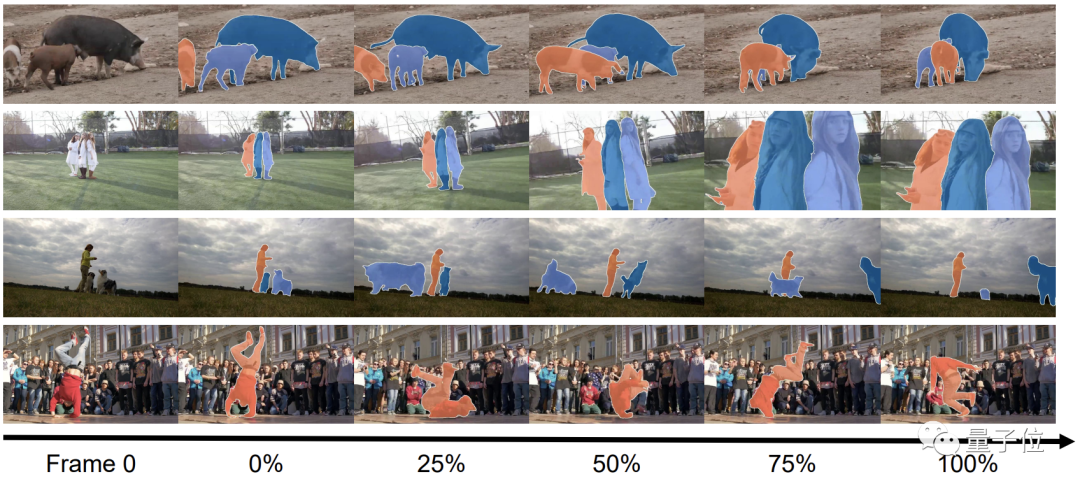

In Bezug auf Hard Power ist der Tracking-Effekt von TAM tatsächlich gut:

Allerdings muss die Genauigkeit der Eliminierungsfunktion in einigen Details verbessert werden.

Wie bereits erwähnt, wird TAM basierend auf SAM implementiert, indem Speicherfunktionen kombiniert werden, um eine räumlich-zeitliche Korrelation herzustellen.

Konkret besteht der erste Schritt darin, das Modell mithilfe der statischen Bildsegmentierungsfunktionen von SAM zu initialisieren.

Mit nur einem Klick kann SAM die anfänglichen Maskenparameter des Zielobjekts generieren und so den komplexen Initialisierungsprozess im herkömmlichen Segmentierungsmodell ersetzen.

Mit den anfänglichen Parametern kann das Team sie für ein halbmanuelles Interventionstraining an XMem übergeben, wodurch die menschliche Arbeitsbelastung erheblich reduziert wird.

In diesem Prozess werden einige manuelle Vorhersageergebnisse zum Vergleich mit der Ausgabe von XMem verwendet.

Im tatsächlichen Prozess wird es für XMem mit der Zeit immer schwieriger, genaue Segmentierungsergebnisse zu erhalten.

Wenn der Unterschied zwischen den Ergebnissen und den Erwartungen zu groß ist, wird der Neusegmentierungsschritt eingegeben, und dieser Schritt wird weiterhin von SAM abgeschlossen.

Nach der Neuoptimierung von SAM sind die meisten Ausgabeergebnisse genauer, einige müssen jedoch noch manuell angepasst werden. Der Trainingsprozess von

TAM sieht ungefähr so aus, und die eingangs erwähnten Fähigkeiten zur Objekteliminierung werden durch die Kombination von TAM mit E2FGVI gebildet.

E2FGVI selbst ist auch ein Tool zur Eliminierung von Videoelementen. Mit der Unterstützung der präzisen Segmentierung von TAM ist seine Arbeit zielgerichteter.

Um TAM zu testen, evaluierte das Team es anhand der DAVIS-16- und DAVIS-17-Datensätze.

Das intuitive Gefühl ist immer noch sehr gut und die Daten bestätigen es.

Obwohl TAM keine manuelle Einstellung der Maskenparameter erfordert, liegen seine beiden Indikatoren J (regionale Ähnlichkeit) und F (Grenzgenauigkeit) sehr nahe am manuellen Modell.

Sogar die Leistung des DAVIS-2017-Datensatzes ist etwas besser als die von STM.

Neben anderen Initialisierungsmethoden kann die Leistung von SiamMask überhaupt nicht mit TAM verglichen werden.

Obwohl eine andere Methode namens MiVOS eine bessere Leistung als TAM erbringt, hat sie sich immerhin 8 Runden lang weiterentwickelt ...

TAM kommt vom Visual Intelligence and Perception (VIP) Laboratory der Southern University of Science and Technology.

Die Forschungsrichtungen des Labors umfassen Text-Bild-Ton-Multimodell-Lernen, Multimodell-Wahrnehmung, Verstärkungslernen und visuelle Fehlererkennung.

Derzeit hat das Team mehr als 30 Artikel veröffentlicht und 5 Patente erhalten.

Der Leiter des Teams ist außerordentlicher Professor Zheng Feng von der Southern University of Science and Technology. Er schloss sein Studium an der University of Sheffield im Vereinigten Königreich ab und arbeitete für das Institute of Advanced Studies der Chinesischen Akademie der Wissenschaften. Tencent Youtu und andere Institutionen traten 2018 in die Southern University of Science and Technology ein und wurden 2021 zum außerordentlichen Professor befördert.

Paper Adresse:

https: //arxiv.org/abs/2304.11968

github Seite:

https: //github.com/gaomingqi/track-anything

reference Link:

https://twitter.com/bilawalsidhu/status/1650710123399233536?s=20

Das obige ist der detaillierte Inhalt vonDie schwarze Technologie von Southern Science and Technology: Eliminieren Sie Videocharaktere mit einem Klick, der Retter des Spezialeffektkünstlers ist da!. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Was tun mit der Grafikkarte?

Was tun mit der Grafikkarte?

So laden Sie Videos von Douyin herunter

So laden Sie Videos von Douyin herunter

Was nützt Bitlocker?

Was nützt Bitlocker?

So entfernen Sie Wasserzeichen aus einem Ausschnitt

So entfernen Sie Wasserzeichen aus einem Ausschnitt

So öffnen Sie PHP auf einer Webseite

So öffnen Sie PHP auf einer Webseite

Lösung für die vscode-Einstellung der chinesischen Schnittstelle wird nicht wirksam

Lösung für die vscode-Einstellung der chinesischen Schnittstelle wird nicht wirksam

Span-Tag-Funktion

Span-Tag-Funktion

Wie hoch sind die Sternebewertungen mobiler Nutzer?

Wie hoch sind die Sternebewertungen mobiler Nutzer?