Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Meta wirft die KI kontinuierlich, um den ultimativen Zug zu beschleunigen! Der erste KI-Inferenzchip, KI-Supercomputer, der speziell für das Training großer Modelle entwickelt wurde

Meta wirft die KI kontinuierlich, um den ultimativen Zug zu beschleunigen! Der erste KI-Inferenzchip, KI-Supercomputer, der speziell für das Training großer Modelle entwickelt wurde

Meta wirft die KI kontinuierlich, um den ultimativen Zug zu beschleunigen! Der erste KI-Inferenzchip, KI-Supercomputer, der speziell für das Training großer Modelle entwickelt wurde

Zusammengestellt |. Li Shuiqing

bearbeiten |. 心元

zhixixi 19. Mai, Ortszeit, Meta gab auf seiner offiziellen Website eine Ankündigung heraus, um der stark wachsenden Nachfrage nach KI-Rechenleistung in den nächsten zehn Jahren gerecht zu werden Plan – speziell für die KI-Infrastruktur der nächsten Generation entwickelt.

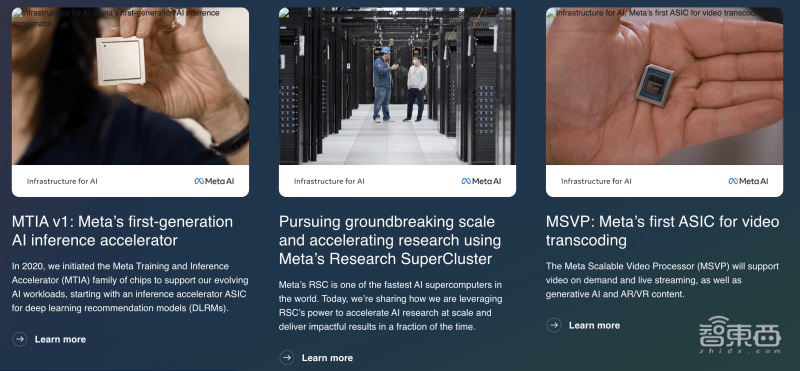

Meta gab seine neuesten Fortschritte beim Aufbau einer Infrastruktur der nächsten Generation für KI bekannt, darunter den ersten benutzerdefinierten Chip für die Ausführung von KI-Modellen, ein neues KI-optimiertes Rechenzentrumsdesign, den ersten Videotranskodierungs-ASIC und eine integrierte 16.000-Block-GPU, KI Supercomputer RSC zur Beschleunigung des KI-Trainings usw.

▲Offenlegung von Details zur KI-Infrastruktur auf der offiziellen Meta-Website

Meta betrachtet KI als die Kerninfrastruktur des Unternehmens. Seit Meta im Jahr 2010 den Grundstein für sein erstes Rechenzentrum gelegt hat, ist KI zum Motor von mehr als 3 Milliarden Menschen geworden, die täglich die Meta-Anwendungsfamilie nutzen. Von der Big-Sur-Hardware im Jahr 2015 über die Entwicklung von PyTorch bis hin zum ersten Einsatz des KI-Supercomputers von Meta im letzten Jahr – Meta ist derzeit dabei, diese Infrastrukturen weiter zu modernisieren und weiterzuentwickeln.

1. Metas KI-Inferenzbeschleuniger der ersten Generation, 7-nm-Prozess, 102,4TOPS Rechenleistung

MTIA (Meta Training and Inference Accelerator) ist Metas erste firmeneigene Beschleuniger-Chipserie für Inferenz-Workloads.

KI-Workloads sind im Geschäft von Meta allgegenwärtig und bilden die Grundlage für eine Vielzahl von Anwendungsprojekten, darunter Inhaltsverständnis, Informationsfluss, generative KI und Anzeigenranking. Da KI-Modelle immer größer und komplexer werden, müssen die zugrunde liegenden Hardwaresysteme eine exponentielle Steigerung des Speichers und der Rechenleistung ermöglichen und gleichzeitig die Effizienz aufrechterhalten. Meta stellte jedoch fest, dass es für CPUs schwierig war, die für ihre Größenordnung erforderlichen Effizienzniveauanforderungen zu erfüllen, und entwickelte daher Metas selbst entwickelte MTIA-ASIC-Serie mit Trainings- und Inferenzbeschleunigern, um dieser Herausforderung zu begegnen.

Ab 2020 entwickelte Meta den MTIA ASIC der ersten Generation für seine internen Workloads. Der Beschleuniger nutzt den 7-nm-Prozess von TSMC, läuft mit 800 MHz und bietet 102,4TOPS Rechenleistung bei INT8-Präzision und 51,2TFLOPS Rechenleistung bei FP16-Präzision. Seine Thermal Design Power (TDP) beträgt 25 W.

Berichten zufolge bietet MTIA eine höhere Rechenleistung und Effizienz als CPU. Durch den gleichzeitigen Einsatz von MTIA-Chips und GPUs wird eine bessere Leistung, geringere Latenz und eine höhere Effizienz für jede Arbeitslast erzielt.

2. Entwerfen Sie das Rechenzentrum der nächsten Generation und entwickeln Sie den ersten Videotranskodierungs-ASIC

Metas Rechenzentrumsdesign der nächsten Generation wird seine aktuellen Produkte unterstützen und gleichzeitig Training und Inferenz für zukünftige Generationen von KI-Hardware unterstützen. Dieses neue Rechenzentrum wird für KI optimiert und unterstützt flüssigkeitsgekühlte KI-Hardware und ein leistungsstarkes KI-Netzwerk, das Tausende von KI-Chips für KI-Trainingscluster im Rechenzentrumsmaßstab verbindet.

Laut der offiziellen Website wird Metas Rechenzentrum der nächsten Generation auch schneller und kostengünstiger gebaut und durch weitere neue Hardware ergänzt, wie beispielsweise Metas erste intern entwickelte ASIC-Lösung, MSVP, die für die Unterstützung konzipiert ist Metas kontinuierliches Wachstum der Video-Workloads.

Mit dem Aufkommen neuer Technologieinhalte wie generativer KI ist die Nachfrage der Menschen nach Videoinfrastruktur weiter gestiegen, was Meta dazu veranlasst hat, einen skalierbaren Videoprozessor MSVP auf den Markt zu bringen.

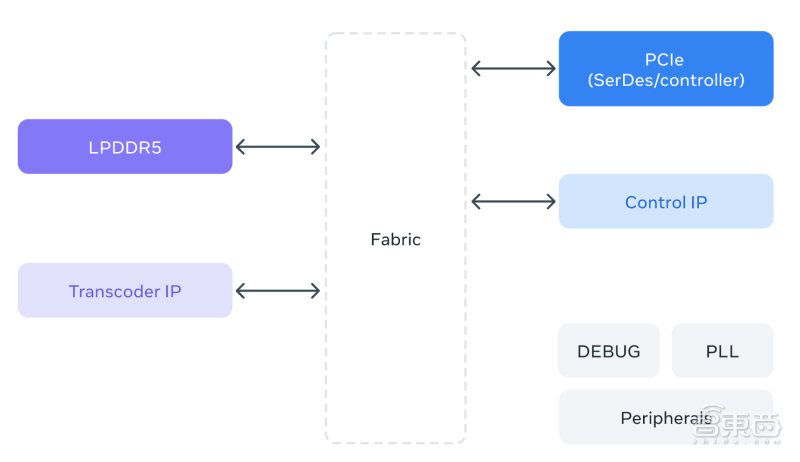

MSVP ist Metas erster selbst entwickelter ASIC für die Videotranskodierung. MSVP ist programmierbar und skalierbar und kann so konfiguriert werden, dass es die für On-Demand erforderliche hochwertige Transkodierung sowie die für Live-Streaming erforderliche geringe Latenz und schnellere Verarbeitungszeiten effizient unterstützt. Zukünftig wird MSVP auch dazu beitragen, jedem Mitglied der Meta-Anwendungsfamilie neue Formen von Videoinhalten bereitzustellen – einschließlich KI-generierter Inhalte sowie VR- (Virtual Reality) und AR- (Augmented Reality) Inhalte.

▲MSVP-Architekturdiagramm

3. KI-Supercomputing integriert 16.000 GPUs und unterstützt große LLaMA-Modelle, um Trainingsiterationen zu beschleunigen

Laut Metas Ankündigung ist sein AI Super Computer (RSC) einer der schnellsten Supercomputer mit künstlicher Intelligenz der Welt. Er soll die nächste Generation groß angelegter KI-Modelle trainieren und neue AR-Tools und Inhaltsverständnis bereitstellen Systeme, Echtzeit-Übersetzungstechnologie usw. liefern Strom.

Meta RSC verfügt über 16.000 GPUs, die alle über eine dreistufige Clos-Netzwerkstruktur zugänglich sind und jedem der 2.000 Trainingssysteme die volle Bandbreite bieten. Im vergangenen Jahr hat das RSC Forschungsprojekte wie LLaMA gefördert.

LLaMA ist ein großes Sprachmodell, das Anfang des Jahres von Meta erstellt und als Open Source bereitgestellt wurde, mit einer Skala von 65 Milliarden Parametern. Laut Meta besteht sein Ziel darin, ein kleineres, leistungsstärkeres Modell bereitzustellen, das Forscher untersuchen und für bestimmte Aufgaben optimieren können, ohne dass erhebliche Hardware erforderlich ist.

Meta trainierte LLaMA 65B und den kleineren LLaMA 33B basierend auf 1,4 Billionen Token. Sein kleinstes Modell, LLaMA 7B, verwendet ebenfalls eine Billion Token für das Training. Durch die Fähigkeit zur skalierten Ausführung kann Meta Trainings- und Optimierungsiterationen beschleunigen und Modelle schneller veröffentlichen als andere Unternehmen.

Fazit: Der Einsatz der Großmodelltechnologie hat große Hersteller gezwungen, den Ausbau der Infrastruktur zu beschleunigen

Meta gestaltet den Großteil seiner Infrastruktur kundenspezifisch, vor allem, weil es dadurch die End-to-End-Erfahrung optimieren kann, von der physischen Ebene über die Softwareebene bis hin zur tatsächlichen Benutzererfahrung. Da der Stapel von oben nach unten gesteuert wird, kann er an Ihre spezifischen Bedürfnisse angepasst werden. Diese Infrastrukturen werden Meta bei der Entwicklung und Bereitstellung größerer und komplexerer KI-Modelle unterstützen.

In den nächsten Jahren werden wir eine zunehmende Spezialisierung und Anpassung im Chipdesign, eine spezialisierte und arbeitslastspezifische KI-Infrastruktur, neue Systeme und Tools sowie eine höhere Effizienz bei der Produkt- und Designunterstützung erleben. Diese werden immer anspruchsvollere Modelle und Produkte liefern, die auf den neuesten Forschungsergebnissen basieren und es Menschen auf der ganzen Welt ermöglichen, diese neue Technologie zu nutzen.

Quelle: Offizielle Meta-Website

Das obige ist der detaillierte Inhalt vonMeta wirft die KI kontinuierlich, um den ultimativen Zug zu beschleunigen! Der erste KI-Inferenzchip, KI-Supercomputer, der speziell für das Training großer Modelle entwickelt wurde. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1664

1664

14

14

1423

1423

52

52

1317

1317

25

25

1268

1268

29

29

1246

1246

24

24

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Metas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

10 generative AI -Codierungsweiterungen im VS -Code, die Sie untersuchen müssen

Apr 13, 2025 am 01:14 AM

Hey da, codieren Ninja! Welche Codierungsaufgaben haben Sie für den Tag geplant? Bevor Sie weiter in diesen Blog eintauchen, möchte ich, dass Sie über all Ihre Coding-Leiden nachdenken-die Auflistung auflisten diese auf. Erledigt? - Lassen Sie ’

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehr

Apr 11, 2025 pm 12:01 PM

AV -Bytes: META ' S Lama 3.2, Googles Gemini 1.5 und mehr

Apr 11, 2025 pm 12:01 PM

Die KI -Landschaft dieser Woche: Ein Wirbelsturm von Fortschritten, ethischen Überlegungen und regulatorischen Debatten. Hauptakteure wie OpenAI, Google, Meta und Microsoft haben einen Strom von Updates veröffentlicht, von bahnbrechenden neuen Modellen bis hin zu entscheidenden Verschiebungen in LE

Verkauf von KI -Strategie an Mitarbeiter: Shopify -CEO Manifesto

Apr 10, 2025 am 11:19 AM

Verkauf von KI -Strategie an Mitarbeiter: Shopify -CEO Manifesto

Apr 10, 2025 am 11:19 AM

Das jüngste Memo von Shopify -CEO Tobi Lütke erklärt kühn für jeden Mitarbeiter eine grundlegende Erwartung und kennzeichnet eine bedeutende kulturelle Veränderung innerhalb des Unternehmens. Dies ist kein flüchtiger Trend; Es ist ein neues operatives Paradigma, das in P integriert ist

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

GPT-4O gegen OpenAI O1: Ist das neue OpenAI-Modell den Hype wert?

Apr 13, 2025 am 10:18 AM

Einführung OpenAI hat sein neues Modell auf der Grundlage der mit Spannung erwarteten „Strawberry“ -Scharchitektur veröffentlicht. Dieses innovative Modell, bekannt als O1

Ein umfassender Leitfaden zu Vision Language Models (VLMs)

Apr 12, 2025 am 11:58 AM

Ein umfassender Leitfaden zu Vision Language Models (VLMs)

Apr 12, 2025 am 11:58 AM

Einführung Stellen Sie sich vor, Sie gehen durch eine Kunstgalerie, umgeben von lebhaften Gemälden und Skulpturen. Was wäre, wenn Sie jedem Stück eine Frage stellen und eine sinnvolle Antwort erhalten könnten? Sie könnten fragen: „Welche Geschichte erzählst du?

3 Methoden zum Ausführen von LLAMA 3.2 - Analytics Vidhya

Apr 11, 2025 am 11:56 AM

3 Methoden zum Ausführen von LLAMA 3.2 - Analytics Vidhya

Apr 11, 2025 am 11:56 AM

METAs Lama 3.2: Ein multimodales KI -Kraftpaket Das neueste multimodale Modell von META, Lama 3.2, stellt einen erheblichen Fortschritt in der KI dar, das ein verbessertes Sprachverständnis, eine verbesserte Genauigkeit und die überlegenen Funktionen der Textgenerierung bietet. Seine Fähigkeit t

Neueste jährliche Zusammenstellung der besten technischen Techniken

Apr 10, 2025 am 11:22 AM

Neueste jährliche Zusammenstellung der besten technischen Techniken

Apr 10, 2025 am 11:22 AM

Für diejenigen unter Ihnen, die in meiner Kolumne neu sein könnten, erforsche ich allgemein die neuesten Fortschritte in der KI auf dem gesamten Vorstand, einschließlich Themen wie verkörpertes KI, KI-Argumentation, High-Tech