Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Python-Programmierung: Neues Verständnis dekoratorbezogener Funktionen

Python-Programmierung: Neues Verständnis dekoratorbezogener Funktionen

Python-Programmierung: Neues Verständnis dekoratorbezogener Funktionen

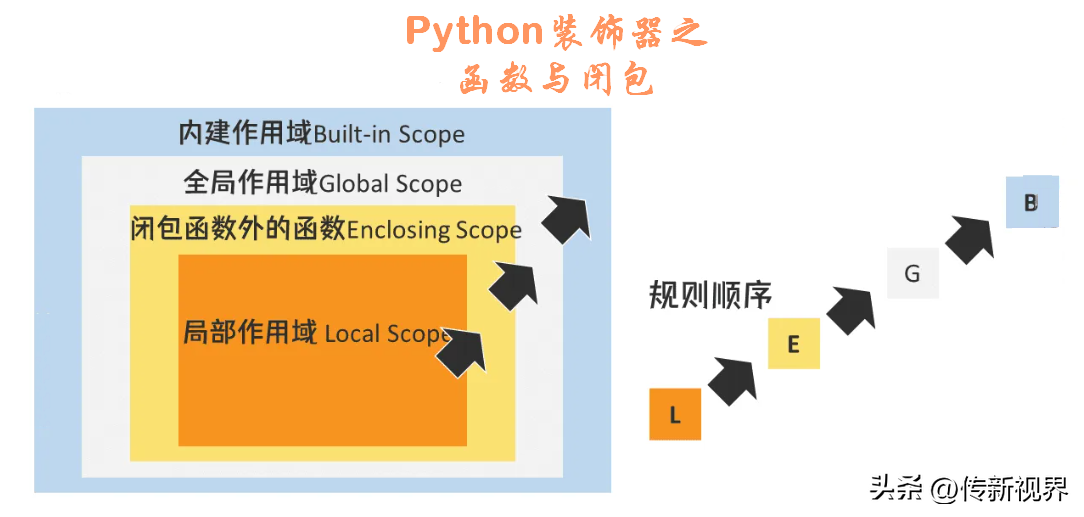

Dekoratoren sind sehr nützliche Werkzeuge in Python. Ein Dekorator ist eine Funktion, die eine andere Funktion als Parameter verwendet und deren Funktionalität erweitert, ohne sie explizit zu ändern. Es ermöglicht uns, das Verhalten einer Funktion oder Klasse zu ändern, ohne deren Quellcode zu berühren.

Mit anderen Worten: Ein Dekorateur umschließt eine Funktion, um ihr Verhalten zu erweitern, anstatt sie dauerhaft zu ändern.

Ab diesem Artikel wollen wir untersuchen, was Dekoratoren sind und wie sie in Python funktionieren.

1.1 Über Funktionen

Um zu verstehen, wie Dekoratoren funktionieren, müssen wir einige wichtige Konzepte zu Funktionen in Python überprüfen. Beachten Sie immer, dass Funktionen in Python erstklassige Bürger sind. Beachten Sie daher die folgenden Konzepte:

- ü Funktionen können regulären Variablen zugewiesen werden.

- ü Funktionen können als Parameter an andere Funktionen übergeben werden Funktionen können Funktionen zurückgeben.

- ü Der Funktionskörper kann andere Funktionen (interne Funktionen) enthalten.

- Schauen wir uns Funktionsbeispiele zu diesen Punkten an.

1.1.1 Beispiel 1: Einer regulären Variablen einen Wert zuweisen

# 把函数赋值给常规变量:

# 定义简单函数

def sayHi(name:str):

return "Hi " + name + "."

#应用:函数赋值给变量

hi = sayHi

print(hi("Solo Cui"))

#输出结果

Hi Solo Cui.1.1.2 Beispiel 2: Funktion als Parameter übergeben

Die Codeliste lautet wie folgt:

# 函数作为参数传递

def printHello(name):

print("Hello,", name)

# 把函数作为参数的函数

def hiWithFunction(func, xname):

func(xname)

#调用以函数为参数的函数

hiWithFunction(printHello,'上官婉儿')1.1.3 Beispiel 3: Funktionen, die Funktionen zurückgeben

Die Codeliste lautet wie folgt:

#示例3:返回函数的函数

def returnXFunction():

return sayHi #示例1中定义的函数,可自行定义其它函数

# 调用函数

xHi = returnXFunction()

print(xHi("BirdMan"))1.1.4 Beispiel 4: Integrierte Funktion im Funktionskörper

Das heißt, eine Funktion innerhalb eines Funktionskörpers definieren. Bitte schauen Sie sich den Code an:

# 示例4:函数体内不含税

def outerXFunction(msg):

'''外部函数'''

#代码...

#定义内嵌函数

def innerXFunc():

'''内部函数'''

print(msg,'来自内嵌函数.')

#函数体内调用内嵌函数

innerXFunc()

#调用外部函数

outerXFunction("火麒麟")Das obige ist der detaillierte Inhalt vonPython-Programmierung: Neues Verständnis dekoratorbezogener Funktionen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

PHP und Python: Code Beispiele und Vergleich

Apr 15, 2025 am 12:07 AM

PHP und Python: Code Beispiele und Vergleich

Apr 15, 2025 am 12:07 AM

PHP und Python haben ihre eigenen Vor- und Nachteile, und die Wahl hängt von den Projektbedürfnissen und persönlichen Vorlieben ab. 1.PHP eignet sich für eine schnelle Entwicklung und Wartung großer Webanwendungen. 2. Python dominiert das Gebiet der Datenwissenschaft und des maschinellen Lernens.

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Effizientes Training von Pytorch -Modellen auf CentOS -Systemen erfordert Schritte, und dieser Artikel bietet detaillierte Anleitungen. 1.. Es wird empfohlen, YUM oder DNF zu verwenden, um Python 3 und Upgrade PIP zu installieren: Sudoyumupdatepython3 (oder sudodnfupdatepython3), PIP3Install-upgradepip. CUDA und CUDNN (GPU -Beschleunigung): Wenn Sie Nvidiagpu verwenden, müssen Sie Cudatool installieren

Python gegen JavaScript: Community, Bibliotheken und Ressourcen

Apr 15, 2025 am 12:16 AM

Python gegen JavaScript: Community, Bibliotheken und Ressourcen

Apr 15, 2025 am 12:16 AM

Python und JavaScript haben ihre eigenen Vor- und Nachteile in Bezug auf Gemeinschaft, Bibliotheken und Ressourcen. 1) Die Python-Community ist freundlich und für Anfänger geeignet, aber die Front-End-Entwicklungsressourcen sind nicht so reich wie JavaScript. 2) Python ist leistungsstark in Bibliotheken für Datenwissenschaft und maschinelles Lernen, während JavaScript in Bibliotheken und Front-End-Entwicklungsbibliotheken und Frameworks besser ist. 3) Beide haben reichhaltige Lernressourcen, aber Python eignet sich zum Beginn der offiziellen Dokumente, während JavaScript mit Mdnwebdocs besser ist. Die Wahl sollte auf Projektbedürfnissen und persönlichen Interessen beruhen.

So wählen Sie die Pytorch -Version unter CentOS aus

Apr 14, 2025 pm 02:51 PM

So wählen Sie die Pytorch -Version unter CentOS aus

Apr 14, 2025 pm 02:51 PM

Bei der Auswahl einer Pytorch -Version unter CentOS müssen die folgenden Schlüsselfaktoren berücksichtigt werden: 1. Cuda -Version Kompatibilität GPU -Unterstützung: Wenn Sie NVIDIA -GPU haben und die GPU -Beschleunigung verwenden möchten, müssen Sie Pytorch auswählen, der die entsprechende CUDA -Version unterstützt. Sie können die CUDA-Version anzeigen, die unterstützt wird, indem Sie den Befehl nvidia-smi ausführen. CPU -Version: Wenn Sie keine GPU haben oder keine GPU verwenden möchten, können Sie eine CPU -Version von Pytorch auswählen. 2. Python Version Pytorch

So machen Sie Datenvorverarbeitung mit Pytorch auf CentOS

Apr 14, 2025 pm 02:15 PM

So machen Sie Datenvorverarbeitung mit Pytorch auf CentOS

Apr 14, 2025 pm 02:15 PM

Effizient verarbeiten Pytorch-Daten zum CentOS-System, die folgenden Schritte sind erforderlich: Abhängigkeit Installation: Aktualisieren Sie zuerst das System und installieren Sie Python3 und PIP: Sudoyumupdate-Judoyuminstallpython3-Tysudoyuminstallpython3-Pip-y, Download und installieren Sie Cudatoolkit und Cudnn-Model von der NVIDIA-offiziellen Website. Konfiguration der virtuellen Umgebung (empfohlen): Verwenden Sie Conda, um eine neue virtuelle Umgebung zu erstellen und zu aktivieren, zum Beispiel: condacreate-n

So installieren Sie Nginx in CentOS

Apr 14, 2025 pm 08:06 PM

So installieren Sie Nginx in CentOS

Apr 14, 2025 pm 08:06 PM

Die Installation von CentOS-Installationen erfordert die folgenden Schritte: Installieren von Abhängigkeiten wie Entwicklungstools, PCRE-Devel und OpenSSL-Devel. Laden Sie das Nginx -Quellcode -Paket herunter, entpacken Sie es, kompilieren Sie es und installieren Sie es und geben Sie den Installationspfad als/usr/local/nginx an. Erstellen Sie NGINX -Benutzer und Benutzergruppen und setzen Sie Berechtigungen. Ändern Sie die Konfigurationsdatei nginx.conf und konfigurieren Sie den Hörport und den Domänennamen/die IP -Adresse. Starten Sie den Nginx -Dienst. Häufige Fehler müssen beachtet werden, z. B. Abhängigkeitsprobleme, Portkonflikte und Konfigurationsdateifehler. Die Leistungsoptimierung muss entsprechend der spezifischen Situation angepasst werden, z. B. das Einschalten des Cache und die Anpassung der Anzahl der Arbeitsprozesse.