Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Metas selbst entwickelter KI-Chip macht Fortschritte: Der erste KI-Chip wird 2025 auf den Markt kommen, außerdem wird es einen Video-KI-Chip geben

Metas selbst entwickelter KI-Chip macht Fortschritte: Der erste KI-Chip wird 2025 auf den Markt kommen, außerdem wird es einen Video-KI-Chip geben

Metas selbst entwickelter KI-Chip macht Fortschritte: Der erste KI-Chip wird 2025 auf den Markt kommen, außerdem wird es einen Video-KI-Chip geben

Nachrichten vom 19. Mai, laut ausländischen Medien Techcrunch, hat die Facebook-Muttergesellschaft Meta heute Morgen in einer Online-Veranstaltung zum ersten Mal den Fortschritt ihres selbst entwickelten KI-Chips bekannt gegeben, der ihr kürzlich eingeführtes Werbedesign und ihre Generierung unterstützen kann KI-Technologie für kreative Werkzeuge.

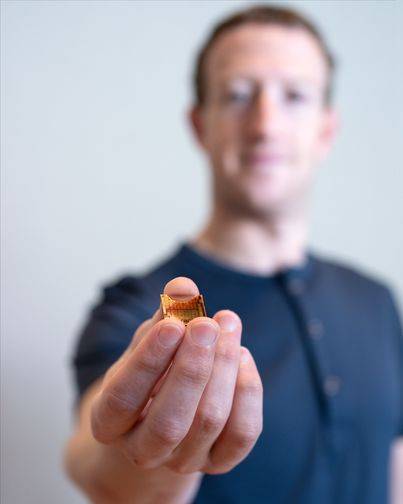

△Meta-CEO Zuckerberg präsentiert den ersten selbst entwickelten KI-Chip MTIA

Meta-Vizepräsident für Infrastruktur Alexis Bjorlin sagte: „Der Aufbau unserer eigenen [Hardware-]Fähigkeiten gibt uns die Kontrolle über jede Ebene des Stacks, vom Rechenzentrumsdesign bis zum Schulungsrahmen. Das ist nötig.“ Dieses Maß an vertikaler Integration kann die Grenzen der Forschung im Bereich der künstlichen Intelligenz in großem Maßstab sprengen.“

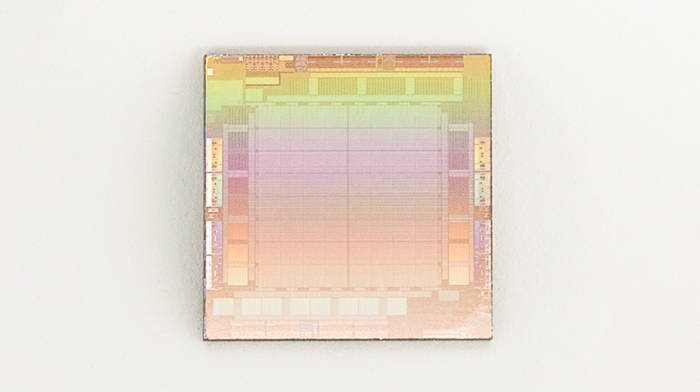

Der erste selbst entwickelte KI-Chip MTIA

Im letzten Jahrzehnt oder so hat Meta Milliarden von Dollar ausgegeben, um Top-Datenwissenschaftler zu rekrutieren und neue Arten künstlicher Intelligenz zu entwickeln, darunter jetzt auch für die Discovery-Engine, Moderationsfilter und Werbeempfehlungen in seinen Apps und Diensten, die auf künstlicher Intelligenz basieren durch den Server. Dieses Unternehmen ist bestrebt, seine vielen ehrgeizigen Innovationen in der KI-Forschung in Produkte umzusetzen, insbesondere im Bereich der generativen KI.Seit 2016 entwickeln führende Internetunternehmen aktiv Cloud-KI-Chips. Google hat selbst entwickelte KI-Chips namens Tensor Processing Units (TPU) entworfen und eingesetzt, um generative KI-Systeme wie PaLM-2, Imagen usw. zu trainieren. Amazon stellt AWS-Kunden zwei selbst entwickelte KI-Chips zur Verfügung: AWS Trainium und AWS Inferentia-Chip zur Anwendung. Gerüchten zufolge arbeitet Microsoft auch mit AMD zusammen, um einen KI-Chip namens Athena zu entwickeln.

Zuvor hatte Meta hauptsächlich eine Kombination aus CPUs von Drittanbietern und benutzerdefinierten Chips verwendet, um KI-Algorithmen für die Ausführung seiner KI-Arbeitslasten zu beschleunigen – CPUs sind bei der Bewältigung solcher Aufgaben tendenziell weniger effizient als GPUs. Um die Situation zu ändern, entwickelte Meta im Jahr 2020 seinen selbst entwickelten KI-Chip MTIA (MTIA v1) der ersten Generation auf Basis des 7-nm-Prozesses.

„Um bei unseren kritischen Arbeitslasten ein höheres Maß an Effizienz und Leistung zu erreichen, brauchten wir eine maßgeschneiderte Lösung, die gemeinsam mit dem Modell, dem Software-Stack und der Systemhardware entwickelt wurde, um unseren Benutzern eine Vielzahl von Diensten zu ermöglichen. Ein besseres Erlebnis.“ Björlin erklärte es.

Laut Einführung wird MTIA v1 im 7-nm-Verfahren hergestellt und sein interner 128-MB-Speicher kann auf bis zu 128 GB erweitert werden. Meta sagte, dass MTIA speziell für Arbeiten im Zusammenhang mit KI-Empfehlungssystemen verwendet werden kann und Benutzern dabei hilft, den besten Beitragsinhalt zu finden und ihn den Benutzern schneller zu präsentieren, und dass seine Rechenleistung und Verarbeitungseffizienz besser als die der CPU sind. Darüber hinaus ist MTIA im Benchmark-Test des Meta-Designs auch bei der Verarbeitung von KI-Modellen mit „niedriger Komplexität“ und „mittlerer Komplexität“ effizienter als die GPU.

Meta sagte, dass in den Speicher- und Netzwerkbereichen der MTIA-Chips noch einiges an Arbeit zu erledigen sei, was mit zunehmender Größe der KI-Modelle zu Engpässen führen werde und eine Verteilung der Arbeitslast auf mehrere Chips erforderlich machen werde. Zu diesem Zweck hat Meta kürzlich das KI-Netzwerktechnologieteam des in Oslo ansässigen britischen Chip-Einhorns Graphcore übernommen. Derzeit konzentriert sich MTIA mehr auf Inferenzfunktionen als auf Trainingsfunktionen für die „empfohlenen Arbeitslasten“ der Meta-Anwendungsfamilie.

Meta betonte, dass es MTIA weiter verbessern und die Effizienz des Unternehmens in Bezug auf die Leistung pro Watt bei der Ausführung der empfohlenen Workloads „dramatisch“ verbessern werde – was Meta wiederum ermöglichen würde, „verbesserte“ und „modernste“ künstliche Intelligenz auszuführen Arbeitsbelastung.

Dem Plan zufolge wird Meta seinen selbst entwickelten MTIA-Chip im Jahr 2025 offiziell auf den Markt bringen.

Metas KI-Supercomputer RSCBerichten zufolge plante Meta ursprünglich, im Jahr 2022 eine groß angelegte Einführung seiner selbst entwickelten maßgeschneiderten KI-Chips zu starten, verzögerte diese jedoch letztendlich und bestellte stattdessen den Supercomputer Research SuperCluster (RSC GPU) von Nvidia im Wert von mehreren Milliarden Dollar , was eine umfassende Neugestaltung seiner zahlreichen Rechenzentren erforderte.

Berichten zufolge debütierte RSC im Januar 2022, wurde in Zusammenarbeit mit Penguin Computing, Nvidia und Pure Storage zusammengestellt und hat die zweite Expansionsphase abgeschlossen. Meta gibt an, dass es jetzt insgesamt 2.000 Nvidia DGX A100-Systeme enthält, die mit 16.000 Nvidia A100-GPUs ausgestattet sind.

Obwohl die aktuelle Rechenleistung von RSC hinter den KI-Supercomputern von Microsoft und Google zurückbleibt. Google behauptet, dass sein KI-fokussierter Supercomputer von 26.000 Nvidia H100-GPUs angetrieben wird. Meta weist darauf hin, dass der Vorteil von RSC darin besteht, dass Forscher damit Modelle anhand tatsächlicher Beispiele aus den Produktionssystemen von Meta trainieren können. Im Gegensatz zur früheren KI-Infrastruktur des Unternehmens, die Open Source und öffentlich verfügbare Datensätze nutzte, ist diese Infrastruktur jetzt verfügbar.

RSC-KI-Supercomputer treiben die KI-Forschung in mehreren Bereichen, einschließlich generativer KI, voran und verschieben die Grenzen der Forschung. „Hier geht es wirklich um die Produktivität der KI-Forschung“, sagte ein Meta-Sprecher. Wir möchten KI-Forschern eine hochmoderne Infrastruktur zur Verfügung stellen, die es ihnen ermöglicht, Modelle zu entwickeln, und ihnen eine Trainingsplattform zur Weiterentwicklung der KI bieten.

Meta behauptet, dass RSC auf seinem Höhepunkt eine Rechenleistung von fast 5 Exaflops erreichen könnte, was es zu einem der schnellsten der Welt macht.

Meta verwendet RSC für das LLaMA-Training, wobei sich RSC auf das Akronym für „Large Scale Language Model Meta Artificial Intelligence“ bezieht. Laut Meta wurde das größte LLaMA-Modell auf 2.048 A100-GPUs trainiert und dauerte 21 Tage.

„Der Aufbau unserer eigenen Supercomputing-Fähigkeiten gibt uns die Kontrolle über jede Ebene des Stacks; vom Rechenzentrumsdesign bis hin zu Trainings-Frameworks“, fügte ein Meta-Sprecher hinzu: „RSC wird den KI-Forschern von Meta helfen, neue und bessere KI-Modelle zu entwickeln, die von Billionen von lernen können.“ Beispiele; Arbeiten Sie in Hunderten von verschiedenen Sprachen zusammen, um neue Augmented-Reality-Tools zu entwickeln

In Zukunft könnte Meta seinen selbst entwickelten KI-Chip MTIA in RSC einführen, um seine KI-Leistung weiter zu verbessern.

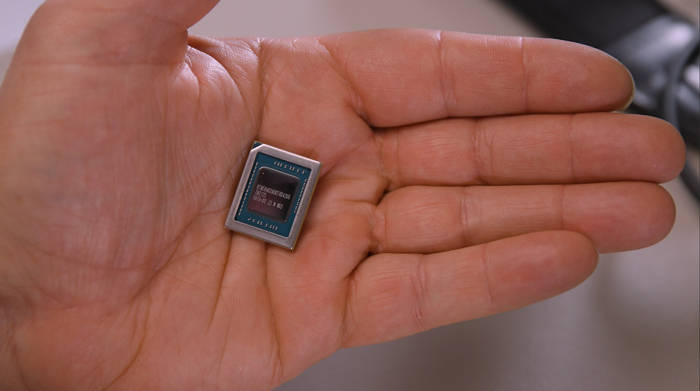

KI-Chip MSVP für die Videoverarbeitung

Neben MTIA entwickelt Meta auch selbst einen weiteren KI-Chip namens Meta Scalable Video Processor (MSVP), der hauptsächlich darauf ausgelegt ist, den wachsenden Datenverarbeitungsanforderungen von Video-on-Demand und Live-Streaming gerecht zu werden Die stabile Verarbeitung von Audio- und Videoinhalten wird von MSVP durchgeführt.Tatsächlich begann Meta vor vielen Jahren mit der Konzeption benutzerdefinierter serverseitiger Videoverarbeitungschips und kündigte 2019 die Einführung von ASICs für Videotranskodierung und Inferenzarbeit an. Dies ist der Höhepunkt einiger dieser Bemühungen und ein neuer Anstoß für Wettbewerbsvorteile. Vor allem im Bereich Live-Video-Streaming.

„Allein auf Facebook verbringen Menschen 50 % ihrer Zeit damit, Videos anzusehen“, schrieben die technischen Direktoren von Meta, Harikrishna Reddy und Yunqing Chen, in einem Blogbeitrag, der am Morgen des 19. veröffentlicht wurde: „Um Menschen auf der ganzen Welt zu bedienen, werden Videos hochgeladen.“ Facebook oder Instagram werden in mehrere Bitströme mit unterschiedlichen Kodierungsformaten, Auflösungen und Qualitäten für verschiedene Geräte (Mobiltelefon, Laptop, Fernseher usw.) transkodiert. MSVP ist programmierbar und skalierbar und kann so konfiguriert werden, dass es die erforderliche hochwertige Transkodierung effizient unterstützt VOD sowie die für Live-Streaming erforderliche geringe Latenz und schnellere Verarbeitungszeiten.“

Meta sagt, sein Plan bestehe darin, die meisten „stabilen und ausgereiften“ Videoverarbeitungs-Workloads irgendwann auf MSVP auszulagern und Software-Videokodierung nur für Workloads zu verwenden, die spezifische Anpassungen und „deutlich“ höhere Qualität erfordern. Laut Meta werden wir die Videoqualität mit MSVP weiter verbessern, indem wir Vorverarbeitungsmethoden wie intelligente Rauschunterdrückung und Bildverbesserung sowie Nachbearbeitungsmethoden wie Artefaktentfernung und Superauflösung einsetzen.

„MSVP wird es uns in Zukunft ermöglichen, mehr der wichtigsten Anwendungsfälle und Bedürfnisse von Meta zu unterstützen, einschließlich Kurzvideos – und so eine effiziente Bereitstellung generativer KI, AR/VR und anderer Metaverse-Inhalte zu ermöglichen“, sagten Reddy und Chen.

Herausgeber: Core Intelligence – Rurouni Sword

Das obige ist der detaillierte Inhalt vonMetas selbst entwickelter KI-Chip macht Fortschritte: Der erste KI-Chip wird 2025 auf den Markt kommen, außerdem wird es einen Video-KI-Chip geben. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Neuer Titel: NVIDIA H200 veröffentlicht: HBM-Kapazität um 76 % erhöht, der leistungsstärkste KI-Chip, der die Leistung großer Modelle deutlich um 90 % verbessert

Nov 14, 2023 pm 03:21 PM

Neuer Titel: NVIDIA H200 veröffentlicht: HBM-Kapazität um 76 % erhöht, der leistungsstärkste KI-Chip, der die Leistung großer Modelle deutlich um 90 % verbessert

Nov 14, 2023 pm 03:21 PM

Laut Nachrichten vom 14. November hat Nvidia auf der „Supercomputing23“-Konferenz am Morgen des 13. Ortszeit offiziell die neue H200-GPU vorgestellt und die GH200-Produktlinie aktualisiert. Darunter basiert der H200 weiterhin auf der bestehenden Hopper H100-Architektur Allerdings wurde mehr Speicher mit hoher Bandbreite (HBM3e) hinzugefügt, um die großen Datenmengen, die für die Entwicklung und Implementierung künstlicher Intelligenz erforderlich sind, besser verarbeiten zu können, wodurch die Gesamtleistung beim Betrieb großer Modelle im Vergleich zur vorherigen Generation H100 um 60 % bis 90 % verbessert wurde . Der aktualisierte GH200 wird auch die nächste Generation von KI-Supercomputern antreiben. Im Jahr 2024 werden mehr als 200 Exaflops KI-Rechenleistung online sein. H200

Gerüchten zufolge hat MediaTek einen Großauftrag von Google für Server-KI-Chips erhalten und wird Hochgeschwindigkeits-Serdes-Chips liefern

Jun 19, 2023 pm 08:23 PM

Gerüchten zufolge hat MediaTek einen Großauftrag von Google für Server-KI-Chips erhalten und wird Hochgeschwindigkeits-Serdes-Chips liefern

Jun 19, 2023 pm 08:23 PM

Berichten vom 19. Juni zufolge hat sich Google (Google) laut Medienberichten in Taiwan an MediaTek gewandt, um bei der Entwicklung des neuesten serverorientierten KI-Chips zusammenzuarbeiten, und plant, ihn für die Gießerei an den 5-nm-Prozess von TSMC zu übergeben um es Anfang nächsten Jahres in Massenproduktion zu bringen. Dem Bericht zufolge enthüllten Quellen, dass diese Zusammenarbeit zwischen Google und MediaTek MediaTek mit Serialisierungs- und Deserialisierungslösungen (SerDes) versorgen und dabei helfen wird, Googles selbst entwickelten Tensorprozessor (TPU) zu integrieren, um Google bei der Entwicklung der neuesten Server-KI-Chips zu unterstützen, die leistungsfähiger sein werden als CPU- oder GPU-Architekturen. Die Branche weist darauf hin, dass viele der aktuellen Dienste von Google mit KI zu tun haben. Sie hat vor vielen Jahren in Deep-Learning-Technologie investiert und festgestellt, dass die Verwendung von GPUs zur Durchführung von KI-Berechnungen sehr teuer ist

Das nächste große Ding in der KI: Spitzenleistung des NVIDIA B100-Chips und des OpenAI GPT-5-Modells

Nov 18, 2023 pm 03:39 PM

Das nächste große Ding in der KI: Spitzenleistung des NVIDIA B100-Chips und des OpenAI GPT-5-Modells

Nov 18, 2023 pm 03:39 PM

Nach dem Debüt des NVIDIA H200, der als der leistungsstärkste KI-Chip der Welt bekannt ist, begann die Branche, sich auf den leistungsstärkeren B100-Chip zu freuen. Gleichzeitig hat OpenAI, das beliebteste KI-Start-up-Unternehmen dieses Jahres, begonnen ein leistungsfähigeres und komplexeres GPT-5-Modell zu entwickeln. Guotai Junan wies im neuesten Forschungsbericht darauf hin, dass die B100 und GPT5 mit grenzenloser Leistung voraussichtlich im Jahr 2024 auf den Markt kommen und die großen Upgrades möglicherweise eine beispiellose Produktivität ermöglichen. Die Agentur erklärte, sie sei optimistisch, dass die KI in eine Phase der schnellen Entwicklung eintreten werde und ihre Sichtbarkeit bis 2024 anhalten werde. Wie leistungsstark sind B100 und GPT-5 im Vergleich zu früheren Produktgenerationen? Nvidia und OpenAI haben bereits eine Vorschau gegeben: B100 könnte mehr als viermal schneller sein als H100, und GPT-5 könnte Super erreichen

Online-Gerüchten zufolge wird vivo ein großes selbst entwickeltes KI-Modell auf den Markt bringen: ähnlich wie Microsoft Copilot

Oct 17, 2023 pm 05:57 PM

Online-Gerüchten zufolge wird vivo ein großes selbst entwickeltes KI-Modell auf den Markt bringen: ähnlich wie Microsoft Copilot

Oct 17, 2023 pm 05:57 PM

Vivo hat offiziell angekündigt, dass es am 1. November 2023 die Entwicklerkonferenz 2023 mit dem Thema „Together Together“ im Shenzhen International Convention and Exhibition Centre abhalten wird. Das Unternehmen wird sein selbst entwickeltes KI-Großmodell und sein selbst entwickeltes Betriebssystem veröffentlichen , und OriginOS4-System. Kürzlich brachte der bekannte digitale Blogger „Digital Chat Station“ die Nachricht, dass das selbst entwickelte KI-Großmodell von vivo auf OriginOS4 gestartet wird, ähnlich wie Microsoft Copilot, mit einem separaten schwebenden Fenster, das aus der Seitenleiste aufgerufen wird, und einem integrierten Modus In den Sprachassistenten ist es nicht dasselbe. Das KI-Datenvolumen und die Systemintegration sind gut gelungen, und alle Mitarbeiter verfügen über ein intelligentes System. Dem Bild nach zu urteilen, wird das von vivo selbst entwickelte KI-Großmodell „JoviCopilot“ heißen. Es wird berichtet, dass JoviCopilot dies kann

Ausführliche Enthüllung: Das Geheimnis hinter Apples eigener Kamera-ISP-Entwicklung!

Nov 11, 2023 pm 02:45 PM

Ausführliche Enthüllung: Das Geheimnis hinter Apples eigener Kamera-ISP-Entwicklung!

Nov 11, 2023 pm 02:45 PM

Laut Nachrichten vom 11. November hat die Autorität auf dem Gebiet der Mobiltelefonchips, @手机 Chip Daren, kürzlich in seinem neuesten Weibo bekannt gegeben, dass Apple bald zwei neue Chips der M3-Serie auf den Markt bringen wird, um seine technische Stärke im Bereich Mobiltelefone weiter zu festigen Gerätechips. Diese beiden Chips werden fortschrittliche 3-nm-Technologie verwenden, um Benutzern eine hervorragende Leistung und Energieeffizienz zu bieten. Details zu diesen beiden Chips sind noch immer rätselhaft. Allerdings heißt der vierte Chip der M3-Serie laut Mobilfunk-Chip-Experten M3 Ultra und wird die fortschrittliche „UltraFusion“-Technologie nutzen. Das Besondere an dieser Technologie ist, dass zwei M3Max-Chips geschickt zusammengefügt werden, um dem Gerät eine höhere Rechenleistung und Verarbeitungsgeschwindigkeit zu verleihen. Was den fünften Kern der M3-Serie betrifft

Kneron bringt den neuesten KI-Chip KL730 auf den Markt, um die groß angelegte Anwendung leichter GPT-Lösungen voranzutreiben

Aug 17, 2023 pm 01:37 PM

Kneron bringt den neuesten KI-Chip KL730 auf den Markt, um die groß angelegte Anwendung leichter GPT-Lösungen voranzutreiben

Aug 17, 2023 pm 01:37 PM

Der Fortschritt des KL730 bei der Energieeffizienz hat den größten Engpass bei der Implementierung von Modellen der künstlichen Intelligenz gelöst – die Energiekosten. Im Vergleich zur Industrie und zu früheren Nerner-Chips ist der KL730-Chip um das Drei- bis Vierfache gestiegen Große Sprachmodelle wie nanoGPT bieten eine effektive Rechenleistung von 0,35 bis 4 Tera pro Sekunde. Das KI-Unternehmen Kneron gab heute die Veröffentlichung des KL730-Chips bekannt, der NPU und Bildsignalverarbeitung (ISP) in Automobilqualität integriert, um sichere und sichere Ergebnisse zu erzielen Niedrigenergie-KI Die Fähigkeiten werden in verschiedenen Anwendungsszenarien wie Edge-Servern, Smart Homes und Fahrzeugassistenzsystemen zum Fahren unterstützt. Das in San Diego ansässige Unternehmen Kneron ist für seine bahnbrechenden Neural Processing Units (NPUs) bekannt und sein neuester Chip, der KL730, hat genau das zum Ziel

NVIDIA bringt neuen KI-Chip H200 auf den Markt, Leistung um 90 % verbessert! Chinas Rechenleistung erreicht unabhängigen Durchbruch!

Nov 14, 2023 pm 05:37 PM

NVIDIA bringt neuen KI-Chip H200 auf den Markt, Leistung um 90 % verbessert! Chinas Rechenleistung erreicht unabhängigen Durchbruch!

Nov 14, 2023 pm 05:37 PM

Während die Welt immer noch von NVIDIA H100-Chips besessen ist und sie verrückt kauft, um die wachsende Nachfrage nach KI-Rechenleistung zu befriedigen, hat NVIDIA am Montag Ortszeit stillschweigend seinen neuesten KI-Chip H200 auf den Markt gebracht, der im Vergleich zu anderen zum Trainieren großer KI-Modelle verwendet wird Die Leistung der Produkte der Vorgängergeneration H100 und H200 wurde um etwa 60 % bis 90 % verbessert. H200 ist eine aktualisierte Version von Nvidia H100. Es basiert ebenfalls auf der Hopper-Architektur. Das Haupt-Upgrade umfasst 141 GB HBM3e-Videospeicher und die Videospeicherbandbreite wurde von 3,35 TB/s bei H100 erhöht. Laut der offiziellen Website von Nvidia ist der H200 auch der erste Chip des Unternehmens, der HBM3e-Speicher verwendet. Dieser Speicher ist schneller und hat eine größere Kapazität, sodass er besser für große Sprachen geeignet ist.

Kneron kündigt die Einführung seines neuesten KI-Chips KL730 an

Aug 17, 2023 am 10:09 AM

Kneron kündigt die Einführung seines neuesten KI-Chips KL730 an

Aug 17, 2023 am 10:09 AM

Den ursprünglichen Worten zufolge kann es wie folgt umgeschrieben werden: (Global TMT 16. August 2023) Das KI-Unternehmen Kneron mit Hauptsitz in San Diego und bekannt für seine bahnbrechenden Neural Processing Units (NPU) kündigte die Veröffentlichung des KL730-Chips an. Der Chip integriert NPU und Bildsignalverarbeitung (ISP) in Automobilqualität und bietet sichere und energiesparende KI-Funktionen für verschiedene Anwendungsszenarien wie Edge-Server, Smart Homes und Systeme für unterstütztes Fahren in der Automobilindustrie Im Hinblick auf die Energieeffizienz ist die Energieeffizienz im Vergleich zu früheren Nerner-Chips um das Drei- bis Vierfache gestiegen und liegt um 150 bis 200 % höher als bei ähnlichen Produkten in großen Industriezweigen. Der Chip verfügt über eine effektive Rechenleistung von 0,35 bis 4 Tera pro Sekunde und kann das fortschrittlichste leichte GPT Large unterstützen