Im März dieses Jahres änderte der „Silicon Valley Knife King“ angesichts des wachsenden KI-Trends seine japanische Einstellung und ergriff die Initiative, trat auf die Bühne und kündigte den Start von DGX Cloud an, bei dem KI-spezifische GPUs zum Einsatz kamen die Cloud für „Miete“.

In der Vergangenheit waren Cloud-Computing-Unternehmen für den Verkauf von Rechenleistung verantwortlich. Sie kaufen mehrere Modelle von Grafikkarten und Beschleunigern für künstliche Intelligenz, bepreisen sie basierend auf der Hardwareleistung oder der Nutzungsdauer und vermieten sie dann an nachgelagerte Kunden.

In diesem Prozess verkauft NVIDIA GPUs entweder an Cloud-Computing-Plattformen oder direkt an KI-Unternehmen. Der erste NVIDIA DGX-Supercomputer wurde beispielsweise 2016 von Huang persönlich an OpenAI geliefert. Es wurde höchstens Rechenleistung verkauft „Schaufelverkäufer“.

Was die Verlagerung von DGX in die Cloud betrifft, so muss NVIDIA es zwar immer noch auf der Cloud-Plattform hosten, es hat jedoch im Wesentlichen die Grenze überschritten.

Nvidia, das immer hinter den Kulissen war, warum kam es dieses Mal an die Front?

NVIDIA ist zweifellos der größte Nutznießer dieser Runde des KI-Booms, vielleicht sogar keiner.

Der Preis für GPU-Chips, die zum Trainieren von KI verwendet werden, ist in die Höhe geschossen. Die Preise für A100 und H100 pro Chip sind auf 15.000 US-Dollar bzw. 40.000 US-Dollar gestiegen. Der Preis für einen inländischen KI-Server, der mit 8 A100 und 80G-Speicherplatz ausgestattet ist, ist ebenfalls gestiegen Von Mitte letzten Jahres stiegen die 80.000/Einheit auf aktuell 1,65 Millionen/Einheit.

Aber nicht das ganze Geld ist in die Taschen von NVIDIA geflossen und die Prämie wurde von den Kanälen weggenommen. Der Schlüssel ist, dass es keine Möglichkeit gibt, NVIDIA zu kaufen und zu verkaufen.

DGX Cloud ist in dieser Situation entstanden und der Schlüsselpreis scheint sehr günstig zu sein. Für die mit 8 H100-GPU-Modulen ausgestattete DGX Cloud beträgt die monatliche Paketgebühr nur 37.000 US-Dollar, was dem Preis eines einzelnen H100 entspricht.

Für KI-Unternehmen, die dringend Rechenleistung und Geld benötigen, aber überfordert sind, ist DGX Cloud zweifellos ein Kissen, das vom Himmel fällt, wenn sie müde sind. Für NVIDIA kann der Verkauf von Cloud-Computing-Leistung nicht nur Geld verdienen, sondern auch binden Kunden.

Aber hinter der scheinbaren Win-Win-Situation verbirgt sich ein geheimer Krieg, der mit der KI beginnt.

Gleichheit der Rechenleistung

Aus Sicht der Branchenmerkmale ist das heutige AIGC, das auf Cloud-Computing-Leistung basiert, dem Krypto-Asset-Mining der Vergangenheit sehr ähnlich, der Ressourcenbedarf ist jedoch viel höher als bei letzterem.

Guosheng Securities hat einmal in „The Evolution of AIGC Computing Power from a Web3 Perspective“ die Gemeinsamkeiten und Unterschiede zwischen Krypto-Asset-Mining und der AIGC-Branche verglichen:

1 Der Stromverbrauch der AIGC-Industrie wird in etwa 1,6 bis 7,5 Jahren den aktuellen Stromverbrauch der Bitcoin-Mining-Industrie übersteigen. Der Hauptantriebsfaktor ist das schnelle Wachstum der großen GPT-Sprachmodelle in Bezug auf Modellparameter, tägliche Aktivität und Anzahl der Modelle ;

2 Ähnlich wie beim Bitcoin-Mining stehen die durch Rechenleistung getriebenen Inhalte in der AIGC-Branche in einem intensiven Wettbewerb. Nur durch die kontinuierliche und schnelle Produktion hochwertiger Inhalte können die Teilnehmer sicherstellen, dass die Aufmerksamkeit der Benutzer nicht nachlässt.

Dies führt zu zwei Hauptmerkmalen der AIGC-Branche: hohe Kosten und Nachhaltigkeit.

Dabei ist die Kostenseite mehr als nur der Stromverbrauch. Natürlich kann der Stromverbrauch als sehr intuitiver Beweis herangezogen werden. Beispielsweise verbraucht das Supercomputing-Zentrum Yangquan, das von Baidu zum Trainieren von Schlussfolgerungen Wen Xinyiyan verwendet wird, 64.000 kWh (Grad) pro Stunde. Gemäß dem kommerziellen Stromverbrauchsstandard von 0,45 Yuan/kWh beträgt die jährliche Stromrechnung 250 Millionen.

Die höheren Kosten entstehen durch die Investition in Rechenleistung.

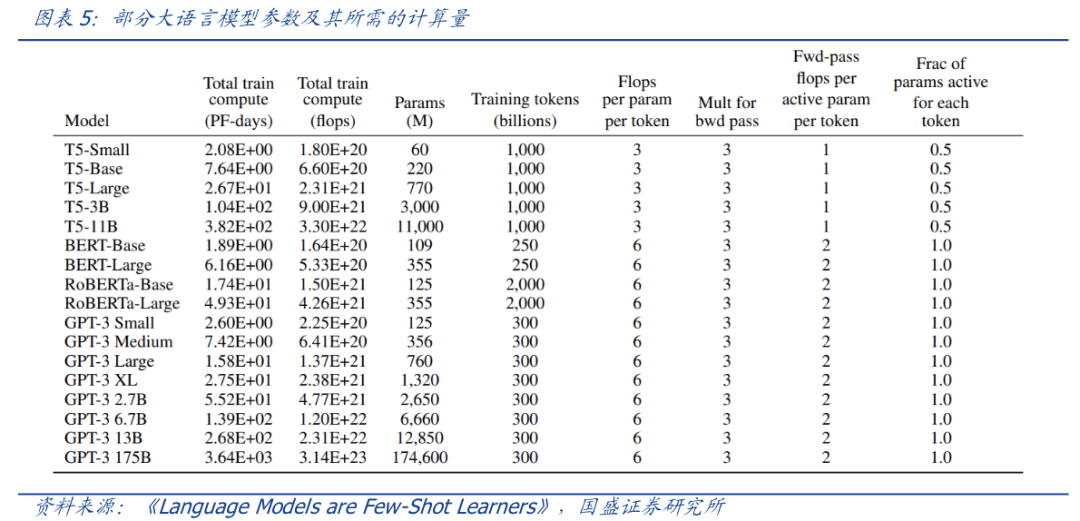

Nehmen Sie ChatGPT als Beispiel. Die für den Inferenzprozess erforderliche Rechenleistung wird nicht berücksichtigt. Berechnungen zufolge ist ein Training von GPT-3 erforderlich Ungefähr 6.000 Nvidia A100-Grafikkarten werden benötigt, wenn man den Verbindungsverlust berücksichtigt.

Basierend auf 100.000 Yuan für einen einzelnen A100-Chip erfordert eine groß angelegte Schulung eine Investition von etwa 1 Milliarde, was für normale Hersteller einfach unerschwinglich ist. Die Modellparameter von GPT-4 sind größer, es gibt mehr Identifikatoren für das Training und die erforderliche Rechenleistung ist beträchtlicher.

Und mit der Veröffentlichung weiterer großer AIGC-Modelle ist die erforderliche Rechenleistung sprunghaft angestiegen.

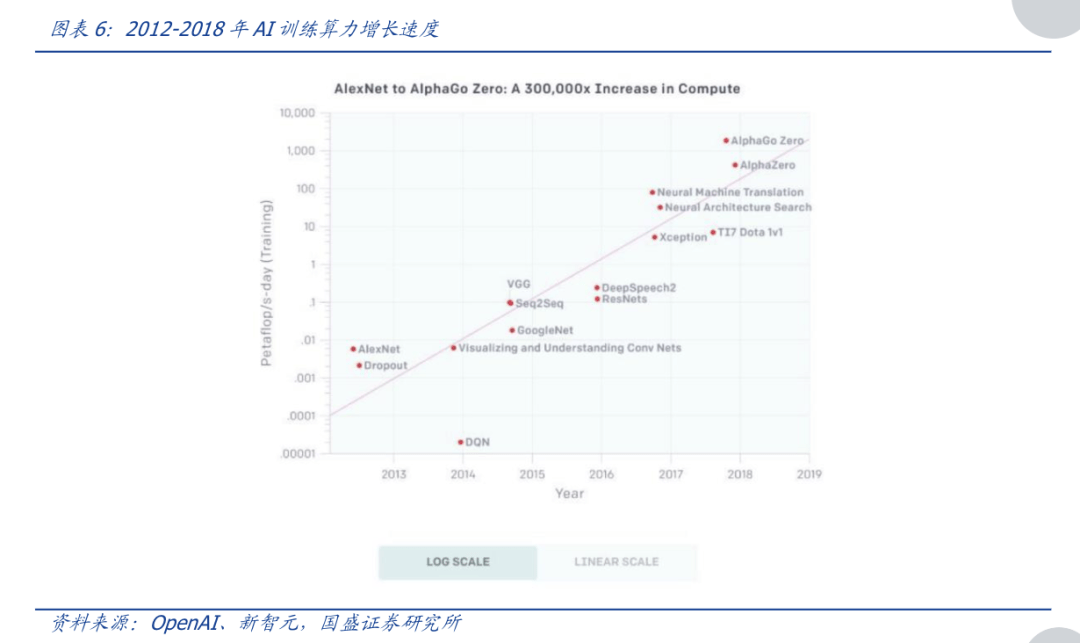

Laut den Berechnungen von OpenAI verdoppelte sich von 2012 bis 2018 die zum Training von KI erforderliche Rechenleistung etwa alle 3–4 Monate, wobei sich die Rechenleistung insgesamt um das 300.000-fache erhöhte (während sich das Mooresche Gesetz im gleichen Zeitraum nur um das Siebenfache erhöhte). Der für Kopftrainingsmodelle erforderliche Aufwand steigt jedes Jahr um das Zehnfache, und der Gesamtanstieg ist exponentiell.

Zu diesem Zeitpunkt kommen die Vorteile der Cloud-Computing-Leistung zum Ausdruck. Sie können in 8 Worten zusammengefasst werden: Teilen Sie es in Teile auf und zahlen Sie nach Bedarf.

Mit der Cloud-Computing-Leistung können große AIGC-Modellhersteller die von der Cloud-Computing-Power-Plattform bereitgestellte Rechenleistung bei Bedarf direkt mieten, ohne Hardware wie NVIDIA A100-Grafikkarten kaufen zu müssen. Dadurch können auch Start-ups oder nicht führende Modellhersteller versuchen, einzusteigen das AIGC-Feld.

Selbst dieser Ansatz „in Teile zerlegen“ ist für alle Parteien in der Industriekette von Vorteil:

1) Upstream-Hersteller von Rechenleistung können, wenn Rechenleistungshardware in die Nebensaison eintritt und die Lagerbestände steigen, die Einkommensschwankungen durch den Verkauf von Cloud-Rechenleistung ausgleichen, „lebenden“ Strom für die Hochsaison reservieren und die Nachfrage kurzfristig decken rechtzeitig Erholung der Marktnachfrage

2) Für Midstream-Cloud-Dienstleister wird es dazu beitragen, den Kundenstrom zu erhöhen

3) Für nachgelagerte Nachfrager nach Rechenleistung kann es die Schwelle für die Nutzung von Rechenleistung minimieren und den Beginn der AIGC-Ära für alle vorantreiben.

Wenn die großen AIGC-Modellhersteller bereit sind, mehr Ressourcen zu übertragen, können sie auch tiefer mit der Cloud-Plattform zusammenarbeiten. Ein typischer Fall hierfür ist die Zusammenarbeit zwischen Microsoft Cloud und OpenAI. Die Zusammenarbeit zwischen beiden endet nicht bei der Anmietung von Rechenleistung, sondern geht tief in die Integration von Eigenkapital und Produkten.

Darüber hinaus fallen bei großen Modellwettbewerben neben den offensichtlichen Hardware-Investitionskosten auch unsichtbare Zeitkosten an.

Im Allgemeinen sind die Anforderungen an die Rechenleistung großer Modelle in zwei Phasen unterteilt: Der Prozess des Trainierens eines großen Modells ähnelt dem von ChatGPT.

Und je länger dieser Prozess andauert, desto besser für größere Modelle. Wenn wir uns nun NVIDIA DGX Cloud ansehen, ist es nicht schwer zu verstehen, was Lao Huang getan hat.

Mit der Cloud-Methode den Preis von GPUs für das KI-Training senken, kleine und mittlere Unternehmen mit gleichberechtigtem Zugriff auf Rechenleistung überzeugen und dann Kunden binden, basierend auf dem Nachhaltigkeitsfaktor des großen Modelltrainings, dem „Silicon Valley“. „Sword King“ schlägt zwei Fliegen mit einer Klappe.

Es ist möglicherweise nicht NVIDIA, das davon profitiert

Seit Dezember letzten Jahres ist der Preis für Nvidia A100 in fünf Monaten um 37,5 % gestiegen, und der Preis für A800 ist im gleichen Zeitraum um 20,0 % gestiegen.

Der explodierende Preis von GPUs hat zweifellos die Schwelle für AIGC erhöht, große Modelle zu trainieren, aber für führende Hersteller müssen sie unabhängig von der Preiserhöhung GPUs kaufen. Doch wenn der Preis nicht steigt, können sie sich vielleicht auf die 50 Millionen US-Dollar verlassen, die Wang Huiwen für die Gründung seines Unternehmens erhalten hat Sie können sogar alle für das Training benötigten Grafikkarten kaufen.

Als Lao Huang zu diesem Zeitpunkt DGX Cloud herausbrachte, war das, als würde man eine Luxusautovermietung eröffnen, damit auch Leute, die es sich nicht leisten können, es mieten können.

Dahinter steht natürlich auch die Überlegung, der Konkurrenz einen Schritt voraus zu sein und mehr kleine und mittelständische Kunden zu binden.

Zusätzlich zu OpenAI sind Midjourney und Authropic die KI-Unternehmen, die in dieser Runde des KI-Wahnsinns am meisten aus dem Kreis geraten sind. Ersteres ist eine KI-Zeichenanwendung, die kürzlich in Zusammenarbeit mit dem QQ-Kanal das Inlandsgeschäft gestartet hat. Der Gründer des letzteren kommt von OpenAI, und sein Konversationsroboter Claude testet ChatGPT direkt.

Die beiden Unternehmen haben eines gemeinsam: Sie kauften keine Nvidia-GPUs, um Supercomputer zu bauen, sondern nutzten stattdessen die Rechendienste von Google.

Dieser Dienst wird von einem Supercomputing-System bereitgestellt, das 4096 TPU v4 integriert und sich auf Googles eigene Forschung konzentriert.

Ein weiterer Riese, der sich mit selbst entwickelten Chips beschäftigt, ist Microsoft, der Anführer dieser KI-Welle. Es wird gemunkelt, dass dieser Chip namens Athena einen fortschrittlichen 5-nm-Prozess verwendet und von TSMC hergestellt wird. Die Anzahl der Forschungs- und Entwicklungsteams beträgt fast 300 Personen.

Das Ziel dieses Chips besteht offensichtlich darin, den teuren A100/H100 zu ersetzen, eine Rechenleistungs-Engine für OpenAI bereitzustellen und schließlich Nvidias Kuchen über den Cloud-Dienst Azure von Microsoft zu erobern.

Neben der Hinterlist der Cloud-Computing-Unternehmen will auch Nvidias Großkunde Tesla einen Alleingang antreten.

Im August 2021 zeigte Musk der Außenwelt den Supercomputing-Dojo ExaPOD, der mit 3.000 seiner eigenen D1-Chips gebaut wurde. Unter anderem wird der D1-Chip von TSMC hergestellt und verwendet einen 7-nm-Prozess. 3.000 D1-Chips machen Dojo gemessen an der Rechenleistung direkt zum fünftgrößten Computer der Welt.

Im Vergleich dazu haben inländische Unternehmen, die vom Verbot betroffen sind, zwar auch alternative Pläne, sind jedoch kurzfristig immer noch stark auf Nvidia angewiesen.

Inländische Chips können Cloud-Inferenzarbeiten durchführen, die keine so hohe Informationsgranularität erfordern, aber die meisten von ihnen sind derzeit nicht in der Lage, Cloud-Training zu bewältigen, das eine extrem hohe Rechenleistung erfordert.

Suiyuan Technology, Biren Technology, Tianshu Zhixin, Cambrian und andere Unternehmen haben ihre eigenen Cloud-Produkte auf den Markt gebracht, und die theoretischen Leistungsindikatoren sind nicht schwach.

Nach zuvor offengelegten Informationen nutzt das von Baidu zum Trainieren der Inferenz Wen Xinyiyan genutzte Yangquan-Supercomputerzentrum neben dem A100 auch einige inländische Produkte, wie den selbst entwickelten Kunlun-Kern von Baidu und den Siyuan 590 von Cambrian, darunter News zeigt, dass Siyuan macht etwa 10–20 % des Beschaffungsplans 2023 aus.

Unter anderem stammen die Chip-Layer-Kernfunktionen von Wen INT8 und Die Rechenleistung von 128 TFLOPS@FP16 ist 2-3 mal höher als die der vorherigen Generation.

Im März dieses Jahres teilte Robin Li auch auf dem Yabuli China Entrepreneur Forum mit, dass Kunlun-Chips jetzt sehr gut für große Modellinferenzen geeignet sind und in Zukunft für das Training geeignet sein werden.

Epilog

Ab RIVA128 hat NVIDIA seine erstaunlichen Marktbeobachtungsfähigkeiten unter Beweis gestellt. Im letzten Jahrzehnt oder so, vom Kryptowährungs-Mining über das Metaverse bis hin zum KI-Boom, hat NVIDIA den Trend genutzt und seine Grafikkartenkunden von Gamern zu Technologiegiganten erweitert.

Während sich der Krieg ausweitete, stieg auch der Marktwert von Nvidia, von einem zweitrangigen Chipunternehmen zur Nr. 1 in der gesamten Branche. Huang Renxun sagte jedoch, dass der Moment des KI-iPhone gekommen sei. Wie kann Nvidia also unbesiegbar sein, selbst wenn Nokia von Apple besiegt wurde?

Referenzen

[1] AIGCs Long-Option: KI-Cloud-Computing-Leistung, Guosheng Securities

[2] AIGC-Rechenleistungsentwicklungstheorie aus der Sicht von Web3, Guosheng Securities

[3] Ein Crack im NVIDIA-Imperium, Yuanchuan Research Institute

[4] Cloud-Computing-Power-Mining ist derzeit möglicherweise der stabilste Weg, um in Bitcoin einzusteigen, Odaily Planet Daily

[5] Experteninterpretation von Baidus „Wen Xin Yi Yan“, Unicorn Think Tank

[6] Im Zeitalter großer Modelle beschleunigen heimische GPUs „wild“ und das digitale Zeitalter boomt

[7] NVIDIA Jensen Huang: KI-Supercomputing-Funktionen werden von chinesischen Cloud-Dienstleistern bereitgestellt, und das KI-iPhone kommt! Wirtschaftsnachrichten aus China

[8] Überblick über die Industriekette der KI-Rechenleistung: Technologieiteration fördert Durchbrüche bei Engpässen, und die Zunahme von AIgc-Szenarien treibt die Nachfrage nach Rechenleistung an, Essence Securities

Das obige ist der detaillierte Inhalt vonJenseits der Cloud-Computing-Leistung beginnt ein geheimer Krieg mit der KI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Lernen Sie C# von Grund auf

Lernen Sie C# von Grund auf

So lösen Sie verstümmelte Filezilla-Zeichen

So lösen Sie verstümmelte Filezilla-Zeichen

So aktivieren Sie die gleiche Stadtfunktion auf Douyin

So aktivieren Sie die gleiche Stadtfunktion auf Douyin

Verlauf der Oracle-Ansichtstabellenoperationen

Verlauf der Oracle-Ansichtstabellenoperationen

Douyin-Level-Preisliste 1-75

Douyin-Level-Preisliste 1-75

So summieren Sie dreidimensionale Arrays in PHP

So summieren Sie dreidimensionale Arrays in PHP

Methode zur Registrierung eines Google-Kontos

Methode zur Registrierung eines Google-Kontos

So lesen Sie Dateien und konvertieren sie in Java in Strings

So lesen Sie Dateien und konvertieren sie in Java in Strings

Die Rolle des Linux-Betriebssystems

Die Rolle des Linux-Betriebssystems