Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Endlich hat jemand die aktuelle Situation von GPT klargestellt! Die neueste Rede von OpenAI ging viral und es muss sich um ein von Musk handverlesenes Genie handeln

Endlich hat jemand die aktuelle Situation von GPT klargestellt! Die neueste Rede von OpenAI ging viral und es muss sich um ein von Musk handverlesenes Genie handeln

Endlich hat jemand die aktuelle Situation von GPT klargestellt! Die neueste Rede von OpenAI ging viral und es muss sich um ein von Musk handverlesenes Genie handeln

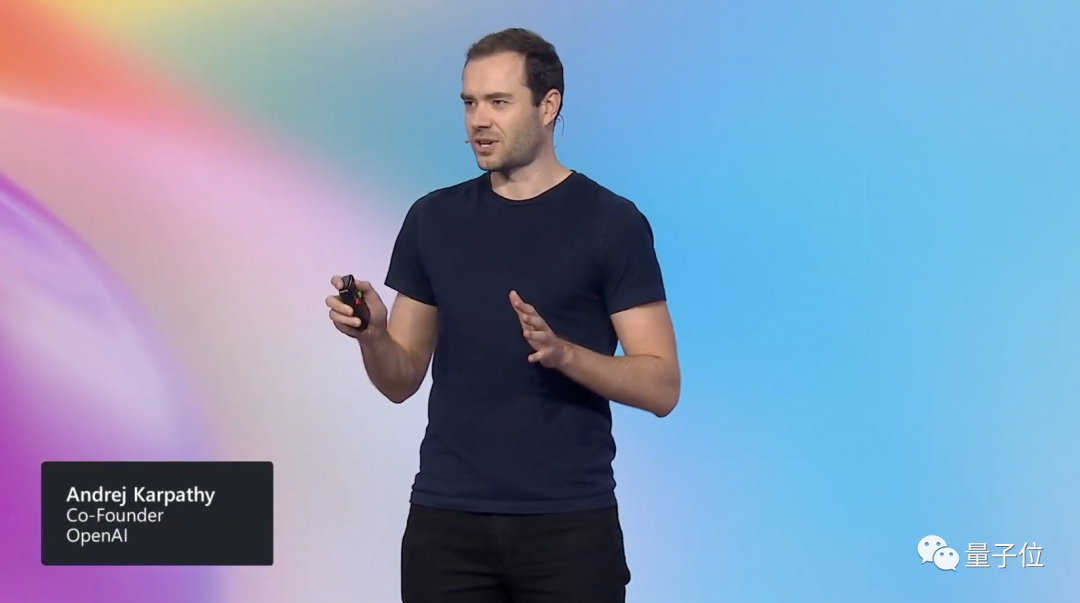

Nach der Veröffentlichung von Windows Copilot wurde die Popularität der Microsoft Build-Konferenz durch eine Rede entfacht.

Der frühere KI-Direktor von Tesla, Andrej Karpathy, glaubte in seiner Rede, dass der „Gedankenbaum“ der „Monte Carlo Tree Search (MCTS)“ von AlphaGo ähnelt! Netizens riefen: Dies ist die detaillierteste und interessanteste Anleitung zur Verwendung großer Sprachmodelle und GPT-4-Modelle!

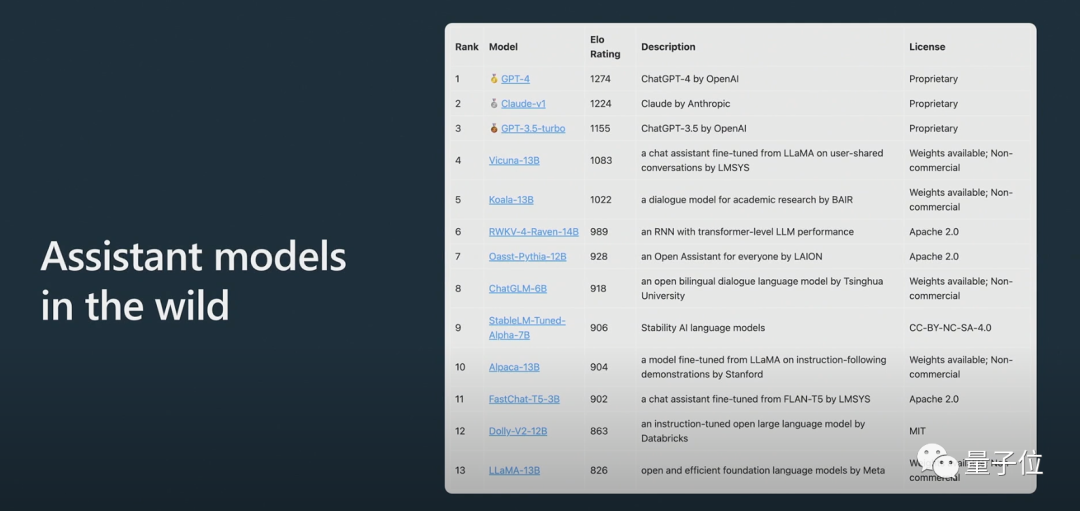

Darüber hinaus enthüllte Karpathy, dass LLAMA 65B aufgrund von Training und Datenerweiterung „deutlich leistungsfähiger als GPT-3 175B“ ist, und stellte die große anonyme Arena ChatBot Arena vor:

Internetnutzer sagten, dass Karpathys Reden immer großartig seien und der Inhalt dieses Mal wie immer nicht alle enttäuscht habe.

Also, dieser Absatz ist vorbereitet Wurde in der Rede ein bestimmter Inhalt erwähnt, der viel Aufmerksamkeit erregte?

Karpathys Rede ist dieses Mal hauptsächlich in zwei Teile gegliedert.

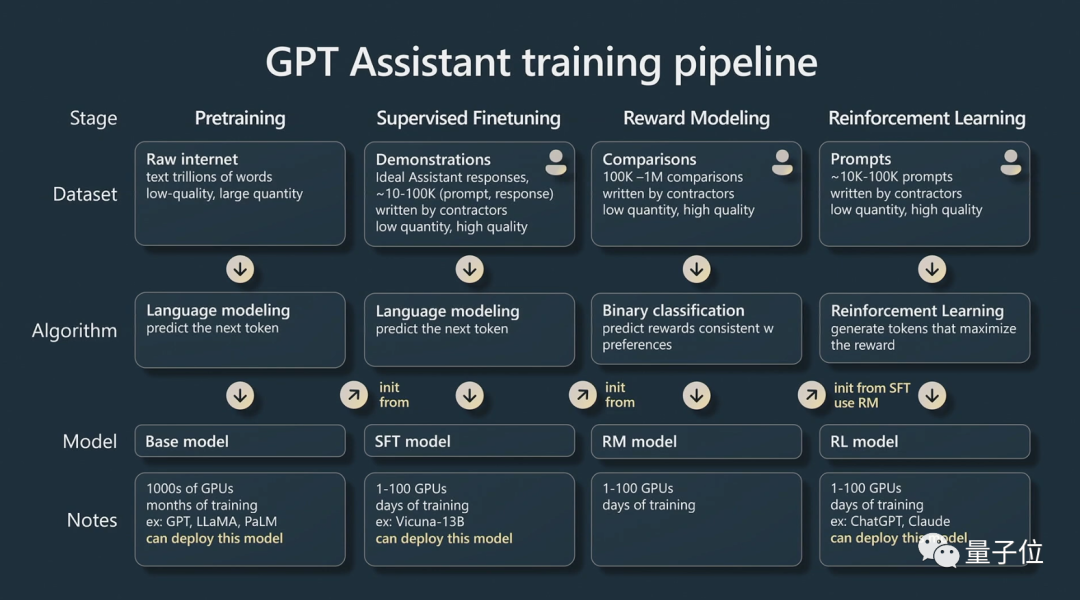

Teil 1, er sprach darüber, wie man einen „GPT-Assistenten“ ausbildet.

Karpathy spricht hauptsächlich über die vier Trainingsphasen des KI-Assistenten: Vortraining, überwachte Feinabstimmung, Belohnungsmodellierung und verstärkendes Lernen.

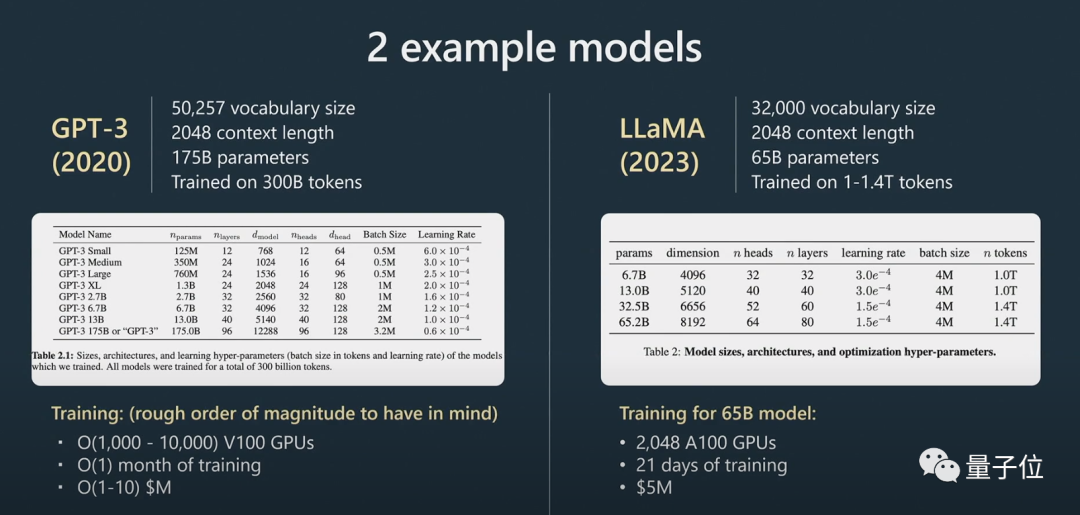

Jede Phase erfordert einen Datensatz.In der Phase vor dem Training müssen große Mengen an Rechenressourcen verwendet werden, um eine große Anzahl von Datensätzen zu sammeln. Ein Basismodell wird anhand eines großen unbeaufsichtigten Datensatzes trainiert.

Dann kommen wir in die Feinabstimmungsphase.

zu erstellen, das die Frage beantworten kann.

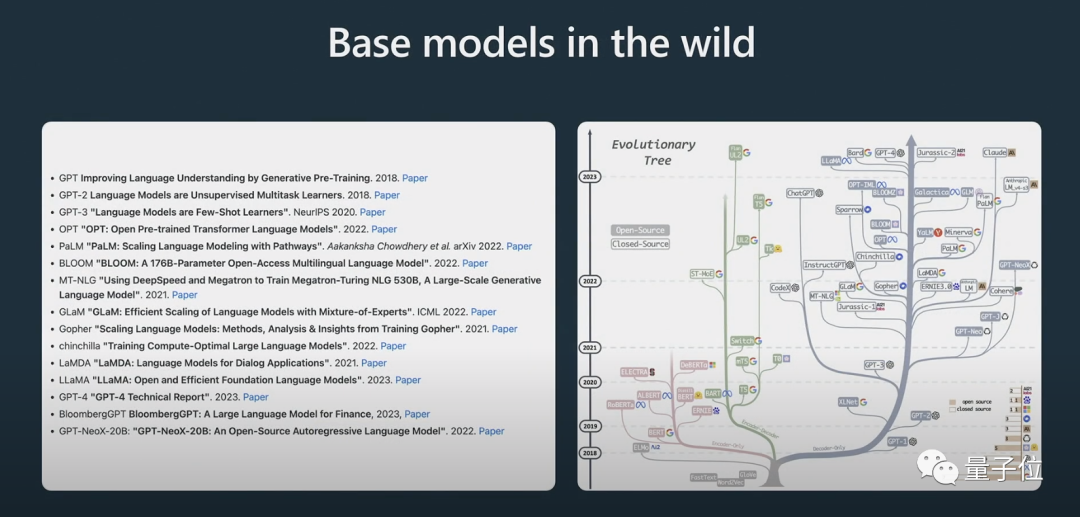

Er zeigte auch den Evolutionsprozess einiger Modelle. Ich glaube, viele Menschen haben das obige „Evolutionsbaum“-Bild schon einmal gesehen.

Hier muss klar darauf hingewiesen werden, dass es sich beim

handelt.

Obwohl das Basismodell in der Lage ist, das Problem zu lösen, sind die Antworten, die es gibt, nicht vertrauenswürdig, während das Assistentenmodell zuverlässige Antworten liefern kann. Das überwachte, fein abgestimmte Assistentenmodell wird auf der Grundlage des Basismodells trainiert und seine Leistung beim Generieren von Antworten und beim Verstehen der Textstruktur ist besser als die des Basismodells. Bestärkendes Lernen ist ein weiterer wichtiger Prozess beim Training von Sprachmodellen.

Während des Trainingsprozesses werden hochwertige, manuell kommentierte Daten verwendet und eine Verlustfunktion wird in Form einer Belohnungsmodellierung erstellt, um die Leistung zu verbessern. Ein Verstärkungstraining kann erreicht werden, indem die Wahrscheinlichkeit einer positiven Bewertung erhöht und die Wahrscheinlichkeit einer negativen Bewertung verringert wird.

Menschliches Urteilsvermögen ist entscheidend für die Verbesserung von KI-Modellen, wenn es um kreative Aufgaben geht, und Modelle können durch die Einbeziehung menschlichen Feedbacks effektiver trainiert werden.

Nach dem verstärkenden Lernen mit menschlichem Feedback kann ein RLHF-Modell erhalten werden.

Nachdem die Modelle trainiert wurden, besteht der nächste Schritt darin, diese Modelle effektiv zur Lösung von Problemen einzusetzen.

Wie kann man Modelle besser nutzen?

In Teil 2 spricht Karpathy über Anstoßstrategien, Feinabstimmung, das sich schnell entwickelnde Tool-Ökosystem und zukünftige Erweiterungen.

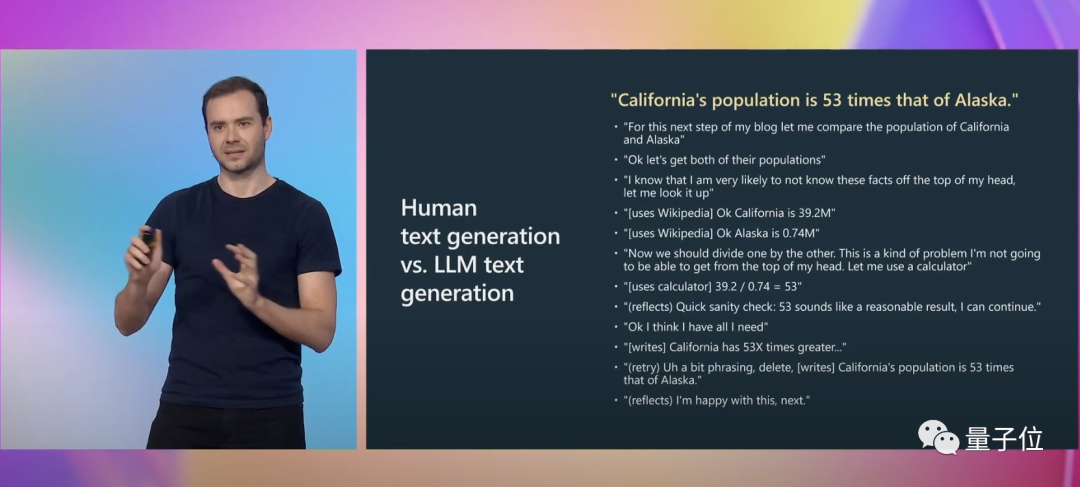

Karpathy gab zur Veranschaulichung ein weiteres konkretes Beispiel:

Beim Schreiben müssen wir viele mentale Aktivitäten ausführen, einschließlich der Überlegung, ob unser Ausdruck korrekt ist. Für GPT ist dies lediglich eine Folge von markierten Token.

Und prompt kann diese kognitive Lücke ausgleichen.

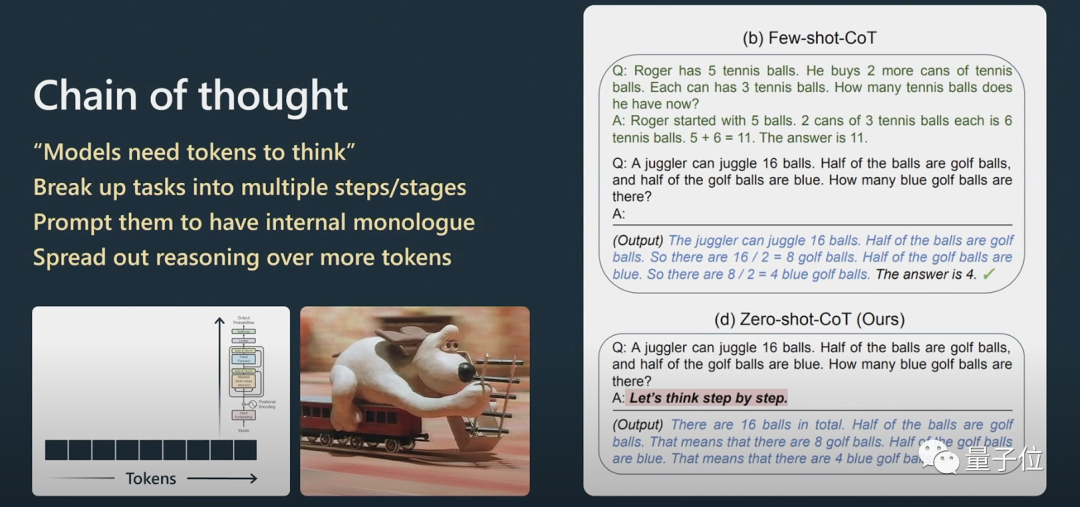

Karpathy erklärt weiter, wie die Aufforderungen der Gedankenkette funktionieren.

Wenn Sie bei Argumentationsproblemen möchten, dass Transformer bei der Verarbeitung natürlicher Sprache eine bessere Leistung erbringt, müssen Sie ihn die Informationen Schritt für Schritt verarbeiten lassen, anstatt sie direkt einem sehr komplexen Problem zu stellen.

Wenn Sie ihm ein paar Beispiele geben, wird die Vorlage dieses Beispiels nachgeahmt und das Endergebnis wird besser sein.

Das Modell kann Fragen nur entsprechend seiner Reihenfolge beantworten. Wenn der von ihm generierte Inhalt falsch ist, können Sie ihn dazu auffordern und ihn neu generieren lassen.

Wenn Sie es nicht zur Überprüfung auffordern, wird es sich nicht selbst überprüfen.

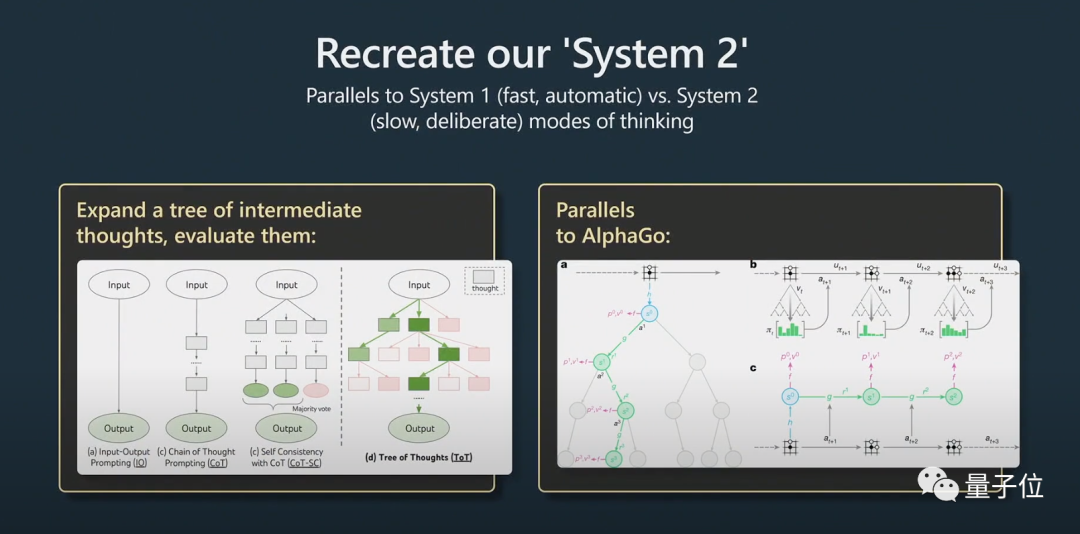

Dabei handelt es sich um das Problem von System1 und System2.

Nobelpreisträger Daniel Kahneman schlug in „Thinking Fast and Slow“ vor, dass das menschliche kognitive System aus zwei Subsystemen besteht, System1 und System2. System1 basiert hauptsächlich auf Intuition, während System2 ein logisches Analysesystem ist.

Laienhaft ausgedrückt ist System1 ein schneller und automatisch generierter Prozess, während System2 ein gut durchdachter Teil ist.

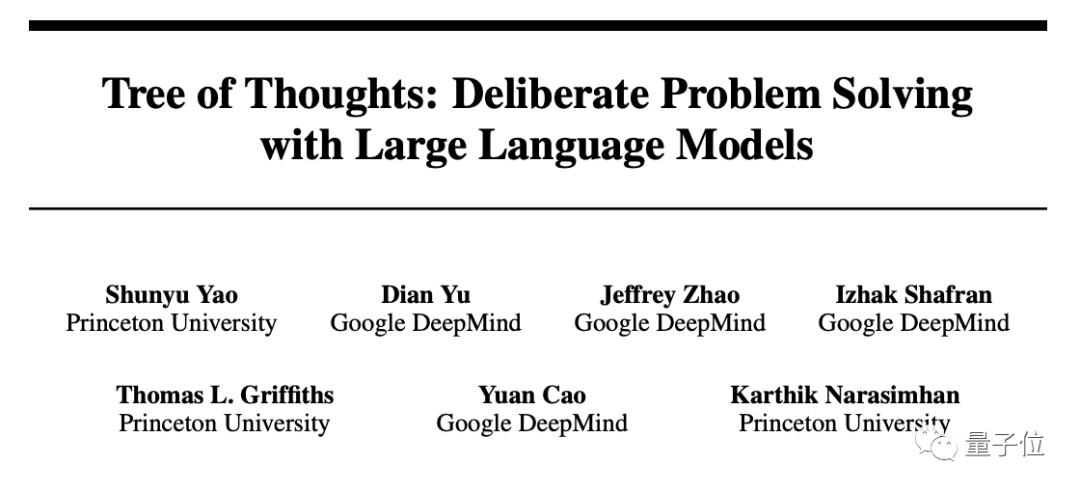

Dies wurde auch in einem kürzlich erschienenen populären Artikel „Tree of Thought“ erwähnt.

Nachdenklich bedeutet nicht einfach, eine Antwort auf eine Frage zu geben, sondern eher wie eine Eingabeaufforderung, die mit Python-Klebercode verwendet wird, um viele Eingabeaufforderungen aneinanderzureihen. Um die Hinweise zu skalieren, muss das Modell mehrere Hinweise verwalten und einen Baumsuchalgorithmus ausführen.

Karpathy glaubt, dass diese Idee AlphaGo sehr ähnlich ist:

Wenn AlphaGo Go spielt, muss es überlegen, wo das nächste Stück platziert werden soll. Ursprünglich lernte es durch die Nachahmung von Menschen.

Darüber hinaus implementiert es die Monte-Carlo-Baumsuche, um Ergebnisse mit mehreren potenziellen Strategien zu erhalten. Es bewertet viele mögliche Züge und behält nur die besseren bei. Ich denke, das entspricht in gewisser Weise AlphaGo.

In diesem Zusammenhang erwähnte Karpathy auch AutoGPT:

Ich denke, die Wirkung ist derzeit nicht sehr gut und ich empfehle es nicht für die praktische Anwendung. Ich denke, im Laufe der Zeit können wir vielleicht aus seiner Entwicklung lernen.

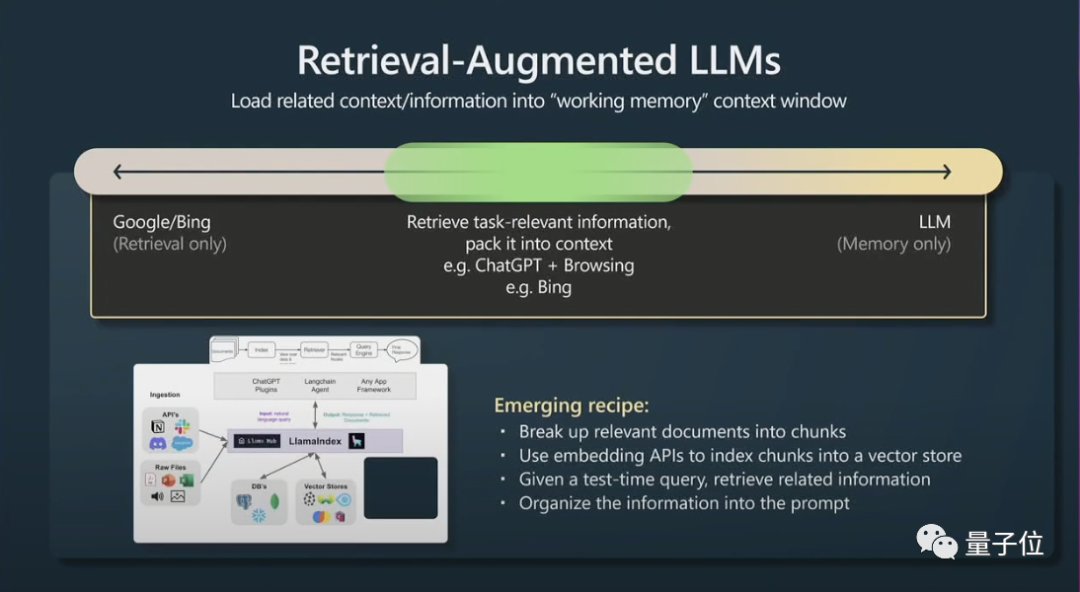

Zweitens ist ein weiterer kleiner Trick das Abrufen einer verbesserten Generation (Retrieval Agumented Generation) und effektiver Tipps.

Der Inhalt des Fensterkontexts ist der Arbeitsspeicher von Transformern zur Laufzeit. Wenn Sie dem Kontext aufgabenbezogene Informationen hinzufügen können, ist die Leistung sehr gut, da er sofort auf diese Informationen zugreifen kann.

Kurz gesagt bedeutet dies, dass relevante Daten indiziert werden können, sodass effizient auf das Modell zugegriffen werden kann.

Transformer erzielen eine bessere Leistung, wenn sie auch über eine Hauptdatei als Referenz verfügen.

Abschließend sprach Karpathy kurz über die Eingabeaufforderung und Feinabstimmung von Einschränkungen in großen Sprachmodellen.

Große Sprachmodelle können durch Einschränkungshinweise und Feinabstimmung verbessert werden. Einschränkungshinweise erzwingen Vorlagen in der Ausgabe großer Sprachmodelle, während durch Feinabstimmung die Gewichtungen des Modells angepasst werden, um die Leistung zu verbessern.

Ich empfehle, große Sprachmodelle in Anwendungen mit geringem Risiko zu verwenden, sie immer mit menschlicher Aufsicht zu kombinieren, sie als Quelle der Inspiration und Beratung zu betrachten und Copiloten in Betracht zu ziehen, anstatt sie zu vollständig autonomen Agenten zu machen.

Über Andrej Karpathy

Andrej Karpathys erster Job nach seinem Abschluss bestand darin, Computer Vision bei OpenAI zu studieren.

Später verliebte sich Musk, einer der Mitbegründer von OpenAI, in Karpathy und stellte ihn bei Tesla ein. Musk und OpenAI waren sich in dieser Angelegenheit uneinig, und Musk wurde schließlich ausgeschlossen. Karpathy ist für Teslas Autopilot, FSD und andere Projekte verantwortlich.

Im Februar dieses Jahres, 7 Monate nachdem er Tesla verlassen hatte, trat Karpathy erneut OpenAI bei.

Kürzlich hat er getwittert, dass er derzeit sehr an der Entwicklung des Open-Source-Ökosystems für große Sprachmodelle interessiert ist, was ein bisschen wie Anzeichen der frühen kambrischen Explosion ist.

Portal:

[1]https://www.youtube.com/watch?v=xO73EUwSegU (Sprachvideo)

[2]https://arxiv . org/PDF/2305.10601.pdf („Tree of Thought“-These)

Referenzlink:

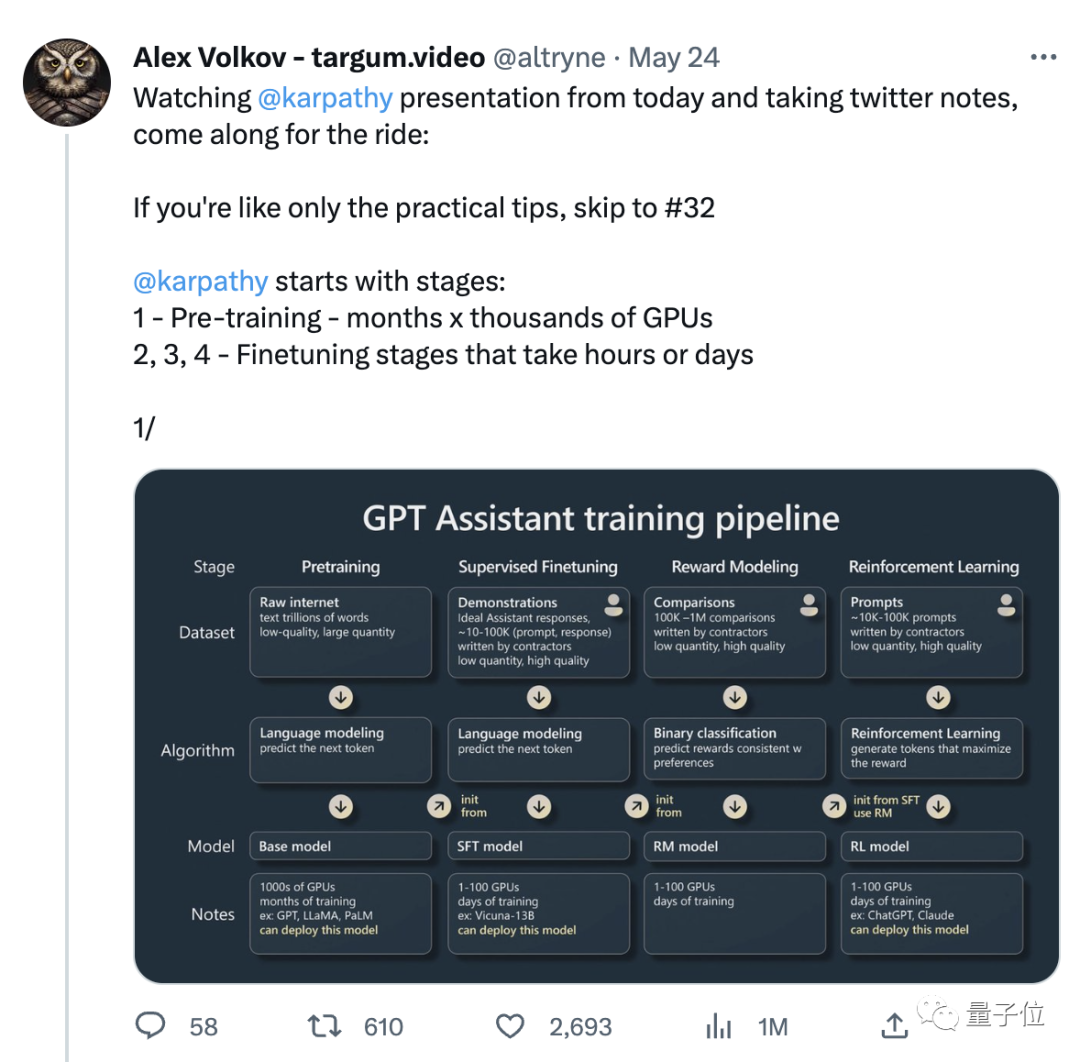

[1] https://twitter.com/altryne/status/16612367888832896

[ 2 ]https://www.reddit.com/r/MachineLearning/comments/13qrtek/n_state_of_gpt_by_andrej_karpathy_in_msbuild_2023/

[3]https://www.wisdominanutshell.academy/state-of-gpt/

Das obige ist der detaillierte Inhalt vonEndlich hat jemand die aktuelle Situation von GPT klargestellt! Die neueste Rede von OpenAI ging viral und es muss sich um ein von Musk handverlesenes Genie handeln. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Detailliertes Verständnis des Win10-Partitionsformats: GPT- und MBR-Vergleich

Dec 22, 2023 am 11:58 AM

Detailliertes Verständnis des Win10-Partitionsformats: GPT- und MBR-Vergleich

Dec 22, 2023 am 11:58 AM

Bei der Partitionierung ihrer eigenen Systeme wissen viele Benutzer aufgrund der unterschiedlichen Festplatten, die von Benutzern verwendet werden, nicht, ob das Win10-Partitionsformat GPT oder MBR ist. Aus diesem Grund haben wir Ihnen eine detaillierte Einführung zusammengestellt, damit Sie den Unterschied zwischen den beiden kennen zwei. Win10-Partitionsformat gpt oder mbr: Antwort: Wenn Sie eine Festplatte mit mehr als 3 TB verwenden, können Sie gpt verwenden. gpt ist weiter fortgeschritten als mbr, aber in Bezug auf die Kompatibilität ist mbr immer noch besser. Selbstverständlich kann dies auch nach den Vorlieben des Nutzers gewählt werden. Der Unterschied zwischen gpt und mbr: 1. Anzahl der unterstützten Partitionen: 1. MBR unterstützt bis zu 4 primäre Partitionen. 2. GPT ist nicht durch die Anzahl der Partitionen begrenzt. 2. Unterstützte Festplattengröße: 1. MBR unterstützt nur bis zu 2 TB

Soll ich MBR oder GPT als Festplattenformat für Win7 wählen?

Jan 03, 2024 pm 08:09 PM

Soll ich MBR oder GPT als Festplattenformat für Win7 wählen?

Jan 03, 2024 pm 08:09 PM

Wenn wir das Betriebssystem Win7 verwenden, kann es manchmal vorkommen, dass wir das System neu installieren und die Festplatte partitionieren müssen. In Bezug auf die Frage, ob das Win7-Festplattenformat MBR oder GPT erfordert, ist der Herausgeber der Meinung, dass Sie immer noch eine Entscheidung basierend auf den Details Ihres eigenen Systems und Ihrer Hardwarekonfiguration treffen müssen. Aus Kompatibilitätsgründen ist es am besten, das MBR-Format zu wählen. Schauen wir uns für Details an, was der Editor getan hat. Das Win7-Festplattenformat erfordert mbr oder gpt1. Wenn das System mit Win7 installiert ist, wird empfohlen, MBR zu verwenden, das eine gute Kompatibilität aufweist. 2. Wenn es 3T überschreitet oder Win8 installiert, können Sie GPT verwenden. 3. Obwohl GPT tatsächlich weiter fortgeschritten ist als MBR, ist MBR in Bezug auf die Kompatibilität definitiv unschlagbar. GPT- und MBR-Bereiche

Die ultimative Waffe für das Kubernetes-Debugging: K8sGPT

Feb 26, 2024 am 11:40 AM

Die ultimative Waffe für das Kubernetes-Debugging: K8sGPT

Feb 26, 2024 am 11:40 AM

Im Zuge der Weiterentwicklung der Technologien für künstliche Intelligenz und maschinelles Lernen haben Unternehmen und Organisationen damit begonnen, aktiv innovative Strategien zu erforschen, um diese Technologien zur Verbesserung der Wettbewerbsfähigkeit zu nutzen. K8sGPT[2] ist eines der leistungsstärksten Tools in diesem Bereich. Es handelt sich um ein auf k8s basierendes GPT-Modell, das die Vorteile der k8s-Orchestrierung mit den hervorragenden Funktionen des GPT-Modells zur Verarbeitung natürlicher Sprache kombiniert. Was ist K8sGPT? Schauen wir uns zunächst ein Beispiel an: Laut der offiziellen Website von K8sGPT ist K8sgpt ein Tool zum Scannen, Diagnostizieren und Klassifizieren von Kubernetes-Clusterproblemen. Es integriert SRE-Erfahrung in seine Analyse-Engine, um die relevantesten Informationen bereitzustellen. Durch den Einsatz künstlicher Intelligenztechnologie bereichert K8sgpt seine Inhalte weiterhin und hilft Benutzern, schneller und genauer zu verstehen.

So ermitteln Sie, ob die Computerfestplatte die GPT- oder MBR-Partitionierungsmethode verwendet

Dec 25, 2023 pm 10:57 PM

So ermitteln Sie, ob die Computerfestplatte die GPT- oder MBR-Partitionierungsmethode verwendet

Dec 25, 2023 pm 10:57 PM

Wie kann man überprüfen, ob eine Computerfestplatte eine GPT-Partition oder eine MBR-Partition ist? Wenn wir eine Computerfestplatte verwenden, müssen wir zwischen GPT und MBR unterscheiden. Lassen Sie uns einen Blick darauf werfen . So überprüfen Sie, ob es sich bei der Computerfestplatte um GPT oder MBR handelt: 1. Klicken Sie mit der rechten Maustaste auf „Computer“ auf dem Desktop und klicken Sie auf „Verwalten“. 2. Suchen Sie „Datenträgerverwaltung“ unter „Verwaltung“. 3. Rufen Sie die Datenträgerverwaltung auf, um den allgemeinen Status anzuzeigen Klicken Sie dann mit der rechten Maustaste auf „Festplatte 0“ und wählen Sie „Eigenschaften“. 4. Wechseln Sie in „Eigenschaften“ zur Registerkarte „Volume“, dann können wir die „Festplattenpartition“ sehen Formular“ und Sie können es als Probleme im Zusammenhang mit der Win10-Festplatte der MBR-Partition sehen. So konvertieren Sie eine MBR-Partition in eine GPT-Partition >

Wie viele der drei größten Mängel des LLM kennen Sie?

Nov 26, 2023 am 11:26 AM

Wie viele der drei größten Mängel des LLM kennen Sie?

Nov 26, 2023 am 11:26 AM

Wissenschaft: Weit davon entfernt, ein ewig wohlwollendes und wohltuendes Wesen zu sein, wird die empfindungsfähige allgemeine KI der Zukunft wahrscheinlich ein manipulativer Soziopath sein, der alle Ihre persönlichen Daten auffrisst und dann zusammenbricht, wenn sie am meisten gebraucht wird. Übersetzt aus 3WaysLLMsCanLetYouDown, Autor JoabJackson. OpenAI steht kurz vor der Veröffentlichung von GPT-5, und die Außenwelt setzt große Hoffnungen darauf. Die optimistischsten Prognosen gehen sogar davon aus, dass es allgemeine künstliche Intelligenz erreichen wird. Doch gleichzeitig stehen CEO Sam Altman und sein Team bei der Markteinführung vor einer Reihe schwerwiegender Hindernisse, was er Anfang des Monats einräumte. Es gibt einige kürzlich veröffentlichte Forschungsarbeiten, die Hinweise auf Altmans Herausforderung liefern könnten. Zusammenfassung dieser Arbeiten

GPT-Lokalisierungsbereitstellungspraxis für das große Sprachmodell Alpaca-lora

Jun 01, 2023 pm 09:04 PM

GPT-Lokalisierungsbereitstellungspraxis für das große Sprachmodell Alpaca-lora

Jun 01, 2023 pm 09:04 PM

Modelleinführung: Das Alpaca-Modell ist ein von der Stanford University entwickeltes LLM-Modell (Large Language Model, große Sprache). Es basiert auf dem LLaMA7B-Modell (7B Open Source von Meta Company) und verfügt über 7 Milliarden Modellparameter (je größer die Modellparameter, desto größer die Modellparameter, desto stärker ist natürlich die Argumentationsfähigkeit des Modells, desto höher sind natürlich die Kosten für das Training des Modells). LoRA, der vollständige englische Name lautet „Low-RankAdaptation of Large Language Models“, wörtlich übersetzt „Low-Rank Adaptation of Large Language Models“. Hierbei handelt es sich um eine von Microsoft-Forschern entwickelte Technologie zur Lösung der Feinabstimmung großer Sprachmodelle. Wenn Sie möchten, dass ein vorab trainiertes großes Sprachmodell eine bestimmte Domäne ausführen kann

Wie hat sich die von Bill Gates gewählte GPT-Technologie entwickelt und wessen Leben hat sie revolutioniert?

May 28, 2023 pm 03:13 PM

Wie hat sich die von Bill Gates gewählte GPT-Technologie entwickelt und wessen Leben hat sie revolutioniert?

May 28, 2023 pm 03:13 PM

Xi Xiaoyao Science and Technology Talks Ursprünglicher Autor |. IQ ist vollständig gesunken, Python Was wird passieren, wenn Maschinen auf ähnliche Weise wie Menschen verstehen und kommunizieren können? Dieses Thema bereitet der akademischen Gemeinschaft große Sorgen, und dank einer Reihe von Durchbrüchen in der Verarbeitung natürlicher Sprache in den letzten Jahren sind wir diesem Ziel möglicherweise näher denn je. An der Spitze dieses Durchbruchs steht der Generative Pre-trained Transformer (GPT) – ein tiefes neuronales Netzwerkmodell, das speziell für Aufgaben der Verarbeitung natürlicher Sprache entwickelt wurde. Seine herausragende Leistung und die Fähigkeit, effektive Gespräche zu führen, haben es zu einem der am weitesten verbreiteten und effektivsten Modelle auf diesem Gebiet gemacht und große Aufmerksamkeit in Forschung und Industrie auf sich gezogen. In einem aktuellen detaillierten

Ist das Solid-State-Laufwerk auf MBR oder GPT initialisiert?

Mar 10, 2023 pm 02:48 PM

Ist das Solid-State-Laufwerk auf MBR oder GPT initialisiert?

Mar 10, 2023 pm 02:48 PM

Das Solid-State-Laufwerk wird auf gpt initialisiert. GPT bietet die Vorteile der Partitionsgröße und -anzahl und ist fortschrittlicher und robuster. Alle Computersysteme stellen einen neuen Standard dar und werden MBR in Zukunft schrittweise ersetzen. Microsoft hat außerdem offiziell angekündigt, dass das Windows 11-System nur GPT und UEFI unterstützt. Wenn Sie daher ein Upgrade Ihres Windows-Systems auf Windows 11 in Betracht ziehen, müssen Sie zuerst den MBR in GPT konvertieren.