So konfigurieren Sie die Nginx-Strombegrenzung

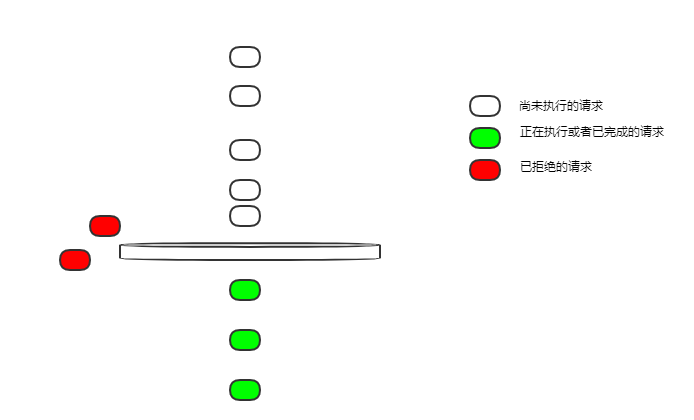

Leerer Bucket

Wir beginnen mit der einfachsten Strombegrenzungskonfiguration:

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit;

proxy_pass http://login_upstream;

}

}$binary_remote_addr für die Client-IP-Strombegrenzung;

zone=ip_limit:10m Der Name der aktuellen Begrenzungsregel ist ip_limit, was zulässig ist 10 MB Speicherplatz zum Aufzeichnen des aktuellen Begrenzungsstatus entsprechend der IP;

rate=10r/s Die aktuelle Begrenzungsgeschwindigkeit beträgt 10 Anfragen pro Sekunde

Standort /login/ Begrenzt den Anmeldefluss

Die Streaming-Geschwindigkeit beträgt 10 Anfragen pro Sekunde. Wenn 10 Anfragen gleichzeitig bei einem inaktiven Nginx eintreffen, werden sie dann alle ausgeführt?

Leaky-Bucket-Leak-Anfragen erfolgen mit gleichmäßiger Geschwindigkeit. Wie ist 10 U/s eine konstante Geschwindigkeit? Alle 100 ms wird eine Anfrage durchgesickert.

Bei dieser Konfiguration ist der Bucket leer und alle Anfragen, die nicht in Echtzeit durchgesickert sind, werden abgelehnt.

Wenn also 10 Anfragen gleichzeitig eingehen, kann nur eine Anfrage ausgeführt werden, die anderen werden abgelehnt.

Das ist nicht sehr freundlich. In den meisten Geschäftsszenarien hoffen wir, dass diese 10 Anfragen ausgeführt werden können.

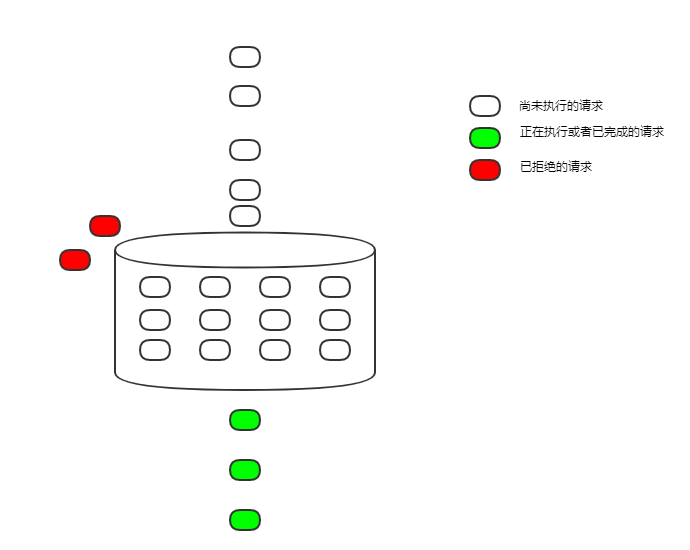

burst

Ändern wir die Konfiguration, um das Problem im vorherigen Abschnitt zu lösen

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit burst=12;

proxy_pass http://login_upstream;

}

}burst=12 Die Größe des Leaky-Buckets ist auf 12 eingestellt. und es ist als Fifo-Warteschlange implementiert, um Anforderungen, die nicht ausgeführt werden können, vorübergehend zwischenzuspeichern.

Auf diese Weise begrenzt der undichte Eimer nicht nur den Durchfluss, sondern übernimmt auch die Rolle der Spitzenglättung und Talfüllung.

Auf diese Weise begrenzt der undichte Eimer nicht nur den Durchfluss, sondern übernimmt auch die Rolle der Spitzenglättung und Talfüllung.

Wenn bei einer solchen Konfiguration 10 Anfragen gleichzeitig eintreffen, werden sie nacheinander alle 100 ms ausgeführt.

Obwohl es ausgeführt wurde, erhöhte sich die Verzögerung aufgrund der Warteschlangenausführung erheblich, was in vielen Szenarien immer noch inakzeptabel ist.

nodelayÄndern Sie die Konfiguration weiter, um das Problem der durch eine zu lange Verzögerung verursachten erhöhten Verzögerung zu lösen Jetzt gibt es keine Verzögerung. Sobald es in den Bucket gelegt wird, wird es entweder sofort ausgeführt oder aufgrund der aktuellen Begrenzung abgelehnt.Da Anfragen mit konstanter Geschwindigkeit aus dem Bucket austreten und der Bucket-Speicherplatz festgelegt ist, werden am Ende durchschnittlich 5 Anfragen pro Sekunde ausgeführt und der Zweck der Strombegrenzung wird weiterhin erreicht.

Aber das hat auch Nachteile. Das aktuelle Limit ist begrenzt, aber das Limit ist nicht so einheitlich. Nehmen wir die obige Konfiguration als Beispiel: Wenn 12 Anfragen gleichzeitig eintreffen, können diese 12 Anfragen sofort ausgeführt werden, und nachfolgende Anfragen können nur mit konstanter Geschwindigkeit in den Bucket eingegeben werden, und alle 100 ms wird eine Anfrage ausgeführt . Wenn für einen bestimmten Zeitraum keine Anfragen vorliegen und der Bucket leer ist, können 12 gleichzeitige Anfragen gleichzeitig ausgeführt werden.

In den meisten Fällen stellt diese ungleichmäßige Strombegrenzung kein großes Problem dar. Nginx bietet jedoch auch einen Parameter zur Steuerung der gleichzeitigen Ausführung, nämlich die Anzahl der Nodelay-Anfragen.

limit_req_zone $binary_remote_addr zone=ip_limit:10m rate=10r/s;

server {

location /login/ {

limit_req zone=ip_limit burst=12 nodelay;

proxy_pass http://login_upstream;

}

}delay=4 beginnt mit der Verzögerung ab der 5. Anfrage im Bucket gleichmäßig und ressourcenintensiv. Es ist immer noch notwendig, diese Menge im Dienst zu kontrollieren.

Das obige ist der detaillierte Inhalt vonSo konfigurieren Sie die Nginx-Strombegrenzung. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

So überprüfen Sie, ob Nginx gestartet wird

Apr 14, 2025 pm 01:03 PM

So überprüfen Sie, ob Nginx gestartet wird

Apr 14, 2025 pm 01:03 PM

So bestätigen Sie, ob Nginx gestartet wird: 1. Verwenden Sie die Befehlszeile: SystemCTL Status Nginx (Linux/Unix), Netstat -ano | FindStr 80 (Windows); 2. Überprüfen Sie, ob Port 80 geöffnet ist; 3. Überprüfen Sie die Nginx -Startmeldung im Systemprotokoll. 4. Verwenden Sie Tools von Drittanbietern wie Nagios, Zabbix und Icinga.

So konfigurieren Sie den Namen des Cloud -Server -Domänennamens in Nginx

Apr 14, 2025 pm 12:18 PM

So konfigurieren Sie den Namen des Cloud -Server -Domänennamens in Nginx

Apr 14, 2025 pm 12:18 PM

So konfigurieren Sie einen Nginx -Domänennamen auf einem Cloud -Server: Erstellen Sie einen Datensatz, der auf die öffentliche IP -Adresse des Cloud -Servers zeigt. Fügen Sie virtuelle Hostblöcke in die NGINX -Konfigurationsdatei hinzu, wobei der Hörport, Domänenname und das Root -Verzeichnis der Website angegeben werden. Starten Sie Nginx neu, um die Änderungen anzuwenden. Greifen Sie auf die Konfiguration des Domänennamens zu. Weitere Hinweise: Installieren Sie das SSL -Zertifikat, um HTTPS zu aktivieren, sicherzustellen, dass die Firewall den Verkehr von Port 80 ermöglicht, und warten Sie, bis die DNS -Auflösung wirksam wird.

Wie kann ich überprüfen, ob Nginx begonnen wird?

Apr 14, 2025 pm 12:48 PM

Wie kann ich überprüfen, ob Nginx begonnen wird?

Apr 14, 2025 pm 12:48 PM

Verwenden Sie unter Linux den folgenden Befehl, um zu überprüfen, ob Nginx gestartet wird: SystemCTL -Status Nginx Richter basierend auf der Befehlsausgabe: Wenn "aktiv: aktiv (lief) angezeigt wird, wird Nginx gestartet. Wenn "Active: Inactive (Dead)" angezeigt wird, wird Nginx gestoppt.

So starten Sie Nginx unter Linux

Apr 14, 2025 pm 12:51 PM

So starten Sie Nginx unter Linux

Apr 14, 2025 pm 12:51 PM

Schritte zum Starten von Nginx unter Linux: Überprüfen Sie, ob Nginx installiert ist. Verwenden Sie SystemCTL Start Nginx, um den Nginx -Dienst zu starten. Verwenden Sie SystemCTL aktivieren NGINX, um das automatische Start von NGINX beim Systemstart zu aktivieren. Verwenden Sie den SystemCTL -Status NGINX, um zu überprüfen, ob das Startup erfolgreich ist. Besuchen Sie http: // localhost in einem Webbrowser, um die Standard -Begrüßungsseite anzuzeigen.

So überprüfen Sie die Nginx -Version

Apr 14, 2025 am 11:57 AM

So überprüfen Sie die Nginx -Version

Apr 14, 2025 am 11:57 AM

Die Methoden, die die Nginx -Version abfragen können, sind: Verwenden Sie den Befehl nginx -v; Zeigen Sie die Versionsrichtlinie in der Datei nginx.conf an. Öffnen Sie die Nginx -Fehlerseite und sehen Sie sich den Seitentitel an.

So starten Sie den Nginx -Server

Apr 14, 2025 pm 12:27 PM

So starten Sie den Nginx -Server

Apr 14, 2025 pm 12:27 PM

Das Starten eines Nginx-Servers erfordert unterschiedliche Schritte gemäß verschiedenen Betriebssystemen: Linux/UNIX-System: Installieren Sie das NGINX-Paket (z. B. mit APT-Get oder Yum). Verwenden Sie SystemCTL, um einen Nginx -Dienst zu starten (z. B. sudo systemctl start nginx). Windows -System: Laden Sie Windows -Binärdateien herunter und installieren Sie sie. Starten Sie Nginx mit der ausführbaren Datei nginx.exe (z. B. nginx.exe -c conf \ nginx.conf). Unabhängig davon, welches Betriebssystem Sie verwenden, können Sie auf die Server -IP zugreifen

So erstellen Sie einen Spiegel in Docker

Apr 15, 2025 am 11:27 AM

So erstellen Sie einen Spiegel in Docker

Apr 15, 2025 am 11:27 AM

Schritte zum Erstellen eines Docker -Images: Schreiben Sie eine Dockerfile, die die Build -Anweisungen enthält. Erstellen Sie das Bild im Terminal mit dem Befehl Docker Build. Markieren Sie das Bild und weisen Sie Namen und Tags mit dem Befehl Docker Tag zu.

So lösen Sie Nginx403

Apr 14, 2025 am 10:33 AM

So lösen Sie Nginx403

Apr 14, 2025 am 10:33 AM

Wie fixiere ich Nginx 403 Verbotener Fehler? Überprüfen Sie die Datei- oder Verzeichnisberechtigungen; 2.Htaccess -Datei prüfen; 3. Überprüfen Sie die Konfigurationsdatei der Nginx; 4. Starten Sie Nginx neu. Weitere mögliche Ursachen sind Firewall -Regeln, Selinux -Einstellungen oder Anwendungsprobleme.