Xinxixi (Öffentliches Konto: aichip001)

Autor |. ZeR0

Herausgeber |. Moying

Eine Möglichkeit, es umzuschreiben: Der KI-Großmodellwettbewerb löst einen beispiellosen Hype aus. Laut dem Kernbericht vom 30. Mai ist der Aufstieg von ChatGPT die wichtigste treibende Kraft dieses Wettbewerbs. In diesem Wettbewerb ist Geschwindigkeit der Schlüssel zum Vorteil als Erstanbieter. Von der Modellschulung bis zur Implementierung besteht ein dringender Bedarf an leistungsstärkeren KI-Chips.

Im März dieses Jahres brachte Aixin Yuanzhi, ein Unternehmen für Forschung und Entwicklung von KI-Chips zur visuellen Wahrnehmung und grundlegender Rechenleistungsplattform, den SoC-Chip AX650N der dritten Generation mit hoher Rechenleistung und hoher Energieeffizienz auf den Markt. Liu Jianwei, Mitbegründer und Vizepräsident von Aixin Yuanzhi, sagte kürzlich in einem Interview mit Xinxi und anderen Medien, dass der AX650N-Chip beim Betrieb von Transformer offensichtliche Vorteile habe und Transformer eine Struktur sei, die häufig in aktuellen großen Modellen verwendet werde.

Transformer wurde ursprünglich zur Bearbeitung von Aufgaben im Bereich der Verarbeitung natürlicher Sprache verwendet und expandierte nach und nach in den Bereich der Computer Vision, was das Potenzial zeigte, den traditionellen Mainstream-Computer Vision-Algorithmus CNN bei immer mehr visuellen Aufgaben zu ersetzen. Die effiziente Bereitstellung von Transformer auf der Geräte- und Edge-Seite ist für immer mehr Benutzer, die bei der Auswahl einer Plattform große Anforderungen an die Modellbereitstellung haben, zu einer zentralen Überlegung geworden.

Verglichen mit der Verwendung einer GPU zur Bereitstellung großer Transformer-Modelle in der Cloud ist Aixin Yuanzhi der Ansicht, dass die größte Herausforderung bei der Bereitstellung von Transformer auf der Edge- und Endseite im Stromverbrauch liegt, der es Aixin Yuanzhi ermöglicht, gemischte Präzision mit hoher Leistung und geringem Stromverbrauch zu erreichen Verbrauchs-NPU hat sich zur bevorzugten Plattform für den Einsatz von Transformern auf der End- und Kantenseite entwickelt.

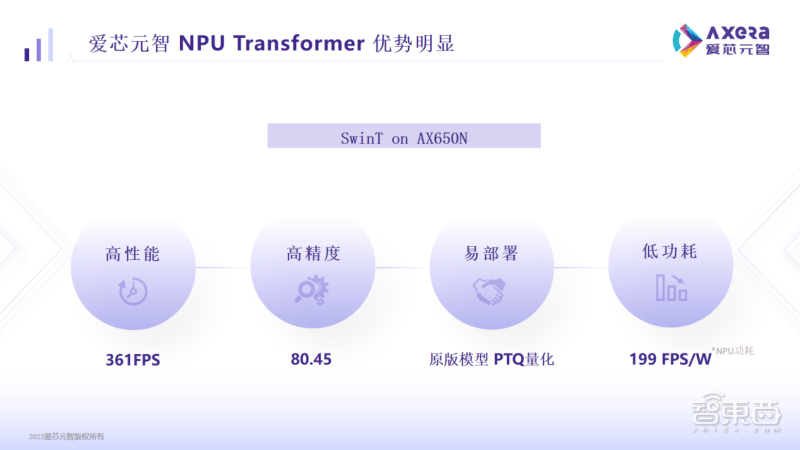

Daten zeigen, dass beim Ausführen des gängigen visuellen Modells Swin Transformer (SwinT) auf der Aixin Yuanzhi AX650N-Plattform die Leistung bis zu 361 FPS, die Genauigkeit bis zu 80,45 % und der Stromverbrauch nur 199 FPS/W beträgt , was im Landeeinsatz sehr wettbewerbsfähig ist.

1. Es verfügt sowohl über eine hohe Rechenleistung als auch über eine hohe Energieeffizienz und wurde an eine Vielzahl von Transformer-Modellen angepasst

Der AX650N-Chip ist ein weiterer leistungsstarker intelligenter Vision-Chip, der von Aixin Yuanzhi nach den Serien AX620 und AX630 auf den Markt gebracht wurde.

Dieser SoC verfügt über ein heterogenes Multi-Core-Design und integriert eine 8-Core-A55-CPU, eine NPU mit hoher Rechenleistung von 43,2TOPs@INT4 oder 10,8TOPs@INT8, einen ISP, der 8K@30fps unterstützt, sowie H.264 und H. 265 Codecs.

In Bezug auf die Schnittstellen unterstützt der AX650N 64-Bit-LPDDR4x, mehrere MIPI-Eingänge, Gigabit-Ethernet, USB- und HDMI-2.0b-Ausgänge sowie 32 Kanäle mit 1080p@30fps-Dekodierung.

Für den Einsatz großer Modelle an Rand- und Stirnseiten bietet der AX650N die Vorteile hoher Leistung, hoher Präzision, geringem Stromverbrauch und einfacher Bereitstellung.

Insbesondere wenn Aixin Yuanzhi AX650N SwinT ausführt, ist die hohe Leistung von 361 Frames mit High-End-GPU-basierten Domänensteuerungs-SoCs im Bereich des autonomen Fahrens im Automobilbereich vergleichbar; die hohe Genauigkeit von 80,45 % liegt über dem Marktdurchschnitt; Die Geschwindigkeit von 199 FPS/W spiegelt den geringen Stromverbrauch wider und ist um ein Vielfaches vorteilhafter als der aktuelle High-End-GPU-basierte Domänensteuerungs-SoC.

Aixin Yuanzhi erklärte, dass frühe Edge- und End-Side-Kunden mehr darauf geachtet haben, wie viele Terabyte an Rechenleistung vorhanden sind, aber dies sind indirekte Daten. Was den Benutzern letztendlich wichtig ist, ist, wie schnell das Modell im tatsächlichen Geschäft laufen kann. sowie die Bereitstellungskosten und wie niedrig die Nutzungskosten sind.

In dieser Hinsicht unterstützt AX650N gemischte Low-Bit-Präzision. Wenn Benutzer INT4 übernehmen, können sie die Speicher- und Bandbreitennutzung erheblich reduzieren und die Kosten der End- und Edge-Side-Bereitstellung effektiv kontrollieren.

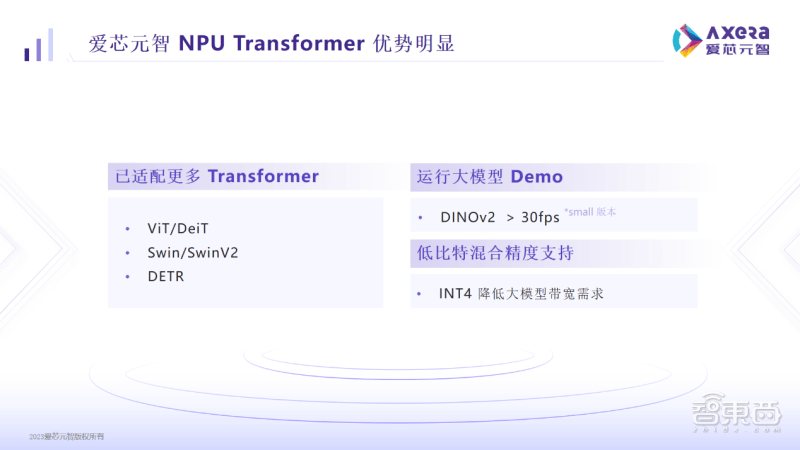

Aktuell wurde AX650N an Transformer-Modelle wie ViT/DeiT, Swin/SwinV2, DETR usw. angepasst und kann in DINOv2 auch über 30 Frames laufen, was die Erkennung, Klassifizierung, Segmentierung und andere Vorgänge für Benutzer komfortabler macht. AX650N-basierte Produkte wurden bereits in wichtigen Computer-Vision-Szenarien wie Smart Cities, Smart Education und Intelligent Manufacturing eingesetzt.

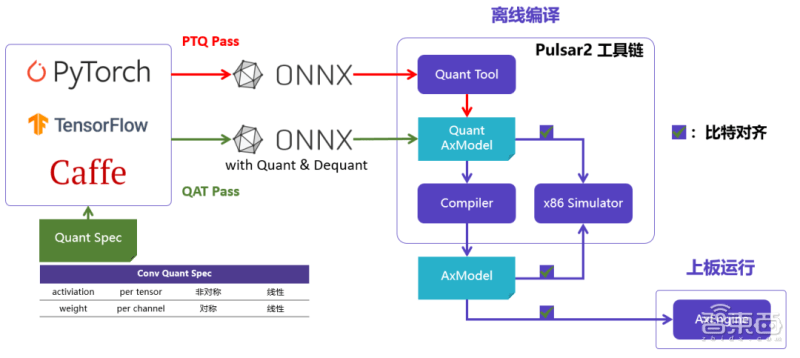

2. Es ist einfach, große Modelle bereitzustellen und GitHub-Originalmodelle auszuführen

Aixin Yuanzhi hat außerdem eine neue Generation der KI-Toolkette Pulsar2 entwickelt. Die Toolkette umfasst vier Funktionen in einem: Modellkonvertierung, Offline-Quantifizierung, Modellkompilierung und heterogene Planung, was den Bedarf an einer effizienten Bereitstellung von Netzwerkmodellen weiter stärkt und gleichzeitig die NPU-Architektur tiefgreifend optimiert, gleichzeitig aber auch die Betreiber- und Modellunterstützung erweitert . Fähigkeiten und Umfang sowie Unterstützung für Transformer-Strukturnetzwerke.

Aixin Yuanzhi hat in der Praxis herausgefunden, dass Unternehmen auf dem Markt, die Chips anbieten, auf denen SwinT ausgeführt werden kann, in der Regel einige Änderungen am Modell vornehmen müssen. Die Änderungen können eine Reihe von Problemen verursachen und den Benutzern weitere Unannehmlichkeiten bereiten.

Die meisten der früheren visuellen Transformer-Modelle, die SwinT ähneln, wurden auf Cloud-Servern bereitgestellt, da GPUs für die Unterstützung der MHA-Strukturberechnung besser geeignet sind. Im Gegensatz dazu müssen randseitige/geräteseitige KI-Chips die CNN-Struktur sicherstellen Aufgrund ihrer architektonischen Einschränkungen ist die Effizienz des Modells grundsätzlich besser, es gibt keine große Leistungsoptimierung in der MHA-Struktur und die Netzwerkstruktur muss sogar geändert werden, bevor sie bereitgestellt werden kann.

Der AX650N ist einfach zu implementieren. Sie können das Originalmodell effizient auf GitHub auf der Aixin Yuanzhi-Plattform ausführen, ohne es zu ändern oder QAT neu zu trainieren.

„Unsere Benutzer haben berichtet, dass unsere Plattform derzeit die beste Plattform zur Unterstützung von Transformer ist, und wir sehen auch die Möglichkeit, große Modelle auf unserer Plattform zu implementieren.“ AX650N ist letztendlich effektiver und einfacher zu verwenden. Es lässt sich stark an Szenarien anpassen und ist schneller einsatzbereit. Es verbessert die Benutzereffizienz erheblich und verkürzt den Massenproduktionszyklus.

Von Aixin Yuanzhi gesammeltes Kundenfeedback zeigt, dass nach Erhalt des Entwicklungsboards und der Dokumentation von Aixin Yuanzhi die Demo-Reproduktion grundsätzlich abgeschlossen und das private Netzwerkmodell in einer Stunde ausgeführt werden kann.

Der AX650N-Chip kann dank eines gewissen Maßes an Flexibilität und Programmierbarkeit im Hardware- und Softwaredesign schnell an neue Netzwerkstrukturen angepasst werden. Als nächstes wird Aixin Yuanzhi AX650N die Transformer-Struktur weiter optimieren und weitere große Transformer-Modelle wie multimodale große Modelle erkunden.

Aixin Yuanzhi wird außerdem das AXera-Pi Pro-Entwicklungsboard auf Basis des AX650N auf den Markt bringen und weitere Informationen und KI-Beispiele auf GitHub veröffentlichen, damit Entwickler schnell umfangreichere Produktanwendungen erkunden können.

3. Visuelle Anwendungsszenarien haben einen dringenden Bedarf an Transformer-Modellen geschaffen

Laut Aixin Yuanzhi kann der Einsatz großer visueller Modelle auf der Edge- oder Endseite dazu beitragen, das Problem zu hoher Investitionen in intelligente KI-Anwendungen in Long-Tail-Szenarien zu lösen.

Die bisherige Methode zur Überwachung von Flussmüll bestand darin, dass nach der Entdeckung von Müll im Fluss zunächst eine Datenerfassung und -kennzeichnung erforderlich war und anschließend ein Modelltraining durchgeführt wurde. Wenn in einem Flussbett neuer Müll auftaucht, der zuvor nicht durch Datenanmerkungen und trainierte Modelle abgedeckt wurde, kann das Modell ihn möglicherweise nicht identifizieren. Eine Neuschulung von Grund auf ist zeitaufwändig und arbeitsintensiv.

Das große Transformer-Modell verfügt über semantische Verständnisfähigkeiten und ist vielseitiger als das herkömmliche CNN-Modell. Es kann ein breiteres Spektrum nachgelagerter Aufgaben verstehen und ausführen, ohne alle komplexen visuellen Szenen im Voraus zu kennen. Mithilfe vorab trainierter großer Modelle und unbeaufsichtigtem Training kann neuer Müll identifiziert werden, der noch nie zuvor gesehen wurde.

爱心元智 teilte Xinxi mit, dass derzeit in allen Anwendungsszenarien, in denen Kameras zur Bilderfassung verwendet werden, eine dringende Nachfrage nach großen Transformer-Modellen besteht. Die spezifische Implementierungsgeschwindigkeit hängt von der Forschung und Entwicklung der Kunden in jedem Segment ab. und Ressourceninvestitionen.

Aus Sicht des Chip-Architekturdesigns müssen wir einerseits versuchen, die Bandbreitennutzung großer Modelle zu reduzieren, um die Bereitstellung des Transformer-Modells am Rand oder am Ende zu beschleunigen Andererseits müssen wir die Struktur des Transformators optimieren. Der zuständige Verantwortliche von Aixin Yuanzhi sagte, dass die beim tatsächlichen Einsatz von AX650N gesammelten technischen Erfahrungen in die Chipplattform der nächsten Generation einfließen werden, wodurch das Transformer-Modell schneller und besser laufen kann, was ihm einen gewissen First-Mover-Vorteil gegenüber anderen verschafft andere Kollegen.

"Aus diesem Grund ist die Chip-Plattform von Aixin die beste Wahl für die Transformer-Implementierung, denn wenn jeder das Modell verkleinert, muss er die Auswirkungen der Ausführung auf der Geräteseite sehen wollen. Wir haben eine solche Plattform, die das kann „Diese Art von Closed-Loop-Experiment“, sagte er.

Um den Transformer-Inferenzeffekt weiter zu optimieren, wird sich Aixin Yuanzhi darauf konzentrieren, wie Hardware in die Lage versetzt werden kann, diskrete Daten effizient zu lesen und unterstützende Berechnungen zu ermöglichen, die mit dem Datenlesen übereinstimmen. Darüber hinaus versucht Aixin Yuanzhi auch, 4bit zu verwenden, um das Problem großer Modellparameter zu lösen, und untersucht die Unterstützung für einige Modelle mit spärlichen oder gemischten Expertensystemen (MOE, Mixture of Experts).

Fazit: Hochleistungs-KI-Chips bilden den Grundstein für den Einsatz großer Modelle

Von der Massenproduktion des ersten Hochleistungs-KI-Vision-Chips AX630A im Jahr 2020 über den selbst entwickelten Edge-Side-Smart-Chip AX620A der zweiten Generation im Jahr 2021 bis hin zum neu veröffentlichten AX650N-Chip der dritten Generation, Aixin Yuanzhi bestanden Wir bringen weiterhin KI-Vision-Chips mit hoher Rechenleistung und hoher Energieeffizienz auf den Markt, um den Anforderungen von KI-Anwendungen auf der End- und Kantenseite gerecht zu werden.

Dr. Qiu Xiaoxin, Gründer, Vorsitzender und CEO von Aixin Yuanzhi, sagte, dass die Entwicklung der Technologie der künstlichen Intelligenz weiterhin neue Möglichkeiten schafft und die Entwicklung von Aixin Yuanzhi in den Bereichen visuelle Verarbeitung, Automobilelektronik und andere Chips gefördert hat Der technologische Fortschritt und die jüngste Explosion großer Modelle haben in den letzten Jahren neue Möglichkeiten für Aixins anhaltende Erforschung der End- und Kantenseite geschaffen.

Die zugehörigen F&E- und Implementierungspläne von Aixin zielen alle auf ein Ziel ab: Wenn Benutzer oder potenzielle Benutzer an Transformer denken, können sie an Aixin Yuanzhi denken und dann mehr auf der KI-Computerplattform von Aixin Yuanzhi entwickeln Eine auf dem Transformer-Modell basierende Anwendung wird letztendlich die Implementierung großer Modelle und intelligenter Anwendungen auf der End- und Kantenseite beschleunigen.

Im Gegenzug wird die Ansammlung von mehr Einsatzerfahrung auch die kontinuierliche Weiterentwicklung der Chips und Software von Aixin Yuanzhi fördern. Durch die Bereitstellung leistungsfähigerer und benutzerfreundlicherer Tools wird es den Algorithmeningenieuren dabei helfen, innovative Anwendungen des Transformer-Modells weiter voranzutreiben Tür zur Fantasie.

Das obige ist der detaillierte Inhalt vonWelche Art von KI-Chip wird benötigt, um ein großes Modell in eine Kamera zu integrieren? Aixin Yuanzhis Antwort ist AX650N. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So verwenden Sie die Konvertierungsfunktion „Konvertieren'.

So verwenden Sie die Konvertierungsfunktion „Konvertieren'.

Was tun, wenn die temporäre Dateiumbenennung fehlschlägt?

Was tun, wenn die temporäre Dateiumbenennung fehlschlägt?

Welche Karte ist eine TF-Karte?

Welche Karte ist eine TF-Karte?

BigDecimal-Methode zum Vergleichen von Größen

BigDecimal-Methode zum Vergleichen von Größen

Was tun, wenn das eingebettete Bild nicht vollständig angezeigt wird?

Was tun, wenn das eingebettete Bild nicht vollständig angezeigt wird?

So konfigurieren Sie die Pfadumgebungsvariable in Java

So konfigurieren Sie die Pfadumgebungsvariable in Java

Lösung dafür, dass Java-Code nicht ausgeführt wird

Lösung dafür, dass Java-Code nicht ausgeführt wird

Verwendung von Oracle-Einsätzen

Verwendung von Oracle-Einsätzen