Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die drei neuen Kurse von Andrew Ng werden nacheinander veröffentlicht und zeigen Ihnen Schritt für Schritt, wie Sie Anwendungen mithilfe der ChatGPT-API erstellen

Die drei neuen Kurse von Andrew Ng werden nacheinander veröffentlicht und zeigen Ihnen Schritt für Schritt, wie Sie Anwendungen mithilfe der ChatGPT-API erstellen

Die drei neuen Kurse von Andrew Ng werden nacheinander veröffentlicht und zeigen Ihnen Schritt für Schritt, wie Sie Anwendungen mithilfe der ChatGPT-API erstellen

Andrew Ng hat der KI-Community wieder gute Nachrichten geschickt.

Heute gab Andrew Ng auf Twitter bekannt, dass drei neue Kurse für generative KI online sind.

Diese drei Kurse umfassen -

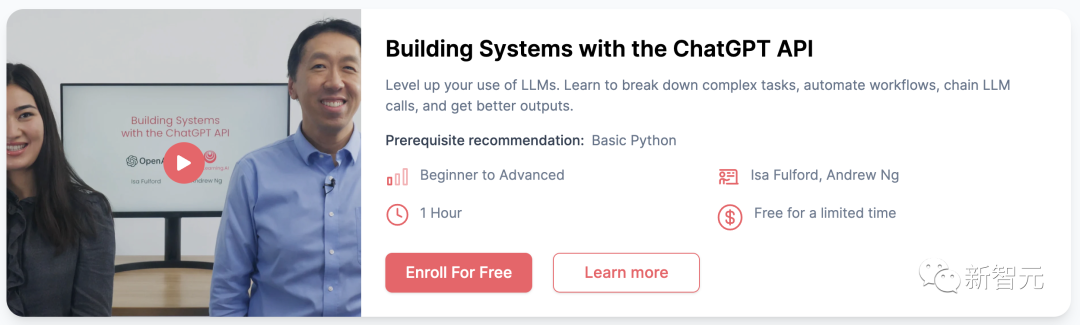

1. Aufbau eines Systems mit der ChatGPT-API von OpenAI: Mit diesem Kurs gehen Sie über eine einzelne Eingabeaufforderung hinaus und lernen die Feinheiten des Aufbaus einer LLM-Anwendung mit mehreren API-Aufrufen kennen . Gleichzeitig erfahren Sie, wie Sie die Ergebnisse von LLM bewerten, um Sicherheit und Genauigkeit zu gewährleisten und iterative Verbesserungen voranzutreiben.

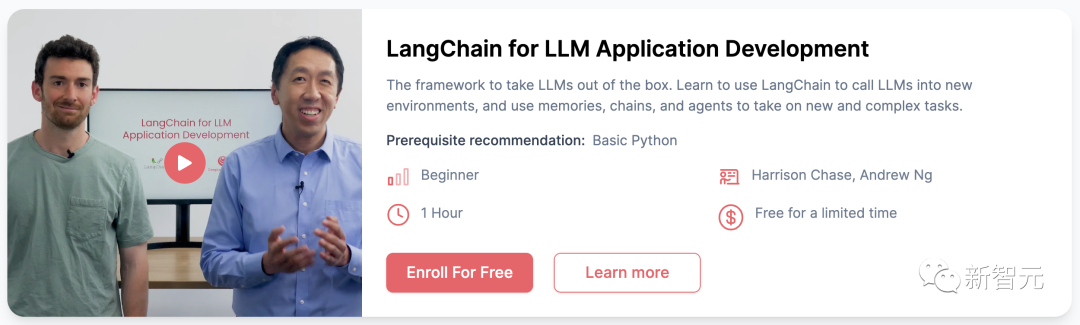

2. LangChain für die LLM-Anwendungsentwicklung: Durch das Erlernen dieses leistungsstarken Open-Source-Tools können Sie Anwendungen erstellen, die LLM verwenden, einschließlich Chatbot-Speicher, Fragenbeantwortung zu Dokumenten und Entscheidungsfindung, welche Maßnahmen ergriffen werden sollen für einen LLM-Agenten.

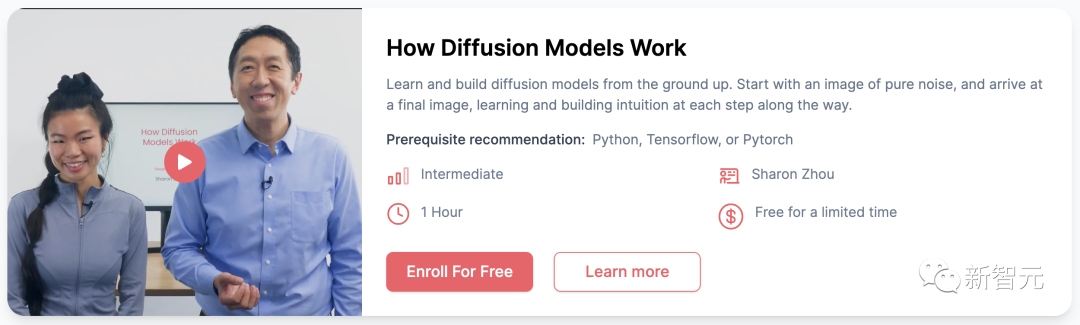

3. Funktionsweise von Diffusionsmodellen: In diesem Kurs lernen Sie die technischen Details von Diffusionsmodellen kennen, die Midjourney, DALL·E 2 und Stable Diffusion unterstützen. Sie können auch Ihren eigenen funktionierenden Jupyter-Code für Videospiel-Sprites generieren.

Beachten Sie, dass diese Kurse für eine begrenzte Zeit kostenlos sind und jeder Kurs 1–1,5 Stunden dauert.

Aufbau eines Systems mit der ChatGPT-API

In diesem Kurs können Sie lernen, wie Sie komplexe Arbeitsabläufe automatisieren, indem Sie kontinuierlich große Sprachmodelle aufrufen.

Zu den Inhalten gehören:

· Erstellen Sie Eingabeaufforderungsketten, die mit vorherigen Eingabeaufforderungen interagieren.

· Erstellen Sie Python-Code für die Interaktion mit vorhandenen und neuen Eingabeaufforderungssystemen.

· Erstellen Sie einen Kundenservice-Chatbot mit den Techniken aus dem Kurs.

Diese Fähigkeiten können auf reale Szenarien angewendet werden, einschließlich der Klassifizierung von Benutzeranfragen in Antworten für Chat-Agenten, der Bewertung der Sicherheit von Benutzeranfragen und der Verarbeitung von Aufgaben zur Gedankenverkettung und zum mehrstufigen Denken.

Darunter praktische Beispiele, die die Konzepte leicht verständlich machen, während das integrierte Jupyter-Notebook es Ihnen ermöglicht, nahtlos mit dem im Kurs vorgestellten Code und den Übungen zu experimentieren.

Dieser Kurs ist für Anfänger geeignet, die über Grundkenntnisse in Python verfügen. Es eignet sich auch für fortgeschrittene und fortgeschrittene Machine-Learning-Ingenieure, die die hochmodernen Rapid-Engineering-Fähigkeiten von LLM erlernen möchten.

LangChain für die LLM-Anwendungsentwicklung

In diesem Kurs erlernen Sie die grundlegenden Fähigkeiten zur Verwendung des LangChain-Frameworks, um die Anwendungsfälle und Funktionalität von Sprachmodellen in der Anwendungsentwicklung zu erweitern.

Im Einzelnen umfasst:

· Modelle, Hinweise und Parser: LLM aufrufen, Hinweise bereitstellen und Antworten analysieren

· LLM-Speicher: Speicher zum Speichern von Dialogen und zur Verwaltung begrenzten Kontextraums

· Ketten: Erstellen von Operationssequenzen

· Fragen und Antworten zur Dokumentation: Anwenden von LLM auf Ihre proprietären Daten und Anwendungsfallanforderungen

· Agenten: Erkundung der leistungsstarken Entwicklung von LLM als Inferenzagent

Am Ende des Kurses verfügen Sie über ein Modell, das als Ausgangspunkt für Ihre eigene Erforschung angewandter Diffusionsmodelle dienen kann.

Dieser Kurs wird Ihnen erheblich dabei helfen, die Möglichkeiten der Nutzung leistungsstarker Sprachmodelle zu erweitern, und in wenigen Stunden können Sie unglaubliche Anwendungen erstellen.

Dieser Kurs ist für Anfänger geeignet, die nur grundlegende Python-Kenntnisse beherrschen müssen.

Wie Diffusionsmodelle funktionieren

In dieser Abteilungslektion können Sie ein tiefgreifendes Verständnis des Diffusionsprozesses und der Modelle, die ihn durchführen, erlangen.

Dieser Kurs geht über das einfache Einbringen eines vorgefertigten Modells oder die Verwendung der API hinaus. Er lehrt Sie, ein Diffusionsmodell von Grund auf zu erstellen.

Im Einzelnen beinhaltet:

· Entdecken Sie die hochmoderne Welt der diffusionsbasierten generativen KI und erstellen Sie Ihr eigenes Diffusionsmodell von Grund auf.

· Gewinnen Sie Einblicke in Modelle von Diffusionsprozessen und Antriebsprozessen, die über vorgefertigte Modelle und APIs hinausgehen.

· Erwerben Sie praktische Programmierfähigkeiten durch Probenentnahme im Labor, Training von Diffusionsmodellen, Aufbau neuronaler Netze für die Rauschvorhersage und das Hinzufügen von Kontext für die personalisierte Bildgenerierung.

Am Ende des Kurses verfügen Sie über ein Modell, das als Ausgangspunkt für Ihre eigene Erkundung der Anwendung von Diffusionsmodellen dienen kann.

Darunter praktische Beispiele, die die Konzepte leicht verständlich machen, während das integrierte Jupyter-Notebook es Ihnen ermöglicht, nahtlos mit dem im Kurs vorgestellten Code und den Übungen zu experimentieren.

Dies ist ein Kurs für Fortgeschrittene und erfordert Kenntnisse in Python, Tensorflow oder Pytorch.

Das obige ist der detaillierte Inhalt vonDie drei neuen Kurse von Andrew Ng werden nacheinander veröffentlicht und zeigen Ihnen Schritt für Schritt, wie Sie Anwendungen mithilfe der ChatGPT-API erstellen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Sony bestätigt die Möglichkeit, spezielle GPUs für PS5 Pro zu verwenden, um KI mit AMD zu entwickeln

Apr 13, 2025 pm 11:45 PM

Sony bestätigt die Möglichkeit, spezielle GPUs für PS5 Pro zu verwenden, um KI mit AMD zu entwickeln

Apr 13, 2025 pm 11:45 PM

Mark Cerny, Chefarchitekt von SonyInteractiveStonterment (Siey Interactive Entertainment), hat weitere Hardware-Details der Host-PlayStation5pro (PS5PRO) der nächsten Generation veröffentlicht, darunter ein auf Performance verbessertes Amdrdna2.x-GPU und ein maschinelles Lernen/künstliches Intelligenzprogramm Code-genannt "Amethylst" mit Amd. Der Fokus der PS5PRO-Leistungsverbesserung liegt immer noch auf drei Säulen, darunter eine leistungsstärkere GPU, eine fortschrittliche Ray-Tracing und eine von KI betriebene PSSR-Superauflösung. GPU nimmt eine maßgeschneiderte AMDRDNA2 -Architektur an, die Sony RDNA2.x nennt, und es hat eine rDNA3 -Architektur.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Was sind die Methoden zur Abstimmung der Leistung von Zookeeper auf CentOS

Apr 14, 2025 pm 03:18 PM

Die Zookeper -Leistungsstimmung auf CentOS kann von mehreren Aspekten beginnen, einschließlich Hardwarekonfiguration, Betriebssystemoptimierung, Konfigurationsparameteranpassung, Überwachung und Wartung usw. Hier finden Sie einige spezifische Tuning -Methoden: SSD wird für die Hardwarekonfiguration: Da die Daten von Zookeeper an Disk geschrieben werden, wird empfohlen, SSD zu verbessern, um die I/O -Leistung zu verbessern. Genug Memory: Zookeeper genügend Speicherressourcen zuweisen, um häufige Lesen und Schreiben von häufigen Festplatten zu vermeiden. Multi-Core-CPU: Verwenden Sie Multi-Core-CPU, um sicherzustellen, dass Zookeeper es parallel verarbeiten kann.

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Wie man ein Pytorch -Modell auf CentOS trainiert

Apr 14, 2025 pm 03:03 PM

Effizientes Training von Pytorch -Modellen auf CentOS -Systemen erfordert Schritte, und dieser Artikel bietet detaillierte Anleitungen. 1.. Es wird empfohlen, YUM oder DNF zu verwenden, um Python 3 und Upgrade PIP zu installieren: Sudoyumupdatepython3 (oder sudodnfupdatepython3), PIP3Install-upgradepip. CUDA und CUDNN (GPU -Beschleunigung): Wenn Sie Nvidiagpu verwenden, müssen Sie Cudatool installieren

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek:

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.