Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Die KI schreitet rasant voran und wir müssen Vorreiter sein, um unsere Kräfte zu schonen

Die KI schreitet rasant voran und wir müssen Vorreiter sein, um unsere Kräfte zu schonen

Die KI schreitet rasant voran und wir müssen Vorreiter sein, um unsere Kräfte zu schonen

Am 30. Mai wurde auf der Ergebniskonferenz des Zhongguancun-Forums 2023 der „Umsetzungsplan für Peking zur Beschleunigung des Aufbaus eines weltweit einflussreichen Innovationszentrums für künstliche Intelligenz (2023-2025)“ offiziell veröffentlicht. Der „Implementierungsplan“ verlangt, dass Innovationseinheiten dabei unterstützt werden, sich auf Durchbrüche bei Technologien wie verteilten, effizienten Deep-Learning-Frameworks und neuen Infrastrukturen für große Modelle zu konzentrieren und sich um die Förderung technologischer Innovationen im Zusammenhang mit großen Modellen zu bemühen.

Dies wird von der Branche als ein weiterer Beweis dafür gewertet, dass China die Entwicklung großer Modelle kräftig vorantreiben wird. Tatsächlich hat in jüngster Zeit von den zentralen Ministerien und Kommissionen bis hin zu den lokalen Provinzen und Städten die politische Ausrichtung auf die Entwicklung von KI-Technologie und die Nutzung der Chancen großer Modelle zugenommen. Sowohl die Dichte der politischen Umsetzung als auch die strategische Gesamthöhe haben erstaunliche Ausmaße erreicht .

Es gibt Grund zu der Annahme, dass China mit großen Modellen als Durchbruch einen KI-Boom erzielen wird. Seit der Einführung einer neuen Generation von Entwicklungsstrategien für künstliche Intelligenz im Jahr 2017 wird China sich im aktuellen Zeitfenster weiterentwickeln und die allgemeine Explosion der KI-Industrie vorantreiben.

Wir alle wissen, dass die Nutzung von KI-Entwicklungschancen technologische Durchbrüche und den Aufbau von Infrastruktur erfordert. Wenn es um Infrastruktur in der KI-Branche geht, werden im Allgemeinen KI-Chips, Deep-Learning-Frameworks und vorab trainierte große Modelle erwähnt Ein zentrales Problem wird oft übersehen: Große Modelle bringen einen enormen Datendruck mit sich, und die Datenspeicherung ist auch eine Säule im Entwicklungsprozess der KI.

ChatGPT ist der Anführer dieser Runde der KI-Explosion, und die Datenprobleme, die durch die groß angelegte Anwendung großer Modelle verursacht werden, wurden tatsächlich in ChatGPT geschrieben.

Ist China angesichts dieses kommenden Drucks bereit?

Sehen Sie sich die Datenherausforderungen an, die der Aufstieg der KI von ChatGPT mit sich bringt

Seit Google BERT im Jahr 2018 herausgebracht hat, hat die Branche den Weg zum Vortraining großer Modelle eingeschlagen. Das Merkmal großer Modelle ist, dass der Umfang der Trainingsdaten und Modellparameter enorm ist, was große Herausforderungen an die Speicherung mit sich bringt, was auch in ChaGPT deutlich wird.

Die sogenannte „Größe“ eines großen vorab trainierten Modells spiegelt sich darin wider, dass das Deep-Learning-Netzwerk des Modells viele Schichten, viele Links und komplexe Parameter aufweist und die für das Training verwendeten Arten von Datensätzen komplexer sind Die Datenmenge ist umfangreicher. Als der Deep-Learning-Algorithmus zum ersten Mal geboren wurde, verfügten Mainstream-Modelle nur über wenige Millionen Parameter, aber als BERT veröffentlicht wurde, überstiegen die Modellparameter 100 Millionen, wodurch Deep Learning in die Phase großer Modelle gelangte. Im ChatGPT-Stadium verfügen Mainstream-Modelle bereits über Hunderte Milliarden Parameter, und die Branche hat sogar mit der Planung von Billionen Modellen begonnen. In wenigen Jahren haben sich die Parameter von KI-Modellen vertausendfacht, und so große Datenmengen und Modelle müssen gespeichert werden. Dies ist der erste große Test für die Speicherung, der durch den Ausbruch der KI verursacht wurde.

Darüber hinaus wird häufig erwähnt, dass das große KI-Modell eine neue Modellstruktur annimmt, sodass es eine bessere Absorptionswirkung und Robustheit gegenüber unstrukturierten Daten aufweist. Dies ist für die endgültige Wirkung der KI sehr wichtig, aber es ist so Außerdem führt dies zu einem abgeleiteten Problem: Wir müssen die Speicherung und den Abruf großer unstrukturierter Daten ordnungsgemäß handhaben. Nach dem Upgrade hat ChatGPT beispielsweise multimodale Funktionen wie Bilderkennung hinzugefügt, sodass zu seinen Trainingsdaten auch eine große Anzahl von Bildern zusätzlich zu Text hinzugefügt werden muss. Ein weiteres Beispiel sind selbstfahrende Fahrzeuge, die Folgendes speichern müssen Täglich zahlreiche Feldversuchsvideos als Grundlage für das Modelltraining. Das Wachstum dieser unstrukturierten Daten hat das Problem eines massiven Wachstums von KI-bezogenen Daten mit sich gebracht, einschließlich Datenspeicherung und -verarbeitung.

Statistik zufolge sind 80 % der neuen Daten weltweit derzeit unstrukturierte Daten, mit einer durchschnittlichen jährlichen Wachstumsrate von 38 %. Der Umgang mit der Flut diversifizierter Daten ist im Zeitalter der großen Datenmengen zu einer Schwierigkeit geworden, die es zu überwinden gilt Modelle.

Es gibt noch ein weiteres Problem: Große Modelle müssen häufig Daten lesen und abrufen. Die Datenzugriffsnutzung von ChatGPT erreicht 1,76 Milliarden Mal in einem einzigen Monat und die durchschnittliche Antwortgeschwindigkeit liegt innerhalb von 10 Sekunden. Der Arbeitsablauf des KI-Modells umfasst vier Teile: Sammlung, Vorbereitung, Training und Argumentation verschiedene Arten von Daten. Daher stellen große Modelle auch Anforderungen an die Speicherleistung.

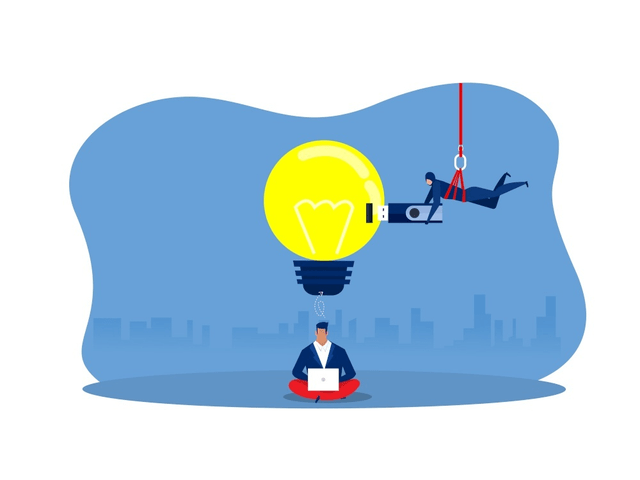

Darüber hinaus erinnern uns eine Reihe von Datensouveränitäts- und Datenschutzstreitigkeiten rund um ChatGPT auch daran, dass große KI-Modelle neue Risiken für die Datensicherheit mit sich bringen. Stellen Sie sich vor, wenn Kriminelle die Datenbank angreifen und das große Sprachmodell dazu veranlassen würden, falsche Informationen zu generieren, um Benutzer zu täuschen, wäre der Schaden schwerwiegend und versteckt.

Insgesamt ist ChatGPT zwar gut, stellt jedoch Herausforderungen in Bezug auf Datenspeicherumfang, Leistung, Sicherheit usw. dar. Wenn wir uns der Entwicklung großer Modelle und ChatGPT-ähnlicher Anwendungen widmen, muss der Speicher übergeben werden.

China hat seine Stärke, sind Sie bereit?

In den letzten Jahren haben wir gesagt, dass Rechenleistung gleich Produktivität ist. Aber wenn man plant, muss man sparen. Die Grenze der Einsparungen bestimmt auch die Obergrenze der Entwicklung der digitalen Produktivität.

Ist Chinas Reservetruppe also bereit für den unvermeidlichen Aufschwung der großen chinesischen Vorbilder? Bedauerlicherweise sind die Vorbereitungen Chinas für seine Reservekapazität in mehrfacher Hinsicht noch immer unzureichend und müssen weiter verbessert und ausgebaut werden. Wir können auf mehrere Probleme in Chinas Cunli achten, um zu sehen, ob sie dem Datendruck großer Modelle standhalten können.

1. Unzureichende Speicherkapazität begrenzt die Obergrenze der Entwicklung der KI-Industrie

Große Modelle bringen riesige Datenmengen mit sich, daher besteht die erste Priorität darin, diese Daten ordnungsgemäß zu speichern. Aber zum jetzigen Zeitpunkt hat China immer noch das Problem unzureichender Speicherkapazität, und große Datenmengen können nicht einmal in die Speicherphase gelangen. Gemessen an den Daten im Jahr 2022 hat Chinas Datenproduktion erstaunliche 8,1 ZB erreicht und liegt damit weltweit an zweiter Stelle. Chinas Speicherkapazität beträgt jedoch nur etwa 1.000 EB, was bedeutet, dass die Datenspeicherrate nur 12 % beträgt und die überwiegende Mehrheit der Daten nicht effektiv gespeichert werden kann. Während China den Status von Daten klar als fünften Produktionsfaktor definiert hat und die Entwicklung von Geheimdiensten auf Daten basieren und diese vollständig nutzen muss, gibt es eine große Datenmenge, die schwer zu speichern ist unseriös. China muss weiterhin ein schnelles und groß angelegtes Kapazitätswachstum aufrechterhalten, um die Entwicklungschancen der KI-Technologie zu nutzen, die große Modelle bieten.

2. Unter dem Einfluss massiver Daten sind die Verwaltungseffizienz und die Zugriffseffizienz gering

Wie bereits erwähnt, besteht die größte Datenherausforderung, die große KI-Modelle mit sich bringen, in der Ineffizienz bei der Verwaltung großer Datenmengen und der Verarbeitung der Datenerfassung und -speicherung. Um die Zugriffseffizienz zu verbessern, müssen Daten hocheffizient und mit geringem Energieverbrauch gespeichert und geschrieben werden. Derzeit werden jedoch in China immer noch 75 % der Daten auf mechanischen Festplatten gespeichert. Im Vergleich zu Flash-Laufwerken weisen mechanische Festplatten eine geringe Kapazitätsdichte, langsames Datenlesen, einen hohen Energieverbrauch und eine geringe Zuverlässigkeit auf. Relativ gesehen bietet All-Flash-Speicher eine Reihe von Vorteilen wie hohe Dichte, geringen Energieverbrauch, hohe Leistung usw Hohe Zuverlässigkeit: Chinas All-Flash-Speicher-Ersatz hat jedoch noch einen langen Weg vor sich.

3. Mehrere Datenprobleme führen zu einer ernsten Speichersicherheitssituation

Datensicherheitsprobleme sind für KI-Unternehmen und sogar die KI-Industrie zu einem dringenden Anliegen geworden. Im Jahr 2020 kam es beim Unternehmen Clearview AI in den USA zu einem Datensicherheitsvorfall, der zum Verlust von 3 Milliarden Daten von mehr als 2.000 Kunden führte. Dieser Fall zeigt uns, dass die Datensicherheitslage in der KI-Branche sehr ernst ist und wir bereits bei der Datenspeicherung auf Sicherheit achten müssen. Insbesondere wenn große KI-Modelle eine immer wichtigere Rolle in der Volkswirtschaft und im Lebensunterhalt der Menschen spielen, ist es umso notwendiger, die Speichersicherheitsfähigkeiten zu verbessern, um mit verschiedenen möglichen Risiken umzugehen.

Objektiv gesehen hat China Cunli eine hohe Entwicklungsgeschwindigkeit beibehalten, weist jedoch immer noch gewisse Mängel hinsichtlich der Gesamtgröße, des All-Flash-Speicheranteils und der technologischen Innovationsfähigkeiten auf. Es ist an der Zeit für ein Speicher-Upgrade, das den Anforderungen der industriellen Intelligenz und der groß angelegten Implementierung von KI gerecht wird.

Angesichts des intelligenten Zeitalters, der Chancen und Richtungen der Speicherbranche

Wenn wir den Druck, den das von ChatGPT repräsentierte große KI-Modell auf den Speicher ausübt, sowie den Entwicklungsstand der chinesischen Speicherkapazität selbst kombinieren, können wir eindeutig eine Schlussfolgerung ziehen: Chinas Speicher muss den Aufstieg der KI unterstützen und umfangreiche Upgrades durchführen.

Wir können die Entwicklungsrichtung der Speicherbranche klar erkennen. Die Dringlichkeit und der große Spielraum dieser Richtungen stellen eine große Chance für die Speicherbranche dar.

Zunächst ist es notwendig, die Speicherkapazität zu erweitern und den Aufbau von All-Flash-Speichern zu beschleunigen.

Der „Silicon in and Magnet out“-Trend, mechanische Festplatten durch All-Flash-Speicher zu ersetzen, ist seit vielen Jahren der allgemeine Entwicklungstrend der Speicherbranche. Angesichts der industriellen Chancen, die sich aus dem Aufstieg der KI ergeben, muss Chinas Speicherindustrie die Einführung und Umsetzung des All-Flash-Speicherersatzes beschleunigen und die Vorteile des All-Flash-Speichers wie hohe Leistung und hohe Zuverlässigkeit maximieren, um den Datenspeicheranforderungen gerecht zu werden gebracht durch große KI-Modelle.

Darüber hinaus ist auch zu beachten, dass die Möglichkeiten für verteilten All-Flash-Speicher zunehmen. Mit dem Aufkommen großer KI-Modelle und der Explosion unstrukturierter Daten nimmt die Bedeutung von Daten erheblich zu. Gleichzeitig ist KI in den Produktionskern großer Regierungsunternehmen eingedrungen und führt tendenziell lokale KI-Schulungen durch Die dateibasierte KI-Schulung hat zu einer erhöhten und verstärkten Nachfrage nach verteilter Speicherung geführt, anstatt Daten auf öffentlichen Cloud-Plattformen abzulegen.

Die Kombination der beiden wird die Implementierung von All-Flash in der Speicherindustrie weiterhin rasch vorantreiben und zum Kernpfad für die Entwicklung der chinesischen Speicherindustrie werden.

Zweitens müssen Innovationen in der Speichertechnologie verbessert werden, um sie an die Entwicklungsanforderungen von KI-Modellen anzupassen.

Wie oben erwähnt, besteht der durch KI verursachte Datentest nicht nur in der großen Menge an Daten, sondern auch in der Herausforderung der Datenkomplexität und der Vielfalt der Anwendungsverfahren. Daher muss die fortschrittliche Natur der Speicherung weiter verbessert werden. Um beispielsweise den häufigen Datenzugriffsanforderungen von KI gerecht zu werden, müssen die Lese- und Schreibbandbreite und die Zugriffseffizienz des Speichers verbessert werden. Um den Datenbedarf großer KI-Modelle zu decken, muss die Speicherbranche umfassende technische Upgrades durchführen.

In Bezug auf Datenspeicherformate besteht die ursprüngliche Entwurfsabsicht herkömmlicher Datenformate wie „Dateien“ und „Objekte“ nicht darin, den Trainingsanforderungen von KI-Modellen gerecht zu werden, und die Datenformate unstrukturierter Daten sind nicht einheitlich, was dies zur Folge hat Es ist schwierig, Daten beim Aufrufen von KI-Modellen zu verwenden. Dabei ist viel Arbeit erforderlich, um das Dateiformat neu zu verstehen und anzupassen, was zu einer Verringerung der Modellbetriebseffizienz und einem Anstieg des Trainingsrechenleistungsverbrauchs führt.

Aus diesem Grund muss auf der Speicherseite ein neues „Datenparadigma“ gebildet werden. Am Beispiel des autonomen Fahrtrainings sind verschiedene Arten von Daten am Datentrainingsprozess beteiligt. Wenn auf der Speicherseite ein neues Datenparadigma eingeführt wird, kann dies dazu beitragen, verschiedene Daten zu vereinheitlichen und sich besser an das KI-Modelltraining anzupassen Ausbildung autonomer Fahrzeuge. Wenn Sie sich beispielsweise KI als ein neues Tier vorstellen, muss es eine neue Art von Futter fressen. Wenn Sie es mit Daten in herkömmlichen Formaten füttern, leidet es unter Verdauungsstörungen. Das neue Datenparadigma besteht darin, Daten zu speichern ist vollständig für KI geeignet, wodurch der Prozess der „KI-Fütterung“ reibungslos und reibungslos verläuft.

Bei der KI-Entwicklungsarbeit macht die Datenverwaltung einen großen Teil der Arbeitslast aus, und es gibt auch Dateninselprobleme zwischen verschiedenen Datensätzen. Datenwebtechnologie kann diese Probleme effektiv lösen. Durch Datenweben kann der Speicher über integrierte Datenanalysefunktionen verfügen und physisch und logisch verstreute Daten integrieren, um eine globale Ansicht der Datenplanungs- und Flussfunktionen zu erstellen, wodurch die durch KI erzeugten riesigen Datenmengen effektiv verwaltet und die Effizienz der Datennutzung verbessert werden.

Diese technologischen Innovationen auf der Speicherseite können eine engere Verbindung zwischen Datenspeicherung und KI-Entwicklung schaffen.

Darüber hinaus müssen Sicherheitsfunktionen in den Speicher selbst integriert werden, um die aktiven Sicherheitsfunktionen zu stärken.

Da der Wert von KI zunimmt, führen Datensicherheitsprobleme zu mehr Verlusten für Unternehmensbenutzer. Daher müssen Unternehmen ihre Datensicherheitsfähigkeiten verbessern. Der wichtigste Punkt besteht darin, die Datenresilienz zu verbessern, den Speicher selbst mit Sicherheitsfunktionen auszustatten und die Datensicherheit von der Quelle aus zu schützen. Als Nächstes werden weitere Datenresilienzfunktionen in Datenspeicherprodukte integriert, wie z. B. Ransomware-Erkennung, Datenverschlüsselung, Sicherheits-Snapshots und AirGap-Quarantäne-Wiederherstellungsfunktionen.

Es ist erwähnenswert, dass die Branche als Reaktion auf den Aufstieg großer KI-Modelle bereits die umfassende Aufrüstung des Speichers untersucht und versucht hat. Durch hochwertige All-Flash-Produkte integriert Huawei Storage fortschrittliche Speichertechnologie und integrierte Sicherheitsfunktionen, um eine enge Verbindung zwischen Speicherinnovation und KI-Entwicklung zu erreichen und aufeinander zu arbeiten.

Insgesamt sind die Entwicklung der Speicherindustrie und der Fortschritt der Speicherkapazität Chinas von entscheidender Bedeutung für die Implementierung groß angelegter KI-Modelle und sogar die intelligente Modernisierung Tausender Industrien. Ohne die Entwicklung von Speicher wird es schwierig sein, die durch die KI verursachte Datenflut richtig zu bewältigen, da die KI-Technologie aufgrund mangelnder Datenunterstützung möglicherweise sogar zu einem wurzellosen Baum wird.

Die Speicherbranche steht gleichzeitig vor den Chancen und Verantwortlichkeiten des intelligenten Zeitalters. Mit der kontinuierlichen Erkundung exzellenter Marken wie Huawei stehen Chinas Speichermöglichkeiten vor beispiellosen Chancen und werden auch der Verantwortung gerecht, die die Zeit mit sich bringt.

Viele Branchenexperten glauben, dass das große Sprachmodell der „iPhone-Moment“ in der Geschichte der KI ist, sodass die durch die KI-Technologie hervorgerufene Welle von Speicher-Upgrades auch ein Meilenstein in der chinesischen Speicherindustrie und der Auftakt zu einem goldenen Zeitalter werden könnte.

Das obige ist der detaillierte Inhalt vonDie KI schreitet rasant voran und wir müssen Vorreiter sein, um unsere Kräfte zu schonen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

So überprüfen Sie die CentOS -HDFS -Konfiguration

Apr 14, 2025 pm 07:21 PM

Vollständige Anleitung zur Überprüfung der HDFS -Konfiguration in CentOS -Systemen In diesem Artikel wird die Konfiguration und den laufenden Status von HDFS auf CentOS -Systemen effektiv überprüft. Die folgenden Schritte helfen Ihnen dabei, das Setup und den Betrieb von HDFs vollständig zu verstehen. Überprüfen Sie die Hadoop -Umgebungsvariable: Stellen Sie zunächst sicher, dass die Hadoop -Umgebungsvariable korrekt eingestellt ist. Führen Sie im Terminal den folgenden Befehl aus, um zu überprüfen, ob Hadoop ordnungsgemäß installiert und konfiguriert ist: Hadoopsion-Check HDFS-Konfigurationsdatei: Die Kernkonfigurationsdatei von HDFS befindet sich im/etc/hadoop/conf/verzeichnis, wobei core-site.xml und hdfs-site.xml von entscheidender Bedeutung sind. verwenden

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

CentOS Shutdown -Befehlszeile

Apr 14, 2025 pm 09:12 PM

Der Befehl centOS stilldown wird heruntergefahren und die Syntax wird von [Optionen] ausgeführt [Informationen]. Zu den Optionen gehören: -h das System sofort stoppen; -P schalten Sie die Leistung nach dem Herunterfahren aus; -r neu starten; -t Wartezeit. Zeiten können als unmittelbar (jetzt), Minuten (Minuten) oder als bestimmte Zeit (HH: MM) angegeben werden. Hinzugefügten Informationen können in Systemmeldungen angezeigt werden.

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Was sind die Backup -Methoden für Gitlab auf CentOS?

Apr 14, 2025 pm 05:33 PM

Backup- und Wiederherstellungsrichtlinie von GitLab im Rahmen von CentOS -System Um die Datensicherheit und Wiederherstellung der Daten zu gewährleisten, bietet GitLab on CentOS eine Vielzahl von Sicherungsmethoden. In diesem Artikel werden mehrere gängige Sicherungsmethoden, Konfigurationsparameter und Wiederherstellungsprozesse im Detail eingeführt, um eine vollständige GitLab -Sicherungs- und Wiederherstellungsstrategie aufzubauen. 1. Manuell Backup Verwenden Sie den GitLab-RakegitLab: Backup: Befehl erstellen, um die manuelle Sicherung auszuführen. Dieser Befehl unterstützt wichtige Informationen wie GitLab Repository, Datenbank, Benutzer, Benutzergruppen, Schlüssel und Berechtigungen. Die Standardsicherungsdatei wird im Verzeichnis/var/opt/gitlab/backups gespeichert. Sie können /etc /gitlab ändern

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

CentOS installieren MySQL

Apr 14, 2025 pm 08:09 PM

Die Installation von MySQL auf CentOS umfasst die folgenden Schritte: Hinzufügen der entsprechenden MySQL Yum -Quelle. Führen Sie den Befehl mySQL-server aus, um den MySQL-Server zu installieren. Verwenden Sie den Befehl mySQL_SECURE_INSTALLATION, um Sicherheitseinstellungen vorzunehmen, z. B. das Festlegen des Stammbenutzerkennworts. Passen Sie die MySQL -Konfigurationsdatei nach Bedarf an. Tune MySQL -Parameter und optimieren Sie Datenbanken für die Leistung.

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Wie man eine verteilte Schulung von Pytorch auf CentOS betreibt

Apr 14, 2025 pm 06:36 PM

Pytorch Distributed Training on CentOS -System erfordert die folgenden Schritte: Pytorch -Installation: Die Prämisse ist, dass Python und PIP im CentOS -System installiert sind. Nehmen Sie abhängig von Ihrer CUDA -Version den entsprechenden Installationsbefehl von der offiziellen Pytorch -Website ab. Für CPU-Schulungen können Sie den folgenden Befehl verwenden: PipinstallTorChTorChVisionTorChaudio Wenn Sie GPU-Unterstützung benötigen, stellen Sie sicher, dass die entsprechende Version von CUDA und CUDNN installiert ist und die entsprechende Pytorch-Version für die Installation verwenden. Konfiguration der verteilten Umgebung: Verteiltes Training erfordert in der Regel mehrere Maschinen oder mehrere Maschinen-Mehrfach-GPUs. Ort

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Detaillierte Erklärung des Docker -Prinzips

Apr 14, 2025 pm 11:57 PM

Docker verwendet Linux -Kernel -Funktionen, um eine effiziente und isolierte Anwendungsumgebung zu bieten. Sein Arbeitsprinzip lautet wie folgt: 1. Der Spiegel wird als schreibgeschützte Vorlage verwendet, die alles enthält, was Sie für die Ausführung der Anwendung benötigen. 2. Das Union File System (UnionFS) stapelt mehrere Dateisysteme, speichert nur die Unterschiede, speichert Platz und beschleunigt. 3. Der Daemon verwaltet die Spiegel und Container, und der Kunde verwendet sie für die Interaktion. 4. Namespaces und CGroups implementieren Container -Isolation und Ressourcenbeschränkungen; 5. Mehrere Netzwerkmodi unterstützen die Containerverbindung. Nur wenn Sie diese Kernkonzepte verstehen, können Sie Docker besser nutzen.

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

So sehen Sie sich Gitlab -Protokolle unter CentOS

Apr 14, 2025 pm 06:18 PM

Eine vollständige Anleitung zum Anzeigen von GitLab -Protokollen unter CentOS -System In diesem Artikel wird in diesem Artikel verschiedene GitLab -Protokolle im CentOS -System angezeigt, einschließlich Hauptprotokolle, Ausnahmebodi und anderen zugehörigen Protokollen. Bitte beachten Sie, dass der Log -Dateipfad je nach GitLab -Version und Installationsmethode variieren kann. Wenn der folgende Pfad nicht vorhanden ist, überprüfen Sie bitte das GitLab -Installationsverzeichnis und die Konfigurationsdateien. 1. Zeigen Sie das Hauptprotokoll an. Verwenden Sie den folgenden Befehl, um die Hauptprotokolldatei der GitLabRails-Anwendung anzuzeigen: Befehl: Sudocat/var/log/gitlab/gitlab-rails/production.log Dieser Befehl zeigt das Produkt an

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Wie ist die GPU -Unterstützung für Pytorch bei CentOS?

Apr 14, 2025 pm 06:48 PM

Aktivieren Sie die Pytorch -GPU -Beschleunigung am CentOS -System erfordert die Installation von CUDA-, CUDNN- und GPU -Versionen von Pytorch. Die folgenden Schritte führen Sie durch den Prozess: Cuda und Cudnn Installation Bestimmen Sie die CUDA-Version Kompatibilität: Verwenden Sie den Befehl nvidia-smi, um die von Ihrer NVIDIA-Grafikkarte unterstützte CUDA-Version anzuzeigen. Beispielsweise kann Ihre MX450 -Grafikkarte CUDA11.1 oder höher unterstützen. Download und installieren Sie Cudatoolkit: Besuchen Sie die offizielle Website von Nvidiacudatoolkit und laden Sie die entsprechende Version gemäß der höchsten CUDA -Version herunter und installieren Sie sie, die von Ihrer Grafikkarte unterstützt wird. Installieren Sie die Cudnn -Bibliothek: