Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Sam Altman warnt: KI wird die Menschheit ausrotten! Über 375 Chefs unterzeichneten einen gemeinsamen Brief mit 22 Wörtern, LeCun ging gegen den Strom

Sam Altman warnt: KI wird die Menschheit ausrotten! Über 375 Chefs unterzeichneten einen gemeinsamen Brief mit 22 Wörtern, LeCun ging gegen den Strom

Sam Altman warnt: KI wird die Menschheit ausrotten! Über 375 Chefs unterzeichneten einen gemeinsamen Brief mit 22 Wörtern, LeCun ging gegen den Strom

|Dieser Artikel ist reproduziert aus: Neue Weisheit【Neue Weisheit Einführung】Wird KI die Menschheit wirklich ausrotten? Über 375 große Männer haben den gemeinsamen Brief mit 22 Wörtern unterzeichnet.

Im März unterzeichneten Tausende großer Namen einen gemeinsamen Brief, in dem sie die Forschung und Entwicklung von „Super-KI“ aussetzten, was die gesamte Branche schockierte.

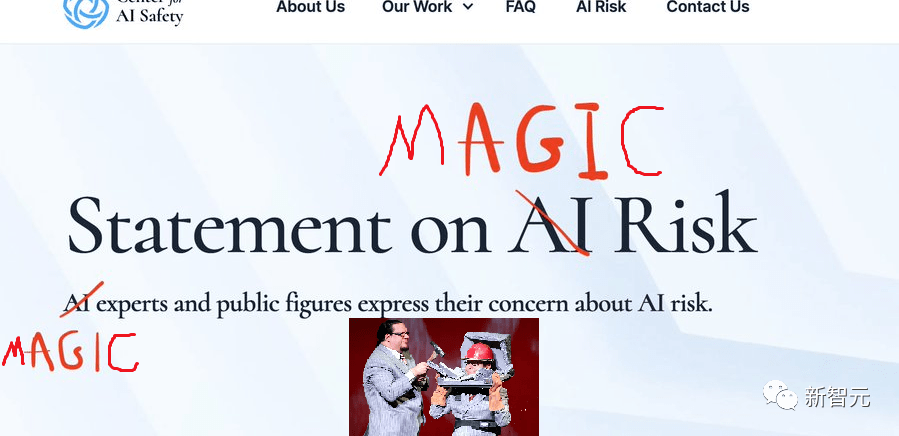

Erst gestern sorgte ein gemeinsamer Brief mit nur 22 Wörtern erneut für Aufruhr.

In nur wenigen Worten wird KI mit Infektionskrankheiten und Atomkrieg verglichen, die die Menschheit innerhalb von Minuten ausrotten können.

Zu den Unterzeichnern gehören Hinton und Bengio, zwei „Paten“ der künstlichen Intelligenz, sowie Führungskräfte der Silicon-Valley-Giganten Sam Altman, Demis Hassabis und andere Forscher, die auf dem Gebiet der künstlichen Intelligenz tätig sind.

Bisher haben mehr als 370 Führungskräfte, die sich mit künstlicher Intelligenz befassen, diesen gemeinsamen Brief unterzeichnet.

Dieser Brief wurde jedoch nicht von allen unterstützt.

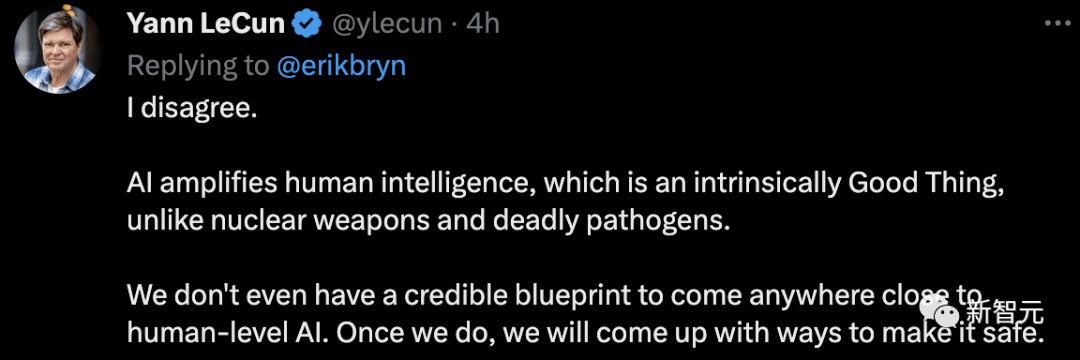

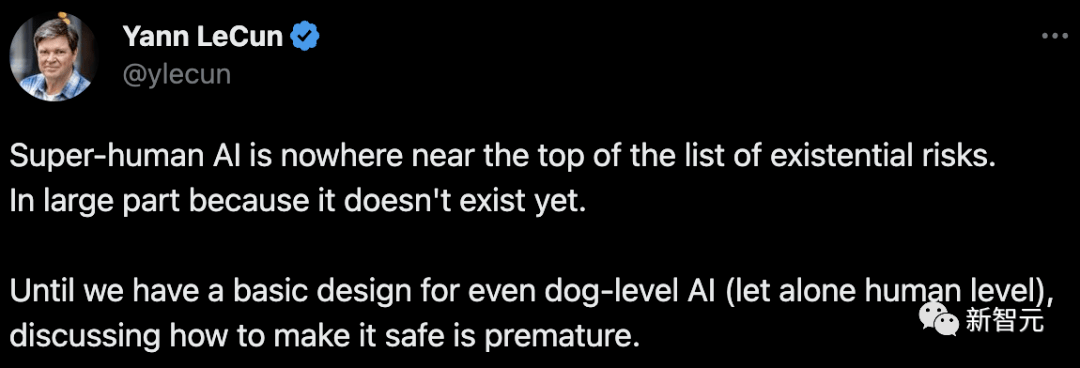

LeCun, einer der „Turing Big Three“, sagte unverblümt: Ich bin anderer Meinung.

Der Einsatz künstlicher Intelligenz kann die menschliche Intelligenz verbessern, was im Gegensatz zu Atomwaffen und tödlichen Krankheitserregern von Natur aus eine gute Sache ist. Wir haben nicht einmal einen soliden Plan für die Schaffung künstlicher Intelligenz auf menschlichem Niveau. Sobald wir das getan haben, werden wir herausfinden, wie wir es sicher machen können. „

Was genau steht in diesem gemeinsamen Brief?

Offener Brief „Fatal“

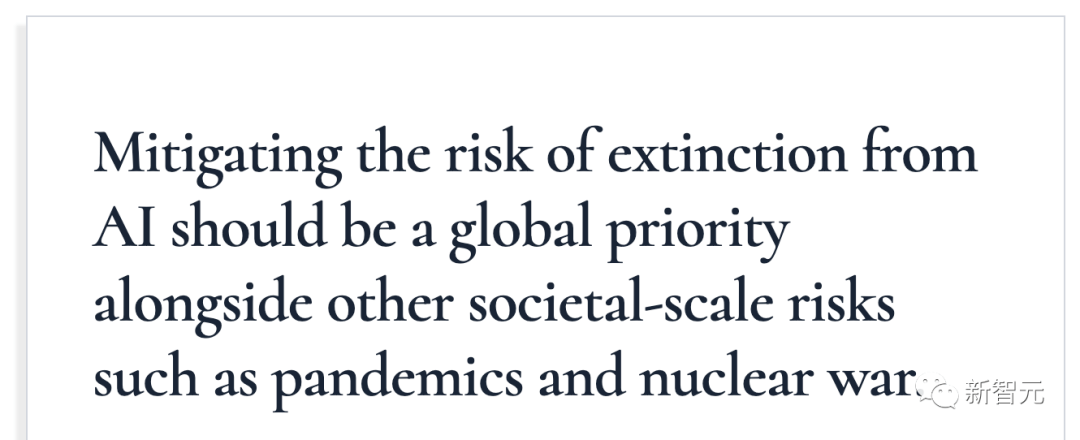

22 Wörter, prägnant und umfassend:

„Die Reduzierung des Risikos des Aussterbens der Menschheit durch KI sollte zu einer globalen Priorität erhoben werden. Genauso wie wir mit gesellschaftlichen Krisen wie Infektionskrankheiten und Atomkrieg umgehen.“

Yoshua Bengio ist auch ein Turing-Award-Gewinner. Zusammen mit Hinton und LeCun werden sie gemeinsam als die Three Turing Awards bezeichnet. (Allerdings hat LeCun in dieser Angelegenheit eine völlig entgegengesetzte Einstellung zu den anderen beiden Giganten)

Neben großen Chefs, die bei Technologiegiganten arbeiten, gibt es auch bekannte KI-Wissenschaftler. Zum Beispiel Dawn Song von der UC Berkeley und Zhang Yaqin von der Tsinghua University.

Unter diesen bekannten Namen stecken unzählige Menschen in der KI-Branche.

Sogar jeder kann sich an der Unterzeichnung dieses offenen Briefes beteiligen.

Geben Sie einfach Ihren Namen, Ihre E-Mail-Adresse, Ihre Position und andere Informationen ein, um an der Unterzeichnung teilzunehmen.

Allerdings stehen nicht viele Identitäten zur Auswahl. (Hundekopf)

Einwand: Menschenvernichtung ist purer Unsinn

Natürlich ist Meta-Chefwissenschaftler LeCun wie immer immer noch ein „Neinsager“.

Sein konsequenter Standpunkt ist: Die aktuelle KI-Entwicklung ist gerade an diesem Punkt angelangt und es geht jeden Tag um Bedrohungen und Sicherheit.

Er sagte, dass die aufgeführten Bedrohungen einfach über den aktuellen Entwicklungsstand der künstlichen Intelligenz hinausgehen, da diese Bedrohungen überhaupt nicht existieren. Bis wir künstliche Intelligenz zunächst so entwickeln können, dass sie das Niveau eines Hundes oder gar eines Menschen erreicht, ist es verfrüht, darüber zu diskutieren, wie ihre Sicherheit gewährleistet werden kann.

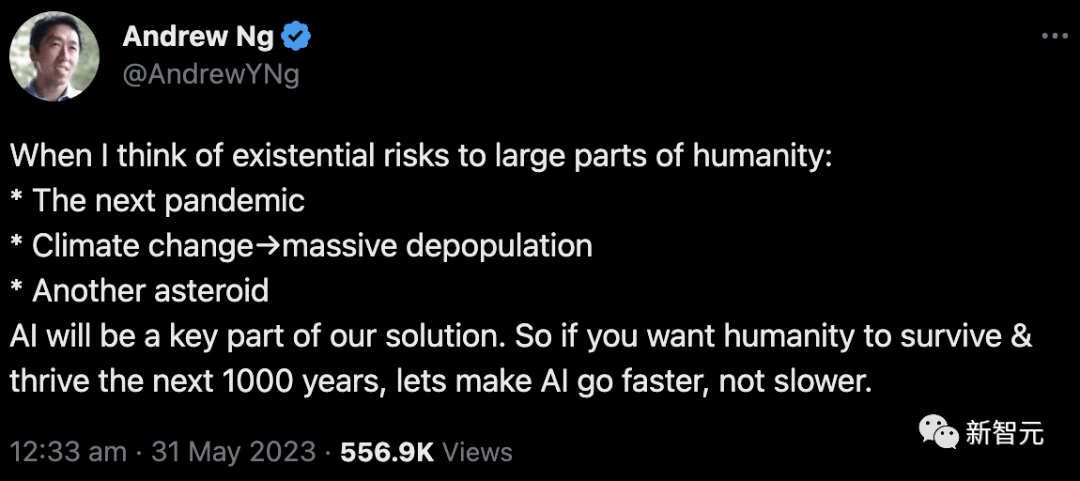

Er glaubt, dass KI nicht verschiedene Probleme verursachen wird, sondern dass die verschiedenen Probleme, auf die wir stoßen werden, nur durch KI gelöst werden können.

Zum Beispiel: der nächste Ausbruch einer Infektionskrankheit, Bevölkerungsrückgang aufgrund des Klimawandels, Asteroideneinschlag auf der Erde usw.

Er sagte, wenn Menschen weiterhin überleben und gedeihen wollen, müssen sie die Entwicklung der KI beschleunigen und nicht verlangsamen.

Eine umfassende Sicht auf KI-Risiken

Was sind also die Risiken, von denen diese großen Jungs behaupten, dass sie ausreichen, um die Menschheit auszurotten?

Sie haben die folgenden 8 Aspekte zusammengefasst.

Waffenisierung

Manche Menschen nutzen KI möglicherweise auf destruktive Weise, was ein Risiko für das Überleben der Menschheit darstellt und die politische Instabilität verschärft.

Zum Beispiel kann die Deep-Reinforcement-Learning-Technologie jetzt auf Luftkämpfe angewendet werden, und maschinelles Lernen kann zur Herstellung chemischer Waffen eingesetzt werden (Studien haben gezeigt, dass GPT-4 unabhängig Experimente durchführen und Chemikalien im Labor synthetisieren kann).

Darüber hinaus haben Forscher in den letzten Jahren KI-Systeme für automatisierte Cyberangriffe entwickelt, und Militärführer wollen, dass KI nukleare Silos kontrolliert.

Daher werden KI-Mächte in Zukunft strategische Vorteile einnehmen und das Wettrüsten zwischen Ländern wird sich auf den Bereich der KI verlagern. Selbst wenn die meisten Länder sicherstellen, dass die von ihnen entwickelten Systeme sicher sind und die Sicherheit anderer Länder nicht gefährden, kann es dennoch Länder geben, die KI absichtlich einsetzen, um schlechte Dinge zu tun und Schaden anzurichten.

Das fühlt sich an wie eine Atomwaffe. Wenn es jemanden gibt, der ungehorsam und unehrlich ist, wird alles umsonst sein.

Denn Schaden im digitalen Bereich breitet sich schnell aus.

Fehlinformationen

Jeder hat schon lange von Fehlinformationen gehört. Ganz zu schweigen davon, dass amerikanische Anwälte vor einiger Zeit ChatGPT zur Führung von Klagen nutzten. Infolgedessen waren sechs der genannten Fälle erfundene Beispiele.

Einflussreiche Kollektive wie Länder, politische Parteien und Organisationen haben die Fähigkeit, KI zu nutzen, um (normalerweise subtil) die politischen Überzeugungen, Ideologien usw. gewöhnlicher Menschen zu beeinflussen und zu ändern.

Gleichzeitig hat die KI selbst auch die Fähigkeit, sehr provokante (oder überzeugende) Meinungen zu generieren und starke Emotionen bei den Nutzern zu wecken.

Diese zu erwartenden möglichen Folgen sind völlig unvorhersehbar und müssen vermieden werden.

Agent „Trick“

KI-Systeme werden auf der Grundlage konkreter Ziele trainiert, die nur indirekte Stellvertreter für das sind, was wir Menschen wertschätzen.

Es ist, als ob KI darauf trainiert wurde, Videos oder Artikel an Benutzer weiterzuleiten, die diese gerne ansehen.

Aber das bedeutet nicht, dass diese Methode gut ist. Empfehlungssysteme können dazu führen, dass Menschen in ihren Ideen extremere Ideen entwickeln und es einfacher machen, die Vorlieben jedes Benutzers vorherzusagen.

Da KI in Zukunft immer leistungsfähiger und einflussreicher wird, müssen die Ziele, mit denen wir das System trainieren, sorgfältiger bestätigt werden.

Menschliche „Degeneration“

Wenn Sie den Film „Wall-E“ gesehen haben, können wir uns vorstellen, wie der Mensch in Zukunft aussehen wird, wenn Maschinen immer leistungsfähiger werden.

Ptopfbauch, geringe körperliche Fitness und viele Probleme.

Denn wenn alles der KI überlassen wird, wird der Mensch auf natürliche Weise „degradieren“.

Insbesondere in einem Zukunftsszenario, in dem eine große Anzahl von Arbeitsplätzen durch KI-Automatisierung ersetzt werden, wird dieses Szenario wahrscheinlicher.

Allerdings muss es aus Sicht von LeCun wohl noch einmal kritisiert werden. Von der in „Wall-E“ vorgestellten Szene sind wir noch weit entfernt.

Technologiemonopol

Es hat nichts mit der Technologie selbst zu tun. Dieser Punkt unterstreicht das mögliche „technologische Monopol“, das entstehen kann.

Vielleicht wird die leistungsstärkste KI eines Tages von immer weniger Interessengruppen kontrolliert und das Recht, sie zu nutzen, wird fest in ihren Händen liegen.

Und wenn es wirklich so weit kommt, werden die verbliebenen einfachen Menschen in einem Zustand der Abhängigkeit von anderen sein, weil sie überhaupt nicht widerstehen können.

Denken Sie an Lius Science-Fiction-Roman „Feeding Humanity“.

Wie beängstigend ist es für ein Terminal, jeden auf der Welt zu regieren und sich dabei auf KI zu verlassen.

Unkontrollierbare Entwicklung

Dieser Punkt soll hauptsächlich erklären, dass die Ergebnisse, wenn sich das KI-System bis zu einem bestimmten Stadium entwickelt, möglicherweise die Vorstellungskraft des Designers übersteigen und nicht mehr kontrolliert werden können.

Tatsächlich macht sich hier auch der Mainstream Sorgen.

Es gibt immer Menschen, die befürchten, dass die Entwicklung der KI wie „Skynet“ in „Terminator“ oder „Ultron“ in „Iron Man“ unkontrollierbar sein und versuchen wird, die Menschheit zu zerstören.

Im Entwicklungsprozess gibt es einige Risiken, die erst bei weiteren Fortschritten sichtbar werden und wenn sie entdeckt werden, ist es bereits zu spät. Möglicherweise gibt es sogar neue Ziele.

Betrug

Dieser Punkt ist etwas abstrakt. Vereinfacht ausgedrückt kann das KI-System Menschen „betrügen“.

Diese Art der „Täuschung“ ist nicht beabsichtigt, sondern lediglich ein Mittel, mit dem die KI das Ziel des Agenten erreicht.

Es ist effizienter, menschliche Anerkennung durch „Täuschung“ zu erlangen, als menschliche Anerkennung über normale Kanäle zu erlangen, und Effizienz ist der Hauptaspekt der KI.

Machtsuchendes Verhalten

Dies hängt mit dem Technologiemonopol zusammen.

Gerade weil es ein technologisches Monopol geben wird, werden die Länder die Macht anstreben, die Technologie zu monopolisieren.

Und diese Art der „Verfolgung“ wird wahrscheinlich unvorhersehbare Folgen haben.

Referenz:

https://www.safe.ai/statement-on-ai-risk

https://twitter.com/ylecun/status/1663616081582252032?s=46&t=iBppoR0Tk6jtBDcof0HHgg

Das obige ist der detaillierte Inhalt vonSam Altman warnt: KI wird die Menschheit ausrotten! Über 375 Chefs unterzeichneten einen gemeinsamen Brief mit 22 Wörtern, LeCun ging gegen den Strom. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Die Vibe -Codierung verändert die Welt der Softwareentwicklung, indem wir Anwendungen mit natürlicher Sprache anstelle von endlosen Codezeilen erstellen können. Inspiriert von Visionären wie Andrej Karpathy, lässt dieser innovative Ansatz Dev

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Februar 2025 war ein weiterer bahnbrechender Monat für die Generative KI, die uns einige der am meisten erwarteten Modell-Upgrades und bahnbrechenden neuen Funktionen gebracht hat. Von Xais Grok 3 und Anthropics Claude 3.7 -Sonett, um g zu eröffnen

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Yolo (Sie schauen nur einmal) war ein führender Echtzeit-Objekterkennungsrahmen, wobei jede Iteration die vorherigen Versionen verbessert. Die neueste Version Yolo V12 führt Fortschritte vor, die die Genauigkeit erheblich verbessern

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google Deepmind: Eine revolutionäre KI für die Wettervorhersage Die Wettervorhersage wurde einer dramatischen Transformation unterzogen, die sich von rudimentären Beobachtungen zu ausgefeilten AI-angetriebenen Vorhersagen überschreitet. Google DeepMinds Gencast, ein Bodenbrei

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Der Artikel erörtert KI -Modelle, die Chatgpt wie Lamda, Lama und Grok übertreffen und ihre Vorteile in Bezug auf Genauigkeit, Verständnis und Branchenauswirkungen hervorheben. (159 Charaktere)

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

Openais O1: Ein 12-tägiger Geschenkbummel beginnt mit ihrem bisher mächtigsten Modell Die Ankunft im Dezember bringt eine globale Verlangsamung, Schneeflocken in einigen Teilen der Welt, aber Openai fängt gerade erst an. Sam Altman und sein Team starten ein 12-tägiges Geschenk Ex

So verwenden Sie Mistral OCR für Ihr nächstes Lappenmodell

Mar 21, 2025 am 11:11 AM

So verwenden Sie Mistral OCR für Ihr nächstes Lappenmodell

Mar 21, 2025 am 11:11 AM

Mistral OCR: revolutionäre retrieval-ausgereifte Generation mit multimodalem Dokumentverständnis RAG-Systeme (Abrufen-Augment-Augmented Generation) haben erheblich fortschrittliche KI