Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Aktuelles Interview mit OpenAI-Gründer Sam Altman: GPT-3 oder Open Source, Skalierungsregeln beschleunigen den Aufbau von AGI

Aktuelles Interview mit OpenAI-Gründer Sam Altman: GPT-3 oder Open Source, Skalierungsregeln beschleunigen den Aufbau von AGI

Aktuelles Interview mit OpenAI-Gründer Sam Altman: GPT-3 oder Open Source, Skalierungsregeln beschleunigen den Aufbau von AGI

Produziert von Big Data Digest

„Uns mangelt es sehr an GPUs“

In einem aktuellen Interview antwortete Sam Altman, der Leiter von OpenAI, auf die Frage des Gastgebers: „Die Unzufriedenheit liegt in der Zuverlässigkeit und Geschwindigkeit der API.“ "

Dieses Interview stammt von Raza Habib, CEO des Startups für künstliche Intelligenz Humanloop. Er hat die Highlights des Interviews auf Twitter zusammengestellt.

Twitter-Adresse:

https://twitter.com/dr_cintas/status/1664281914948337664

In diesem Interview kündigte Altman auch den GPT-Plan für die letzten zwei Jahre an, beispielsweise den Plan für 2023 Es geht darum, die Kosten von GPT-4 zu senken und die Reaktionsgeschwindigkeit zu verbessern.

Ein längeres Kontextfenster, das 1 Million Token unterstützen kann.

3. API, die den Sitzungsstatus unterstützt, d. h. API, die den Sitzungsstatus unterstützt.

Der Plan für 2024 sieht vor, dass GPT-4 die Multimodalität unterstützt. Der Grund, warum er auf 2024 verschoben wurde, ist, dass zu wenig GPU vorhanden ist.

Raza Habib veröffentlichte ursprünglich detailliertere Informationen zu diesem Interview gegenüber Humanloop, aber als Digest heute Morgen nachschaute, hatte die Seite bereits den Status 404. Laut der Übersetzung von @宝玉xp auf inländischem Weibo erwähnte er auch die Skalierungsregeln für die zukünftige Entwicklung großer Modelle:

Die internen Daten von OpenAI zeigen, dass die Skalierungsregeln für die Modellleistung weiterhin wirksam sind und das Modell größer machen wird weiterhin Leistung erbringen. OpenAI hat seine Modelle millionenfach skaliert und kann daher nicht in einem Tempo weiter skalieren, das in Zukunft nicht mehr nachhaltig sein wird. Das bedeutet nicht, dass OpenAI nicht weiterhin versuchen wird, Modelle größer zu machen, sondern nur, dass sie sich wahrscheinlich jedes Jahr nur verdoppeln oder verdreifachen werden, anstatt um viele Größenordnungen zu wachsen.

Die Tatsache, dass die Skalierung weiterhin effektiv ist, hat wichtige Auswirkungen auf den Zeitplan der AGI-Entwicklung. Die Skalierungsannahme ist, dass wir wahrscheinlich bereits über die meisten Teile verfügen, die zum Aufbau einer AGI erforderlich sind, und der Großteil der verbleibenden Arbeit darin bestehen wird, bestehende Methoden auf größere Modelle und größere Datensätze zu skalieren. Wenn die Ära der Skalierung vorbei ist, sollten wir wahrscheinlich damit rechnen, dass AGI noch weiter entfernt sein wird. Dass das Gesetz der Skalierung weiterhin in Kraft ist, deutet stark auf eine kürzere Zeitspanne hin.

Offensichtlich ist das Gesetz der Skalierung der schnellste Weg zur AGI.

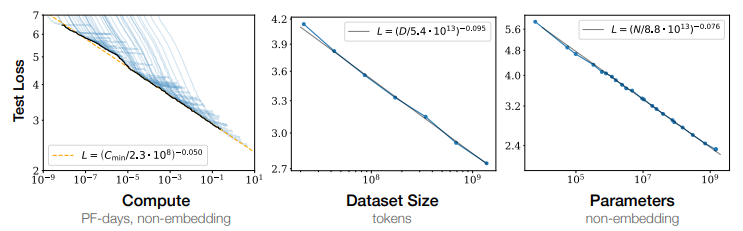

Was ist die Skalierungsregel?

Mit anderen Worten, wenn die Anzahl der Parameter (Parameter) des Modells, die Menge der am Training beteiligten Daten (Tokens) und die Menge der während des Trainingsprozesses akkumulierten Berechnungen (FLOPS) exponentiell zunehmen, kommt es zum Verlust des Modells auf dem Testsatz nimmt linear ab, was bedeutet, dass die Wirkung des Modells besser ist.

Im Jahr 2022 führte DeepMind weitere Analysen in ScalingLaw durch. Die Forschung hat durch quantitative Experimente bestätigt, dass die Größe der Sprachmodell-Trainingsdaten proportional zur Größe der Modellparameter vergrößert werden sollte. Wenn der Gesamtberechnungsumfang unverändert bleibt, weist der Effekt des Modelltrainings einen optimalen Gleichgewichtspunkt zwischen der Parametergröße und der Trainingsdatenmenge auf. Der niedrigste Punkt unter der Kurve ist ein sehr guter Kompromiss zwischen der Parametergröße und der Trainingsdatenmenge. Punkt.

Der Erfolg von OpeaAI und GPT-4

OpenAI war ursprünglich ein gemeinnütziges Forschungslabor für künstliche Intelligenz, das 2016 von Sam Altman und Elon Musk eine Milliarde US-Dollar an Fördermitteln erhielt.

Im Jahr 2019 verwandelte sich OpenAI in ein gewinnorientiertes Forschungslabor für künstliche Intelligenz, um Investorengelder aufzunehmen.

Als dem Labor die Mittel zur Unterstützung seiner Forschung ausgehen, kündigte Microsoft an, eine weitere Milliarde US-Dollar in das Labor zu investieren.

Jede Version der von OpenAI gestarteten GPT-Reihe kann für Karneval in der Branche sorgen. Auf der Microsoft Build 2023-Entwicklerkonferenz hielt OpenAI-Gründer Andrej Karpthy eine Rede: „State of GPT“ (die aktuelle Situation von GPT) und sagte, dass dies schon immer der Fall gewesen sei Betrachtet wird das Modell als „menschliches Gehirn“.

Andrej erwähnte, dass das aktuelle große LLM-Sprachmodell mit System 1 (schnelles System) des menschlichen Denkmodus verglichen werden kann, das mit System 2 (langsames System) verglichen wird, das langsam reagiert, aber über längerfristige Überlegungen verfügt.

„System eins ist ein schneller, automatischer Prozess, der meiner Meinung nach in gewisser Weise dem LLM entspricht, nur das Abtasten von Markern

System zwei ist der langsamere, gut durchdachte Planungsteil des Gehirns

Und im Grunde die Hoffnung.“ ist, dass LLM einige der Fähigkeiten unseres Gehirns wiederherstellen kann.“

Andrej Karpthy erwähnte auch, dass GPT-4 ein erstaunliches Artefakt ist und er für seine Existenz sehr dankbar ist. Es verfügt über eine Menge Wissen in vielen Bereichen, es kann Mathematik, Code und mehr erledigen, alles auf Knopfdruck.

Und CEO Altman sagte, dass GPT-4 in der Anfangszeit sehr langsam war, Fehler hatte und viele Dinge schlecht machte. Aber das galt auch für die ersten Computer, die den Weg zu etwas wiesen, das in unserem Leben sehr wichtig werden würde, auch wenn die Entwicklung Jahrzehnte dauerte.

Es scheint, dass OpenAI eine Organisation ist, die auf Träumen besteht und ein Unternehmen, das Dinge bis zum Äußersten tun will.

Wie Zhou Ming, ehemaliger Vizepräsident von Microsoft Research Asia und Gründer von Lanzhou Technology, in einem Interview erwähnte:

OpenAIs größte Errungenschaft besteht darin, in allen Aspekten Perfektion zu erreichen, und es ist ein Modell für integrierte Innovation.

Es gibt verschiedene Arten von Menschen auf der Welt. Manche Menschen wollen einfach nur die zugrunde liegende Innovation studieren. Bei einigen handelt es sich um Anwendungen, die auf zugrunde liegenden Innovationen basieren, während allgemeine Anwendungen eine einzelne Aufgabe lösen sollen. Es kann wie folgt umgeschrieben werden: Ein anderer Ansatz besteht darin, integrierte Innovationen zu erreichen, indem alle Arbeiten, Anwendungen und Algorithmen auf einer großen Plattform konzentriert werden, um Meilensteine zu schaffen. OpenAI leistet wirklich gute Arbeit bei der Integration von Innovationen. T Referenz: tHttps: //mp.weixin.qq.com/s/p42pbvyjzws8xsstdor2jw https://mp.weixin.qq.com/s/zmegzm1cdxupnoqzyg https://weibo.com. /1727858283/4907695679472174?wm=3333_2001&from=10D 5293010&Quellentyp =weixin&s_trans=6289897940_4907695679472174&s_channel=4 https://humanloop.com/blog/openai-plans?cnotallow=bd9e7 6a5f41a6d847de52fa275480e22

Das obige ist der detaillierte Inhalt vonAktuelles Interview mit OpenAI-Gründer Sam Altman: GPT-3 oder Open Source, Skalierungsregeln beschleunigen den Aufbau von AGI. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

So überprüfen Sie schnell die Numpy-Version

Jan 19, 2024 am 08:23 AM

So überprüfen Sie schnell die Numpy-Version

Jan 19, 2024 am 08:23 AM

Numpy ist eine wichtige Mathematikbibliothek in Python. Sie bietet effiziente Array-Operationen und wissenschaftliche Berechnungsfunktionen und wird häufig in den Bereichen Datenanalyse, maschinelles Lernen, Deep Learning und anderen Bereichen verwendet. Bei der Verwendung von Numpy müssen wir häufig die Versionsnummer von Numpy überprüfen, um die von der aktuellen Umgebung unterstützten Funktionen zu ermitteln. In diesem Artikel erfahren Sie, wie Sie die Numpy-Version schnell überprüfen und spezifische Codebeispiele bereitstellen. Methode 1: Verwenden Sie das __version__-Attribut, das mit numpy geliefert wird. Das numpy-Modul wird mit einem __ geliefert.

So überprüfen Sie die Maven-Version

Jan 17, 2024 pm 05:06 PM

So überprüfen Sie die Maven-Version

Jan 17, 2024 pm 05:06 PM

Methoden zum Überprüfen der Maven-Version: 1. Verwenden Sie die Befehlszeile. 3. Überprüfen Sie die IDE. Detaillierte Einführung: 1. Verwenden Sie die Befehlszeile, geben Sie „mvn -v“ oder „mvn --version“ in die Befehlszeile ein und drücken Sie dann die Eingabetaste. Dadurch werden die Maven-Versionsinformationen und die Java-Versionsinformationen angezeigt Variablen: Auf einigen Systemen können Sie die Umgebungsvariablen überprüfen, um die Maven-Versionsinformationen zu finden, den Befehl in die Befehlszeile eingeben und dann die Eingabetaste drücken usw.

Tutorial zum Aktualisieren der Curl-Version unter Linux!

Mar 07, 2024 am 08:30 AM

Tutorial zum Aktualisieren der Curl-Version unter Linux!

Mar 07, 2024 am 08:30 AM

Um die Curl-Version unter Linux zu aktualisieren, können Sie die folgenden Schritte ausführen: Überprüfen Sie die aktuelle Curl-Version: Zunächst müssen Sie die im aktuellen System installierte Curl-Version ermitteln. Öffnen Sie ein Terminal und führen Sie den folgenden Befehl aus: curl --version Dieser Befehl zeigt die aktuellen Informationen zur Curl-Version an. Verfügbare Curl-Version bestätigen: Bevor Sie Curl aktualisieren, müssen Sie die neueste verfügbare Version bestätigen. Sie können die offizielle Website von Curl (curl.haxx.se) oder verwandte Softwarequellen besuchen, um die neueste Version von Curl zu finden. Laden Sie den Curl-Quellcode herunter: Laden Sie mit Curl oder einem Browser die Quellcodedatei für die Curl-Version Ihrer Wahl herunter (normalerweise .tar.gz oder .tar.bz2).

Überprüfen Sie die Version des Kirin-Betriebssystems und des Kernels

Feb 21, 2024 pm 07:04 PM

Überprüfen Sie die Version des Kirin-Betriebssystems und des Kernels

Feb 21, 2024 pm 07:04 PM

Überprüfen der Kylin-Betriebssystemversion und der Kernelversion Im Kirin-Betriebssystem ist das Wissen, wie die Systemversion und die Kernelversion überprüft werden, die Grundlage für die Systemverwaltung und -wartung. Methode 1 zum Überprüfen der Kylin-Betriebssystemversion: Verwenden Sie die Datei /etc/.kyinfo. Um die Kylin-Betriebssystemversion zu überprüfen, können Sie die Datei /etc/.kyinfo überprüfen. Diese Datei enthält Informationen zur Betriebssystemversion. Führen Sie den folgenden Befehl aus: cat/etc/.kyinfo Dieser Befehl zeigt detaillierte Versionsinformationen des Betriebssystems an. Methode 2: Verwenden Sie die Datei /etc/issue. Eine andere Möglichkeit, die Betriebssystemversion zu überprüfen, besteht darin, sich die Datei /etc/issue anzusehen. Diese Datei enthält auch Versionsinformationen, ist jedoch möglicherweise nicht so gut wie die .kyinfo-Datei

Einfache Schritte zum Aktualisieren der Pip-Version: in 1 Minute erledigt

Jan 27, 2024 am 09:45 AM

Einfache Schritte zum Aktualisieren der Pip-Version: in 1 Minute erledigt

Jan 27, 2024 am 09:45 AM

In einer Minute erledigt: So aktualisieren Sie die Pip-Version. Mit der rasanten Entwicklung von Python ist Pip zu einem Standardtool für die Python-Paketverwaltung geworden. Mit der Zeit werden die Pip-Versionen jedoch ständig aktualisiert. Um die neuesten Funktionen nutzen und mögliche Sicherheitslücken schließen zu können, ist es sehr wichtig, die Pip-Version zu aktualisieren. In diesem Artikel wird erläutert, wie Sie Pip in einer Minute schnell aktualisieren können, und es werden spezifische Codebeispiele bereitgestellt. Zuerst müssen wir ein Befehlszeilenfenster öffnen. In Windows-Systemen können Sie verwenden

So überprüfen Sie ganz einfach die installierte Version von Oracle

Mar 07, 2024 am 11:27 AM

So überprüfen Sie ganz einfach die installierte Version von Oracle

Mar 07, 2024 am 11:27 AM

Um die installierte Version von Oracle einfach zu überprüfen, sind spezifische Codebeispiele erforderlich. Da es sich bei der Oracle-Datenbank um eine in Datenbankverwaltungssystemen auf Unternehmensebene weit verbreitete Software handelt, gibt es viele Versionen und unterschiedliche Installationsmethoden. In unserer täglichen Arbeit müssen wir häufig die installierte Version der Oracle-Datenbank auf entsprechende Betriebs- und Wartungsarbeiten überprüfen. In diesem Artikel erfahren Sie, wie Sie die installierte Version von Oracle einfach überprüfen können, und geben konkrete Codebeispiele. Methode 1: Durch SQL-Abfrage in der Oracle-Datenbank können wir

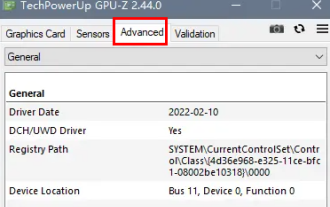

Wie kann man feststellen, ob die dp-Schnittstelle 1.2 oder 1.4 ist?

Feb 06, 2024 am 10:27 AM

Wie kann man feststellen, ob die dp-Schnittstelle 1.2 oder 1.4 ist?

Feb 06, 2024 am 10:27 AM

Die DP-Schnittstelle ist ein wichtiges Schnittstellenkabel im Computer. Viele Benutzer möchten wissen, wie sie überprüfen können, ob die DP-Schnittstelle 1.2 oder 1.4 ist. Tatsächlich müssen sie sie nur in GPU-Z überprüfen. So ermitteln Sie, ob die dp-Schnittstelle 1.2 oder 1.4 ist: 1. Wählen Sie zunächst „Erweitert“ in GPU-Z. 2. Schauen Sie sich „Monitor1“ in „Allgemein“ unter „Erweitert“ an, dort sehen Sie die beiden Punkte „LinkRate (aktuell)“ und „Lanes (aktuell)“. 3. Wenn schließlich 8,1 Gbit/s × 4 angezeigt wird, bedeutet dies DP1.3-Version oder höher, normalerweise DP1.4. Wenn es 5,4 Gbit/s × 4 ist

Nach 750.000 Runden Einzelkampf zwischen großen Modellen gewann GPT-4 die Meisterschaft und Llama 3 belegte den fünften Platz

Apr 23, 2024 pm 03:28 PM

Nach 750.000 Runden Einzelkampf zwischen großen Modellen gewann GPT-4 die Meisterschaft und Llama 3 belegte den fünften Platz

Apr 23, 2024 pm 03:28 PM

Zu Llama3 wurden neue Testergebnisse veröffentlicht – die große Modellbewertungs-Community LMSYS veröffentlichte eine große Modell-Rangliste, die Llama3 auf dem fünften Platz belegte und mit GPT-4 den ersten Platz in der englischen Kategorie belegte. Das Bild unterscheidet sich von anderen Benchmarks. Diese Liste basiert auf Einzelkämpfen zwischen Modellen, und die Bewerter aus dem gesamten Netzwerk machen ihre eigenen Vorschläge und Bewertungen. Am Ende belegte Llama3 den fünften Platz auf der Liste, gefolgt von drei verschiedenen Versionen von GPT-4 und Claude3 Super Cup Opus. In der englischen Einzelliste überholte Llama3 Claude und punktgleich mit GPT-4. Über dieses Ergebnis war Metas Chefwissenschaftler LeCun sehr erfreut und leitete den Tweet weiter