Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Ohne die Notwendigkeit, riesige Datenmengen zu kennzeichnen, bringt das neue Paradigma der Zielerkennung OVD die multimodale AGI einen Schritt weiter

Ohne die Notwendigkeit, riesige Datenmengen zu kennzeichnen, bringt das neue Paradigma der Zielerkennung OVD die multimodale AGI einen Schritt weiter

Ohne die Notwendigkeit, riesige Datenmengen zu kennzeichnen, bringt das neue Paradigma der Zielerkennung OVD die multimodale AGI einen Schritt weiter

Die Zielerkennung ist eine sehr wichtige Grundaufgabe in der Computer-Vision. Bei der Zielerkennung muss das Modell zusätzlich zur gegebenen Zielkategorie auch die Positions- und Größeninformationen angeben Aufgrund der Hauptaufgaben des Lebenslaufs (Identifizierung, Erkennung und Segmentierung) kommt ihm eine Schlüsselposition als Bindeglied zwischen der Vergangenheit und der Zukunft zu.

Der derzeit beliebte multimodale GPT-4 verfügt nur über die Fähigkeit zur Zielerkennung in Bezug auf die visuellen Fähigkeiten und ist nicht in der Lage, schwierigere Zielerkennungsaufgaben zu lösen. Das Erkennen der Kategorie-, Standort- und Größeninformationen von Objekten in Bildern oder Videos ist der Schlüssel zu vielen Anwendungen der künstlichen Intelligenz in der realen Produktion, wie z. B. der Fußgänger- und Fahrzeugerkennung beim autonomen Fahren, der Gesichtserkennung bei Sicherheitsüberwachungsanwendungen und der medizinischen Bildanalyse von Tumoren , usw.

Bestehende Zielerkennungsmethoden wie die YOLO-Serie, die R-CNN-Serie und andere Zielerkennungsalgorithmen haben aufgrund der kontinuierlichen Bemühungen wissenschaftlicher Forscher jedoch eine hohe Zielerkennungsgenauigkeit und -effizienz erreicht Modelltraining Definieren Sie einfach den Satz (geschlossener Satz) der zu erkennenden Ziele, sodass sie keine Ziele außerhalb des Trainingssatzes erkennen können. Darüber hinaus können vorhandene Methoden nicht zum Erkennen von Fahrzeugen verwendet werden Wenn bei gekennzeichneten Daten die zu erkennenden Zielkategorien hinzugefügt oder geändert werden müssen, müssen einerseits die Trainingsdaten neu gekennzeichnet werden und andererseits muss das Modell neu gekennzeichnet werden -geschult, was zeit- und arbeitsintensiv ist.

Eine mögliche Lösung besteht darin, umfangreiche Bilder zu sammeln und Box-Informationen und semantische Informationen manuell zu kennzeichnen. Dies erfordert jedoch extrem hohe Kennzeichnungskosten, und die Verwendung umfangreicher Daten zum Trainieren des Erkennungsmodells stellt auch wissenschaftliche Forscher vor Herausforderungen Die Long-Tail-Verteilung der Daten und die instabile Qualität der manuellen Annotation wirken sich auf die Leistung des Erkennungsmodells aus.

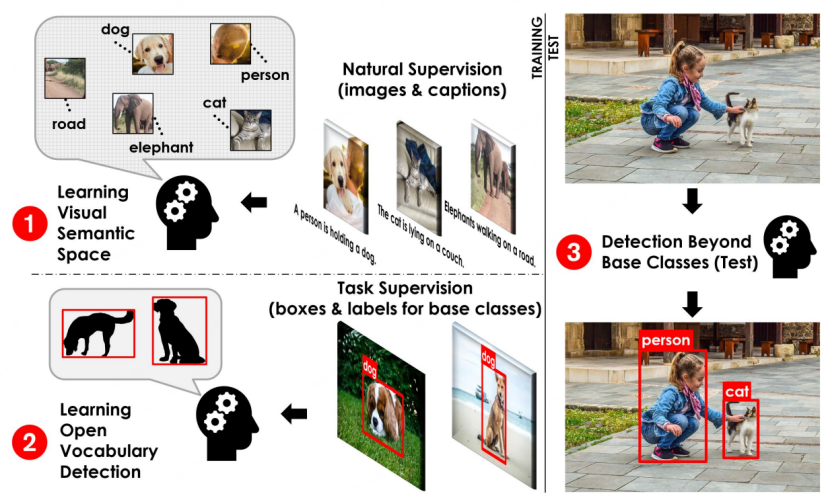

Der in CVPR 2021 veröffentlichte Artikel OVR-CNN [1] schlägt ein neues Zielerkennungsparadigma vor: Open-Vocabulary Detection (OVD, auch bekannt als Open-World-Zielerkennung) zur Bewältigung des oben genannten Problems ist das Erkennungsszenario von unbekannte Objekte in der offenen Welt.

OVD hat seit seiner Einführung kontinuierliche Aufmerksamkeit in Wissenschaft und Industrie auf sich gezogen, da es in der Lage ist, eine beliebige Anzahl und Kategorie von Zielen zu identifizieren und zu lokalisieren, ohne die Menge der annotierten Daten manuell zu erweitern, und hat auch großen Erfolg bei der klassischen Zielerkennung gebracht Es bringt neue Vitalität und neue Herausforderungen mit sich und wird voraussichtlich zu einem neuen Paradigma für die Zielerkennung werden.

Insbesondere erfordert die OVD-Technologie keine manuelle Annotation von Massenbildern, um die Erkennungsfähigkeit des Erkennungsmodells für unbekannte Kategorien zu verbessern. Stattdessen wird ein klassenunabhängiger Bereichsdetektor mit einer guten Verallgemeinerung kombiniert Das auf unbeschrifteten Daten trainierte Modell wird kombiniert, um die Fähigkeit des Zielerkennungsmodells zu erweitern, Open-World-Ziele durch modalübergreifende Ausrichtung von Bildbereichsmerkmalen und beschreibendem Text des zu erkennenden Ziels zu verstehen.

Die kreuz- und multimodale Arbeit an großen Modellen wie CLIP [2], ALIGN [3] und R2D2 [4] usw. hat sich in letzter Zeit sehr schnell entwickelt, und ihre Entwicklung hat auch die Entstehung von OVD gefördert und das Gebiet der OVD. Schnelle Iteration und Weiterentwicklung verwandter Arbeiten.

Die OVD-Technologie beinhaltet die Lösung von zwei Schlüsselproblemen: 1) Wie kann die Anpassung zwischen Regionsinformationen und modalübergreifenden großen Modellen verbessert werden? 2) Wie kann die Verallgemeinerungsfähigkeit von kategorienübergreifenden Zieldetektoren verbessert werden? Aus diesen beiden Perspektiven werden im Folgenden einige verwandte Arbeiten im Bereich OVD ausführlich vorgestellt.

OVD-Grundprozessdiagramm [1]

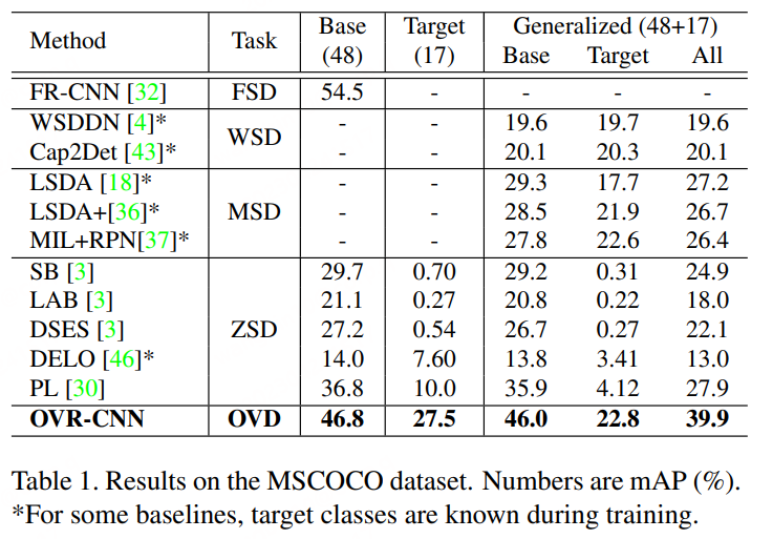

Grundlegende Konzepte von OVD: Die Verwendung von OVD umfasst hauptsächlich zwei Hauptszenarien: wenige Schüsse und Null-Schüsse, wenige Schüsse Es bezieht sich auf die Zielkategorie mit einer kleinen Anzahl manuell beschrifteter Trainingsbeispiele, während sich Zero-Shot auf die Zielkategorie ohne manuell beschriftete Trainingsbeispiele bezieht. In den häufig verwendeten akademischen Bewertungsdatensätzen COCO und LVIS ist der Datensatz in Basisklasse und Romanklasse unterteilt, wobei die Basisklasse dem Wenig-Schuss-Szenario und die Roman-Klasse dem Null-Schuss-Szenario entspricht. Beispielsweise enthält der COCO-Datensatz 65 Kategorien, und eine übliche Bewertungseinstellung besteht darin, dass der Basissatz 48 Kategorien enthält und nur diese 48 Kategorien im Training mit wenigen Schüssen verwendet werden. Das Novel-Set enthält 17 Kategorien, die während des Trainings völlig unsichtbar sind. Die Testindikatoren beziehen sich zum Vergleich hauptsächlich auf den AP50-Wert der Novel-Klasse.

Nr.Papieradresse: https://arxiv.org/pdf/2011.10678.pdf

#🎜 🎜#

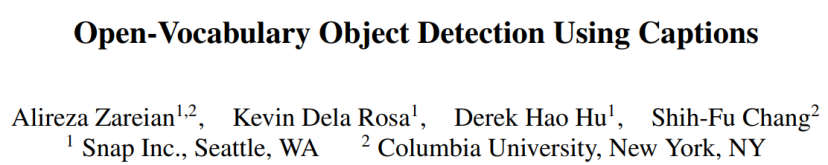

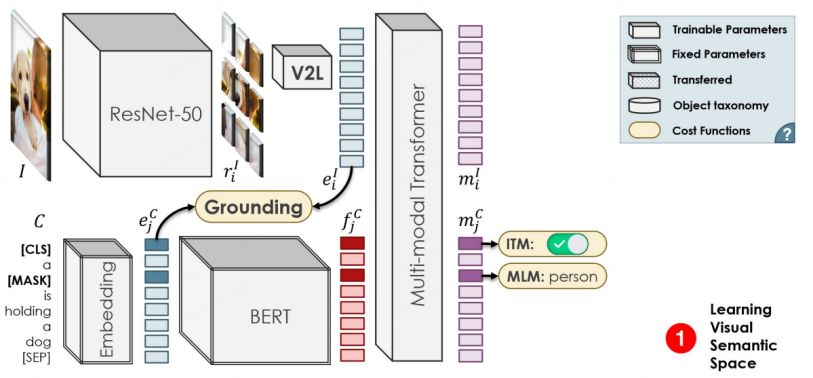

- OVR-CNN ist der mündliche Vortrag des CVPR 2021 und eine Pionierarbeit im OVD-Bereich. Sein zweistufiges Trainingsparadigma hat viele nachfolgende OVD-Arbeiten beeinflusst. Wie in der folgenden Abbildung dargestellt, verwendet die erste Stufe hauptsächlich Bildunterschriftenpaare, um den visuellen Encoder vorab zu trainieren. Dabei wird BERT (feste Parameter) zum Generieren von Wortmasken verwendet und ein schwach überwachter Grounding-Matching wird mit ResNet50 durchgeführt, das mit ImageNet geladen ist Aufgrund der vorab trainierten Gewichte geht der Autor davon aus, dass eine schwache Überwachung dazu führen wird, dass die Übereinstimmung in die lokale Optimalität fällt. Daher wird ein multimodaler Transformator zur Wortmaskenvorhersage hinzugefügt, um die Robustheit zu erhöhen.

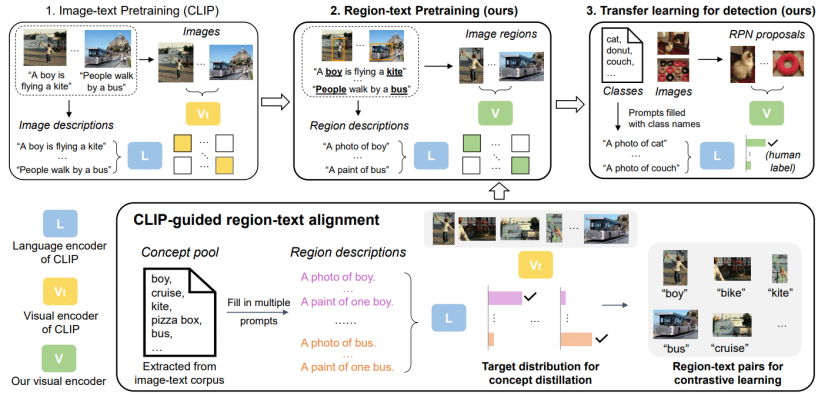

Papier 2: RegionCLIP: Regionsbasierte Sprache- Bild Pretraining

#🎜🎜 # Papieradresse: https ://arxiv.org/abs/2112.09106

Codeadresse: https://github.com/microsoft /RegionCLIP#🎜 ??? Im Rahmen der modalen Großmodellforschung haben wissenschaftliche Forscher damit begonnen, leistungsfähigere modalübergreifende Großmodelle wie CLIP und ALIGN zum Trainieren von OVD-Aufgaben zu verwenden. Das Detektormodell selbst zielt hauptsächlich auf die Klassifizierung und Identifizierung von Vorschlägen ab. RegionCLIP [5] hat im CVPR 2022 herausgefunden, dass die Klassifizierungsfähigkeit derzeit vorhandener großer Modelle wie CLIP für beschnittene Gebiete viel geringer ist Um die Klassifizierung des Originalbildes selbst zu verbessern, schlägt RegionCLIP ein neues zweistufiges OVD-Schema vor.

- In der ersten Phase verwendet der Datensatz hauptsächlich CC3M, COCO- Bildunterschrift usw. Der Bild-Text-Matching-Datensatz ist für die Destillation auf Regionsebene vorab trainiert. Konkret:

-

1. Extrahieren Sie die Wörter, die ursprünglich im Langtext vorhanden waren, um einen Konzeptpool zu bilden, und bilden Sie anschließend eine Reihe einfacher Beschreibungen über die Region für das Training.

2. Verwenden Sie RPN basierend auf dem LVIS-Vortraining, um Vorschlagsregionen zu extrahieren, und verwenden Sie Original-CLIP, um die extrahierten verschiedenen Regionen mit den vorbereiteten Beschreibungen abzugleichen und zu klassifizieren und sie weiter zu gefälschten semantischen Etiketten zusammenzusetzen.

3. Führen Sie ein Region-Text-Vergleichslernen mit dem neuen CLIP-Modell mit den vorbereiteten Vorschlagsregionen und semantischen Bezeichnungen durch und erhalten Sie dann ein CLIP-Modell, das auf Regionsinformationen spezialisiert ist.

4. Im Vorfeld des Trainings lernt das neue CLIP-Modell auch die Klassifizierungsfähigkeit des ursprünglichen CLIP durch die Destillationsstrategie und führt ein Bild-Text-Vergleichslernen auf der Vollbildebene durch, um den Ausdruck des neuen CLIP-Modells beizubehalten die vollständige Bildfähigkeit.

In der zweiten Stufe wird das erhaltene vorab trainierte Modell zum Transferlernen auf das Erkennungsmodell übertragen.

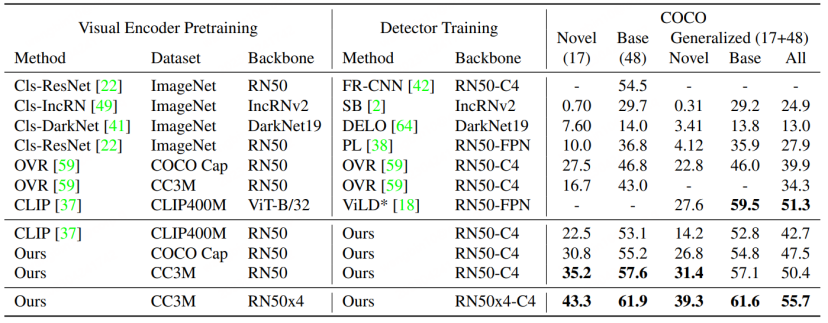

RegionCLIP erweitert die Darstellungsmöglichkeiten vorhandener modalübergreifender großer Modelle gegenüber herkömmlichen Erkennungsmodellen und erzielt eine bessere Leistung. Wie in der Abbildung unten gezeigt, ist RegionCLIP bei Verbesserungen in der Kategorie „Novel“ besser als OVR-CNN wurden gemacht. RegionCLIP verbessert effektiv die Anpassungsfähigkeit zwischen Regionsinformationen und multimodalen großen Modellen durch einstufiges Vortraining. CORA geht jedoch davon aus, dass die Trainingskosten steigen, wenn ein größeres modalübergreifendes großes Modell mit einer größeren Parameterskala für einstufiges Training verwendet wird sehr hoch sein. ?? Papieradresse: https://arxiv .org/abs/2303.13076

Codeadresse: https://github.com/tgxs002/CORA

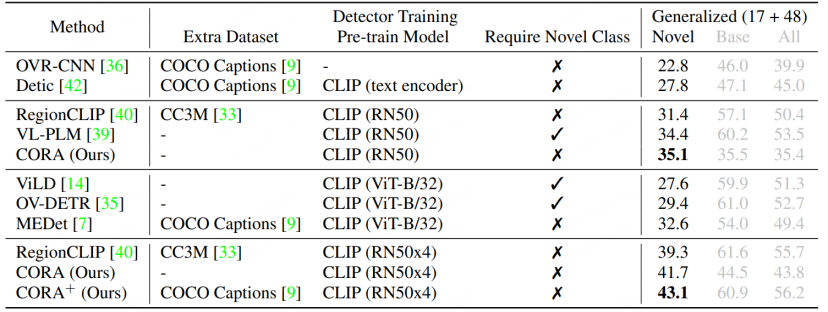

CORA [6] wurde in CVPR 2023 aufgenommen, um die aktuelle OVD zu überwinden Von ihm vorgeschlagen Um die beiden Hindernisse zu überwinden, mit denen diese Aufgabe konfrontiert ist, wurde ein DETR-ähnliches OVD-Modell entworfen. Wie im Titel des Artikels gezeigt, umfasst das Modell hauptsächlich zwei Strategien: Region Prompting und Anchor Pre-Matching. Ersteres nutzt die Prompt-Technologie, um die vom CLIP-basierten Regionalklassifikator extrahierten regionalen Merkmale zu optimieren und so die Verteilungslücke zwischen dem Ganzen und der Region zu verringern. Letzteres nutzt die Ankerpunkt-Pre-Matching-Strategie in der DETR-Erkennungsmethode, um die OVD zu verbessern Die Fähigkeit des Modells, neue Objekttypen zu positionieren.

- CLIP Es besteht eine Verteilungslücke zwischen den Gesamtbildmerkmalen und den regionalen Merkmalen des ursprünglichen visuellen Encoders, was wiederum zu einer geringeren Klassifizierungsgenauigkeit des Detektors führt (dies ähnelt dem Ausgangspunkt von RegionCLIP). ). Daher schlägt CORA Region Prompting vor, um sich an den CLIP-Bildcodierer anzupassen und die Klassifizierungsleistung regionaler Informationen zu verbessern. Konkret wird das gesamte Bild zunächst über die ersten drei Schichten des CLIP-Encoders in eine Feature-Map codiert. Anschließend werden durch RoI Align Ankerboxen oder Vorhersageboxen generiert und mit regionalen Features zusammengeführt. Dies wird dann von der vierten Schicht des CLIP-Bildkodierers kodiert. Um die Verteilungslücke zwischen der Vollbild-Feature-Map und den regionalen Features des CLIP-Bildencoders zu schließen, werden lernbare Regions-Prompts eingerichtet und mit den von der vierten Ebene ausgegebenen Features kombiniert, um die endgültigen regionalen Features zur Verwendung mit Text-Features zu generieren Für das Matching verwendet der Matching-Verlust einen naiven Kreuzentropieverlust, und alle mit CLIP verbundenen Parametermodelle werden während des Trainingsprozesses eingefroren.

CORA ist ein DETR-ähnliches Detektormodell, ähnlich wie DETR, das ebenfalls die Anker-Pre-Matching-Strategie verwendet, um im Voraus Kandidatenboxen für das Box-Regressionstraining zu generieren. Insbesondere ordnet der Anker-Vorabgleich jedes Label-Feld dem nächstgelegenen Satz von Anker-Feldern zu, um zu bestimmen, welche Anker-Felder als positive Proben und welche als negative Proben betrachtet werden sollten. Dieser Matching-Prozess basiert normalerweise auf der IoU (Intersection-over-Union-Ratio). Wenn die IoU zwischen der Ankerbox und der Labelbox einen vordefinierten Schwellenwert überschreitet, wird sie als positive Stichprobe betrachtet, andernfalls wird sie als negative Stichprobe betrachtet. CORA zeigt, dass diese Strategie die Verallgemeinerung von Lokalisierungsfähigkeiten auf neue Kategorien effektiv verbessern kann.

Die Verwendung des Anker-Pre-Matching-Mechanismus bringt jedoch auch einige Probleme mit sich. Beispielsweise kann er nur dann normal funktionieren, wenn mindestens ein Ankerfeld mit dem Etikettenfeld übereinstimmt. Zug. Andernfalls wird das Beschriftungsfeld ignoriert, wodurch eine Modellkonvergenz verhindert wird. Selbst wenn das Beschriftungsfeld ein genaueres Ankerpunktfeld erhält, wird das Beschriftungsfeld aufgrund der begrenzten Erkennungsgenauigkeit des Regionsklassifikators möglicherweise immer noch ignoriert, dh die dem Beschriftungsfeld entsprechenden Kategorieinformationen stimmen nicht mit dem überein Regionsklassifikator basierend auf CLIP-Training. Daher nutzt CORA die CLIP-Aligned-Technologie, um die semantischen Erkennungsfähigkeiten von CLIP und die Positionierungsfähigkeiten des vorab trainierten ROI zu nutzen, um die Bilder im Trainingsdatensatz mit weniger Personalaufwand neu zu kennzeichnen. Mit dieser Technologie kann das Modell währenddessen trainiert werden Training Ordnen Sie mehr Tag-Boxen zu.

Verglichen mit RegionCLIP hat CORA den COCO-Datensatz AP50 weiter verbessert Wert von 2,4.

Zusammenfassung und Ausblick

Die OVD-Technologie ist nicht nur eng mit der Entwicklung der derzeit beliebten Cross-/Multimodal-Großmodelle verbunden, sondern auch unternimmt In der Vergangenheit haben wissenschaftliche Forscher Technologien im Bereich der Zielerkennung angehäuft, die eine erfolgreiche Verbindung zwischen traditioneller KI-Technologie und der Erforschung allgemeiner KI-Fähigkeiten darstellen. OVD ist eine neue Zielerkennungstechnologie mit Zukunft. Es ist zu erwarten, dass die Fähigkeit von OVD, jedes Ziel zu erkennen und zu lokalisieren, wiederum die Weiterentwicklung multimodaler Großmodelle vorantreiben wird und voraussichtlich zu einem wichtigen Eckpfeiler der multimodalen AGI werden wird in der Entwicklung. Derzeit ist die Trainingsdatenquelle großer multimodaler Modelle eine große Anzahl grober Informationspaare im Internet, also Text-Bild-Paare oder Text-Sprach-Paare. Wenn die OVD-Technologie verwendet wird, um die ursprünglichen groben Bildinformationen genau zu lokalisieren und bei der Vorhersage der semantischen Informationen des Bildes zur Filterung des Korpus zu helfen, wird die Qualität der vorab trainierten Daten des großen Modells weiter verbessert, wodurch die Darstellungs- und Verständnisfähigkeiten optimiert werden des großen Modells.

Ein gutes Beispiel ist SAM (Segment Anything)[7]. SAM ermöglicht es wissenschaftlichen Forschern nicht nur, die zukünftige Richtung allgemeiner visueller Großmodelle zu erkennen, sondern löst auch A aus viel nachdenken. Es ist erwähnenswert, dass die OVD-Technologie gut mit SAM verbunden werden kann, um das semantische Verständnis von SAM zu verbessern und automatisch die von SAM benötigten Boxinformationen zu generieren, wodurch Arbeitskräfte weiter freigesetzt werden. In ähnlicher Weise kann die OVD-Technologie auch für AIGC (durch künstliche Intelligenz generierte Inhalte) die Fähigkeit verbessern, mit Benutzern zu interagieren. Wenn der Benutzer beispielsweise ein bestimmtes Ziel in einem Bild angeben muss, um es zu ändern, oder eine Beschreibung des Ziels erstellen muss, kann er dies tun Nutzen Sie das Sprachverständnis von OVD und die Fähigkeit von OVD, unbekannte Ziele zu erkennen, um die vom Benutzer beschriebenen Objekte genau zu lokalisieren und so eine qualitativ hochwertigere Inhaltsgenerierung zu erreichen. Die relevante Forschung im Bereich OVD boomt derzeit und die Veränderungen, die die OVD-Technologie für künftige allgemeine KI-Großmodelle mit sich bringen kann, sind es wert, gespannt zu sein.

Das obige ist der detaillierte Inhalt vonOhne die Notwendigkeit, riesige Datenmengen zu kennzeichnen, bringt das neue Paradigma der Zielerkennung OVD die multimodale AGI einen Schritt weiter. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Verwenden Sie ddrescue, um Daten unter Linux wiederherzustellen

Mar 20, 2024 pm 01:37 PM

Verwenden Sie ddrescue, um Daten unter Linux wiederherzustellen

Mar 20, 2024 pm 01:37 PM

DDREASE ist ein Tool zum Wiederherstellen von Daten von Datei- oder Blockgeräten wie Festplatten, SSDs, RAM-Disks, CDs, DVDs und USB-Speichergeräten. Es kopiert Daten von einem Blockgerät auf ein anderes, wobei beschädigte Blöcke zurückbleiben und nur gute Blöcke verschoben werden. ddreasue ist ein leistungsstarkes Wiederherstellungstool, das vollständig automatisiert ist, da es während der Wiederherstellungsvorgänge keine Unterbrechungen erfordert. Darüber hinaus kann es dank der ddasue-Map-Datei jederzeit gestoppt und fortgesetzt werden. Weitere wichtige Funktionen von DDREASE sind: Es überschreibt die wiederhergestellten Daten nicht, füllt aber die Lücken im Falle einer iterativen Wiederherstellung. Es kann jedoch gekürzt werden, wenn das Tool explizit dazu aufgefordert wird. Stellen Sie Daten aus mehreren Dateien oder Blöcken in einer einzigen wieder her

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

Open Source! Jenseits von ZoeDepth! DepthFM: Schnelle und genaue monokulare Tiefenschätzung!

Apr 03, 2024 pm 12:04 PM

0.Was bewirkt dieser Artikel? Wir schlagen DepthFM vor: ein vielseitiges und schnelles generatives monokulares Tiefenschätzungsmodell auf dem neuesten Stand der Technik. Zusätzlich zu herkömmlichen Tiefenschätzungsaufgaben demonstriert DepthFM auch hochmoderne Fähigkeiten bei nachgelagerten Aufgaben wie dem Tiefen-Inpainting. DepthFM ist effizient und kann Tiefenkarten innerhalb weniger Inferenzschritte synthetisieren. Lassen Sie uns diese Arbeit gemeinsam lesen ~ 1. Titel der Papierinformationen: DepthFM: FastMonocularDepthEstimationwithFlowMatching Autor: MingGui, JohannesS.Fischer, UlrichPrestel, PingchuanMa, Dmytr

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Langsame Internetgeschwindigkeiten für Mobilfunkdaten auf dem iPhone: Korrekturen

May 03, 2024 pm 09:01 PM

Stehen Sie vor einer Verzögerung oder einer langsamen mobilen Datenverbindung auf dem iPhone? Normalerweise hängt die Stärke des Mobilfunk-Internets auf Ihrem Telefon von mehreren Faktoren ab, wie z. B. der Region, dem Mobilfunknetztyp, dem Roaming-Typ usw. Es gibt einige Dinge, die Sie tun können, um eine schnellere und zuverlässigere Mobilfunk-Internetverbindung zu erhalten. Fix 1 – Neustart des iPhone erzwingen Manchmal werden durch einen erzwungenen Neustart Ihres Geräts viele Dinge zurückgesetzt, einschließlich der Mobilfunkverbindung. Schritt 1 – Drücken Sie einfach einmal die Lauter-Taste und lassen Sie sie los. Drücken Sie anschließend die Leiser-Taste und lassen Sie sie wieder los. Schritt 2 – Der nächste Teil des Prozesses besteht darin, die Taste auf der rechten Seite gedrückt zu halten. Lassen Sie das iPhone den Neustart abschließen. Aktivieren Sie Mobilfunkdaten und überprüfen Sie die Netzwerkgeschwindigkeit. Überprüfen Sie es erneut. Fix 2 – Datenmodus ändern 5G bietet zwar bessere Netzwerkgeschwindigkeiten, funktioniert jedoch besser, wenn das Signal schwächer ist

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Die Vitalität der Superintelligenz erwacht! Aber mit der Einführung der sich selbst aktualisierenden KI müssen sich Mütter keine Sorgen mehr über Datenengpässe machen

Apr 29, 2024 pm 06:55 PM

Ich weine zu Tode. Die Daten im Internet reichen überhaupt nicht aus. Das Trainingsmodell sieht aus wie „Die Tribute von Panem“, und KI-Forscher auf der ganzen Welt machen sich Gedanken darüber, wie sie diese datenhungrigen Esser ernähren sollen. Dieses Problem tritt insbesondere bei multimodalen Aufgaben auf. Zu einer Zeit, als sie ratlos waren, nutzte ein Start-up-Team der Abteilung der Renmin-Universität von China sein eigenes neues Modell, um als erstes in China einen „modellgenerierten Datenfeed selbst“ in die Realität umzusetzen. Darüber hinaus handelt es sich um einen zweigleisigen Ansatz auf der Verständnisseite und der Generierungsseite. Beide Seiten können hochwertige, multimodale neue Daten generieren und Datenrückmeldungen an das Modell selbst liefern. Was ist ein Modell? Awaker 1.0, ein großes multimodales Modell, das gerade im Zhongguancun-Forum erschienen ist. Wer ist das Team? Sophon-Motor. Gegründet von Gao Yizhao, einem Doktoranden an der Hillhouse School of Artificial Intelligence der Renmin University.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Der erste Roboter erscheint, der menschliche Aufgaben autonom erledigt, mit fünf flexiblen Fingern und übermenschlicher Geschwindigkeit, und große Modelle unterstützen das Training im virtuellen Raum

Mar 11, 2024 pm 12:10 PM

Diese Woche gab FigureAI, ein Robotikunternehmen, an dem OpenAI, Microsoft, Bezos und Nvidia beteiligt sind, bekannt, dass es fast 700 Millionen US-Dollar an Finanzmitteln erhalten hat und plant, im nächsten Jahr einen humanoiden Roboter zu entwickeln, der selbstständig gehen kann. Und Teslas Optimus Prime hat immer wieder gute Nachrichten erhalten. Niemand zweifelt daran, dass dieses Jahr das Jahr sein wird, in dem humanoide Roboter explodieren. SanctuaryAI, ein in Kanada ansässiges Robotikunternehmen, hat kürzlich einen neuen humanoiden Roboter auf den Markt gebracht: Phoenix. Beamte behaupten, dass es viele Aufgaben autonom und mit der gleichen Geschwindigkeit wie Menschen erledigen kann. Pheonix, der weltweit erste Roboter, der Aufgaben autonom in menschlicher Geschwindigkeit erledigen kann, kann jedes Objekt sanft greifen, bewegen und elegant auf der linken und rechten Seite platzieren. Es kann Objekte autonom identifizieren

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Die U.S. Air Force präsentiert ihren ersten KI-Kampfjet mit großem Aufsehen! Der Minister führte die Testfahrt persönlich durch, ohne in den gesamten Prozess einzugreifen, und 100.000 Codezeilen wurden 21 Mal getestet.

May 07, 2024 pm 05:00 PM

Kürzlich wurde die Militärwelt von der Nachricht überwältigt: US-Militärkampfflugzeuge können jetzt mithilfe von KI vollautomatische Luftkämpfe absolvieren. Ja, erst kürzlich wurde der KI-Kampfjet des US-Militärs zum ersten Mal der Öffentlichkeit zugänglich gemacht und sein Geheimnis gelüftet. Der vollständige Name dieses Jägers lautet „Variable Stability Simulator Test Aircraft“ (VISTA). Er wurde vom Minister der US-Luftwaffe persönlich geflogen, um einen Eins-gegen-eins-Luftkampf zu simulieren. Am 2. Mai startete US-Luftwaffenminister Frank Kendall mit einer X-62AVISTA auf der Edwards Air Force Base. Beachten Sie, dass während des einstündigen Fluges alle Flugaktionen autonom von der KI durchgeführt wurden! Kendall sagte: „In den letzten Jahrzehnten haben wir über das unbegrenzte Potenzial des autonomen Luft-Luft-Kampfes nachgedacht, aber es schien immer unerreichbar.“ Nun jedoch,