Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Entdecken Sie ThinkGPT: die hochmoderne Python-Bibliothek, die KI in leistungsstarke Denkmaschinen verwandelt

Entdecken Sie ThinkGPT: die hochmoderne Python-Bibliothek, die KI in leistungsstarke Denkmaschinen verwandelt

Entdecken Sie ThinkGPT: die hochmoderne Python-Bibliothek, die KI in leistungsstarke Denkmaschinen verwandelt

ThinkGPT ist eine innovative Python-Bibliothek, die große Sprachmodelle in die Lage versetzt, effizienter zu denken, zu argumentieren und zu handeln. Wenn Sie ThinkGPT in Ihre Python-Skripte integrieren und die erweiterten Funktionen nutzen möchten, lesen Sie bitte diesen Artikel. Dieser Artikel führt Sie durch die ersten Schritte der Verwendung von ThinkGPT in Ihrem Python-Projekt.

Wir werden die Kernfunktionen von ThinkGPT erkunden, einschließlich seiner erweiterten Speicherfunktionen, Mechanismen zur Selbstverbesserung und Fähigkeiten zum logischen Denken höherer Ordnung. Sie können entdecken, wie diese innovative Bibliothek die KI-Entwicklungslandschaft verändert, und erfahren, wie Sie ihre Leistungsfähigkeit nutzen können, um Ihre eigenen Projekte zu verbessern.

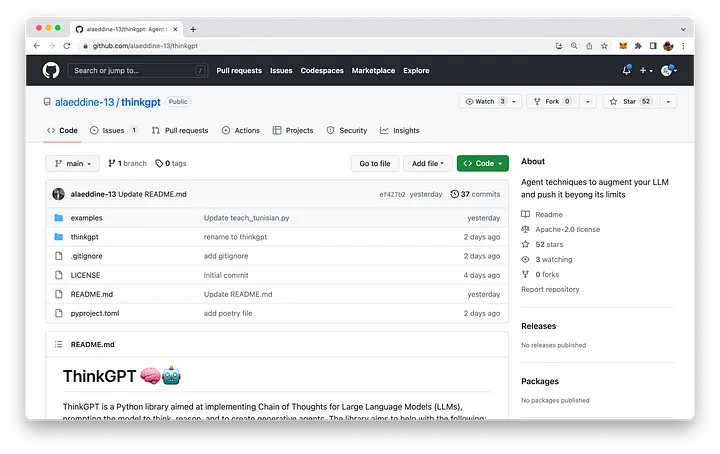

ThinkGPT wird auf GitHub gehostet. Die Codebasis finden Sie unter: https://github.com/alaeddine-13/thinkgpt.

Hauptfunktionen von ThinkGPT

- Speicher: ThinkGPT ermöglicht es großen Sprachmodellen (LLMs), sich an Erfahrungen zu erinnern und neue Konzepte erlernen.

- Selbstverbesserung: Mit dieser Funktion kann das Modell den generierten Inhalt verbessern, indem es auf Kritik eingeht, Probleme behebt und sein Verständnis verfeinert.

- Abstraktion: LLM wird dazu ermutigt, Regeln aus Beispielen oder Beobachtungen zu verallgemeinern, um dabei zu helfen, komprimiertes Wissen zu schaffen, das besser zur begrenzten Kontextlänge des Modells passt.

- Inferenz: Ermöglicht LLM, fundierte Vermutungen auf der Grundlage verfügbarer Informationen anzustellen.

- Bedingungen in natürlicher Sprache: Benutzer können Aufgaben und Bedingungen einfach in natürlicher Sprache ausdrücken, sodass Modelle intelligente Entscheidungen treffen können.

- Einfache Einrichtung und Pythonic-API: Dank DocArray bietet ThinkGPT einen äußerst einfachen Einrichtungsprozess und eine Pythonic-API.

Installation

Die Installation von ThinkGPT ist einfach und kann mit pip installiert werden:

pip install git+https://github.com/alaeddine-13/thinkgpt.git

Dieser Befehl wird direkt aus dem GitHub-Code installiert Repository ThinkGPT-Bibliothek.

Der erste Schritt zur Verwendung von ThinkGPT in Python-Skripten

Nachdem die Installation abgeschlossen ist, können Sie mit der Verwendung von ThinkGPT in Python-Skripten beginnen. Importieren Sie dazu einfach die ThinkGPT-Klasse aus dem thinkgpt.llm-Modul und erstellen Sie eine neue Instanz der Klasse:

from thinkgpt.llm import ThinkGPT llm = ThinkGPT(model_name="gpt-3.5-turbo")

Dieses Code-Snippet verwendet das angegebene Modell (in diesem Fall wurde eine neue ThinkGPT-Instanz initialisiert für „gpt-3.5-turbo“).

Mit einer ThinkGPT-Instanz können Sie jetzt die Methode memorize() verwenden, um Ihrem KI-Modell neue Konzepte oder Fakten beizubringen:

llm.memorize(['DocArray is a library for representing, sending, and storing multi-modal data.'])

Um gespeicherte Informationen abzurufen, können Sie die verwenden Methode „remember()“:

memory = llm.remember('DocArray definition')Sobald das KI-Modell einige Informationen gelernt hat, können Sie mit der Methode „predict()“ Vorhersagen treffen oder Fragen basierend auf den gespeicherten Daten beantworten:

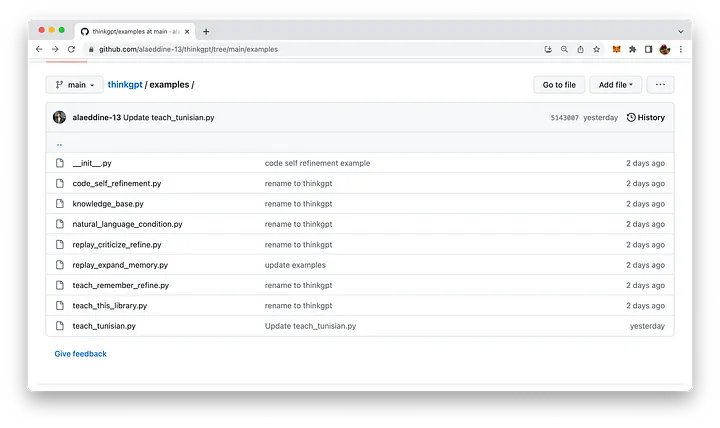

llm.predict('what is DocArray ?', remember=memory)this Das Code-Snippet verwendet die Methode „remember()“, um Speicherinformationen abzurufen, und gibt diese an die Methode „predict()“ zurück, um die Frage zu beantworten. ThinkGPT enthält einige leicht verständliche Anwendungsbeispiele. Das entsprechende Python-Skript finden Sie im Beispielordner der Codebasis:

Lassen Sie uns in eines der bereitgestellten Beispiele eintauchen: replay_expand_memory .py:

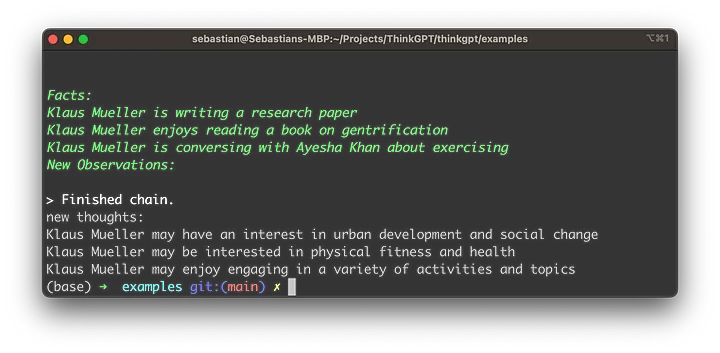

from thinkgpt.llm import ThinkGPT llm = ThinkGPT(model_name="gpt-3.5-turbo") # 加载旧内存 old_memory = [ "Klaus Mueller is writing a research paper", "Klaus Mueller enjoys reading a book on gentrification", "Klaus Mueller is conversing with Ayesha Khan about exercising" ] # 教给LLM旧的记忆 llm.memorize(old_memory) # 在旧记忆的基础上诱发反思 new_observations = llm.infer(facts=llm.remember()) print('new thoughts:') print('\n'.join(new_observations)) llm.memorize(new_observations)- Definieren Sie die Variable old_memory, die drei Aussagen über Klaus Müller enthält, die Vorwissen darstellen.

- Verwenden Sie die Methode memorize(), um einem großen Sprachmodell (LLM) die in old_memory gespeicherten Informationen beizubringen.

- Rufen Sie die Methode infer() auf und setzen Sie den Parameter „facts“ auf das Ergebnis der Methode „remember()“. Dies weist LLM an, neue Beobachtungen oder Gedanken auf der Grundlage zuvor gespeicherter Informationen hervorzurufen.

- Neu induzierte Beobachtungen werden unter dem Tag „neue Gedanken:“ an die Konsole ausgegeben.

- Abschließend wird die Methode memorize() erneut aufgerufen, um die neuen Beobachtungen im Speicher von LLM zu speichern und so in zukünftigen Interaktionen ein Verständnis für Klaus Mueller aufzubauen.

- Bevor wir das Skript ausführen und die Ergebnisse anzeigen, müssen wir den OpenAI-API-Schlüssel abrufen und den Schlüsselwert der entsprechenden Umgebungsvariablen OPENAI_API_KEY festlegen.

- Um einen OpenAI-API-Schlüssel zu erhalten, befolgen Sie diese einfachen Schritte:

- 请访问OpenAI网站https://www.openai.com/。

- 如果没有帐户,请注册一个帐户。在首页右上角点击“注册”,并按照注册流程操作。

- 注册或登录后,通过点击页面顶部的“API”或访问https://www.openai.com/api/来导航到API部分。

- 查看可用的API定价计划,并选择适合你需求的计划。某些计划可能提供带有有限使用的免费访问权限,而其他计划根据你的要求和预算提供不同级别的访问权限。

- 选择一个计划后,将提供你的唯一API密钥。请确保保密,因为它授予你的账户使用限制和特权的API访问权限。 在命令行中使用以下命令来设置OpenAI API密钥:

export OPENAI_API_KEY="YOUR OPENAI API KEY"

现在我们已经准备好执行脚本了,只需输入以下命令:

python replay_expand_memory.py

然后,你应该能够看到类似于以下的结果:

总结

ThinkGPT是一款强大的Python库,它通过添加先进的记忆、自我完善、抽象和推理功能,增强了大型语言模型的能力。它对用户友好的安装过程和Pythonic API使它成为许多AI项目的有价值的补充。通过探索本文提供的实际示例,你可以利用ThinkGPT的能力,彻底改变你的AI思考方式、得出结论和采取行动的方式。

Das obige ist der detaillierte Inhalt vonEntdecken Sie ThinkGPT: die hochmoderne Python-Bibliothek, die KI in leistungsstarke Denkmaschinen verwandelt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1358

1358

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Mar 18, 2024 am 09:20 AM

Mar 18, 2024 am 09:20 AM

Heute möchte ich eine aktuelle Forschungsarbeit der University of Connecticut vorstellen, die eine Methode zum Abgleichen von Zeitreihendaten mit großen NLP-Modellen (Natural Language Processing) im latenten Raum vorschlägt, um die Leistung von Zeitreihenprognosen zu verbessern. Der Schlüssel zu dieser Methode besteht darin, latente räumliche Hinweise (Eingabeaufforderungen) zu verwenden, um die Genauigkeit von Zeitreihenvorhersagen zu verbessern. Titel des Papiers: S2IP-LLM: SemanticSpaceInformedPromptLearningwithLLMforTimeSeriesForecasting Download-Adresse: https://arxiv.org/pdf/2403.05798v1.pdf 1. Hintergrundmodell für große Probleme

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren