Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Apple WWDC23 erwähnt „künstliche Intelligenz' nicht und verwendet lieber „maschinelles Lernen'

Apple WWDC23 erwähnt „künstliche Intelligenz' nicht und verwendet lieber „maschinelles Lernen'

Apple WWDC23 erwähnt „künstliche Intelligenz' nicht und verwendet lieber „maschinelles Lernen'

IT House News am 6. Juni: Neben der Einführung der mit Spannung erwarteten neuen Produkte wie Mac Pro und Vision Pro stellte Apple während seiner Keynote-Rede zur WWDC 2023 am Montag auch seine neuesten Fortschritte im Bereich maschinelles Lernen vor. Allerdings fiel IT House auf, dass Apple im Gegensatz zu Konkurrenten wie Microsoft und Google, die generative künstliche Intelligenz stark vorantreiben, in seiner Rede nicht das Wort „künstliche Intelligenz“ erwähnte, sondern häufiger von „maschinellem Lernen“ und „maschinellem Lernen“ sprach. Begriffe wie „ML“.

Zum Beispiel beschrieb Craig Federighi, Senior Vice President of Software Engineering, in einer Demo von iOS 17 Verbesserungen bei der automatischen Fehlerkorrektur und Spracherkennung:

Die automatische Fehlerkorrektur basiert auf maschinellem Lernen auf dem Gerät und wir haben diese Modelle im Laufe der Jahre kontinuierlich verbessert. Die Tastatur nutzt jetzt ein Transformer-Sprachmodell, die fortschrittlichste Wortvorhersagetechnologie auf dem Markt, wodurch die automatische Fehlerkorrektur genauer denn je ist. Und dank der Leistung der Apple Silicon-Chips kann das iPhone dieses Modell jedes Mal ausführen, wenn Sie eine Taste drücken.

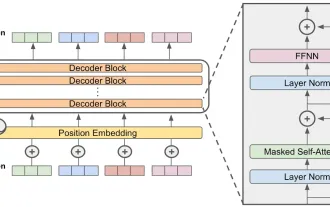

Es ist erwähnenswert, dass Apple in seiner Keynote-Rede den Begriff „Transformer“ im Bereich der künstlichen Intelligenz erwähnt hat. Das Unternehmen spricht speziell von einem „Transformer-Sprachmodell“, was bedeutet, dass seine KI-Modelle die Transformer-Architektur verwenden, die die zugrunde liegende Technologie ist, die vielen neueren generativen KIs wie dem DALL-E-Bildgenerator und dem ChatGPT-Chatbot zugrunde liegt. Das Transformer-Modell (ein Konzept, das erstmals 2017 vorgeschlagen wurde) ist eine neuronale Netzwerkarchitektur für die Verarbeitung natürlicher Sprache (NLP), die einen Selbstaufmerksamkeitsmechanismus verwendet, der es ihr ermöglicht, verschiedene Wörter oder Elemente in einer Sequenz zu priorisieren. Seine Fähigkeit, Eingaben parallel zu verarbeiten, verbessert die Effizienz erheblich und ermöglicht bahnbrechende Fortschritte bei NLP-Aufgaben wie Übersetzung, Zusammenfassung und Beantwortung von Fragen.

Laut Apple kann das neue Transformer-Modell in iOS 17 eine automatische Fehlerkorrektur auf Satzebene erreichen. Wenn Sie die Leertaste drücken, kann ein Wort oder ein ganzer Satz vervollständigt werden. Es lernt auch anhand Ihres Schreibstils, um Empfehlungen abzugeben. Apple sagt außerdem, dass die Spracherkennung „ein transformatorbasiertes Spracherkennungsmodell verwendet, das eine neuronale Engine nutzt, um die Spracherkennung genauer zu machen“.

In der Keynote-Rede erwähnte Apple auch mehrfach „maschinelles Lernen“, beispielsweise bei der Beschreibung der neuen iPad-Sperrbildschirmfunktion („Wenn Sie ein Live-Foto auswählen, verwenden wir ein fortschrittliches maschinelles Lernmodell, um zusätzliche Frames zu synthetisieren“); PDF-Funktion („Dank neuer Modelle für maschinelles Lernen kann iPadOS Felder in PDFs erkennen, sodass Sie mithilfe von AutoFill schnell Informationen wie Namen, Adressen und E-Mails aus Ihren Kontakten usw. eingeben können.“); Durch die Personalisierung der Lautstärke nutzen wir maschinelles Lernen, um zu lernen, wie sich Ihre Hörpräferenzen im Laufe der Zeit ändern“); und die Apple Watch-Widget-Funktion Smart Stack („Smart Stack nutzt maschinelles Lernen, um Ihnen relevante Informationen anzuzeigen, wenn Sie sie brauchen“).

Apple hat außerdem eine neue App namens Journal auf den Markt gebracht, die maschinelles Lernen auf dem Gerät nutzt, um personalisierte Empfehlungen bereitzustellen und den Benutzern Inspiration für das Tagebuch zu bieten. Diese Vorschläge werden intelligent generiert und basieren auf den letzten Aktivitäten des Benutzers, einschließlich Fotos, Personen, Orten, körperlichem Training usw., sodass Benutzer leichter mit der Aufnahme beginnen können.

Schließlich enthüllte das Unternehmen während einer Demo des Vision Pro-Headsets, dass das dynamische Bild auf den Augen des Benutzers ein spezieller 3D-Avatar ist, der durch Scannen Ihres Gesichts erstellt wurde – natürlich dank maschinellem Lernen.

Das obige ist der detaillierte Inhalt vonApple WWDC23 erwähnt „künstliche Intelligenz' nicht und verwendet lieber „maschinelles Lernen'. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Beste KI -Kunstgeneratoren (kostenlos & amp; bezahlt) für kreative Projekte

Apr 02, 2025 pm 06:10 PM

Der Artikel überprüft Top -KI -Kunstgeneratoren, diskutiert ihre Funktionen, Eignung für kreative Projekte und Wert. Es zeigt MidJourney als den besten Wert für Fachkräfte und empfiehlt Dall-E 2 für hochwertige, anpassbare Kunst.

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Erste Schritte mit Meta Lama 3.2 - Analytics Vidhya

Apr 11, 2025 pm 12:04 PM

Metas Lama 3.2: Ein Sprung nach vorne in der multimodalen und mobilen KI Meta hat kürzlich Lama 3.2 vorgestellt, ein bedeutender Fortschritt in der KI mit leistungsstarken Sichtfunktionen und leichten Textmodellen, die für mobile Geräte optimiert sind. Aufbau auf dem Erfolg o

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Beste AI -Chatbots verglichen (Chatgpt, Gemini, Claude & amp; mehr)

Apr 02, 2025 pm 06:09 PM

Der Artikel vergleicht Top -KI -Chatbots wie Chatgpt, Gemini und Claude und konzentriert sich auf ihre einzigartigen Funktionen, Anpassungsoptionen und Leistung in der Verarbeitung und Zuverlässigkeit natürlicher Sprache.

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

Top -KI -Schreibassistenten, um Ihre Inhaltserstellung zu steigern

Apr 02, 2025 pm 06:11 PM

In dem Artikel werden Top -KI -Schreibassistenten wie Grammarly, Jasper, Copy.ai, Writesonic und RYTR erläutert und sich auf ihre einzigartigen Funktionen für die Erstellung von Inhalten konzentrieren. Es wird argumentiert, dass Jasper in der SEO -Optimierung auszeichnet, während KI -Tools dazu beitragen, den Ton zu erhalten

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Wie kann ich Falcon 3 zugreifen? - Analytics Vidhya

Mar 31, 2025 pm 04:41 PM

Falcon 3: Ein revolutionäres Open-Source-Großsprachmodell Falcon 3, die neueste Iteration in der gefeierten Falcon -Serie von LLMs, stellt einen erheblichen Fortschritt in der AI -Technologie dar. Entwickelt vom Technology Innovation Institute (TII), diesem offen

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

Top 7 Agentenlagersystem zum Aufbau von KI -Agenten

Mar 31, 2025 pm 04:25 PM

2024 veränderte sich von einfacher Verwendung von LLMs für die Erzeugung von Inhalten zum Verständnis ihrer inneren Funktionsweise. Diese Erkundung führte zur Entdeckung von AI -Agenten - autonome Systeme zur Handhabung von Aufgaben und Entscheidungen mit minimalem menschlichen Eingreifen. Bauen

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Auswahl des besten KI -Sprachgenerators: Top -Optionen überprüft

Apr 02, 2025 pm 06:12 PM

Der Artikel überprüft Top -KI -Sprachgeneratoren wie Google Cloud, Amazon Polly, Microsoft Azure, IBM Watson und Descript, wobei sie sich auf ihre Funktionen, die Sprachqualität und die Eignung für verschiedene Anforderungen konzentrieren.