Verteilte Computer- und Datenanalysetechnologie in Java

Mit dem Aufkommen des Big-Data-Zeitalters hat das explosionsartige Wachstum des Datenvolumens enorme Auswirkungen auf traditionelle Rechenmethoden gehabt. Um dieses Problem zu lösen, wurden verteilte Computer- und Datenanalysetechnologien entwickelt. Als universelle Programmiersprache hat Java gute Leistungen in den Bereichen verteiltes Rechnen und Datenanalyse gezeigt.

1. Distributed Computing-Technologie

Distributed Computing ist eine Technologie, die Rechenaufgaben in mehrere Unteraufgaben aufteilt, die auf verschiedenen Computern ausgeführt werden können und deren Ausgabeergebnisse dann zum Endergebnis zusammengeführt werden. Diese Technologie kann die Recheneffizienz erheblich verbessern und die Skalierbarkeit des Systems verbessern.

In der verteilten Computertechnologie sind Hadoop und Spark die am häufigsten verwendeten Tools für Java. Hadoop ist ein Java-basiertes Framework für die verteilte Big-Data-Verarbeitung, das große Datenmengen verteilt verarbeiten und Daten über mehrere Computerknoten hinweg speichern und verarbeiten kann. Spark ist ein weiteres Java-basiertes Framework, das eine schnelle, universelle Engine für die Verarbeitung großer Datensätze bereitstellt, die auf einem Hadoop-Cluster ausgeführt werden kann.

2. Datenanalysetechnologie

Datenanalyse bezieht sich auf die Verwendung verschiedener Technologien und Tools zur Verarbeitung und Analyse großer Datenmengen, um die Muster und Trends zu entdecken, die sich hinter den Daten verbergen. Java verfügt außerdem über viele hervorragende Tools und Frameworks für die Datenanalyse.

- Mahout

Mahout ist eine Java-basierte Plattform für maschinelles Lernen, die für das Data Mining und die Datenanalyse großer Datensätze verwendet werden kann. Es bietet viele Algorithmen für maschinelles Lernen, einschließlich Clustering, Klassifizierung usw.

- Weka

Weka ist ein Java-basiertes Open-Source-Tool für maschinelles Lernen, das für Data Mining, prädiktive Modellierung, Clusteranalyse usw. verwendet werden kann. Es bietet viele Datenvorverarbeitungs- und maschinelle Lernalgorithmen.

- ELK

ELK ist eine universelle Lösung zur Protokolldatenanalyse, die aus drei reibungslosen Kollaborationstools besteht: Logstash, Elasticsearch und Kibana. Logstash ist ein Protokolldatensammler, Elasticsearch ist eine verteilte Such- und Analysemaschine und Kibana ist ein benutzerfreundliches Web-Frontend, mit dem Protokolldaten in Echtzeit gezählt und analysiert werden können.

3. Fazit

Java hat eine gute Leistung und Skalierbarkeit im Bereich verteilter Datenverarbeitung und Datenanalyse gezeigt. Verschiedene Open-Source-Tools und Frameworks helfen Java-Entwicklern, große Datensätze schneller zu verarbeiten und zu analysieren. Während des Anwendungsdesigns und der Implementierung sollten Entwickler geeignete Tools und Frameworks für verteiltes Computing und Datenanalyse basierend auf spezifischen Anforderungen auswählen, um Leistung und Skalierbarkeit sicherzustellen.

Das obige ist der detaillierte Inhalt vonVerteilte Computer- und Datenanalysetechnologie in Java. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1359

1359

52

52

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Das Stable Diffusion 3-Papier wird endlich veröffentlicht und die architektonischen Details werden enthüllt. Wird es helfen, Sora zu reproduzieren?

Mar 06, 2024 pm 05:34 PM

Der Artikel von StableDiffusion3 ist endlich da! Dieses Modell wurde vor zwei Wochen veröffentlicht und verwendet die gleiche DiT-Architektur (DiffusionTransformer) wie Sora. Nach seiner Veröffentlichung sorgte es für großes Aufsehen. Im Vergleich zur Vorgängerversion wurde die Qualität der von StableDiffusion3 generierten Bilder erheblich verbessert. Es unterstützt jetzt Eingabeaufforderungen mit mehreren Themen, und der Textschreibeffekt wurde ebenfalls verbessert, und es werden keine verstümmelten Zeichen mehr angezeigt. StabilityAI wies darauf hin, dass es sich bei StableDiffusion3 um eine Reihe von Modellen mit Parametergrößen von 800 M bis 8 B handelt. Durch diesen Parameterbereich kann das Modell direkt auf vielen tragbaren Geräten ausgeführt werden, wodurch der Einsatz von KI deutlich reduziert wird

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Dieser Artikel reicht aus, um etwas über autonomes Fahren und Flugbahnvorhersage zu lesen!

Feb 28, 2024 pm 07:20 PM

Die Trajektorienvorhersage spielt eine wichtige Rolle beim autonomen Fahren. Unter autonomer Fahrtrajektorienvorhersage versteht man die Vorhersage der zukünftigen Fahrtrajektorie des Fahrzeugs durch die Analyse verschiedener Daten während des Fahrvorgangs. Als Kernmodul des autonomen Fahrens ist die Qualität der Trajektorienvorhersage von entscheidender Bedeutung für die nachgelagerte Planungssteuerung. Die Trajektorienvorhersageaufgabe verfügt über einen umfangreichen Technologie-Stack und erfordert Vertrautheit mit der dynamischen/statischen Wahrnehmung des autonomen Fahrens, hochpräzisen Karten, Fahrspurlinien, Fähigkeiten in der neuronalen Netzwerkarchitektur (CNN&GNN&Transformer) usw. Der Einstieg ist sehr schwierig! Viele Fans hoffen, so schnell wie möglich mit der Flugbahnvorhersage beginnen zu können und Fallstricke zu vermeiden. Heute werde ich eine Bestandsaufnahme einiger häufiger Probleme und einführender Lernmethoden für die Flugbahnvorhersage machen! Einführungsbezogenes Wissen 1. Sind die Vorschaupapiere in Ordnung? A: Schauen Sie sich zuerst die Umfrage an, S

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Rezension! Tiefe Modellfusion (LLM/Basismodell/Verbundlernen/Feinabstimmung usw.)

Apr 18, 2024 pm 09:43 PM

Am 23. September wurde das Papier „DeepModelFusion:ASurvey“ von der National University of Defense Technology, JD.com und dem Beijing Institute of Technology veröffentlicht. Deep Model Fusion/Merging ist eine neue Technologie, die die Parameter oder Vorhersagen mehrerer Deep-Learning-Modelle in einem einzigen Modell kombiniert. Es kombiniert die Fähigkeiten verschiedener Modelle, um die Verzerrungen und Fehler einzelner Modelle zu kompensieren und so eine bessere Leistung zu erzielen. Die tiefe Modellfusion bei groß angelegten Deep-Learning-Modellen (wie LLM und Basismodellen) steht vor einigen Herausforderungen, darunter hohe Rechenkosten, hochdimensionaler Parameterraum, Interferenzen zwischen verschiedenen heterogenen Modellen usw. Dieser Artikel unterteilt bestehende Methoden zur Tiefenmodellfusion in vier Kategorien: (1) „Musterverbindung“, die Lösungen im Gewichtsraum über einen verlustreduzierenden Pfad verbindet, um eine bessere anfängliche Modellfusion zu erzielen

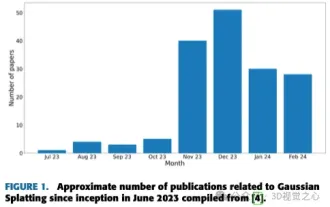

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Mehr als nur 3D-Gauß! Aktueller Überblick über modernste 3D-Rekonstruktionstechniken

Jun 02, 2024 pm 06:57 PM

Oben geschrieben & Nach persönlichem Verständnis des Autors ist die bildbasierte 3D-Rekonstruktion eine anspruchsvolle Aufgabe, bei der aus einer Reihe von Eingabebildern auf die 3D-Form eines Objekts oder einer Szene geschlossen werden muss. Lernbasierte Methoden haben wegen ihrer Fähigkeit, 3D-Formen direkt abzuschätzen, Aufmerksamkeit erregt. Dieser Übersichtsartikel konzentriert sich auf modernste 3D-Rekonstruktionstechniken, einschließlich der Generierung neuartiger, unsichtbarer Ansichten. Es wird ein Überblick über die jüngsten Entwicklungen bei Gaußschen Splash-Methoden gegeben, einschließlich Eingabetypen, Modellstrukturen, Ausgabedarstellungen und Trainingsstrategien. Auch ungelöste Herausforderungen und zukünftige Ausrichtungen werden besprochen. Angesichts der rasanten Fortschritte auf diesem Gebiet und der zahlreichen Möglichkeiten zur Verbesserung der 3D-Rekonstruktionsmethoden scheint eine gründliche Untersuchung des Algorithmus von entscheidender Bedeutung zu sein. Daher bietet diese Studie einen umfassenden Überblick über die jüngsten Fortschritte in der Gaußschen Streuung. (Wischen Sie mit dem Daumen nach oben

Revolutionäres GPT-4o: Neugestaltung des Mensch-Computer-Interaktionserlebnisses

Jun 07, 2024 pm 09:02 PM

Revolutionäres GPT-4o: Neugestaltung des Mensch-Computer-Interaktionserlebnisses

Jun 07, 2024 pm 09:02 PM

Das von OpenAI veröffentlichte GPT-4o-Modell ist zweifellos ein großer Durchbruch, insbesondere in Bezug auf seine Fähigkeit, mehrere Eingabemedien (Text, Audio, Bilder) zu verarbeiten und entsprechende Ausgaben zu generieren. Diese Fähigkeit macht die Mensch-Computer-Interaktion natürlicher und intuitiver und verbessert die Praktikabilität und Benutzerfreundlichkeit von KI erheblich. Zu den wichtigsten Highlights von GPT-4o gehören: hohe Skalierbarkeit, Multimedia-Ein- und -Ausgabe, weitere Verbesserungen der Fähigkeiten zum Verstehen natürlicher Sprache usw. 1. Medienübergreifende Eingabe/Ausgabe: GPT-4o+ kann jede beliebige Kombination aus Text, Audio und Bildern als Eingabe akzeptieren und direkt eine Ausgabe aus diesen Medien generieren. Dadurch wird die Beschränkung herkömmlicher KI-Modelle aufgehoben, die nur einen einzigen Eingabetyp verarbeiten, wodurch die Mensch-Computer-Interaktion flexibler und vielfältiger wird. Diese Innovation unterstützt intelligente Assistenten

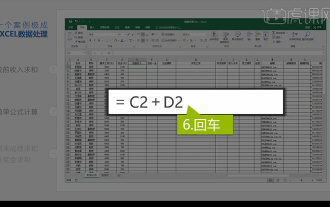

Integrierte Excel-Datenanalyse

Mar 21, 2024 am 08:21 AM

Integrierte Excel-Datenanalyse

Mar 21, 2024 am 08:21 AM

1. In dieser Lektion erklären wir die integrierte Excel-Datenanalyse. Wir vervollständigen sie anhand eines Falls. Öffnen Sie das Kursmaterial und klicken Sie auf Zelle E2, um die Formel einzugeben. 2. Anschließend wählen wir Zelle E53 aus, um alle folgenden Daten zu berechnen. 3. Dann klicken wir auf Zelle F2 und geben dann die Formel ein, um sie zu berechnen. Ebenso können wir durch Ziehen nach unten den gewünschten Wert berechnen. 4. Wir wählen Zelle G2 aus, klicken auf die Registerkarte „Daten“, klicken auf „Datenvalidierung“, wählen aus und bestätigen. 5. Verwenden wir dieselbe Methode, um die unten stehenden Zellen, die berechnet werden müssen, automatisch auszufüllen. 6. Als nächstes berechnen wir den tatsächlichen Lohn und wählen Zelle H2 aus, um die Formel einzugeben. 7. Dann klicken wir auf das Wert-Dropdown-Menü, um auf andere Zahlen zu klicken.

Kombination von Golang- und Front-End-Technologie: Entdecken Sie, welche Rolle Golang im Front-End-Bereich spielt

Mar 19, 2024 pm 06:15 PM

Kombination von Golang- und Front-End-Technologie: Entdecken Sie, welche Rolle Golang im Front-End-Bereich spielt

Mar 19, 2024 pm 06:15 PM

Kombination von Golang und Front-End-Technologie: Um zu untersuchen, welche Rolle Golang im Front-End-Bereich spielt, sind spezifische Codebeispiele erforderlich. Mit der rasanten Entwicklung des Internets und mobiler Anwendungen ist die Front-End-Technologie immer wichtiger geworden. Auch in diesem Bereich kann Golang als leistungsstarke Back-End-Programmiersprache eine wichtige Rolle spielen. In diesem Artikel wird untersucht, wie Golang mit Front-End-Technologie kombiniert wird, und sein Potenzial im Front-End-Bereich anhand spezifischer Codebeispiele demonstriert. Die Rolle von Golang im Front-End-Bereich ist effizient, prägnant und leicht zu erlernen