Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

LeCun unterstützt das fünfjährige Meisterwerk von Professor Ma Yi: einen vollständig mathematisch interpretierbaren White-Box-Transformer, dessen Leistung ViT in nichts nachsteht.

LeCun unterstützt das fünfjährige Meisterwerk von Professor Ma Yi: einen vollständig mathematisch interpretierbaren White-Box-Transformer, dessen Leistung ViT in nichts nachsteht.

LeCun unterstützt das fünfjährige Meisterwerk von Professor Ma Yi: einen vollständig mathematisch interpretierbaren White-Box-Transformer, dessen Leistung ViT in nichts nachsteht.

In den letzten etwa zehn Jahren war die rasante Entwicklung der KI hauptsächlich auf Fortschritte in der Ingenieurspraxis zurückzuführen. Die KI-Theorie hat bei der Steuerung der Algorithmenentwicklung immer noch keine Rolle gespielt.

Mit der Popularität von ChatGPT wurden die Fähigkeiten der KI ständig übertrieben und gehypt, bis hin zur Bedrohung und Entführung der Gesellschaft. Es ist dringend erforderlich, das Design der Transformer-Architektur transparent zu machen!

Kürzlich veröffentlichte das Team von Professor Ma Yi die neuesten Forschungsergebnisse und entwarf ein White-Box-Transformer-Modell CRATE, das vollständig durch Mathematik erklärt werden kann und nahe an ViT auf dem realen Datensatz ImageNet erreicht wird -1K Leistung.

Code-Link: https://github.com/Ma-Lab-Berkeley/CRATE

Papier-Link: https://arxiv.org/abs/2306.01129

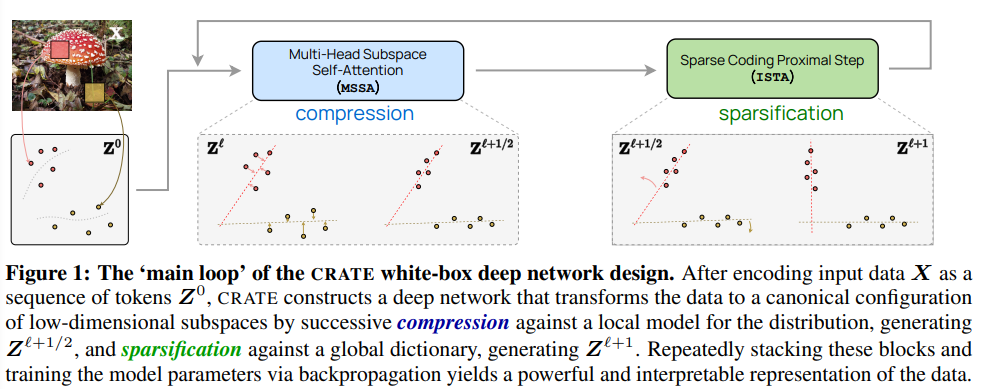

Here In In diesem Artikel glauben die Forscher, dass das Ziel des Repräsentationslernens darin besteht, die Verteilung von Daten (z. B. Token-Sets) zu komprimieren und zu transformieren, um eine Mischung aus niedrigdimensionalen Gaußschen Verteilungen auf inkohärenten Unterräumen zu unterstützen Sie wird anhand der einheitlichen Zielfunktion der Sparse-Rate-Reduktion gemessen.

Aus dieser Perspektive können beliebte Deep-Network-Modelle wie Transformer natürlich als realisierende iterative Schemata betrachtet werden, um dieses Ziel schrittweise zu optimieren.

Insbesondere zeigen die Ergebnisse, dass der Standard-Transformer-Block aus einer abwechselnden Optimierung komplementärer Teile dieses Ziels abgeleitet werden kann: Der Multi-Head-Selbstaufmerksamkeitsoperator kann als Komprimierung des Tokensatzes durch Minimierung der verlustbehafteten Codierung angesehen werden rate Der Gradientenabstiegsschritt und das anschließende mehrschichtige Perzeptron können als Versuch angesehen werden, die Darstellung des Tokens zu spärlich zu machen.

Diese Entdeckung führte auch zum Entwurf einer Reihe von White-Box-Transformator-ähnlichen tiefen Netzwerkarchitekturen, die zwar vollständig mathematisch interpretierbar sind, experimentelle Ergebnisse zeigen jedoch, dass diese Netzwerke lernen, die Entwurfsziele zu optimieren: Komprimierung und Sparsame Darstellungen großer realer visueller Datensätze wie ImageNet und eine Leistung, die der von hochentwickelten Transformer-Modellen (ViT) nahe kommt.

Turing-Award-Gewinner Yann LeCun stimmte ebenfalls der Arbeit von Professor Ma Yi zu und glaubte, dass Transformer eine Methode ähnlich LISTA (Learned Iterative Shrinkage and Thresholding Algorithm) verwendet, um die Sparse-Komprimierung schrittweise zu optimieren.

Professor Ma Yi erhielt 1995 einen Doppel-Bachelor-Abschluss in Automatisierung und angewandter Mathematik von der Tsinghua-Universität, 1997 einen Master-Abschluss in EECS von der University of California, Berkeley sowie einen Master-Abschluss in Mathematik und einen Doktortitel in EECS im Jahr 2000.

Im Jahr 2018 wechselte Professor Ma Yi an die Fakultät für Elektrotechnik und Informatik der University of California, Berkeley. Im Januar dieses Jahres wechselte er als Dekan des Institute of Data an die University of Hong Kong Seit Kurzem ist er Dekan der Fakultät für Informatik an der Universität Hongkong.

Die Hauptforschungsrichtungen sind 3D-Computervision, niedrigdimensionale Modelle für hochdimensionale Daten, Skalierbarkeitsoptimierung und maschinelles Lernen. Zu den jüngsten Forschungsthemen gehören groß angelegte 3D-geometrische Rekonstruktion und Interaktion sowie die Beziehung zwischen niedrigdimensionalen Modellen und tiefe Netzwerke.

Transformer zu einer White Box machen

Der Hauptzweck dieses Artikels besteht darin, ein einheitlicheres Framework zu verwenden, um eine Netzwerkstruktur ähnlich wie Transformer zu entwerfen, um mathematische Interpretierbarkeit und eine gute praktische Leistung zu erreichen.

Zu diesem Zweck schlugen die Forscher vor, eine Folge inkrementeller Zuordnungen zu erlernen, um die minimale Komprimierung und die dünnste Darstellung der Eingabedaten (Token-Satz) zu erhalten und so eine einheitliche Zielfunktion zu optimieren, d. h. die Sparsity-Rate zu reduzieren.

Dieses Framework vereint drei scheinbar unterschiedliche Methoden: „Transformer-Modell und Selbstaufmerksamkeit“, „Diffusionsmodell und Rauschunterdrückung“ und „Struktursuchende Modelle und Ratenreduzierung“ und zeigt, dass transformatorähnliche tiefe Netzwerkschichten vorliegen kann auf natürliche Weise aus der Entwicklung iterativer Optimierungsschemata abgeleitet werden, um die Ziele zur Sparsity-Reduktion schrittweise zu optimieren. Die Forscher verwendeten ein idealisiertes Token-Verteilungsmodell, um zu zeigen, dass die relevante Bewertungsfunktion nach der iterativen Entrauschung der dimensionalen Unterraumreihe eine explizite Form annimmt, ähnlich dem Selbstaufmerksamkeitsoperator in Transformer.

Die Forscher leiteten die Multi-Head-Selbstaufmerksamkeitsschicht als einen entfalteten Gradientenabstiegsschritt ab, um den verlustbehafteten Kodierungsratenanteil der Ratenreduzierung zu minimieren. Dies zeigt eine andere Möglichkeit, die Selbstaufmerksamkeitsschicht als komprimierte Token-Darstellung zu interpretieren.

MLP über Iterative Shrinkage-Thresholding Algorithms (ISTA) für Sparse Coding

Die Forscher zeigten, dass ein mehrschichtiges Perzeptron, das einer mehrköpfigen Selbstaufmerksamkeitsschicht in einem Transformer-Block folgt, interpretiert werden kann als ( und Kann durch eine Schicht ersetzt werden, die den Zielrest zur Reduzierung der Sparsity-Rate schrittweise optimiert, indem eine spärliche Codierung für die Token-Repräsentation erstellt wird.CRATE

Basierend auf dem obigen Verständnis haben die Forscher eine neue White-Box-Transformator-Architektur CRATE (Coding RAte Reduction TransformEr) erstellt. Die Lernzielfunktion, die Deep-Learning-Architektur und die endgültige erlernte Darstellung können alle mathematisch erklärt werden Jede Schicht führt einen Schritt des alternierenden Minimierungsalgorithmus aus, um das Ziel der Sparsity-Reduktion zu optimieren.

Es ist zu erkennen, dass CRATE in jeder Phase des Baus die einfachste Art des Bauens gewählt hat. Solange der neu gebaute Teil die gleiche konzeptionelle Rolle beibehält, kann er direkt ersetzt und durch einen neuen ersetzt werden White-Box-Architektur.

Experimenteller TeilDie experimentellen Ziele der Forscher bestehen nicht nur darin, mit anderen gut entwickelten Transformern zu konkurrieren, die das Basisdesign verwenden, sondern umfassen auch:

1. Vergleich mit dem, was normalerweise nur am Ende bewertet wird -Endleistung Im Gegensatz zu empirisch entworfenen Black-Box-Netzwerken können White-Box-entworfene Netzwerke in die tiefe Architektur blicken und „überprüfen, ob die Schichten des erlernten Netzwerks tatsächlich ihre Entwurfsziele erfüllen“, d. h. die Ziele schrittweise optimieren.

2. Obwohl die CRATE-Architektur einfach ist, sollten die experimentellen Ergebnisse „das enorme Potenzial dieser Architektur bestätigen“, das heißt, sie kann eine Leistung erzielen, die dem hochentwickelten Transformer-Modell entspricht, bei großen realen Datensätzen und Aufgaben . „Modellarchitektur“ Basis- und CRATE-Large-Datensätze und Optimierung

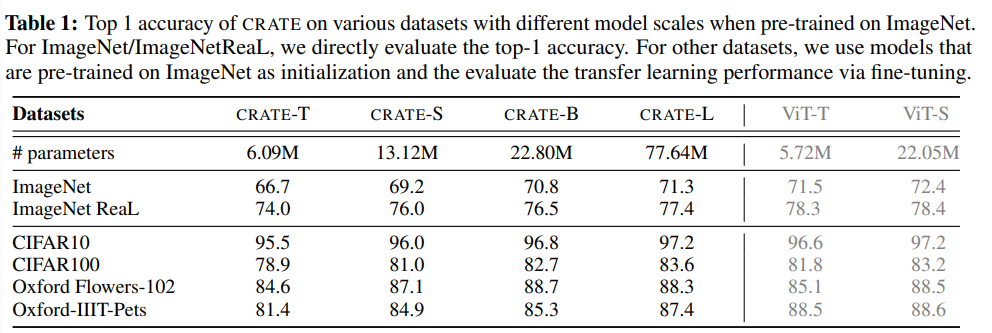

In diesem Artikel wird hauptsächlich ImageNet-1K als Testplattform betrachtet und der Lion-Optimierer verwendet, um CRATE-Modelle mit unterschiedlichen Modellgrößen zu trainieren.

Die Transfer-Lernleistung von CRATE wurde ebenfalls bewertet: Das auf ImageNet-1K trainierte Modell wurde als vorab trainiertes Modell verwendet und dann für mehrere häufig verwendete Downstream-Datensätze (CIFAR10/100, Oxford Flowers, Oxford-) verwendet. IIT-Pets) Feinabstimmung von CRATE.

Hat die Ebene von CRATE ihre Designziele erreicht?

Mit zunehmendem Schichtindex ist ersichtlich, dass die Komprimierungs- und Sparsifizierungsbedingungen des CRATE-Small-Modells in den meisten Fällen verbessert werden, was auf die Erhöhung des Sparsity-Maßes der letzten Schicht zurückzuführen ist die zusätzliche lineare Ebene zur Klassifizierung.

Die Ergebnisse zeigen, dass CRATE gut zum ursprünglichen Designziel passt: Sobald es gelernt ist, lernt es im Grunde, die Darstellung inkrementell über seine Ebenen hinweg zu komprimieren und auszusparen.

Nach der Messung der Komprimierungs- und Sparsifizierungsterme an CRATE-Modellen anderer Größen und Zwischenmodellkontrollpunkten kann festgestellt werden, dass die experimentellen Ergebnisse immer noch sehr konsistent sind. Modelle mit mehr Schichten neigen dazu, das Ziel effektiver zu optimieren. Überprüfen Sie das vorherige Verständnis der Rolle jeder Ebene.

Leistungsvergleich

Die empirische Leistung des vorgeschlagenen Netzwerks wird untersucht, indem die höchste Genauigkeit auf ImageNet-1K und die Transfer-Lernleistung auf mehreren weit verbreiteten Downstream-Datensätzen gemessen werden.

Da die entworfene Architektur die gemeinsame Nutzung von Parametern sowohl im Aufmerksamkeitsblock (MSSA) als auch im MLP-Block (ISTA) nutzt, sind die Parameter des CRATE-Base-Modells (22,08 Millionen) und ViT-Small (22,05 Millionen) Die Mengen sind ähnlich.

Es ist ersichtlich, dass das im Artikel vorgeschlagene Netzwerk bei ähnlicher Anzahl von Modellparametern eine ähnliche ImageNet-1K- und Transferlernleistung wie ViT erreicht, das Design von CRATE jedoch einfacher und besser interpretierbar ist.

Darüber hinaus kann CRATE weiterhin unter denselben Trainingshyperparametern skalieren, d. h. eine kontinuierliche Verbesserung der Leistung durch Vergrößerung der Modellgröße, während eine direkte Vergrößerung der ViT-Größe auf ImageNet-1K nicht immer zu konsistenten Ergebnissen führt Leistungsverbesserungen.

Das heißt, trotz seiner Einfachheit kann das CRATE-Netzwerk bereits die erforderliche Komprimierung und spärliche Darstellung in großen realen Datensätzen erlernen und bei verschiedenen Aufgaben wie Klassifizierung und Transferlernen bessere Ergebnisse erzielen Leistung technischer Transformer-Netzwerke (z. B. ViT).

Das obige ist der detaillierte Inhalt vonLeCun unterstützt das fünfjährige Meisterwerk von Professor Ma Yi: einen vollständig mathematisch interpretierbaren White-Box-Transformer, dessen Leistung ViT in nichts nachsteht.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

DualBEV: BEVFormer und BEVDet4D deutlich übertreffen, öffnen Sie das Buch!

Mar 21, 2024 pm 05:21 PM

In diesem Artikel wird das Problem der genauen Erkennung von Objekten aus verschiedenen Blickwinkeln (z. B. Perspektive und Vogelperspektive) beim autonomen Fahren untersucht, insbesondere wie die Transformation von Merkmalen aus der Perspektive (PV) in den Raum aus der Vogelperspektive (BEV) effektiv ist implementiert über das Modul Visual Transformation (VT). Bestehende Methoden lassen sich grob in zwei Strategien unterteilen: 2D-zu-3D- und 3D-zu-2D-Konvertierung. 2D-zu-3D-Methoden verbessern dichte 2D-Merkmale durch die Vorhersage von Tiefenwahrscheinlichkeiten, aber die inhärente Unsicherheit von Tiefenvorhersagen, insbesondere in entfernten Regionen, kann zu Ungenauigkeiten führen. Während 3D-zu-2D-Methoden normalerweise 3D-Abfragen verwenden, um 2D-Features abzutasten und die Aufmerksamkeitsgewichte der Korrespondenz zwischen 3D- und 2D-Features über einen Transformer zu lernen, erhöht sich die Rechen- und Bereitstellungszeit.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren