Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Drei Schlüsseltechnologien verleihen AR-Schnittstellen die nötige Leistungsfähigkeit

Drei Schlüsseltechnologien verleihen AR-Schnittstellen die nötige Leistungsfähigkeit

Drei Schlüsseltechnologien verleihen AR-Schnittstellen die nötige Leistungsfähigkeit

Dieser Artikel beginnt aus technischer Sicht und analysiert am Beispiel des kürzlich eingeführten Apple MR die drei wichtigsten technischen Punkte, auf die sich die AR-Welt verlassen muss: Eye-Tracking, manuelle Erkennung und räumliches Computing. Werfen wir einen Blick auf die Analyse dieser drei technischen Punkte durch den Autor ~

In der physischen Welt sind das Beobachten mit den Augen und das Bedienen mit den Händen die natürlichsten Formen der Interaktion. Um die Fortsetzung dieser natürlichen Interaktion in der AR-Welt zu realisieren, müssen wir uns auf drei wichtige technische Punkte verlassen.

Wir sind nicht enttäuscht, denn die Einführung von Apple Vision Pro demonstriert die natürlichen Interaktionsmöglichkeiten, die drei Technologien ermöglichen.

1. Eye-Tracking-Technologie

Wenn wir in der Realität weiter mit einem Objekt interagieren müssen, richten wir unseren Blick ganz natürlich darauf. Wenn wir unsere Aufmerksamkeit darauf richten, stellt dies bereits unsere Wahl dar.

Dieser Prozess deckt die aktuellen beiden Zustände im Schnittstellenfeld ab: Aktivierungszustand (Fokus) und Klickzustand (Auswahl). Die Eye-Tracking-Technologie realisiert den Prozess des Sehens und Fokussierens.

Diese Technologie ist sicherlich nicht die erste ihrer Art. Der Pionier der AR-Brillen, Microsoft Holoens Interaktion der 2. Generation, verfügt über Eye-Gaze, also die Funktion, die Augen zum Fokussieren zu nutzen.Zuvor basierte die Kopf-Blick-Interaktion der ersten Generation von Microsoft Holoens tatsächlich auf dem Konzept des Sehens und Aktivierens mit den Augen. Beim Head-Gaze wird der Kopf jedoch leicht bewegt, um einen Punkt (Gaze) in der Mitte des Bildschirms zu steuern und Inhalte zu aktivieren. Es besteht immer eine Lücke zwischen ihm und unserer ursprünglichen natürlichen Interaktion, da wir uns tatsächlich auf einen konzentrieren Objekt und müssen sich nicht jedes Mal darauf konzentrieren. Verlassen Sie sich einfach darauf, dass sich Ihr Kopf und Ihre Augen bewegen.

Obwohl die Eye-Tracking-Technologie den Standard der natürlichen Interaktion besser lösen kann, ist die Interaktion mit Kopfbewegungen nicht ohne Vorzüge. Beispielsweise kann die derzeit von meinem Team entwickelte Brille nur die Interaktion zwischen Kopf und Blick unterstützen. Die Kosten und der technische Aufwand dieser interaktiven Methode sind geringer als bei der Fokusaktivierungsmethode per Hand/Maus/Fernbedienung usw., sie kommt dem natürlichen Interaktionskonzept des Sehens mit unseren Augen näher.

Darüber hinaus hat die Eye-Tracking-Technologie den Aktivierungsstatus erkannt, die Auswahl, also den Klickstatus, jedoch noch nicht wirklich erkannt. Die Funktion besteht darin, der Maschine mitzuteilen, dass ich bestätige, dass sie es ist.

Streng genommen ist es unbedingt erforderlich, den manuellen Bestätigungsschritt für Dinge wegzulassen, die keinen Betrieb erfordern. Wenn ich zum Beispiel Snacks esse und Fernsehsendungen schaue, hoffe ich wirklich, dass ich mir nicht vor jeder Operation die schmutzigen Hände abwischen muss ... Im Fertigungsbereich wird dieses Bedürfnis, Hände frei zu haben, oft geäußert Kunden.

Für eine natürlichere Interaktion kann dies vielleicht auch Teil unserer Fantasie werden. Ich habe zuvor über ein Patent geschrieben, das sich zur einfachen Bestätigung auf Gehirnwellentechnologie stützte.

2. Gestenerkennungstechnologie

Eye-Tracking erfüllt die Interaktion, diesen Teil mit den Augen zu betrachten, während die Bedienung mit den Händen eine Gestenerkennungstechnologie erfordert.

Dies ist keine neue Technologie, die bereits auf vielen ARVR-Geräten installiert wurde. Der Grad der Implementierung muss jedoch durch tatsächliche Erfahrungen bestätigt werden.

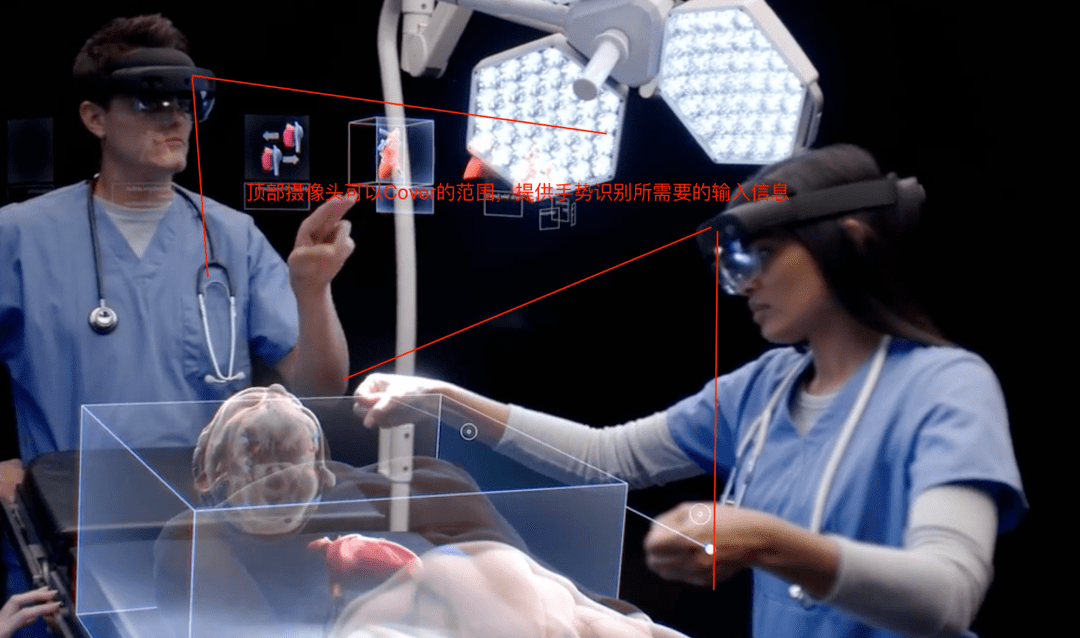

Im Werbevideo von Vision Pro sieht die Gestenerkennung sehr natürlich aus und die Hand muss nicht einmal angehoben werden. Dies sollte auf 4 Sätze von nach unten gerichteten Kameras beruhen (dies ist wahrscheinlich einer der Gründe, warum eine 12- Kamerakonfiguration ist erforderlich).

Darüber hinaus ist auch die Erfahrung der 2D-Gestenerkennungs- und 3D-Gestenerkennungstechnologie unterschiedlich.

3. Räumliche Berechnung

Um den Augen das Sehen zu erleichtern und eine natürlichere Bedienung mit den Händen zu ermöglichen, muss das Gerät in der Lage sein, den Raum zu verstehen.

Spatial Computing ist das, was Vision Pro fördern möchte. Ihr Fokus auf diese Fähigkeit lässt sie glauben, dass diese Fähigkeit eine Ära spalten kann.

„Die Ära des Spatial Computing“.Viele Interaktionen erfolgen auf natürliche Weise, weil Maschinen über räumliche Rechenfähigkeiten verfügen. Mit anderen Worten: Wenn Maschinen nicht in der Lage sind, den Raum zu verstehen, können diese Interaktionen nicht auf natürliche Weise stattfinden. Nerf, SLAM, 3DOF und 6DOF sind alle Teil der Spatial-Computing-Technologie, und alles, was Sie hören, fällt in diese Kategorie.

Aus Erfahrungssicht die Wahrnehmung der Distanz zwischen Objekten und zwischen Objekten und Benutzern, die durch die Veränderung der Form von Objekten in der Tiefe hervorgerufen werden, die durch die perspektivische Ausrichtung des Benutzers in verschiedenen Positionen und Haltungen hervorgerufen wird; aufgrund von Zeit und Veränderungen in der Farbwahrnehmung, die durch unterschiedliche Lichtverhältnisse wie Wetter oder sogar Geräusche von unterschiedlichen räumlichen Standorten usw. verursacht werden. Spatial Computing kann Designern mehr Raum für natürliche Interaktion bieten.

Man kann sagen, dass Spatial Computing die Schlüsseltechnologie ist, die es AR in Zukunft ermöglichen wird, sich von gewöhnlichen Bildschirmschnittstellen zu unterscheiden, und was wir wirklich erwarten: „Alles, was Sie betrachten, kann zu einer Schnittstelle werden.“

Kolumnist

Lin Yingluo, öffentlicher WeChat-Account: Es fallen Schatten in den Wald und jeder ist ein Produktmanager-Kolumnist. Ein User-Experience-Designer, der weiß, wie man Karten spielt, Autor von „AR Interface Design“, mehr als 10 Jahre Erfahrung im UIUX-Design, mit Schwerpunkt auf User-Experience-Design im Bereich AR und Intelligenz seit 6 Jahren, nationaler Profi; Zertifizierung zum Senior OH Card Master/Talent Mining Coach. Ich hoffe, dass meine Bemühungen einen Mehrwert für den Designbereich einer intelligenten Zukunft schaffen und die Karriere eines Designers wertvoller machen können

Titelbild von Unsplash, basierend auf dem CC0-Protokoll

Das obige ist der detaillierte Inhalt vonDrei Schlüsseltechnologien verleihen AR-Schnittstellen die nötige Leistungsfähigkeit. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1379

1379

52

52

Das offizielle Einführungs-Tutorial von Huawei für die Programmiersprache Cangjie wird veröffentlicht. Erfahren Sie in einem Artikel, wie Sie die universelle Version des SDK erhalten

Jun 25, 2024 am 08:05 AM

Das offizielle Einführungs-Tutorial von Huawei für die Programmiersprache Cangjie wird veröffentlicht. Erfahren Sie in einem Artikel, wie Sie die universelle Version des SDK erhalten

Jun 25, 2024 am 08:05 AM

Laut Nachrichten dieser Website vom 24. Juni kündigte Gong Ti, Präsident der Softwareabteilung von Huawei Terminal BG, bei der Grundsatzrede der Huawei-Entwicklerkonferenz HDC2024 am 21. Juni offiziell die von Huawei selbst entwickelte Programmiersprache Cangjie an. Diese Sprache wurde fünf Jahre lang entwickelt und steht jetzt als Entwicklervorschau zur Verfügung. Auf der offiziellen Entwickler-Website von Huawei wurde jetzt das offizielle Einführungsvideo zur Programmiersprache Cangjie veröffentlicht, um Entwicklern den Einstieg und das Verständnis zu erleichtern. Dieses Tutorial führt Benutzer dazu, Cangjie zu erleben, Cangjie zu lernen und Cangjie anzuwenden, einschließlich der Verwendung der Cangjie-Sprache zur Schätzung von Pi, der Berechnung der Stamm- und Zweigregeln für jeden Monat des Jahres 2024, der N Möglichkeiten, Binärbäume in der Cangjie-Sprache auszudrücken, und der Verwendung der Aufzählung Typen zur Implementierung algebraischer Berechnungen, Signalsystemsimulation mithilfe von Schnittstellen und Erweiterungen sowie neuer Syntax mithilfe von Cangjie-Makros usw. Diese Site hat die Tutorial-Zugriffsadresse: ht

Nach fünf Jahren Forschung und Entwicklung hat Huaweis Programmiersprache der nächsten Generation „Cangjie' offiziell seine Vorschau veröffentlicht

Jun 22, 2024 am 09:54 AM

Nach fünf Jahren Forschung und Entwicklung hat Huaweis Programmiersprache der nächsten Generation „Cangjie' offiziell seine Vorschau veröffentlicht

Jun 22, 2024 am 09:54 AM

Diese Website berichtete am 21. Juni, dass Gong Ti, Präsident der Softwareabteilung von Huawei Terminal BG, heute Nachmittag auf der Huawei-Entwicklerkonferenz HDC2024 offiziell die von Huawei selbst entwickelte Cangjie-Programmiersprache angekündigt und eine Entwicklervorschauversion der Cangjie-Sprache HarmonyOSNEXT veröffentlicht hat. Dies ist das erste Mal, dass Huawei die Programmiersprache Cangjie öffentlich veröffentlicht. Gong Ti sagte: „Im Jahr 2019 wurde das Cangjie-Programmiersprachenprojekt bei Huawei geboren. Nach fünf Jahren voller Forschung und Entwicklung und hohen Investitionen in Forschung und Entwicklung trifft es heute endlich auf globale Entwickler. Die Cangjie-Programmiersprache integriert moderne Sprachfunktionen, umfassende Kompilierungsoptimierung und Laufzeitimplementierung.“ und die sofort einsatzbereite IDE-Toolkettenunterstützung sorgen für ein benutzerfreundliches Entwicklungserlebnis und eine hervorragende Programmleistung für Entwickler. „Berichten zufolge ist die Programmiersprache Cangjie ein All-Szenario-Intelligence-Tool.

Huawei startet Beta-Rekrutierung für Entwickler der Programmiersprache HarmonyOS NEXT Cangjie

Jun 22, 2024 am 04:07 AM

Huawei startet Beta-Rekrutierung für Entwickler der Programmiersprache HarmonyOS NEXT Cangjie

Jun 22, 2024 am 04:07 AM

Laut Nachrichten dieser Website vom 21. Juni wurde die von Huawei selbst entwickelte Cangjie-Programmiersprache heute offiziell vorgestellt, und der Beamte kündigte den Start der Beta-Rekrutierung für die Vorschauversion der Cangjie-Sprachentwickler von HarmonyOSNEXT an. Bei diesem Upgrade handelt es sich um ein Early-Adopter-Upgrade auf die Entwicklervorschauversion, das das Cangjie-Sprach-SDK, Entwicklerhandbücher und zugehörige DevEcoStudio-Plug-Ins bereitstellt, damit Entwickler die Cangjie-Sprache zum Entwickeln, Debuggen und Ausführen von HarmonyOSNext-Anwendungen verwenden können. Anmeldezeitraum: 21. Juni 2024 – 21. Oktober 2024 Bewerbungsvoraussetzungen: Diese Rekrutierungsveranstaltung für HarmonyOSNEXT Cangjie Language Developer Preview Beta steht nur den folgenden Entwicklern offen: 1) Echte Namen wurden in der Huawei Developer Alliance-Zertifizierung vervollständigt 2) Vervollständigen Sie H

Die Tianjin-Universität und die Beihang-Universität sind maßgeblich am „Cangjie'-Projekt von Huawei beteiligt und haben das erste KI-Agent-Programmier-Framework „Cangqiong' auf Basis inländischer Programmiersprachen auf den Markt gebracht.

Jun 23, 2024 am 08:37 AM

Die Tianjin-Universität und die Beihang-Universität sind maßgeblich am „Cangjie'-Projekt von Huawei beteiligt und haben das erste KI-Agent-Programmier-Framework „Cangqiong' auf Basis inländischer Programmiersprachen auf den Markt gebracht.

Jun 23, 2024 am 08:37 AM

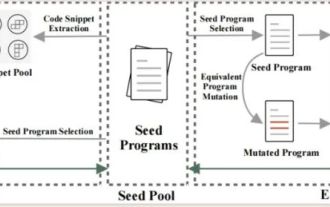

Laut Nachrichten dieser Website vom 22. Juni stellte Huawei gestern Entwicklern auf der ganzen Welt die von Huawei selbst entwickelte Programmiersprache Cangjie vor. Dies ist der erste öffentliche Auftritt der Programmiersprache Cangjie. Laut Anfragen auf dieser Website waren die Tianjin-Universität und die Pekinger Universität für Luft- und Raumfahrt stark an der Forschung und Entwicklung von Huaweis „Cangjie“ beteiligt. Tianjin-Universität: Cangjie-Programmiersprachen-Compiler Das Software-Engineering-Team der Abteilung für Intelligenz und Informatik der Tianjin-Universität hat sich mit dem Huawei Cangjie-Team zusammengetan, um sich intensiv an der Qualitätssicherungsforschung des Cangjie-Programmiersprachen-Compilers zu beteiligen. Berichten zufolge ist der Cangjie-Compiler die Basissoftware, die eine Symbiose mit der Programmiersprache Cangjie eingeht. In der Vorbereitungsphase der Cangjie-Programmiersprache wurde ein hochwertiger Compiler, der dazu passt, zu einem der Kernziele. Während sich die Programmiersprache Cangjie weiterentwickelt, wird der Cangjie-Compiler ständig aktualisiert und verbessert. In den letzten fünf Jahren an der Tianjin-Universität

So wechseln Sie die Sprache in Microsoft-Teams

Feb 23, 2024 pm 09:00 PM

So wechseln Sie die Sprache in Microsoft-Teams

Feb 23, 2024 pm 09:00 PM

In Microsoft Teams stehen viele Sprachen zur Auswahl. Wie kann man also die Sprache wechseln? Benutzer müssen auf das Menü klicken, dann „Allgemein“ auswählen, dann auf „Sprache“ klicken, die Sprache auswählen und sie speichern. Nachfolgend finden Sie eine detaillierte Einführung. Bar! So wechseln Sie die Sprache in Microsoft Teams Antwort: Wählen Sie den spezifischen Prozess unter „Einstellungen – Allgemein – Sprache“ aus: 1. Klicken Sie zunächst auf die drei Punkte neben dem Avatar, um die Einstellungen einzugeben. 2. Klicken Sie dann auf die allgemeinen Optionen im Inneren. 3. Klicken Sie dann auf die Sprache und scrollen Sie nach unten, um weitere Sprachen anzuzeigen. 4. Klicken Sie abschließend auf Speichern und neu starten.

Was soll ich tun, wenn der Microsoft Edge-Browser keine Bilder anzeigt? – Was tun, wenn der Microsoft Edge-Browser keine Bilder anzeigt?

Mar 04, 2024 pm 07:43 PM

Was soll ich tun, wenn der Microsoft Edge-Browser keine Bilder anzeigt? – Was tun, wenn der Microsoft Edge-Browser keine Bilder anzeigt?

Mar 04, 2024 pm 07:43 PM

Kürzlich haben viele Freunde den Editor gefragt, was zu tun ist, wenn der Microsoft Edge-Browser keine Bilder anzeigt. Als Nächstes erfahren Sie, wie Sie das Problem lösen können, dass der Microsoft Edge-Browser keine Bilder anzeigt. 1. Klicken Sie zum Starten zunächst auf die untere linke Ecke und dann mit der rechten Maustaste auf „Microsoft Edge Browser“, wie in der folgenden Abbildung dargestellt. 2. Wählen Sie dann „Mehr“ und klicken Sie auf „App-Einstellungen“, wie in der Abbildung unten gezeigt. 3. Scrollen Sie dann nach unten, um „Bilder“ zu finden, wie im Bild unten gezeigt. 4. Schalten Sie abschließend den Schalter unter dem Bild ein, wie im Bild unten gezeigt. Das Obige ist der gesamte Inhalt, den Ihnen der Editor zur Verfügung stellt, was zu tun ist, wenn der Microsoft Edge-Browser keine Bilder anzeigt. Ich hoffe, dass er Ihnen hilfreich sein kann.

Golangs Bytecode entmystifizieren: Erkundung der Essenz seiner Programmiersprache

Feb 26, 2024 pm 02:36 PM

Golangs Bytecode entmystifizieren: Erkundung der Essenz seiner Programmiersprache

Feb 26, 2024 pm 02:36 PM

Golang (auch bekannt als Go-Sprache) ist eine von Google entwickelte Open-Source-Programmiersprache. Sie wurde erstmals 2007 veröffentlicht und soll die Produktivität und Entwicklungseffizienz von Ingenieuren verbessern. Ziel von Golang ist es, die Komplexität von Programmiersprachen zu vereinfachen und eine effiziente Ausführungsgeschwindigkeit unter Berücksichtigung der Benutzerfreundlichkeit zu gewährleisten. In diesem Artikel werden die Eigenschaften von Golang eingehend untersucht, sein Bytecode-Mechanismus analysiert und sein Funktionsprinzip anhand spezifischer Codebeispiele erläutert. 1. Die Eigenschaften und Vorteile von Golang sind einfach und effizient: Golang hat eine prägnante und reichhaltige grammatikalische Struktur

Huaweis selbst entwickelte offizielle Website und Entwicklungsdokumente für die Programmiersprache Cangjie sind online und integrieren sich erstmals in das Hongmeng-Ökosystem

Jun 22, 2024 am 03:10 AM

Huaweis selbst entwickelte offizielle Website und Entwicklungsdokumente für die Programmiersprache Cangjie sind online und integrieren sich erstmals in das Hongmeng-Ökosystem

Jun 22, 2024 am 03:10 AM

Laut Nachrichten dieser Website wurde am 21. Juni vor der Huawei-Entwicklerkonferenz HDC2024 die von Huawei selbst entwickelte Programmiersprache Cangjie offiziell vorgestellt und die offizielle Website von Cangjie ist jetzt online. Die offizielle Einführung auf der Website zeigt, dass die Programmiersprache Cangjie eine Programmiersprache der neuen Generation für All-Szenario-Intelligenz ist, die sich auf „native Intelligenz, natürliche All-Szenarien, hohe Leistung und starke Sicherheit“ konzentriert. Integrieren Sie sich in das Hongmeng-Ökosystem, um Entwicklern ein gutes Programmiererlebnis zu bieten. Die dieser Website beigefügte offizielle Website stellt Folgendes vor: Natives intelligentes Programmier-Framework, eingebettet in AgentDSL, organische Integration natürlicher Sprache und Multi-Agent-Zusammenarbeit, vereinfachter symbolischer Ausdruck, freie Kombination von Mustern, Unterstützung der Entwicklung verschiedener intelligenter Anwendungen; Von Natur aus leichte und skalierbare Laufzeit für alle Szenen, modulares Schichtdesign, egal wie klein der Speicher ist, es kann eine Domänenerweiterung für alle Szenarien berücksichtigt werden