Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Turing-Preisträger Yang Likun: KI verfügt nur über begrenzte logische Denk- und Planungsfähigkeiten und wird sachliche und logische Fehler machen.

Turing-Preisträger Yang Likun: KI verfügt nur über begrenzte logische Denk- und Planungsfähigkeiten und wird sachliche und logische Fehler machen.

Turing-Preisträger Yang Likun: KI verfügt nur über begrenzte logische Denk- und Planungsfähigkeiten und wird sachliche und logische Fehler machen.

Produziert von Sohu Technology

Autor|Zheng Songyi

Am 9. Juni fand in Peking die Zhiyuan-Konferenz für künstliche Intelligenz 2023 statt. Um vier Uhr morgens Ortszeit in Frankreich hielt Yann LeCun, bekannt als einer der „drei Giganten des Deep Learning in der Welt“, auf der französischen Videokonferenz in Peking eine Rede zum Thema „Auf dem Weg zu einem großen Modell“. „Fähig zu lernen, zu argumentieren und zu planen“ Die Rede drückte ein tiefgreifendes Nachdenken über künstliche Intelligenz aus.

Sohu Technology hat sich diese Rede auf der Zhiyuan-Konferenz angesehen. An Yang Likuns lächelndem Gesichtsausdruck während der Rede können wir Yang Likuns positive und optimistische Haltung gegenüber der Entwicklung künstlicher Intelligenz erkennen. Als Musk und andere zuvor einen gemeinsamen Brief unterzeichneten, in dem sie feststellten, dass die Entwicklung künstlicher Intelligenz Risiken für die menschliche Zivilisation mit sich bringen würde, widerlegte Yang Likun dies öffentlich und glaubte, dass künstliche Intelligenz noch nicht so weit entwickelt sei, dass sie eine ernsthafte Bedrohung für die Menschheit darstelle. In seiner Rede betonte Yang Likun noch einmal, dass künstliche Intelligenz kontrollierbar sei. Er sagte: „Angst entsteht durch die Erwartung möglicher negativer Ergebnisse, während Hochstimmung durch die Vorhersage positiver Ergebnisse erzeugt wird.“ Ich nenne es „zielgesteuerte KI“, sie wird kontrollierbar sein, weil wir ihr über eine Kostenfunktion Ziele setzen können, um sicherzustellen, dass diese Systeme nicht die Welt erobern wollen, sondern sie stattdessen der Menschlichkeit und Sicherheit erliegt.

Yang Likun sagte, dass die Kluft zwischen künstlicher Intelligenz und Menschen und Tieren im logischen Denken und Planen liegt, die wichtige Merkmale der Intelligenz sind. Die heutigen großen Modelle können nur „instinktiv reagieren“.

„Wenn man sie mit einer Billion oder zwei Billionen Token trainiert, ist die Leistung der Maschine erstaunlich, aber irgendwann macht die Maschine sachliche Fehler, logische Fehler und ihre Denkfähigkeiten sind begrenzt.“

Yang Likun betonte, dass Sprachmodelle, die auf Selbstüberwachung basieren, kein Wissen über die reale Welt erlangen können. Er glaubt, dass Maschinen im Vergleich zu Menschen und Tieren nicht sehr gut lernen können. Überwachtes Lernen wurde jahrzehntelang entwickelt, aber überwachtes Lernen erfordert zu viele Etiketten, das Erlernen erfordert viele Versuche und die Ergebnisse des verstärkenden Lernens sind unbefriedigend und machen Fehler falsch und nicht wirklich in der Lage, vernünftig zu denken oder zu planen."Genau wie wenn wir eine Rede halten, wird die Art und Weise, wie wir einen Punkt zum anderen ausdrücken und wie wir Dinge erklären, in unserem Gehirn geplant, anstatt Wort für Wort zu improvisieren. Vielleicht improvisieren wir auf einem niedrigen Niveau, aber auf einem hohen Niveau Wir müssen planen, daher ist die Notwendigkeit einer Planung sehr offensichtlich, dass vernünftige Menschen in relativ kurzer Zeit keine autoregressiven Elemente mehr verwenden werden (eines der Modelle in These). Systeme werden bald aufgegeben, weil sie nicht mehr zu reparieren sind.“

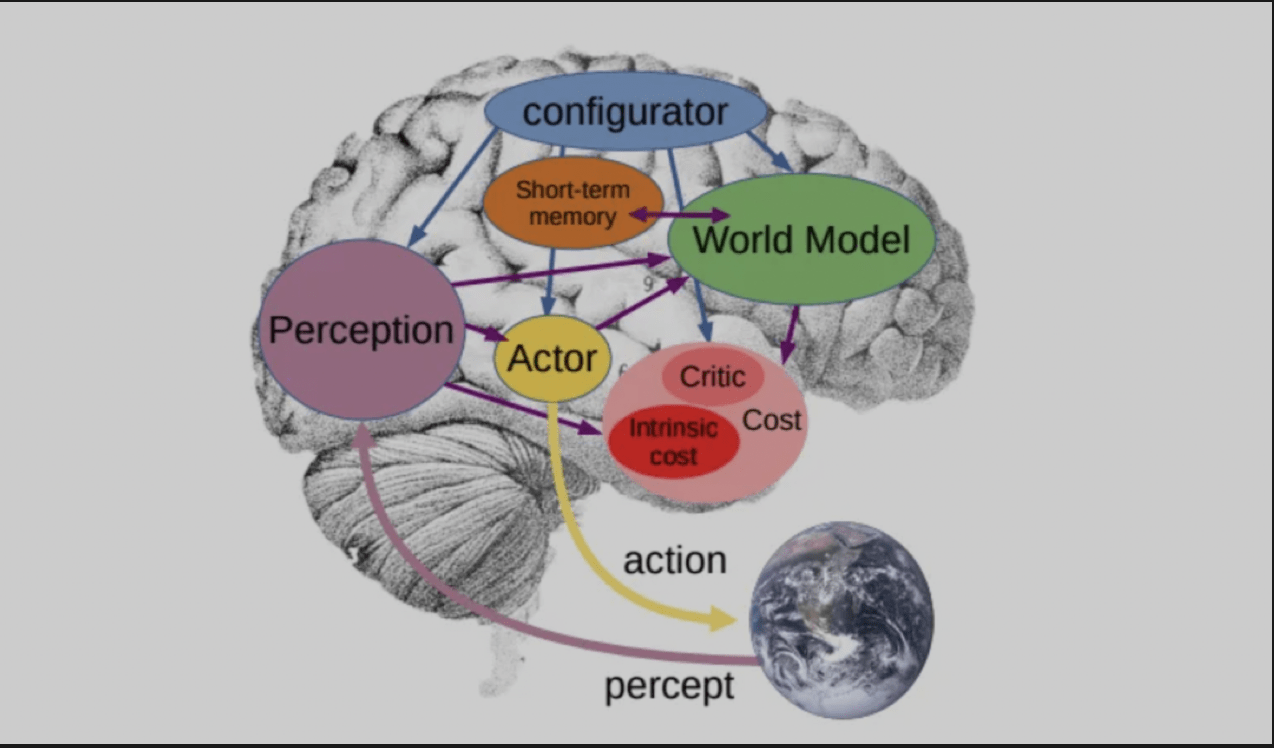

Er sagte, dass, damit das Sprachmodell das Wissen der realen Welt wirklich verstehen kann, eine neue Architektur erforderlich ist, um es zu ersetzen, und diese Architektur ist die Architektur, die er in dem von ihm vor einem Jahr veröffentlichten Artikel „Autonome Intelligenz“ vorgeschlagen hat. . Hierbei handelt es sich um eine Architektur, bei der ein Konfigurationsmodul das gesamte System steuert und auf der Grundlage von Eingabeinformationen Vorhersagen, Überlegungen und Entscheidungen durchführt. Das „Weltmodul“ verfügt über die Fähigkeit, fehlende Informationen abzuschätzen und zukünftige äußere Bedingungen vorherzusagen.

Apropos, Yang Likun stellte ein weiteres Modell vor, das er in der Arbeit „World Model“ veröffentlichte, das sich eine Szene vorstellen und die Ergebnisse von Aktionen basierend auf der Szene vorhersagen kann. Das Ziel besteht darin, eine Abfolge von Aktionen zu finden, die durch das eigene Weltmodell vorhergesagt wird und eine Reihe von Kosten minimiert.

Als Yang Likun während der Frage-und-Antwort-Runde zu einer bevorstehenden Debatte über den Status und die Zukunft von AGI befragt wurde, sagte er, dass sich die Debatte um die Frage drehen werde, ob künstliche Intelligenzsysteme existenzielle Risiken für den Menschen darstellen. Max Tegmark und Yoshua Bengio werden sich für „Ja“ einsetzen und argumentieren, dass leistungsstarke KI-Systeme existenzielle Risiken für den Menschen darstellen könnten. Und Liqun Yang und Melanie Mitchell werden auf der „Nein“-Seite stehen.

„Uns geht es nicht darum, dass es keine Risiken gibt, sondern dass diese Risiken, obwohl sie existieren, durch sorgfältiges Design leicht gemindert oder unterdrückt werden können.“

Yang Likun glaubt, dass das superintelligente System noch nicht entwickelt wurde. Nach seiner Erfindung wird es zu spät sein, darüber zu diskutieren, „ob das superintelligente System für den Menschen sicher gemacht werden kann“.

Das obige ist der detaillierte Inhalt vonTuring-Preisträger Yang Likun: KI verfügt nur über begrenzte logische Denk- und Planungsfähigkeiten und wird sachliche und logische Fehler machen.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Ich habe versucht, die Vibe -Codierung mit Cursor AI und es ist erstaunlich!

Mar 20, 2025 pm 03:34 PM

Die Vibe -Codierung verändert die Welt der Softwareentwicklung, indem wir Anwendungen mit natürlicher Sprache anstelle von endlosen Codezeilen erstellen können. Inspiriert von Visionären wie Andrej Karpathy, lässt dieser innovative Ansatz Dev

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Top 5 Genai Starts vom Februar 2025: GPT-4,5, GROK-3 & MEHR!

Mar 22, 2025 am 10:58 AM

Februar 2025 war ein weiterer bahnbrechender Monat für die Generative KI, die uns einige der am meisten erwarteten Modell-Upgrades und bahnbrechenden neuen Funktionen gebracht hat. Von Xais Grok 3 und Anthropics Claude 3.7 -Sonett, um g zu eröffnen

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Wie benutze ich Yolo V12 zur Objekterkennung?

Mar 22, 2025 am 11:07 AM

Yolo (Sie schauen nur einmal) war ein führender Echtzeit-Objekterkennungsrahmen, wobei jede Iteration die vorherigen Versionen verbessert. Die neueste Version Yolo V12 führt Fortschritte vor, die die Genauigkeit erheblich verbessern

Sora vs Veo 2: Welches erstellt realistischere Videos?

Mar 10, 2025 pm 12:22 PM

Sora vs Veo 2: Welches erstellt realistischere Videos?

Mar 10, 2025 pm 12:22 PM

Google's Veo 2 und Openais Sora: Welcher AI -Videogenerator regiert oberste? Beide Plattformen erzeugen beeindruckende KI -Videos, aber ihre Stärken liegen in verschiedenen Bereichen. Dieser Vergleich unter Verwendung verschiedener Eingabeaufforderungen zeigt, welches Werkzeug Ihren Anforderungen am besten entspricht. T

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google: Wettervorhersage mit Gencast Mini Demo

Mar 16, 2025 pm 01:46 PM

Gencast von Google Deepmind: Eine revolutionäre KI für die Wettervorhersage Die Wettervorhersage wurde einer dramatischen Transformation unterzogen, die sich von rudimentären Beobachtungen zu ausgefeilten AI-angetriebenen Vorhersagen überschreitet. Google DeepMinds Gencast, ein Bodenbrei

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Ist Chatgpt 4 o verfügbar?

Mar 28, 2025 pm 05:29 PM

Chatgpt 4 ist derzeit verfügbar und weit verbreitet, wodurch im Vergleich zu seinen Vorgängern wie ChatGPT 3.5 signifikante Verbesserungen beim Verständnis des Kontextes und des Generierens kohärenter Antworten zeigt. Zukünftige Entwicklungen können mehr personalisierte Inters umfassen

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Welche KI ist besser als Chatgpt?

Mar 18, 2025 pm 06:05 PM

Der Artikel erörtert KI -Modelle, die Chatgpt wie Lamda, Lama und Grok übertreffen und ihre Vorteile in Bezug auf Genauigkeit, Verständnis und Branchenauswirkungen hervorheben. (159 Charaktere)

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

O1 gegen GPT-4O: Ist OpenAIs neues Modell besser als GPT-4O?

Mar 16, 2025 am 11:47 AM

Openais O1: Ein 12-tägiger Geschenkbummel beginnt mit ihrem bisher mächtigsten Modell Die Ankunft im Dezember bringt eine globale Verlangsamung, Schneeflocken in einigen Teilen der Welt, aber Openai fängt gerade erst an. Sam Altman und sein Team starten ein 12-tägiges Geschenk Ex