Backend-Entwicklung

Backend-Entwicklung

PHP-Tutorial

PHP-Tutorial

Verwendung von PHP zur Implementierung eines Crawlers, der zufällig eine Proxy-IP erhält

Verwendung von PHP zur Implementierung eines Crawlers, der zufällig eine Proxy-IP erhält

Verwendung von PHP zur Implementierung eines Crawlers, der zufällig eine Proxy-IP erhält

Mit der Popularisierung des Internets und von Big Data müssen immer mehr Anwendungen und Unternehmen Daten über Webcrawler abrufen. Um ein effizientes, schnelles und stabiles Datencrawlen zu erreichen, ist die Verwendung von Proxy-IP für viele Entwickler zur ersten Wahl geworden .

Bei der Implementierung von Proxy-IP-Crawlern bietet PHP als leistungsstarke und weit verbreitete Back-End-Programmiersprache große Vorteile. In diesem Artikel wird erläutert, wie Sie mit PHP einen Crawler implementieren, der zufällig Proxy-IPs abruft, um Daten besser zu crawlen.

1. Auswahl und Erwerb der Proxy-IP

Bei der Verwendung der Proxy-IP zum Crawlen ist es sehr wichtig, die geeignete Proxy-IP auszuwählen. Bei der Auswahl einer Proxy-IP müssen wir die folgenden Faktoren berücksichtigen:

- Stabilität und Zuverlässigkeit: Durch die Wahl einer stabilen und zuverlässigen Proxy-IP kann der normale Betrieb des Crawlers weitestgehend gewährleistet werden.

- Geschwindigkeit und Reaktionszeit: Die Wahl einer Proxy-IP mit hoher Geschwindigkeit und kurzer Reaktionszeit kann uns dabei helfen, ein schnelleres Daten-Crawling zu erreichen.

- Region und Region: Es ist sehr wichtig, die entsprechende Proxy-IP-Region und -Region entsprechend den tatsächlichen Crawling-Anforderungen auszuwählen. Die Leistung verschiedener Proxy-IP-Regionen und -Regionen ist unterschiedlich.

Um eine Proxy-IP zu erhalten, gibt es mehrere Möglichkeiten:

- Kauf über einen Proxy-IP-Anbieter. Die von großen Proxy-IP-Anbietern bereitgestellte Proxy-IP-Qualität ist relativ zuverlässig und verfügt über einen Kundendienst. Allerdings ist es relativ teuer und für Anwendungen im kleinen Maßstab nicht geeignet.

- Beziehen Sie es kostenlos über Websites, z. B. über kostenlose Proxy-IPs, die von Proxy-IP-Websites bereitgestellt werden. Es gibt jedoch Probleme mit der Verfügbarkeit und Stabilität dieser Proxy-IPs.

- Erstellen Sie Ihren eigenen Proxy-IP-Pool, verwenden Sie einige Open-Source-Proxy-IP-Crawling-Tools, um regelmäßig Proxy-IPs abzurufen und zu testen, und fügen Sie über automatisierte Skripte gültige Proxy-IPs zum Proxy-IP-Pool hinzu.

2. Verwenden Sie PHP, um ein Crawler-Programm zu implementieren.

Wenn Sie PHP zum Schreiben eines Crawler-Programms verwenden, müssen Sie das HTTP-Protokoll verwenden, um Daten anzufordern. Die HTTP-Anforderung kann über die cURL-Erweiterung implementiert werden eine libcurl-basierte Datei, die in PHP-Übertragungstools bereitgestellt wird.

- cURL-Erweiterung installieren

Bevor Sie die cURL-Erweiterung verwenden, müssen Sie cURL und die cURL-Erweiterung auf dem Server installieren. Führen Sie den folgenden Befehl in der Befehlszeile aus:

sudo apt-get install curl sudo apt-get install php-curl

- Implementieren Sie eine Funktion, um die Proxy-IP zufällig zu erhalten.

Zuerst müssen wir eine Funktion implementieren, um die Proxy-IP zufällig zu erhalten:

<?php

function getProxyIp($proxyList) {

if (empty($proxyList)) {

return null;

}

$index = rand(0, count($proxyList) - 1);

return $proxyList[$index];

}

?>In dieser Funktion übergeben wir einen Proxy-IP-Pool, dann einen Index über eine Zufallszahl generieren, eine zufällige Proxy-IP aus dem Proxy-IP-Pool abrufen und zurückgeben.

- Schreiben Sie eine Funktion zum Crawlen von Daten

Als nächstes müssen wir eine Funktion zum Crawlen von Daten schreiben:

<?php

function getContent($url, $proxyList = array()) {

$ch = curl_init();

curl_setopt($ch, CURLOPT_URL, $url);

curl_setopt($ch, CURLOPT_RETURNTRANSFER, true);

if (!empty($proxyList)) {

$proxy = getProxyIp($proxyList);

if ($proxy) {

curl_setopt($ch, CURLOPT_PROXY, $proxy['ip']);

if (!empty($proxy['user_pwd'])) {

curl_setopt($ch, CURLOPT_PROXYUSERPWD, $proxy['user_pwd']);

}

}

}

$content = curl_exec($ch);

curl_close($ch);

return $content;

}

?>In dieser Funktion übergeben wir die zu crawlende URL und den Proxy-IP-Pool. Nach dem Festlegen von Parametern wie URL und Rückgabeergebnis über die Funktion „curl_setopt“ wird bei einem eingehenden Proxy-IP-Pool eine Proxy-IP zufällig abgerufen und festgelegt.

Führen Sie abschließend die Funktion „curl_exec“ aus, um die Daten abzurufen, schließen Sie „Curl“ und geben Sie die Daten zurück.

- Rufen Sie die Crawler-Funktion auf, um Daten abzurufen

Abschließend können wir Daten erhalten, indem wir die Crawler-Funktion getContent aufrufen:

<?php

$url = 'https://www.example.com';

$proxyList = array(

array('ip' => '127.0.0.1:8888', 'user_pwd' => ''),

array('ip' => '192.168.1.1:8080', 'user_pwd' => 'user:passwd'),

);

$content = getContent($url, $proxyList);

echo $content;

?>In diesem Beispiel übergeben wir eine zu crawlende URL und einen Proxy-IP-Pool, die getContent-Funktion wählt automatisch zufällig eine Proxy-IP aus und ruft Daten ab. Abschließend geben wir die erhaltenen Daten aus.

Auf diese Weise ist es sehr einfach, mit PHP einen Crawler zu implementieren, der zufällig Proxy-IPs erhält.

Fazit

Die Verwendung von Proxy-IP zum Crawlen kann uns helfen, Daten stabiler zu erhalten, aber gleichzeitig müssen wir auch den Erwerb und die Verfügbarkeit von Proxy-IP berücksichtigen. In der heutigen Einführung erfahren Sie, wie Sie mit PHP einen Crawler implementieren, der zufällig Proxy-IPs abruft, um Daten besser zu crawlen.

Das obige ist der detaillierte Inhalt vonVerwendung von PHP zur Implementierung eines Crawlers, der zufällig eine Proxy-IP erhält. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

PHP 8.4 Installations- und Upgrade-Anleitung für Ubuntu und Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 Installations- und Upgrade-Anleitung für Ubuntu und Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 bringt mehrere neue Funktionen, Sicherheitsverbesserungen und Leistungsverbesserungen mit einer beträchtlichen Menge an veralteten und entfernten Funktionen. In dieser Anleitung wird erklärt, wie Sie PHP 8.4 installieren oder auf PHP 8.4 auf Ubuntu, Debian oder deren Derivaten aktualisieren. Obwohl es möglich ist, PHP aus dem Quellcode zu kompilieren, ist die Installation aus einem APT-Repository wie unten erläutert oft schneller und sicherer, da diese Repositorys in Zukunft die neuesten Fehlerbehebungen und Sicherheitsupdates bereitstellen.

CakePHP Datum und Uhrzeit

Sep 10, 2024 pm 05:27 PM

CakePHP Datum und Uhrzeit

Sep 10, 2024 pm 05:27 PM

Um in cakephp4 mit Datum und Uhrzeit zu arbeiten, verwenden wir die verfügbare FrozenTime-Klasse.

CakePHP-Datei hochladen

Sep 10, 2024 pm 05:27 PM

CakePHP-Datei hochladen

Sep 10, 2024 pm 05:27 PM

Um am Datei-Upload zu arbeiten, verwenden wir den Formular-Helfer. Hier ist ein Beispiel für den Datei-Upload.

Besprechen Sie CakePHP

Sep 10, 2024 pm 05:28 PM

Besprechen Sie CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP ist ein Open-Source-Framework für PHP. Es soll die Entwicklung, Bereitstellung und Wartung von Anwendungen erheblich vereinfachen. CakePHP basiert auf einer MVC-ähnlichen Architektur, die sowohl leistungsstark als auch leicht zu verstehen ist. Modelle, Ansichten und Controller gu

CakePHP erstellt Validatoren

Sep 10, 2024 pm 05:26 PM

CakePHP erstellt Validatoren

Sep 10, 2024 pm 05:26 PM

Der Validator kann durch Hinzufügen der folgenden zwei Zeilen im Controller erstellt werden.

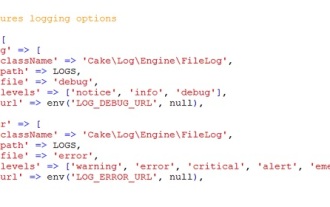

CakePHP-Protokollierung

Sep 10, 2024 pm 05:26 PM

CakePHP-Protokollierung

Sep 10, 2024 pm 05:26 PM

Die Anmeldung bei CakePHP ist eine sehr einfache Aufgabe. Sie müssen nur eine Funktion verwenden. Sie können Fehler, Ausnahmen, Benutzeraktivitäten und von Benutzern durchgeführte Aktionen für jeden Hintergrundprozess wie Cronjob protokollieren. Das Protokollieren von Daten in CakePHP ist einfach. Die Funktion log() wird bereitgestellt

So richten Sie Visual Studio-Code (VS-Code) für die PHP-Entwicklung ein

Dec 20, 2024 am 11:31 AM

So richten Sie Visual Studio-Code (VS-Code) für die PHP-Entwicklung ein

Dec 20, 2024 am 11:31 AM

Visual Studio Code, auch bekannt als VS Code, ist ein kostenloser Quellcode-Editor – oder eine integrierte Entwicklungsumgebung (IDE) –, die für alle gängigen Betriebssysteme verfügbar ist. Mit einer großen Sammlung von Erweiterungen für viele Programmiersprachen kann VS Code c

CakePHP-Kurzanleitung

Sep 10, 2024 pm 05:27 PM

CakePHP-Kurzanleitung

Sep 10, 2024 pm 05:27 PM

CakePHP ist ein Open-Source-MVC-Framework. Es erleichtert die Entwicklung, Bereitstellung und Wartung von Anwendungen erheblich. CakePHP verfügt über eine Reihe von Bibliotheken, um die Überlastung der häufigsten Aufgaben zu reduzieren.