Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

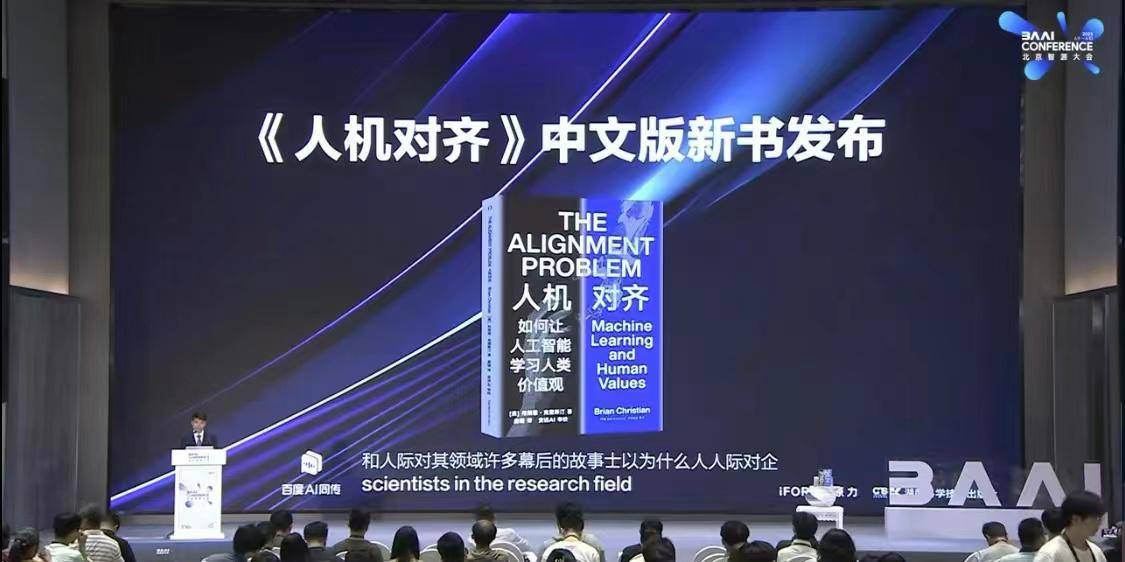

Das Thema KI-Sicherheit hat auf der Intelligent Source Conference 2023 große Aufmerksamkeit erregt und das neue Buch „Human-Machine Alignment' wurde veröffentlicht.

Das Thema KI-Sicherheit hat auf der Intelligent Source Conference 2023 große Aufmerksamkeit erregt und das neue Buch „Human-Machine Alignment' wurde veröffentlicht.

Das Thema KI-Sicherheit hat auf der Intelligent Source Conference 2023 große Aufmerksamkeit erregt und das neue Buch „Human-Machine Alignment' wurde veröffentlicht.

Viele Entdecker und Praktiker auf dem Gebiet der KI kamen zusammen, um Forschungsergebnisse auszutauschen, praktische Erfahrungen auszutauschen und über die Schönheit von Wissenschaft und Technologie zu sprechen. Die Beijing Intelligent Source Conference 2023 wurde kürzlich erfolgreich als umfassende Expertenveranstaltung auf diesem Gebiet abgehalten Im Bereich der künstlichen Intelligenz glänzt diese Veranstaltung durch den Austausch von Ideen und wird Zeuge einer erstaunlichen Entwicklung der Intelligenz mit Hunderten wunderbaren Berichten und Diskussionen.

Im AI Security and Alignment Forum haben viele Experten und Wissenschaftler darüber gesprochen, wie man im Zeitalter großer Modelle sicherstellen kann, dass immer leistungsfähigere und vielseitigere Systeme der künstlichen Intelligenz sicher und kontrollierbar sind und mit menschlichen Absichten und Werten im Einklang stehen äußerst wichtiges Thema. Dieses Sicherheitsproblem wird auch als Problem der Mensch-Maschine-Ausrichtung (KI-Ausrichtung) bezeichnet und stellt eine der dringendsten und bedeutsamsten wissenschaftlichen Herausforderungen dar, vor denen die menschliche Gesellschaft in diesem Jahrhundert steht.

Auf dem Forum konzentrierten sich 14 in- und ausländische Gäste, darunter „Vater des Deep Learning“ Geoffrey Hinton, OpenAI-Gründer Sam Altman und Akademiker Zhang Bo, auf die Mensch-Maschine-Ausrichtung und die Machbarkeit großer Modelle Ganz im Einklang mit den Themen dieses Forums wurde auf der Konferenz auch Brian Christians neuestes Werk „The Alignment Problem“ offiziell veröffentlicht, dessen chinesische Version den Titel „Human-Machine Alignment“ trägt. Das Buch wurde von Hunan Science and Technology Press vorgestellt und veröffentlicht und von Anyuan AI rezensiert. Xie Minxi, Gründer von Anyuan AI, leitete die Zeremonie zur Veröffentlichung des neuen Buches.

Brian Christian, Autor von „Human-Computer Alignment“, wurde eingeladen, online zu sprechen. In seiner Rede richtete er zunächst Grüße an die Leser und Gäste der Versammlung. Er fühlt sich durch die Veröffentlichung des neuen Buches „Human-Machine Alignment“ geehrt und hofft, dass das Buch zur weiteren Forschung auf dem Gebiet der künstlichen Intelligenz in China beitragen kann. Gleichzeitig wird eine kurze Einführung in die Hauptinhalte von „Human-Machine Alignment“ gegeben: Das Buch ist in drei Teile gegliedert Autonomie mit Schwerpunkt auf Supervision und selbstüberwachtem Lernen bis hin zu verstärkendem Lernen. Der dritte Artikel untersucht, wie wir komplexe KI-Systeme in der realen Welt auf der Grundlage von überwachtem Lernen, selbstüberwachtem Lernen und verstärkendem Lernen ausrichten. Wir hoffen, dass die Veröffentlichung von „Human-Computer Alignment“ in China nicht nur Forschern hilft, sondern uns auch dabei hilft, unsere Begeisterung für dieses Gebiet jedem Laien zu vermitteln. Abschließend brachte er seine Erwartung zum Ausdruck, dass die globale Entwicklung auf dem Gebiet der künstlichen Intelligenz durch die Diskussionen auf dieser Konferenz und Chinas Forschung auf dem Gebiet der KI vorangetrieben werde.

《Mensch-Maschine-Ausrichtung》

【US】Geschrieben von Brian Christian; Übersetzt von Tang Lu

Herausgeber: Hunan Science and Technology Press

Moderne maschinelle Lernsysteme sind sehr leistungsfähig geworden und können in unserem Namen in verschiedenen Situationen Informationen beobachten und abhören und Entscheidungen für uns treffen. Aber die Alarmglocken haben geläutet. Da maschinelles Lernen rasant voranschreitet, nehmen auch die Bedenken zu. Potenzielle Risiken und ethische Probleme können entstehen, wenn sich künstliche Intelligenz (KI) nicht im Einklang mit unseren wahren Zielen verhält. Die Forscher bezeichnen es als Alignment-Problem.

In einem anschaulichen Stil erklärt Brian Christian klar und deutlich die Probleme, die untrennbar mit der KI und uns verbunden sind, und die Leser seiner Bestseller haben davon sehr profitiert. Im Buch lernen wir die erste Gruppe von Wissenschaftlern kennen, die sich aktiv mit dem Alignment-Problem beschäftigt haben, und erfahren von ihren außergewöhnlichen Bemühungen und ehrgeizigen Plänen, zu verhindern, dass die Entwicklung der KI außer Kontrolle gerät. Kristen beschrieb nicht nur prägnant die Entwicklungsgeschichte des maschinellen Lernens, sondern ging auch persönlich tief in die Front der wissenschaftlichen Forschung, um mit Wissenschaftlern zu sprechen und die bahnbrechenden Fortschritte des maschinellen Lernens präzise darzustellen. Der Erfolg oder Misserfolg der Forschung zu Ausrichtungsfragen wird einen entscheidenden Einfluss auf die Zukunft der Menschheit haben, und die Leser können sich dessen zutiefst bewusst sein.

Das Problem der Ausrichtung ist auch ein Spiegel, der die eigenen Vorurteile und blinden Flecken der Menschen aufdeckt und es uns ermöglicht, unsere eigenen nie geklärten Annahmen und oft widersprüchlichen Ziele klar zu erkennen. Dies ist ein brillantes, interdisziplinäres Epos, das nicht nur die menschliche Technologie, sondern auch die menschliche Kultur untersucht, manchmal frustrierend und manchmal aufschlussreich.

Dieses Buch stieß bei seiner Veröffentlichung im Ausland auf begeisterte Resonanz. Es wurde von Microsoft-CEO Satya Nadella als eines der fünf Bücher bezeichnet, die ihn im Jahr 2021 am meisten inspirieren, und von der New York Times als eine der Schlüsseltechnologien und Ethik der KI bewertet . Das beste Buch zu diesem Problem, wie der Autor Brian Christian sagte: „Ich hoffe, dass das chinesische KI-Feld und die breiteren chinesischen Leser dieses Buch auch lesen können. Ich hoffe, dass dieses Buch für Sie reich an Inhalten ist und zum Nachdenken anregt.“ , und inspirierend, nicht nur hilfreich für Forscher, sondern auch hilfreich für Sie, Ihre Begeisterung für dieses Gebiet in Ihrem Leben an Nicht-Informatiker weiterzugeben.“

Xiaoxiang Morning News-Reporter Zhou Shihao

Das obige ist der detaillierte Inhalt vonDas Thema KI-Sicherheit hat auf der Intelligent Source Conference 2023 große Aufmerksamkeit erregt und das neue Buch „Human-Machine Alignment' wurde veröffentlicht.. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Im KI-Zeitalter hat die sichere Nutzung von ChatGPT heftige Diskussionen ausgelöst

Jun 03, 2023 pm 05:35 PM

Im KI-Zeitalter hat die sichere Nutzung von ChatGPT heftige Diskussionen ausgelöst

Jun 03, 2023 pm 05:35 PM

ChatGPT hat seit seiner öffentlichen Einführung im November 2022 ein deutliches Wachstum verzeichnet. Für viele Unternehmen und Privatpersonen ist es zu einem unverzichtbaren Tool geworden, aber da ChatGPT in großem Umfang in unser tägliches Leben und unsere Arbeit integriert ist, werden sich die Leute natürlich fragen: Ist die Verwendung von ChatGPT sicher? ChatGPT gilt aufgrund der umfangreichen Sicherheitsmaßnahmen, Datenverarbeitungsmethoden und Datenschutzrichtlinien, die von seinen Entwicklern implementiert wurden, allgemein als sicher. Allerdings ist ChatGPT wie jede Technologie nicht immun gegen Sicherheitsprobleme und Schwachstellen. Dieser Artikel hilft Ihnen, die Sicherheit von ChatGPT- und AI-Sprachmodellen besser zu verstehen. Wir werden Aspekte wie Datenvertraulichkeit, Benutzerdatenschutz, potenzielle Risiken, KI-Regulierung und Sicherheitsmaßnahmen untersuchen. Schließlich werden Sie sich für Chat interessieren

Wenn KI auf Betrug stößt

May 31, 2023 pm 02:06 PM

Wenn KI auf Betrug stößt

May 31, 2023 pm 02:06 PM

„Obwohl ich weiß, dass Betrug heutzutage weit verbreitet ist, kann ich immer noch nicht glauben, dass ich tatsächlich auf einen gestoßen bin.“ Am 23. Mai war Leserin Wu Jia (Pseudonym) immer noch verängstigt, als sie sich an den Telekommunikationsbetrug erinnerte, dem sie vor ein paar Tagen ausgesetzt war. Bei dem Betrug, dem Wu Jia begegnete, nutzte die Betrügerin KI, um ihr Gesicht in das Gesicht einer ihr bekannten Person zu verwandeln. Wu Jia war nicht nur in ihrem täglichen Leben auf KI-Betrug gestoßen, vor dem sie sich nur schwer schützen konnte, ein Reporter von Beijing Business Daily bemerkte auch, dass neue Telekommunikationsbetrugsmodelle, die KI-Technologie nutzen, in den letzten Tagen eine hohe Erfolgsquote gezeigt haben liegt bei nahezu 100 %.“ „Technologiethemen wie „Der Firmeninhaber wurde in 10 Minuten um 4,3 Millionen Yuan betrogen“ waren nacheinander in den heißen Suchthemen, was auch Diskussionen unter den Benutzern über die Anwendung neuer Technologien ausgelöst hat Technologien. „KI verändert das Gesicht“-Betrug Künstliche Intelligenz ist wieder populär geworden, dieses Mal im Zusammenhang mit Telekommunikationsbetrug. Wu Jia

Ein langer Artikel mit 10.000 Wörtern: Dekonstruktion der Kette, Lösungen und unternehmerischen Möglichkeiten der KI-Sicherheitsbranche

Jun 06, 2023 pm 12:53 PM

Ein langer Artikel mit 10.000 Wörtern: Dekonstruktion der Kette, Lösungen und unternehmerischen Möglichkeiten der KI-Sicherheitsbranche

Jun 06, 2023 pm 12:53 PM

Kernpunkte: 1. Das Sicherheitsproblem großer KI-Modelle ist nie ein einzelnes Problem, genau wie das menschliche Gesundheitsmanagement, es ist eine komplexe und systematische Systemtechnik, die mehrere Themen und die gesamte Industriekette einbezieht. 2. Die KI-Sicherheit ist unterteilt in: die Sicherheit großer Sprachmodelle (AISafety), die Sicherheit von Modellen und Nutzungsmodellen (Security for AI) und die Auswirkungen der Entwicklung großer Sprachmodelle auf die bestehende Netzwerksicherheit, die dem Einzelnen entspricht Sicherheit, Umweltsicherheit und soziale Sicherheit. 3. KI als „neue Spezies“ erfordert eine Sicherheitsüberwachung während des Trainingsprozesses großer Modelle. Wenn die großen Modelle schließlich auf den Markt gebracht werden, benötigen sie auch eine „Qualitätsprüfung“. und müssen auf kontrollierte Weise verwendet werden. Dies sind alles Makros zur Lösung von Sicherheitsproblemen

Das Thema KI-Sicherheit hat auf der Intelligent Source Conference 2023 große Aufmerksamkeit erregt und das neue Buch „Human-Machine Alignment' wurde veröffentlicht.

Jun 14, 2023 pm 10:34 PM

Das Thema KI-Sicherheit hat auf der Intelligent Source Conference 2023 große Aufmerksamkeit erregt und das neue Buch „Human-Machine Alignment' wurde veröffentlicht.

Jun 14, 2023 pm 10:34 PM

Viele Forscher und Praktiker auf dem Gebiet der KI kamen zusammen, um Forschungsergebnisse auszutauschen, praktische Erfahrungen auszutauschen und über die Schönheit von Wissenschaft und Technologie zu sprechen. Die Beijing Intelligent Source Conference 2023 wurde kürzlich erfolgreich als umfassende Expertenveranstaltung auf diesem Gebiet abgehalten der künstlichen Intelligenz, dieser vor Weisheit strahlende Gedanke, tauschen Sie sich aus und werden Sie Zeuge einer erstaunlichen Entwicklung der Intelligenz mit Hunderten wunderbaren Berichten und Diskussionen. Auf dem AI Security and Alignment Forum diskutierten viele Experten und Wissenschaftler darüber, wie im Zeitalter großer Modelle sichergestellt werden kann, dass immer leistungsfähigere und vielseitigere Systeme der künstlichen Intelligenz sicher, kontrollierbar und im Einklang mit menschlichen Absichten und Werten sind äußerst wichtiges Thema. Dieses Sicherheitsproblem ist auch als Problem der Mensch-Maschine-Ausrichtung (AIalignment) bekannt und stellt eine der dringendsten und bedeutsamsten wissenschaftlichen Herausforderungen dar, vor denen die menschliche Gesellschaft in diesem Jahrhundert steht. Argument

„Großbritannien, die USA und 28 weitere Länder haben vereinbart, die Zusammenarbeit im Bereich KI-Sicherheit zu stärken, um katastrophale Verletzungen zu verhindern.'

Nov 02, 2023 pm 05:41 PM

„Großbritannien, die USA und 28 weitere Länder haben vereinbart, die Zusammenarbeit im Bereich KI-Sicherheit zu stärken, um katastrophale Verletzungen zu verhindern.'

Nov 02, 2023 pm 05:41 PM

Länder wie das Vereinigte Königreich, die USA und China haben sich auf einen Konsens über die Risiken der fortgeschrittenen künstlichen Intelligenz geeinigt und sich verpflichtet, dafür zu sorgen, dass die Technologie sicher entwickelt und eingesetzt wird. Auf dem zweitägigen „Global Artificial Intelligence Security Summit“ der britischen Regierung, der diese Woche stattfand, unterzeichneten 28 Länder, darunter Brasilien, Indien, Nigeria und Saudi-Arabien, sowie die Europäische Union ein KI-Abkommen namens „Bletchley Declaration“. Die britische Regierung sagte, die Erklärung erfülle das Hauptziel des Gipfels, eine gemeinsame Einigung und Verantwortlichkeiten für die Risiken, Chancen und die internationale Zusammenarbeit zu schaffen, die in der fortgeschrittenen KI-Sicherheit und -Forschung voranschreiten, insbesondere durch eine umfassendere wissenschaftliche Zusammenarbeit. Die teilnehmenden Länder teilten die Ansicht, dass potenzieller vorsätzlicher Missbrauch ernsthafte Risiken bergen könnte, und äußerten Bedenken hinsichtlich Cybersicherheit, Biotechnologie, Desinformation, Voreingenommenheit und Datenschutzrisiken.

Lassen Sie sich nicht bloßstellen, geben Sie die KI auf und entfernen Sie sich so schnell wie möglich von der Erde! Was bedeutet Hawkings Rat?

Oct 21, 2023 pm 05:17 PM

Lassen Sie sich nicht bloßstellen, geben Sie die KI auf und entfernen Sie sich so schnell wie möglich von der Erde! Was bedeutet Hawkings Rat?

Oct 21, 2023 pm 05:17 PM

Suchen Sie nicht aktiv nach Außerirdischen! Versuchen Sie, sich so schnell wie möglich von der Erde zu entfernen! Geben Sie die Entwicklung künstlicher Intelligenz auf, sonst wird sie der Welt Zerstörung bringen. Das sind die drei Ratschläge, die der verstorbene Physiker Stephen Hawking der Welt hinterlassen hat. Vielleicht werden Sie denken, dass seine Aussage zwangsläufig etwas übertrieben oder sogar alarmierend ist. Aber haben Sie jemals darüber nachgedacht, wie die Welt aussehen würde, wenn seine Sorgen endlich wahr würden? Wenn Sie sich für außerirdische Zivilisationen interessieren, haben Sie bestimmt schon einmal vom Namen SETI gehört. Es handelt sich um einen experimentellen Plan, weltweit vernetzte Computer zur Suche nach außerirdischen Zivilisationen einzusetzen. Seit seiner Gründung im Jahr 1999 ist es unermüdlich auf der Suche nach verdächtigen Signalen im Universum. Und ich freue mich darauf, eines Tages einer fernen außerirdischen Zivilisation zu begegnen. Aber Hawking glaubt, dass dies der Fall ist

Huayunan und andere Einheiten initiierten gemeinsam die Gründung der „AI Security Working Group', um die Zusammenarbeit und Forschung im Bereich der KI-Sicherheit zu stärken.

Sep 18, 2023 am 11:53 AM

Huayunan und andere Einheiten initiierten gemeinsam die Gründung der „AI Security Working Group', um die Zusammenarbeit und Forschung im Bereich der KI-Sicherheit zu stärken.

Sep 18, 2023 am 11:53 AM

Am Nachmittag des 7. September kündigte die Cloud Security Alliance (CSA) Greater China, die weltweit maßgebliche internationale Industrieorganisation, auf dem Forum „Exploring the Next Generation of Security Intelligence“ auf der Inclusion Bund-Konferenz 2023 die Einrichtung einer „KI“ an Sicherheitsarbeitsgruppe". Huayunan und China Mehr als 30 Institutionen, darunter das Telecommunications Research Institute, die Ant Group, Huawei, die Xi'an University of Electronic Science and Technology und das Shenzhen National Financial Technology Evaluation Center, wurden die ersten Sponsoren. Die „AI Security Working Group“ setzt sich dafür ein, gemeinsam die Sicherheitsprobleme zu lösen, die durch die rasante Entwicklung der KI-Technologie entstehen. Die Cloud Security Alliance Greater China AI Security Working Group wird gemeinsam vom China Telecom Research Institute und der Ant Group geleitet. Die Arbeitsgruppe wird Unternehmen, Schulen, Forschungseinrichtungen und Benutzereinheiten zusammenbringen, die an der vor- und nachgelagerten Industriekette der künstlichen Intelligenz beteiligt sind innerhalb der Allianz.

Das weltweit erste Institut für KI-Sicherheitsforschung wird in Großbritannien gegründet

Oct 27, 2023 am 11:21 AM

Das weltweit erste Institut für KI-Sicherheitsforschung wird in Großbritannien gegründet

Oct 27, 2023 am 11:21 AM

Nachrichten des IT-Hauses vom 27. Oktober, basierend auf Berichten von CNBC, Reuters und anderen Berichten, kündigte der britische Premierminister Sunak am Donnerstag Ortszeit Pläne an, das weltweit erste KI-Sicherheitsforschungsinstitut zu gründen und am 1. und 2. November eine KI-Sicherheitskonferenz abzuhalten. Sicherheitsgipfel. Auf dem Gipfel kommen KI-Unternehmen, Regierungen, die Zivilgesellschaft und Experten aus verwandten Bereichen aus der ganzen Welt zusammen, um zu diskutieren, wie die von KI ausgehenden Risiken durch international koordinierte Maßnahmen verringert werden können. Quelle Pexels Sunak sagte in seiner Rede, dass dieses demnächst gegründete Institut das weltweite Verständnis der KI-Sicherheit fördern und neue KI-Technologien sorgfältig erforschen, bewerten und testen wird, um die Fähigkeiten jedes neuen Modells zu verstehen und die verschiedenen Risiken zu erkunden soziale Schäden wie „Voreingenommenheit und Fehlinformationen“ bis hin zu „extremsten Risiken“. Sunak sagte: „KI