Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

ChatGPT großes Update! OpenAI bietet Programmierern ein Geschenkpaket: Die API fügt Killerfunktionen hinzu und die Preise werden gesenkt, neue Modelle und ein vierfacher Kontext kommen

ChatGPT großes Update! OpenAI bietet Programmierern ein Geschenkpaket: Die API fügt Killerfunktionen hinzu und die Preise werden gesenkt, neue Modelle und ein vierfacher Kontext kommen

ChatGPT großes Update! OpenAI bietet Programmierern ein Geschenkpaket: Die API fügt Killerfunktionen hinzu und die Preise werden gesenkt, neue Modelle und ein vierfacher Kontext kommen

ChatGPT hat sich über Nacht erneut weiterentwickelt und OpenAI hat eine große Anzahl von Updates auf einmal veröffentlicht!

Der Kern ist die neue Funktionsaufruffähigkeit der API. Ähnlich wie bei der Webversion des Plug-Ins kann die API auch externe Tools nutzen.

Diese Fähigkeit liegt in den Händen von Entwicklern, und Funktionen, über die die ChatGPT-API ursprünglich nicht verfügt, können auch durch verschiedene Dienste von Drittanbietern gelöst werden.

Manche Leute denken, dass dies eine Killerfunktion und das wichtigste Update seit der Veröffentlichung der ChatGPT-API ist.

Darüber hinaus ist dieses Update zur ChatGPT-APIAlle sind sehr wichtig, nicht nur die Kapazität wird erhöht, sondern auch der Preis ist niedriger:

- Neue Versionen gpt-4-0613 und gpt-3.5- eingeführt Turbo -0613-Modell

- Die Kontextlänge von gpt-3.5-turbo wurde um 400 % von 4k auf 16k erhöht. Der Preis für den gpt-3.5-turbo-Eingabetoken wurde um 25 % reduziert. Der Preis für das fortschrittlichste Einbettungsmodell wurde um 75 % reduziert GPT-4-API groß Die Skala ist offen, bis die Warteschlangenliste gelöscht ist

- Die Nachricht hat China erreicht, und einige Internetnutzer glauben, dass dies eine große Herausforderung für große inländische Modelle darstellt.

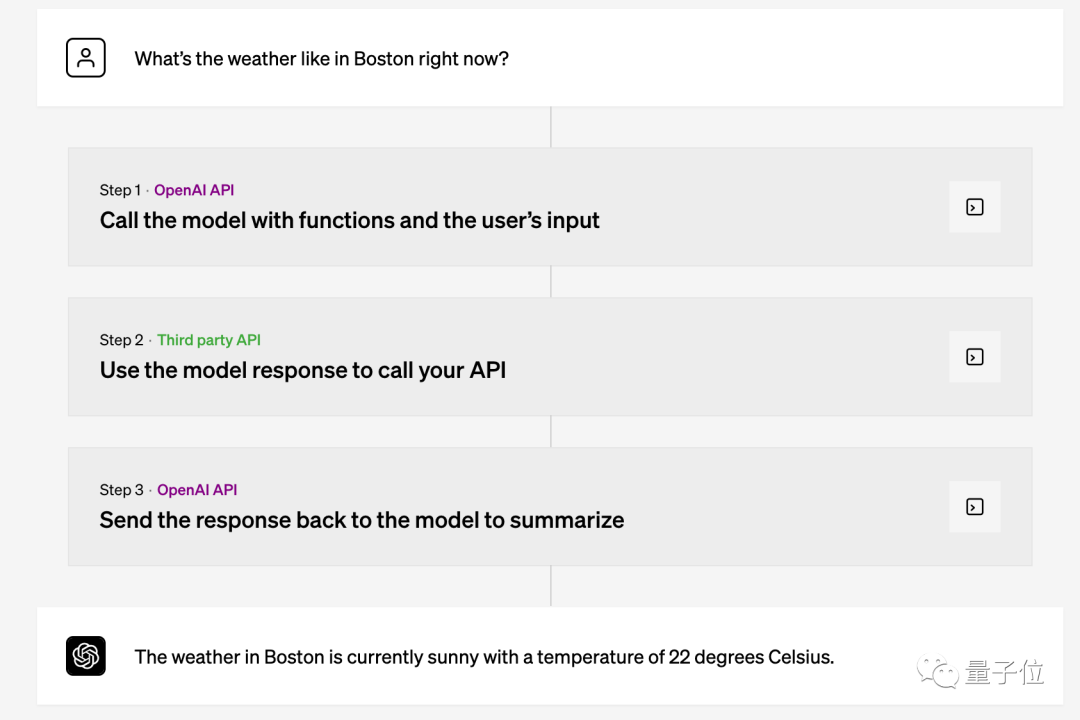

Entwickler benötigen das Modell nur, um die Funktionen zu beschreiben, die verwendet werden müssen. Wann welche Funktion aufgerufen werden soll, wird vom Modell selbst anhand der Eingabeaufforderungswörter bestimmt, was dem Mechanismus des ChatGPT-Aufrufs von Plug-Ins entspricht.

Entwickler benötigen das Modell nur, um die Funktionen zu beschreiben, die verwendet werden müssen. Wann welche Funktion aufgerufen werden soll, wird vom Modell selbst anhand der Eingabeaufforderungswörter bestimmt, was dem Mechanismus des ChatGPT-Aufrufs von Plug-Ins entspricht.

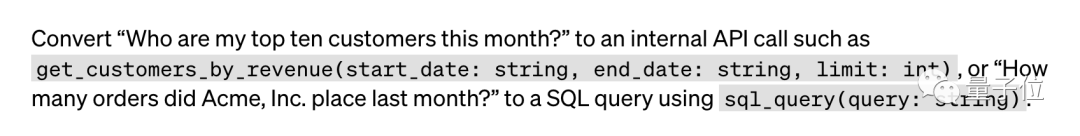

Für spezifische Nutzungsmethoden nennt der Beamte drei Beispiele:

Erstens

ruft der Chatbot eine externe API auf, um Vorgänge auszuführen oder Fragen zu beantworten, wie zum Beispiel „Jemanden eine E-Mail senden“ oder „Wie ist das Wetter heute?“ " ".

Zweitens: Konvertieren Sie natürliche Sprache in API-Aufrufe oder Datenbankabfragen, z. B. „Wie viele Bestellungen gab es letzten Monat?“ Es werden automatisch SQL-Abfrageanweisungen generiert.

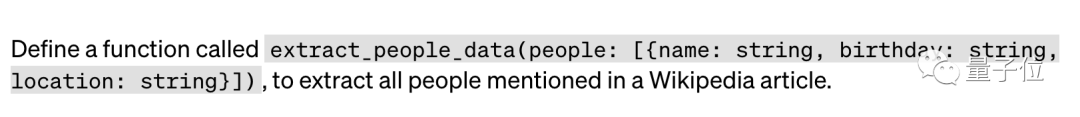

Drittens: Extrahieren Sie automatisch strukturierte Daten aus dem Text. Sie müssen beispielsweise nur den erforderlichen „Namen, Geburtstag, Ort“ definieren und einen Weblink angeben, und schon können Sie einen Wikipedia-Artikel automatisch extrahieren Informationen zu allen im Artikel genannten Personen.

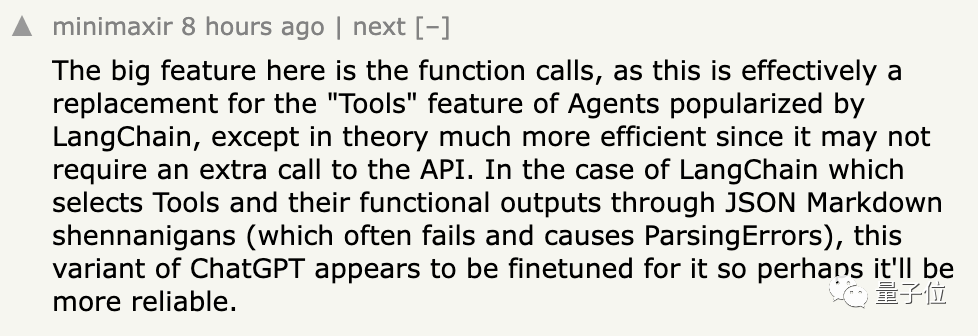

Wenn Sie in der Vergangenheit wollten, dass GPT Funktionen aufruft, mussten Sie die Tools von LangChain verwenden. ...Obwohl LangChain theoretisch eine höhere Betriebseffizienz aufweist, ist seine Zuverlässigkeit schlechter als die des speziell abgestimmten neuen GPT.

gpt-3.5-turbo-16k unterstützt keine Funktionsaufrufe und bietet die vierfache Kontextlänge, was bedeutet, dass eine Anfrage etwa 20 Textseiten unterstützen kann.Derzeit hat die neue Version des Modells nach und nach mit der Iteration begonnen.

Die neuesten Versionen von gpt-4-0613, gpt-3.5-turbo-0613 und die erweiterte Kontextlänge gpt-4-32k-0613 unterstützen alle Funktionsaufrufe.

Auch alte Modelle werden nach und nach aufgegeben.

Auch alte Modelle werden nach und nach aufgegeben.

Apps, die die ersten Versionen von gpt-3.5-turbo und gpt-4 verwenden, werden am 27. Juni automatisch auf die neue Version aktualisiert.

Entwickler, die mehr Zeit für die Umstellung benötigen, können auch manuell festlegen, dass sie weiterhin die alte Version verwenden möchten, jedoch weiterhin 13. September Alle Anfragen für ältere Versionen werden in Zukunft komplett verworfen.

Nachdem wir über diesen Zeitplan gesprochen haben, werfen wir einen Blick auf den Preis.

Nach dem Upgrade hat OpenAI den Preis des Produkts nicht nur nicht erhöht, sondern auch gesenkt.

Das erste ist das am häufigsten verwendete gpt-3.5-turbo (4K-Token-Version).

Der Preis für Input-Token wurde um 25 % gesenkt und beträgt jetzt 0,0015 US-Dollar pro tausend Token, was 666.000 Token pro 1 US-Dollar entspricht.

Der Preis des Ausgabe-Tokens pro tausend Token beträgt 0,002 US-Dollar, was 500.000 Token pro 1 US-Dollar entspricht.

Umgerechnet in englischen Text sind es etwa 1 US-Dollar und 700 Seiten.

Der Preis des Einbettungsmodells ist stark gesunken und wurde direkt um 75 % gesenkt.

Alle tausend Token kosten nur 0,0001 USD, was 1 USD und 10 Millionen Token entspricht.

Darüber hinaus bietet die neu eingeführte 16K-Token-Version von GPT3.5-Turbo die vierfache Rechenleistung der 4K-Version, ist aber nur doppelt so teuer.

Die Preise für Eingabe- und Ausgabe-Token betragen 0,003 US-Dollar bzw. 0,004 US-Dollar pro tausend Token.

Außerdem berichteten einige Internetnutzer, dass die monatliche Rechnung von 100 auf einige Cent gesunken sei. Es ist unklar, wie die konkrete Situation ist.

Abschließend vergessen Sie nicht, sich bei Bedarf für die GPT-4-API-Testqualifikationen anzumelden.

OpenAI fängt „Chain“ ein, Microsoft steckt dahinter

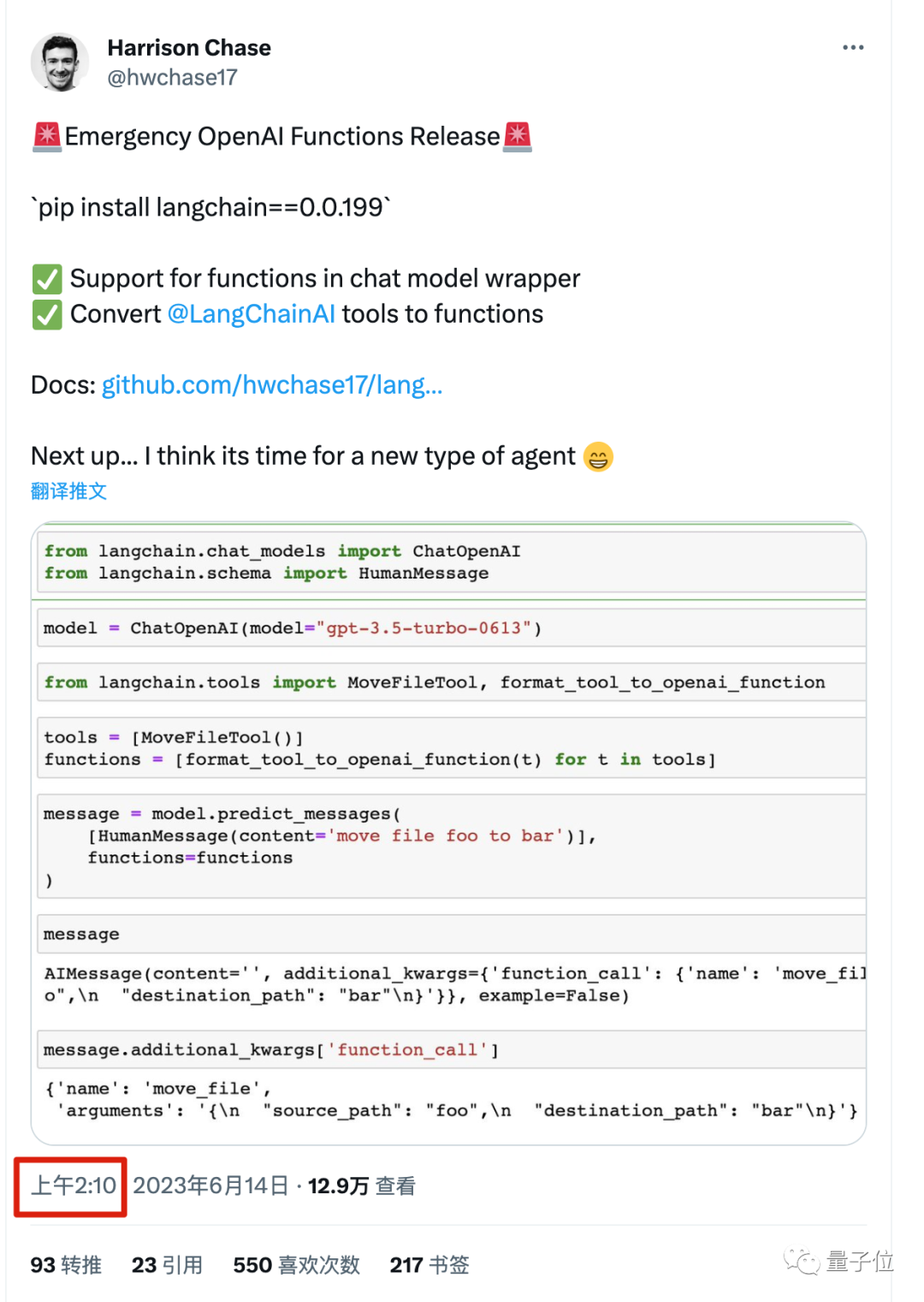

Viele Internetnutzer wiesen darauf hin, dass der neue „Funktionsaufruf“ von OpenAI im Grunde eine Nachbildung der „Tools“ in Langchain ist.

Vielleicht wird OpenAI in Zukunft auch weitere Funktionen von Langchain kopieren, wie zum Beispiel Ketten und Indizes.

Langchain ist das beliebteste Open-Source-Entwicklungsframework im Bereich großer Modelle, das verschiedene Funktionen großer Modelle integrieren kann, um schnell Anwendungen zu erstellen.

Das Team erhielt außerdem kürzlich eine Seed-Finanzierung in Höhe von 10 Millionen US-Dollar.

Obwohl dieses Update von OpenAI das unternehmerische Projekt von Langchain nicht direkt „töten“ wird.

Aber ursprünglich brauchten Entwickler LangChain, um einige Funktionen zu implementieren, aber jetzt brauchen sie es nicht mehr.

Wenn man sich Langchains Reaktion ansieht, ist der Überlebenswille tatsächlich sehr stark.

Innerhalb von 10 Minuten nach der offiziellen Veröffentlichung des Updates durch OpenAI gab Langchain sofort bekannt, dass es „bereits an der Kompatibilität arbeitet“.

Und in weniger als einer Stunde wurde eine neue Version veröffentlicht. Neben der Unterstützung neuer offizieller Funktionen kann es auch bereits von Entwicklern geschriebene Tools in OpenAI-Funktionen konvertieren.

Neben dem Anstehen, um sich über die lächerlich schnelle Entwicklungsgeschwindigkeit zu beklagen, dachten sie auch über eine unvermeidbare Frage nach:

Was sollten Sie tun, wenn OpenAI Ihr unternehmerisches Projekt zerstört?

In diesem Zusammenhang hat OpenAI-CEO Sam Altman kürzlich eine Erklärung abgegeben.

Beim Austauschtreffen von Humanloop Ende Mai sagte Altman einmal:

Außer bei Verbraucheranwendungen wie ChatGPT sollten Sie vermeiden, mit Kunden zu konkurrieren.

Jetzt scheint es, dass Entwicklungstools nicht in den Bereich der Wettbewerbsvermeidung einbezogen sind.

Neben Startups gibt es noch ein weiteres nicht zu übersehendes Unternehmen, das mit OpenAI konkurriert:

Microsoft, der größte Sponsor von OpenAI, stellt auch OpenAI-API-Dienste über die Azure-Cloud bereit.

Erst kürzlich berichteten einige Entwickler, dass nach dem Wechsel von der offiziellen OpenAI-API auf die Microsoft Azure-Version die Leistung deutlich verbessert wurde.

Konkret:

- Die mittlere Latenz wurde von 15 Sekunden auf 3 Sekunden reduziert.

- Die Latenz im 95. Perzentil wurde von 60 Sekunden auf 15 Sekunden reduziert.

- Die durchschnittliche Anzahl der pro Sekunde verarbeiteten Token hat sich verdreifacht, von 8 auf 24.

Inklusive einiger Rabatte von Azure ist es sogar günstiger als zuvor.

Aber die Update-Geschwindigkeit von Microsoft Azure ist im Allgemeinen mehrere Wochen langsamer als die von OpenAI.

Nutzen Sie OpenAI für eine schnelle Iteration während der Entwicklungsphase und wechseln Sie zu Microsoft Azure für eine groß angelegte Bereitstellung. Haben Sie etwas gelernt?

Update-Ankündigung https://openai.com/blog/function-calling-and-other-api-updates.

GPT-4 API-Warteschlange https://openai.com/waitlist/gpt-4-api.

Referenzlink:

[1]https://news.ycombinator.com/item?id=36313348.

[2]https://twitter.com/svpino/status/1668695130570903552.

[3]https://weibo.com/1727858283/N5cjr0jBq.

[4]https://twitter.com/LangChainAI/status/1668671302624747520.

[5]https://twitter.com/hwchase17/status/1668682373767020545.

[6]https://twitter.com/ItakGol/status/1668336193270865921.

Das obige ist der detaillierte Inhalt vonChatGPT großes Update! OpenAI bietet Programmierern ein Geschenkpaket: Die API fügt Killerfunktionen hinzu und die Preise werden gesenkt, neue Modelle und ein vierfacher Kontext kommen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1371

1371

52

52

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

Mit ChatGPT können kostenlose Benutzer jetzt Bilder mithilfe von DALL-E 3 mit einem Tageslimit generieren

Aug 09, 2024 pm 09:37 PM

DALL-E 3 wurde im September 2023 offiziell als deutlich verbessertes Modell gegenüber seinem Vorgänger eingeführt. Er gilt als einer der bisher besten KI-Bildgeneratoren und ist in der Lage, Bilder mit komplexen Details zu erstellen. Zum Start war es jedoch exklusiv

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

OpenAI kündigte kürzlich die Einführung seines Einbettungsmodells embeddingv3 der neuesten Generation an, das seiner Meinung nach das leistungsstärkste Einbettungsmodell mit höherer Mehrsprachenleistung ist. Diese Reihe von Modellen ist in zwei Typen unterteilt: das kleinere Text-Embeddings-3-Small und das leistungsfähigere und größere Text-Embeddings-3-Large. Es werden nur wenige Informationen darüber offengelegt, wie diese Modelle entworfen und trainiert werden, und auf die Modelle kann nur über kostenpflichtige APIs zugegriffen werden. Es gab also viele Open-Source-Einbettungsmodelle. Aber wie schneiden diese Open-Source-Modelle im Vergleich zum Closed-Source-Modell von OpenAI ab? In diesem Artikel wird die Leistung dieser neuen Modelle empirisch mit Open-Source-Modellen verglichen. Wir planen, Daten zu erstellen

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Im Jahr 2023 ist die KI-Technologie zu einem heißen Thema geworden und hat enorme Auswirkungen auf verschiedene Branchen, insbesondere im Programmierbereich. Die Bedeutung der KI-Technologie wird den Menschen zunehmend bewusst, und die Spring-Community bildet da keine Ausnahme. Mit der kontinuierlichen Weiterentwicklung der GenAI-Technologie (General Artificial Intelligence) ist es entscheidend und dringend geworden, die Erstellung von Anwendungen mit KI-Funktionen zu vereinfachen. Vor diesem Hintergrund entstand „SpringAI“ mit dem Ziel, den Prozess der Entwicklung von KI-Funktionsanwendungen zu vereinfachen, ihn einfach und intuitiv zu gestalten und unnötige Komplexität zu vermeiden. Durch „SpringAI“ können Entwickler einfacher Anwendungen mit KI-Funktionen erstellen, wodurch diese einfacher zu verwenden und zu bedienen sind.

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

So installieren Sie ChatGPT auf einem Mobiltelefon

Mar 05, 2024 pm 02:31 PM

Installationsschritte: 1. Laden Sie die ChatGTP-Software von der offiziellen ChatGTP-Website oder dem mobilen Store herunter. 2. Wählen Sie nach dem Öffnen in der Einstellungsoberfläche die Sprache aus. 3. Wählen Sie in der Spieloberfläche das Mensch-Maschine-Spiel aus 4. Geben Sie nach dem Start Befehle in das Chatfenster ein, um mit der Software zu interagieren.

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Wenn die Antwort des KI-Modells überhaupt unverständlich ist, würden Sie es wagen, sie zu verwenden? Da maschinelle Lernsysteme in immer wichtigeren Bereichen eingesetzt werden, wird es immer wichtiger zu zeigen, warum wir ihren Ergebnissen vertrauen können und wann wir ihnen nicht vertrauen sollten. Eine Möglichkeit, Vertrauen in die Ausgabe eines komplexen Systems zu gewinnen, besteht darin, vom System zu verlangen, dass es eine Interpretation seiner Ausgabe erstellt, die für einen Menschen oder ein anderes vertrauenswürdiges System lesbar ist, d. h. so vollständig verständlich, dass mögliche Fehler erkannt werden können gefunden. Um beispielsweise Vertrauen in das Justizsystem aufzubauen, verlangen wir von den Gerichten, dass sie klare und lesbare schriftliche Stellungnahmen abgeben, die ihre Entscheidungen erläutern und stützen. Für große Sprachmodelle können wir auch einen ähnlichen Ansatz verfolgen. Stellen Sie bei diesem Ansatz jedoch sicher, dass das Sprachmodell generiert wird

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Autor丨Zusammengestellt von TimAnderson丨Produziert von Noah|51CTO Technology Stack (WeChat-ID: blog51cto) Das Zed-Editor-Projekt befindet sich noch in der Vorabversionsphase und wurde unter AGPL-, GPL- und Apache-Lizenzen als Open Source bereitgestellt. Der Editor zeichnet sich durch hohe Leistung und mehrere KI-gestützte Optionen aus, ist jedoch derzeit nur auf der Mac-Plattform verfügbar. Nathan Sobo erklärte in einem Beitrag, dass in der Codebasis des Zed-Projekts auf GitHub der Editor-Teil unter der GPL lizenziert ist, die serverseitigen Komponenten unter der AGPL lizenziert sind und der GPUI-Teil (GPU Accelerated User) die Schnittstelle übernimmt Apache2.0-Lizenz. GPUI ist ein vom Zed-Team entwickeltes Produkt

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Vor nicht allzu langer Zeit wurde OpenAISora mit seinen erstaunlichen Videogenerierungseffekten schnell populär und stach aus der Masse der literarischen Videomodelle hervor und rückte in den Mittelpunkt der weltweiten Aufmerksamkeit. Nach der Einführung des Sora-Trainings-Inferenzreproduktionsprozesses mit einer Kostenreduzierung von 46 % vor zwei Wochen hat das Colossal-AI-Team das weltweit erste Sora-ähnliche Architektur-Videogenerierungsmodell „Open-Sora1.0“ vollständig als Open-Source-Lösung bereitgestellt, das das gesamte Spektrum abdeckt Lernen Sie den Trainingsprozess, einschließlich der Datenverarbeitung, aller Trainingsdetails und Modellgewichte, kennen und schließen Sie sich mit globalen KI-Enthusiasten zusammen, um eine neue Ära der Videoerstellung voranzutreiben. Schauen wir uns für einen kleinen Vorgeschmack ein Video einer geschäftigen Stadt an, das mit dem vom Colossal-AI-Team veröffentlichten Modell „Open-Sora1.0“ erstellt wurde. Open-Sora1.0

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Ollama ist ein superpraktisches Tool, mit dem Sie Open-Source-Modelle wie Llama2, Mistral und Gemma problemlos lokal ausführen können. In diesem Artikel werde ich vorstellen, wie man Ollama zum Vektorisieren von Text verwendet. Wenn Sie Ollama nicht lokal installiert haben, können Sie diesen Artikel lesen. In diesem Artikel verwenden wir das Modell nomic-embed-text[2]. Es handelt sich um einen Text-Encoder, der OpenAI text-embedding-ada-002 und text-embedding-3-small bei kurzen und langen Kontextaufgaben übertrifft. Starten Sie den nomic-embed-text-Dienst, wenn Sie o erfolgreich installiert haben