Vor ein paar Tagen enthüllte OpenAI-CEO Sam Altman während einer globalen Redetour den jüngsten Entwicklungspfad von OpenAI, der hauptsächlich in zwei Phasen unterteilt ist. Die oberste Priorität im Jahr 2023 ist die Einführung von günstigerem und schnellerem GPT-4 sowie längeren Kontextfenstern mehr; 2024 Fokus auf Multimodalität.

Die Ziele von OpenAI für 2023 werden nach und nach erreicht. In nur wenigen Monaten seit der Einführung von ChatGPT hat OpenAI unglaubliche Anwendungen basierend auf Modellen wie GPT-3.5 Turbo, GPT-4 und mehr entwickelt. Am 13. Juni Ortszeit veröffentlichte OpenAI Funktionsaufrufe und andere API-Updates, darunter:

Funktionsaufrufe

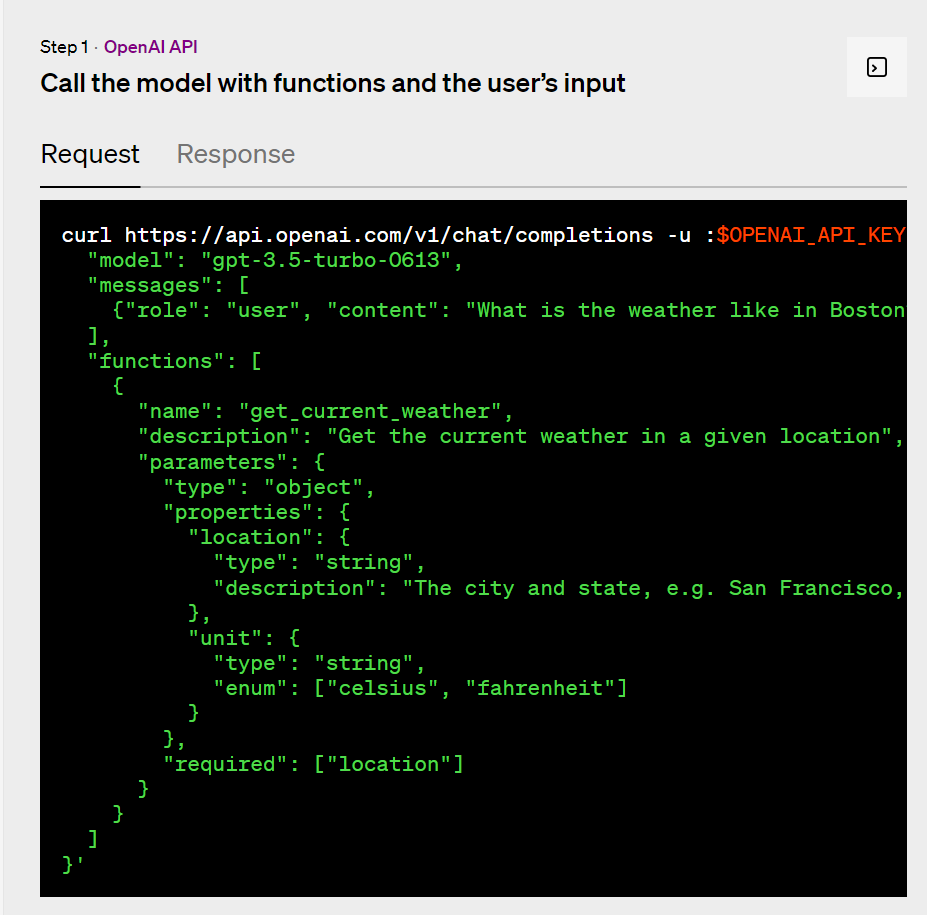

Jetzt können Entwickler sich für gpt-4-0613 bewerben und gpt-3.5-turbo-0613 Beschreiben Sie Funktionen und lassen Sie das Modell intelligent entscheiden, ein JSON-Objekt auszugeben, das die zum Aufrufen dieser Funktionen erforderlichen Parameter enthält. Dies ist eine neue Möglichkeit, die Funktionen von GPT zuverlässiger mit externen Tools und APIs zu verbinden.Das Modell ist so abgestimmt, dass es sowohl erkennt, wann eine Funktion aufgerufen werden muss (abhängig von der Benutzereingabe), als auch mit JSON antwortet, das der Funktionssignatur entspricht. Funktionsaufrufe ermöglichen es Entwicklern, strukturierte Daten aus Modellen zuverlässiger zu erhalten. Ein Entwickler könnte zum Beispiel:

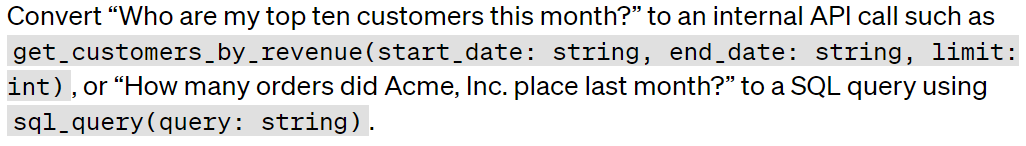

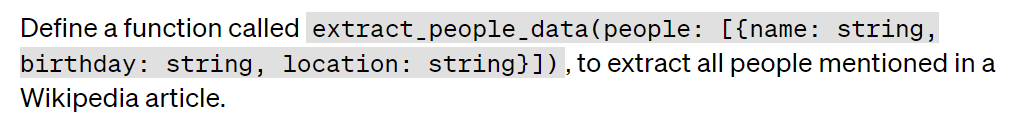

Einen Chatbot erstellen, der ein externes Tool aufruft, um Fragen zu beantworten:

Natürliche Sprache in API-Aufrufe oder Datenbankabfragen umwandeln:

Datenstruktur aus Text extrahieren:

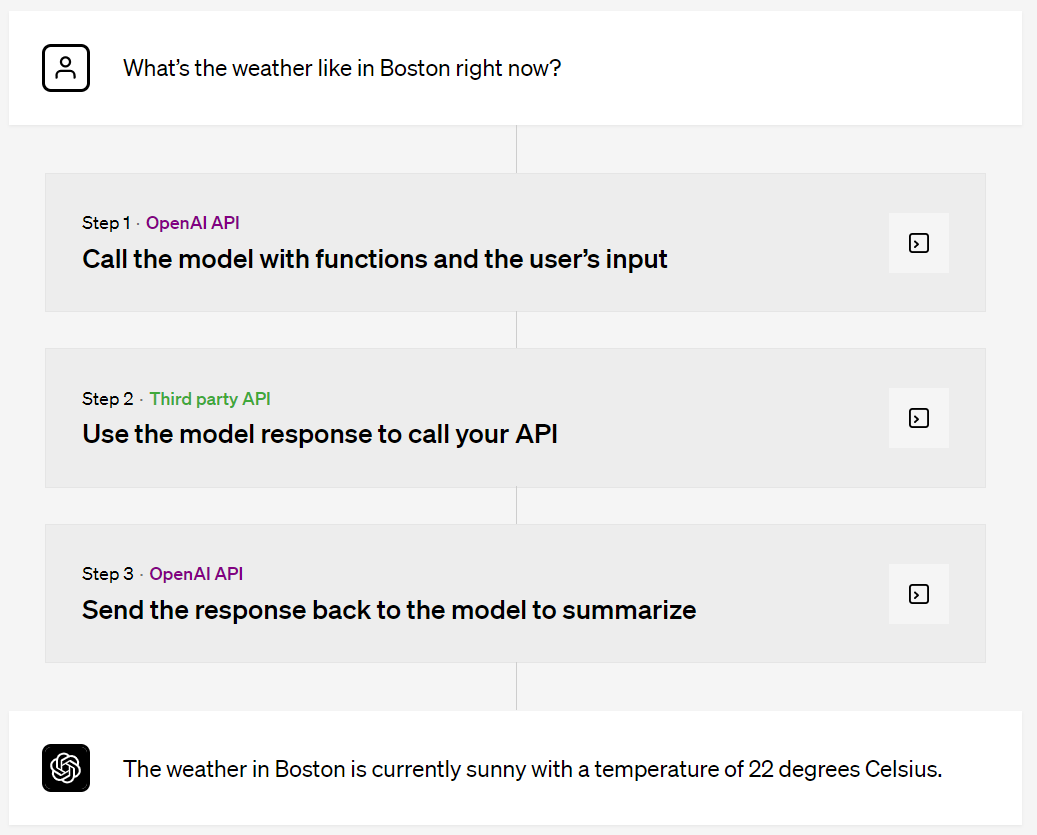

Beispiel für einen Funktionsaufruf

Zum Beispiel fragt ein Benutzer: „Wie ist das Wetter in Boston jetzt?“ Nach einer Reihe von Verarbeitungen gibt das endgültige Modell die Antwort aus: „Das Wetter in Boston ist derzeit sonnig und die Temperatur beträgt 22 Grad Celsius.“

Modellabwertung Darüber hinaus können Entwickler, die eine Übergangszeit benötigen, weiterhin ältere Versionen der Modelle gpt-3.5-turbo-0301, gpt-4-0314 oder gpt-4-32k-0314 verwenden, jedoch nach dem 13. September, Anfragen mit Diese Modelle werden scheitern. Weitere Neuigkeiten zur Modellveraltung finden Sie unter: Abfrage zur Modellveraltung: https://platform.openai.com/docs/deprecations/ Darüber hinaus ist der Preis für dieses Update niedriger, Texteinbettung -ada-002 ist das beliebteste Einbettungsmodell für Einbettungssysteme. Heute sind die Kosten um 75 % auf nur 0,0001 US-Dollar pro 1.000 Token gesunken. Schließlich gibt es GPT-3.5 Turbo, dem alle mehr Aufmerksamkeit schenken und das Millionen von Benutzern die ChatGPT-Funktion bereitstellt. Heute sind die Eingabe-Token-Kosten von gpt-3.5-turbo um 25 % reduziert. Entwickler, die dieses Modell verwenden, zahlen jetzt nur noch 0,0015 US-Dollar pro 1K-Eingabetoken und 0,002 US-Dollar pro 1K-Ausgabetoken, was etwa 700 Seiten pro Dollar entspricht.

Neues Modell

Neues Modell gpt -4-0613 enthält eine aktualisierte und verbesserte Funktion „Modell aufrufen“.

Dann kommt GPT - 3.5 Turbo: gpt-3.5-turbo-0613 enthält die gleichen Funktionsaufrufe wie GPT-4, sowie eine zuverlässigere Bedienbarkeit durch Systemmeldungen, Entwickler können davon profitieren Zwei Funktionen steuern die Reaktion des Modells effektiver.

Das obige ist der detaillierte Inhalt vonOpenAI aktualisiert GPT-4 und andere Modelle, fügt neue API-Funktionsaufrufe hinzu und senkt die Preise um bis zu 75 %. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

So verwenden Sie die Auswahlfunktion

So verwenden Sie die Auswahlfunktion

Der Unterschied zwischen PHP und JS

Der Unterschied zwischen PHP und JS

Tutorial zur Symboleingabe in voller Breite

Tutorial zur Symboleingabe in voller Breite

BTC-Preis heute

BTC-Preis heute

Wie viele Menschen können Sie mit Douyin großziehen?

Wie viele Menschen können Sie mit Douyin großziehen?

Die Rolle von Isset in PHP

Die Rolle von Isset in PHP

Die Funktion des Zwischenrelais

Die Funktion des Zwischenrelais

Was tun bei Verbindungsfehlern?

Was tun bei Verbindungsfehlern?

Welches Format ist m4a?

Welches Format ist m4a?