Backend-Entwicklung

Backend-Entwicklung

PHP-Tutorial

PHP-Tutorial

Crawler-Entwicklung und -Implementierung: Praktische Strategie für PHP und Selenium

Crawler-Entwicklung und -Implementierung: Praktische Strategie für PHP und Selenium

Crawler-Entwicklung und -Implementierung: Praktische Strategie für PHP und Selenium

随着互联网的不断发展,越来越多的数据需要从网页中获取,不同于人工手动浏览网页读取信息,爬虫技术可以自动化地获取数据。在爬虫技术中,Selenium作为一个自动化测试工具,可以模拟用户在网页上进行操作,获取网页上的数据。本文将介绍如何使用PHP和Selenium实现爬虫功能。

什么是Selenium?

Selenium是一个自动化测试工具,它可以模拟用户在网页中的所有操作,例如输入、点击、滚动等,同时可以获取网页上的数据。Selenium可以支持多种浏览器,例如Chrome、Firefox、Edge等,并可以使用不同的语言进行编写测试脚本。在爬虫技术中,Selenium可以模拟用户操作网页并抓取网页中的数据。

爬虫开发之前的准备

在使用Selenium进行爬虫开发之前,需要安装一个支持Selenium的浏览器驱动程序,例如Chrome的浏览器驱动程序。可以从Selenium官网下载最新版本的Chrome驱动程序并安装。

接着,需要在本地安装PHP和相关扩展,例如php-webdriver。可以使用Composer进行安装,如下所示:

composer require php-webdriver/webdriver

简单示例:获取网页标题

使用Selenium进行爬虫开发的第一步,是打开需要抓取数据的网页。假设我们需要获取某个网页的标题,可按照以下步骤进行:

<?php

require_once 'vendor/autoload.php';

use FacebookWebDriverRemoteDesiredCapabilities;

use FacebookWebDriverRemoteRemoteWebDriver;

// 启动Chrome浏览器

$capabilities = DesiredCapabilities::chrome();

$driver = RemoteWebDriver::create('http://localhost:9515', $capabilities);

// 打开需要抓取数据的网页

$driver->get('https://www.example.com');

// 获取网页标题

$title = $driver->getTitle();

echo $title;

// 关闭浏览器

$driver->quit();代码解析:

- 首先,使用

require_once引入需要的类库文件。 - 使用

DesiredCapabilities创建浏览器驱动程序,指定使用Chrome浏览器。 - 使用

RemoteWebDriver::create启动一个Chrome浏览器并连接到Selenium服务器。 - 使用

get方法打开需要抓取数据的网页。 - 使用

getTitle方法获取网页标题。 - 输出网页标题。

- 最后使用

quit方法关闭Chrome浏览器。

简单示例:登录网页并抓取数据

在实际爬虫开发中,我们可能需要在网页中进行登录,才能获取到需要的数据。以下为登录某网站并抓取数据的示例代码:

<?php

require_once 'vendor/autoload.php';

use FacebookWebDriverRemoteDesiredCapabilities;

use FacebookWebDriverRemoteRemoteWebDriver;

use FacebookWebDriverWebDriverBy;

// 启动Chrome浏览器

$capabilities = DesiredCapabilities::chrome();

$driver = RemoteWebDriver::create('http://localhost:9515', $capabilities);

// 打开登录页面

$driver->get('https://www.example.com/login');

// 输入账号密码并登录

$accountInput = $driver->findElement(WebDriverBy::id('account'));

$passwordInput = $driver->findElement(WebDriverBy::id('password'));

$submitButton = $driver->findElement(WebDriverBy::id('submit'));

$accountInput->sendKeys('your_username');

$passwordInput->sendKeys('your_password');

$submitButton->click();

// 等待登录成功并打开需要抓取数据的页面

$driver->wait(10)->until(

WebDriverExpectedCondition::titleContains('Homepage')

);

$driver->get('https://www.example.com/data');

// 获取数据

$data = $driver->findElement(WebDriverBy::cssSelector('.data'))->getText();

echo $data;

// 关闭浏览器

$driver->quit();代码解析:

- 首先,使用

require_once引入需要的类库文件。 - 使用

DesiredCapabilities创建浏览器驱动程序,指定使用Chrome浏览器。 - 使用

RemoteWebDriver::create启动一个Chrome浏览器并连接到Selenium服务器。 - 使用

get方法打开需要登录的页面。 - 使用

findElement方法通过账号和密码的input元素的id获取对应的WebElement对象,并分别调用sendKeys方法传入账号密码进行输入。 - 使用

findElement方法通过提交按钮的id获取对应的WebElement对象,并调用click方法进行点击,完成登录操作。 - 使用

wait方法等待页面跳转后的标题包含Homepage。 - 使用

get方法打开需要抓取数据的页面。 - 使用

findElement方法通过CSS选择器获取对应的WebElement对象,并使用getText方法获取文本内容。 - 输出获取的数据。

- 最后使用

quit方法关闭Chrome浏览器。

以上是示例代码,实际开发中需要根据具体网站的页面结构和元素id进行修改。

总结

本文介绍了如何使用PHP和Selenium进行爬虫开发,分别从获取网页标题和登录抓取数据两个方面进行了示例演示。Selenium作为一个自动化测试工具,可以模拟用户在网页中的操作,方便抓取网页中的数据,同时也可以应用于其他自动化测试场景中。通过掌握Selenium的使用,可以提高自身的技术水平和工作效率。

Das obige ist der detaillierte Inhalt vonCrawler-Entwicklung und -Implementierung: Praktische Strategie für PHP und Selenium. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

PHP 8.4 Installations- und Upgrade-Anleitung für Ubuntu und Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 Installations- und Upgrade-Anleitung für Ubuntu und Debian

Dec 24, 2024 pm 04:42 PM

PHP 8.4 bringt mehrere neue Funktionen, Sicherheitsverbesserungen und Leistungsverbesserungen mit einer beträchtlichen Menge an veralteten und entfernten Funktionen. In dieser Anleitung wird erklärt, wie Sie PHP 8.4 installieren oder auf PHP 8.4 auf Ubuntu, Debian oder deren Derivaten aktualisieren. Obwohl es möglich ist, PHP aus dem Quellcode zu kompilieren, ist die Installation aus einem APT-Repository wie unten erläutert oft schneller und sicherer, da diese Repositorys in Zukunft die neuesten Fehlerbehebungen und Sicherheitsupdates bereitstellen.

CakePHP Datum und Uhrzeit

Sep 10, 2024 pm 05:27 PM

CakePHP Datum und Uhrzeit

Sep 10, 2024 pm 05:27 PM

Um in cakephp4 mit Datum und Uhrzeit zu arbeiten, verwenden wir die verfügbare FrozenTime-Klasse.

Besprechen Sie CakePHP

Sep 10, 2024 pm 05:28 PM

Besprechen Sie CakePHP

Sep 10, 2024 pm 05:28 PM

CakePHP ist ein Open-Source-Framework für PHP. Es soll die Entwicklung, Bereitstellung und Wartung von Anwendungen erheblich vereinfachen. CakePHP basiert auf einer MVC-ähnlichen Architektur, die sowohl leistungsstark als auch leicht zu verstehen ist. Modelle, Ansichten und Controller gu

CakePHP-Datei hochladen

Sep 10, 2024 pm 05:27 PM

CakePHP-Datei hochladen

Sep 10, 2024 pm 05:27 PM

Um am Datei-Upload zu arbeiten, verwenden wir den Formular-Helfer. Hier ist ein Beispiel für den Datei-Upload.

CakePHP erstellt Validatoren

Sep 10, 2024 pm 05:26 PM

CakePHP erstellt Validatoren

Sep 10, 2024 pm 05:26 PM

Der Validator kann durch Hinzufügen der folgenden zwei Zeilen im Controller erstellt werden.

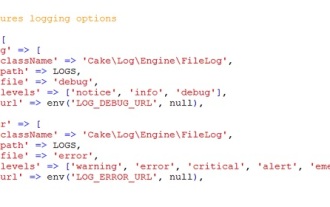

CakePHP-Protokollierung

Sep 10, 2024 pm 05:26 PM

CakePHP-Protokollierung

Sep 10, 2024 pm 05:26 PM

Die Anmeldung bei CakePHP ist eine sehr einfache Aufgabe. Sie müssen nur eine Funktion verwenden. Sie können Fehler, Ausnahmen, Benutzeraktivitäten und von Benutzern durchgeführte Aktionen für jeden Hintergrundprozess wie Cronjob protokollieren. Das Protokollieren von Daten in CakePHP ist einfach. Die Funktion log() wird bereitgestellt

So richten Sie Visual Studio-Code (VS-Code) für die PHP-Entwicklung ein

Dec 20, 2024 am 11:31 AM

So richten Sie Visual Studio-Code (VS-Code) für die PHP-Entwicklung ein

Dec 20, 2024 am 11:31 AM

Visual Studio Code, auch bekannt als VS Code, ist ein kostenloser Quellcode-Editor – oder eine integrierte Entwicklungsumgebung (IDE) –, die für alle gängigen Betriebssysteme verfügbar ist. Mit einer großen Sammlung von Erweiterungen für viele Programmiersprachen kann VS Code c

CakePHP-Kurzanleitung

Sep 10, 2024 pm 05:27 PM

CakePHP-Kurzanleitung

Sep 10, 2024 pm 05:27 PM

CakePHP ist ein Open-Source-MVC-Framework. Es erleichtert die Entwicklung, Bereitstellung und Wartung von Anwendungen erheblich. CakePHP verfügt über eine Reihe von Bibliotheken, um die Überlastung der häufigsten Aufgaben zu reduzieren.