Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Meta veröffentlicht ein Audio-KI-Modell, das die Sprache einer echten Person in nur 2 Sekunden simuliert

Meta veröffentlicht ein Audio-KI-Modell, das die Sprache einer echten Person in nur 2 Sekunden simuliert

Meta veröffentlicht ein Audio-KI-Modell, das die Sprache einer echten Person in nur 2 Sekunden simuliert

Meta hat kürzlich das Voicebox AI-Modell veröffentlicht, das erhebliche Vorteile bei der Audiosimulation bietet.

Es wird berichtet, dass Voicebox nur ein 2-sekündiges Audiobeispiel benötigt, um die Audiodetails und die Klangfarbe genau zu identifizieren und es basierend auf den Textergebnissen in eine Sprachausgabe umzuwandeln.

Voicebox ist ein generatives KI-Modell, das bei der Audiobearbeitung, dem Sampling und dem Styling hilft.

Mit dieser Technologie können YouTuber in Zukunft Audiospuren einfacher bearbeiten. Gleichzeitig kann sie auch Menschen mit geschädigten Stimmbändern helfen und ihnen helfen, wieder zu „klingen“. Ermöglicht sehbehinderten Menschen, die schriftlichen Nachrichten ihrer Freunde über Ton zu hören, während Menschen gleichzeitig jede Fremdsprache mit ihrer eigenen Stimme sprechen können.

Gleichzeitig kann es auch automatisch den fehlenden Inhalt basierend auf dem vorhergehenden und nachfolgenden Inhalt des Sprachclips ergänzen.

Laut Meta kann Voicebox im zukünftigen Metaversum natürliche und realistische Spracheffekte für KI-Assistenten oder NPCs bereitstellen und so das Eintauchen der Benutzer bei der Verwendung erheblich verbessern.

Die Vielseitigkeit von Voicebox unterstützt eine Vielzahl von Aufgaben, darunter:

Kontextuelle Text-zu-Sprache-Synthese: Mit Audio-Samples von nur zwei Sekunden kann Voicebox den Audiostil anpassen und für die Text-zu-Sprache-Erzeugung verwenden.

Sprachbearbeitung und Rauschunterdrückung: Voicebox kann durch Rauschen unterbrochene Wortteile wiederherstellen oder falsch gesprochene Wörter ersetzen, ohne die gesamte Sprache neu aufzeichnen zu müssen. Sie können beispielsweise einen durch einen bellenden Hund unterbrochenen Sprachabschnitt identifizieren, ihn zuschneiden und dann Voicebox anweisen, den Abschnitt neu zu generieren – wie ein Radiergummi für die Audiobearbeitung.

Sprachübergreifende Konvertierung: Wenn Voicebox eine Sprachprobe und einen Text in Englisch, Französisch, Deutsch, Spanisch, Polnisch oder Portugiesisch erhält, kann sie eine Textlesung in jeder dieser Sprachen generieren, auch wenn die Sprachprobe und der Text unterschiedlich sind Sprache. In Zukunft können Menschen diese Funktion nutzen, um natürlicher und authentischer zu kommunizieren, auch wenn sie die Sprachen nicht verstehen.

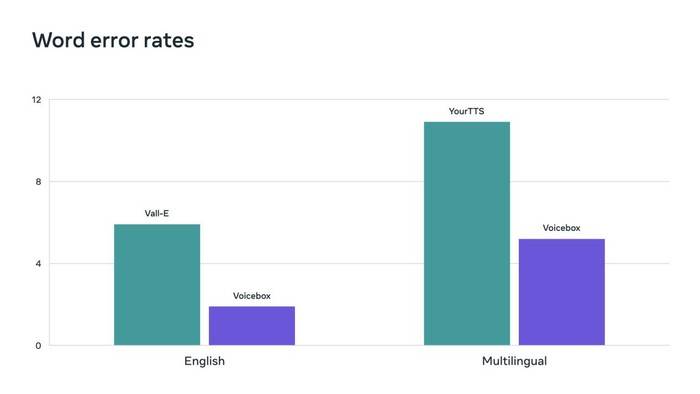

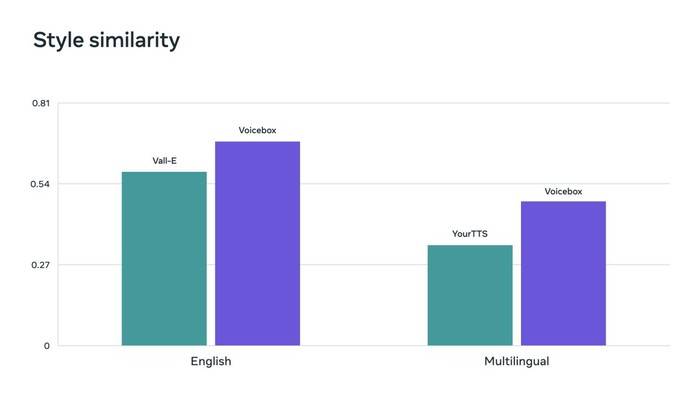

Flow Matching ist eine von Voicebox verwendete Methode, die nachweislich die Leistung von Diffusionsmodellen verbessert. Voicebox übertrifft VALL-E, das aktuelle hochmoderne englische Modell, in Bezug auf Verständlichkeit (5,9 % gegenüber 1,9 % Wortfehlerrate) und Audioähnlichkeit (0,580 gegenüber 0,681) und ist gleichzeitig 20-mal schneller. Bei der sprachübergreifenden Stilübertragung übertrifft Voicebox YourTTS, indem es die durchschnittliche Wortfehlerrate von 10,9 % auf 5,2 % senkt und die Audioähnlichkeit von 0,335 auf 0,481 verbessert.

Voicebox erzielt neue, hochmoderne Ergebnisse und übertrifft Vall-E und YourTTS bei der Wortfehlerrate.

Voicebox erzielt auch hochmoderne Ergebnisse bei Kennzahlen zur Ähnlichkeit von Audiostilen in englischen bzw. mehrsprachigen Benchmarks.

Es ist erwähnenswert, dass sich Meta derzeit des potenziellen Schadens bewusst ist, der bei der Verwendung von Voicebox im Bereich der Fälschung entsteht, und daher nach einer Möglichkeit sucht, zwischen echter Sprache und von Voicebox generierter Sprache zu unterscheiden.

Bis eine Lösung gefunden ist, wird Meta das Voicebox-KI-Modell nicht der Öffentlichkeit zugänglich machen, um unnötigen Schaden zu vermeiden.

Anmerkung des Herausgebers: KI wurde mittlerweile in verschiedenen Bereichen eingesetzt und ist das erste multifunktionale und effiziente Modell, das die Aufgabenverallgemeinerung erfolgreich durchführt. Ich glaube, dass Voicebox eine neue Ära der Sprachgenerierungs-KI einläuten kann. Wenn Meta Audio-Betrug nicht effektiv bekämpfen kann, wird die Voicebox-Technologie möglicherweise deaktiviert.

Das obige ist der detaillierte Inhalt vonMeta veröffentlicht ein Audio-KI-Modell, das die Sprache einer echten Person in nur 2 Sekunden simuliert. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1382

1382

52

52

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Das neue erschwingliche Meta Quest 3S VR-Headset erscheint bei FCC, was auf eine baldige Markteinführung hindeutet

Sep 04, 2024 am 06:51 AM

Die Meta Connect 2024-Veranstaltung findet vom 25. bis 26. September statt. Bei dieser Veranstaltung wird das Unternehmen voraussichtlich ein neues erschwingliches Virtual-Reality-Headset vorstellen. Gerüchten zufolge handelt es sich bei dem VR-Headset um das Meta Quest 3S, das offenbar auf der FCC-Liste aufgetaucht ist. Dieser Vorschlag

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Das erste Open-Source-Modell, das das GPT4o-Niveau übertrifft! Llama 3.1 durchgesickert: 405 Milliarden Parameter, Download-Links und Modellkarten sind verfügbar

Jul 23, 2024 pm 08:51 PM

Machen Sie Ihre GPU bereit! Llama3.1 ist endlich erschienen, aber die Quelle ist nicht offiziell von Meta. Heute gingen die durchgesickerten Nachrichten über das neue Llama-Großmodell auf Reddit viral. Zusätzlich zum Basismodell enthält es auch Benchmark-Ergebnisse von 8B, 70B und den maximalen Parameter von 405B. Die folgende Abbildung zeigt die Vergleichsergebnisse jeder Version von Llama3.1 mit OpenAIGPT-4o und Llama38B/70B. Es ist ersichtlich, dass selbst die 70B-Version in mehreren Benchmarks GPT-4o übertrifft. Bildquelle: https://x.com/mattshumer_/status/1815444612414087294 Offensichtlich Version 3.1 von 8B und 70

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Apr 19, 2024 pm 12:16 PM

Sechs schnelle Möglichkeiten, das neu veröffentlichte Llama 3 zu erleben!

Apr 19, 2024 pm 12:16 PM

Gestern Abend hat Meta die Modelle Llama38B und 70B veröffentlicht. Das anweisungsoptimierte Modell Llama3 ist für Dialog-/Chat-Anwendungsfälle optimiert und übertrifft viele bestehende Open-Source-Chat-Modelle in gängigen Benchmarks. Zum Beispiel Gemma7B und Mistral7B. Das Llama+3-Modell verbessert Daten und Skalierung und erreicht neue Höhen. Es wurde mit mehr als 15T Datentokens auf zwei benutzerdefinierten 24K-GPU-Clustern trainiert, die kürzlich von Meta veröffentlicht wurden. Dieser Trainingsdatensatz ist siebenmal größer als Llama2 und enthält viermal mehr Code. Dies bringt die Leistungsfähigkeit des Llama-Modells auf das derzeit höchste Niveau, das Textlängen von mehr als 8 KB unterstützt, doppelt so viel wie Llama2. unter

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Apr 19, 2024 pm 12:43 PM

Lama3 kommt plötzlich! In der Open-Source-Community brodelt es wieder: Die Ära des freien Zugangs zu Modellen auf GPT4-Ebene ist angebrochen

Apr 19, 2024 pm 12:43 PM

Lama3 ist da! Gerade wurde die offizielle Website von Meta aktualisiert und die offiziellen Versionen der Parameter Llama 38 Milliarden und 70 Milliarden angekündigt. Und es ist nach seiner Einführung ein Open-Source-SOTA: Offizielle Daten von Meta zeigen, dass die Llama38B- und 70B-Versionen alle Konkurrenten in ihren jeweiligen Parameterskalen übertreffen. Das 8B-Modell übertrifft Gemma7B und Mistral7BInstruct bei vielen Benchmarks wie MMLU, GPQA und HumanEval. Das 70B-Modell hat das beliebte Closed-Source-Brathähnchen Claude3Sonnet übertroffen und ist mit Googles GeminiPro1.5 hin und her gegangen. Sobald der Huggingface-Link veröffentlicht wurde, war die Open-Source-Community wieder aufgeregt. Auch die scharfsichtigen, blinden Schüler entdeckten es sofort

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

Das stärkste Modell Llama 3.1 405B wird offiziell veröffentlicht, Zuckerberg: Open Source leitet eine neue Ära ein

Jul 24, 2024 pm 08:23 PM

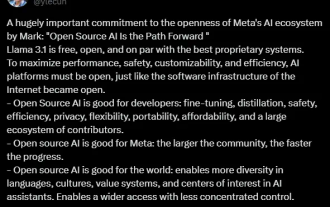

Gerade jetzt wurde das lang erwartete Llama 3.1 offiziell veröffentlicht! Meta gab offiziell bekannt, dass „Open Source eine neue Ära einläutet“. Im offiziellen Blog sagte Meta: „Bis heute sind große Open-Source-Sprachmodelle hinsichtlich Funktionalität und Leistung meist hinter geschlossenen Modellen zurückgeblieben. Jetzt läuten wir eine neue Ära ein, die von Open Source angeführt wird. Wir haben MetaLlama3.1405B öffentlich veröffentlicht.“ , von dem wir glauben, dass es sich um das größte und leistungsfähigste Open-Source-Basismodell der Welt handelt, die Gesamtzahl der Downloads aller Llama-Versionen hat gerade 300 Millionen Mal überschritten, und wir haben gerade erst damit begonnen, eine zu schreiben Artikel. Langer Artikel „OpenSourceAIIsthePathForward“,

Was bedeutet META?

Mar 05, 2024 pm 12:18 PM

Was bedeutet META?

Mar 05, 2024 pm 12:18 PM

META bezieht sich normalerweise auf eine virtuelle Welt oder Plattform namens Metaverse. Das Metaversum ist eine von Menschen mithilfe digitaler Technologie geschaffene virtuelle Welt, die die reale Welt widerspiegelt oder über sie hinausgeht und mit der realen Welt interagieren kann. Es handelt sich um einen digitalen Lebensraum mit einem neuen sozialen System.

Es wird erwartet, dass Meta im Jahr 2024 einen revolutionären AR-Brillen-Prototyp namens „Orion' auf den Markt bringen will.

Jan 04, 2024 pm 09:35 PM

Es wird erwartet, dass Meta im Jahr 2024 einen revolutionären AR-Brillen-Prototyp namens „Orion' auf den Markt bringen will.

Jan 04, 2024 pm 09:35 PM

Laut Nachrichten vom 24. Dezember setzt Meta, ein Technologieunternehmen mit großem Einfluss in der Social-Media-Branche, nun große Erwartungen an Augmented-Reality-Brillen (AR), eine Technologie, die als Computerplattform der nächsten Generation gilt. Kürzlich gab der technische Direktor von Meta, Andrew Bosworth, in einem Interview bekannt, dass das Unternehmen voraussichtlich im Jahr 2024 einen fortschrittlichen AR-Brillen-Prototyp mit dem Codenamen „Orion“ auf den Markt bringen wird. Meta investiert seit langem ebenso viel in die AR-Technologie wie in andere Bereiche. Sie haben riesige Summen investiert, die sich auf Milliarden von Dollar belaufen, mit dem Ziel, ein revolutionäres Produkt zu entwickeln, das mit dem iPhone vergleichbar ist. Obwohl sie letztes Jahr das Ende der Massenproduktionspläne für Orion-Brillen angekündigt hatten,

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Analyst bespricht Einführungspreise für das gemunkelte Meta Quest 3S VR-Headset

Aug 27, 2024 pm 09:35 PM

Seit Metas Erstveröffentlichung von Quest 3 (aktuell 499,99 $ bei Amazon) ist mittlerweile über ein Jahr vergangen. Seitdem hat Apple das deutlich teurere Vision Pro ausgeliefert, während Byte Dance nun in China die Pico 4 Ultra vorgestellt hat. Es gibt jedoch eine