Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Praktische Anwendung von Scrapy beim Crawlen und Analysieren von Twitter-Daten

Praktische Anwendung von Scrapy beim Crawlen und Analysieren von Twitter-Daten

Praktische Anwendung von Scrapy beim Crawlen und Analysieren von Twitter-Daten

Scrapy ist ein Python-basiertes Webcrawler-Framework, das schnell Daten aus dem Internet crawlen kann und einfache und benutzerfreundliche APIs und Tools für die Datenverarbeitung und -analyse bereitstellt. In diesem Artikel besprechen wir praktische Anwendungsfälle von Scrapy beim Crawlen und Analysieren von Twitter-Daten.

Twitter ist eine Social-Media-Plattform mit riesigen Nutzer- und Datenressourcen. Forscher, Social-Media-Analysten und Datenwissenschaftler können durch Data Mining und Analyse auf große Datenmengen zugreifen und interessante Erkenntnisse und Informationen gewinnen. Es gibt jedoch einige Einschränkungen beim Abrufen von Daten über die Twitter-API, und Scrapy kann diese Einschränkungen umgehen, indem es den menschlichen Zugriff simuliert, um größere Mengen an Twitter-Daten zu erhalten.

Zuerst müssen wir ein Twitter-Entwicklerkonto erstellen und einen API-Schlüssel und ein Zugriffstoken beantragen. Als nächstes müssen wir die Twitter-API-Zugriffsparameter in der Datei „settings.py“ von Scrapy festlegen, die es Scrapy ermöglichen, den manuellen Zugriff auf die Twitter-API zu simulieren, um Daten abzurufen. Zum Beispiel:

TWITTER_CONSUMER_KEY = 'your_consumer_key' TWITTER_CONSUMER_SECRET = 'your_consumer_secret' TWITTER_ACCESS_TOKEN = 'your_access_token' TWITTER_ACCESS_TOKEN_SECRET = 'your_access_token_secret'

Als nächstes müssen wir einen Scrapy-Crawler definieren, um Twitter-Daten zu crawlen. Wir können die Item-Definition von Scrapy verwenden, um den Typ der zu crawlenden Daten anzugeben, zum Beispiel:

class TweetItem(scrapy.Item):

text = scrapy.Field()

created_at = scrapy.Field()

user_screen_name = scrapy.Field()In der Crawler-Konfiguration können wir die Schlüsselwörter und den Zeitbereich festlegen, die abgefragt werden sollen, zum Beispiel:

class TwitterSpider(scrapy.Spider):

name = 'twitter'

allowed_domains = ['twitter.com']

start_urls = ['https://twitter.com/search?f=tweets&q=keyword%20since%3A2021-01-01%20until%3A2021-12-31&src=typd']

def parse(self, response):

tweets = response.css('.tweet')

for tweet in tweets:

item = TweetItem()

item['text'] = tweet.css('.tweet-text::text').extract_first().strip()

item['created_at'] = tweet.css('._timestamp::text').extract_first()

item['user_screen_name'] = tweet.css('.username b::text').extract_first().strip()

yield itemIn diesem Beispiel-Crawler: Wir haben einen CSS-Selektor verwendet, um alle Tweets zum Thema „Keywords“ auf Twitter vom 1. Januar 2021 bis 31. Dezember 2021 zu extrahieren. Wir speichern die Daten im oben definierten TweetItem-Objekt und übergeben sie über eine Yield-Anweisung an die Scrapy-Engine.

Wenn wir den Scrapy-Crawler ausführen, simuliert er automatisch den menschlichen Zugriff auf die Twitter-API, ruft Twitter-Daten ab und speichert sie im definierten Datentyp-TweetItem-Objekt. Wir können verschiedene von Scrapy bereitgestellte Tools und Datenanalysebibliotheken verwenden, um die gecrawlten Daten zu analysieren und zu extrahieren, wie zum Beispiel:

class TwitterAnalyzer():

def __init__(self, data=[]):

self.data = data

self.texts = [d['text'] for d in data]

self.dates = [dt.strptime(d['created_at'], '%a %b %d %H:%M:%S %z %Y').date() for d in data]

def get_top_hashtags(self, n=5):

hashtags = Counter([re.findall(r'(?i)#w+', t) for t in self.texts])

return hashtags.most_common(n)

def get_top_users(self, n=5):

users = Counter([d['user_screen_name'] for d in self.data])

return users.most_common(n)

def get_dates_histogram(self, step='day'):

if step == 'day':

return Counter(self.dates)

elif step == 'week':

return Counter([date.fromisoformat(str(dt).split()[0]) for dt in pd.date_range(min(self.dates), max(self.dates), freq='W')])

analyzer = TwitterAnalyzer(data)

print(analyzer.get_top_hashtags())

print(analyzer.get_top_users())

print(analyzer.get_dates_histogram('day'))In diesem Beispielcode definieren wir eine TwitterAnalyzer-Klasse, die die Daten im TweetItem-Objekt verwendet, um uns beim Erhalten verschiedener Informationen zu helfen und Erkenntnisse aus Twitter-Daten. Wir können Methoden dieser Klasse verwenden, um die am häufigsten verwendeten Hash-Tags in Tweets abzurufen, Zeitänderungen bei aktiven Benutzern und Impressionsdaten aufzudecken und vieles mehr.

Kurz gesagt, Scrapy ist ein sehr effektives Tool, das uns dabei helfen kann, Daten von Websites wie Twitter zu erhalten und dann mithilfe von Data-Mining- und Analysetechniken interessante Informationen und Erkenntnisse zu entdecken. Egal, ob Sie ein akademischer Forscher, ein Social-Media-Analyst oder ein Data-Science-Enthusiast sind, Scrapy ist ein Tool, das es wert ist, ausprobiert und verwendet zu werden.

Das obige ist der detaillierte Inhalt vonPraktische Anwendung von Scrapy beim Crawlen und Analysieren von Twitter-Daten. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

Was sind die Tools für Blockchain -Datenanalyse?

Feb 21, 2025 pm 10:24 PM

Was sind die Tools für Blockchain -Datenanalyse?

Feb 21, 2025 pm 10:24 PM

Die schnelle Entwicklung der Blockchain -Technologie hat die Notwendigkeit zuverlässiger und effizienter analytischer Tools ermöglicht. Diese Tools sind wichtig, um wertvolle Erkenntnisse aus Blockchain -Transaktionen zu entfernen, um ihr Potenzial besser zu verstehen und zu nutzen. In diesem Artikel werden einige der führenden Tools für Blockchain -Datenanalyse auf dem Markt untersucht, einschließlich ihrer Fähigkeiten, Vorteile und Einschränkungen. Durch das Verständnis dieser Tools können Benutzer die erforderlichen Erkenntnisse gewinnen, um die Möglichkeiten der Blockchain -Technologie zu maximieren.

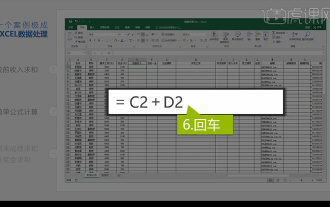

Integrierte Excel-Datenanalyse

Mar 21, 2024 am 08:21 AM

Integrierte Excel-Datenanalyse

Mar 21, 2024 am 08:21 AM

1. In dieser Lektion erklären wir die integrierte Excel-Datenanalyse. Wir vervollständigen sie anhand eines Falls. Öffnen Sie das Kursmaterial und klicken Sie auf Zelle E2, um die Formel einzugeben. 2. Anschließend wählen wir Zelle E53 aus, um alle folgenden Daten zu berechnen. 3. Dann klicken wir auf Zelle F2 und geben dann die Formel ein, um sie zu berechnen. Ebenso können wir durch Ziehen nach unten den gewünschten Wert berechnen. 4. Wir wählen Zelle G2 aus, klicken auf die Registerkarte „Daten“, klicken auf „Datenvalidierung“, wählen aus und bestätigen. 5. Verwenden wir dieselbe Methode, um die unten stehenden Zellen, die berechnet werden müssen, automatisch auszufüllen. 6. Als nächstes berechnen wir den tatsächlichen Lohn und wählen Zelle H2 aus, um die Formel einzugeben. 7. Dann klicken wir auf das Wert-Dropdown-Menü, um auf andere Zahlen zu klicken.

Welche Datenanalyse-Websites werden empfohlen?

Mar 13, 2024 pm 05:44 PM

Welche Datenanalyse-Websites werden empfohlen?

Mar 13, 2024 pm 05:44 PM

Empfohlen: 1. Wirtschaftsforum des Volkskongresses – Bereich Ökonometrie und Statistik; 4. Forum für Datenanalyse; . Datenanalyse; 8. Data Mining Research Institute; 9. S-PLUS, R Statistikforum.

Wo ist der offizielle Eingang zu Deepseek? Neueste Besuchshandbuch im Jahr 2025

Feb 19, 2025 pm 05:03 PM

Wo ist der offizielle Eingang zu Deepseek? Neueste Besuchshandbuch im Jahr 2025

Feb 19, 2025 pm 05:03 PM

Deepseek, eine umfassende Suchmaschine, die eine Vielzahl von Ergebnissen aus akademischen Datenbanken, Nachrichten -Websites und sozialen Medien liefert. Besuchen Sie die offizielle Website von Deepseek https://www.deepseek.com/, registrieren Sie ein Konto und melden Sie sich an. Anschließend können Sie mit der Suche beginnen. Verwenden Sie bestimmte Schlüsselwörter, präzise Phrasen oder erweiterte Suchoptionen, um Ihre Suche einzugrenzen und die relevantesten Ergebnisse zu erzielen.

Golang-Anwendungsbeispiele in der Datenanalyse und -visualisierung

Jun 04, 2024 pm 12:10 PM

Golang-Anwendungsbeispiele in der Datenanalyse und -visualisierung

Jun 04, 2024 pm 12:10 PM

Go wird häufig zur Datenanalyse und -visualisierung verwendet. Beispiele hierfür sind: Infrastrukturüberwachung: Gebäudeüberwachungsanwendungen mit Go mit Telegraf und Prometheus. Maschinelles Lernen: Erstellen und trainieren Sie Modelle mit Go und TensorFlow oder PyTorch. Datenvisualisierung: Erstellen Sie interaktive Diagramme mit den Bibliotheken Plotly und Go-echarts.

Bitget Exchange Offizielle Website Login Neueste Eingang

Feb 18, 2025 pm 02:54 PM

Bitget Exchange Offizielle Website Login Neueste Eingang

Feb 18, 2025 pm 02:54 PM

Der Bitget Exchange bietet eine Vielzahl von Anmeldemethoden, darunter E -Mail, Mobiltelefonnummer und Social Media -Konten. In diesem Artikel werden die neuesten Eingänge und Schritte für jede Anmeldemethode beschrieben, einschließlich des Zugriffs auf die offizielle Website, die Auswahl der Anmeldemethode, die Eingabe der Anmeldeinformationen und das Abschluss der Anmeldung. Benutzer sollten darauf achten, die offizielle Website zu nutzen, wenn sie sich anmelden und die Anmeldeinformationen ordnungsgemäß aufbewahren.

Wie viel kostet der Preis für MRT -Münzen? Der jüngste Preistrend der MRT -Münze

Mar 03, 2025 pm 11:48 PM

Wie viel kostet der Preis für MRT -Münzen? Der jüngste Preistrend der MRT -Münze

Mar 03, 2025 pm 11:48 PM

Diese Kryptowährung hat nicht wirklich einen Geldwert und ihr Wert hängt ausschließlich von der Unterstützung der Gemeinschaft ab. Anleger müssen vor dem Investieren sorgfältig nachforschen, da dies fehlen, und attraktive Token -Wirtschaftsmodelle. Da der Token im letzten Monat ausgestellt wurde, können Anleger derzeit nur durch dezentrale Börsen erwerben. Der Echtzeitpreis für die MRI-Münze beträgt 0,000045 ¥ 0,00033 mri Münze Historischer Preis ab 13:51 am 24. Februar 2025, der Preis für die MRT-Münze beträgt 0,000045 USD. Die folgende Abbildung zeigt den Preistrend des Tokens von Februar 2022 bis Juni 2024. MRT -Münzmünzen -Investitionsrisikobewertung Derzeit wurde die MRT -Münze in keiner Börse aufgeführt und der Preis wurde auf Null zurückgesetzt und kann nicht erneut gekauft werden. Auch wenn das Projekt

Gateio Offizieller Website Eingang

Mar 05, 2025 pm 08:09 PM

Gateio Offizieller Website Eingang

Mar 05, 2025 pm 08:09 PM

Die offizielle Website Gate.io ist über die offizielle Bewerbung zugänglich. Gefälschte Websites können falsch geschriebene, Designunterschiede oder verdächtige Sicherheitszertifikate enthalten. Zu den Schutzgebieten gehört das Vermeiden von Klicken auf verdächtige Links, die Verwendung von Zwei-Faktor-Authentifizierung und die Berichterstattung über betrügerische Aktivitäten an das offizielle Team. Häufig gestellte Fragen decken Registrierung, Transaktionen, Abhebungen, Kundendienst und Gebühren ab, während Sicherheitsmaßnahmen Kühlspeicher, Multisignaturen und KYC-Einhaltung umfassen. Benutzer sollten sich der häufigen betrügerischen Mittel bewusst sein, um Mitarbeiter auszugeben, Token zu geben oder um persönliche Informationen zu bitten.