Backend-Entwicklung

Backend-Entwicklung

Python-Tutorial

Python-Tutorial

Tipps zur Scrapy-Optimierung: So reduzieren Sie das Crawling doppelter URLs und verbessern die Effizienz

Tipps zur Scrapy-Optimierung: So reduzieren Sie das Crawling doppelter URLs und verbessern die Effizienz

Tipps zur Scrapy-Optimierung: So reduzieren Sie das Crawling doppelter URLs und verbessern die Effizienz

Scrapy ist ein leistungsstarkes Python-Crawler-Framework, mit dem große Datenmengen aus dem Internet abgerufen werden können. Bei der Entwicklung von Scrapy stoßen wir jedoch häufig auf das Problem, doppelte URLs zu crawlen, was viel Zeit und Ressourcen verschwendet und die Effizienz beeinträchtigt. In diesem Artikel werden einige Scrapy-Optimierungstechniken vorgestellt, um das Crawlen doppelter URLs zu reduzieren und die Effizienz von Scrapy-Crawlern zu verbessern.

1. Verwenden Sie die Attribute „start_urls“ und „allowed_domains“

Im Scrapy-Crawler können Sie das Attribut „start_urls“ verwenden, um die URLs anzugeben, die gecrawlt werden müssen. Gleichzeitig können Sie mit dem Attribut „allowed_domains“ auch die Domänennamen angeben, die der Crawler crawlen kann. Die Verwendung dieser beiden Attribute kann Scrapy dabei helfen, URLs, die nicht gecrawlt werden müssen, schnell herauszufiltern, was Zeit und Ressourcen spart und gleichzeitig die Effizienz verbessert.

2. Verwenden Sie Scrapy-Redis, um verteiltes Crawlen zu implementieren.

Wenn eine große Anzahl von URLs gecrawlt werden muss, ist das Crawlen auf einer einzelnen Maschine ineffizient, sodass Sie die Verwendung verteilter Crawling-Technologie in Betracht ziehen können. Scrapy-Redis ist ein Plug-in für Scrapy, das die Redis-Datenbank verwendet, um verteiltes Crawlen zu implementieren und die Effizienz von Scrapy-Crawlern zu verbessern. Durch Festlegen der Parameter REDIS_HOST und REDIS_PORT in der Datei „settings.py“ können Sie die Adresse und Portnummer der Redis-Datenbank angeben, mit der Scrapy-Redis eine Verbindung herstellt, um verteiltes Crawlen zu erreichen.

3. Verwenden Sie die inkrementelle Crawling-Technologie

Bei der Entwicklung von Scrapy-Crawlern stoßen wir häufig auf Situationen, in denen wir dieselbe URL wiederholt crawlen müssen, was zu einer großen Zeit- und Ressourcenverschwendung führt. Daher können inkrementelle Crawling-Techniken verwendet werden, um wiederholtes Crawlen zu reduzieren. Die Grundidee der inkrementellen Crawling-Technologie besteht darin, die gecrawlte URL aufzuzeichnen und beim nächsten Crawlen zu überprüfen, ob dieselbe URL basierend auf dem Datensatz gecrawlt wurde. Auf diese Weise kann das Crawlen doppelter URLs reduziert und die Effizienz verbessert werden.

4. Verwenden Sie Middleware, um doppelte URLs zu filtern.

Zusätzlich zur inkrementellen Crawling-Technologie können Sie auch Middleware verwenden, um doppelte URLs zu filtern. Die Middleware in Scrapy ist ein benutzerdefinierter Prozessor. Während der Ausführung des Scrapy-Crawlers können Anfragen und Antworten über die Middleware verarbeitet werden. Wir können die URL-Deduplizierung implementieren, indem wir benutzerdefinierte Middleware schreiben. Unter diesen besteht die am häufigsten verwendete Deduplizierungsmethode darin, mithilfe der Redis-Datenbank eine Liste der gecrawlten URLs aufzuzeichnen und die Liste abzufragen, um festzustellen, ob die URL gecrawlt wurde.

5. Verwenden Sie DupeFilter, um doppelte URLs zu filtern

Zusätzlich zur benutzerdefinierten Middleware bietet Scrapy auch einen integrierten Deduplizierungsfilter DupeFilter, der das Crawlen doppelter URLs effektiv reduzieren kann. DupeFilter hasht jede URL und speichert eindeutige Hash-Werte im Speicher. Daher werden während des Crawling-Vorgangs nur URLs mit unterschiedlichen Hash-Werten gecrawlt. Die Verwendung von DupeFilter erfordert keine zusätzliche Redis-Serverunterstützung und ist eine einfache Filtermethode für doppelte URLs.

Zusammenfassung:

Bei der Entwicklung von Scrapy-Crawlern ist das Crawlen doppelter URLs ein häufiges Problem. Um das Crawlen doppelter URLs zu reduzieren und die Effizienz von Scrapy-Crawlern zu verbessern, müssen verschiedene Optimierungstechniken eingesetzt werden. In diesem Artikel werden einige gängige Scrapy-Optimierungstechniken vorgestellt, darunter die Verwendung der Attribute „start_urls“ und „allowed_domains“, die Verwendung von Scrapy-Redis zur Implementierung des verteilten Crawlings, die Verwendung der inkrementellen Crawling-Technologie, die Verwendung benutzerdefinierter Middleware zum Filtern doppelter URLs und die Verwendung des integrierten DupeFilter zum Filtern doppelter URLs . Leser können je nach Bedarf geeignete Optimierungsmethoden auswählen, um die Effizienz von Scrapy-Crawlern zu verbessern.

Das obige ist der detaillierte Inhalt vonTipps zur Scrapy-Optimierung: So reduzieren Sie das Crawling doppelter URLs und verbessern die Effizienz. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1374

1374

52

52

Was ist der Unterschied zwischen HTML und URL?

Mar 06, 2024 pm 03:06 PM

Was ist der Unterschied zwischen HTML und URL?

Mar 06, 2024 pm 03:06 PM

Unterschiede: 1. Unterschiedliche Definitionen, URL ist ein einheitlicher Ressourcen-Locator und HTML ist eine Hypertext-Markup-Sprache. 2. Es kann viele URLs in einer HTML-Seite geben, aber nur eine HTML-Seite kann in einer URL vorhanden sein eine Webseite, und URL bezieht sich auf die Website-Adresse.

Ausführliche Interpretation: Warum ist Laravel so langsam wie eine Schnecke?

Mar 07, 2024 am 09:54 AM

Ausführliche Interpretation: Warum ist Laravel so langsam wie eine Schnecke?

Mar 07, 2024 am 09:54 AM

Laravel ist ein beliebtes PHP-Entwicklungsframework, wird jedoch manchmal dafür kritisiert, dass es so langsam wie eine Schnecke ist. Was genau verursacht die unbefriedigende Geschwindigkeit von Laravel? In diesem Artikel werden die Gründe, warum Laravel in vielerlei Hinsicht so langsam wie eine Schnecke ist, ausführlich erläutert und mit spezifischen Codebeispielen kombiniert, um den Lesern zu einem tieferen Verständnis dieses Problems zu verhelfen. 1. Probleme mit der ORM-Abfrageleistung In Laravel ist ORM (Object Relational Mapping) eine sehr leistungsstarke Funktion, die dies ermöglicht

Diskussion über Golangs GC-Optimierungsstrategie

Mar 06, 2024 pm 02:39 PM

Diskussion über Golangs GC-Optimierungsstrategie

Mar 06, 2024 pm 02:39 PM

Die Garbage Collection (GC) von Golang war schon immer ein heißes Thema unter Entwicklern. Als schnelle Programmiersprache kann der integrierte Garbage Collector von Golang den Speicher sehr gut verwalten, mit zunehmender Programmgröße treten jedoch manchmal Leistungsprobleme auf. In diesem Artikel werden die GC-Optimierungsstrategien von Golang untersucht und einige spezifische Codebeispiele bereitgestellt. Die Garbage Collection im Garbage Collector von Golang Golang basiert auf gleichzeitigem Mark-Sweep (concurrentmark-s

C++-Programmoptimierung: Techniken zur Reduzierung der Zeitkomplexität

Jun 01, 2024 am 11:19 AM

C++-Programmoptimierung: Techniken zur Reduzierung der Zeitkomplexität

Jun 01, 2024 am 11:19 AM

Die Zeitkomplexität misst die Ausführungszeit eines Algorithmus im Verhältnis zur Größe der Eingabe. Zu den Tipps zur Reduzierung der Zeitkomplexität von C++-Programmen gehören: Auswahl geeigneter Container (z. B. Vektor, Liste) zur Optimierung der Datenspeicherung und -verwaltung. Nutzen Sie effiziente Algorithmen wie die schnelle Sortierung, um die Rechenzeit zu verkürzen. Eliminieren Sie mehrere Vorgänge, um Doppelzählungen zu reduzieren. Verwenden Sie bedingte Verzweigungen, um unnötige Berechnungen zu vermeiden. Optimieren Sie die lineare Suche, indem Sie schnellere Algorithmen wie die binäre Suche verwenden.

Entschlüsselung von Laravel-Leistungsengpässen: Optimierungstechniken vollständig enthüllt!

Mar 06, 2024 pm 02:33 PM

Entschlüsselung von Laravel-Leistungsengpässen: Optimierungstechniken vollständig enthüllt!

Mar 06, 2024 pm 02:33 PM

Entschlüsselung von Laravel-Leistungsengpässen: Optimierungstechniken vollständig enthüllt! Als beliebtes PHP-Framework bietet Laravel Entwicklern umfangreiche Funktionen und ein komfortables Entwicklungserlebnis. Mit zunehmender Größe des Projekts und steigender Anzahl an Besuchen kann es jedoch zu Leistungsengpässen kommen. Dieser Artikel befasst sich mit den Techniken zur Leistungsoptimierung von Laravel, um Entwicklern dabei zu helfen, potenzielle Leistungsprobleme zu erkennen und zu lösen. 1. Optimierung der Datenbankabfrage mithilfe von Eloquent. Vermeiden Sie verzögertes Laden, wenn Sie Eloquent zum Abfragen der Datenbank verwenden

Laravel-Leistungsengpass aufgedeckt: Optimierungslösung aufgedeckt!

Mar 07, 2024 pm 01:30 PM

Laravel-Leistungsengpass aufgedeckt: Optimierungslösung aufgedeckt!

Mar 07, 2024 pm 01:30 PM

Laravel-Leistungsengpass aufgedeckt: Optimierungslösung aufgedeckt! Mit der Entwicklung der Internettechnologie ist die Leistungsoptimierung von Websites und Anwendungen immer wichtiger geworden. Als beliebtes PHP-Framework kann es bei Laravel während des Entwicklungsprozesses zu Leistungsengpässen kommen. In diesem Artikel werden die Leistungsprobleme untersucht, auf die Laravel-Anwendungen stoßen können, und einige Optimierungslösungen und spezifische Codebeispiele bereitgestellt, damit Entwickler diese Probleme besser lösen können. 1. Optimierung von Datenbankabfragen Datenbankabfragen sind einer der häufigsten Leistungsengpässe in Webanwendungen. existieren

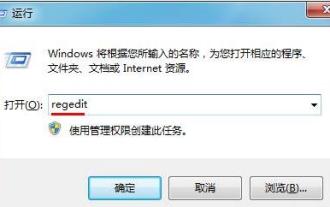

So optimieren Sie die Startelemente des WIN7-Systems

Mar 26, 2024 pm 06:20 PM

So optimieren Sie die Startelemente des WIN7-Systems

Mar 26, 2024 pm 06:20 PM

1. Drücken Sie die Tastenkombination (Win-Taste + R) auf dem Desktop, um das Ausführungsfenster zu öffnen, geben Sie dann [regedit] ein und drücken Sie zur Bestätigung die Eingabetaste. 2. Nachdem wir den Registrierungseditor geöffnet haben, klicken wir zum Erweitern auf [HKEY_CURRENT_USERSoftwareMicrosoftWindowsCurrentVersionExplorer] und prüfen dann, ob sich im Verzeichnis ein Serialize-Element befindet. Wenn nicht, können wir mit der rechten Maustaste auf Explorer klicken, ein neues Element erstellen und es Serialize nennen. 3. Klicken Sie dann auf „Serialisieren“, klicken Sie dann mit der rechten Maustaste auf die leere Stelle im rechten Bereich, erstellen Sie einen neuen DWORD-Wert (32) und nennen Sie ihn „Star“.

Wie erkennt man eine URL mit regulärem Ausdruck in Golang?

May 31, 2024 am 10:32 AM

Wie erkennt man eine URL mit regulärem Ausdruck in Golang?

May 31, 2024 am 10:32 AM

Die Schritte zum Erkennen von URLs in Golang mithilfe regulärer Ausdrücke sind wie folgt: Kompilieren Sie das reguläre Ausdrucksmuster mit regexp.MustCompile(pattern). Das Muster muss mit Protokoll, Hostname, Port (optional), Pfad (optional) und Abfrageparametern (optional) übereinstimmen. Verwenden Sie regexp.MatchString(pattern,url), um zu erkennen, ob die URL mit dem Muster übereinstimmt.