Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Warum kommt das große Modell von Chinas leistungsstärkstem KI-Forschungsinstitut zu spät?

Warum kommt das große Modell von Chinas leistungsstärkstem KI-Forschungsinstitut zu spät?

Warum kommt das große Modell von Chinas leistungsstärkstem KI-Forschungsinstitut zu spät?

Produziert von der Huxiu Technology Group

Autor|Qi Jian

Herausgeber|Chen Yifan

Kopfzeilenbild|FlagStudio

„Wird OpenAI wieder große Modelle als Open-Source-Lösung anbieten?“

Als Zhang Hongjiang, Vorsitzender des Zhiyuan Research Institute, Sam Altman, CEO von OpenAI, der online an der Zhiyuan-Konferenz 2023 teilnahm, nach Open-Source-Themen fragte, lächelte Sam Altman und sagte: OpenAI wird in Zukunft mehr Codes öffnen, aber es gibt welche kein spezifischer Open-Source-Zeitplan.

Eine solche Diskussion stammt aus einem der Themen dieser Weisheitskonferenz – Open-Source-Großmodelle.

Am 9. Juni fand in Peking die Zhiyuan-Konferenz 2023 statt und alle Plätze waren besetzt. Auf dem Konferenzgelände tauchten in den Chats der Teilnehmer sowie verschiedener Unternehmen dieser Industriekette von Zeit zu Zeit KI-bezogene Wörter wie „Rechenleistung“, „Großmodell“ und „Ökologie“ auf.

Auf dieser Konferenz veröffentlichte das Zhiyuan Research Institute die umfassende Open-Source-Version Wu Dao 3.0. Darunter Die visuelle Großmodellreihe „Vision“, die Sprachgroßmodellreihe „Sky Eagle“ und das ursprüngliche Großmodell-Bewertungssystem „Libra“.

Open Source für große Modelle bedeutet, den Modellcode für KI-Entwickler zum Studieren offenzulegen. Das grundlegende Sprachmodell „Sky Eagle“ in Wu Dao 3.0 ist immer noch ein im Handel erhältliches Modell, und jeder kann dieses große Modell kostenlos nutzen.

Derzeit sind Microsofts vertiefte Partner OpenAI, Google und BAAI die drei Institutionen, die auf dem Gebiet der künstlichen Intelligenz führend sind. „In einem aktuellen Interview erwähnte Microsoft-Präsident Brad Smith BAAI, die „stärkste“ KI-Forschungseinrichtung in China, die ebenso berühmt ist wie OpenAI und Google. Diese Einrichtung ist das Beijing Zhiyuan Artificial Intelligence Research Institute. Viele Leute in der Branche glauben das , die von diesem Institut veranstaltete Konferenz zur künstlichen Intelligenz ist ein Maßstab für Branchentrends

. Das vom Präsidenten von Microsoft hochgeschätzte Chiyuan Research Institute hat bereits im Oktober 2020 das KI-Großmodellprojekt „Enlightenment“ gestartet und zwei Versionen des Enlightenment-Großmodells 1.0 und 2.0 veröffentlicht.Die offiziell angekündigte Parameterskala der Aufklärung 2.0 erreicht 1,7 Billionen. Zu diesem Zeitpunkt war es erst ein Jahr her, seit OpenAI das GPT-3-Modell mit 175 Milliarden Parametern veröffentlichte. Allerdings war ein solcher Pionier großer KI-Modelle während des KI-Großmodell-Wahnsinns in den letzten sechs Monaten äußerst zurückhaltend.

Während unter den großen Herstellern und Start-up-Unternehmen nach und nach große Modelle auftauchen, blieb Zhiyuan gegenüber der Außenwelt mehr als drei Monate lang „still“, mit Ausnahme von „SegGPT“, das zu Beginn mit Metas ausgeschnittener KI „SAM“ kollidierte April wurden der Öffentlichkeit fast keine Informationen über das große KI-Modell preisgegeben.

In dieser Hinsicht haben viele Menschen innerhalb und außerhalb der KI-Branche Fragen: Warum scheint das Zhiyuan Research Institute, ein führendes Unternehmen auf dem Gebiet der großen KI-Modelle, erst spät auf dem Höhepunkt der großen Modelle zu sein?

Wird das Open-Source-Modell den Burggraben von OpenAI einreißen?

„Obwohl der Wettbewerb um große Modelle jetzt hart ist, haben weder OpenAI noch Google einen Burggraben, weil „Open Source“ im Bereich der großen KI-Modelle auf dem Vormarsch istIn einem von Google durchgesickerten Dokument glauben interne Google-Forscher, dass Open-Source-Modelle die Zukunft der Entwicklung großer Modelle anführen könnten. In dem Dokument heißt es: „

Open-Source-Modelle haben schnellere Iterationen, eine stärkere Anpassbarkeit und mehr. „Sie zahlen nicht für eingeschränkte Modelle, wenn die kostenlosen, uneingeschränkten Alternativen von gleicher Qualität sind“ Dies könnte einer der Gründe sein, warum sich Intelligent Source für die Entwicklung großer Open-Source-Modelle entschieden hat. Derzeit gibt es nicht viele kommerzielle Open-Source-Großmodelle. Das Zhiyuan Research Institute hat eine Umfrage zu einigen der im Ausland veröffentlichten Open-Source-Großmodelle durchgeführt. . Von den 28 in China veröffentlichten großen Sprachmodellen sind insgesamt 11 Open-Source-Modelle, aber nur eines davon ist ein Open-Source- und kommerziell erhältliches Modell.

Das von Zhiyuan veröffentlichte große Sprachmodell ist Open Source und im Handel erhältlich. Es ist auch eines der wenigen Open Source-Modelle für große Sprachen, die derzeit für die kommerzielle Nutzung verfügbar sind. Dies bedeutet auch, dass ein solches Modell vor der Veröffentlichung vorsichtiger sein muss .

„Was Zhiyuan betrifft, wollen wir auf keinen Fall, dass das Open-Source-Modell zu hässlich ist, deshalb werden wir es mit Vorsicht veröffentlichen.“ Ein KI-Forscher sagte auf der Zhiyuan-Konferenz, dass Open-Source-Modelle es zwangsläufig sein müssen Um die Qualität des Open-Source-Modells sicherzustellen, wurde der Forschungs- und Entwicklungsfortschritt von Zhiyuan möglicherweise durch „Open Source“ verlangsamt.

Huang Tiejun, Präsident des Zhiyuan Research Institute, glaubt, dass die derzeitige Open Source und Offenheit großer Modelle auf dem Markt unseres Landes bei weitem nicht ausreicht. „

Wir sollten Open Source weiter stärken und Open Source sind auch Wettbewerber.“ . Wenn es wirklich gute Standards und gute Algorithmen gibt, stellen Sie diese zur Bewertung bereit. Nur durch einen Vergleich können Sie Ihr technisches Niveau nachweisen“. Wenn inländische Hersteller große Modelle auf den Markt bringen, mangelt es an Transparenz und viele Menschen bezweifeln, dass diese Hersteller wirklich unabhängige Forschung und Entwicklung betrieben haben. Einige Leute sagen, dass sie ChatGPT über die API aufrufen, während andere sagen, dass sie das von Meta durchgesickerte LLaMA-Modell + die Antwortdaten von ChatGPT verwenden, um es zu trainieren. Das Open-Source-Modell schneidet diese Zweifel von der Quelle ab.

Allerdings Das Open-Source-Modell und die Verbesserung der technischen Transparenz dienen nicht dazu, die eigene Unschuld zu beweisen, sondern wirklich „die Anstrengungen zu konzentrieren, um große Dinge zu tun“. Laut Zhiyuan-Daten belaufen sich die täglichen Schulungskosten für das Tianying Big Language Model auf mehr als 100.000 Yuan. Im Rahmen des allgemeinen Trends des inländischen „Krieges der Hunderten von Modellen“ oder sogar des „Krieges der Tausenden von Modellen“ führen viele Branchen Eine große Anzahl unnötiger wiederholter Schulungen, die zu wiederholten Kosten führen können, kann astronomisch sein.

Open-Source-Modelle können wiederholte Schulungen reduzieren. Die direkte Verwendung von Open-Source- und kommerziell verfügbaren großen KI-Modellen und deren Kombination mit ihren eigenen Daten für die Schulung kann die beste Lösung für die KI-Implementierung und Branchenanwendungen sein.

Eine weitere Überlegung bei Open Source besteht darin, frühzeitig Benutzer und Entwickler zu gewinnen, um ein gutes Ökosystem aufzubauen und eine zukünftige Kommerzialisierung zu erreichen. Ein Gründer eines großen inländischen Modellunternehmens sagte zu Huxiu: „GPT-1 und GPT-2 von OpenAI sind beide Open-Source-Großmodelle. Dies dient dazu, Benutzer zu sammeln und die Erkennung des Modells zu verbessern.“ Nach dem Erscheinen wird die Kommerzialisierung im Mittelpunkt stehen und dieses Modell wird nach und nach geschlossen. Daher darf das Open-Source-Modell im Allgemeinen nicht kommerzialisiert werden. Dies ist auch auf spätere Kommerzialisierungsüberlegungen zurückzuführen

Aber offensichtlich hat Zhiyuan als gemeinnützige Forschungseinrichtung keine kommerziellen Überlegungen, wenn es um Open-Source-Themen geht. In Bezug auf Modell-Open-Source hofft Zhiyuan einerseits, die wissenschaftliche Forschung und Innovation in der KI-Großmodellindustrie zu fördern und die industrielle Umsetzung durch die Öffnung von Open-Source-Modellen wie zugrunde liegenden Modellen zu beschleunigen. Andererseits möchten Sie möglicherweise auch mehr Benutzerfeedback auf der Grundlage von Open-Source-Modellen sammeln und die Benutzerfreundlichkeit großer Modelle im Ingenieurwesen verbessern.Allerdings sind Open-Source-Modelle nicht „perfekt“.

Ein technischer KI-Direktor eines großen Herstellers sagte gegenüber Huxiu, dass der aktuelle Kommerzialisierungsmarkt für große KI-Modelle in drei Stufen unterteilt werden kann Für diejenigen, die Modelle basierend auf spezifischen Anforderungen entwickeln müssen, ist die dritte Ebene für kleine und mittlere Kunden gedacht, die nur allgemeine Modellfunktionen benötigen und API-Aufrufe verwenden können, um ihre Anforderungen zu erfüllen.

In diesem Zusammenhang können Open-Source-Modelle führenden Akteuren mit Selbstforschungsfähigkeiten dabei helfen, viel Zeit und Kosten bei der Entwicklung von Modellen zu sparen. Aber für Unternehmen der zweiten und dritten Ebene müssen sie ihre eigenen technischen Teams einrichten, um die Modelle zu trainieren und zu optimieren. Für viele Unternehmen mit geringerer technischer Stärke wird dies den Implementierungsprozess komplizierter und offener machen Die Quelle scheint das Gefühl zu haben, dass „kostenlose Dinge am teuersten sind“.

Diese „Erleuchtung“ ist nicht mehr diese „Erleuchtung“

Zhiyuan’s Enlightenment 3.0 ist eine komplett neu entwickelte Großmodellserie

Dies ist auch einer der Gründe für die „späte Veröffentlichung“.Warum muss Zhiyuan ein neues Modellsystem entwickeln, da wir bereits über die Grundlage der Aufklärung 2.0 verfügen? Einerseits liegt es an der Anpassung der technischen Ausrichtung des Modells, andererseits an der „Ersetzung“ der zugrunde liegenden Trainingsdaten des Modells.

"Wudao 2.0 wird im Jahr 2021 entwickelt. Unabhängig davon, ob es sich um ein Sprachmodell (wie GLM) oder ein vinzentinisches Diagrammmodell (wie CogView) handelt, ist die Algorithmusarchitektur, auf der es basiert, von nun an relativ früh. In der Vergangenheit Etwa ein Jahr später wurden Modellarchitekturen in verwandten Bereichen stärker verifiziert oder weiterentwickelt. Beispielsweise hat die in Sprachmodellen verwendete Nur-Decoder-Architektur gezeigt, dass in Basismodellen eine bessere Generierungsleistung erzielt werden kann Beim Textgraphenmodell haben wir für weitere Innovationen auf Diffusion umgestellt. Deshalb haben wir diese aktualisierten Architekturen für das große Sprachmodell und das große Textgraphengenerierungsmodell übernommen. Entwickelt Das Zhiyuan Research Institute sagte, dass Wu Dao 3.0 auf der Grundlage der Forschung früherer Modelle in viele Richtungen rekonstruiert wurde.

Darüber hinaus hat Wudao 3.0 auch die Trainingsdaten des zugrunde liegenden Modells umfassend optimiert und aktualisiert. Die aktualisierten Wudao-Chinesischdaten wurden in den Trainingsdaten verwendet, auch von 2021 bis heute, und wurden einer strengeren Qualitätsreinigung unterzogen Andererseits wurde eine große Anzahl hochwertiger chinesischer Bücher, Literatur usw. hinzugefügt. Darüber hinaus wurden hochwertige Codedatensätze hinzugefügt, sodass auch das Grundmodell große Änderungen erfahren hat.

Die zugrunde liegenden Modelltrainingsdaten stammen nicht aus muttersprachlichem Chinesisch, was dazu führt, dass viele inländische Modelle Probleme mit der Chinesisch-Verständnis haben. Viele große KI-Modelle im In- und Ausland nutzen für das Training umfangreiche Open-Source-Daten aus dem Ausland. Zu den Primärquellen gehört der berühmte Open-Source-Datensatz Common Crawl. Zhiyuan analysierte 1 Million Common Crawl-Webseitendaten und

39.052 chinesische Webseiten konnten extrahiert werden. Aus der Sicht der Website-Quellen gibt es 25.842 Websites, die Chinesisch extrahieren können, von denen nur 4.522 IPs auf dem chinesischen Festland haben, was nur 17 % ausmacht.Dies verringert nicht nur die Genauigkeit chinesischer Daten erheblich, sondern verringert auch die Sicherheit.

„Der Korpus, der zum Trainieren des Grundmodells verwendet wird, wird einen großen Einfluss auf die Konformität, Sicherheit und Werte haben, die durch AIGC-Anwendungen, fein abgestimmte Modelle und andere Inhalte generiert werden.“ Einfache Übersetzung, aber ausreichend. „In dieses Modell sind viele chinesische Kenntnisse eingeflossen.“ 99 % der chinesischen Internetdaten stammen von inländischen Websites, und Unternehmen können darauf basierend kontinuierliche Schulungen durchführen.

Gleichzeitig kann durch eine große Menge an verfeinerter Verarbeitung und Bereinigung von Daten und Zahlen ein Modell mit der gleichen oder sogar besseren Leistung mit einer kleinen Datenmenge trainiert werden. Diese Daten können sogar nur 30 % betragen 40 % der Datenmenge gehen über bestehende Open-Source-Modelle hinaus.Jetzt scheint es, dass dieser Weg eine bessere Lösung für Zhiyuan sein könnte. Denn in Bezug auf Trainingsdaten weist Zhiyuan im Vergleich zu Internetherstellern Defizite auf. Große Internetunternehmen verfügen über umfangreiche Benutzerinteraktionsdaten und eine große Menge an Urheberrechtsdaten für Schulungen. Vor nicht allzu langer Zeit hat die Alibaba Damo Academy gerade einen Video-Sprachdatensatz namens Youku-mPLUG veröffentlicht, dessen gesamter Inhalt von Youku stammt, einer Videoplattform von Alibaba.

Da

Zhiyuan in Bezug auf Trainingsdaten nicht über eine tiefe Benutzerbasis verfügt, kann es die Genehmigung nur durch Verhandlungen mit dem Urheberrechtsinhaber einholen und diese nach und nach durch einige öffentliche Wohlfahrtsdatenprojekte sammeln und akkumulieren.

Derzeit kann der chinesische Datensatz von Zhiyuan jedoch nur teilweise Open Source sein. Der Hauptgrund dafür ist, dass das Urheberrecht an chinesischen Daten in den Händen verschiedener Institutionen liegt. Derzeit werden die Trainingsdaten von Zhiyuan durch die Koordination mehrerer Parteien erhalten Open-Source-Modelle. Die meisten Daten können nur auf die Modelle von Zhiyuan angewendet werden und haben kein Recht auf eine Zweitverwendung."

In China ist es sehr wichtig, eine Industrieallianz für Datensätze zu gründen, Urheberrechtsinhaber zu vereinen und eine einheitliche Planung von Trainingsdaten für künstliche Intelligenz durchzuführen, aber dazu ist die Weisheit eines Designs auf höchstem Niveau erforderlich. ", sagte Lin Yonghua gegenüber Huxiu .

Whampoa Military Academy in der heimischen GroßmodellindustrieEnlightenment 3.0 erzählt eine andere Geschichte als Enlightenment 2.0, und die Veränderungen im Forschungs- und Entwicklungsteam sind eine davon. Als Pionier in der KI-Großmodellbranche ist das Zhiyuan Research Institute wie die Whampoa-Militärakademie für inländische KI-Großmodelle.

Von Zhiyuan-Wissenschaftlern bis hin zu Basisingenieuren sind sie alle im heutigen großen Modellwahn in der Branche populär geworden. Das ursprüngliche Team von Zhiyuan hat auch mehrere große Modellunternehmerteams gegründet.

Vor Wudao 3.0 war eine große Modellreihe eine Kombination von Forschungsergebnissen, die von mehreren externen Labors gemeinsam veröffentlicht wurden. Dieses Mal handelt es sich bei Wudao 3.0 jedoch um eine Reihe von Modellen, die vom Zhiyuan-Team vollständig selbst entwickelt wurden.Wudao 2.0-Modell wurde 2021 veröffentlicht, einschließlich Wenyuan, Wenlan, Wenhui und Wensu. Unter anderem wurden die beiden Kernmodelle von zwei Labors der Tsinghua-Universität fertiggestellt. Heute haben die beiden Teams ihre eigenen Unternehmen gegründet und eigene unabhängige Produkte in der Forschungs- und Entwicklungsrichtung von CPM und GLM entwickelt.

Unter anderem hat das Knowledge Engineering Laboratory (KEG) der Tsinghua University, das Haupt-F&E-Team von GLM, zusammen mit Zhipu AI das Open-Source-Modell ChatGLM-6B auf den Markt gebracht, das in der Branche weithin Anerkennung gefunden hat; Der Bereich Informatik der Tsinghua-Universität Shenyan Technology, der sich aus einigen Mitgliedern des Natural Language Processing and Social Humanities Computing Laboratory (THUNLP) zusammensetzt, wurde seit seiner Gründung vor einem Jahr in den beiden Finanzierungsrunden dieses Jahres bevorzugt , Tencent Investment, Sequoia China und Qiji Chuangtan und andere Fonds.

Eine dem Zhiyuan Research Institute nahestehende Person sagte zu Huxiu:

Seit dem Aufkommen inländischer groß angelegter KI-Modelle ist das Zhiyuan-Team zu einem „Jagdziel“ im Talentkrieg geworden: „Das gesamte Forschungs- und Entwicklungsteam wurde von anderen Unternehmen ins Visier genommen.“ Headhunter.

In der aktuellen inländischen KI-Großmodellindustrie mangelt es am meisten an Geld und am meisten an Menschen. Durchsuchen Sie ChatGPT auf den drei Plattformen Liepin, Maimai und BOSS Zhipin. Das monatliche Gehalt für Stellen mit Master- und Doktortiteln liegt im Allgemeinen über 30.000, das Höchstgehalt liegt bei 90.000. „In Bezug auf das Gehalt haben große IT-Unternehmen keinen großen Vorteil. Die Forschung und Entwicklung großer KI-Modelle erfolgt auf hohem Niveau. Das von Startups angebotene Gehalt ist möglicherweise wettbewerbsfähiger.“ , sagte Huxiu, dass der Kampf um Talente in der KI-Branche immer heftiger werden werde.„Ein doppeltes Gehalt ist nach Meinung vieler Mitarbeiter bei Zhiyuan überhaupt nicht konkurrenzfähig, denn jetzt werben sie Leute mit dem fünffachen oder sogar zehnfachen Gehalt ab, egal wie ideal man ist und wie man für die Zukunft plant.“ Es wird schwierig sein, der Versuchung eines Jahresgehalts von über einer Million zu widerstehen.“ Im Vergleich dazu steckt viel Kapital dahinter.

Durch Headhunting erfuhr Huxiu, dass das Einstiegsgehalt von Experten für die Verarbeitung natürlicher Sprache derzeit über 1 Million liegt. Für einige Arbeitnehmer mit langen Arbeitsjahren und niedrigem Lohn ist es schwierig, nicht ins Wanken zu geraten, wenn sie mit einem Vielfachen ihres Gehalts konfrontiert werden.

Den aktuellen öffentlichen Daten des Zhiyuan Research Institute zufolge sind die meisten Kernprojektteamleiter des Zhiyuan Research Institute jedoch immer noch hauptberuflich für die Forschungs- und Entwicklungsprojekte des Zhiyuan Research Institute verantwortlich.

"

Die Modelle von Enlightenment 3.0 wurden alle von Zhiyuans eigenen Forschern entwickelt, darunter Tianying, Libra und Vision." Lin Yonghua sagte, dass die aktuelle F&E-Stärke des Zhiyuan Research Institute immer die Spitze der Branche sei. Diejenigen, die sich verändern und die Welt verändern wollen, sind auf der Huxiu APP

Das obige ist der detaillierte Inhalt vonWarum kommt das große Modell von Chinas leistungsstärkstem KI-Forschungsinstitut zu spät?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1377

1377

52

52

Die große Model-App Tencent Yuanbao ist online! Hunyuan wird zu einem Allround-KI-Assistenten aufgerüstet, der überall hin mitgenommen werden kann

Jun 09, 2024 pm 10:38 PM

Die große Model-App Tencent Yuanbao ist online! Hunyuan wird zu einem Allround-KI-Assistenten aufgerüstet, der überall hin mitgenommen werden kann

Jun 09, 2024 pm 10:38 PM

Am 30. Mai kündigte Tencent ein umfassendes Upgrade seines Hunyuan-Modells an. Die auf dem Hunyuan-Modell basierende App „Tencent Yuanbao“ wurde offiziell eingeführt und kann in den App-Stores von Apple und Android heruntergeladen werden. Im Vergleich zur Hunyuan-Applet-Version in der vorherigen Testphase bietet Tencent Yuanbao Kernfunktionen wie KI-Suche, KI-Zusammenfassung und KI-Schreiben für Arbeitseffizienzszenarien. Yuanbaos Gameplay ist außerdem umfangreicher und bietet mehrere Funktionen für KI-Anwendungen , und neue Spielmethoden wie das Erstellen persönlicher Agenten werden hinzugefügt. „Tencent strebt nicht danach, der Erste zu sein, der große Modelle herstellt.“ Liu Yuhong, Vizepräsident von Tencent Cloud und Leiter des großen Modells von Tencent Hunyuan, sagte: „Im vergangenen Jahr haben wir die Fähigkeiten des großen Modells von Tencent Hunyuan weiter gefördert.“ . In die reichhaltige und umfangreiche polnische Technologie in Geschäftsszenarien eintauchen und gleichzeitig Einblicke in die tatsächlichen Bedürfnisse der Benutzer gewinnen

Das große Bytedance Beanbao-Modell wurde veröffentlicht. Der Full-Stack-KI-Dienst Volcano Engine unterstützt Unternehmen bei der intelligenten Transformation

Jun 05, 2024 pm 07:59 PM

Das große Bytedance Beanbao-Modell wurde veröffentlicht. Der Full-Stack-KI-Dienst Volcano Engine unterstützt Unternehmen bei der intelligenten Transformation

Jun 05, 2024 pm 07:59 PM

Tan Dai, Präsident von Volcano Engine, sagte, dass Unternehmen, die große Modelle gut implementieren wollen, vor drei zentralen Herausforderungen stehen: Modelleffekt, Inferenzkosten und Implementierungsschwierigkeiten: Sie müssen über eine gute Basisunterstützung für große Modelle verfügen, um komplexe Probleme zu lösen, und das müssen sie auch Dank der kostengünstigen Inferenzdienste können große Modelle weit verbreitet verwendet werden, und es werden mehr Tools, Plattformen und Anwendungen benötigt, um Unternehmen bei der Implementierung von Szenarien zu unterstützen. ——Tan Dai, Präsident von Huoshan Engine 01. Das große Sitzsackmodell feiert sein Debüt und wird häufig genutzt. Das Polieren des Modelleffekts ist die größte Herausforderung für die Implementierung von KI. Tan Dai wies darauf hin, dass ein gutes Modell nur durch ausgiebigen Gebrauch poliert werden kann. Derzeit verarbeitet das Doubao-Modell täglich 120 Milliarden Text-Tokens und generiert 30 Millionen Bilder. Um Unternehmen bei der Umsetzung groß angelegter Modellszenarien zu unterstützen, wird das von ByteDance unabhängig entwickelte Beanbao-Großmodell durch den Vulkan gestartet

Mithilfe der Shengteng-KI-Technologie hilft das Qinling·Qinchuan-Transportmodell Xi'an beim Aufbau eines intelligenten Transportinnovationszentrums

Oct 15, 2023 am 08:17 AM

Mithilfe der Shengteng-KI-Technologie hilft das Qinling·Qinchuan-Transportmodell Xi'an beim Aufbau eines intelligenten Transportinnovationszentrums

Oct 15, 2023 am 08:17 AM

„Hohe Komplexität, hohe Fragmentierung und Cross-Domain“ waren schon immer die Hauptprobleme auf dem Weg zur digitalen und intelligenten Modernisierung der Transportbranche. Kürzlich ist das „Qinling·Qinchuan Traffic Model“ mit einer Parameterskala von 100 Milliarden, das gemeinsam von China Science Vision, der Bezirksregierung Xi'an Yanta und dem Xi'an Future Artificial Intelligence Computing Center entwickelt wurde, auf den Bereich des intelligenten Transports ausgerichtet und bietet Dienstleistungen für Xi'an und die umliegenden Gebiete. Die Region wird ein Dreh- und Angelpunkt für intelligente Transportinnovationen sein. Das „Qinling·Qinchuan Traffic Model“ kombiniert Xi'ans umfangreiche lokale verkehrsökologische Daten in offenen Szenarien, den ursprünglich von China Science Vision unabhängig entwickelten fortschrittlichen Algorithmus und die leistungsstarke Rechenleistung der Shengteng AI des Xi'an Future Artificial Intelligence Computing Center Überwachung des Straßennetzes, intelligente Transportszenarien wie Notfallkommando, Wartungsmanagement und öffentlicher Verkehr führen zu digitalen und intelligenten Veränderungen. Das Verkehrsmanagement weist in verschiedenen Städten und auf verschiedenen Straßen unterschiedliche Merkmale auf

Entdeckung des NVIDIA-Inferenz-Frameworks für große Modelle: TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

Entdeckung des NVIDIA-Inferenz-Frameworks für große Modelle: TensorRT-LLM

Feb 01, 2024 pm 05:24 PM

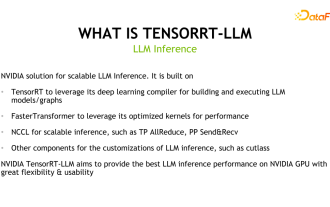

1. Produktpositionierung von TensorRT-LLM TensorRT-LLM ist eine von NVIDIA entwickelte skalierbare Inferenzlösung für große Sprachmodelle (LLM). Es erstellt, kompiliert und führt Berechnungsdiagramme auf der Grundlage des TensorRT-Deep-Learning-Kompilierungsframeworks aus und stützt sich auf die effiziente Kernels-Implementierung in FastTransformer. Darüber hinaus nutzt es NCCL für die Kommunikation zwischen Geräten. Entwickler können Betreiber entsprechend der Technologieentwicklung und Nachfrageunterschieden an spezifische Anforderungen anpassen, beispielsweise durch die Entwicklung maßgeschneiderter GEMM auf Basis von Entermessern. TensorRT-LLM ist die offizielle Inferenzlösung von NVIDIA, die sich der Bereitstellung hoher Leistung und der kontinuierlichen Verbesserung ihrer Praktikabilität verschrieben hat. TensorRT-LL

Benchmark GPT-4! Das große Jiutian-Modell von China Mobile hat die doppelte Registrierung bestanden

Apr 04, 2024 am 09:31 AM

Benchmark GPT-4! Das große Jiutian-Modell von China Mobile hat die doppelte Registrierung bestanden

Apr 04, 2024 am 09:31 AM

Laut Nachrichten vom 4. April hat die Cyberspace Administration of China kürzlich eine Liste registrierter großer Modelle veröffentlicht, in der das „Jiutian Natural Language Interaction Large Model“ von China Mobile enthalten ist, was darauf hinweist, dass das große Jiutian AI-Modell von China Mobile offiziell generative künstliche Intelligenz bereitstellen kann Geheimdienste nach außen. China Mobile gab an, dass dies das erste groß angelegte Modell sei, das von einem zentralen Unternehmen entwickelt wurde und sowohl die nationale Doppelregistrierung „Generative Artificial Intelligence Service Registration“ als auch die „Domestic Deep Synthetic Service Algorithm Registration“ bestanden habe. Berichten zufolge zeichnet sich Jiutians großes Modell für die Interaktion mit natürlicher Sprache durch verbesserte Branchenfähigkeiten, Sicherheit und Glaubwürdigkeit aus und unterstützt die vollständige Lokalisierung. Es hat mehrere Parameterversionen wie 9 Milliarden, 13,9 Milliarden, 57 Milliarden und 100 Milliarden gebildet. und kann flexibel in der Cloud eingesetzt werden, Edge und End sind unterschiedliche Situationen

Fortgeschrittene Praxis des industriellen Wissensgraphen

Jun 13, 2024 am 11:59 AM

Fortgeschrittene Praxis des industriellen Wissensgraphen

Jun 13, 2024 am 11:59 AM

1. Einführung in den Hintergrund Lassen Sie uns zunächst die Entwicklungsgeschichte von Yunwen Technology vorstellen. Yunwen Technology Company ... 2023 ist die Zeit, in der große Modelle vorherrschen. Viele Unternehmen glauben, dass die Bedeutung von Diagrammen nach großen Modellen stark abgenommen hat und die zuvor untersuchten voreingestellten Informationssysteme nicht mehr wichtig sind. Mit der Förderung von RAG und der Verbreitung von Data Governance haben wir jedoch festgestellt, dass eine effizientere Datenverwaltung und qualitativ hochwertige Daten wichtige Voraussetzungen für die Verbesserung der Wirksamkeit privatisierter Großmodelle sind. Deshalb beginnen immer mehr Unternehmen, darauf zu achten zu wissenskonstruktionsbezogenen Inhalten. Dies fördert auch den Aufbau und die Verarbeitung von Wissen auf einer höheren Ebene, wo es viele Techniken und Methoden gibt, die erforscht werden können. Es ist ersichtlich, dass das Aufkommen einer neuen Technologie nicht alle alten Technologien besiegt, sondern auch neue und alte Technologien integrieren kann.

Neuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich

Apr 23, 2024 pm 12:13 PM

Neuer Test-Benchmark veröffentlicht, der leistungsstärkste Open-Source-Llama 3 ist peinlich

Apr 23, 2024 pm 12:13 PM

Wenn die Testfragen zu einfach sind, können sowohl Spitzenschüler als auch schlechte Schüler 90 Punkte erreichen, und der Abstand kann nicht vergrößert werden ... Mit der Veröffentlichung stärkerer Modelle wie Claude3, Llama3 und später sogar GPT-5 ist die Branche in Bewegung Dringender Bedarf an einem schwierigeren und differenzierteren Benchmark-Modell. LMSYS, die Organisation hinter der großen Modellarena, brachte den Benchmark der nächsten Generation, Arena-Hard, auf den Markt, der große Aufmerksamkeit erregte. Es gibt auch die neueste Referenz zur Stärke der beiden fein abgestimmten Versionen der Llama3-Anweisungen. Im Vergleich zu MTBench, das zuvor ähnliche Ergebnisse erzielte, stieg die Arena-Hard-Diskriminierung von 22,6 % auf 87,4 %, was auf den ersten Blick stärker und schwächer ist. Arena-Hard basiert auf menschlichen Echtzeitdaten aus der Arena und seine Übereinstimmungsrate mit menschlichen Vorlieben liegt bei bis zu 89,1 %.

Xiaomi Byte schließt sich zusammen! Ein großes Modell von Xiao Ais Zugang zu Doubao: bereits auf Mobiltelefonen und SU7 installiert

Jun 13, 2024 pm 05:11 PM

Xiaomi Byte schließt sich zusammen! Ein großes Modell von Xiao Ais Zugang zu Doubao: bereits auf Mobiltelefonen und SU7 installiert

Jun 13, 2024 pm 05:11 PM

Laut Nachrichten vom 13. Juni hat Xiaomis Assistent für künstliche Intelligenz „Xiao Ai“ laut Bytes öffentlichem Bericht „Volcano Engine“ eine Zusammenarbeit mit Volcano Engine erzielt. Die beiden Parteien werden ein intelligenteres interaktives KI-Erlebnis auf der Grundlage des großen Beanbao-Modells erzielen . Berichten zufolge kann das von ByteDance erstellte groß angelegte Beanbao-Modell bis zu 120 Milliarden Text-Tokens effizient verarbeiten und täglich 30 Millionen Inhalte generieren. Xiaomi nutzte das große Doubao-Modell, um die Lern- und Denkfähigkeiten seines eigenen Modells zu verbessern und einen neuen „Xiao Ai Classmate“ zu schaffen, der nicht nur die Benutzerbedürfnisse genauer erfasst, sondern auch eine schnellere Reaktionsgeschwindigkeit und umfassendere Inhaltsdienste bietet. Wenn ein Benutzer beispielsweise nach einem komplexen wissenschaftlichen Konzept fragt, &ldq