Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Für große KI-Modelle hat Tencent Cloud erstmals sein selbst entwickeltes Xingmai-Hochleistungscomputernetzwerk vollständig offengelegt

Für große KI-Modelle hat Tencent Cloud erstmals sein selbst entwickeltes Xingmai-Hochleistungscomputernetzwerk vollständig offengelegt

Für große KI-Modelle hat Tencent Cloud erstmals sein selbst entwickeltes Xingmai-Hochleistungscomputernetzwerk vollständig offengelegt

Der Ausbruch von AIGC bringt nicht nur Herausforderungen bei der Rechenleistung mit sich, sondern stellt auch beispiellose Anforderungen an das Netzwerk.

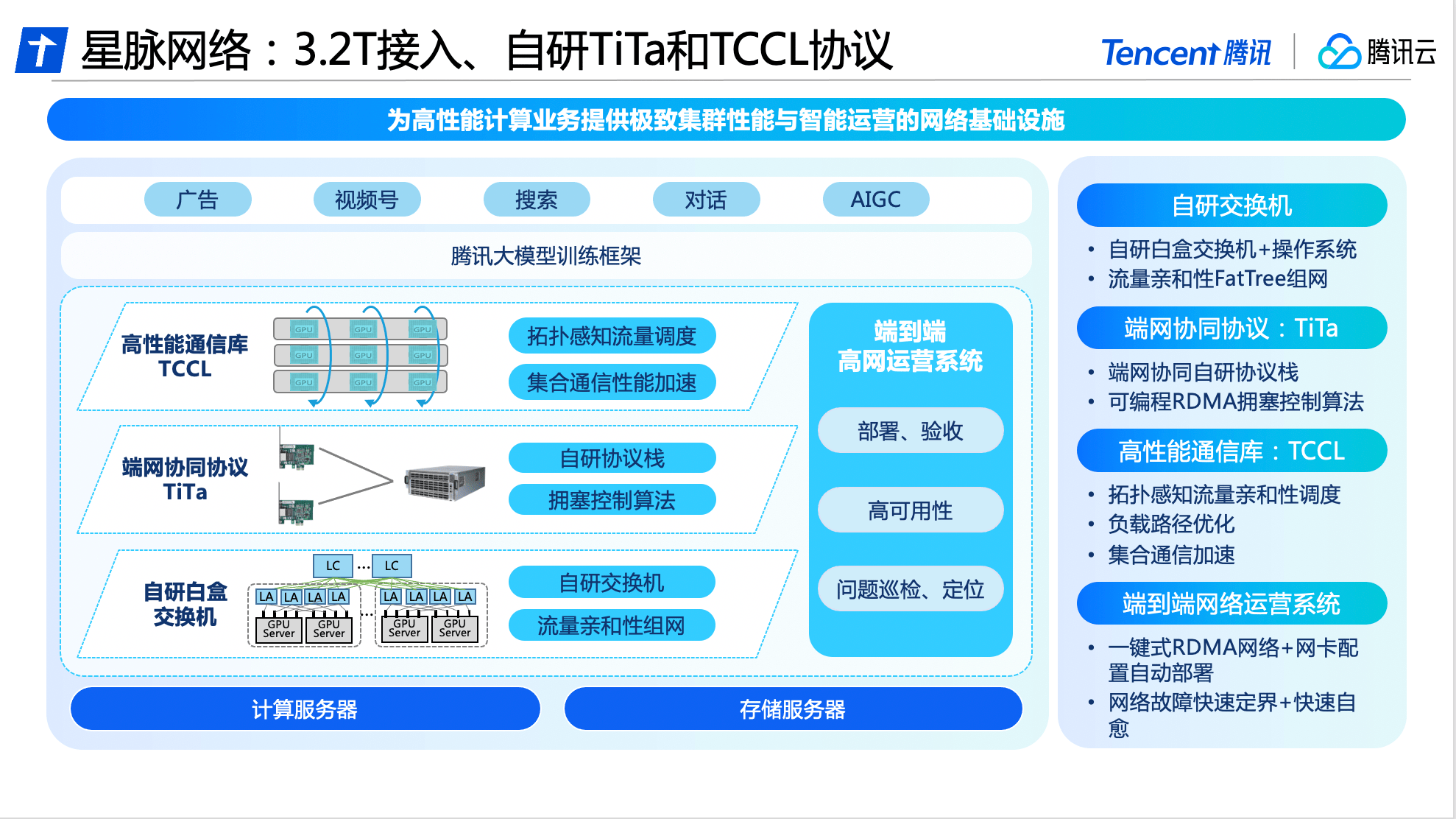

Am 26. Juni stellte Tencent Cloud erstmals sein selbst entwickeltes Xingmai-Hochleistungscomputernetzwerk vollständig vor: Das Xingmai-Netzwerk verfügt über die branchenweit höchste 3,2-T-Kommunikationsbandbreite, wodurch die GPU-Auslastung um 40 % erhöht und 30 bis 60 % eingespart werden können von Modellen führen zu einer zehnfachen Verbesserung der Kommunikationsleistung bei großen KI-Modellen. Der Rechencluster HCC der neuen Generation von Tencent Cloud kann einen riesigen Rechenumfang von mehr als 100.000 Karten unterstützen.

Wang Yachen, Vizepräsident von Tencent Cloud, sagte: „Xingmai Network ist für große Modelle konzipiert. Die leistungsstarken Netzwerkdienste, die es mit großer Bandbreite, hoher Auslastung und keinem Paketverlust bietet, werden dazu beitragen, den Engpass bei der Rechenleistung zu überwinden und weitere Freigaben zu ermöglichen.“ KI-Potenzial, umfassende Verbesserung der Trainingseffizienz großer Unternehmensmodelle und Beschleunigung der iterativen Aktualisierung und Implementierung der Großmodelltechnologie in der Cloud.“

Bauen Sie ein Hochleistungsnetzwerk für große Modelle auf und steigern Sie die GPU-Auslastung um 40 %

Die Popularität von AIGC hat zu einem Anstieg der Anzahl großer KI-Modellparameter von Hunderten Millionen auf Billionen geführt. Um das groß angelegte Training großer Datenmengen zu unterstützen, bilden eine große Anzahl von Servern über Hochgeschwindigkeitsnetzwerke einen Rechencluster und sind miteinander verbunden, um gemeinsam Trainingsaufgaben zu erledigen.

Im Gegenteil: Je größer der GPU-Cluster, desto größer ist der zusätzliche Kommunikationsverlust. Ein großer Cluster bedeutet keine große Rechenleistung. Die Ära der großen KI-Modelle hat das Netzwerk vor erhebliche Herausforderungen gestellt, darunter hohe Bandbreitenanforderungen, hohe Auslastung und Informationsverlustfreiheit.

Herkömmliche Netzwerkbandbreite mit niedriger Geschwindigkeit kann große Modelle mit Hunderten von Milliarden oder Billionen Parametern nicht erfüllen. Während des Trainingsprozesses kann der Kommunikationsanteil bis zu 50 % betragen. Gleichzeitig können herkömmliche Netzwerkprotokolle leicht zu Netzwerküberlastung, hoher Latenz und Paketverlust führen, und nur 0,1 % der Netzwerkpaketverluste können zu einem Verlust von 50 % der Rechenleistung führen, was letztendlich zu einer erheblichen Verschwendung von Rechenleistungsressourcen führt.

Basierend auf umfassenden Selbstforschungsfunktionen hat Tencent Cloud Software- und Hardware-Upgrades sowie Innovationen bei Switches, Kommunikationsprotokollen, Kommunikationsbibliotheken und Betriebssystemen durchgeführt und ist das erste Unternehmen, das das branchenweit führende dedizierte Hochleistungsnetzwerk für große Modelle auf den Markt bringt - Xingmai-Netzwerk.

In Bezug auf die Hardware basiert Xingmai Network auf der Netzwerk-F&E-Plattform von Tencent und nutzt alle selbst entwickelten Geräte, um eine Verbindungsbasis aufzubauen, um eine automatisierte Bereitstellung und Konfiguration zu erreichen.

In Bezug auf die Software verwendet das selbst entwickelte TiTa-Netzwerkprotokoll von Tencent Cloud eine fortschrittliche Technologie zur Überlastungskontrolle und -verwaltung, mit der Netzwerküberlastungen in Echtzeit überwacht und angepasst, die Kommunikationsanforderungen zwischen einer großen Anzahl von Serverknoten erfüllt und ein reibungsloser Datenaustausch sichergestellt werden können und geringe Latenz. Erreichen Sie unter hoher Last keinen Paketverlust, wodurch die Cluster-Kommunikationseffizienz mehr als 90 % erreicht.

Darüber hinaus hat Tencent Cloud auch eine leistungsstarke kollektive Kommunikationsbibliothek TCCL für das Xingmai-Netzwerk entwickelt und in maßgeschneiderte Lösungen integriert, sodass das System eine Netzwerkqualitätswahrnehmung auf Mikrosekundenebene realisieren kann. Durch die Verwendung eines dynamischen Planungsmechanismus zur sinnvollen Zuweisung von Kommunikationskanälen können Trainingsunterbrechungen aufgrund von Netzwerkproblemen effektiv vermieden und Kommunikationsverzögerungen um 40 % reduziert werden.

Die Verfügbarkeit des Netzwerks bestimmt auch die Rechenstabilität des gesamten Clusters. Um die hohe Verfügbarkeit des Xingmai-Netzwerks sicherzustellen, hat Tencent Cloud ein End-to-End-Full-Stack-Netzwerkbetriebssystem entwickelt. Durch die dreidimensionale Überwachung des Endnetzwerks und das intelligente Positionierungssystem werden Endnetzwerkprobleme automatisch abgegrenzt und analysiert, so dass die gesamte Fehlerbehebungszeit verkürzt werden kann. Die Tagesebene wird auf die Minutenebene reduziert. Durch Verbesserungen wurde die Gesamtbereitstellungszeit des groß angelegten Modelltrainingssystems auf 4,5 Tage verkürzt, wodurch eine 100-prozentige Genauigkeit der Grundkonfiguration gewährleistet wurde.

Nach drei Generationen technologischer Entwicklung haben wir die Integration von Software und Hardware intensiv gepflegt und erforscht

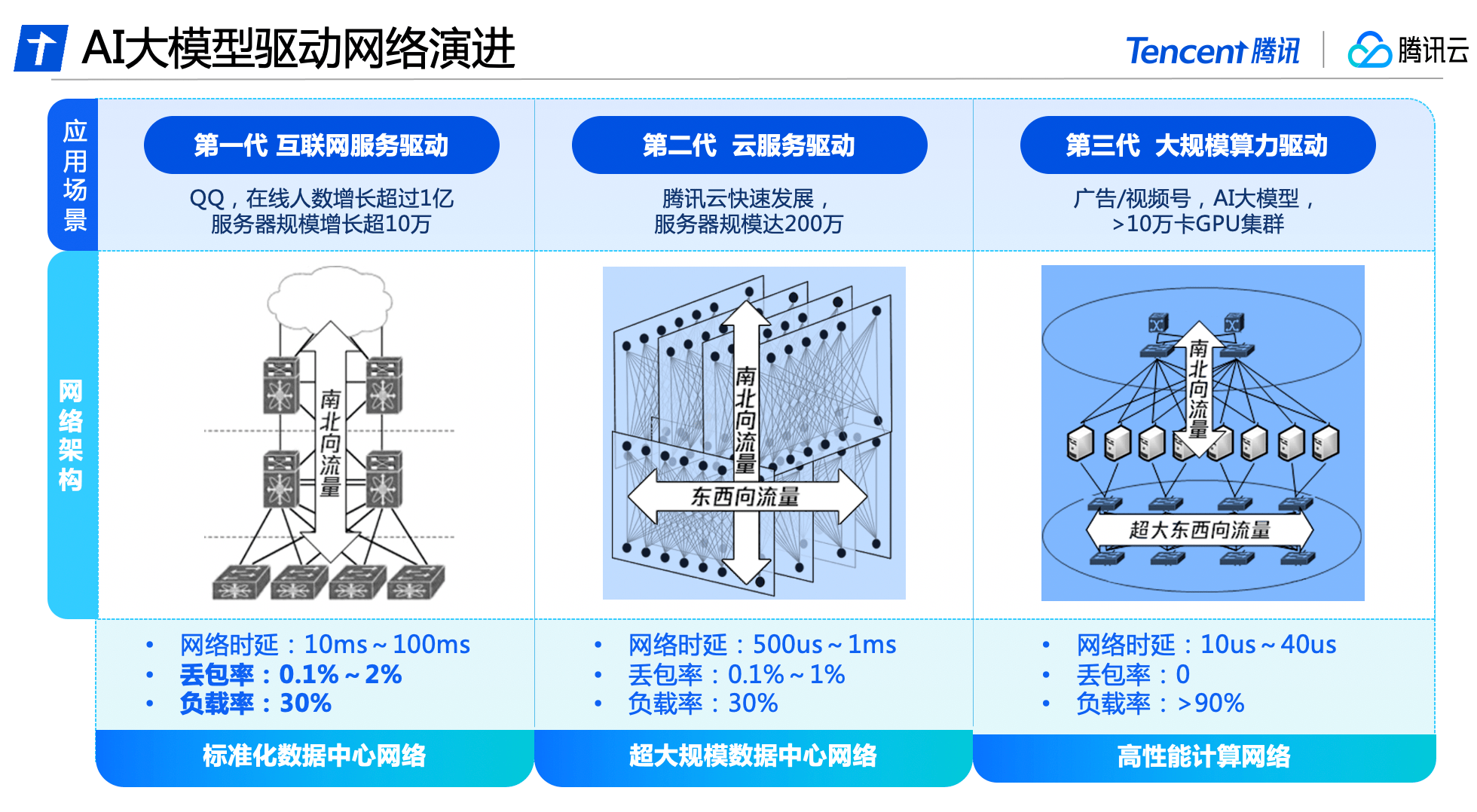

Hinter der umfassenden Modernisierung des Xingmai-Netzwerks steckt das Ergebnis von drei Generationen technologischer Weiterentwicklung des Rechenzentrumsnetzwerks von Tencent.

In den frühen Tagen der Entwicklung von Tencent bestand der Netzwerkverkehr von Rechenzentren hauptsächlich aus Nord-Süd-Verkehr für Benutzer, um auf Server von Rechenzentren zuzugreifen. Die Netzwerkarchitektur basierte hauptsächlich auf Zugriff, Aggregation und Ausgang. Zu diesem Zeitpunkt wurde hauptsächlich kommerzielle Netzwerkausrüstung zum Aufbau eines standardisierten Rechenzentrumsnetzwerks verwendet, was das Wachstum der QQ-Online-Benutzer um mehr als 100 Millionen und die Größe der Server um mehr als 100.000 unterstützte.

Mit dem Aufkommen von Big Data und Cloud Computing hat der Ost-West-Verkehr zwischen Servern allmählich zugenommen, und Cloud-Mieter haben Virtualisierungs- und Isolationsanforderungen für das Netzwerk geschaffen. Die Netzwerkarchitektur des Rechenzentrums hat sich nach und nach zu einer Cloud-Netzwerkarchitektur entwickelt, die sowohl den Nord-Süd- als auch den Ost-West-Verkehr überträgt. Tencent Cloud hat ein vollständig selbst entwickeltes Netzwerkausrüstungs- und Verwaltungssystem aufgebaut, um ein extrem großes Rechenzentrumsnetzwerk zu schaffen mit fast 2 Millionen Servern.

Tencent Cloud war das erste Unternehmen, das in China ein Hochleistungs-Computing-Netzwerk eingeführt hat, um den Anforderungen großer KI-Modelle gerecht zu werden, und eine Trennungsarchitektur für den Ost-West- und Nord-Süd-Verkehr eingeführt hat. Es hat eine unabhängige Netzwerkarchitektur mit extrem großer Bandbreite aufgebaut, die den Merkmalen des KI-Trainingsverkehrs entspricht, und arbeitet mit selbst entwickelten Software- und Hardwareeinrichtungen zusammen, um eine unabhängige Steuerbarkeit des gesamten Systems zu erreichen und den neuen Anforderungen an Superrechenleistung für das Netzwerk gerecht zu werden Leistung.

Kürzlich hat Tencent Cloud eine neue Generation von HCC-Hochleistungs-Computing-Clustern veröffentlicht, die auf dem Xingmai-Hochleistungsnetzwerk basieren. Es kann eine ultrahohe Verbindungsbandbreite von 3,2 T erreichen und die Rechenleistung ist dreimal höher als die Vorherige Generation. Es wurde für das Training großer KI-Modelle entwickelt. Zuverlässige, leistungsstarke Netzwerkbasis.

Tencent Cloud wird auch in Zukunft in die Forschung und Entwicklung grundlegender Technologien investieren, um starke technische Unterstützung für die digitale und intelligente Transformation verschiedener Branchen zu bieten.

Das obige ist der detaillierte Inhalt vonFür große KI-Modelle hat Tencent Cloud erstmals sein selbst entwickeltes Xingmai-Hochleistungscomputernetzwerk vollständig offengelegt. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1386

1386

52

52

Große KI-Modelle sind sehr teuer und nur große Unternehmen und Superreiche können sie erfolgreich einsetzen

Apr 15, 2023 pm 07:34 PM

Große KI-Modelle sind sehr teuer und nur große Unternehmen und Superreiche können sie erfolgreich einsetzen

Apr 15, 2023 pm 07:34 PM

Der ChatGPT-Brand hat zu einer weiteren Welle der KI-Begeisterung geführt. Die Branche geht jedoch allgemein davon aus, dass sich nur große Unternehmen und superreiche Unternehmen KI leisten können, wenn die KI in die Ära großer KI-Modelle eintritt, da die Erstellung großer KI-Modelle sehr teuer ist . Das erste ist, dass es rechenintensiv ist. Avi Goldfarb, Marketingprofessor an der University of Toronto, sagte: „Wenn Sie ein Unternehmen gründen, selbst ein großes Sprachmodell entwickeln und es selbst berechnen möchten, sind die Kosten zu hoch. OpenAI ist sehr teuer und kostet Milliarden von Dollar.“ „Mietcomputer werden sicherlich viel billiger sein, aber Unternehmen müssen immer noch hohe Gebühren an AWS und andere Unternehmen zahlen. Zweitens sind Daten teuer. Trainingsmodelle erfordern riesige Datenmengen, manchmal sind die Daten leicht verfügbar und manchmal nicht. Daten wie CommonCrawl und LAION können kostenlos sein

Wie baut man ein KI-orientiertes Data-Governance-System auf?

Apr 12, 2024 pm 02:31 PM

Wie baut man ein KI-orientiertes Data-Governance-System auf?

Apr 12, 2024 pm 02:31 PM

In den letzten Jahren sind mit dem Aufkommen neuer Technologiemodelle, der Wertsteigerung von Anwendungsszenarien in verschiedenen Branchen und der Verbesserung der Produkteffekte aufgrund der Ansammlung riesiger Datenmengen Anwendungen der künstlichen Intelligenz aus Bereichen wie Konsum und Internet ausgestrahlt worden zu traditionellen Branchen wie Fertigung, Energie und Elektrizität. Der Reifegrad der Technologie und Anwendung künstlicher Intelligenz in Unternehmen verschiedener Branchen in den Hauptbereichen wirtschaftlicher Produktionsaktivitäten wie Design, Beschaffung, Produktion, Management und Vertrieb verbessert sich ständig und beschleunigt die Implementierung und Abdeckung künstlicher Intelligenz in allen Bereichen schrittweise Integration in das Hauptgeschäft, um den Industriestatus zu verbessern oder die Betriebseffizienz zu optimieren und die eigenen Vorteile weiter auszubauen. Die groß angelegte Implementierung innovativer Anwendungen der Technologie der künstlichen Intelligenz hat die starke Entwicklung des Big-Data-Intelligence-Marktes vorangetrieben und auch den zugrunde liegenden Data-Governance-Diensten Marktvitalität verliehen. Mit Big Data, Cloud Computing und Computing

Populärwissenschaft: Was ist ein KI-Großmodell?

Jun 29, 2023 am 08:37 AM

Populärwissenschaft: Was ist ein KI-Großmodell?

Jun 29, 2023 am 08:37 AM

Unter KI-Großmodellen versteht man Modelle der künstlichen Intelligenz, die mithilfe umfangreicher Daten und leistungsstarker Rechenleistung trainiert werden. Diese Modelle weisen in der Regel ein hohes Maß an Genauigkeit und Generalisierungsfähigkeiten auf und können auf verschiedene Bereiche wie die Verarbeitung natürlicher Sprache, Bilderkennung, Spracherkennung usw. angewendet werden. Das Training großer KI-Modelle erfordert eine große Menge an Daten und Rechenressourcen, und in der Regel ist es erforderlich, ein verteiltes Computer-Framework zu verwenden, um den Trainingsprozess zu beschleunigen. Der Trainingsprozess dieser Modelle ist sehr komplex und erfordert eine eingehende Untersuchung und Optimierung der Datenverteilung, Merkmalsauswahl, Modellstruktur usw. KI-Großmodelle haben ein breites Anwendungsspektrum und können in verschiedenen Szenarien eingesetzt werden, z. B. im intelligenten Kundenservice, im Smart Home, beim autonomen Fahren usw. In diesen Anwendungen können große KI-Modelle Menschen dabei helfen, verschiedene Aufgaben schneller und genauer zu erledigen und die Arbeitseffizienz zu verbessern.

So entwickeln Sie Hochleistungs-Computing-Funktionen mit Redis und TypeScript

Sep 20, 2023 am 11:21 AM

So entwickeln Sie Hochleistungs-Computing-Funktionen mit Redis und TypeScript

Sep 20, 2023 am 11:21 AM

Überblick über die Verwendung von Redis und TypeScript zur Entwicklung leistungsstarker Computerfunktionen: Redis ist ein Open-Source-In-Memory-Datenstrukturspeichersystem mit hoher Leistung und Skalierbarkeit. TypeScript ist eine Obermenge von JavaScript, die ein Typsystem und eine bessere Unterstützung für Entwicklungstools bietet. Durch die Kombination von Redis und TypeScript können wir effiziente Rechenfunktionen entwickeln, um große Datenmengen zu verarbeiten und die Speicher- und Rechenfunktionen von Redis voll auszunutzen. Dieser Artikel zeigt Ihnen, wie es geht

Geboren für KI: Samsung kündigt an, den HBM4-Videospeicher im Jahr 2025 in Produktion zu bringen und damit um die Führung im Hochleistungsrechnen zu konkurrieren

Oct 13, 2023 pm 02:17 PM

Geboren für KI: Samsung kündigt an, den HBM4-Videospeicher im Jahr 2025 in Produktion zu bringen und damit um die Führung im Hochleistungsrechnen zu konkurrieren

Oct 13, 2023 pm 02:17 PM

Der rasante Anstieg der KI-Rechenleistung in den letzten Jahren hat Computerkarten zu einem neuen Ziel für große Hardwarehersteller gemacht. Neben den leistungsstarken GPUs von NVIDIA sind insbesondere Computerkarten von Herstellern wie Samsung Mangelware Auch Hynix und Hynix wollen sich dieses KI-Fest nicht entgehen lassen, insbesondere die von ihnen hergestellten Hochleistungs-Computerkarten, die einen leistungsstarken Grafikspeicher benötigen. Derzeit hat ein leitender Angestellter im Speicherbereich von Samsung ein Dokument herausgegeben, in dem es heißt, dass Samsung dies plant 2025 soll der neueste Speicher in Massenproduktion hergestellt werden. Der HBM4-Videospeicher überholt damit Hynix. Im Jahr 2016 begann Samsung offiziell mit der Massenproduktion von HBM-Videospeichern. Im Vergleich zum GDDR-Videospeicher verfügt der HBM-Videospeicher über eine größere Bandbreite und erreicht dadurch eine höhere Übertragungsleistung. Im Verbrauchermarkt AMDs Radeon

Im Zeitalter großer KI-Modelle fördern neue Datenspeicherbasen den Übergang zur digitalen Intelligenz in der Bildung und wissenschaftlichen Forschung

Jul 21, 2023 pm 09:53 PM

Im Zeitalter großer KI-Modelle fördern neue Datenspeicherbasen den Übergang zur digitalen Intelligenz in der Bildung und wissenschaftlichen Forschung

Jul 21, 2023 pm 09:53 PM

Generative KI (AIGC) hat eine neue Ära der allgemeinen künstlichen Intelligenz eingeleitet. Der Wettbewerb um große Modelle ist zu einem spektakulären Schwerpunkt geworden, und das Erwachen der Macht ist zunehmend zu einem Branchenkonsens geworden. In der neuen Ära bewegen sich große Modelle von Einzelmodalität zu Multimodalität, die Größe von Parametern und Trainingsdatensätzen wächst exponentiell und riesige unstrukturierte Daten erfordern gleichzeitig die Unterstützung leistungsstarker Mischlastfunktionen; datenintensiv Das neue Paradigma erfreut sich immer größerer Beliebtheit und Anwendungsszenarien wie Supercomputing und High Performance Computing (HPC) rücken in die Tiefe. Bestehende Datenspeichergrundlagen sind nicht mehr in der Lage, den ständig wachsenden Anforderungen gerecht zu werden. Wenn Rechenleistung, Algorithmen und Daten die „Troika“ sind, die die Entwicklung künstlicher Intelligenz vorantreibt, dann müssen diese drei angesichts der enormen Veränderungen im äußeren Umfeld dringend wieder an Dynamik gewinnen

Vivo bringt ein selbst entwickeltes Allzweck-KI-Modell auf den Markt – das Blue Heart Model

Nov 01, 2023 pm 02:37 PM

Vivo bringt ein selbst entwickeltes Allzweck-KI-Modell auf den Markt – das Blue Heart Model

Nov 01, 2023 pm 02:37 PM

Vivo veröffentlichte am 1. November auf der Entwicklerkonferenz 2023 seine selbst entwickelte allgemeine Matrix für künstliche Intelligenz – das Blue Heart Model. Vivo kündigte an, dass das Blue Heart Model 5 Modelle mit unterschiedlichen Parameterebenen auf den Markt bringen wird : Milliarden, Dutzende Milliarden und Hunderte von Milliarden, die Kernszenarien abdecken, und ihre Modellfähigkeiten nehmen eine führende Position in der Branche ein. Vivo ist der Ansicht, dass ein gutes selbstentwickeltes großes Modell die folgenden fünf Anforderungen erfüllen muss: großer Maßstab, umfassende Funktionen, leistungsstarke Algorithmen, sicher und zuverlässig, unabhängige Entwicklung und sollte weitgehend Open Source sein. Der neu geschriebene Inhalt ist wie folgt: Unter ihnen Das erste ist das Blue-Heart-Modell Modell 7B, ein 7-Milliarden-Level-Modell, das duale Dienste für Mobiltelefone und die Cloud bereitstellen soll. Vivo sagte, dass dieses Modell in Bereichen wie Sprachverständnis und Texterstellung eingesetzt werden kann.

Wird das Lernen des Vergessens in Bezug auf das menschliche Gehirn große KI-Modelle besser machen?

Mar 12, 2024 pm 02:43 PM

Wird das Lernen des Vergessens in Bezug auf das menschliche Gehirn große KI-Modelle besser machen?

Mar 12, 2024 pm 02:43 PM

Kürzlich entwickelte ein Team von Informatikern ein flexibleres und belastbareres Modell für maschinelles Lernen mit der Fähigkeit, bekannte Informationen regelmäßig zu vergessen, eine Funktion, die in bestehenden groß angelegten Sprachmodellen nicht zu finden ist. Tatsächliche Messungen zeigen, dass die „Vergessensmethode“ in vielen Fällen beim Training sehr effizient ist und das Vergessensmodell eine bessere Leistung erbringt. Jea Kwon, ein KI-Ingenieur am Institute for Basic Science in Korea, sagte, die neue Forschung bedeute einen erheblichen Fortschritt auf dem Gebiet der KI. Die Trainingseffizienz der „Vergessensmethode“ ist sehr hoch. Die meisten gängigen KI-Sprach-Engines verwenden künstliche neuronale Netzwerktechnologie. Jedes „Neuron“ in dieser Netzwerkstruktur ist eigentlich eine mathematische Funktion. Sie sind miteinander verbunden, um Informationen zu empfangen und zu übertragen.