Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Google AudioPaLM implementiert die dualmodale Lösung „Text + Audio', ein großes Modell für Sprechen und Hören

Google AudioPaLM implementiert die dualmodale Lösung „Text + Audio', ein großes Modell für Sprechen und Hören

Google AudioPaLM implementiert die dualmodale Lösung „Text + Audio', ein großes Modell für Sprechen und Hören

Groß angelegte Sprachmodelle haben mit ihrer leistungsstarken Leistung und Vielseitigkeit die Entwicklung einer Reihe multimodaler großer Modelle wie Audio, Video usw. vorangetrieben.

Die zugrunde liegende Architektur des Sprachmodells basiert größtenteils auf Transformer und hauptsächlich auf Decoder, sodass die Modellarchitektur ohne große Anpassungen an andere Sequenzmodalitäten angepasst werden kann.

Kürzlich hat Google ein einheitliches Sprachtextmodell AudioPaLM veröffentlicht, das Text- und Audio-Tokens zu einem multimodalen gemeinsamen Vokabular zusammenführt und es mit verschiedenen Aufgabenbeschreibungs-Tags kombiniert, um eine beliebige Mischung aus Sprache und Text zu erreichen. Nur Modelle für Aufgaben, einschließlich Spracherkennung (ASR), Text-zu-Sprache-Synthese, automatische Sprachübersetzung (AST) und Sprache-zu-Sprache-Übersetzung (S2ST) usw., wodurch Aufgaben, die traditionell von heterogenen Modellen gelöst werden, in einer Architektur vereint werden und Ausbildungsprozess.

Bilder

Bilder

Papierlink: https://arxiv.org/pdf/2306.12925.pdf

Beispiellink: https://google-research.github.io/seanet/audiopalm/examples /

Da die zugrunde liegende Architektur von AudioPaLM außerdem ein großes Transformer-Modell ist, das mit den Gewichten eines großen Sprachmodells initialisiert werden kann, das vorab auf Text trainiert wurde, kann es vom linguistischen Wissen von Modellen wie PaLM profitieren .

Aus der Perspektive der Implementierungsergebnisse hat AudioPaLM bei den AST- und S2ST-Benchmarks Ergebnisse auf dem neuesten Stand der Technik erzielt und seine Leistung beim ASR-Benchmark ist mit anderen Modellen vergleichbar.

Durch die Nutzung der Audio-Hinweise von AudioLM ist das AudioPaLM-Modell in der Lage, S2ST bei der Sprachmigration neuer Sprecher durchzuführen und dabei bestehende Methoden in Bezug auf Sprachqualität und Spracherhaltung zu übertreffen.

Das AudioPaLM-Modell verfügt außerdem über die Zero-Shot-Fähigkeit, AST-Aufgaben für Kombinationen aus Spracheingabe und Zielsprache auszuführen, die im Training nicht vorkommen.

AudioPaLM

Die Forscher verwenden ein reines Decoder-Transformer-Modell, um Text- und Sprachtokens zu modellieren. Der Text und das Audio wurden vor der Eingabe in das Modell segmentiert, sodass die Eingabe nur eine Folge von ganzen Zahlen ist Ausgabe Ende Führen Sie dann den detokenisierten Vorgang aus und geben Sie ihn an den Benutzer zurück.

Bilder

Bilder

Audioeinbettung und Wortsegmentierung

Der Prozess der Umwandlung der ursprünglichen Audiowellenform in Token umfasst das Extrahieren von Einbettungen aus vorhandenen Sprachdarstellungsmodellen und die Diskretisierung der Einbettungen in einen begrenzten Satz von Audio-Tokens

In früheren Arbeiten wurden die Einbettungen aus dem w2v-BERT-Modell extrahiert und mit k-means quantisiert. In diesem Artikel experimentierten die Forscher mit drei Schemata:

w2v-BERT: Verwenden Sie das w2v -Das BERT-Modell wird auf mehrsprachigen Daten statt auf reinem Englisch trainiert. Vor dem K-Means-Clustering wird keine Normalisierungsverarbeitung durchgeführt, da sonst die Leistung in der mehrsprachigen Umgebung beeinträchtigt wird. Generieren Sie dann Token mit einer Rate von 25 Hz und einer Vokabulargröße von 1024 USM-v2: Mit zusätzlichem ASR-Verlust trainiert und weiter verfeinert, um mehrere Sprachen zu unterstützen.

Ändern Sie den Nur-Text-Decoder

In der Transfomrer-Decoderstruktur ist die Anzahl der Modellierungstoken mit Ausnahme der Eingabe- und der letzten Softmax-Ausgabeschicht nicht beteiligt, und in der PaLM-Architektur ist Die Gewichtsvariablen der Eingabe- und Ausgabematrizen werden gemeinsam genutzt, das heißt, sie sind Transponierte voneinander. Sie müssen also nur die Größe der Einbettungsmatrix von (t × m) auf (t+a) ×m erweitern, um ein reines Textmodell in ein Modell umzuwandeln, das sowohl Text als auch Audio simulieren kann, wobei t ist die Größe des Textvokabulars, a ist die Größe des Audiovokabulars und m ist die Einbettungsdimension.

Um das vorab trainierte Textmodell zu nutzen, änderten die Forscher den Prüfpunkt des vorhandenen Modells, indem sie der Einbettungsmatrix neue Zeilen hinzufügten.

Die spezifische Implementierung besteht darin, dass die ersten t-Tokens den SentencePiece-Text-Tags entsprechen und die folgenden a-Tokens die Audio-Tags darstellen. Obwohl die Texteinbettung die vorab trainierten Gewichte wiederverwendet, wird die Audio-Einbettung neu initialisiert und muss es sein ausgebildet.

Experimentelle Ergebnisse zeigen, dass textbasierte Pre-Training-Modelle im Vergleich zu einem Neutraining von Grund auf sehr vorteilhaft für die Verbesserung der Leistung multimodaler Sprach- und Textaufgaben sind.

AUDIO TOKEN -Decodierung in native Audio

In -Anordnung zur Synthese von Audiowellenformen von Audio -Token, experimentierten die Forscher mit zwei verschiedenen Methoden:

1.

2. Nicht-autoregressive Dekodierung ähnlich dem SoundStorm-ModellBeide Methoden müssen zuerst das SoundStream-Token generieren und es dann mithilfe eines Faltungsdecoders in eine Audiowellenform umwandeln.

Die auf Multilingual LibriSpeech geschulten Forscher sind eine 3 Sekunden lange Sprachprobe, die gleichzeitig als Audio-Token und SoundStream-Token dargestellt wird.

Durch die Bereitstellung eines Teils der ursprünglichen Eingabesprache Als Sprachbedingung ist das Modell in der Lage zu sprechen. Wenn menschliche Sprache in verschiedene Sprachen übersetzt wird, bleibt die Sprache des ursprünglichen Sprechers erhalten. Wenn der ursprüngliche Ton kürzer als 3 Sekunden ist, wird die leere Zeit durch wiederholte Wiedergabe gefüllt.

Trainingsaufgabe

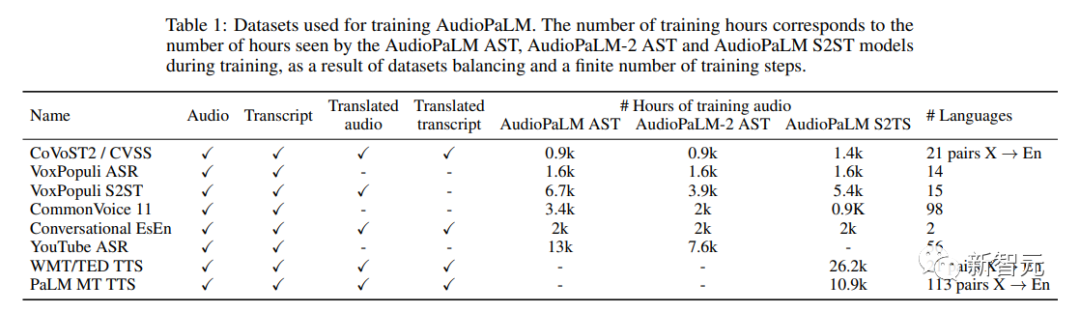

Die verwendeten Trainingsdatensätze sind alle Sprachtextdaten:1. Audio: Sprache in der Ausgangssprache (Sprache)

2. Transkription : Transkription von Sprache in Audiodaten

3. Übersetztes Audio Übersetztes Audio: Gesprochene Übersetzung von Sprache in Audio

4. Übersetztes Transkript: Schriftliche Übersetzung von Sprache in Audio

Zu den Aufgaben gehören: ... in Sprachübersetzung): Übersetzen Sie Audio, um übersetztes Audio zu erhalten

4. TTS (Text to Speech): Lesen Sie den transkribierten Inhalt vor, um Audio zu erhalten.

5. MT (Text-zu-Text-Maschinenübersetzung): Übersetzen Sie das Transkript, um das übersetzte Transkript zu erhalten.

Ein Datensatz kann für mehrere Aufgaben verwendet werden, daher entschieden sich die Forscher, dem Modell zu signalisieren, welche Aufgabe es ist Die Leistung des Modells für eine bestimmte Eingabe wird durch Hinzufügen einer Bezeichnung vor der Eingabe angegeben, die den englischen Namen der Aufgabe und die Eingabesprache angibt. Die Ausgabesprache kann ebenfalls ausgewählt werden.

Wenn Sie beispielsweise möchten, dass das Modell ASR auf dem französischen Korpus ausführt, müssen Sie nach der Wortsegmentierung die Bezeichnung [ASR Französisch] vor der Audioeingabe hinzufügen; um TTS-Aufgaben auf Englisch auszuführen, müssen Sie hinzufügen [TTS English] vor dem Text; Um die S2ST-Aufgabe vom Englischen ins Französische auszuführen, wird dem segmentierten englischen Audio [S2ST English French] vorangestellt

Training Mix

Die Forscher verwendeten Die SeqIO-Bibliothek zum Mischen der Trainingsdaten wird einer Gewichtsreduzierung unterzogen.

BilderExperimenteller Teil

BilderAudioPaLM übertrifft andere Basismodelle bei AST- und S2ST-Aufgaben. Obwohl die Leistung bei ASR nicht optimal ist, ist die Wirkung auch sehr gut.

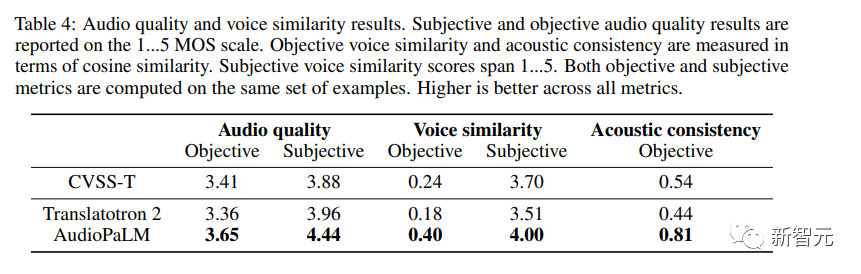

Zusätzlich zur Bewertung der Übersetzungsqualität von Sprachinhalten bewerteten die Forscher auch, ob die von AudioPaLM erzeugte Sprache von ausreichend hoher Qualität war und ob die Stimme des Sprechers bei der Übersetzung in verschiedene Sprachen erhalten blieb.

Zusätzlich zur Bewertung der Übersetzungsqualität von Sprachinhalten bewerteten die Forscher auch, ob die von AudioPaLM erzeugte Sprache von ausreichend hoher Qualität war und ob die Stimme des Sprechers bei der Übersetzung in verschiedene Sprachen erhalten blieb.

Objektive Metriken

Objektive Metriken

Die Verwendung von etwas Ähnlichem wie dem referenzfreien MOS-Schätzer liefert anhand eines Audiobeispiels eine Schätzung der wahrgenommenen Audioqualität auf einer Skala von 1 bis 5.

Um die Qualität der Sprachübertragung über Sprachen hinweg zu messen, verwendeten die Forscher handelsübliche Sprecherverifizierungsmodelle und berechneten die Kosinusähnlichkeit zwischen der Quelle (kodiert/dekodiert mit SoundStream) und den ebenfalls gemessenen Einbettungen der übersetzten Sprache die Einbettungen von akustischen Eigenschaften des Quellaudios in das Zielaudio (Aufnahmebedingungen, Hintergrundgeräusche).

Subjektive Bewertung

Die Forscher führten zwei unabhängige Studien durch, um die erzeugte Stimmqualität und Stimmähnlichkeit zu bewerten, wobei sie in beiden Studien denselben Satz von Proben verwendeten.

Aufgrund der ungleichmäßigen Qualität des Korpus kommt es bei einigen zu lauten, überlappenden Sprache (z. B. bei im Hintergrund abgespielten Fernsehsendungen oder Liedern) oder zu extrem starken Geräuschen (z. B. wenn Kleidung am Mikrofon reibt). Menschen Die Arbeit des Bewerters war kompliziert, daher entschieden sich die Forscher für eine Vorfilterung, indem sie nur Eingaben mit einer MOS-Schätzung von mindestens 3,0 auswählten.

Die Bewertungen erfolgen auf einer 5-Punkte-Skala von 1 (schlechte Qualität oder völlig anderer Klang) bis 5 (gute Qualität, gleicher Klang).

Bilder

Bilder

Aus den Ergebnissen geht hervor, dass AudioPaLM das Basissystem Translatotron 2 in Bezug auf Audioqualität und Sprachähnlichkeit sowohl bei objektiven als auch bei subjektiven Messungen deutlich übertrifft und AudioPaLM in puncto Audioqualität und Sprachähnlichkeit deutlich besser ist als das echte System Synthetische CVSS-T-Aufnahmen weisen eine höhere Qualität und eine bessere Stimmähnlichkeit auf und sind in den meisten Indikatoren deutlich verbessert.

Die Forscher verglichen auch Systeme in Gruppen mit hohen und niedrigen Ressourcen (Französisch, Deutsch, Spanisch und Katalanisch im Vergleich zu anderen Sprachen) und fanden keine signifikanten Unterschiede in den Metriken zwischen diesen Gruppen.

Das obige ist der detaillierte Inhalt vonGoogle AudioPaLM implementiert die dualmodale Lösung „Text + Audio', ein großes Modell für Sprechen und Hören. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1662

1662

14

14

1418

1418

52

52

1311

1311

25

25

1261

1261

29

29

1234

1234

24

24

Sesam Open Door Exchange Webseite Login Neueste Version Gateio Offizieller Website Eingang

Mar 04, 2025 pm 11:48 PM

Sesam Open Door Exchange Webseite Login Neueste Version Gateio Offizieller Website Eingang

Mar 04, 2025 pm 11:48 PM

Eine detaillierte Einführung in den Anmeldungsbetrieb der Sesame Open Exchange -Webversion, einschließlich Anmeldeschritte und Kennwortwiederherstellungsprozess.

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

Sesame Open Door Exchange -Webseite Registrierung Link Gate Trading App Registrierung Website Neueste

Feb 28, 2025 am 11:06 AM

In diesem Artikel wird der Registrierungsprozess der Webversion Sesam Open Exchange (GATE.IO) und die Gate Trading App im Detail vorgestellt. Unabhängig davon, ob es sich um eine Webregistrierung oder eine App -Registrierung handelt, müssen Sie die offizielle Website oder den offiziellen App Store besuchen, um die Genuine App herunterzuladen, und dann den Benutzernamen, das Kennwort, die E -Mail, die Mobiltelefonnummer und die anderen Informationen eingeben und eine E -Mail- oder Mobiltelefonüberprüfung abschließen.

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Top 10 für Crypto Digital Asset Trading App (2025 Global Ranking) empfohlen

Mar 18, 2025 pm 12:15 PM

Dieser Artikel empfiehlt die Top Ten Ten Cryptocurrency -Handelsplattformen, die es wert sind, auf Binance, OKX, Gate.io, Bitflyer, Kucoin, Bybit, Coinbase Pro, Kraken, BYDFI und Xbit -dezentrale Börsen geachtet zu werden. Diese Plattformen haben ihre eigenen Vorteile in Bezug auf Transaktionswährungsmenge, Transaktionstyp, Sicherheit, Konformität und Besonderheiten. Die Auswahl einer geeigneten Plattform erfordert eine umfassende Überlegung, die auf eigener Handelserfahrung, Risikotoleranz und Investitionspräferenzen basiert. Ich hoffe, dieser Artikel hilft Ihnen dabei, den besten Anzug für sich selbst zu finden

Tutorial zur Registrierung, Verwendung und Stornierung von Ouyi Okex -Konto

Mar 31, 2025 pm 04:21 PM

Tutorial zur Registrierung, Verwendung und Stornierung von Ouyi Okex -Konto

Mar 31, 2025 pm 04:21 PM

In diesem Artikel wird ausführlich die Registrierungs-, Nutzungs- und Stornierungsverfahren von Ouyi Okex -Konto eingeführt. Um sich zu registrieren, müssen Sie die App herunterladen, Ihre Handynummer oder E-Mail-Adresse eingeben, um sich zu registrieren, und die authentifizierte Authentifizierung abschließen. Die Verwendung deckt die Betriebsschritte wie Anmeldung, Aufladung und Rückzug, Transaktion und Sicherheitseinstellungen ab. Um ein Konto zu kündigen, müssen Sie den Kundendienst von Ouyi Okex kontaktieren, die erforderlichen Informationen bereitstellen und auf die Bearbeitung warten und schließlich die Bestätigung des Konto -Stornierens erhalten. In diesem Artikel können Benutzer das vollständige Lebenszyklusmanagement von Ouyi Okex -Konto problemlos beherrschen und digitale Asset -Transaktionen sicher und bequem durchführen.

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Sesame Open Door Trading Platform Download Mobile Version Gateio Trading Platform Download -Adresse

Feb 28, 2025 am 10:51 AM

Es ist wichtig, einen formalen Kanal auszuwählen, um die App herunterzuladen und die Sicherheit Ihres Kontos zu gewährleisten.

Registrieren Sie sich und laden Sie die neueste App auf der offiziellen Bitget -Website herunter und laden Sie sie herunter

Mar 05, 2025 am 07:54 AM

Registrieren Sie sich und laden Sie die neueste App auf der offiziellen Bitget -Website herunter und laden Sie sie herunter

Mar 05, 2025 am 07:54 AM

Dieser Leitfaden enthält detaillierte Download- und Installationsschritte für die offizielle Bitget Exchange -App, die für Android- und iOS -Systeme geeignet ist. Der Leitfaden integriert Informationen aus mehreren maßgeblichen Quellen, einschließlich der offiziellen Website, dem App Store und Google Play, und betont Überlegungen während des Downloads und des Kontoverwaltung. Benutzer können die App aus offiziellen Kanälen herunterladen, einschließlich App Store, offizieller Website APK Download und offizieller Website -Sprung sowie vollständige Registrierung, Identitätsüberprüfung und Sicherheitseinstellungen. Darüber hinaus deckt der Handbuch häufig gestellte Fragen und Überlegungen ab, wie z.

Warum wird Bittensor als 'Bitcoin' in der KI -Strecke gesagt?

Mar 04, 2025 pm 04:06 PM

Warum wird Bittensor als 'Bitcoin' in der KI -Strecke gesagt?

Mar 04, 2025 pm 04:06 PM

Original -Titel: Bittensor = Aibitcoin? Bittensor nimmt ein Subnetzmodell an, das die Entstehung verschiedener KI -Lösungen ermöglicht und Innovation durch Tao -Token inspiriert. Obwohl der KI -Markt ausgereift ist, steht Bittensor mit wettbewerbsfähigen Risiken aus und kann anderen Open Source unterliegen

Detailliertes Tutorial zur Registrierung für Binance (2025 Anfängerhandbuch)

Mar 18, 2025 pm 01:57 PM

Detailliertes Tutorial zur Registrierung für Binance (2025 Anfängerhandbuch)

Mar 18, 2025 pm 01:57 PM

Dieser Artikel enthält einen vollständigen Leitfaden für Binance-Registrierungs- und Sicherheitseinstellungen, die Vorbereitungen vor der Registrierung (einschließlich Ausrüstung, E-Mail, Mobiltelefonnummer und Identitätsdokumentenvorbereitung) abdecken und zwei Registrierungsmethoden auf der offiziellen Website und der App sowie auf verschiedenen Ebenen der Identitätsprüfungsstufen (KYC) einführen. Darüber hinaus konzentriert sich der Artikel auch auf wichtige Sicherheitsschritte wie das Einrichten eines Fondskennworts, die Aktivierung von Zwei-Faktor-Überprüfung (2FA, einschließlich Google Authenticator- und SMS-Überprüfung) und das Einrichten von Anti-Phishing-Codes, die Registrierung und Verwendung der Binance-Binance-Plattform für Kryptowährungstransaktionen sicher und bequem. Bitte verstehen Sie unbedingt relevante Gesetze und Vorschriften und Marktrisiken, bevor Sie mit Vorsicht handeln und investieren.