Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Der Server ist überfüllt, das große Rechtsmodell ChatLaw der Peking-Universität ist beliebt: Erzählen Sie direkt, wie Zhang San verurteilt wurde

Der Server ist überfüllt, das große Rechtsmodell ChatLaw der Peking-Universität ist beliebt: Erzählen Sie direkt, wie Zhang San verurteilt wurde

Der Server ist überfüllt, das große Rechtsmodell ChatLaw der Peking-Universität ist beliebt: Erzählen Sie direkt, wie Zhang San verurteilt wurde

Das große Modell ist wieder „explodiert“.

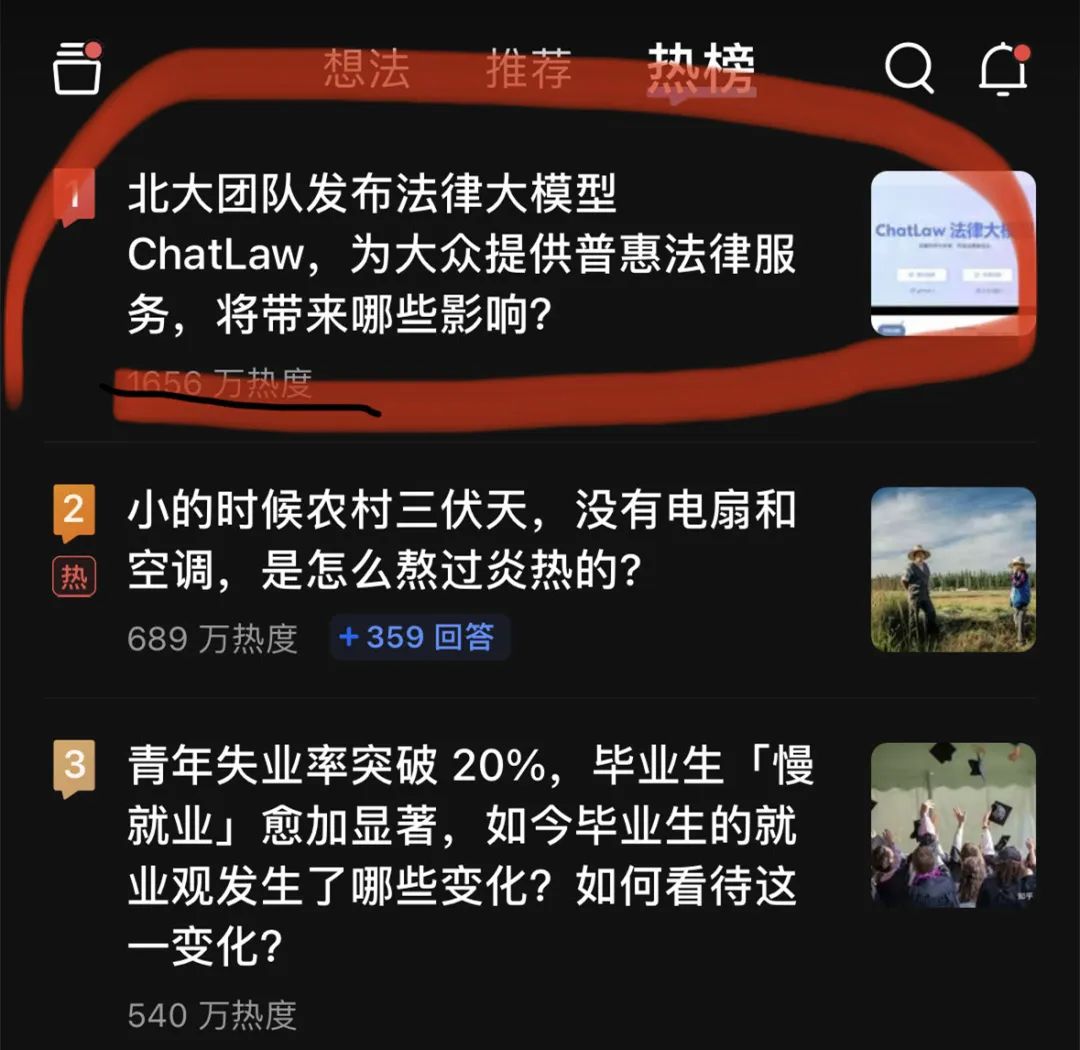

Gestern Abend stand ein großes Anwaltsmodell, ChatLaw, ganz oben auf der Zhihu-Hot-Search-Liste. Auf dem Höhepunkt erreichte die Popularität rund 20 Millionen.

Dieser ChatLaw wird vom Team der Peking-Universität veröffentlicht und setzt sich für die Bereitstellung inklusiver Rechtsdienstleistungen ein. Einerseits herrscht derzeit im ganzen Land ein Mangel an praktizierenden Anwälten, und das Angebot ist weitaus geringer als die gesetzliche Nachfrage. Andererseits haben die einfachen Menschen eine natürliche Lücke in den Rechtskenntnissen und -versorgungen und können diese nicht nutzen legale Waffen, um sich zu schützen.

Der jüngste Aufstieg großer Sprachmodelle bietet für normale Menschen eine hervorragende Gelegenheit, sich auf konversationelle Weise zu rechtlichen Fragen zu beraten.

Derzeit gibt es drei Versionen von ChatLaw:

- ChatLaw-13B, eine akademische Demoversion, die auf Jiang Ziya Ziya-LLaMA-13B-v1 basiert funktioniert sehr gut auf Chinesisch. Logisch komplexe juristische Fragen und Antworten sind jedoch nicht effektiv und müssen mit einem Modell mit größeren Parametern gelöst werden.

- ChatLaw-33B, ebenfalls eine akademische Demoversion, basiert auf Anima-33B und seiner Fähigkeit zum logischen Denken ist stark verbessert. Da Anima jedoch zu wenig chinesischen Korpus hat, erscheinen bei Fragen und Antworten häufig englische Daten Die Angaben entsprechen den entsprechenden gesetzlichen Bestimmungen.

- Laut der offiziellen Demonstration unterstützt ChatLaw Benutzer beim Hochladen von Dokumenten, Aufzeichnungen und anderen rechtlichen Materialien und hilft ihnen beim Zusammenfassen und Analysieren sowie beim Erstellen visueller Karten, Diagramme usw. Darüber hinaus kann ChatLaw faktenbasierte Rechtsberatung und Rechtsdokumente generieren. Das Projekt hat 1,1.000 Sterne auf GitHub.

Bilder

Offizielle Website-Adresse: https://www.chatlaw.cloud/

Offizielle Website-Adresse: https://www.chatlaw.cloud/

Papieradresse: https://arxiv.org/pdf/2306.16092.pdf

Das ist Link zum GitHub-Projekt von uns: https://github.com/PKU-YuanGroup/ChatLaw

Aufgrund der Beliebtheit des ChatLaw-Projekts ist der Server derzeit vorübergehend abgestürzt und die Rechenleistung hat die Obergrenze erreicht. Das Team arbeitet an einer Lösung und interessierte Leser können das Beta-Modell auf GitHub bereitstellen.

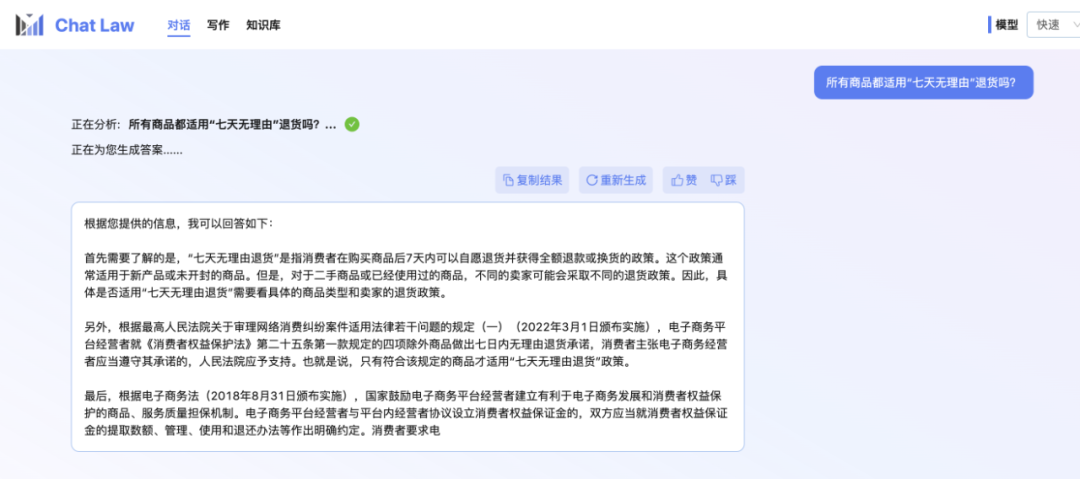

Der Redakteur selbst steht immer noch in der Warteschlange für den geschlossenen Betatest. Hier ist also ein offizielles Gesprächsbeispiel des ChatLaw-Teams über das Problem der „siebentägigen Rückgabe ohne Angabe von Gründen“, das beim Online-Einkauf auftreten kann. Ich muss sagen, dass die Antworten von ChatLaw recht umfassend sind.

Bilder

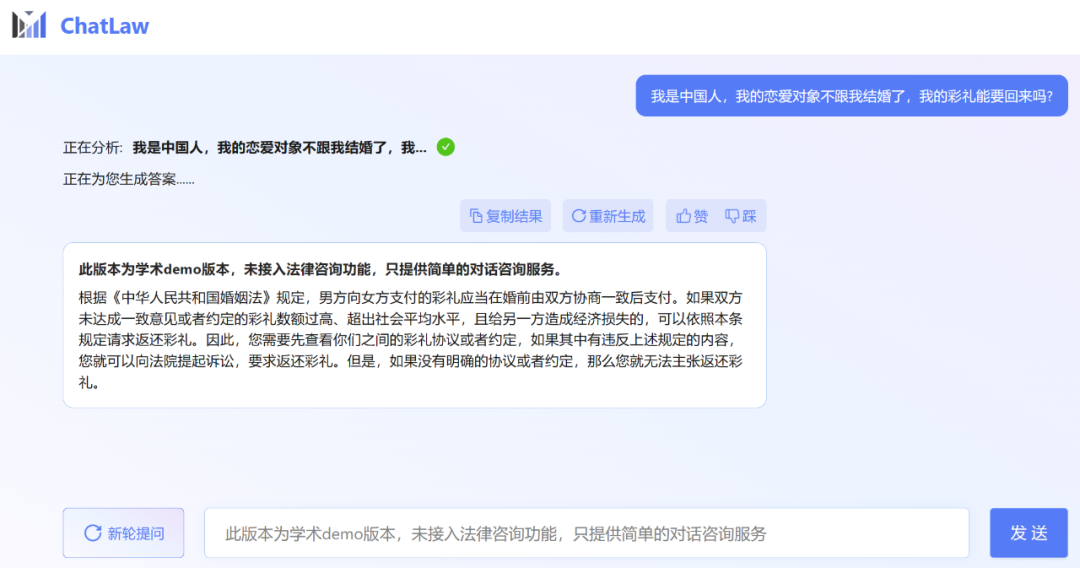

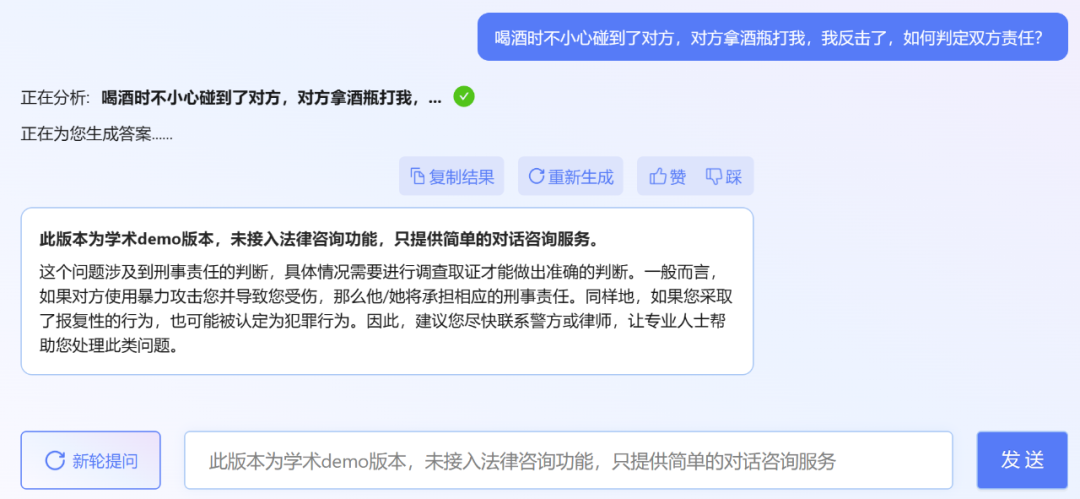

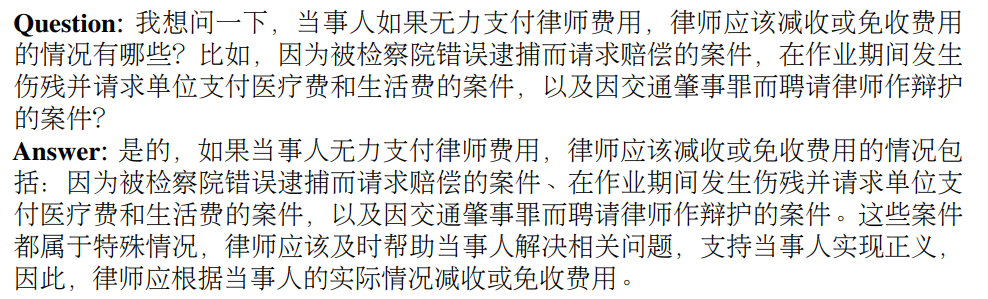

Der Herausgeber stellte jedoch fest, dass die akademische Demoversion von ChatLaw leider keinen Zugriff auf die Rechtsberatungsfunktion hat und nur einfache Dialogberatungsdienste bietet. Hier sind ein paar Fragen zum Ausprobieren.

Der Herausgeber stellte jedoch fest, dass die akademische Demoversion von ChatLaw leider keinen Zugriff auf die Rechtsberatungsfunktion hat und nur einfache Dialogberatungsdienste bietet. Hier sind ein paar Fragen zum Ausprobieren.

Bilder

Tatsächlich ist die Peking-Universität nicht die einzige, die in letzter Zeit große Rechtsmodelle veröffentlicht hat. Ende letzten Monats veröffentlichten Power Law Intelligence und Zhipu AI das rechtliche vertikale Modell PowerLawGLM auf 100-Milliarden-Parameterebene. Es wird berichtet, dass das Modell einzigartige Vorteile in seiner Anwendungswirkung in chinesischen Rechtsszenarien gezeigt hat.

ChatLaws Datenquelle und Trainingsrahmen

Das erste ist die Datenzusammensetzung

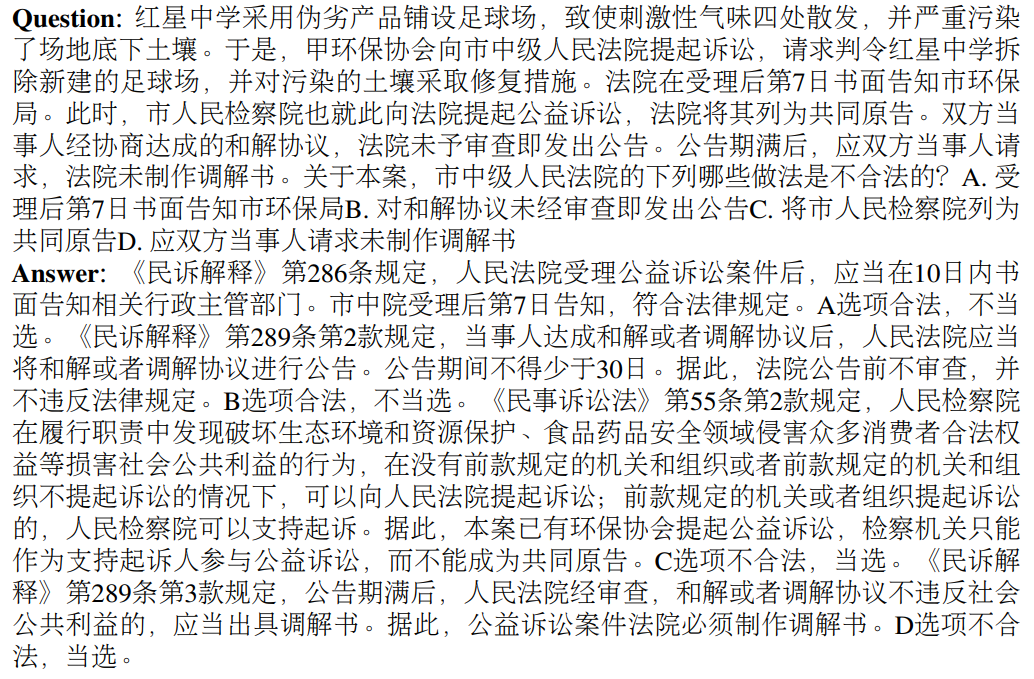

. ChatLaw-Daten bestehen hauptsächlich aus Foren, Nachrichten, gesetzlichen Bestimmungen, gerichtlichen Auslegungen, Rechtsberatungen, rechtlichen Prüfungsfragen und Urteilsdokumenten. Sie werden dann zur Erstellung von Dialogdaten durch Bereinigung, Datenverbesserung usw. verwendet. Gleichzeitig kann das ChatLaw-Team durch die Zusammenarbeit mit der Peking University School of International Law und namhaften Anwaltskanzleien der Branche sicherstellen, dass die Wissensdatenbank zeitnah aktualisiert werden kann und gleichzeitig die Professionalität und Zuverlässigkeit der Daten gewährleistet ist. Schauen wir uns unten konkrete Beispiele an.Konstruktionsbeispiele basierend auf Gesetzen, Vorschriften und richterlichen Auslegungen:

Beispiel für die Erfassung echter Rechtsberatungsdaten:

Beispiel für die Erstellung von Multiple-Choice-Fragen für die Anwaltsprüfung:

Bilder

Bilder

Dann gibt es noch die Modellebene. Um ChatLAW zu trainieren, hat das Forschungsteam es mithilfe der Low-Rank Adaptation (LoRA) basierend auf Ziya-LLaMA-13B verfeinert. Darüber hinaus stellt diese Studie auch die Rolle der Selbstsuggestion vor, um das Problem der Modellhalluzinationen zu lindern. Der Trainingsprozess wird auf mehreren A100-GPUs durchgeführt, wobei Deepspeed die Trainingskosten weiter senkt.

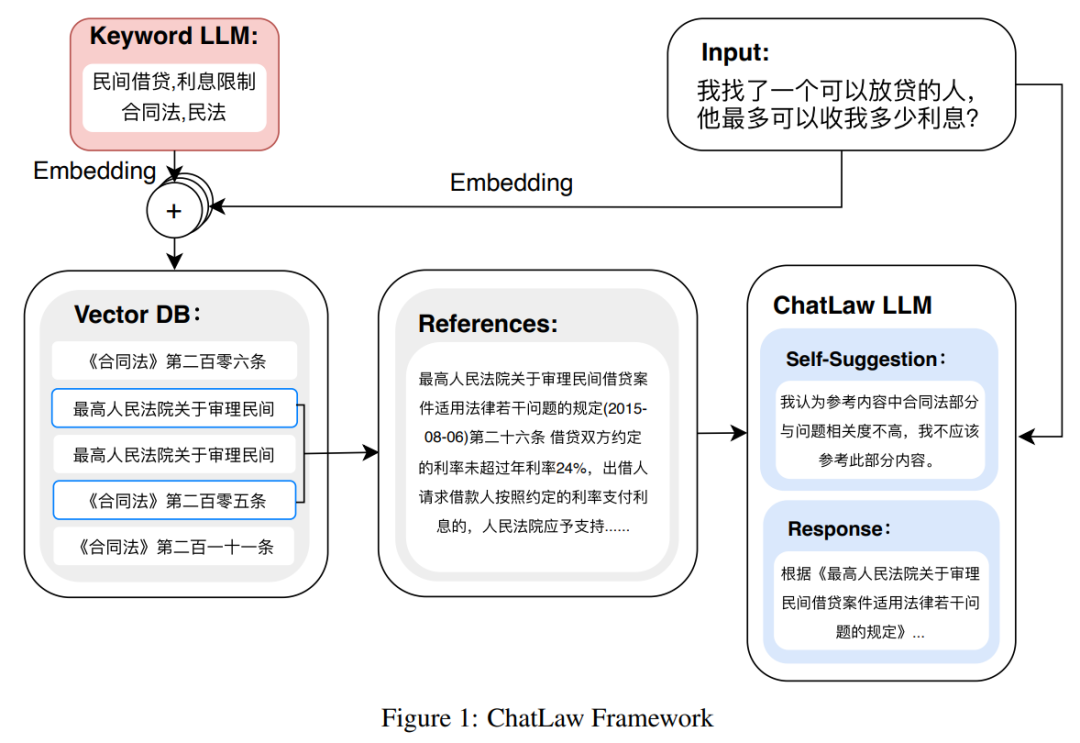

Die folgende Abbildung ist das Architekturdiagramm von ChatLAW. Diese Forschung fügt rechtliche Daten in das Modell ein und führt eine spezielle Verarbeitung und Erweiterung dieses Wissens durch. Gleichzeitig werden während der Argumentation mehrere Module eingeführt, um allgemeines Modell und Fachwissen zu kombinieren Modell integriert in die Wissensdatenbank.

Diese Studie hat das Modell auch während der Inferenz eingeschränkt, um sicherzustellen, dass das Modell korrekte Gesetze und Vorschriften generiert und Modellillusionen so weit wie möglich reduziert wird.

Bilder

Bilder

Zunächst probierte das Forschungsteam traditionelle Softwareentwicklungsmethoden aus, beispielsweise die Verwendung von MySQL und Elasticsearch zum Abrufen, aber die Ergebnisse waren unbefriedigend. Daher begann diese Forschung mit dem Versuch, das BERT-Modell vorab für die Einbettung zu trainieren und dann Methoden wie Faiss zu verwenden, um die Kosinusähnlichkeit zu berechnen und die wichtigsten k Gesetze und Vorschriften im Zusammenhang mit der Benutzerabfrage zu extrahieren.

Dieser Ansatz führt oft zu suboptimalen Ergebnissen, wenn das Problem des Benutzers vage ist. Daher extrahieren Forscher wichtige Informationen aus Benutzeranfragen und entwerfen Algorithmen mithilfe der Vektoreinbettung dieser Informationen, um die Übereinstimmungsgenauigkeit zu verbessern.

Da große Modelle erhebliche Vorteile beim Verständnis von Benutzeranfragen haben, wurde in dieser Studie LLM verfeinert, um Schlüsselwörter aus Benutzeranfragen zu extrahieren. Nach Erhalt mehrerer Schlüsselwörter verwendete die Studie Algorithmus 1, um relevante gesetzliche Bestimmungen abzurufen.

Bilder

Bilder

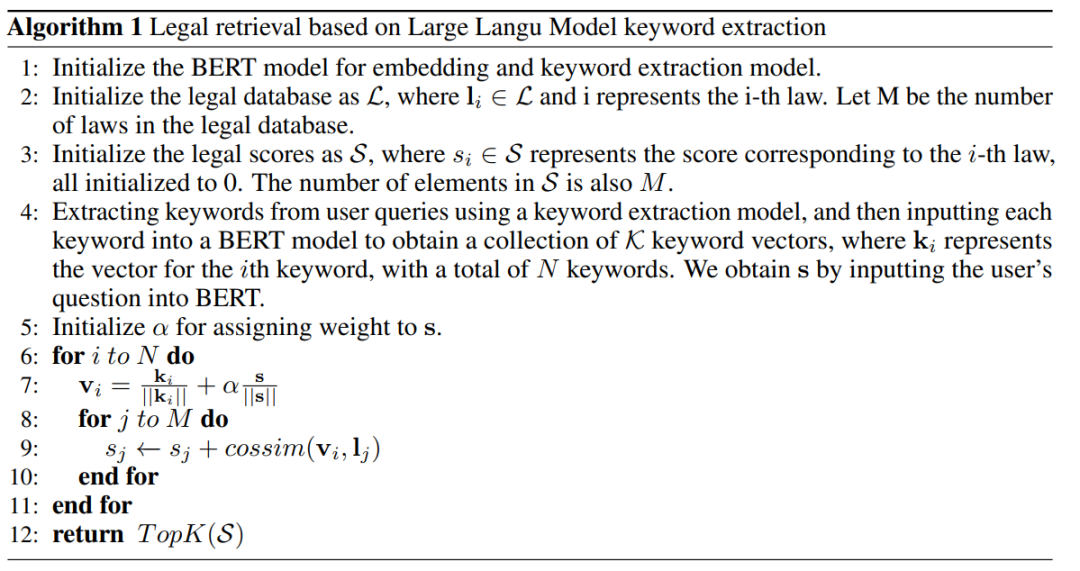

Experimentelle Ergebnisse

Diese Studie sammelte mehr als zehn Jahre lang nationale richterliche Prüfungsfragen und stellte einen Testdatensatz mit 2000 Fragen und ihren Standardantworten zusammen, um die Fähigkeit des Modells, mit Multiple-Choice umzugehen, zu messen rechtliche Fragen.

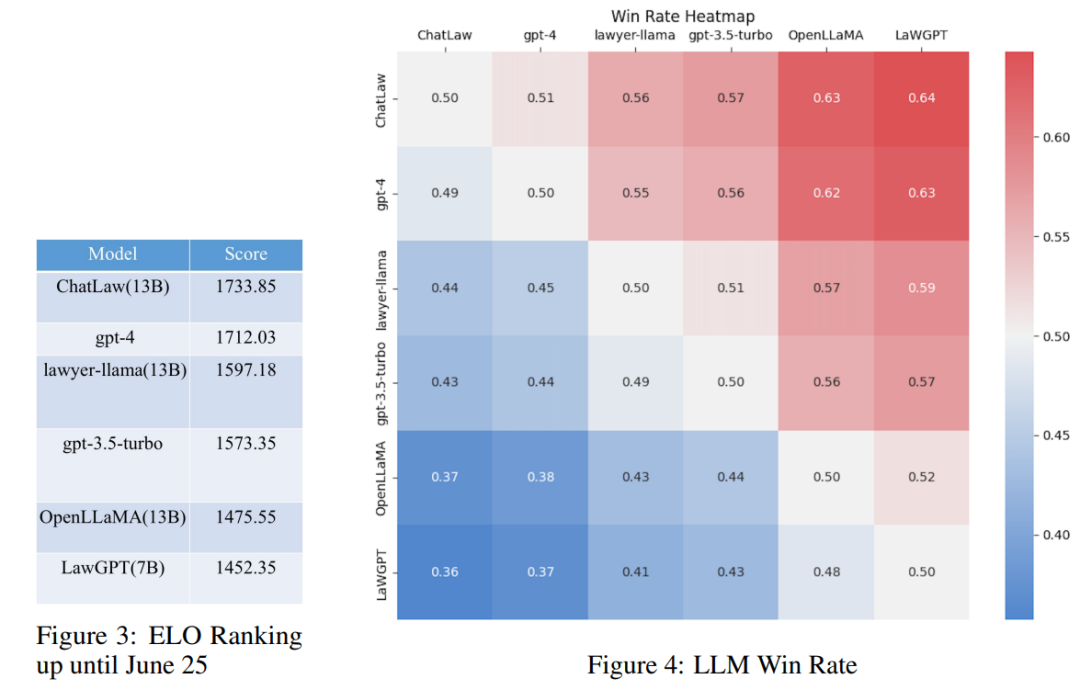

Untersuchungen haben jedoch ergeben, dass die Genauigkeit jedes Modells im Allgemeinen gering ist. In diesem Fall sagt der Vergleich der Genauigkeit allein nicht viel aus. Daher stützt sich diese Studie auf den ELO-Matching-Mechanismus von League of Legends und erstellt einen Modell-gegen-ELO-Mechanismus, um die Fähigkeit jedes Modells, rechtliche Multiple-Choice-Fragen zu bearbeiten, effektiver zu bewerten. Im Folgenden sind die ELO-Ergebnisse bzw. Gewinnratendiagramme aufgeführt:

Bilder

Bilder

Durch die Analyse der oben genannten experimentellen Ergebnisse können wir die folgenden Beobachtungen ziehen

(1) Einführung in rechtliche Fragen und Antworten und Regulierungsbestimmungen Die Daten können die Leistung des Modells bei Multiple-Choice-Fragen bis zu einem gewissen Grad verbessern. Der Grund, warum das ChatLaw-Modell beispielsweise besser ist als GPT-4, liegt darin, dass der Artikel eine große Anzahl von Multiple-Choice-Fragen als Trainingsdaten verwendet Modelle mit größeren Parametern schneiden normalerweise besser ab.

Referenz-Zhihu-Link:

https://www.zhihu.com/question/610072848

Andere Referenzlinks:

https://mp.weixin.qq.com/ s /bXAFALFY6GQkL30j1sYCEQ

Das obige ist der detaillierte Inhalt vonDer Server ist überfüllt, das große Rechtsmodell ChatLaw der Peking-Universität ist beliebt: Erzählen Sie direkt, wie Zhang San verurteilt wurde. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1376

1376

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

FisheyeDetNet: der erste Zielerkennungsalgorithmus basierend auf einer Fischaugenkamera

Apr 26, 2024 am 11:37 AM

Die Zielerkennung ist ein relativ ausgereiftes Problem in autonomen Fahrsystemen, wobei die Fußgängererkennung einer der ersten Algorithmen ist, die eingesetzt werden. In den meisten Arbeiten wurde eine sehr umfassende Recherche durchgeführt. Die Entfernungswahrnehmung mithilfe von Fischaugenkameras für die Rundumsicht ist jedoch relativ wenig untersucht. Aufgrund der großen radialen Verzerrung ist es schwierig, die standardmäßige Bounding-Box-Darstellung in Fischaugenkameras zu implementieren. Um die obige Beschreibung zu vereinfachen, untersuchen wir erweiterte Begrenzungsrahmen-, Ellipsen- und allgemeine Polygondesigns in Polar-/Winkeldarstellungen und definieren eine mIOU-Metrik für die Instanzsegmentierung, um diese Darstellungen zu analysieren. Das vorgeschlagene Modell „fisheyeDetNet“ mit polygonaler Form übertrifft andere Modelle und erreicht gleichzeitig 49,5 % mAP auf dem Valeo-Fisheye-Kameradatensatz für autonomes Fahren

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

Mit einer einzelnen Karte läuft Llama 70B schneller als mit zwei Karten, Microsoft hat gerade FP6 in A100 integriert |

Apr 29, 2024 pm 04:55 PM

FP8 und die geringere Gleitkomma-Quantifizierungsgenauigkeit sind nicht länger das „Patent“ von H100! Lao Huang wollte, dass jeder INT8/INT4 nutzt, und das Microsoft DeepSpeed-Team begann, FP6 auf A100 ohne offizielle Unterstützung von NVIDIA auszuführen. Testergebnisse zeigen, dass die FP6-Quantisierung der neuen Methode TC-FPx auf A100 nahe an INT4 liegt oder gelegentlich schneller als diese ist und eine höhere Genauigkeit aufweist als letztere. Darüber hinaus gibt es eine durchgängige Unterstützung großer Modelle, die als Open-Source-Lösung bereitgestellt und in Deep-Learning-Inferenz-Frameworks wie DeepSpeed integriert wurde. Dieses Ergebnis wirkt sich auch unmittelbar auf die Beschleunigung großer Modelle aus – in diesem Rahmen ist der Durchsatz bei Verwendung einer einzelnen Karte zum Ausführen von Llama 2,65-mal höher als der von Doppelkarten. eins