Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

OpenAI hat die APIs GPT-3.5 Turbo, DALL-E und Whisper vollständig geöffnet

OpenAI hat die APIs GPT-3.5 Turbo, DALL-E und Whisper vollständig geöffnet

OpenAI hat die APIs GPT-3.5 Turbo, DALL-E und Whisper vollständig geöffnet

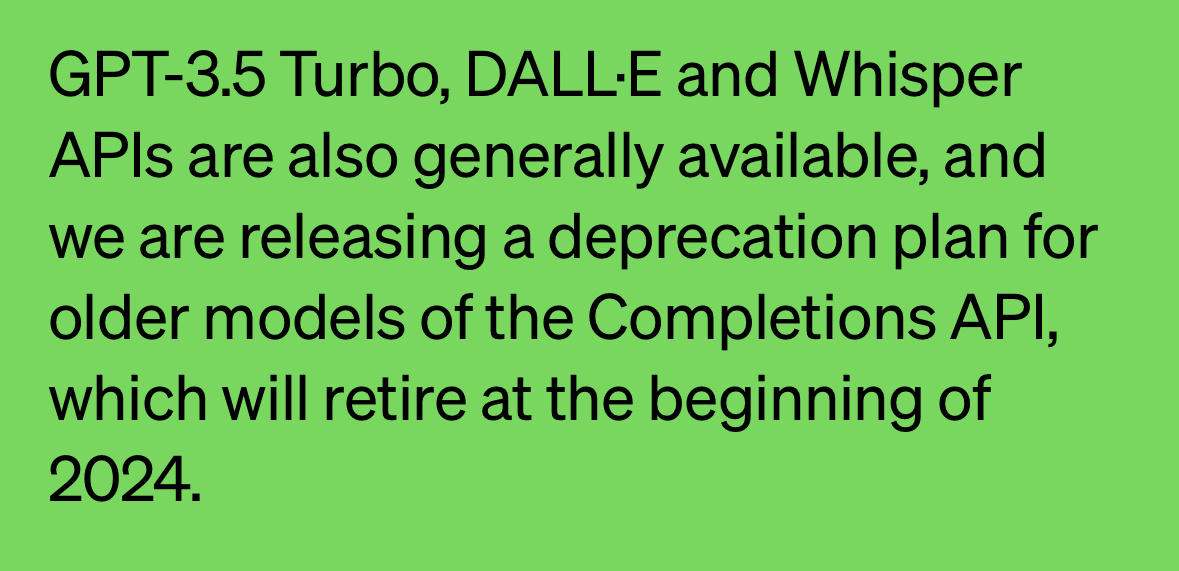

Nachrichten vom 10. Juli: OpenAI gab gestern die vollständige Öffnung der GPT-3.5 Turbo-, DALL-E- und Whisper-APIs bekannt, um Entwickler bei der Verbesserung der Modellverarbeitungseffizienz zu unterstützen. Darüber hinaus gab OpenAI auch an, dass es GPT-4 und entwickelt GPT-3.5 Nachfolgefunktionen für Turbo, deren Einführung noch in diesem Jahr geplant ist.

OpenAI hat bekannt gegeben, dass alle aktuellen, von APIs aufgerufenen KI-Modelle standardmäßig auf GPT-4 aktualisiert wurden und bestehende Benutzer es ohne Wechsel verwenden können.

Hinweis: Whisper API ist ein Sprache-zu-Text-KI-Modell, das die Stimme, das Video und andere Medien des Benutzers erkennen und in Text umwandeln kann.

▲ Bildquelle Offizielle OpenAI-Website

OpenAI gab an, die Chat Completions API ständig zu verbessern, mit dem Hauptziel, die Recheneffizienz zu verbessern. Sie planen, das veraltete Modell der Completions API im Januar 2024, also sechs Monate später, einzustellen.

Hinweis: Completions API ist eine API zur Verarbeitung natürlicher Sprache, die für verschiedene Textgenerierungsaufgaben verwendet werden kann, z. B. zum Generieren von Zusammenfassungen, Übersetzen von Sprachen, Generieren von Artikeln, Self-Service-Fragen und Antworten usw.

OpenAI behauptet, dass Entwickler derzeit noch die Completions-API aufrufen können, aber ab heute wird OpenAI „alte Versionen von Completions“ in Entwicklerdateien als „alte APIs“ markieren. OpenAI wird seine Ressourcen in Zukunft auf die Chat Completions API konzentrieren und keine Modelle mehr verfügbar machen, die die Completions API verwenden.

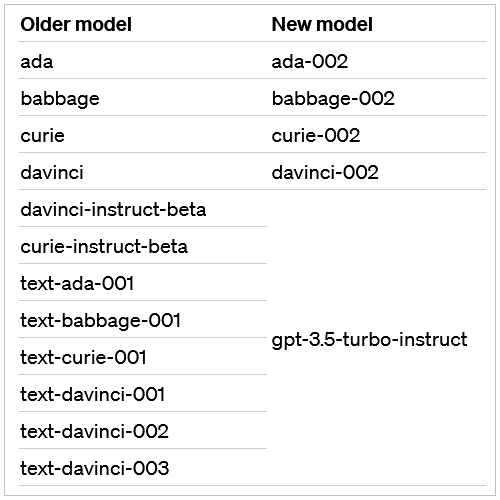

IT House erfuhr nach Anfragen, dass OpenAI mitgeteilt hat, dass das alte Modell voraussichtlich bis zum 4. Januar 2024 eingestellt wird und auch die Edits API Anfang Januar nächsten Jahres für Benutzer der Edits API und damit verbundener Unternehmen deaktiviert wird Modelle müssen vom alten Modell wechseln ( text-davinci-edit-001 oder code-davinci-edit-001) Gehen Sie zu GPT-3.5 Turbo, OpenAI listet auch die Vergleichstabelle des alten und neuen Modells auf.

▲ Bildquelle OpenAI

Das obige ist der detaillierte Inhalt vonOpenAI hat die APIs GPT-3.5 Turbo, DALL-E und Whisper vollständig geöffnet. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

Video Face Swap

Tauschen Sie Gesichter in jedem Video mühelos mit unserem völlig kostenlosen KI-Gesichtstausch-Tool aus!

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1677

1677

14

14

1431

1431

52

52

1334

1334

25

25

1280

1280

29

29

1257

1257

24

24

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Ein neues Programmierparadigma, wenn Spring Boot auf OpenAI trifft

Feb 01, 2024 pm 09:18 PM

Im Jahr 2023 ist die KI-Technologie zu einem heißen Thema geworden und hat enorme Auswirkungen auf verschiedene Branchen, insbesondere im Programmierbereich. Die Bedeutung der KI-Technologie wird den Menschen zunehmend bewusst, und die Spring-Community bildet da keine Ausnahme. Mit der kontinuierlichen Weiterentwicklung der GenAI-Technologie (General Artificial Intelligence) ist es entscheidend und dringend geworden, die Erstellung von Anwendungen mit KI-Funktionen zu vereinfachen. Vor diesem Hintergrund entstand „SpringAI“ mit dem Ziel, den Prozess der Entwicklung von KI-Funktionsanwendungen zu vereinfachen, ihn einfach und intuitiv zu gestalten und unnötige Komplexität zu vermeiden. Durch „SpringAI“ können Entwickler einfacher Anwendungen mit KI-Funktionen erstellen, wodurch diese einfacher zu verwenden und zu bedienen sind.

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

Wählen Sie das Einbettungsmodell, das am besten zu Ihren Daten passt: Ein Vergleichstest von OpenAI und mehrsprachigen Open-Source-Einbettungen

Feb 26, 2024 pm 06:10 PM

OpenAI kündigte kürzlich die Einführung seines Einbettungsmodells embeddingv3 der neuesten Generation an, das seiner Meinung nach das leistungsstärkste Einbettungsmodell mit höherer Mehrsprachenleistung ist. Diese Reihe von Modellen ist in zwei Typen unterteilt: das kleinere Text-Embeddings-3-Small und das leistungsfähigere und größere Text-Embeddings-3-Large. Es werden nur wenige Informationen darüber offengelegt, wie diese Modelle entworfen und trainiert werden, und auf die Modelle kann nur über kostenpflichtige APIs zugegriffen werden. Es gab also viele Open-Source-Einbettungsmodelle. Aber wie schneiden diese Open-Source-Modelle im Vergleich zum Closed-Source-Modell von OpenAI ab? In diesem Artikel wird die Leistung dieser neuen Modelle empirisch mit Open-Source-Modellen verglichen. Wir planen, Daten zu erstellen

CMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet

Dec 21, 2023 am 08:13 AM

CMU führte eine detaillierte Vergleichsstudie durch und stellte fest, dass GPT-3.5 Gemini Pro überlegen ist und eine faire, transparente und reproduzierbare Leistung gewährleistet

Dec 21, 2023 am 08:13 AM

Was ist die Stärke von Google Gemini? Die Carnegie Mellon University führte einen professionellen und objektiven Vergleich durch Dritte durch. Um Fairness zu gewährleisten, verwenden alle Modelle dieselben Eingabeaufforderungen und Generierungsparameter und liefern reproduzierbaren Code und vollständig transparente Ergebnisse. CoT@32 wird nicht zum Vergleich von 5-Shots wie bei der offiziellen Pressekonferenz von Google verwendet. Ergebnisse in einem Satz: Die GeminiPro-Version ist GPT-3.5Turbo nahe, aber leicht unterlegen, und GPT-4 liegt immer noch weit vorne. Während der eingehenden Analyse haben wir auch einige seltsame Eigenschaften von Gemini entdeckt, wie z. B. die Wahl von D für Multiple-Choice-Fragen ... Viele Forscher sagten, dass Gemini nur wenige Tage nach seiner Veröffentlichung sehr detailliert getestet wurde, was großartig ist Leistung. Eingehende Prüfung von sechs Hauptaufgaben. Dieser Test ist spezifischer als

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Der Rust-basierte Zed-Editor ist Open Source und bietet integrierte Unterstützung für OpenAI und GitHub Copilot

Feb 01, 2024 pm 02:51 PM

Autor丨Zusammengestellt von TimAnderson丨Produziert von Noah|51CTO Technology Stack (WeChat-ID: blog51cto) Das Zed-Editor-Projekt befindet sich noch in der Vorabversionsphase und wurde unter AGPL-, GPL- und Apache-Lizenzen als Open Source bereitgestellt. Der Editor zeichnet sich durch hohe Leistung und mehrere KI-gestützte Optionen aus, ist jedoch derzeit nur auf der Mac-Plattform verfügbar. Nathan Sobo erklärte in einem Beitrag, dass in der Codebasis des Zed-Projekts auf GitHub der Editor-Teil unter der GPL lizenziert ist, die serverseitigen Komponenten unter der AGPL lizenziert sind und der GPUI-Teil (GPU Accelerated User) die Schnittstelle übernimmt Apache2.0-Lizenz. GPUI ist ein vom Zed-Team entwickeltes Produkt

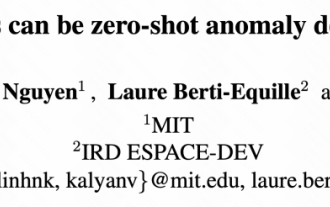

Das neueste Meisterwerk des MIT: Verwendung von GPT-3.5 zur Lösung des Problems der Erkennung von Zeitreihenanomalien

Jun 08, 2024 pm 06:09 PM

Das neueste Meisterwerk des MIT: Verwendung von GPT-3.5 zur Lösung des Problems der Erkennung von Zeitreihenanomalien

Jun 08, 2024 pm 06:09 PM

Heute möchte ich Ihnen einen letzte Woche vom MIT veröffentlichten Artikel vorstellen, in dem GPT-3.5-turbo verwendet wird, um das Problem der Erkennung von Zeitreihenanomalien zu lösen, und zunächst die Wirksamkeit von LLM bei der Erkennung von Zeitreihenanomalien überprüft wird. Im gesamten Prozess gibt es keine Feinabstimmung, und GPT-3.5-Turbo wird direkt zur Anomalieerkennung verwendet. Der Kern dieses Artikels besteht darin, wie man Zeitreihen in Eingaben umwandelt, die von GPT-3.5-Turbo erkannt werden können, und wie man sie entwirft Eingabeaufforderungen oder Pipelines, damit LLM die Anomalieerkennungsaufgabe lösen kann. Lassen Sie mich Ihnen diese Arbeit im Detail vorstellen. Titel des Bildpapiers: Largelingualmodelscanbezero-shotanomalydete

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Posthume Arbeit des OpenAI Super Alignment Teams: Zwei große Modelle spielen ein Spiel und die Ausgabe wird verständlicher

Jul 19, 2024 am 01:29 AM

Wenn die Antwort des KI-Modells überhaupt unverständlich ist, würden Sie es wagen, sie zu verwenden? Da maschinelle Lernsysteme in immer wichtigeren Bereichen eingesetzt werden, wird es immer wichtiger zu zeigen, warum wir ihren Ergebnissen vertrauen können und wann wir ihnen nicht vertrauen sollten. Eine Möglichkeit, Vertrauen in die Ausgabe eines komplexen Systems zu gewinnen, besteht darin, vom System zu verlangen, dass es eine Interpretation seiner Ausgabe erstellt, die für einen Menschen oder ein anderes vertrauenswürdiges System lesbar ist, d. h. so vollständig verständlich, dass mögliche Fehler erkannt werden können gefunden. Um beispielsweise Vertrauen in das Justizsystem aufzubauen, verlangen wir von den Gerichten, dass sie klare und lesbare schriftliche Stellungnahmen abgeben, die ihre Entscheidungen erläutern und stützen. Für große Sprachmodelle können wir auch einen ähnlichen Ansatz verfolgen. Stellen Sie bei diesem Ansatz jedoch sicher, dass das Sprachmodell generiert wird

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Die lokale Ausführungsleistung des Embedding-Dienstes übertrifft die von OpenAI Text-Embedding-Ada-002, was sehr praktisch ist!

Apr 15, 2024 am 09:01 AM

Ollama ist ein superpraktisches Tool, mit dem Sie Open-Source-Modelle wie Llama2, Mistral und Gemma problemlos lokal ausführen können. In diesem Artikel werde ich vorstellen, wie man Ollama zum Vektorisieren von Text verwendet. Wenn Sie Ollama nicht lokal installiert haben, können Sie diesen Artikel lesen. In diesem Artikel verwenden wir das Modell nomic-embed-text[2]. Es handelt sich um einen Text-Encoder, der OpenAI text-embedding-ada-002 und text-embedding-3-small bei kurzen und langen Kontextaufgaben übertrifft. Starten Sie den nomic-embed-text-Dienst, wenn Sie o erfolgreich installiert haben

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Warten Sie nicht auf OpenAI, sondern darauf, dass Open-Sora vollständig Open Source ist

Mar 18, 2024 pm 08:40 PM

Vor nicht allzu langer Zeit wurde OpenAISora mit seinen erstaunlichen Videogenerierungseffekten schnell populär und stach aus der Masse der literarischen Videomodelle hervor und rückte in den Mittelpunkt der weltweiten Aufmerksamkeit. Nach der Einführung des Sora-Trainings-Inferenzreproduktionsprozesses mit einer Kostenreduzierung von 46 % vor zwei Wochen hat das Colossal-AI-Team das weltweit erste Sora-ähnliche Architektur-Videogenerierungsmodell „Open-Sora1.0“ vollständig als Open-Source-Lösung bereitgestellt, das das gesamte Spektrum abdeckt Lernen Sie den Trainingsprozess, einschließlich der Datenverarbeitung, aller Trainingsdetails und Modellgewichte, kennen und schließen Sie sich mit globalen KI-Enthusiasten zusammen, um eine neue Ära der Videoerstellung voranzutreiben. Schauen wir uns für einen kleinen Vorgeschmack ein Video einer geschäftigen Stadt an, das mit dem vom Colossal-AI-Team veröffentlichten Modell „Open-Sora1.0“ erstellt wurde. Open-Sora1.0