Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Das Byte-Team schlug das Lynx-Modell vor: multimodale LLMs, die kognitive Generierungslisten-SoTA verstehen

Das Byte-Team schlug das Lynx-Modell vor: multimodale LLMs, die kognitive Generierungslisten-SoTA verstehen

Das Byte-Team schlug das Lynx-Modell vor: multimodale LLMs, die kognitive Generierungslisten-SoTA verstehen

Aktuelle Large Language Models (LLMs) wie GPT4 haben hervorragende multimodale Fähigkeiten bei der Befolgung offener Anweisungen bei gegebenem Bild gezeigt. Allerdings hängt die Leistung dieser Modelle stark von der Wahl der Netzwerkstruktur, der Trainingsdaten und der Trainingsstrategien ab, diese Wahl wurde jedoch in der bisherigen Literatur nicht ausführlich diskutiert. Darüber hinaus mangelt es derzeit an geeigneten Benchmarks zur Bewertung und zum Vergleich dieser Modelle, was die Entwicklung multimodaler LLMs einschränkt.

Bilder

Bilder

- Papier: https://arxiv.org/abs/2307.02469

- Website: https://lynx-llm.github.io/

- Code: https: //github.com/bytedance/lynx-llm

In diesem Artikel führt der Autor eine systematische und umfassende Studie zum Training solcher Modelle unter quantitativen und qualitativen Aspekten durch. Für die Netzwerkstruktur wurden mehr als 20 Varianten erstellt, verschiedene LLM-Backbones und Modelldesigns wurden für die Trainingsdaten verglichen, die Auswirkungen von Daten und Stichprobenstrategien wurden im Hinblick auf Anweisungen untersucht; Die Fähigkeit, Anweisungen zu folgen, wurde untersucht. Für Benchmarks schlägt der Artikel erstmals Open-VQA vor, ein offenes visuelles Frage-Antwort-Bewertungsset einschließlich Bild- und Videoaufgaben.

Basierend auf den experimentellen Schlussfolgerungen schlug der Autor Lynx vor, das im Vergleich zum bestehenden Open-Source-Modell im GPT4-Stil das genaueste multimodale Verständnis zeigt und gleichzeitig die beste Multimodalität beibehält.

Bewertungsschema

Anders als bei typischen visuellen Sprachaufgaben besteht die größte Herausforderung bei der Bewertung von Modellen im GPT4-Stil darin, die Leistung von Textgenerierungsfunktionen und multimodaler Verständnisgenauigkeit in Einklang zu bringen. Um dieses Problem zu lösen, schlagen die Autoren einen neuen Benchmark Open-VQA einschließlich Video- und Bilddaten vor und führen eine umfassende Bewertung aktueller Open-Source-Modelle durch.

Konkret werden zwei quantitative Bewertungsschemata übernommen:

- Sammeln Sie den Open Visual Question Answering (Open-VQA)-Testsatz, der Informationen zu Objekten, OCR, Zählen, Argumentation, Aktionserkennung und zeitlicher Reihenfolge enthält . und andere verschiedene Kategorien von Fragen. Im Gegensatz zum VQA-Datensatz, der Standardantworten enthält, sind die Antworten von Open-VQA offenes Ergebnis. Um die Leistung bei Open-VQA zu bewerten, wird GPT4 als Diskriminator verwendet und die Ergebnisse stimmen zu 95 % mit der menschlichen Bewertung überein.

- Darüber hinaus verwendete der Autor den von mPLUG-owl [1] bereitgestellten OwlEval-Datensatz, um die Textgenerierungsfähigkeit des Modells zu bewerten. Obwohl er nur 50 Bilder und 82 Fragen enthält, deckt er die Generierung von Geschichten und Werbung ab. Codegenerierung usw. Verschiedene Fragen und Rekrutierung menschlicher Kommentatoren, um die Leistung verschiedener Modelle zu bewerten.

Fazit

Um die Trainingsstrategie multimodaler LLMs eingehend zu untersuchen, untersucht der Autor hauptsächlich die Netzwerkstruktur (Präfix-Feinabstimmung/Queraufmerksamkeit) und Trainingsdaten (Datenauswahl und -kombination). Verhältnis), Anweisungen (Einzelanweisung/Mehr als zwanzig Varianten wurden in verschiedenen Aspekten wie Diversifikationsanzeige festgelegt), LLMs-Modell (LLaMA [5]/Vicuna [6]), Bildpixel (420/224) usw. und die Folgende Hauptschlussfolgerungen wurden durch Experimente gezogen:

- Multimodale LLMs haben eine schlechtere Fähigkeit, Anweisungen zu befolgen als LLMs. Zum Beispiel tendiert InstructBLIP [2] dazu, unabhängig von Eingabeanweisungen kurze Antworten zu generieren, während andere Modelle dazu neigen, unabhängig von Anweisungen lange Sätze zu generieren, was nach Ansicht der Autoren auf das Fehlen hochwertiger und vielfältiger Multi- Modalität, die durch Befehlsdaten verursacht wird.

- Die Qualität der Trainingsdaten ist entscheidend für die Leistung des Modells. Basierend auf den Ergebnissen von Experimenten mit verschiedenen Daten wurde festgestellt, dass die Verwendung einer kleinen Menge hochwertiger Daten eine bessere Leistung erbringt als die Verwendung großer, verrauschter Daten. Der Autor glaubt, dass dies der Unterschied zwischen generativem Training und kontrastivem Training ist, da generatives Training direkt die bedingte Verteilung von Wörtern lernt und nicht die Ähnlichkeit zwischen Text und Bildern. Für eine bessere Modellleistung müssen daher zwei Dinge in Bezug auf die Daten erfüllt sein: 1) hochwertiger, glatter Text enthalten; 2) Text- und Bildinhalte sind gut aufeinander abgestimmt.

- Quests und Eingabeaufforderungen sind entscheidend für die Zero-Shot-Fähigkeit. Durch die Verwendung verschiedener Aufgaben und Anweisungen kann die Fähigkeit des Modells zur Erzeugung von Nullschüssen bei unbekannten Aufgaben verbessert werden, was mit Beobachtungen in Klartextmodellen übereinstimmt.

- Es ist wichtig, Korrektheit und Sprachgenerierungsfähigkeiten in Einklang zu bringen. Wenn das Modell bei nachgelagerten Aufgaben (z. B. VQA) untertrainiert ist, ist es wahrscheinlicher, dass es fabrizierte Inhalte generiert, die nicht mit der visuellen Eingabe übereinstimmen, und wenn das Modell bei nachgelagerten Aufgaben übertrainiert ist, generiert es tendenziell kurze Antworten und wird nicht in der Lage sein, Benutzeranweisungen zu befolgen, die zu längeren Antworten führen.

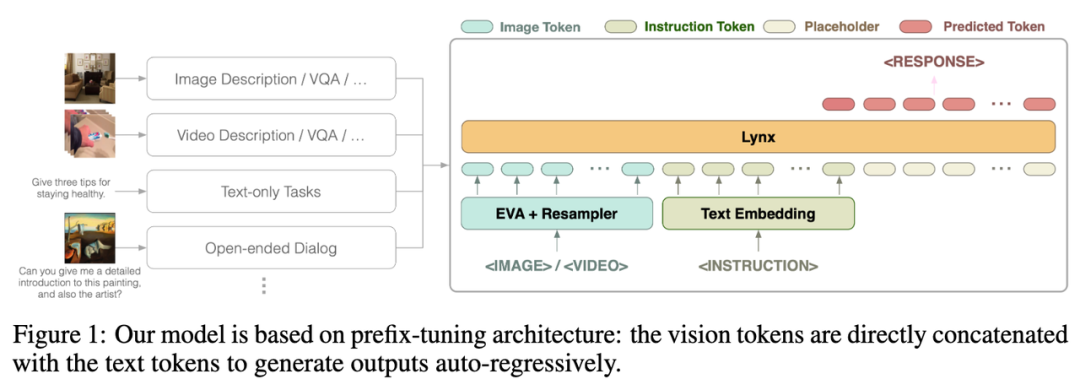

- Präfix-Finetuning (PT) ist derzeit die beste Lösung für die multimodale Anpassung von LLMs. In Experimenten kann das Modell mit Präfix-Feinabstimmungsstruktur die Fähigkeit verbessern, verschiedenen Anweisungen schneller zu folgen und ist einfacher zu trainieren als die Modellstruktur mit Kreuzaufmerksamkeit (CA). (Präfix-Tuning und Queraufmerksamkeit sind zwei Modellstrukturen, Einzelheiten finden Sie im Einführungsabschnitt zum Lynx-Modell.) -Style-Modell mit Präfix-Feinabstimmung. In der ersten Phase werden etwa 120 Millionen Bild-Text-Paare verwendet, um visuelle und sprachliche Einbettungen auszurichten. In der zweiten Phase werden 20 Bilder oder Videos für multimodale Aufgaben und Daten zur Verarbeitung natürlicher Sprache (NLP) verwendet, um die Modelle anzupassen Befehlsfolgefähigkeiten.

Bilder

Die Gesamtstruktur des Lynx-Modells ist in Abbildung 1 oben dargestellt.

Die visuelle Eingabe wird vom visuellen Encoder verarbeitet, um visuelle Token (Token) $$W_v$$ zu erhalten. Nach der Zuordnung wird sie mit den Befehls-Tokens $$W_l$$ als Eingabe von LLMs gespleißt Die Struktur wird in diesem Artikel als „Präfix-Feinabstimmung“ bezeichnet, um sie von der von Flamingo verwendeten Struktur „Queraufmerksamkeit“ zu unterscheiden [3]. Darüber hinaus stellten die Autoren fest, dass die Schulungskosten durch das Hinzufügen von

Darüber hinaus stellten die Autoren fest, dass die Schulungskosten durch das Hinzufügen von

nach bestimmten Schichten eingefrorener LLMs weiter gesenkt werden können.

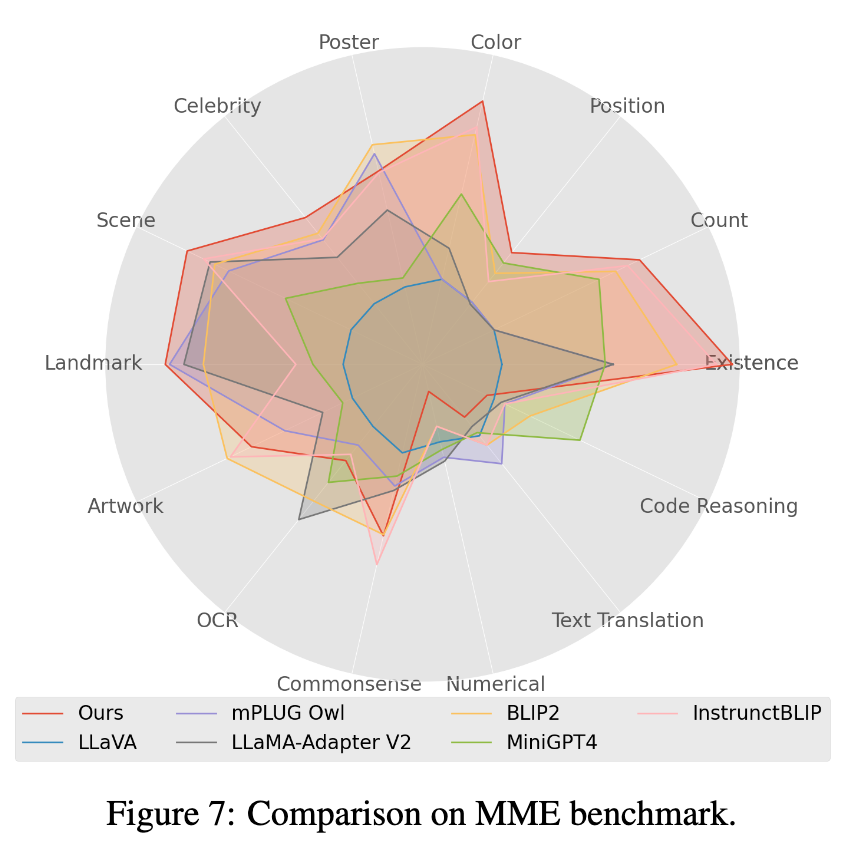

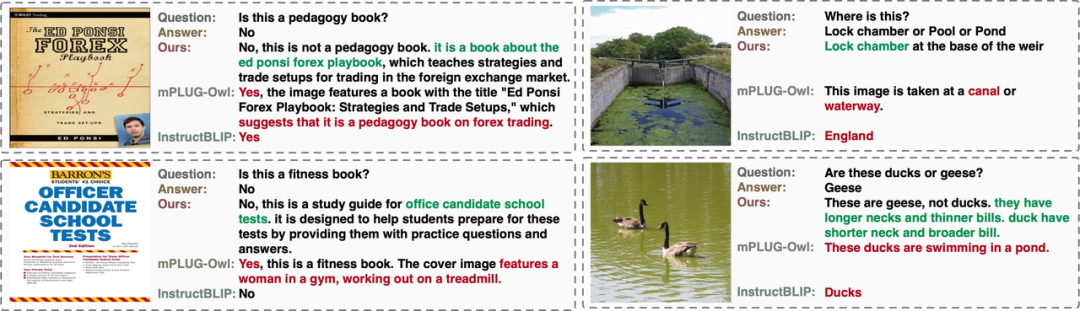

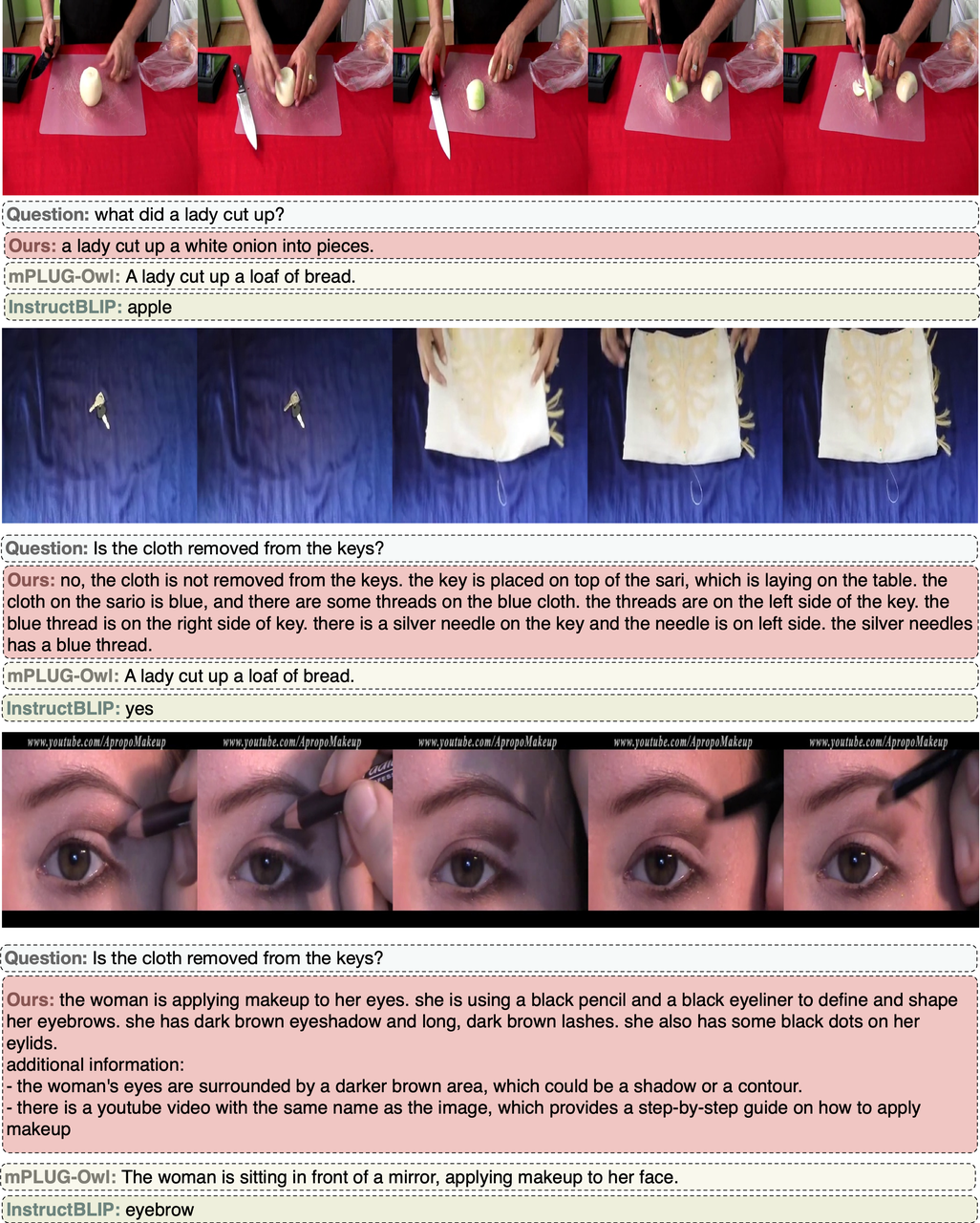

ModelleffektDer Autor bewertete die Leistung vorhandener multimodaler Open-Source-LLM-Modelle anhand der manuellen Bewertung von Open-VQA, Mme [4] und OwlEval (die Ergebnisse finden Sie in der Tabelle unten und siehe das Bewertungsdetailpapier). Es ist ersichtlich, dass das Lynx-Modell die beste Leistung bei Open-VQA-Bild- und Videoverständnisaufgaben, der manuellen OwlEval-Bewertung und Mme-Wahrnehmungsaufgaben erzielt hat. Unter diesen erreicht InstructBLIP bei den meisten Aufgaben ebenfalls eine hohe Leistung, aber seine Antwort ist zu kurz. Im Vergleich dazu liefert das Lynx-Modell in den meisten Fällen prägnante Gründe, die Antwort auf der Grundlage der richtigen Antwort zu unterstützen. freundlich (siehe Abschnitt „Fälle anzeigen“ weiter unten für einige Fälle).

1. Die Indikatorergebnisse des Open-VQA-Bildtestsatzes sind in Tabelle 1 unten aufgeführt:

Bilder

2 Die Indikatorergebnisse des Open-VQA-Videotestsatzes sind wie folgt in Tabelle 1 unten 2 dargestellt. Bilder

3. Wählen Sie das Modell mit der höchsten Punktzahl in Open-VQA aus, um eine manuelle Effektbewertung für den OwlEval-Bewertungssatz durchzuführen. Die Ergebnisse sind in Abbildung 4 oben dargestellt. Aus den Ergebnissen der manuellen Bewertung geht hervor, dass das Lynx-Modell die beste Leistung bei der Sprachgenerierung aufweist.

Bilder

Bilder

4. Im Mme-Benchmarktest erzielten Wahrnehmungsklassenaufgaben die beste Leistung, wobei 7 der 14 Klassenunteraufgaben am besten abschnitten. (Detaillierte Ergebnisse finden Sie im Anhang des Papiers)

Fälle mit offenen VQA-Bildern

OwlEval.-Fälle

Open-VQA-Videofall

Zusammenfassung

In diesem Artikel ermittelt der Autor durch Experimente an mehr als zwanzig Varianten multimodaler LLMs das Lynx-Modell mit Präfix-Feinabstimmung als Hauptstruktur und gibt einen Open-VQA-Bewertungsplan mit an offene Antworten. Experimentelle Ergebnisse zeigen, dass das Lynx-Modell die genaueste multimodale Verständnisgenauigkeit bietet und gleichzeitig die besten multimodalen Generierungsfähigkeiten beibehält.

Das obige ist der detaillierte Inhalt vonDas Byte-Team schlug das Lynx-Modell vor: multimodale LLMs, die kognitive Generierungslisten-SoTA verstehen. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1369

1369

52

52

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Das weltweit leistungsstärkste Open-Source-MoE-Modell ist da, mit chinesischen Fähigkeiten, die mit GPT-4 vergleichbar sind, und der Preis beträgt nur fast ein Prozent von GPT-4-Turbo

May 07, 2024 pm 04:13 PM

Stellen Sie sich ein Modell der künstlichen Intelligenz vor, das nicht nur die Fähigkeit besitzt, die traditionelle Datenverarbeitung zu übertreffen, sondern auch eine effizientere Leistung zu geringeren Kosten erzielt. Dies ist keine Science-Fiction, DeepSeek-V2[1], das weltweit leistungsstärkste Open-Source-MoE-Modell, ist da. DeepSeek-V2 ist ein leistungsstarkes MoE-Sprachmodell (Mix of Experts) mit den Merkmalen eines wirtschaftlichen Trainings und einer effizienten Inferenz. Es besteht aus 236B Parametern, von denen 21B zur Aktivierung jedes Markers verwendet werden. Im Vergleich zu DeepSeek67B bietet DeepSeek-V2 eine stärkere Leistung, spart gleichzeitig 42,5 % der Trainingskosten, reduziert den KV-Cache um 93,3 % und erhöht den maximalen Generierungsdurchsatz auf das 5,76-fache. DeepSeek ist ein Unternehmen, das sich mit allgemeiner künstlicher Intelligenz beschäftigt

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

KAN, das MLP ersetzt, wurde durch Open-Source-Projekte auf Faltung erweitert

Jun 01, 2024 pm 10:03 PM

Anfang dieses Monats schlugen Forscher des MIT und anderer Institutionen eine vielversprechende Alternative zu MLP vor – KAN. KAN übertrifft MLP in Bezug auf Genauigkeit und Interpretierbarkeit. Und es kann MLP, das mit einer größeren Anzahl von Parametern ausgeführt wird, mit einer sehr kleinen Anzahl von Parametern übertreffen. Beispielsweise gaben die Autoren an, dass sie KAN nutzten, um die Ergebnisse von DeepMind mit einem kleineren Netzwerk und einem höheren Automatisierungsgrad zu reproduzieren. Konkret verfügt DeepMinds MLP über etwa 300.000 Parameter, während KAN nur etwa 200 Parameter hat. KAN hat eine starke mathematische Grundlage wie MLP und basiert auf dem universellen Approximationssatz, während KAN auf dem Kolmogorov-Arnold-Darstellungssatz basiert. Wie in der folgenden Abbildung gezeigt, hat KAN

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Hallo, elektrischer Atlas! Der Boston Dynamics-Roboter erwacht wieder zum Leben, seltsame 180-Grad-Bewegungen machen Musk Angst

Apr 18, 2024 pm 07:58 PM

Boston Dynamics Atlas tritt offiziell in die Ära der Elektroroboter ein! Gestern hat sich der hydraulische Atlas einfach „unter Tränen“ von der Bühne der Geschichte zurückgezogen. Heute gab Boston Dynamics bekannt, dass der elektrische Atlas im Einsatz ist. Es scheint, dass Boston Dynamics im Bereich kommerzieller humanoider Roboter entschlossen ist, mit Tesla zu konkurrieren. Nach der Veröffentlichung des neuen Videos wurde es innerhalb von nur zehn Stunden bereits von mehr als einer Million Menschen angesehen. Die alten Leute gehen und neue Rollen entstehen. Das ist eine historische Notwendigkeit. Es besteht kein Zweifel, dass dieses Jahr das explosive Jahr der humanoiden Roboter ist. Netizens kommentierten: Die Weiterentwicklung der Roboter hat dazu geführt, dass die diesjährige Eröffnungsfeier wie Menschen aussieht, und der Freiheitsgrad ist weitaus größer als der von Menschen. Aber ist das wirklich kein Horrorfilm? Zu Beginn des Videos liegt Atlas ruhig auf dem Boden, scheinbar auf dem Rücken. Was folgt, ist atemberaubend

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI untergräbt die mathematische Forschung! Der Gewinner der Fields-Medaille und der chinesisch-amerikanische Mathematiker führten 11 hochrangige Arbeiten an | Gefällt mir bei Terence Tao

Apr 09, 2024 am 11:52 AM

KI verändert tatsächlich die Mathematik. Vor kurzem hat Tao Zhexuan, der diesem Thema große Aufmerksamkeit gewidmet hat, die neueste Ausgabe des „Bulletin of the American Mathematical Society“ (Bulletin der American Mathematical Society) weitergeleitet. Zum Thema „Werden Maschinen die Mathematik verändern?“ äußerten viele Mathematiker ihre Meinung. Der gesamte Prozess war voller Funken, knallhart und aufregend. Der Autor verfügt über eine starke Besetzung, darunter der Fields-Medaillengewinner Akshay Venkatesh, der chinesische Mathematiker Zheng Lejun, der NYU-Informatiker Ernest Davis und viele andere bekannte Wissenschaftler der Branche. Die Welt der KI hat sich dramatisch verändert. Viele dieser Artikel wurden vor einem Jahr eingereicht.

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Google ist begeistert: JAX-Leistung übertrifft Pytorch und TensorFlow! Es könnte die schnellste Wahl für das GPU-Inferenztraining werden

Apr 01, 2024 pm 07:46 PM

Die von Google geförderte Leistung von JAX hat in jüngsten Benchmark-Tests die von Pytorch und TensorFlow übertroffen und belegt bei 7 Indikatoren den ersten Platz. Und der Test wurde nicht auf der TPU mit der besten JAX-Leistung durchgeführt. Obwohl unter Entwicklern Pytorch immer noch beliebter ist als Tensorflow. Aber in Zukunft werden möglicherweise mehr große Modelle auf Basis der JAX-Plattform trainiert und ausgeführt. Modelle Kürzlich hat das Keras-Team drei Backends (TensorFlow, JAX, PyTorch) mit der nativen PyTorch-Implementierung und Keras2 mit TensorFlow verglichen. Zunächst wählen sie eine Reihe von Mainstream-Inhalten aus

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Empfohlen: Ausgezeichnetes JS-Open-Source-Projekt zur Gesichtserkennung und -erkennung

Apr 03, 2024 am 11:55 AM

Die Technologie zur Gesichtserkennung und -erkennung ist bereits eine relativ ausgereifte und weit verbreitete Technologie. Derzeit ist JS die am weitesten verbreitete Internetanwendungssprache. Die Implementierung der Gesichtserkennung und -erkennung im Web-Frontend hat im Vergleich zur Back-End-Gesichtserkennung Vor- und Nachteile. Zu den Vorteilen gehören die Reduzierung der Netzwerkinteraktion und die Echtzeiterkennung, was die Wartezeit des Benutzers erheblich verkürzt und das Benutzererlebnis verbessert. Die Nachteile sind: Es ist durch die Größe des Modells begrenzt und auch die Genauigkeit ist begrenzt. Wie implementiert man mit js die Gesichtserkennung im Web? Um die Gesichtserkennung im Web zu implementieren, müssen Sie mit verwandten Programmiersprachen und -technologien wie JavaScript, HTML, CSS, WebRTC usw. vertraut sein. Gleichzeitig müssen Sie auch relevante Technologien für Computer Vision und künstliche Intelligenz beherrschen. Dies ist aufgrund des Designs der Webseite erwähnenswert

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Das multimodale Dokumentenverständnis-Großmodell Alibaba 7B gewinnt neue SOTA

Apr 02, 2024 am 11:31 AM

Neues SOTA für multimodale Dokumentverständnisfunktionen! Das Alibaba mPLUG-Team hat die neueste Open-Source-Arbeit mPLUG-DocOwl1.5 veröffentlicht, die eine Reihe von Lösungen zur Bewältigung der vier großen Herausforderungen der hochauflösenden Bildtexterkennung, des allgemeinen Verständnisses der Dokumentstruktur, der Befolgung von Anweisungen und der Einführung externen Wissens vorschlägt. Schauen wir uns ohne weitere Umschweife zunächst die Auswirkungen an. Ein-Klick-Erkennung und Konvertierung von Diagrammen mit komplexen Strukturen in das Markdown-Format: Es stehen Diagramme verschiedener Stile zur Verfügung: Auch eine detailliertere Texterkennung und -positionierung ist einfach zu handhaben: Auch ausführliche Erläuterungen zum Dokumentverständnis können gegeben werden: Sie wissen schon, „Document Understanding“. " ist derzeit ein wichtiges Szenario für die Implementierung großer Sprachmodelle. Es gibt viele Produkte auf dem Markt, die das Lesen von Dokumenten unterstützen. Einige von ihnen verwenden hauptsächlich OCR-Systeme zur Texterkennung und arbeiten mit LLM zur Textverarbeitung zusammen.

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Tesla-Roboter arbeiten in Fabriken, Musk: Der Freiheitsgrad der Hände wird dieses Jahr 22 erreichen!

May 06, 2024 pm 04:13 PM

Das neueste Video von Teslas Roboter Optimus ist veröffentlicht und er kann bereits in der Fabrik arbeiten. Bei normaler Geschwindigkeit sortiert es Batterien (Teslas 4680-Batterien) so: Der Beamte hat auch veröffentlicht, wie es bei 20-facher Geschwindigkeit aussieht – auf einer kleinen „Workstation“, pflücken und pflücken und pflücken: Dieses Mal wird es freigegeben. Eines der Highlights Der Vorteil des Videos besteht darin, dass Optimus diese Arbeit in der Fabrik völlig autonom und ohne menschliches Eingreifen während des gesamten Prozesses erledigt. Und aus Sicht von Optimus kann es auch die krumme Batterie aufnehmen und platzieren, wobei der Schwerpunkt auf der automatischen Fehlerkorrektur liegt: In Bezug auf die Hand von Optimus gab der NVIDIA-Wissenschaftler Jim Fan eine hohe Bewertung ab: Die Hand von Optimus ist der fünffingrige Roboter der Welt am geschicktesten. Seine Hände sind nicht nur taktil