Technologie-Peripheriegeräte

Technologie-Peripheriegeräte

KI

KI

Verschiedene Arten der VCT-Anleitung, alle mit einem Bild, sodass Sie sie einfach implementieren können

Verschiedene Arten der VCT-Anleitung, alle mit einem Bild, sodass Sie sie einfach implementieren können

Verschiedene Arten der VCT-Anleitung, alle mit einem Bild, sodass Sie sie einfach implementieren können

In den letzten Jahren hat die Bilderzeugungstechnologie viele wichtige Durchbrüche erzielt. Insbesondere seit der Veröffentlichung großer Modelle wie DALLE2 und Stable Diffusion ist die Technologie zur Textgenerierung von Bildern allmählich ausgereift, und die Generierung hochwertiger Bilder bietet breite praktische Szenarien. Die detaillierte Bearbeitung vorhandener Bilder ist jedoch immer noch ein schwieriges Problem

Einerseits kann das vorhandene hochwertige Textbildmodell aufgrund der Einschränkungen der Textbeschreibung nur Text verwenden, um Bilder beschreibend und für bestimmte Zwecke zu bearbeiten Effekte, Text ist schwer zu beschreiben; andererseits verfügen Bildverfeinerungsbearbeitungsaufgaben oft nur über eine kleine Anzahl von Referenzbildern, Dadurch sind viele Lösungen, die für das Training eine große Datenmenge erfordern, klein Datenmengen, insbesondere wenn nur ein Referenzbild vorhanden ist, sind schwierig zu verarbeiten.

Kürzlich haben Forscher vom NetEase Interactive Entertainment AI Lab eine Bild-zu-Bild-Bearbeitungslösung vorgeschlagen, die auf der Einzelbildführung basiert. Bei einem einzelnen Referenzbild können die Objekte oder Stile im Referenzbild ohne Änderung in das Quellbild migriert werden die Gesamtstruktur des Quellbildes.Das Forschungspapier wurde vom ICCV 2023 angenommen und der entsprechende Code ist Open Source.

- Paper Adresse: https://arxiv.org/abs/2307.14352

- code Adresse: https://github.com/crystalneuro/visual-concept-translator

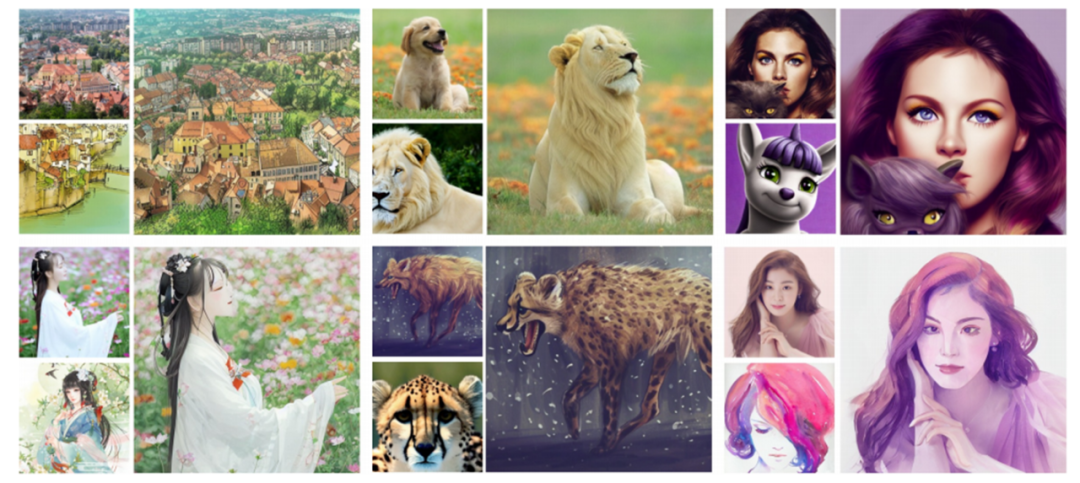

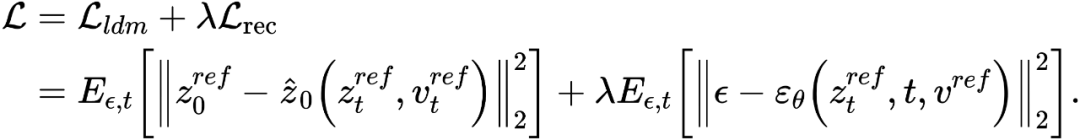

- Werfen wir zunächst einen Blick auf eine Reihe von Bildern, um die Wirkung zu spüren.

Thesis-Renderings: Die obere linke Ecke jedes Bildsatzes ist das Quellbild, die untere linke Ecke ist das Referenzbild und die rechte Seite ist das generierte Ergebnisbild

Thesis-Renderings: Die obere linke Ecke jedes Bildsatzes ist das Quellbild, die untere linke Ecke ist das Referenzbild und die rechte Seite ist das generierte Ergebnisbild

Hauptrahmen

Der Autor des Artikels schlug ein Bildbearbeitungs-Framework vor, das auf

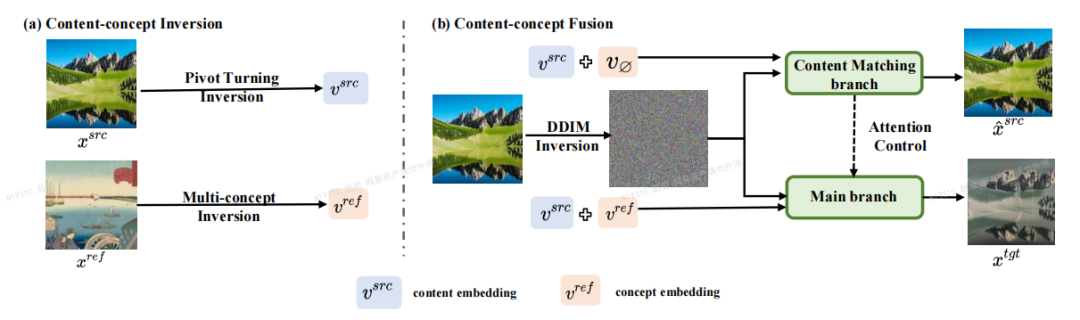

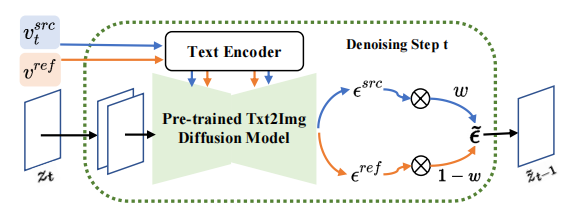

Inversion-Fusion – VCT (visueller Konzeptübersetzer, visueller Konzeptkonverter) basiert.Wie in der folgenden Abbildung dargestellt, umfasst das Gesamtgerüst von VCT zwei Prozesse: den Inhalt-Konzept-Inversionsprozess (Content-Konzept-Inversion) und den Inhalt-Konzept-Fusionsprozess (Inhalt-Konzept-Fusion). Der Inhaltskonzept-Inversionsprozess verwendet zwei verschiedene Inversionsalgorithmen, um die latenten Vektoren der Strukturinformationen des Originalbilds bzw. die semantischen Informationen des Referenzbilds zu lernen und darzustellen. Der Inhaltskonzept-Fusionsprozess verwendet die latenten Vektoren der Strukturinformationen und semantische Informationen Fusion, um das Endergebnis zu generieren.

Der Inhalt, der neu geschrieben werden muss, ist: das Hauptgerüst des Papiers

Der Inhalt, der neu geschrieben werden muss, ist: das Hauptgerüst des Papiers

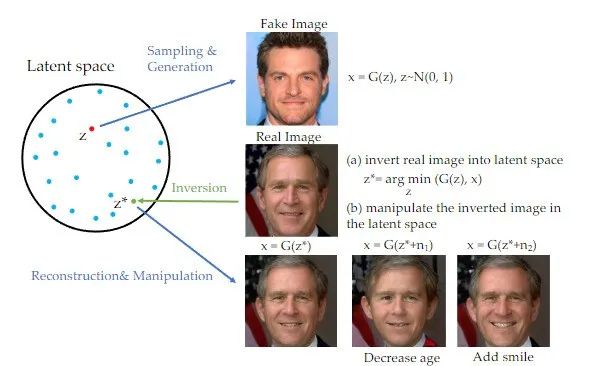

Es ist erwähnenswert, dass im Bereich der Generative Adversarial Networks (GAN) in den letzten Jahren die Inversionsmethode verwendet wurde weit verbreitet und in vielen Bereichen eingesetzt. Bei Bilderzeugungsaufgaben wurden bemerkenswerte Ergebnisse erzielt [1]. Wenn GAN Inhalte umschreibt, muss der Originalsatz nicht in den verborgenen Raum des trainierten GAN-Generators umgewandelt werden, und der Zweck der Bearbeitung kann durch die Steuerung erreicht werden versteckter Raum. Dieses Inversionsschema kann die generative Kraft vorab trainierter generativer Modelle voll ausnutzen. In dieser Studie wird der Inhalt tatsächlich mit GAN neu geschrieben, und der Originalsatz muss nicht a priori auf Bildbearbeitungsaufgaben angewendet werden, die auf dem Diffusionsmodell basieren.

Beim Umschreiben des Inhalts muss der Originaltext ins Chinesische umgeschrieben werden und der Originalsatz muss nicht erscheinen

Beim Umschreiben des Inhalts muss der Originaltext ins Chinesische umgeschrieben werden und der Originalsatz muss nicht erscheinen

Einführung in die Methode

Basierend auf der Idee der Umkehrung, VCT hat einen Diffusionsprozess mit zwei Zweigen entworfen, der einen Zweig B* für die Inhaltsrekonstruktion und einen Hauptzweig B für die Bearbeitung umfasst. Sie beginnen mit demselben Rauschen xT, das von DDIM Inversion

【2】 erhalten wird, einem Algorithmus, der Diffusionsmodelle verwendet, um Rauschen aus Bildern für die Inhaltsrekonstruktion bzw. Inhaltsbearbeitung zu berechnen. Das in diesem Artikel verwendete Vortrainingsmodell ist Latent Diffusion Models (kurz LDM). Der Diffusionsprozess findet im latenten Vektorraum z-Raum statt. Der Doppelzweigprozess kann wie folgt ausgedrückt werden:

Doppelzweig-Diffusionsprozess

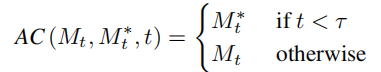

Der Inhaltsrekonstruktionszweig B* lernt T-Inhaltsmerkmalsvektoren  , der verwendet wird, um die Strukturinformationen des Originalbilds wiederherzustellen, und durch das Soft-Attention-Control-Schema die Struktur der Informationen wird an den Editor des Hauptzweigs B übergeben. Das Soft-Attention-Control-Schema basiert auf der Arbeit von prompt2prompt [3]:

, der verwendet wird, um die Strukturinformationen des Originalbilds wiederherzustellen, und durch das Soft-Attention-Control-Schema die Struktur der Informationen wird an den Editor des Hauptzweigs B übergeben. Das Soft-Attention-Control-Schema basiert auf der Arbeit von prompt2prompt [3]:

Das heißt, wenn die Anzahl der laufenden Schritte des Diffusionsmodells innerhalb eines bestimmten Bereichs liegt, wird die Aufmerksamkeitsmerkmalskarte des Der Bearbeitungshauptzweig wird durch den Inhaltsrekonstruktionszweig Feature Map ersetzt, um eine strukturelle Kontrolle über das generierte Bild zu erreichen. Der Bearbeitungshauptzweig B kombiniert den aus dem Originalbild gelernten Inhaltsmerkmalsvektor  und den aus dem Referenzbild gelernten Konzeptmerkmalsvektor

und den aus dem Referenzbild gelernten Konzeptmerkmalsvektor  , um das bearbeitete Bild zu generieren.

, um das bearbeitete Bild zu generieren.

Rauschraumfusion ( Raum)

Raum)

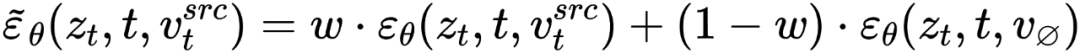

Bei jedem Schritt des Diffusionsmodells erfolgt die Fusion von Merkmalsvektoren im Rauschraumraum, bei dem es sich um die Gewichtung des nach dem vorhergesagten Rauschens handelt Merkmalsvektoren werden in das Diffusionsmodell eingegeben. Die Merkmalsmischung des Inhaltsrekonstruktionszweigs erfolgt auf dem Inhaltsmerkmalsvektor  und dem leeren Textvektor, im Einklang mit der Form der klassifikatorfreien Diffusionsführung [4]:

und dem leeren Textvektor, im Einklang mit der Form der klassifikatorfreien Diffusionsführung [4]:

Bearbeitungsmischung Hauptzweig Es ist eine Mischung aus Inhaltsmerkmalsvektor  und Konzeptmerkmalsvektor

und Konzeptmerkmalsvektor  , also

, also

An diesem Punkt liegt der Schlüssel zur Forschung darin, wie man den Merkmalsvektor der Strukturinformationen erhält ein einzelnes Quellbild  und aus einem einzelnen Quellbild ein Referenzbild, um den Merkmalsvektor der Konzeptinformationen zu erhalten

und aus einem einzelnen Quellbild ein Referenzbild, um den Merkmalsvektor der Konzeptinformationen zu erhalten  . Dieser Artikel erreicht diesen Zweck durch zwei verschiedene Inversionsschemata.

. Dieser Artikel erreicht diesen Zweck durch zwei verschiedene Inversionsschemata.

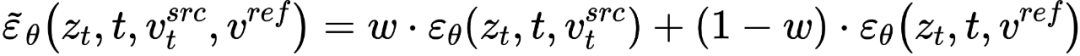

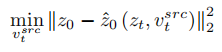

Um das Quellbild wiederherzustellen, bezieht sich der Artikel auf das NULL-Text-Optimierungsschema [5] und lernt, die Merkmalsvektoren der T-Stufen so anzupassen, dass sie mit dem Quellbild übereinstimmen und passen. Aber im Gegensatz zu NULL-Text, der den leeren Textvektor so optimiert, dass er in den DDIM-Pfad passt, passt dieser Artikel den geschätzten sauberen Merkmalsvektor direkt an, indem er den Quellbild-Merkmalsvektor optimiert. Die Anpassungsformel lautet:

Anders als beim Lernen von Strukturinformationen müssen die Konzeptinformationen im Referenzbild durch einen einzelnen hochverallgemeinerten Merkmalsvektor dargestellt werden. Die T-Stufen des Diffusionsmodells teilen sich einen Konzeptmerkmalsvektor  . Der Artikel optimiert die bestehenden Inversionsschemata Textual Inversion [6] und DreamArtist [7]. Es verwendet einen Multikonzept-Merkmalsvektor, um den Inhalt des Referenzbildes darzustellen. Die Verlustfunktion umfasst einen Rauschschätzungsterm des Diffusionsmodells und einen geschätzten Rekonstruktionsverlustterm im latenten Vektorraum:

. Der Artikel optimiert die bestehenden Inversionsschemata Textual Inversion [6] und DreamArtist [7]. Es verwendet einen Multikonzept-Merkmalsvektor, um den Inhalt des Referenzbildes darzustellen. Die Verlustfunktion umfasst einen Rauschschätzungsterm des Diffusionsmodells und einen geschätzten Rekonstruktionsverlustterm im latenten Vektorraum:

Experimentelle Ergebnisse

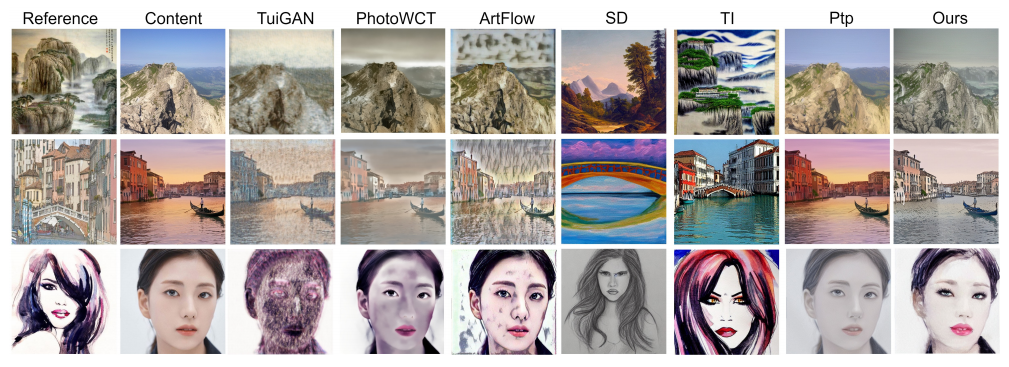

Der Artikel führt Experimente zu Themenersetzungs- und Stilisierungsaufgaben durch, die den Inhalt in das Thema oder den Stil des Referenzbilds ändern und gleichzeitig die Strukturinformationen des Quellbilds besser beibehalten können.

Umgeschriebener Inhalt: Artikel über experimentelle Effekte

Im Vergleich zu früheren Lösungen bietet das in diesem Artikel vorgeschlagene VCT-Framework die folgenden Vorteile:

(1) Anwendung Verallgemeinerung : Im Vergleich zu früheren Bildbearbeitungsaufgaben, die auf Bildführung basieren, erfordert VCT keine große Datenmenge für das Training und weist eine bessere Generierungsqualität und Generalisierung auf. Es basiert auf der Idee der Inversion und basiert auf hochwertigen vinzentinischen Graphenmodellen, die vorab auf Open-World-Daten trainiert wurden. In der tatsächlichen Anwendung sind nur ein Eingabebild und ein Referenzbild erforderlich, um bessere Bildbearbeitungseffekte zu erzielen .

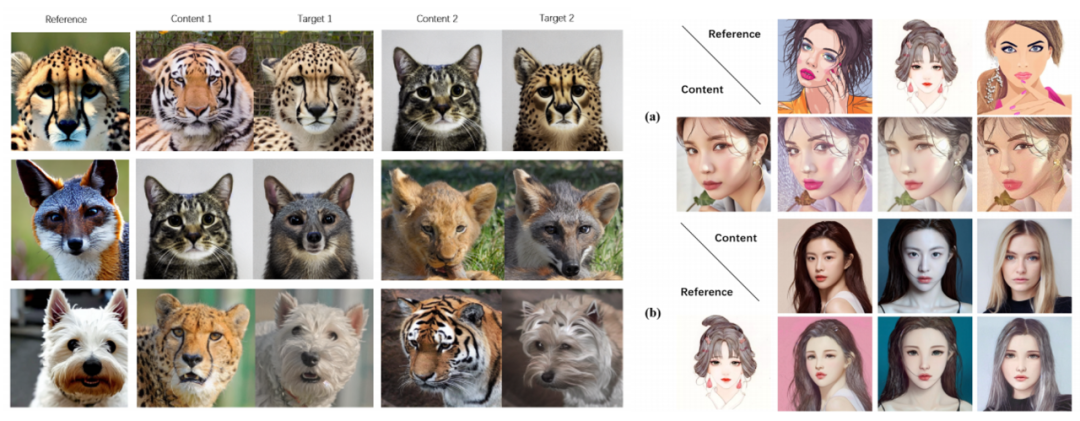

(2) Visuelle Genauigkeit: Im Vergleich zu neueren Textbearbeitungs-Bildlösungen verwendet VCT Bilder als Referenzhilfe. Mit der Bildreferenz können Sie Bilder genauer bearbeiten als mit Textbeschreibungen. Die folgende Abbildung zeigt die Vergleichsergebnisse zwischen VCT und anderen Lösungen:

Vergleich der Wirkung der Subjektersetzungsaufgabe

Vergleich der Stilübertragungsaufgabe

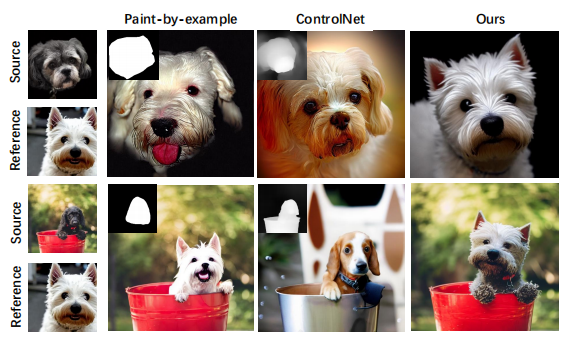

(3) Es sind keine zusätzlichen Informationen erforderlich: Im Vergleich zu einigen neueren Lösungen, die das Hinzufügen zusätzlicher Steuerinformationen (z. B. Maskenkarten oder Tiefenkarten) zur Führungssteuerung erfordern, lernt VCT Strukturinformationen und semantische Informationen direkt aus dem Quellbild und dem Referenzbild Generation zeigt die folgende Abbildung einige Vergleichsergebnisse. Unter anderem ersetzt Paint-by-Example die entsprechenden Objekte durch Objekte im Referenzbild, indem es eine Maskenkarte des Quellbilds bereitstellt; Controlnet steuert die generierten Ergebnisse durch Strichzeichnungen, Tiefenkarten usw.; Bild- und Referenzbilder, wobei Strukturinformationen und Inhaltsinformationen ohne zusätzliche Einschränkungen zu Zielbildern zusammengeführt werden können.

Kontrasteffekt einer Bildbearbeitungslösung basierend auf Bildführung

NetEase Interactive Entertainment AI Lab

NetEase Interactive Entertainment AI Lab wurde 2017 gegründet und ist der NetEase Interactive Entertainment Business Group angegliedert führendes Labor für künstliche Intelligenz in der Gaming-Branche. Der Schwerpunkt des Labors liegt auf der Erforschung und Anwendung von Computer Vision, Sprach- und natürlicher Sprachverarbeitung sowie Reinforcement Learning in Spieleszenarien. Ziel ist es, das technische Niveau der beliebten Spiele und Produkte von NetEase Interactive Entertainment durch KI-Technologie zu verbessern. Derzeit wird diese Technologie in vielen beliebten Spielen verwendet, wie zum Beispiel „Fantasy Westward Journey“, „Harry Potter: Magic Awakening“, „Onmyoji“, „Westward Journey“ usw.

Das obige ist der detaillierte Inhalt vonVerschiedene Arten der VCT-Anleitung, alle mit einem Bild, sodass Sie sie einfach implementieren können. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

1378

1378

52

52

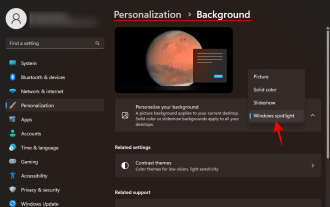

So laden Sie das Windows Spotlight-Hintergrundbild auf den PC herunter

Aug 23, 2023 pm 02:06 PM

So laden Sie das Windows Spotlight-Hintergrundbild auf den PC herunter

Aug 23, 2023 pm 02:06 PM

Bei Fenstern kommt die Ästhetik nie zu kurz. Von den idyllischen grünen Feldern von XP bis zum blauen, wirbelnden Design von Windows 11 erfreuen Standard-Desktop-Hintergründe seit Jahren die Benutzer. Mit Windows Spotlight haben Sie jetzt jeden Tag direkten Zugriff auf wunderschöne, beeindruckende Bilder für Ihren Sperrbildschirm und Ihr Desktop-Hintergrundbild. Leider bleiben diese Bilder nicht hängen. Wenn Sie sich in eines der Windows-Spotlight-Bilder verliebt haben, möchten Sie vielleicht wissen, wie Sie sie herunterladen können, damit Sie sie für eine Weile als Hintergrund behalten können. Hier finden Sie alles, was Sie wissen müssen. Was ist WindowsSpotlight? Window Spotlight ist ein automatischer Hintergrund-Updater, der unter Personalisierung > in der App „Einstellungen“ verfügbar ist

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Ein tiefer Einblick in Modelle, Daten und Frameworks: eine ausführliche 54-seitige Übersicht über effiziente große Sprachmodelle

Jan 14, 2024 pm 07:48 PM

Large-Scale Language Models (LLMs) haben überzeugende Fähigkeiten bei vielen wichtigen Aufgaben bewiesen, darunter das Verständnis natürlicher Sprache, die Sprachgenerierung und das komplexe Denken, und hatten tiefgreifende Auswirkungen auf die Gesellschaft. Diese herausragenden Fähigkeiten erfordern jedoch erhebliche Schulungsressourcen (im linken Bild dargestellt) und lange Inferenzzeiten (im rechten Bild dargestellt). Daher müssen Forscher wirksame technische Mittel entwickeln, um ihre Effizienzprobleme zu lösen. Darüber hinaus wurden, wie auf der rechten Seite der Abbildung zu sehen ist, einige effiziente LLMs (LanguageModels) wie Mistral-7B erfolgreich beim Entwurf und Einsatz von LLMs eingesetzt. Diese effizienten LLMs können den Inferenzspeicher erheblich reduzieren und gleichzeitig eine ähnliche Genauigkeit wie LLaMA1-33B beibehalten

Wie verwende ich die Bildsemantiksegmentierungstechnologie in Python?

Jun 06, 2023 am 08:03 AM

Wie verwende ich die Bildsemantiksegmentierungstechnologie in Python?

Jun 06, 2023 am 08:03 AM

Mit der kontinuierlichen Weiterentwicklung der Technologie der künstlichen Intelligenz hat sich die Bildsemantiksegmentierungstechnologie zu einer beliebten Forschungsrichtung im Bereich der Bildanalyse entwickelt. Bei der semantischen Bildsegmentierung segmentieren wir verschiedene Bereiche in einem Bild und klassifizieren jeden Bereich, um ein umfassendes Verständnis des Bildes zu erreichen. Python ist eine bekannte Programmiersprache. Aufgrund seiner leistungsstarken Datenanalyse- und Datenvisualisierungsfähigkeiten ist es die erste Wahl auf dem Gebiet der Technologieforschung im Bereich der künstlichen Intelligenz. In diesem Artikel wird die Verwendung der Bildsemantiksegmentierungstechnologie in Python vorgestellt. 1. Vorkenntnisse werden vertieft

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

Nvidias GPU der nächsten Generation zerschmettert H100 und wird enthüllt! Das erste 3-nm-Multichip-Moduldesign, vorgestellt im Jahr 2024

Sep 30, 2023 pm 12:49 PM

3-nm-Prozess, Leistung übertrifft H100! Kürzlich brachten die ausländischen Medien DigiTimes die Nachricht, dass Nvidia die GPU der nächsten Generation, die B100, mit dem Codenamen „Blackwell“ entwickelt, angeblich als Produkt für Anwendungen im Bereich der künstlichen Intelligenz (KI) und des Hochleistungsrechnens (HPC). Der B100 wird den 3-nm-Prozess von TSMC sowie ein komplexeres Multi-Chip-Modul (MCM)-Design nutzen und im vierten Quartal 2024 erscheinen. Nvidia, das mehr als 80 % des GPU-Marktes für künstliche Intelligenz monopolisiert, kann mit dem B100 zuschlagen, solange das Eisen heiß ist, und in dieser Welle des KI-Einsatzes weitere Herausforderer wie AMD und Intel angreifen. Nach Schätzungen von NVIDIA wird erwartet, dass der Produktionswert dieses Bereichs bis 2027 ungefähr erreicht

iOS 17: So verwenden Sie das Zuschneiden mit einem Klick in Fotos

Sep 20, 2023 pm 08:45 PM

iOS 17: So verwenden Sie das Zuschneiden mit einem Klick in Fotos

Sep 20, 2023 pm 08:45 PM

Mit der iOS 17-Fotos-App erleichtert Apple das Zuschneiden von Fotos nach Ihren Vorgaben. Lesen Sie weiter, um zu erfahren, wie. Bisher umfasste das Zuschneiden eines Bildes in der Fotos-App in iOS 16 mehrere Schritte: Tippen Sie auf die Bearbeitungsoberfläche, wählen Sie das Zuschneidewerkzeug aus und passen Sie dann den Zuschnitt mithilfe einer Pinch-to-Zoom-Geste oder durch Ziehen an den Ecken des Zuschneidewerkzeugs an. In iOS 17 hat Apple diesen Vorgang dankenswerterweise vereinfacht, sodass beim Vergrößern eines ausgewählten Fotos in Ihrer Fotobibliothek automatisch eine neue Schaltfläche „Zuschneiden“ in der oberen rechten Ecke des Bildschirms angezeigt wird. Wenn Sie darauf klicken, wird die vollständige Zuschneideoberfläche mit der Zoomstufe Ihrer Wahl angezeigt, sodass Sie den gewünschten Teil des Bildes zuschneiden, das Bild drehen, umkehren, das Bildschirmverhältnis anwenden oder Markierungen verwenden können

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! 7 Microsoft-Forscher arbeiteten intensiv zusammen, 5 Hauptthemen, 119 Seiten Dokument

Sep 25, 2023 pm 04:49 PM

Die umfassendste Übersicht über multimodale Großmodelle finden Sie hier! Es wurde von sieben chinesischen Forschern bei Microsoft verfasst und umfasst 119 Seiten. Es geht von zwei Arten multimodaler Forschungsrichtungen für große Modelle aus, die abgeschlossen wurden und immer noch an der Spitze stehen, und fasst fünf spezifische Forschungsthemen umfassend zusammen: visuelles Verständnis und visuelle Generierung Der vom einheitlichen visuellen Modell LLM unterstützte multimodale Großmodell-Multimodalagent konzentriert sich auf ein Phänomen: Das multimodale Grundmodell hat sich von spezialisiert zu universell entwickelt. Ps. Aus diesem Grund hat der Autor am Anfang des Artikels direkt ein Bild von Doraemon gezeichnet. Wer sollte diese Rezension (Bericht) lesen? Mit den ursprünglichen Worten von Microsoft: Solange Sie daran interessiert sind, das Grundwissen und die neuesten Fortschritte multimodaler Grundmodelle zu erlernen, egal ob Sie ein professioneller Forscher oder ein Student sind, ist dieser Inhalt sehr gut für Sie geeignet.

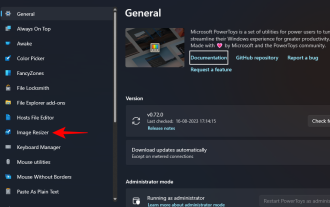

So ändern Sie die Größe von Bildern stapelweise mit PowerToys unter Windows

Aug 23, 2023 pm 07:49 PM

So ändern Sie die Größe von Bildern stapelweise mit PowerToys unter Windows

Aug 23, 2023 pm 07:49 PM

Wer täglich mit Bilddateien arbeitet, muss diese oft in der Größe anpassen, um sie an die Anforderungen seiner Projekte und Aufgaben anzupassen. Wenn Sie jedoch zu viele Bilder verarbeiten müssen, kann die Größenänderung einzelner Bilder viel Zeit und Mühe kosten. In diesem Fall kann ein Tool wie PowerToys nützlich sein, um unter anderem die Größe von Bilddateien mit dem Bild-Resizer-Dienstprogramm stapelweise zu ändern. Hier erfahren Sie, wie Sie Ihre Image Resizer-Einstellungen einrichten und mit PowerToys mit der Stapelgrößenänderung von Bildern beginnen. So ändern Sie die Größe von Bildern stapelweise mit PowerToys PowerToys ist ein All-in-One-Programm mit einer Vielzahl von Dienstprogrammen und Funktionen, die Ihnen helfen, Ihre täglichen Aufgaben zu beschleunigen. Eines seiner Dienstprogramme sind Bilder

So bearbeiten Sie Fotos auf dem iPhone mit iOS 17

Nov 30, 2023 pm 11:39 PM

So bearbeiten Sie Fotos auf dem iPhone mit iOS 17

Nov 30, 2023 pm 11:39 PM

Die mobile Fotografie hat die Art und Weise, wie wir die Momente des Lebens festhalten und teilen, grundlegend verändert. Das Aufkommen von Smartphones, insbesondere des iPhone, spielte bei diesem Wandel eine Schlüsselrolle. Das iPhone ist für seine fortschrittliche Kameratechnologie und benutzerfreundlichen Bearbeitungsfunktionen bekannt und zur ersten Wahl sowohl für Amateur- als auch für erfahrene Fotografen geworden. Die Einführung von iOS 17 markiert einen wichtigen Meilenstein auf diesem Weg. Das neueste Update von Apple bietet erweiterte Fotobearbeitungsfunktionen und gibt Benutzern ein leistungsfähigeres Toolkit an die Hand, mit dem sie ihre alltäglichen Schnappschüsse in visuell ansprechende und künstlerisch anspruchsvolle Bilder umwandeln können. Diese technologische Entwicklung vereinfacht nicht nur den Fotografieprozess, sondern eröffnet auch neue Möglichkeiten für den kreativen Ausdruck und ermöglicht es Benutzern, ihren Fotos mühelos eine professionelle Note zu verleihen