Wird Google JavaScript crawlen, das Textinhalte enthält?

Historisch gesehen konnten Suchmaschinen-Crawler wie Googlebot nur statischen HTML-Quellcode lesen und waren nicht in der Lage, dynamisch mit JavaScript geschriebenes Material zu scannen und zu indizieren. Dies hat sich jedoch mit dem Aufkommen von JavaScript-reichen Websites und Frameworks wie Angular, React und Vue.JS sowie Single-Page-Anwendungen (SPA) und Progressive Web Applications (PWA) geändert. Um Webseiten vor der Indexierung korrekt anzuzeigen, hat Google seine bisherige AJAX-Crawling-Technologie geändert und eingestellt. Obwohl Google im Allgemeinen die meisten JavaScript-Informationen crawlen und indizieren kann, raten sie davon ab, clientseitige Lösungen zu verwenden, da JavaScript „schwer zu verarbeiten ist und nicht alle Suchmaschinen-Crawler es korrekt oder schnell verarbeiten können“.

Was ist Google Fetch?Google und andere Suchmaschinen verwenden Software namens Google Crawler (auch bekannt als Such-Bots oder Spider), um das Web zu scannen. Mit anderen Worten: Es „durchsucht“ das Internet von Seite zu Website und sucht nach neuen oder aktualisierten Inhalten, die noch nicht in der Google-Datenbank vorhanden sind.

Jede Suchmaschine verfügt über eine einzigartige Sammlung von Crawlern. Für Google gibt es mehr als 15 verschiedene Arten von Crawlern, wobei der Googlebot der wichtigste ist. Da der Googlebot das Crawling und die Indexierung durchführt, werden wir seine Funktionsweise genauer untersuchen.

Wie funktioniert der Google-Crawler?

Keine Suchmaschine (einschließlich Google) führt ein zentrales URL-Register und aktualisiert die URL jedes Mal, wenn eine neue Seite erstellt wird. Das bedeutet, dass Google das Internet nach neuen Seiten durchsuchen muss, anstatt sie automatisch zu „alarmieren“. Der Googlebot durchstreift ständig das Internet und sucht nach neuen Webseiten, die er dem Google-Inventar bestehender Webseiten hinzufügen kann.

Nachdem der Googlebot eine neue Website gefunden hat, rendert (oder „visualisiert“) er die Website im Browser, indem er sämtliches HTML, Code von Drittanbietern, JavaScript und CSS lädt. Suchmaschinen verwenden diese in Datenbanken gespeicherten Daten, um Seiten zu indizieren und zu bewerten. Die Seite wird in den Google-Index aufgenommen, der bei Indexierung eine zusätzliche, sehr große Google-Datenbank darstellt.

JavaScript- und HTML-Rendering

Langsamer Code kann für den Googlebot schwierig zu verarbeiten und darzustellen sein. Wenn der Code nicht sauber ist, kann der Crawler Ihre Website möglicherweise nicht korrekt rendern. In diesem Fall wird sie als leer behandelt.

Bitte beachten Sie beim Rendern von JavaScript, dass sich die Sprache schnell weiterentwickelt und Googlebot manchmal die Unterstützung der neuesten Version nicht mehr unterstützt. Stellen Sie sicher, dass Ihr JavaScript mit Googlebot kompatibel ist, damit Ihre Website nicht angezeigt wird Zu Unrecht. Stellen Sie sicher, dass JavaScript schnell geladen wird. Der Googlebot rendert und indiziert kein per Skript generiertes Material, wenn das Laden länger als fünf Sekunden dauert.

Wann sollte JavaScript zum Scrapen verwendet werden?

Wir empfehlen weiterhin, bei der ersten Analyse einer Website auf JavaScript selektiv das JavaScript-Crawling zu verwenden, obwohl Google normalerweise jede Seite rendert. JavaScript wird verwendet, um bekannte Clientabhängigkeiten für Prüfzwecke und während der Bereitstellung auf großen Websites zu nutzen.

Alle Ressourcen (einschließlich JavaScript, CSS und Bilder) müssen selektiv gecrawlt werden, um jede Webseite anzuzeigen und das DOM in einem Headless-Browser im Hintergrund zu erstellen. Das Crawlen von JavaScript ist langsamer und arbeitsintensiver.

Während dies für kleinere Websites kein Problem darstellt, kann es bei größeren Websites mit Hunderten oder sogar Millionen Seiten erhebliche Auswirkungen haben. Wenn Ihre Website nicht stark auf JavaScript zur dynamischen Änderung von Webseiten angewiesen ist, müssen Sie weder Zeit noch Ressourcen aufwenden.

Beim Umgang mit JavaScript und Webseiten mit dynamischem Inhalt (DOM) muss der Crawler das Document Object Model lesen und auswerten. Nachdem der gesamte Code geladen und verarbeitet wurde, muss auch eine vollständig angezeigte Version einer solchen Website generiert werden. Browser sind für uns das einfachste Werkzeug, um angezeigte Webseiten anzuzeigen. Aus diesem Grund wird das Crawlen von JavaScript manchmal als Verwendung eines „kopflosen Browsers“ beschrieben.

Fazit

In den kommenden Jahren wird es mehr JavaScript geben, denn es wird bleiben. JavaScript kann problemlos mit SEOs und Crawlern koexistieren, solange Sie dies frühzeitig bei der Erstellung Ihrer Website-Architektur mit SEO besprechen. Crawler sind immer noch nur Nachbildungen des Verhaltens tatsächlicher Suchmaschinen-Bots. Zusätzlich zu JavaScript-Crawlern empfehlen wir dringend die Verwendung einer Protokolldateianalyse, des URL-Inspektionstools von Google oder mobilfreundlicher Testtools, um zu verstehen, was Google crawlen, rendern und indizieren kann.

Das obige ist der detaillierte Inhalt vonWird Google JavaScript crawlen, das Textinhalte enthält?. Für weitere Informationen folgen Sie bitte anderen verwandten Artikeln auf der PHP chinesischen Website!

Heiße KI -Werkzeuge

Undresser.AI Undress

KI-gestützte App zum Erstellen realistischer Aktfotos

AI Clothes Remover

Online-KI-Tool zum Entfernen von Kleidung aus Fotos.

Undress AI Tool

Ausziehbilder kostenlos

Clothoff.io

KI-Kleiderentferner

AI Hentai Generator

Erstellen Sie kostenlos Ai Hentai.

Heißer Artikel

Heiße Werkzeuge

Notepad++7.3.1

Einfach zu bedienender und kostenloser Code-Editor

SublimeText3 chinesische Version

Chinesische Version, sehr einfach zu bedienen

Senden Sie Studio 13.0.1

Leistungsstarke integrierte PHP-Entwicklungsumgebung

Dreamweaver CS6

Visuelle Webentwicklungstools

SublimeText3 Mac-Version

Codebearbeitungssoftware auf Gottesniveau (SublimeText3)

Heiße Themen

Ersetzen Sie Stringzeichen in JavaScript

Mar 11, 2025 am 12:07 AM

Ersetzen Sie Stringzeichen in JavaScript

Mar 11, 2025 am 12:07 AM

Detaillierte Erläuterung der Methode für JavaScript -Zeichenfolge und FAQ In diesem Artikel werden zwei Möglichkeiten untersucht, wie String -Zeichen in JavaScript ersetzt werden: Interner JavaScript -Code und interne HTML für Webseiten. Ersetzen Sie die Zeichenfolge im JavaScript -Code Die direkteste Möglichkeit ist die Verwendung der Ersatz () -Methode: str = str.replace ("find", "ersetzen"); Diese Methode ersetzt nur die erste Übereinstimmung. Um alle Übereinstimmungen zu ersetzen, verwenden Sie einen regulären Ausdruck und fügen Sie das globale Flag G hinzu:: STR = Str.Replace (/fi

Benutzerdefinierte Google -Search -API -Setup -Tutorial

Mar 04, 2025 am 01:06 AM

Benutzerdefinierte Google -Search -API -Setup -Tutorial

Mar 04, 2025 am 01:06 AM

Dieses Tutorial zeigt Ihnen, wie Sie eine benutzerdefinierte Google -Such -API in Ihr Blog oder Ihre Website integrieren und ein raffinierteres Sucherlebnis bieten als Standard -WordPress -Themen -Suchfunktionen. Es ist überraschend einfach! Sie können die Suche auf y beschränken

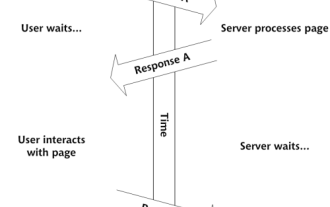

Erstellen Sie Ihre eigenen AJAX -Webanwendungen

Mar 09, 2025 am 12:11 AM

Erstellen Sie Ihre eigenen AJAX -Webanwendungen

Mar 09, 2025 am 12:11 AM

Hier sind Sie also bereit, alles über dieses Ding namens Ajax zu lernen. Aber was genau ist das? Der Begriff AJAX bezieht sich auf eine lose Gruppierung von Technologien, mit denen dynamische, interaktive Webinhalte erstellt werden. Der Begriff Ajax, ursprünglich von Jesse J geprägt

Beispielfarben JSON -Datei

Mar 03, 2025 am 12:35 AM

Beispielfarben JSON -Datei

Mar 03, 2025 am 12:35 AM

Diese Artikelserie wurde Mitte 2017 mit aktuellen Informationen und neuen Beispielen umgeschrieben. In diesem JSON -Beispiel werden wir uns ansehen, wie wir einfache Werte in einer Datei mit JSON -Format speichern können. Mit der Notation des Schlüsselwertpaares können wir jede Art speichern

8 atemberaubende JQuery -Seiten -Layout -Plugins

Mar 06, 2025 am 12:48 AM

8 atemberaubende JQuery -Seiten -Layout -Plugins

Mar 06, 2025 am 12:48 AM

Nutzen Sie JQuery für mühelose Webseiten -Layouts: 8 Essential Plugins JQuery vereinfacht das Webseitenlayout erheblich. In diesem Artikel werden acht leistungsstarke JQuery -Plugins hervorgehoben, die den Prozess optimieren, insbesondere nützlich für die manuelle Website -Erstellung

Was ist ' this ' in JavaScript?

Mar 04, 2025 am 01:15 AM

Was ist ' this ' in JavaScript?

Mar 04, 2025 am 01:15 AM

Kernpunkte Dies in JavaScript bezieht sich normalerweise auf ein Objekt, das die Methode "besitzt", aber es hängt davon ab, wie die Funktion aufgerufen wird. Wenn es kein aktuelles Objekt gibt, bezieht sich dies auf das globale Objekt. In einem Webbrowser wird es durch Fenster dargestellt. Wenn Sie eine Funktion aufrufen, wird das globale Objekt beibehalten. Sie können den Kontext mithilfe von Methoden wie CALL (), Apply () und Bind () ändern. Diese Methoden rufen die Funktion mit dem angegebenen Wert und den Parametern auf. JavaScript ist eine hervorragende Programmiersprache. Vor ein paar Jahren war dieser Satz

Verbessern Sie Ihr JQuery -Wissen mit dem Quell Betrachter

Mar 05, 2025 am 12:54 AM

Verbessern Sie Ihr JQuery -Wissen mit dem Quell Betrachter

Mar 05, 2025 am 12:54 AM

JQuery ist ein großartiges JavaScript -Framework. Wie in jeder Bibliothek ist es jedoch manchmal notwendig, unter die Motorhaube zu gehen, um herauszufinden, was los ist. Vielleicht liegt es daran, dass Sie einen Fehler verfolgen oder nur neugierig darauf sind, wie JQuery eine bestimmte Benutzeroberfläche erreicht

10 Mobile Cheat Sheets für die mobile Entwicklung

Mar 05, 2025 am 12:43 AM

10 Mobile Cheat Sheets für die mobile Entwicklung

Mar 05, 2025 am 12:43 AM

Dieser Beitrag erstellt hilfreiche Cheat -Blätter, Referenzführer, schnelle Rezepte und Code -Snippets für die Entwicklung von Android-, Blackberry und iPhone -App. Kein Entwickler sollte ohne sie sein! Touch Gesten -Referenzhandbuch (PDF) Eine wertvolle Ressource für Desig